- 1乡村振兴与农业科技创新:加大农业科技研发投入,推动农业科技创新,促进农业现代化和美丽乡村建设

- 22. USB通讯原理_usb bulk optimization通讯

- 3基于socket.io开发的聊天室demo_socketio demo

- 4Python判断语句的练习题及题解_python判断题

- 5Hadoop(04) HDFS编程实践操作_使用vim编辑器,在本地linux文件系统的“ home hadoop ”目录下创建一个文件 (1)_创建1.txt文件并上传到hdfs中

- 6网络可视化工具netron

- 7大数据HBase(十六):HBase的协处理器(Coprocessor)_hbase协处理器

- 8从0开始,部署私有模型,搭建企业知识库(理论篇)

- 9简化开发插件Lombok使用_lombok.extern.slf4j.slf4j

- 10大前端(全栈)学习路线指南_js全栈技术大全

搞算法的仙女妹子,爱了!!

赞

踩

今天这篇文章不谈技术,给大家分享一些干货!首先来聊聊一个AI圈子里画风清奇的公众号 夕小瑶的卖萌屋。公号的作者中不仅妹子居多,颜值能打,而且喜欢将学术研究和大厂业务上线中的收获与读者分享。

卖萌屋的作者们就读或毕业于北大、中科院、北邮、蒙特利尔大学MILA、墨尔本大学 等国内外的顶尖CS院校&实验室,在微软、百度、腾讯等大厂核心研究/业务团队从事搜索、推荐、NLP/CV相关的研究和业务落地,顶会收割机、上线狂魔、顶级赛事冠军、SSP offer收割机、知乎大V等只是ta们的部分标签。公众号主页点击「这是哪儿」了解更多ta们的故事(有照片哦)

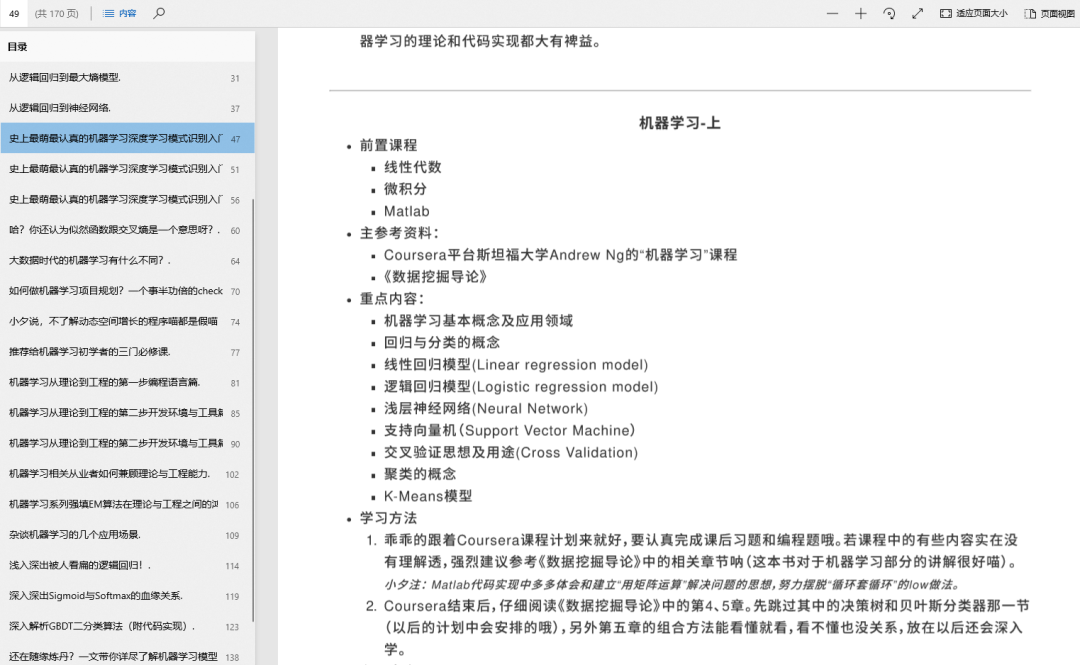

同样,这个公众号一直保持原创输出,高质量的文章整理成了一个 1200 页+的技术栈手册,内容从零基础到进阶,方向不限于:

机器学习算法

经典机器学习算法

逻辑回归

朴素贝叶斯

...

数学基础

互联网算法岗求职篇

秋招经验

面试经验

岗位分析

面试必备基础知识

...

深度学习炼丹技巧篇

基础篇

理论篇

实践篇

加速训练篇

模型压缩篇

高效炼丹篇

调参技巧篇

...

...

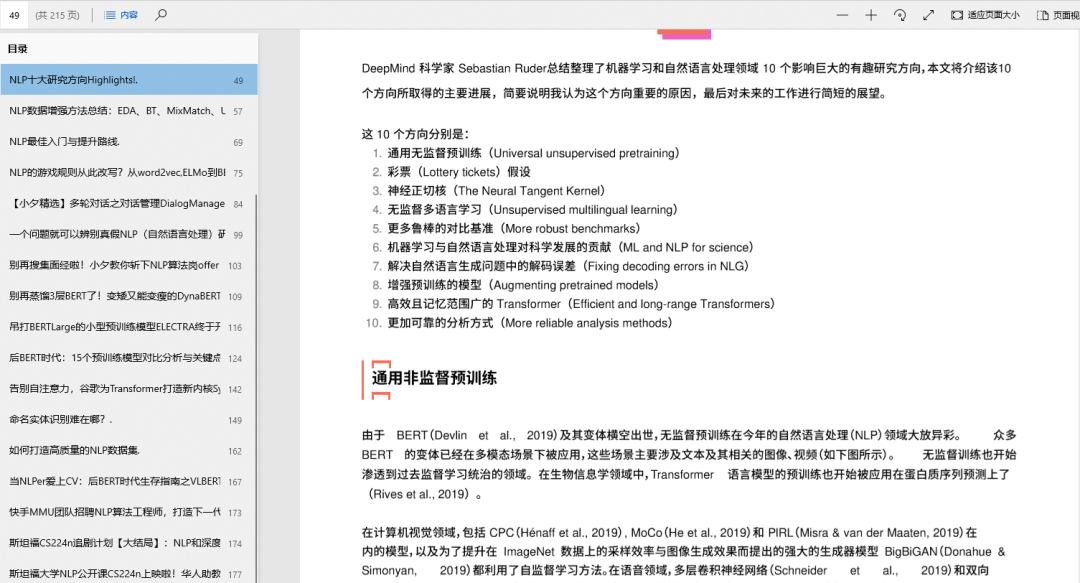

自然语言处理篇

基础知识

学术前沿

子方向综述

对话系统

知识图谱

预训练模型

智能问答

...

...

编程基础篇

手册内容截屏

下载方式

关注公号,后台回复「666」即可下载

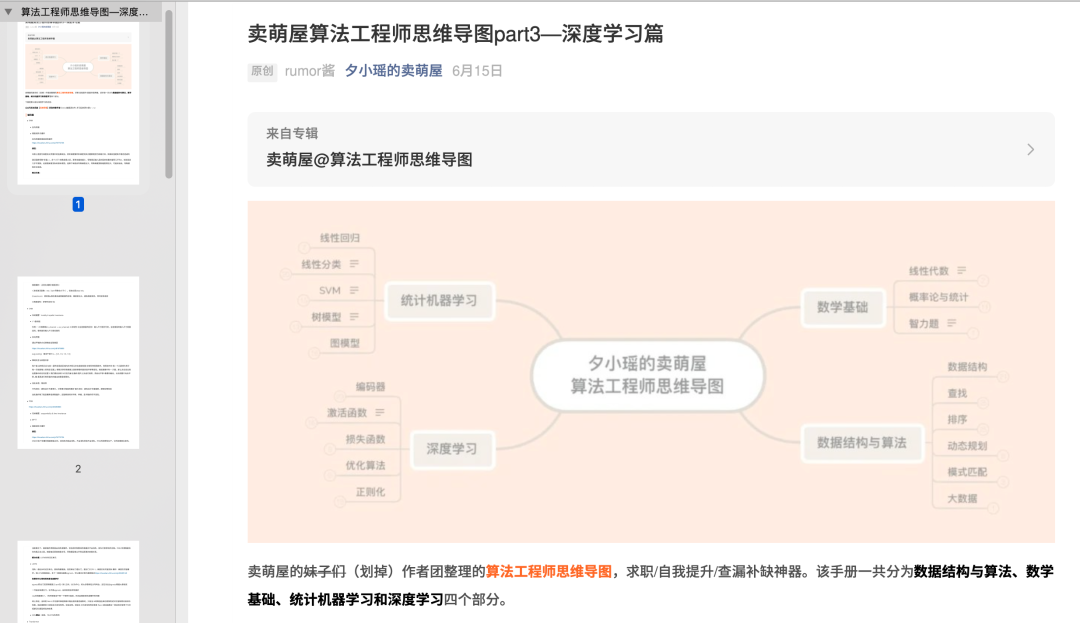

手册内容展示

图文并茂

思维导图

机器学习

自然语言处理

论文解读

手册目录树

├───深度学习与炼丹技巧

│ ├───实践篇

│ │ ├───万万没想到,我的炼丹炉玩坏了

│ │ ├───分类问题后处理技巧CAN,近乎零成本获取效果提升

│ │ ├───模型训练太慢?显存不够用?这个算法让你的GPU老树开新花

│ │ ├───盘点我跳过的科研天坑,进坑就是半年白干

│ │ ├───BERT重计算:用22.5%的训练时间节省5倍的显存开销(附代码)

│ │ ├───算法工程师的效率神器——vim篇

│ │ ├───你的 GNN,可能 99% 的参数都是冗余的

│ │ ├───训练效率低?GPU利用率上不去?快来看看别人家的tricks吧~

│ │ ├───显存不够,如何训练大型神经网络?

│ │ ├───All in Linux:一个算法工程师的IDE断奶之路

│ │ ├───别再喊我调参侠!夕小瑶“科学炼丹”手册了解一下

│ │ ├───一训练就显存爆炸?Facebook 推出 8 比特优化器,两行代码拯救你的显存!

│ ├───夕小瑶NLP全栈手册说明

│ ├───夕小瑶NLP全栈手册说明.md

│ ├───基础篇

│ │ ├───深度解析LSTM神经网络的设计原理

│ │ ├───训练神经网络时如何确定batch的大小?

│ │ ├───你的模型真的陷入局部最优点了吗?

│ │ ├───不要再纠结卷积的公式啦!0公式深度解析全连接前馈网络与卷积神经网络

│ │ ├───从前馈到反馈:解析循环神经网络(RNN)及其tricks

│ ├───理论篇

│ │ ├───一人之力,刷爆三路榜单!信息抽取竞赛夺冠经验分享

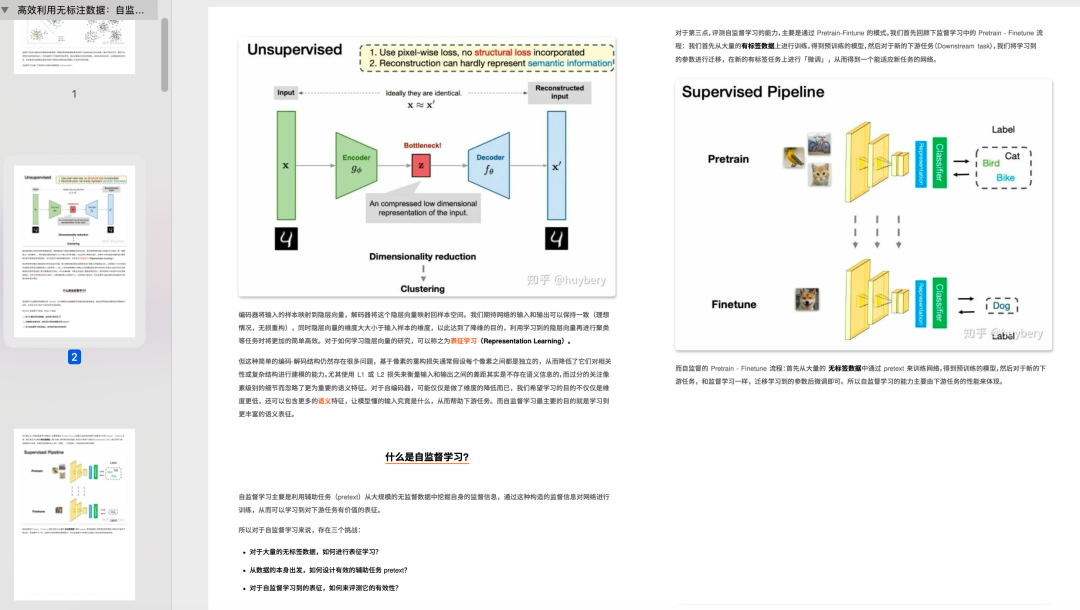

│ │ ├───高效利用无标注数据:自监督学习简述

│ │ ├───抓住训练集中真正有用的样本,提升模型整体性能!

│ │ ├───把数据集刷穿是什么体验?MetaQA已100%准确率

│ │ ├───我删了这些训练数据…模型反而表现更好了!?

│ │ ├───可交互的 Attention 可视化工具!我的Transformer可解释性有救了?

│ │ ├───超硬核 ICML’21 _ 如何使自然语言生成提速五倍,且显存占用减低99%

│ │ ├───ICLR2020满分论文 ─ 为什么梯度裁剪能加速模型训练?

│ │ ├───打破情感分类准确率 80 分天花板!更加充分的知识图谱结合范式

│ │ ├───为什么搜索与推荐场景用AUC评价模型好坏?

│ │ ├───吴恩达发起新型竞赛范式!模型固定,只调数据?!

│ │ ├───这篇论文提出了一个文本_─_知识图谱的格式转换器.._

│ │ ├───如何提升大规模Transformer的训练效果?Primer给出答案

│ │ ├───CMU & MILA & 谷歌 _ 三家巨头发布史上最干文本增强总结

│ │ ├───AdaX:一个比Adam更优秀,带”长期记忆“的优化器

│ │ ├───谷歌 _ 多任务学习,如何挑选有效的辅助任务?只需一个公式!

│ │ ├───Transformer太大了,我要把它微调成RNN

│ │ ├───ICLR2020───如何判断两个神经网络学到的知识是否一致

│ │ ├───硬核推导Google AdaFactor:一个省显存的宝藏优化器

│ │ ├───大模型炼丹无从下手?谷歌、OpenAI烧了几百万刀,总结出这些方法论…

│ │ ├───中文BERT上分新技巧,多粒度信息来帮忙

│ │ ├───一时学习一时爽,_持续学习_持续爽

│ │ ├───打破BERT天花板:11种花式炼丹术刷爆NLP分类SOTA!

│ │ ├───谈谈怎样提高炼丹手速

│ │ ├───别让数据坑了你!用置信学习找出错误标注(附开源实现)

├───夕小瑶NLP全栈手册说明

├───机器学习

│ ├───还在随缘炼丹?一文带你详尽了解机器学习模型可解释性的奥秘

│ ├───谈谈工业界落地能力最强的机器学习算法

│ ├───史上最萌最认真的机器学习─深度学习─模式识别入门指导手册─三─

│ ├───史上最萌最认真的机器学习─深度学习─模式识别入门指导手册─二─

│ ├───Allen AI提出MERLOT,视频理解领域新SOTA!

│ ├───AllenAI _ 用GPT─3帮助增建数据,NLI任务直接提升十个点!?

│ ├───夕小瑶NLP全栈手册说明

│ ├───夕小瑶NLP全栈手册说明.md

│ ├───数据缺失、混乱、重复怎么办?最全数据清洗指南让你所向披靡

│ ├───强化学习扫盲贴:从Q─learning到DQN

│ ├───AdaX:一个比Adam更优秀,带”长期记忆“的优化器

│ ├───2202年了,“小样本”还值得卷吗?

│ ├───史上最萌最认真的机器学习─深度学习─模式识别入门指导手册─一─

│ ├───硬核推导Google AdaFactor:一个省显存的宝藏优化器

│ ├───经典统计机器学习模型

│ │ ├───从逻辑回归到受限玻尔兹曼机

│ │ ├───深度前馈网络与Xavier初始化原理

│ │ ├───从点到线:逻辑回归到条件随机场

│ │ ├───LightGBM最强解析,从算法原理到代码实现~

│ │ ├───逻辑回归与朴素贝叶斯的战争

│ │ ├───从逻辑回归到最大熵模型

│ │ ├───解开玻尔兹曼机的封印会发生什么?

│ │ ├───朴素贝叶斯与拣鱼的故事

│ │ ├───机器学习系列─强填EM算法在理论与工程之间的鸿沟(上)

│ │ ├───机器学习系列─强填EM算法在理论与工程之间的鸿沟(下)

│ │ ├───深入解析GBDT二分类算法(附代码实现)

│ ├───如何优雅而时髦的解决不均衡分类问题

│ ├───一时学习一时爽,_持续学习_持续爽

│ ├───怎样将Embedding融入传统机器学习框架?

│ ├───以4%参数量比肩GPT─3!Deepmind 发布检索型 LM,或将成为 LM 发展新趋势!?

│ ├───数学基础

│ │ ├───线性代数应该这样讲─四──奇异值分解与主成分分析

│ │ ├───线性代数应该这样讲(二)

│ │ ├───线性代数应该这样讲─三──向量2范数与模型泛化

│ │ ├───线性代数应该这样讲(一)

│ ├───Meta AI 发布 data2vec!统一模态的新里程碑!

│ ├───别让数据坑了你!用置信学习找出错误标注(附开源实现)

├───夕小瑶NLP全栈手册说明.md

├───自然语言处理

│ ├───基础知识

│ │ ├───史上最可爱的关系抽取指南?从一条规则到十个开源项目

│ │ ├───斯坦福大学最甜网剧:知识图谱CS520面向大众开放啦!

│ │ ├───中文分词的古今中外,你想知道的都在这里

│ │ ├───如何优雅地编码文本中的位置信息?三种positioanl encoding方法简述的副本

│ │ ├───Step─by─step─to─Transformer:深入解析工作原理(以Pytorch机器翻译为例)

│ │ ├───文本分类问题不需要ResNet?小夕解析DPCNN设计原理(上)

│ │ ├───NLP的游戏规则从此改写?从word2vec,─ELMo到BERT

│ │ ├───搜索引擎核心技术与算法─——─倒排索引初体验

│ │ ├───文本分类问题不需要ResNet?小夕解析DPCNN设计原理(下)

│ │ ├───如何打造高质量的NLP数据集

│ │ ├───文本分类有哪些论文中很少提及却对性能有重要影响的tricks?

│ │ ├───那些击溃了所有NLP系统的样本

│ │ ├───NLP最佳入门与提升路线

│ │ ├───45个小众而实用的NLP开源字典和工具

│ │ ├───NLP─Subword三大算法原理:BPE、WordPiece、ULM

│ ├───夕小瑶NLP全栈手册说明

│ ├───夕小瑶NLP全栈手册说明.md

│ ├───子方向综述

│ │ ├───基于知识图谱的篇章标签生成综述

│ │ ├───NLP中的少样本困境问题探究

│ │ ├───多轮对话与检索式聊天机器人(chatbot)综述

│ │ ├───后BERT时代:15个预训练模型对比分析与关键点探究

│ │ ├───中文分词的古今中外,你想知道的都在这里

│ │ ├───对话系统的设计艺术

│ │ ├───超一流 ─ 从XLNet的多流机制看最新预训练模型的研究进展

│ │ ├───从零构建知识图谱

│ │ ├───限定域文本语料的短语挖掘综述

│ │ ├───文本对抗攻击入坑宝典

│ │ ├───预训练模型关键问题梳理与面试必备高频FAQ

│ │ ├───一文跟进Prompt进展!综述+15篇最新论文逐一梳理

│ │ ├───MSRA─万字综述 直击多模态文档理解

│ │ ├───NLP数据增强方法综述:EDA、BT、MixMatch、UDA

│ │ ├───NLP进入预训练模型时代:从word2vec,ELMo到BERT

│ │ ├───智能问答系统与机器阅读理解分方向综述

│ │ ├───文本生成评价指标的进化与推翻

│ │ ├───如何提高NLP模型鲁棒性和泛化能力?对抗训练论文综述

│ │ ├───工业界求解NER问题的12条黄金法则

│ │ ├───任务完成型对话之对话状态追踪DST综述

│ │ ├───写了一篇关于 NLP 综述的综述!

│ │ ├───文本匹配相关方向打卡点总结

│ │ ├───搜索中的Query理解及应用

│ ├───20篇NLP综述.zip

│ ├───学术前沿

│ │ ├───丹琦女神的对比学习新SOTA,在中文表现如何?我们补充实验后,惊了!

│ │ ├───Prompt tuning新工作,五个参数解决下游任务 fine─tuning

│ │ ├───万能的BERT连文本纠错也不放过

│ │ ├───ACL2020───基于Knowledge─Embedding的多跳知识图谱问答

│ │ ├───GPT─3诞生,Finetune也不再必要了!NLP领域又一核弹!

│ │ ├───Google Research新成果,让表格理解和检索更上一层楼!

│ │ ├───NAACL’21 _ 来看如何让模型学会因为所以但是如果

│ │ ├───ACL'21 _ 多模态数值推理新挑战,让 AI 学解几何题

│ │ ├───告别自注意力,谷歌为Transformer打造新内核Synthesizer

│ │ ├───迁移Prompt–解决Prompt Tuning三大问题!

│ │ ├───夕小瑶NLP全栈手册说明

│ │ ├───如何让BERT拥有视觉感知能力?两种方式将视频信息注入BERT

│ │ ├───当NLPer爱上CV:后BERT时代生存指南之VL─BERT篇

│ │ ├───还在用[CLS]?从BERT得到最强句子Embedding的打开方式!

│ │ ├───ACL’21 _ 对话系统也要进军多模态了!

│ │ ├───谷歌重磅:可以优化自己的优化器!手动调参或将成为历史!?

│ │ ├───别再Prompt了!谷歌提出tuning新方法,强力释放GPT─3潜力!

│ │ ├───ACL2020───对话数据集Mutual:论对话逻辑,BERT还差的很远

│ │ ├───格局打开,带你解锁 prompt 的花式用法

│ │ ├───ACL2020 ─ 线上搜索结果大幅提升!亚马逊提出对抗式query─doc相关性模型

│ │ ├───别再蒸馏3层BERT了!变矮又能变瘦的DynaBERT了解一下

│ │ ├───卖萌屋上线Arxiv论文速刷神器,直达学术最前沿!

│ │ ├───加了元学习之后,少样本学习竟然可以变得这么简单!

│ │ ├───无需人工!无需训练!构建知识图谱 BERT一下就行了!

│ │ ├───NYU & Google_ 知识蒸馏无处不在,但它真的有用吗?

│ │ ├───LayerNorm是Transformer的最优解吗?

│ │ ├───成本砍砍砍!不用数据也能用 BERT 做对比学习?

│ │ ├───数据有偏差,照样能学对!20年前就有这么强的算法了?

│ │ ├───Google ─ 突破瓶颈,打造更强大的Transformer

│ │ ├───吊打BERT─Large的小型预训练模型ELECTRA终于开源!真相却让人───

│ │ ├───对话系统答非所问?快试试这篇ACL'21的连贯性评估大法

│ │ ├───ACL'21 _ 弱标签的垃圾数据,也能变废为宝!

│ │ ├───如何优雅地编码文本中的位置信息?三种positioanl encoding方法简述

│ │ ├───FLAT:中文NER屠榜之作!

│ │ ├───ACL2020───FastBERT:放飞BERT的推理速度

│ │ ├───图灵奖大佬 Lecun 发表对比学习新作,比 SimCLR 更好用!

│ │ ├───陈丹琦“简单到令人沮丧”的屠榜之作:关系抽取新SOTA!

│ │ ├───用多模态信息做 prompt,解锁 GPT 新玩法

│ │ ├───为什么每次有人大声通电话时,我就很烦躁.._

│ │ ├───ACL20 ─ 让笨重的BERT问答匹配模型变快!

│ │ ├───EMNLP'21 _ 让压缩语言模型自动搜索最优结构!

│ │ ├───刷新SOTA!Salesforce提出跨模态对比学习新方法,仅需4M图像数据!

├───算法岗求职必备

│ ├───别再搜集面经啦!小夕教你斩下NLP算法岗offer!

│ ├───拒绝跟风,谈谈几种算法岗的区别和体验

│ ├───在大厂和小厂做算法有什么不同?

│ ├───夕小瑶NLP全栈手册说明

│ ├───夕小瑶NLP全栈手册说明.md

│ ├───写在校招季,谈谈机器学习岗的Offer选择问题

│ ├───6 年大厂面试官,谈谈我对算法岗面试的一些看法

│ ├───13个offer,8家SSP,谈谈我的秋招经验

│ ├───面试必备基础知识

│ │ ├───卖萌屋算法岗面试手册上线!通往面试自由之路

│ │ ├───算法工程师思维导图—深度学习篇

│ │ ├───预训练模型关键问题梳理与面试必备高频FAQ

│ │ ├───算法工程师思维导图—数据结构与算法

│ │ ├───算法工程师思维导图—统计机器学习篇

│ │ ├───算法与数据结构──空间复杂度O─1─遍历树

│ │ ├───「小公式」平均数与级数

│ │ ├───「小算法」回文数与数值合法性检验

│ ├───Google、MS和BAT教给我的面试真谛

├───精编文章

│ ├───如何让BERT拥有视觉感知能力?两种方式将视频信息注入BERT

│ ├───吐血整理:论文写作中注意这些细节,能显著提升成稿质量

│ ├───视觉增强词向量:我是词向量,我开眼了!

│ ├───别再喊我调参侠!夕小瑶“科学炼丹”手册了解一下

│ ├───如何优雅地编码文本中的位置信息?三种positioanl encoding方法简述

│ ├───ACL2020 ─ 线上搜索结果大幅提升!亚马逊提出对抗式query─doc相关性模型

│ ├───纵观对话预训练技术演变史:化繁为简的背后,什么在消亡?

│ ├───模型训练太慢?显存不够用?这个算法让你的GPU老树开新花

│ ├───从论文到PPT,一键生成!从此报告不用愁!

│ ├───数据还是模型?人类知识在深度学习里还有用武之地吗?

│ ├───图灵奖大佬+谷歌团队,为通用人工智能背书!CV 任务也能用 LM 建模!

│ ├───工作6年,谈谈我对“算法岗”的理解

│ ├───谁才是Transformer家族中的最强王者?谷歌告诉你答案

│ ├───屠榜CV还不是这篇论文的终极目标,它更大的目标其实是……

│ ├───对话系统的设计艺术

│ ├───诺奖级成果开源!为什么说AlphaFold2足以改变全人类?

│ ├───丹琦女神新作:对比学习,简单到只需要Dropout两下

│ ├───预训练语言模型真的是世界模型?

│ ├───恕我直言,很多小样本学习的工作就是不切实际的

│ ├───超一流 ─ 从XLNet的多流机制看最新预训练模型的研究进展

│ ├───All in Linux:一个算法工程师的IDE断奶之路

│ ├───肝了1W字!文本生成评价指标的进化与推翻

│ ├───我拿模型当朋友,模型却想泄漏我的隐私?

│ ├───NLP中的少样本困境问题探究

│ ├───恕我直言,你的实验结论可能严重依赖随机数种子!

│ ├───11 个好用的科研工具推荐!工作效率提升 max!

│ ├───夕小瑶NLP全栈手册说明

│ ├───软硬兼施极限轻量BERT!能比ALBERT再轻13倍?!

│ ├───中文分词的古今中外,你想知道的都在这里

│ ├───BERT重计算:用22.5%的训练时间节省5倍的显存开销(附代码)

│ ├───ACL'21 _ debug完的神经网络,如何测试是否仍然存在bug?

│ ├───谷歌:CNN击败Transformer,有望成为预训练界新霸主!LeCun却沉默了.._

│ ├───Google掀桌了,GLUE基准的时代终于过去了?

│ ├───NLP哪个细分方向最具社会价值?

│ ├───对比学习有多火?文本聚类都被刷爆了…

│ ├───夕小瑶NLP全栈手册说明.md

│ ├───一时学习一时爽,_持续学习_持续爽

│ ├───万万没想到,我的炼丹炉玩坏了

│ ├───万能的BERT连文本纠错也不放过

│ ├───从 ACL’22 投稿情况,速览当下 NLP 研究热点!

│ ├───Google ─ 突破瓶颈,打造更强大的Transformer

│ ├───Facebook 推出多模态通用模型 FLAVA,吊打 CLIP 平均十个点!

│ ├───在错误的数据上,刷到 SOTA 又有什么意义?

│ ├───如何提高NLP模型鲁棒性和泛化能力?对抗训练论文串讲

│ ├───论文投稿新规则,不用跑出SOTA,还能“内定”发论文?!

│ ├───算法工程师的效率神器——vim篇

│ ├───AllenAI 发布万能问答系统 MACAW!各类题型样样精通,性能大幅超越 GPT─3!

│ ├───吊打BERT、GPT、DALL·E,跨模态榜单新霸主诞生!

│ ├───撑起百万亿参数模型想象力!英伟达发布新一代SuperPOD超算,AI算力新巅峰!

│ ├───深度学习,路在何方?

│ ├───别只关注GPT3!细如发丝的模型更具现实杀伤力!

│ ├───史上最大多模态图文数据集发布!

│ ├───13个offer,8家SSP,谈谈我的秋招经验

│ ├───多模态为什么比单模态好?第一份严谨证明来了!

│ ├───聊聊机器翻译界的“灌水与反灌水之战”!

│ ├───GAN 的内在漏洞!只看眼睛就能找出虚拟人脸?

│ ├───ACL20 ─ 让笨重的BERT问答匹配模型变快!

│ ├───惊呆!不用一张图片,却训出个图像识别SOTA?

│ ├───写Rap,编菜谱,你画我猜……这些 AI demo 我可以玩一天!

│ ├───预训练卷不动,可以卷输入预处理啊!

│ ├───LayerNorm是Transformer的最优解吗?

│ ├───Git从入门到进阶,你想要的全在这里

│ ├───近期神奇机器学习应用大赏

│ ├───学完文本知识,我就直接看懂图片了!

│ ├───工业界求解NER问题的12条黄金法则

│ ├───谷歌:一篇论文,让研究者吃我三份安利

│ ├───谁说发 paper 一定要追快打新?2021年,研究 word2vec 也能中顶会!

│ ├───Transformer哪家强?Google爸爸辨优良!

│ ├───ICLR2020满分论文 ─ 为什么梯度裁剪能加速模型训练?

│ ├───硬核推导Google AdaFactor:一个省显存的宝藏优化器

├───编程基础

│ ├───一份北大信科内部流传的 “CS 自救指南”(无广推荐)

│ ├───Git从入门到进阶,你想要的全在这里

│ ├───算法工程师的效率神器——vim篇

│ ├───All in Linux:一个算法工程师的IDE断奶之路

│ ├───7款优秀Vim插件帮你打造完美IDE

├───有毒的文章

│ ├───万万没想到,我的炼丹炉玩坏了

│ ├───两个月,刷了八千篇Arxiv,我发现……

│ ├───机器学习梗图大赏

│ ├───我对你的爱,是只为你而留的神经元

│ ├───发现一篇专门吐槽 NLP 内卷现状的 ACL 论文 .._

│ ├───他与她,一个两年前的故事

│ ├───谢撩,人在斯坦福打SoTA

│ ├───如何优雅的追到女神夕小瑶

│ ├───一位老师,一位领导,一个让全体学生考上目标学校的故事

│ ├───如果你跟夕小瑶恋爱了───(上)

│ ├───无内鬼,来点ICML_ACL审稿人笑话

│ ├───如果你跟夕小瑶恋爱了───(下)

│ ├───我在斯坦福做科研的碎碎念

│ ├───在斯坦福,做 Manning 的 phd 要有多强?

其它宝藏

除此之外,这群硬核的萌妹子将公众号其它宝藏整理了一番,分享给大家:

1. 自然语言处理入门书单与热门方向论文列表。

2. 通往面试自由之路的算法岗面试手册,涵盖数学基础、数据结构与算法、统计机器学习和深度学习。

3. NLP经典公开课Stanford CS224n追剧计划,收录了中英字幕视频、笔记、FAQ、课后作业等,还有数千人的讨论群。

4. 轻松跟紧前沿的NLP/CV/IR方向Arxiv神器。

获取方式

关注公号,后台回复「666」即可获取