- 1从键盘中输入一个整数n,求1-n的和,以及偶数和、奇数和_输入整数n,分别计算1加到n的总和,奇数和,偶数和(用回车间隔三个输出)

- 2R使用netmeta程序包实现生存数据的频率学网状meta分析

- 3【零基础入门前端系列】—无序列表、有序列表、定义列表(五)_飞书里的有序列表空心圆

- 4聊聊十大网络安全上市公司,看F5拥有强大安全基因

- 5python输入一个数字n、计算1到n的和_怎么用python求1到n所有整数的和

- 6素数求和

- 7LiteOS 配置文件target_config.h文件详解_3861 target_config.h的配置

- 8人工智能大模型中token的理解_人工智能token

- 9linux c多线程进度条,C语言实现进度条Demo(vs/gcc) | 术与道的分享

- 10全网最全的Kali工具大全

hadoop启动集群之后没有namenode的一种情况_hadoop namenode -format未找到命令

赞

踩

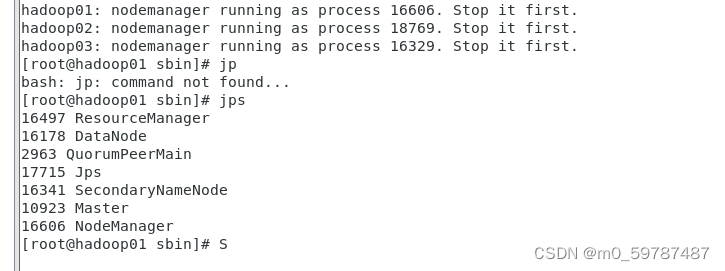

先说结论吧,一般在网上搜索这个问题都是让重新格式化namenode(当然,格式化之前要记得清空namenode和DataNode文件夹)。但是对于我之前遇到的问题却没法解决。我的做法是:检查你的hadoop的配置文件是否填写正确,我的hadoop的hdfs-site.xml中的主机IP地址未填写正确,导致启动集群服务后namenode启动不上,hdfs当然也没法用。

我的虚拟机会产生这个问题主要是虚拟机的IP地址发生了改变,在这里我简单记录一下发生这种问题怎么处理,也方便我日后参阅。

1.首先查明每台虚拟机的IP地址,修改 etc/hosts文件。

2.保证每台虚拟机能互ping,ssh免密码登录可以使用。

3.修改hadoop文件夹中 etc/hadoop中的core-site.xml、hdfs-site.xml、和zookeeper文件夹(如果安装了zookeeper的话)中的zoo.cfg 文件

4.格式化节点(hadoop-2.9.2/bin/hdfs namenode -format),如果所有虚拟机的IP地址都发生了改变,那么就都要格式化,格式化之前要记得清空namenode和DataNode文件夹,并修改namenode和DataNode文件夹的权限(chmod 777 namenode)

5.最后再启动集群 hadoop-2.9.2/sbin/start-all.sh,以后关闭集群最好使用stop-all.sh

6.先试试用命令上传文件到hdfs是否成功(hadoop-2.9.2/bin/hdfs dfs -put student.txt /tmp/),然后再试着用浏览器访问虚拟机50070端口,如果都能调试成功再试着用java或者python等脚本操作hdfs。