- 1Tesseract OCR 训练字库_tesseract训练自己的字库

- 2数组和广义表 讲义实现_数组与广义表基本操作c

- 3提升开发安全5大成熟度 跨国企业落地默安“一站式”方案_开发安全能力提升

- 4排序算法案例_郑州航空大学

- 5SpringCloud之Gateway(服务网关)_springcloud 查看 gateway 是否生效

- 6还在用HttpUtil?SpringBoot 3.0全新HTTP客户端工具来了,用起来够优雅~_spring 新版本自带的 http 客户端工具

- 7华为昇腾AI芯片加持,9.1k Star 的 Open-Sora-Plan,国产Sora要来了吗_opensora-plan

- 8深度学习(十一):YOLOv9之最新的目标检测器解读_yolov9 智慧 检测

- 9在iOS设备上演示Axure原型的方法

- 107套干货,Python常用技术学习知识图谱!!(史上最全,建议收藏(2)

sqoop导入数据到hdfs

赞

踩

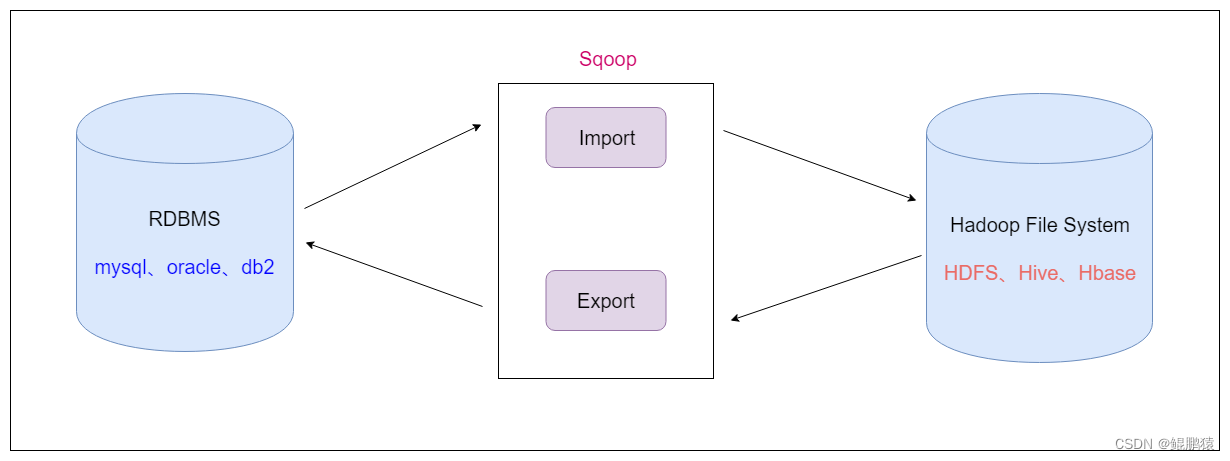

Sqoop是apache旗下的一款 ”Hadoop和关系数据库之间传输数据”的工具

导入数据:将MySQL,Oracle导入数据到Hadoop的HDFS、HIVE、HBASE等数据存储系统

导出数据:从Hadoop的文件系统中导出数据到关系数据库

2. Sqoop的工作机制

将导入和导出的命令翻译成mapreduce程序实现

在翻译出的mapreduce中主要是对inputformat和outputformat进行定制

Sqoop ETL工具

- 安装VMware15虚拟化软件

- 安装CentOS 7虚拟机3个

- 安装3节点的hadoop-2.6.0-cdh5.14.2集群

- 安装了hive

- 安装了zookeeper集群

- 安装了hbase集群

sqoop import 连接mysql --connect jdbc:mysql://node03:3306/userdb --username root --password 123456 --table emp --m 1

导入数据到hdfs:

sqoop import --connect jdbc:mysql://node03:3306/userdb --username

root --password 123456 --table emp --m 1

在网页上的user里找到emp文件

扩充:

–delete-target-dir 如果输出的目录存在,则删除。

–target-dir 指定表数据导入到hdfs的据体路径

sqoop import --connect jdbc:mysql://node03:3306/userdb --username root

–password 123456 --delete-target-dir --table emp --target-dir /sqoop/emp --m 1

导入到hdfs指定目录并指定字段之间的分隔符:

sqoop import --connect jdbc:mysql://node03:3306/userdb --username root

–password 123456 --delete-target-dir --table emp --target-dir /sqoop/emp2 --m 1 --fields-terminated-by ‘\t’