热门标签

热门文章

- 1猫头虎分享:Element UI & Element Plus组件的安装及使用_element-plus安装

- 2十大计算机专业证书,考过了同事对你刮目相看,老板给你升职加薪_计算机cct和ncre哪个好

- 3Git:查看本地分支基于哪个分支创建_查看当前分支是基于哪个分支

- 4mysql 操作命令小结_select,insert, update, delete, create, drop, reloa

- 5linux-DNS服务器的搭建_linux搭建dns服务器

- 6Ubuntu22.04虚拟机配置及使用代理工具_ubuntu 代理软件

- 7华为外包hr面试刷人吗,面试一个百度T7 Java 岗,简单聊聊2024年Java开发的现状和思考

- 8git代码提交推送报错:remote: The project you were looking for could not be found的解决

- 9Unity引擎学习笔记之【触摸屏监听操作】_unity touchphase.began

- 10为什么 Python 能成为最受欢迎的编程语言之一?_python为什么在程序员中很受欢迎?

当前位置: article > 正文

本地搭建大模型知识库Ollama+AnythingLLM(保姆级)_anythingllm 不识别本地的ollama

作者:从前慢现在也慢 | 2024-05-31 17:48:16

赞

踩

anythingllm 不识别本地的ollama

安装OLLAMA

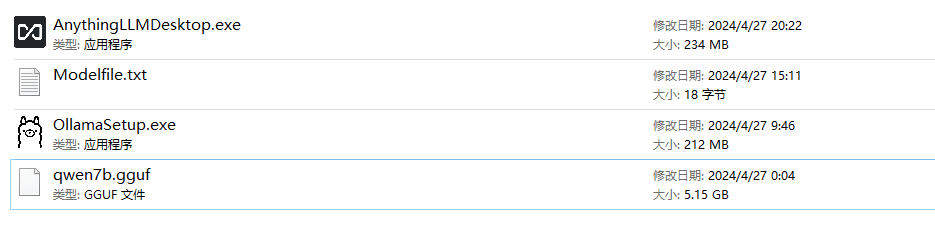

好多同学不知道怎么下载需要用到的工具,我这里给大家都准备好了,需要的文末领取。qwen7b.gguf是阿里巴巴的通义千问大模型,7B大模型,7亿参数,至少需要8G内存,越大回复越流畅,

下载完后,双击OllamaSetup,自动安装成功,默认安装在C盘,不能选择安装路径的哦,安装完后,右下角会出现Ollama图标。

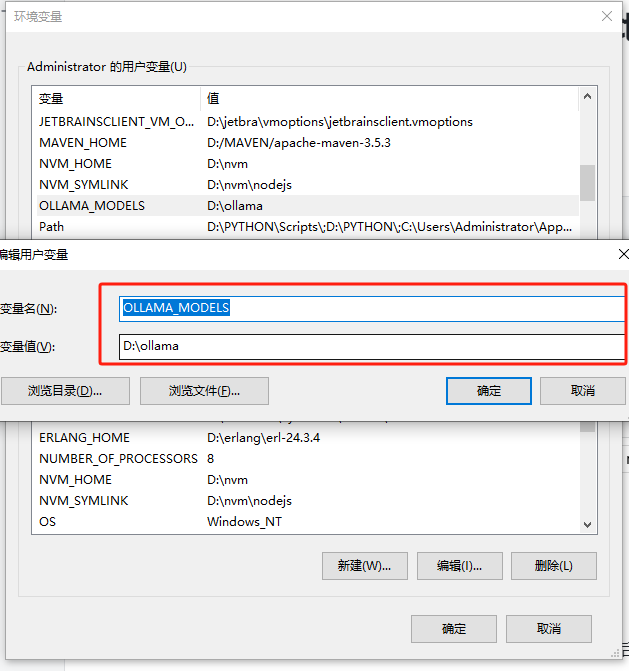

创建环境变量

OLLAMA_MODELS,随意指定变量值,如图所示:

| OLLAMA_MODELS |

重启OLLAMA

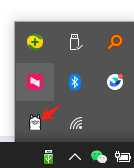

选择右键小图标,然后退出,

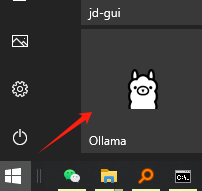

在开始菜单中找到重启Ollama

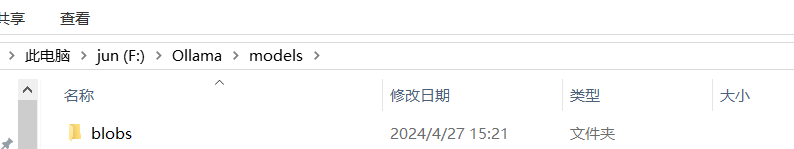

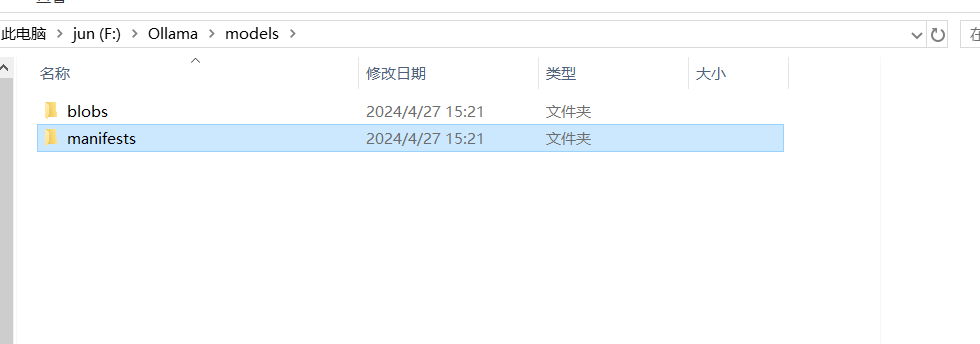

重启后目录如下:

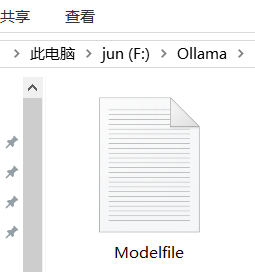

创建Modelfile

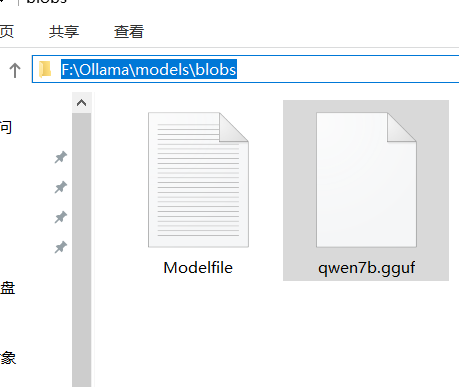

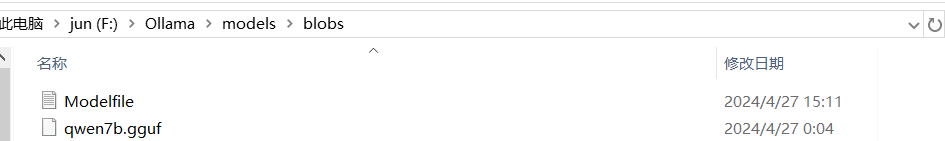

在blobs下创建Modelfile文件,没有后缀。

加载模型

1、将qwen7b.gguf模型放到F:\Ollama\models\blobs目录下,和ModelFile同目录(不一定非要同目录,如果放到其他地方,以下路径随着更改就行)

| FROM ./qwen7b.gguf |

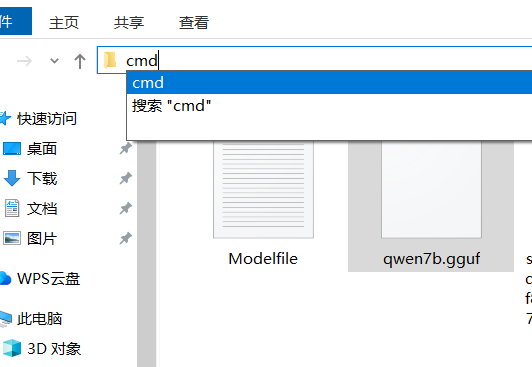

2、在Modelfile所在路径输入cmd,然后回车:

|

|

|

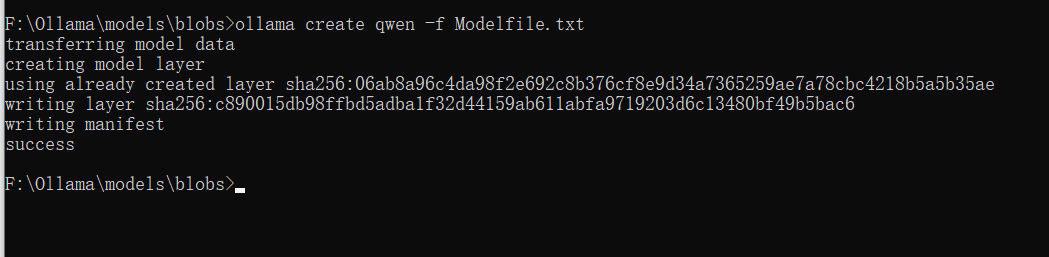

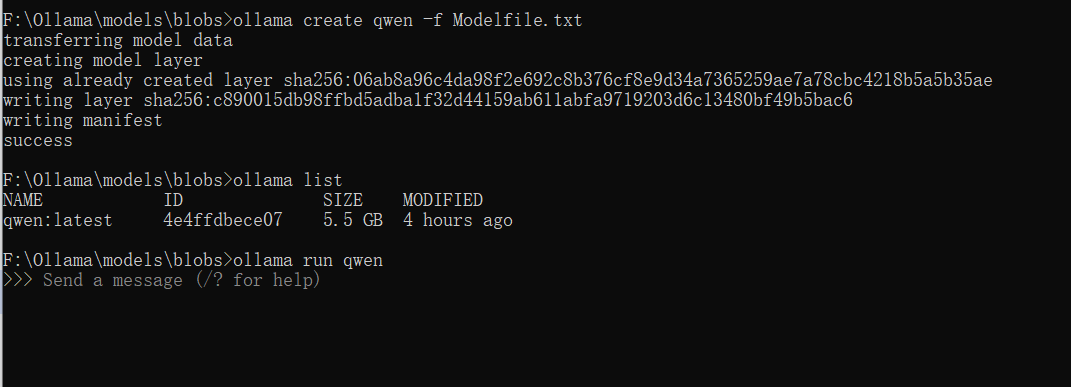

3、执行命令

| ollama create qwen -f Modelfile.txt |

等待差不多10分钟,出现success表示成功。

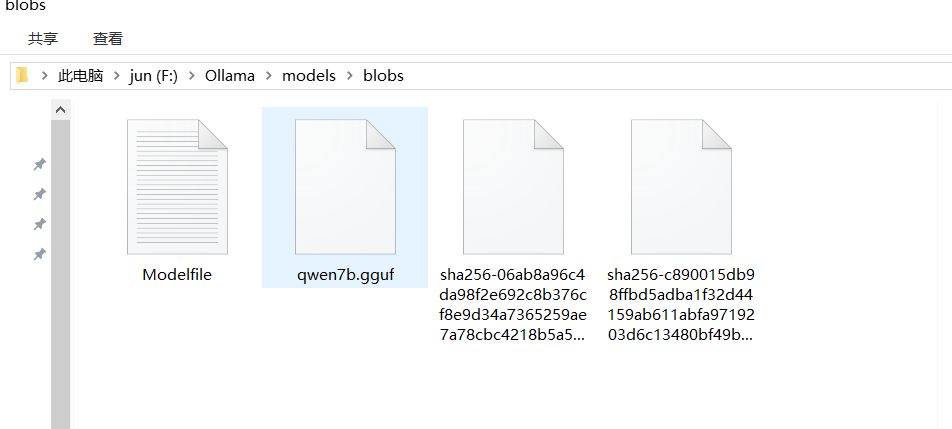

成功后的目录

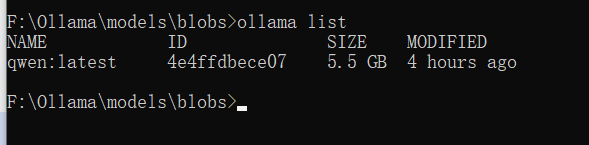

查看模型

| ollama list |

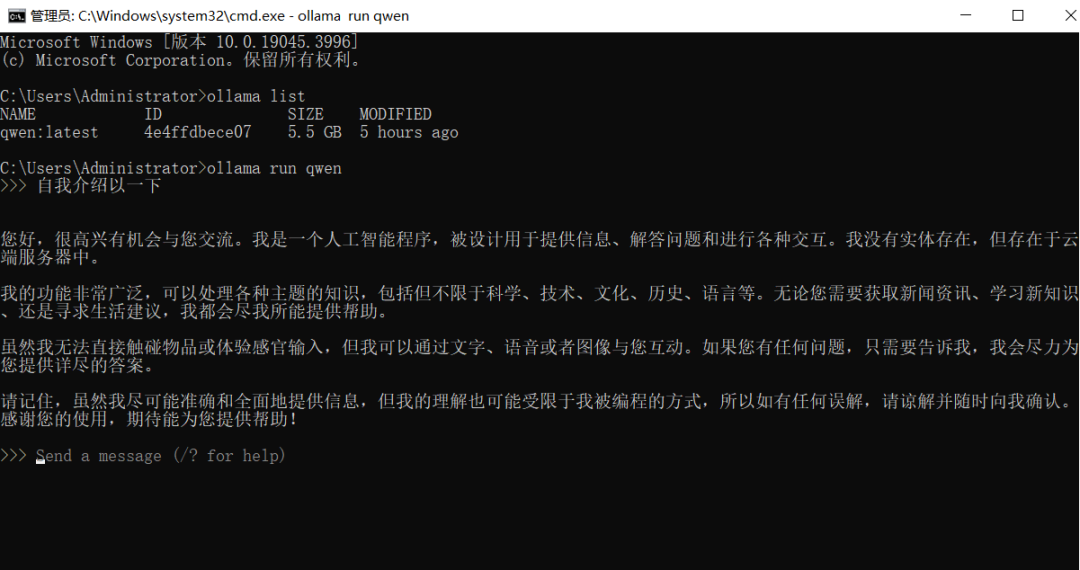

运行模型

| ollama run qwen |

运行成功的窗口如下:

这样就可以开始对话了

安装包获取

在使用的过程中会遇到很多问题,而且很多问题在网上找不到答案,因此我给大家搭建了一个环境,建了一个群,相关安装包都在里面了,专门沟通AI大模型领域,非诚勿扰!扫码请备注“大模型”,带其他目的人请走开,二维码文末名片中。

下一篇将讲解如何通过结合ollama+AnythingLLM搭建企业自己的知识库

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/从前慢现在也慢/article/detail/653555

推荐阅读

相关标签