- 1DeBERTaV3

- 2进销存ERP系统源码 基于springboot+vue开发_erp源码

- 3如何理解驱动程序、设备树、platform、device、driver之间的关系_设备树与驱动的关系

- 4XXE详解_xxe是什么

- 5李沐【动手学深度学习V2】-数据操作+数据预处理(2023.06.19)_李沐深度学习

- 6Vue项目中如何使用WebSocket编程_在vue项目中使用websocket需要安装依赖包吗

- 7web前端工资一般多少?在北京前端工程师多少钱一个月?_北京前端开发工资一般多少

- 8Android中的数据存储方式_在android中,以下哪些存储方式适合存储结构化数据,如表格数据

- 9Windows下启动RabbitMQ服务及安装详解_windows启动rabbitmq

- 10Cocos2d-x 实时动态阴影_cocos 阴影 2d 光照

llama3安装以及页面可视化_ollama3

赞

踩

llama3安装以及页面可视化

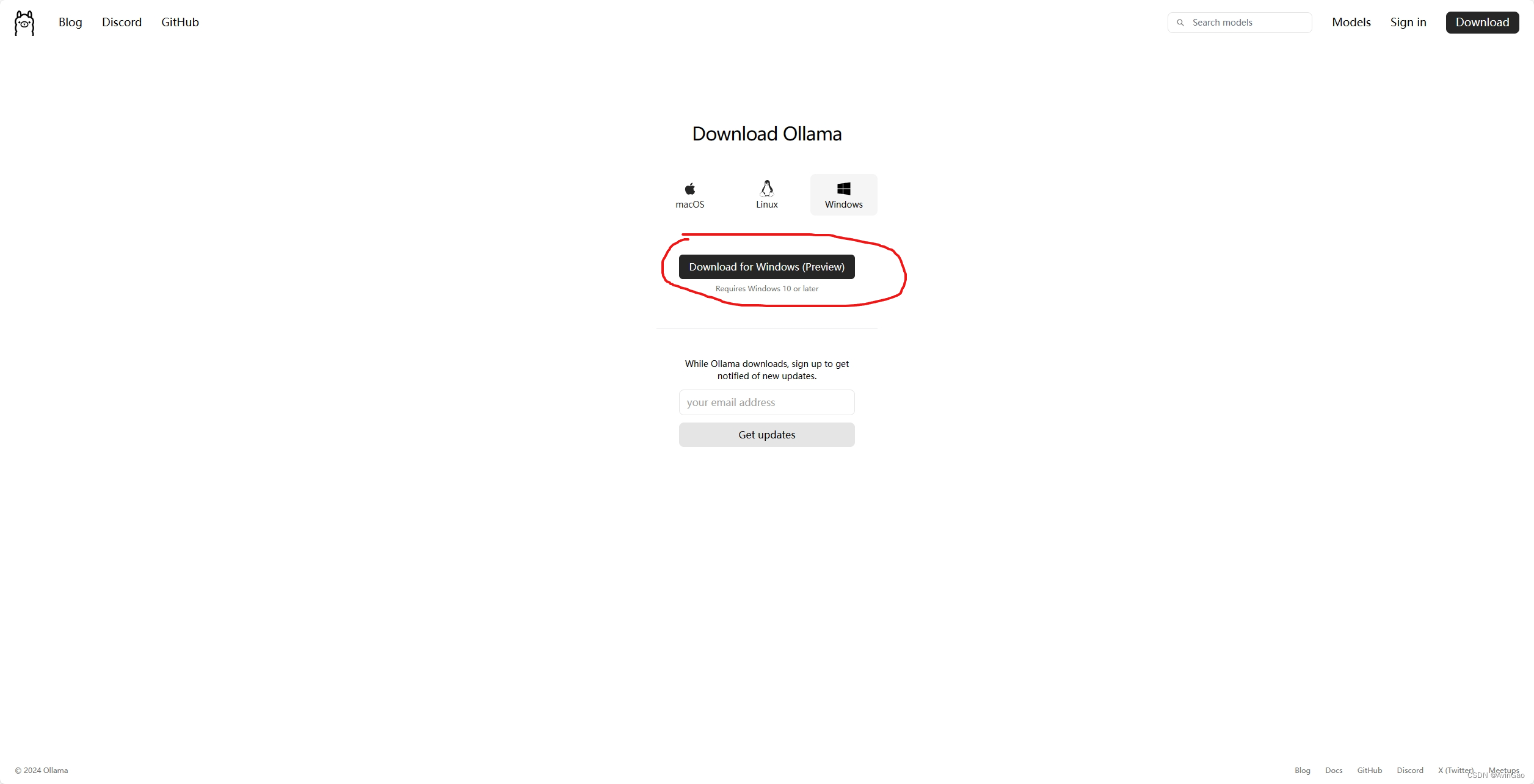

一、ollama的安装

ollama官网:https://ollama.com/

下载地址 : https://ollama.com/download

github下载: https://github.com/ollama/ollama/releases

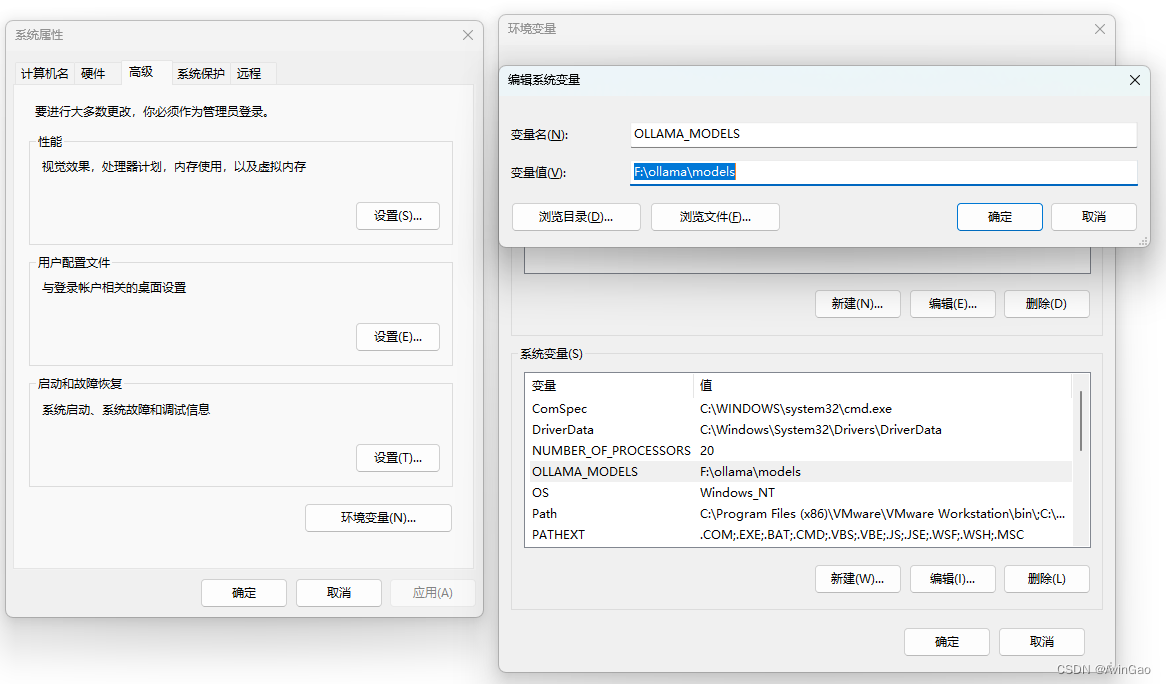

注意: 安装前可以设置模型安装的位置,最好设置下。默认会在C盘用户文件夹下的.ollama/models文件夹中

描述: 当下载好后,双击安装,点击Install就可以了。

二、下载模型并运行ollama

安装ollama以后,win + R,输入cmd,打开terminal

输入ollama,只要出现下面这些,说明安装成功了

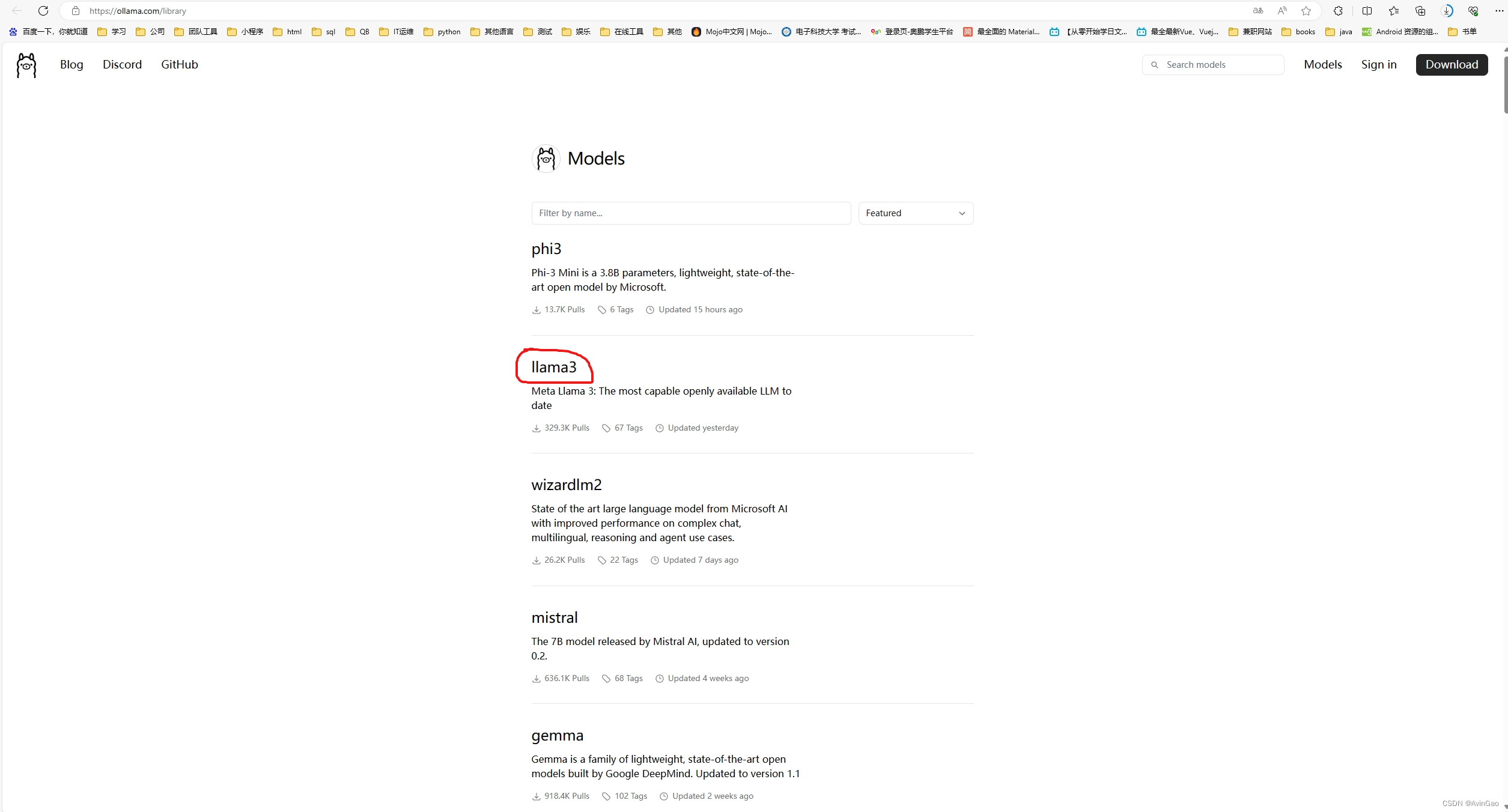

打开ollama的模型的网页:https://ollama.com/library

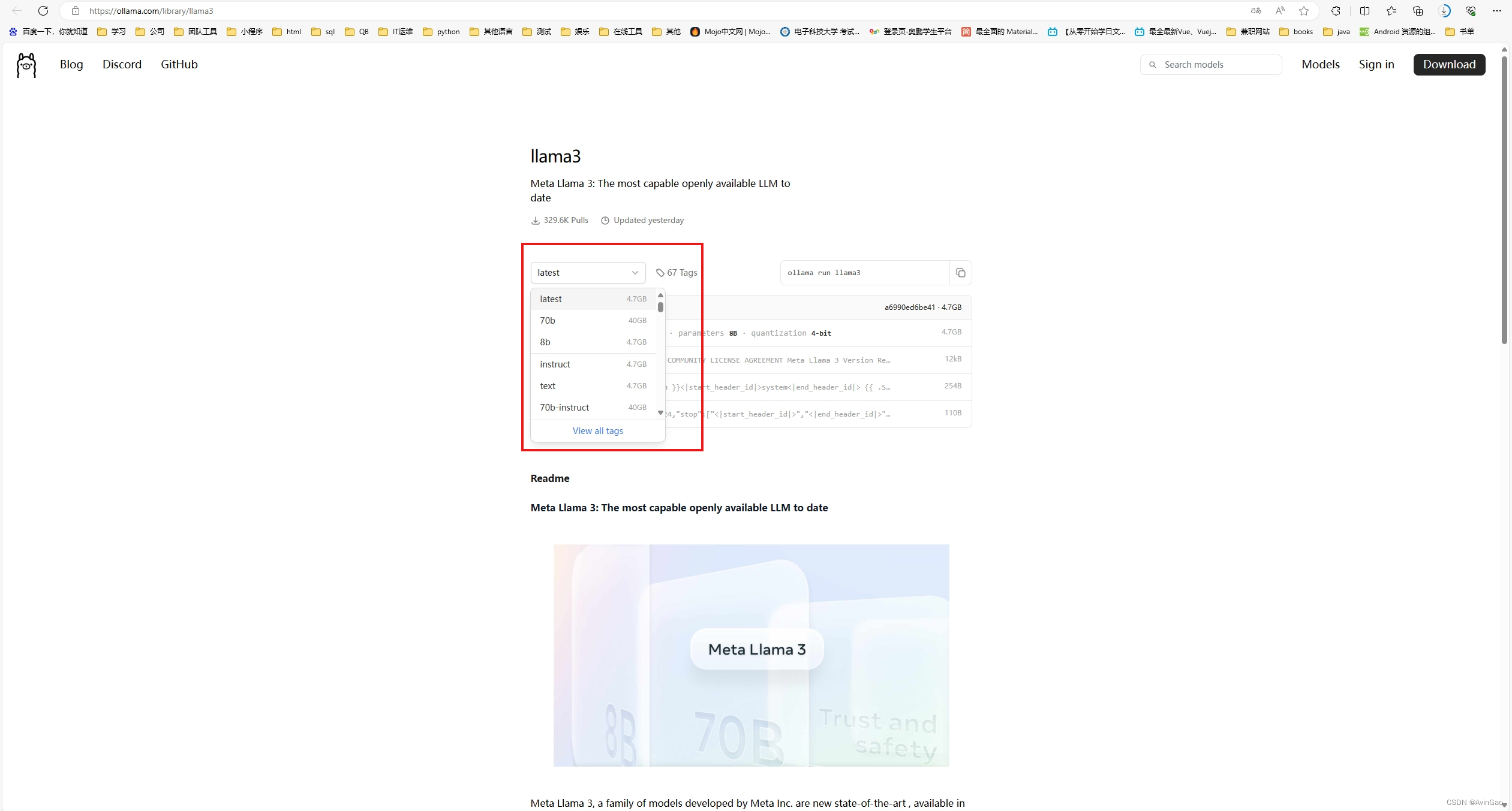

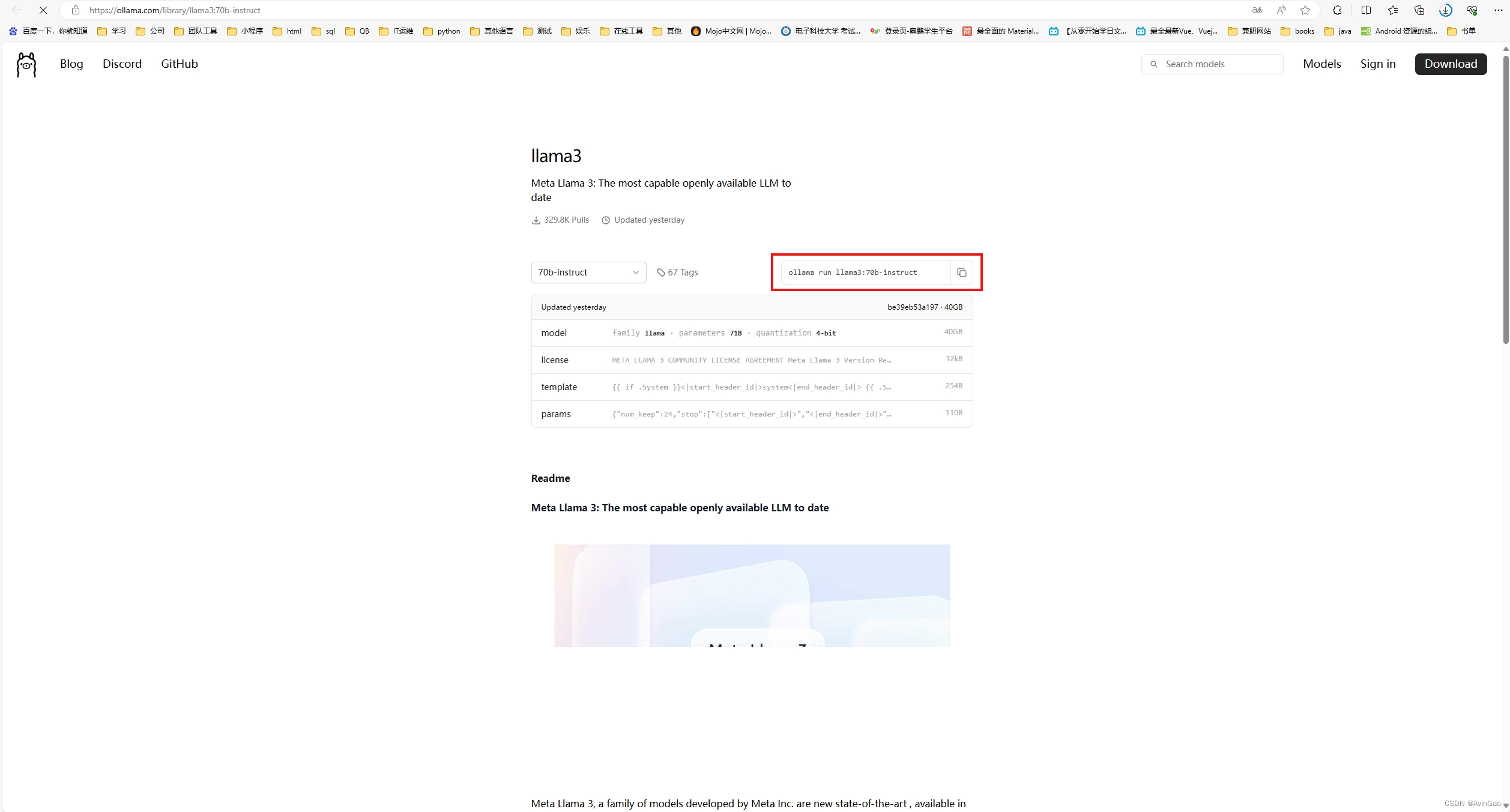

选中想要下载的模型,进入详情,以llama3举例:

根据上图选中你想要的模型,并copy下载命令。在terminal上执行。

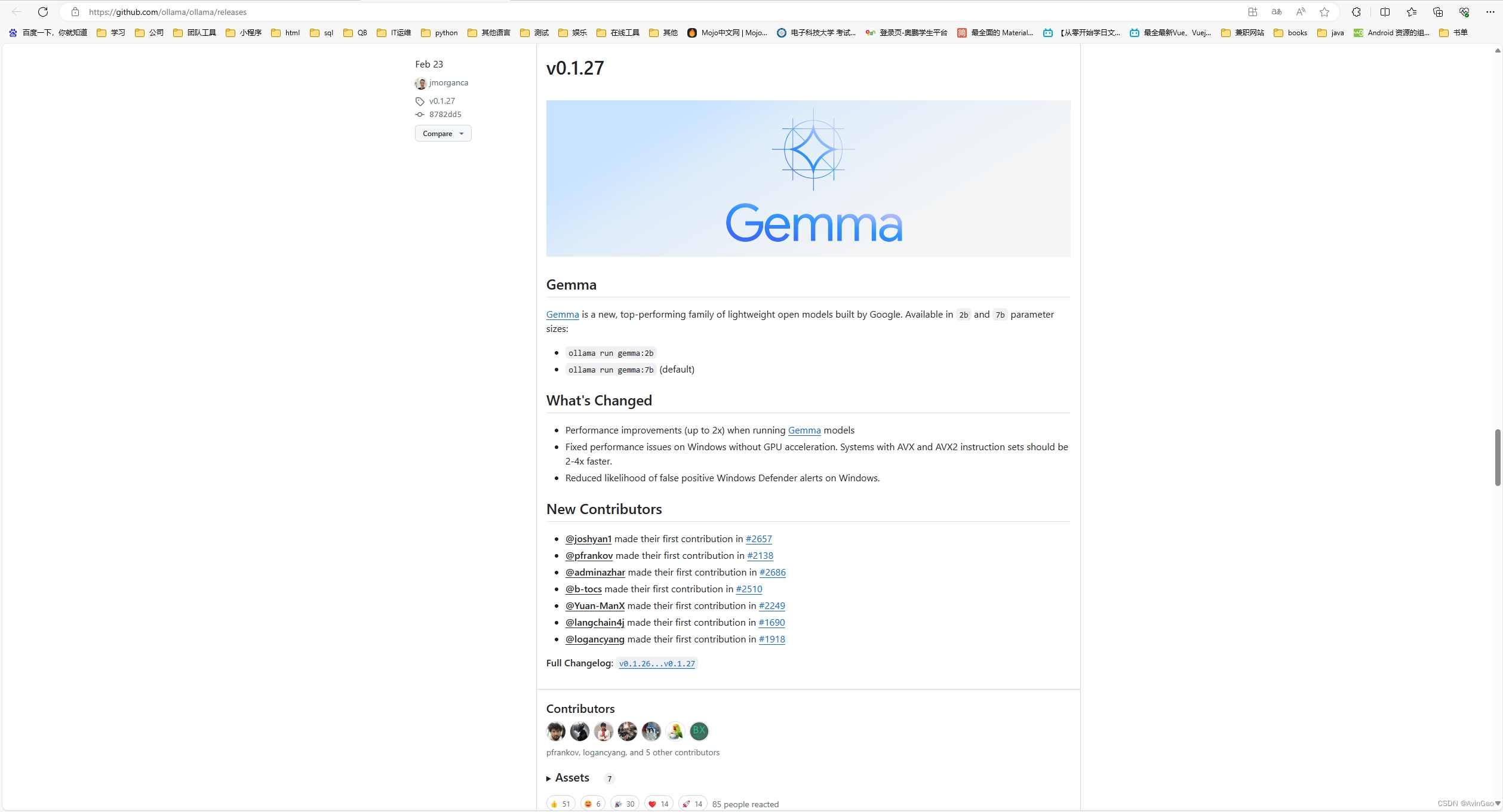

注意: 当运行命令出现下列错误时,网上又提是代理proxy的问题。但我遇到的是Ollama版本的问题,尝试下载0.1.27版本,重新下载。

pulling manifest

Error: pull model manifest: Get "https://ollama.com/token?nonce=7IvIlMJgfGMaoIrPbu6Yrw&scope=repository%!A(MISSING)library%!F(MISSING)llama3%!A(MISSING)pull&service=ollama.com&ts=1713960299": read tcp 192.168.168.101:53318->34.120.132.20:443: wsarecv: An existing connection was forcibly closed by the remote host.

- 1

- 2

当出现下列情况,就表示安装好了

三、下载并配置AngthingLLM

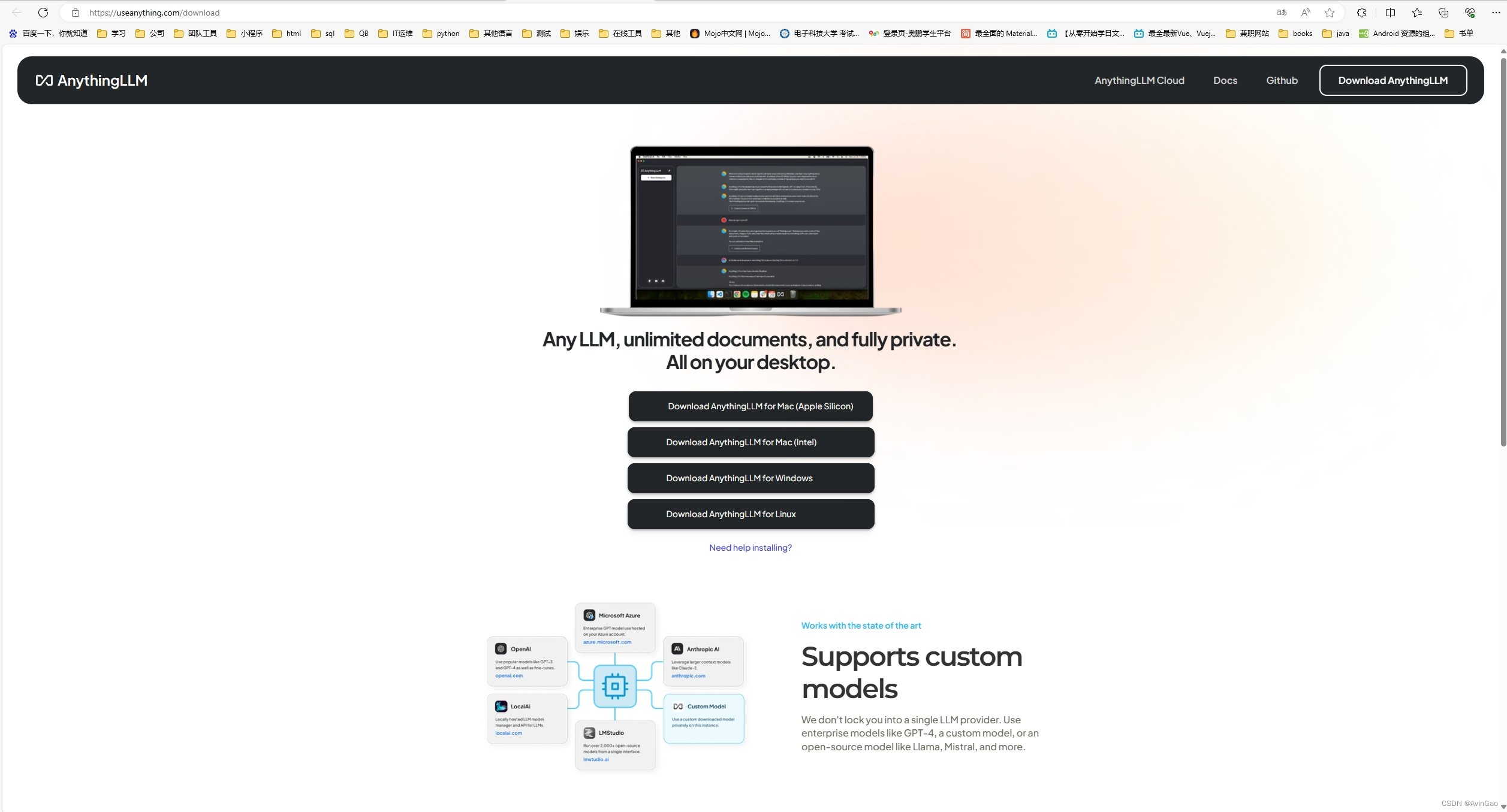

AngthingLLM官网:https://useanything.com

下载链接:https://useanything.com/download

同样的选择对应的系统版本即可

在使用前,需要启动Ollama服务

执行ollama serve,ollama默认地址为:http://127.0.0.1:11434

注意: ollama安装默认是启动的,请退出,然后再运行ollama serve

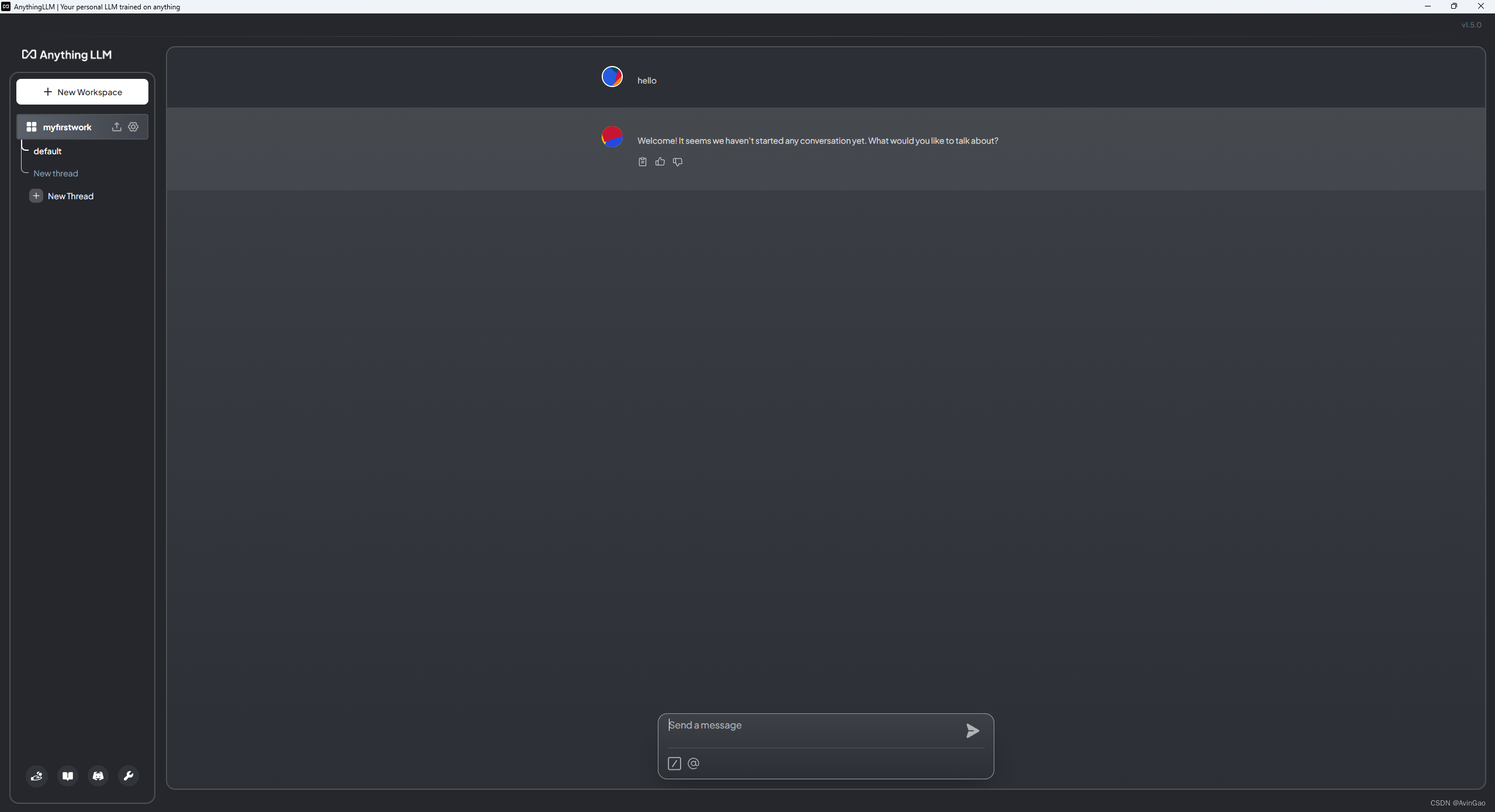

然后双击打开AngthingLLM

首先是LLM Preference,LLM provider选择ollama,URL填写默认地址,后面的模型选择llama3,token填4096

Embedding Preferenc同样选择ollama,其余基本一致,max我看默认8192,我也填了8192

Vector Database就直接默认的LanceDB即可

此时我们新建工作区,名字就随便取,在右边就会有对话界面出现了

此时你就有了自己本地的语言模型了