- 1(十)服务器K8S集群部署SpringBoot项目实战_k8s部署springboot项目

- 2yudao-cloud 怎么改为单体部署...

- 3【C++】谈谈对值传递、指针传递、引用传递的理解_c++ 值传递 指针传递

- 4模型部署 | TensorRT加速PyTorch实战教程

- 5Spring系列之集成Druid连接池及监控配置_spring.datasource.druid.min-idle

- 6Spring Data之MongoDB配置_org.springframework.data.mongodb.repository.suppor

- 7SpringBoot+SpringSecurity+Vue实现动态权限(三)_springsecurity vue 动态权限管

- 8重磅:2024QS世界大学排名发布!

- 9基于Boostrap+Html的响应式Web电影网站设计_web前端影视网站网站风格分析

- 10微服务统一认证中心_微服务认证中心

拥抱全球大模型开源生态,FlagAI+Aquila 支持多种开源高效训练推理框架

赞

踩

在大模型飞入千家万户的科技浪潮中,智源率先倡导建设大模型开源生态,建设FlagOpen大模型基础软件开源体系,构建大模型基础设施。

近期,FlagAI 与悟道·天鹰Aquila 语言模型,与 llama.cpp 、vLLM 等多个大模型开源工具和框架进行了无缝集成。为加速大模型落地,构筑全面高效的开源生态圈,迈出一步。

FlagAI 是 FlagOpen 的核心组成部分,是大模型算法、模型及工具一站式开源项目,集成了众多明星开源模型,支持主流并行训练框架及加速方法。其中亦包括悟道·天鹰(Aquila), 国内首个开源可商用语言大模型系列。

-

极高的灵活性和可扩展性是开源的一大魅力。通过支持 llama.cpp ,FlagAI+Aquila 可以在消费级计算资源上进行推理,降低大模型使用门槛,消除“望参数量而却步”的顾虑,从而激励更多个体参与到大模型应用开发浪潮之中。

-

高效推理已成为大模型应用的基础性要求。Aquila 与 vLLM 加速推理框架实现兼容,大大提升了Aquila 的推理速度,相比 HuggingFace Transformers 提升1.2倍。也进一步优化了Aquila 的使用体验,拓宽其在各个场景下的应用边界。

建设开源开放的大模型技术生态不仅将推动 FlagAI+Aquila 自身的快速发展,提升其在全球的竞争力,更为整个AI开发者社区注入新的活力,让 FlagAI+Aquila 能够更为灵活地适应各种不同的应用场景和用户需求。

用llama.cpp加速AquilaChat推理,可在苹果M1上运行

神经网络的推理代码通常用 Python 语言编写。但相比于Python,C/C++ 代码运行速度更快,因此一些开发者尝试用 C/C++ 语言实现神经网络。资深开源开发者 Georgi Gerganov 用纯 C/C++ 语言框架构建的开源项目 llama.cpp 近期走红。

llama.cpp ,无需GPU也能运行Meta的Llama 模型,甚至在 MacBook 和树莓派上也可以运行Llama,让没有高级GPU的开发者在家就能动手把玩大模型。

llama.cpp有多个对开发者非常友好的特点:

-

无需任何额外依赖,相比 Python 代码对 PyTorch 等库的要求,C/C++ 直接编译出可执行文件,跳过不同硬件繁杂的准备流程;

-

支持 Apple Silicon 芯片的 ARM NEON 加速;

-

具有 F16 和 F32 的混合精度;

-

支持 4-bit 量化;

又一个值得开发者关注的好消息来了:悟道·天鹰(Aquila)已兼容 llama.cpp。开发者可通过 llama.cpp 享受 Aquila 系列模型的极速推理体验。实测可在苹果电脑 M1 芯片上运行~

值得注意的是,Aquila 与 Llama 结构不同,其 tokenizer 基于 BPE 格式,为此我们在 llama.cpp 增加了vocabtype 新特性(PR#2487 已被 llama.cpp 官方合并),开发者在使用 llama.cpp 加速 Aquila 推理时,指定 bpe 即可,无需更多改动。

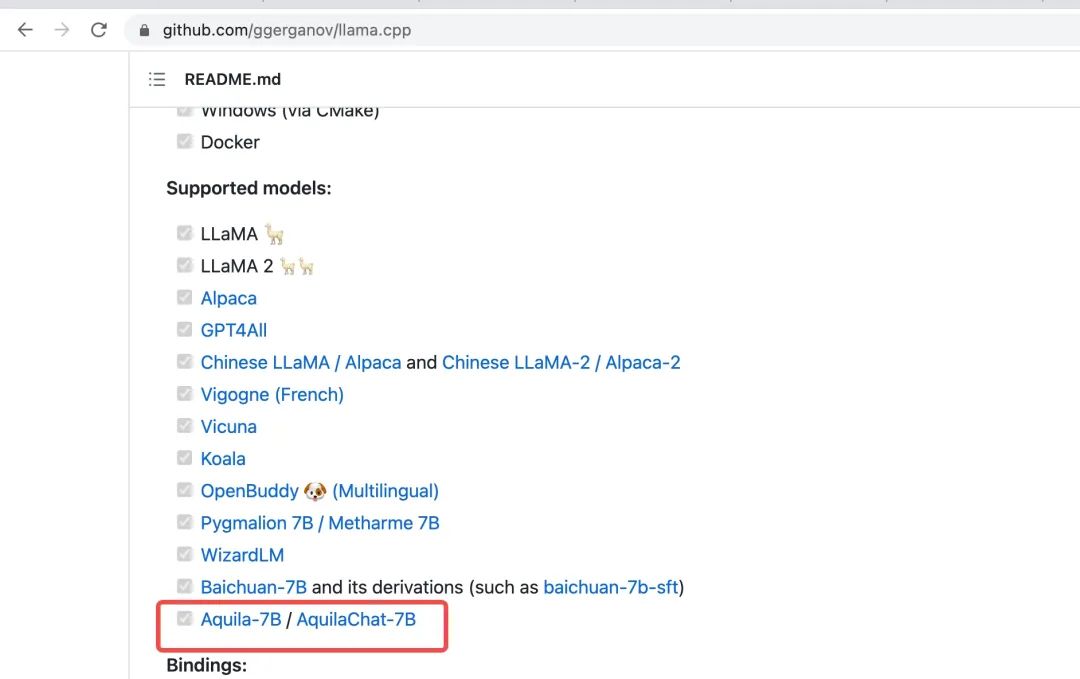

llama.cpp 官方 README 中已更新对 Aquila 模型的支持

查看详细操作步骤:

https://zhuanlan.zhihu.com/p/648893557

用 vLLM 加速 Aquila-7B 推理速度提升1.2倍

vLLM 是伯克利大学 LMSYS 组织开源的大语言模型高速推理框架,可极大提升实时场景下的 LLM 服务的吞吐与内存使用效率。

vLLM 主要采用 Paged Attention 技术,结合 Continuous Batching,对传入请求进行持续分批处理,同时优化 CUDA 内核。vLLM 的灵活性和易用性利于开发者构建高吞吐量的大语言模型服务,其支持流式输出,支持单机多卡、分布式并行推理。

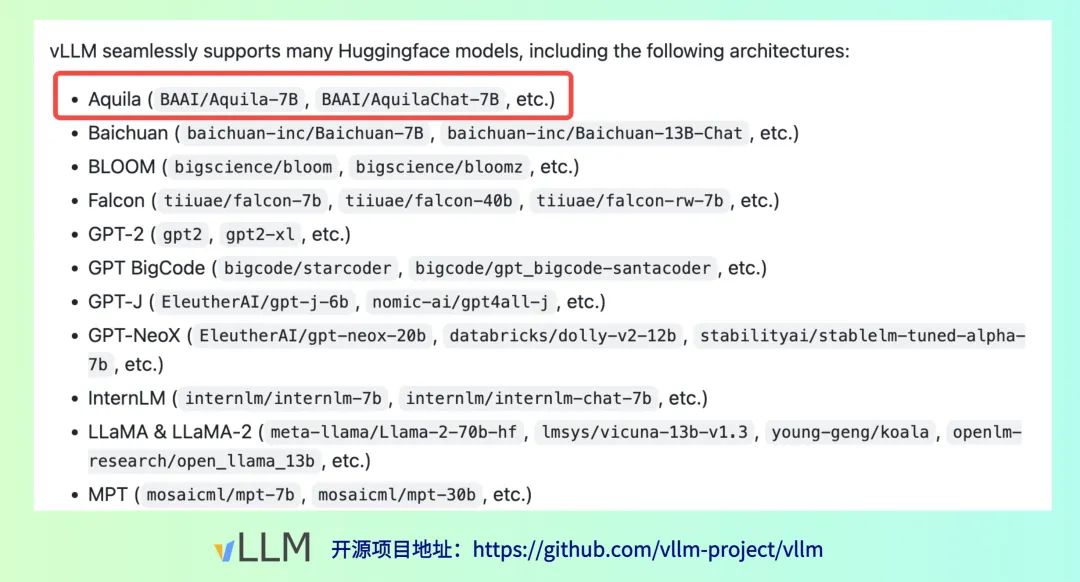

目前,vLLM 官方已支持 Aquila-7B 模型,推理速度大幅提升。

举例:输入“请给出10个要到北京旅游的理由”:

实测结果显示,AquilaChat-7B 使用 vLLM 推理速度相比 HuggingFace Transfomers 提升了 1,2倍。

| 推理方式 | 速度 | 内存 | 参数 |

| HuggingFace Transformers | 30.11 tokens/秒 | 29.22 GB | Max length 1000 |

| vllm | 65.06 tokens/秒 | 34.04 GB | Max length 1000 |

查看详细操作步骤:

https://zhuanlan.zhihu.com/p/652759799

智源 FlagOpen 大模型开源技术生态包含大模型算法、模型、数据、工具、评测等重要组成部分,例如 FlagEval 多领域、多维度大模型评测体系、FlagPerf 面向多种AI硬件的一体化评测引擎、FlagData 大模型数据处理工具集等。

欢迎各科研单位、企业与智源共建,一起打造大模型时代的新“Linux 生态”。