机器学习(第一天)

赞

踩

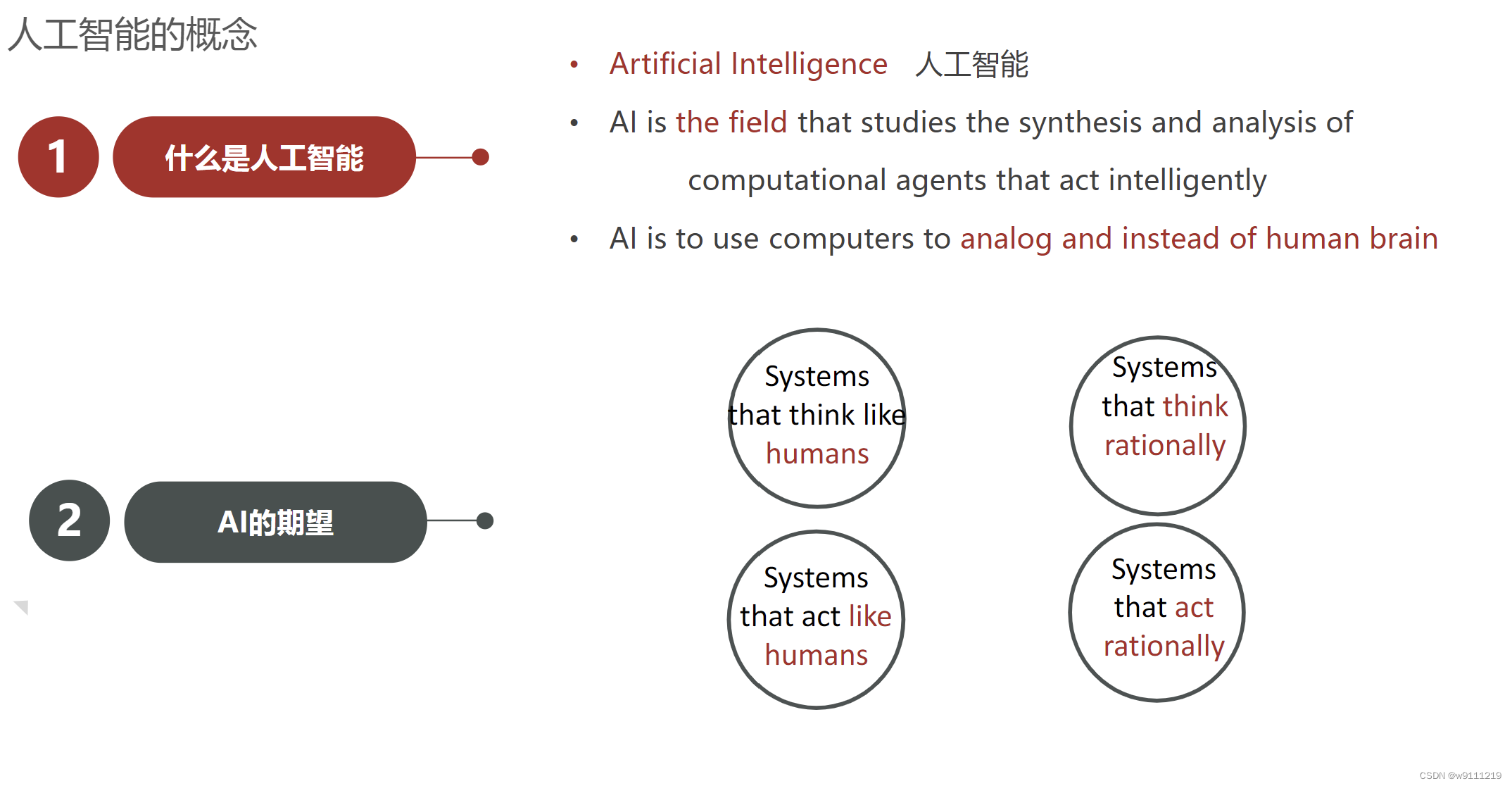

一.◆人工智能三大概念

人工智能(AI):仿智,使用计算机来模拟或者代替人类

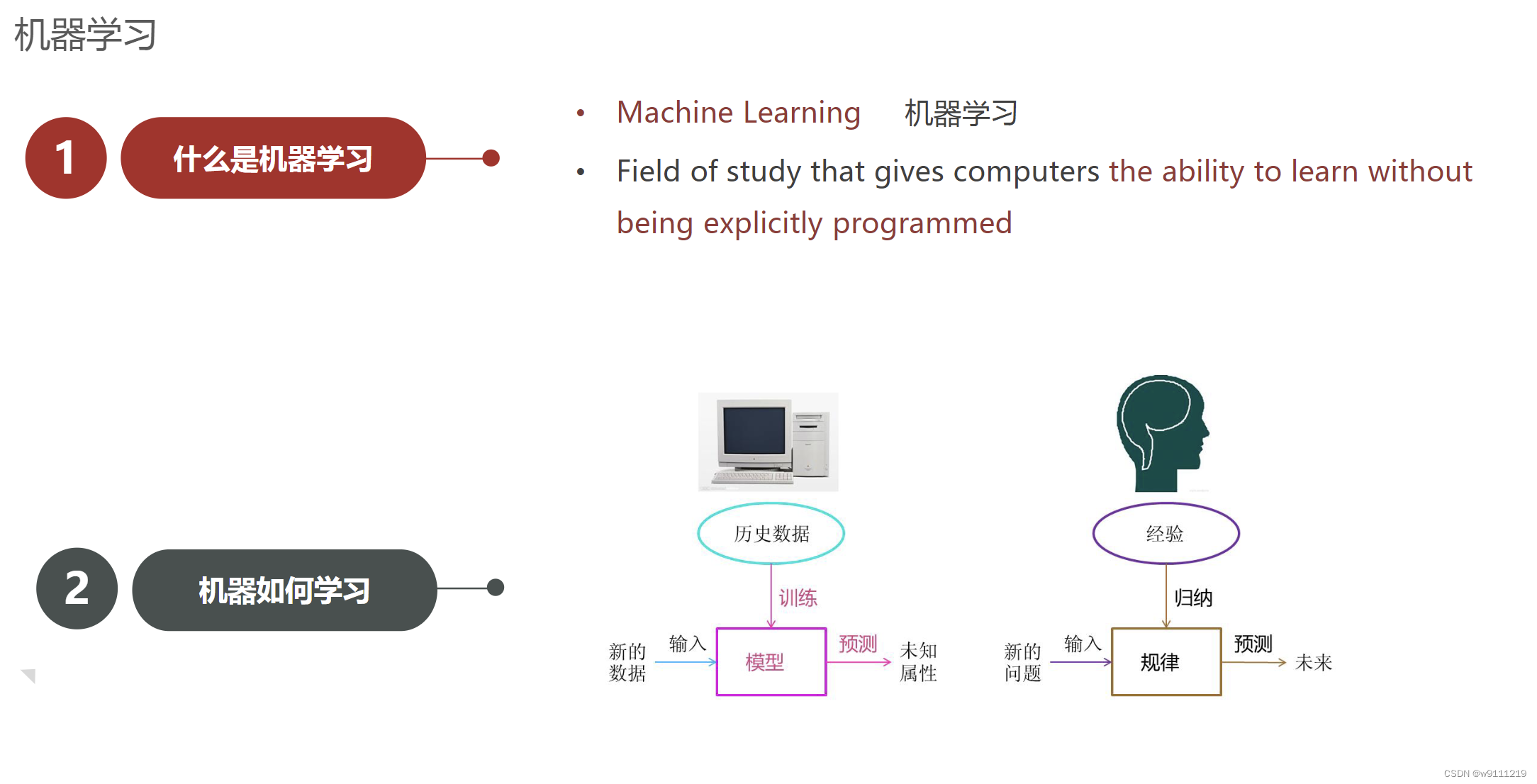

机器学习(ML):机器自动学习,不是人为规则编程

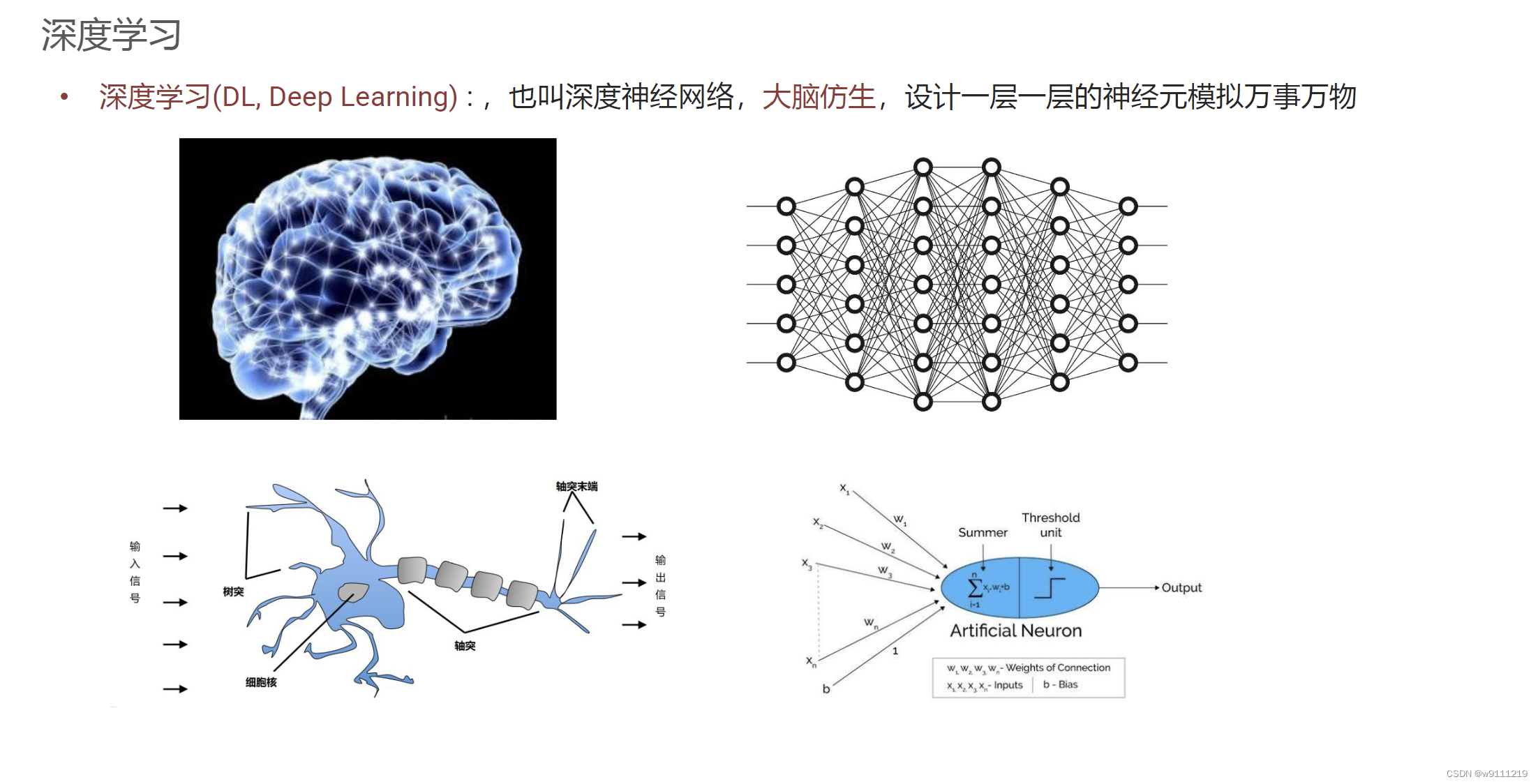

深度学习(DL):大脑仿生,设计一层一层的神经元模拟万事万物

◆ 机器学习的应用领域和发展史

机器学习最早可以追溯到对人工神经网络的研究。1943年,Warren McCulloch和Wallter Pitts提出了神经网络层次结构模型[1],确立了神经网络的计算模型理论,从而为机器学习的发展奠定了基础。1950年,“人工智能之父”图灵提出了著名的“图灵测试”,使人工智能成为了科学领域的一个重要研究课题。

1957年,康奈尔大学教授Frank Rosenblatt提出了Perceptron概念,并且首次用算法精确定义了自组织自学习的神经网络数学模型,设计出了第一个计算机神经网络。这个机器学习算法成为了神经网络模型的开山鼻祖[2]。1959年美国IBM公司的A.M.Samuel设计了一个具有学习能力的跳棋程序,曾经战胜了美国保持8年不败的冠军。这个程序向人们初步展示了机器学习的能力。

1962年,Hubel和Wiesel发现了猫脑皮层中独特的神经网络结构可以有效降低学习的复杂性,从而提出著名的Hubel-Wiese生物视觉模型,这之后提出的神经网络模型均受此启迪。

1969年,人工智能研究的先驱者Marvin Minsky和Seymour Papert出版了对机器学习研究有深远影响的著作《Perceptron》,其中对于机器学习基本思想的论断:解决问题的算法能力和计算复杂性,影响深远且延续至今。

1980年夏,在美国卡内基梅隆大学举行了第一届机器学习国际研讨会,标志着机器学习研究在世界范围内兴起。1986年,《Machine Learning》创刊,标志着机器学习逐渐为世人瞩目并开始加速发展。

1986年,Rumelhart,Hinton和Williams联合在《自然》杂志发表了著名的反向传播算法(BP)。1989年,美国贝尔实验室学者Yann和LeCun教授提出了目前最为流行的卷积神经网络(CNN)计算模型,推导出基于BP算法的高效训练方法,并成功地应用于英文手写体识别。

进入90年代,多浅层机器学习模型相继问世,诸如逻辑回归,支持向量机等,这些机器学习算法的共性是数学模型为凸代价函数的最优化问题,理论分析相对简单,容易从训练样本中学习到内在模式,来完对象识别,人物分配等初级智能工作。

2006年,机器学习领域泰斗Geoffrey Hinton和Ruslan Salakhutdinov发表文章[3],提出了深度学习模型。主要论点包括:多个隐层的人工神经网络具有良好的特征学习能力;通过逐层初始化来克服训练的难度,实现网络整体调优。这个模型的提出,开启了深度网络机器学习的新时代。2012年,Hinton研究团队采用深度学习模型赢得了计算机视觉领域最具有影响力的ImageNet 比赛冠军,标志着深度学习进入第二阶段。

深度学习近年来在多个领域取得了令人赞叹的成绩,推出了一批成功的商业应用,诸如谷歌翻译,苹果语音工具siri,微软的Cortana个人语音助手,蚂蚁金服的Smile to Pay扫脸技术[4]。特别是2016年3月,谷歌的AlphaGo与围棋世界冠军、职业九段棋手李世石进行围棋人机大战,以4比1的总比分获胜。2017年10月18日,DeepMind团队公布了最强版AlphaGo,代号AlphaGo Zero,它能在无任何人类输入的条件下,从空白状态学起,自我训练的时间仅为3天,自我对弈的棋局数量为490万盘,能以100:0的战绩击败前辈。

◆ 机器学习常用术语

样本、特征、标签、训练集和测试集

一行数据就是一个样本,多个样本组成一个数据集

一列数据就是一个特征,有时也被称为特征

模型要预测的那一列数据成为目标或标签

◆ 机器学习算法分类

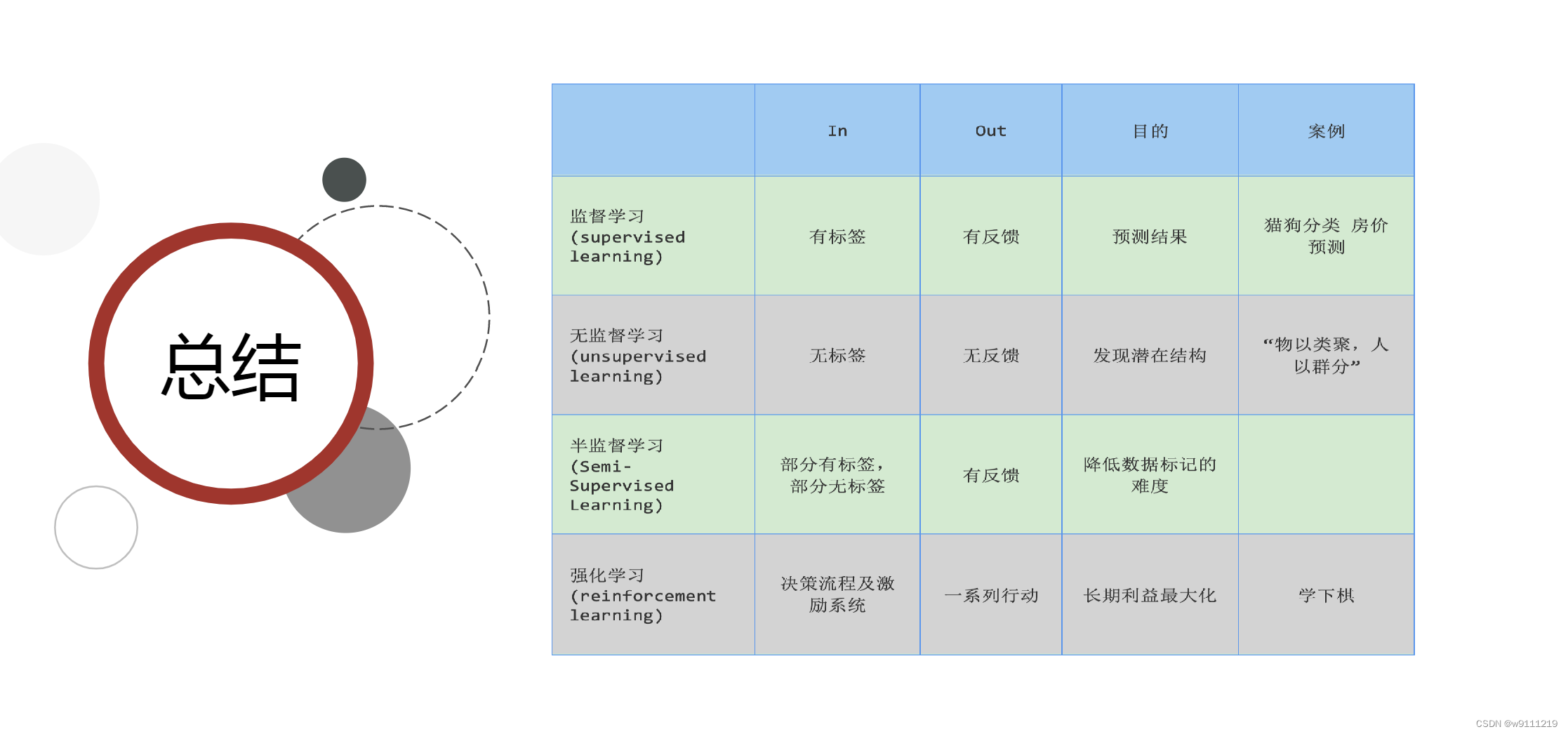

有监督学习、无监督学习、半监督、强化学习

监督学习目标值连续:回归 目标值离散:分类

无监督学习:无目标值,根据样本的特征进行聚类

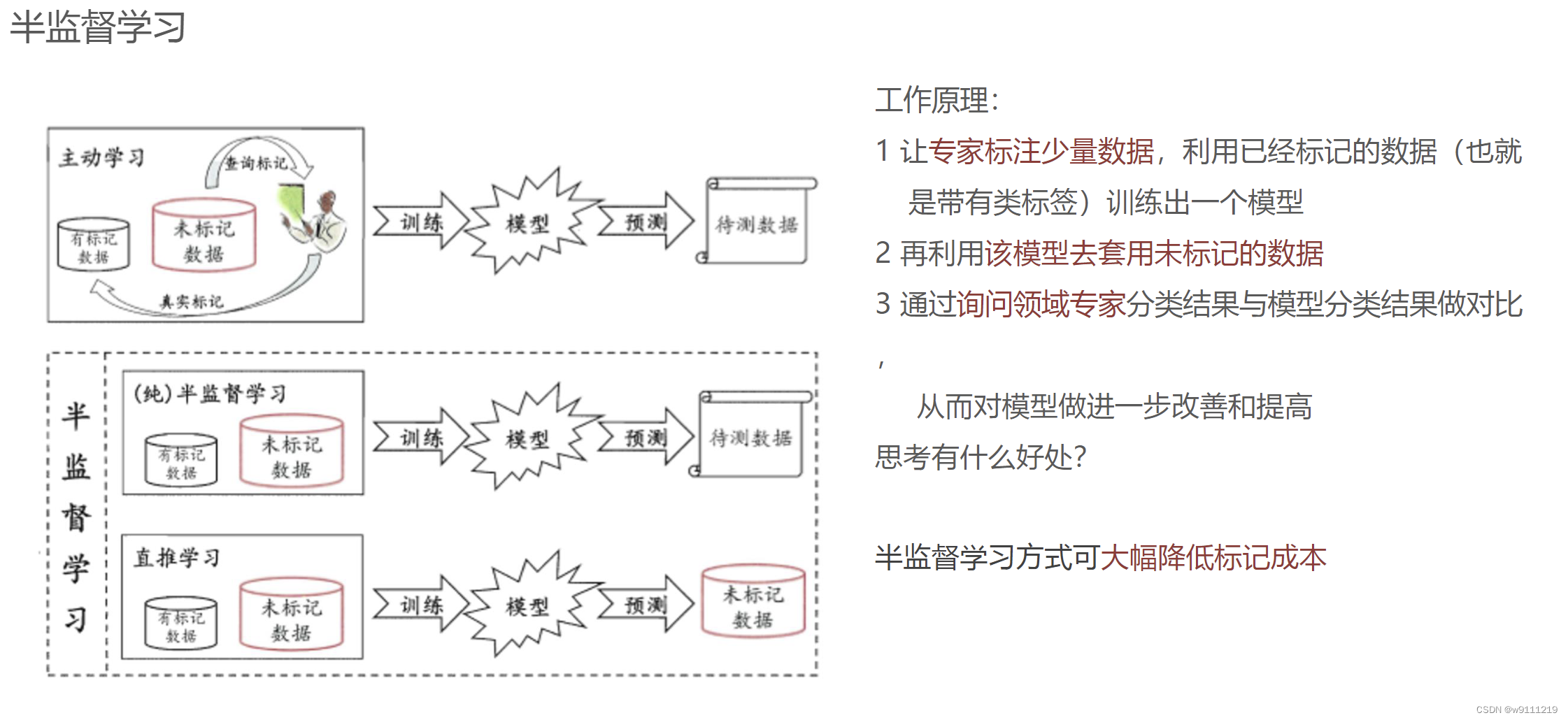

半监督学习:部分有目标值,部分没有目标值

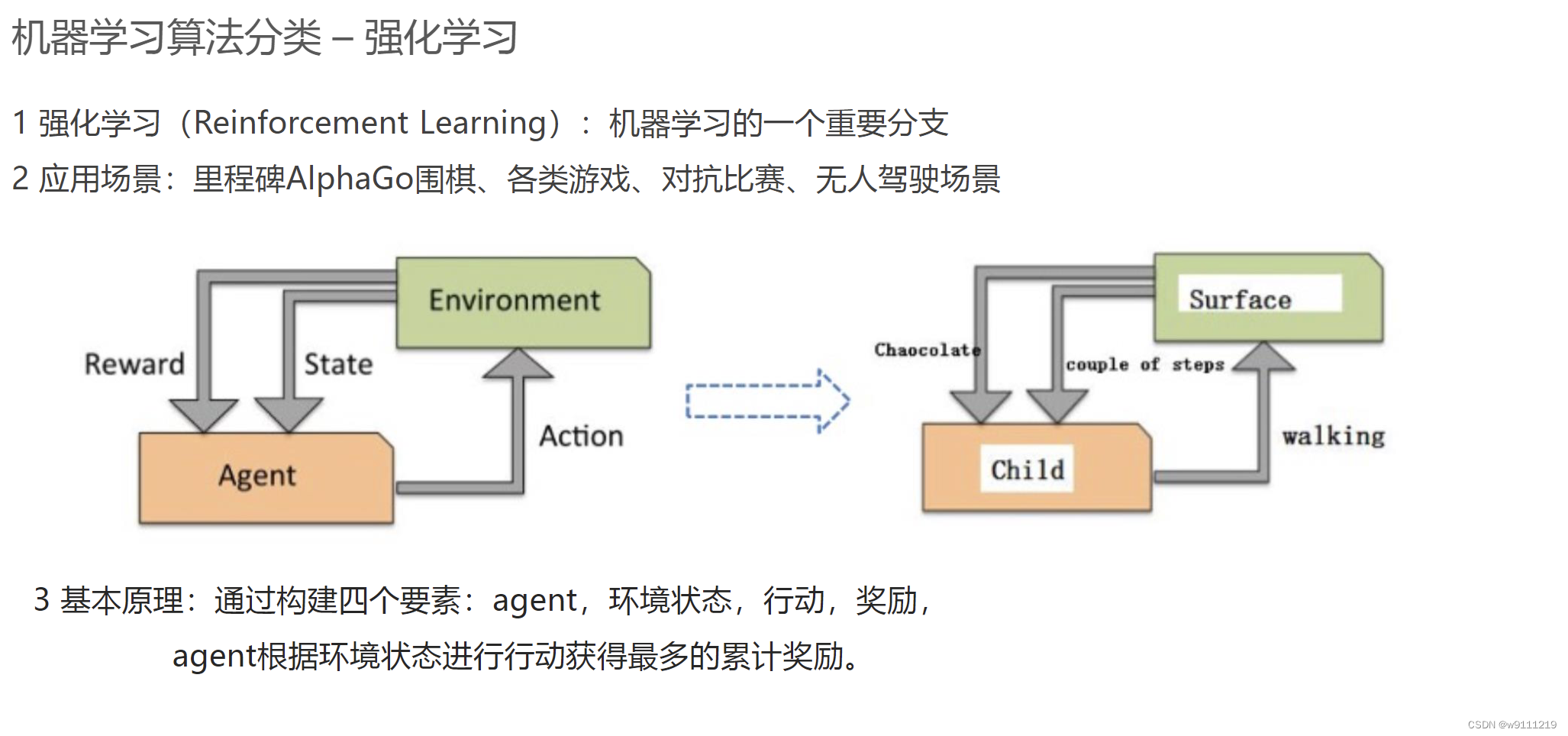

强化学习:目的是获得更多奖励,进行一系列决策过程