热门标签

热门文章

- 1python爬取B站视频_python爬b站电影

- 2第三代人工智能基础设施背后,是一次技术应用的常识普及运动

- 3【华为2021校招】笔试题【通用硬件】_华为硬件先进制造笔试

- 4.net core 3.1 使用Apollo进行配置_c# apollo

- 5数组算法——查询位置

- 6文心一言4.0用来论文降重怎么样 神码ai_文心一言4.0写论文怎么样

- 7修改yolov5的detect层,提高Triton推理服务的性能_yolov5多层detect

- 8axios 完整封装_axios封装

- 9顺序栈操作清空,销毁,入栈,判断栈空操作_动态数组顺序栈清空

- 10红黑树----原理及详细实现过程_红黑树原理是什么?建立过程?

当前位置: article > 正文

openai-translator 通过open api 使用本地LLM模型_openai translator如何使用

作者:很楠不爱3 | 2024-04-21 17:56:59

赞

踩

openai translator如何使用

@ 使用openai translator 配置本地大模型进行离线翻译。

1、下载并安装 chrome 插件 openai-translator. https://github.com/openai-translator/openai-translator/releases/tag/v0.3.25

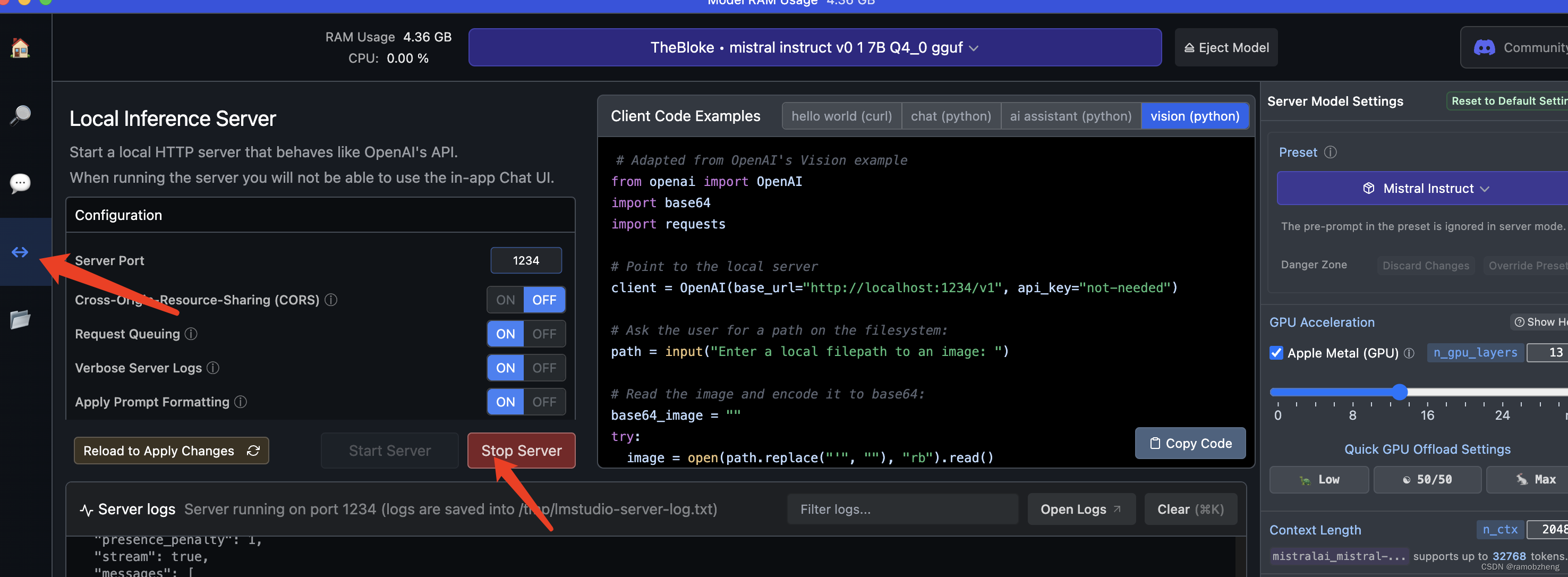

2、在 LM studio 中的Local Server 启动 本地大模型服务。以 Qwen-7B 大模型作为示例;(也可以通过ollama 启动本地大模型)

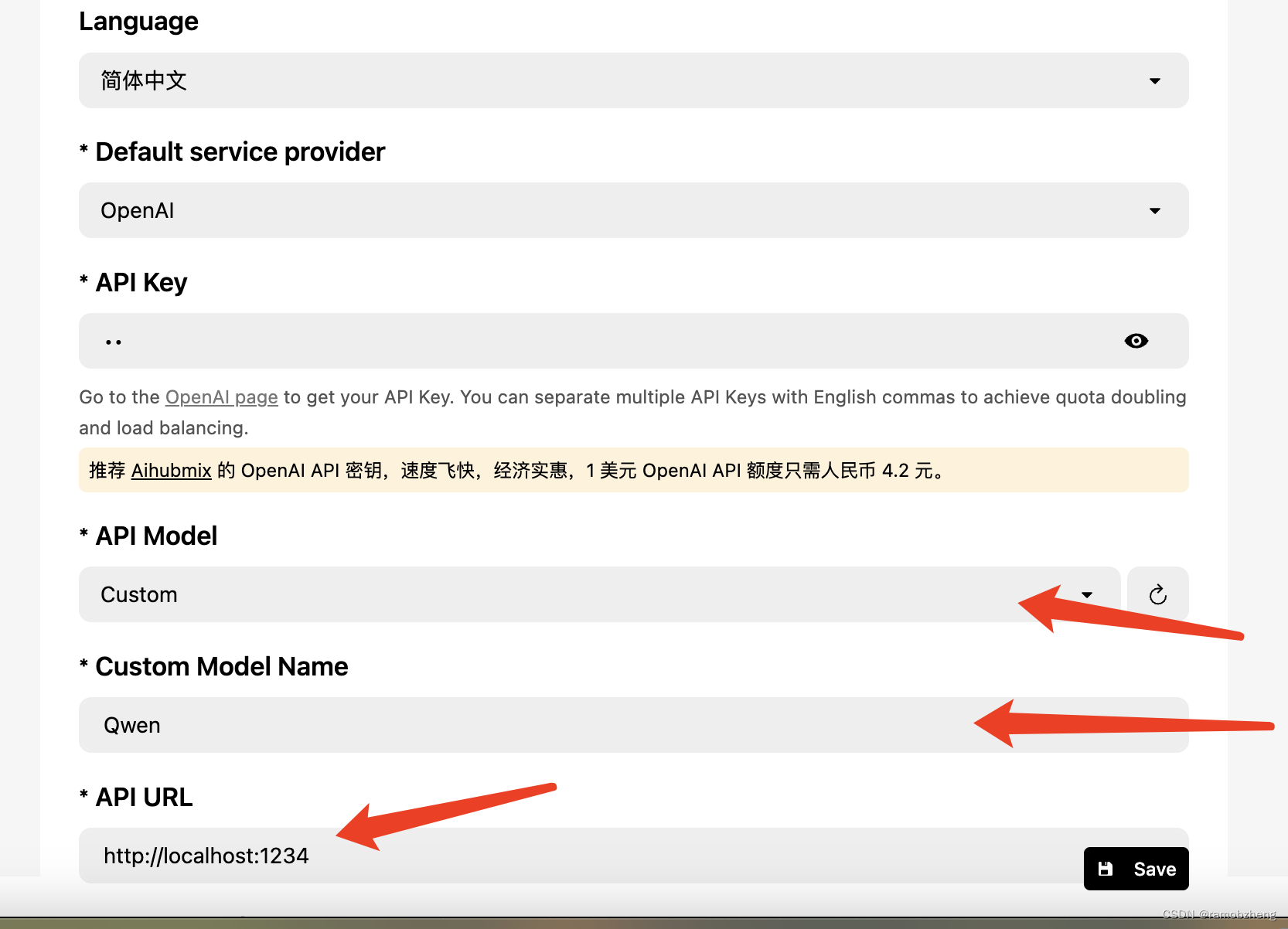

3、在openai-translator 配置使用本地LLM。

API Model 选择 Custom,Custom Model Name 填写你启动的模型,此次示例填写 Qwen。API URL填写你启动的服务地址和端口,本处以 http://localhost:1234 作为示例。选择保持后即可开始使用 openai translator进行文章翻译等功能。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/很楠不爱3/article/detail/464378

推荐阅读

相关标签