- 1保姆级教程!Golang微服务简洁架构实战

- 2经典机器学习算法:逻辑斯谛回归

- 3git 更新远程代码到本地仓库_git更新远程代码到本地

- 4红外的初识(NEC协议)

- 5考试专用计算机6,6所双非计算机强校,评估都是c-类,性价比高,不到500分就可考取...

- 6MacOS 配置JDK和Maven_mac系统java和maven合并配置path

- 7寻找工作的意义——《你在为谁工作》读后感

- 8Stripe支付,国外支付Stripe、跨境支付_微信小程序对接stripe支付

- 9Nature重磅综述|2022年最新生物信息学,你想知道的都在这里!

- 10appium安装及初级使用(mac电脑,python)_appium uiautomator2在mac上显示图标

Python爬虫必备!教你如何使用Beautiful Soup解析网页_soup 解析

赞

踩

如果你是一个Python开发者,你一定会涉及到从网页上提取数据的问题。那么你可能会问:“如何用Python从网页上提取数据?”

解决这个问题的一个好的方法是使用Beautiful Soup库。本文将介绍如何使用Beautiful Soup库解析HTML和XML文档,如何使用CSS选择器来查找元素,以及如何从网页上提取数据。

什么是Beautiful Soup库?

Beautiful Soup库是一个Python库,用于从HTML和XML文档中提取数据。它能够自动将输入文档转换为Unicode编码,因此你不必担心编码问题。此外,它还能够处理坏的HTML和XML文档。

解析HTML文档

Beautiful Soup库最常用的功能之一是解析HTML文档。解析HTML文档通常涉及两个步骤:首先,使用Python的请求库从网络上下载HTML文档,然后使用Beautiful Soup库解析文档。

以下是一段使用Beautiful Soup库解析HTML文档的代码示例:

import requests

from bs4 import BeautifulSoup

url = "https://www.python.org/"

html = requests.get(url).text

soup = BeautifulSoup(html, "html.parser")

print(soup.prettify())

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

这段代码使用Python的请求库从Python官网下载HTML文档,并使用Beautiful Soup库将其解析。最后,使用prettify()方法来美化输出的结果。

使用CSS选择器查找元素

Beautiful Soup库还提供了一个简单而强大的CSS选择器系统,可以使用类似于jQuery的语法来查找元素。通过使用CSS选择器,你可以很容易地查找特定类型的元素,例如所有段落元素或所有链接元素。

以下是使用CSS选择器查找元素的代码示例:

import requests from bs4 import BeautifulSoup url = "https://www.python.org/" html = requests.get(url).text soup = BeautifulSoup(html, "html.parser") # 通过标签名查找元素 print(soup.select("title")) # 通过类名查找元素 print(soup.select(".shrubbery")) # 通过ID查找元素 print(soup.select("#documentation")) # 通过属性名和属性值查找元素 print(soup.select('a[href^="/events/python-events"]'))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

这个例子中,我们使用了四种不同类型的CSS选择器:标签选择器、类选择器、ID选择器和属性选择器。在这个例子中,我们查找了Python官网页面上的四个元素。

提取数据

解析HTML文档和使用CSS选择器查找元素只是第一步。接下来的问题是如何从元素中提取有用的数据。

以下是使用Beautiful Soup库从网页中提取数据的代码示例:

import requests from bs4 import BeautifulSoup # 指定要抓取的网页URL url = "https://www.example.com" # 发送HTTP请求并获取响应内容 response = requests.get(url) html = response.text # 解析HTML内容 soup = BeautifulSoup(html, 'html.parser') # 查找目标元素并提取数据 title_element = soup.find('title') # 查找网页标题元素 title = title_element.text # 提取网页标题 print("Title: ", title) links = soup.select('a[href]') # 查找所有链接元素 for link in links: link_url = link['href'] # 提取链接URL link_text = link.text # 提取链接文本 print("Link URL: ", link_url) print("Link Text: ", link_text)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

以上代码会抓取指定的网页,解析HTML内容,并从中提取出网页标题和所有链接,将它们打印到控制台上。

技术总结

在本文中,我们介绍了Beautiful Soup库的基本知识,包括解析HTML文档、使用CSS选择器查找元素以及从网页中提取数据。通过使用Beautiful Soup库,你可以轻松地从网页上提取数据,无论是从单个页面还是整个网站。希望这篇文章能够帮助你开始使用Beautiful Soup库,提取网页数据。

在本文中,我们介绍了Beautiful Soup库的基本知识,包括解析HTML文档、使用CSS选择器查找元素以及从网页中提取数据。通过使用Beautiful Soup库,你可以轻松地从网页上提取数据,无论是从单个页面还是整个网站。希望这篇文章能够帮助你开始使用Beautiful Soup库,提取网页数据。

如果你对Python技术比较感兴趣,这里给大家分享一份Python全套学习资料,都是我自己学习时整理的,整理不易,请多多点赞分享哦~

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、Python学习软件

工欲善其事,必先利其器。学习Python常用的开发软件都在这里了!

三、Python入门学习视频

还有很多适合0基础入门的学习视频,有了这些视频,轻轻松松上手Python~

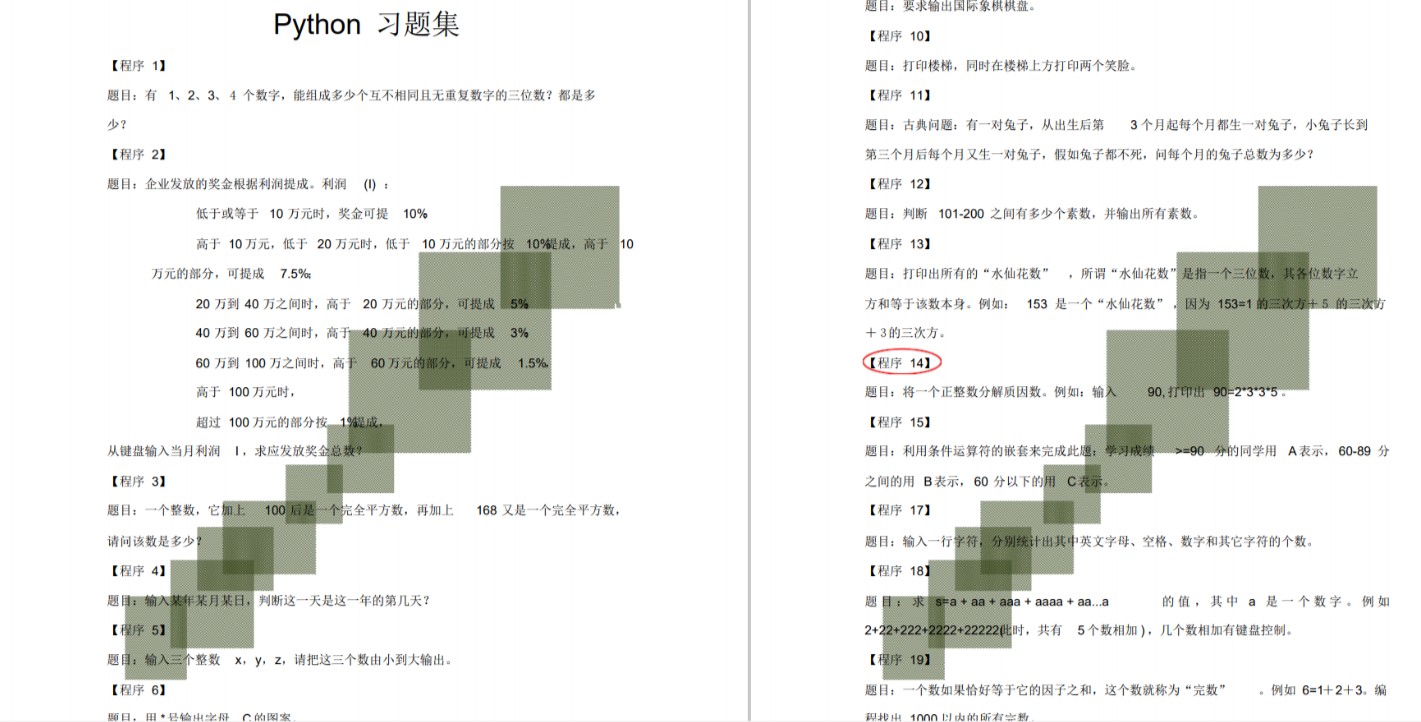

四、Python练习题

每节视频课后,都有对应的练习题哦,可以检验学习成果哈哈!

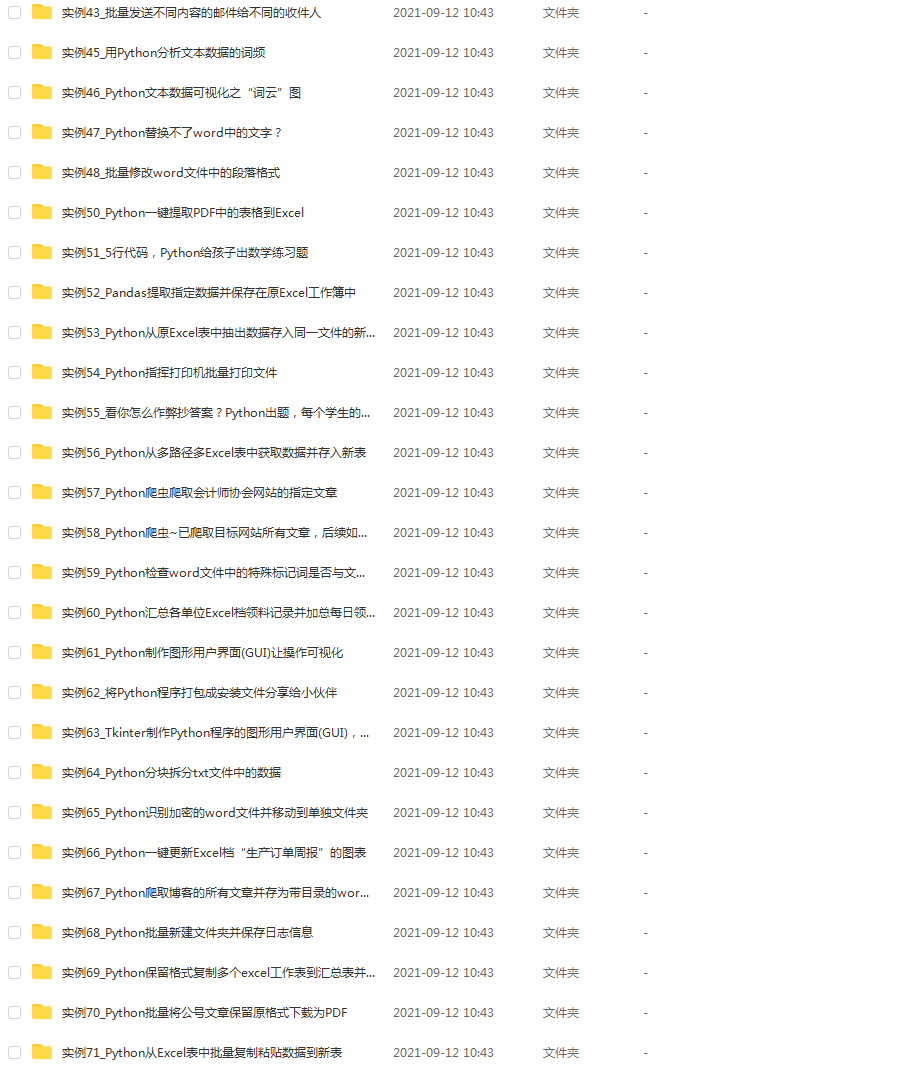

五、Python实战案例

光学理论是没用的,要学会跟着一起敲代码,动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。这份资料也包含在内的哈~

六、Python面试资料

我们学会了Python之后,有了技能就可以出去找工作啦!下面这些面试题是都来自阿里、腾讯、字节等一线互联网大厂,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

七、资料领取

上述完整版Python全套学习资料已经上传CSDN官方,需要的小伙伴可自行微信扫描下方CSDN官方认证二维码输入“领取资料”免费领取!!