- 1探索Python数据容器之乐趣:列表与元组的奇妙旅程!

- 2RabbitMQ-Plugin configuration unchanged_enabling plugins on node rabbit@laptop-04itchu3: r

- 33_2Linux中内核级加强型火墙的管理

- 4记录一次mysql慢查询的优化过程

- 5美团团购订单系统优化记_团购订单系统的主要用户和作用

- 6C++轻量级界面开发框架ImGUI介绍

- 7LLMNR和NetBIOS欺骗攻击分析及防范_禁用netbios后会怎样

- 8H3C交换机ACL的单向访问解决方案_h3c 接口acl单向访问

- 9RK3568 OpenHarmony3.2 ADC按键驱动适配_open harmony 键盘驱动

- 10Windows环境部署安装Chatglm2-6B-int4

Gartner发布中国采用GhatGPT等生成式AI应用的安全问答_gartner智能问答

赞

踩

以ChatGPT为代表的生成式人工智能(AI)已成为最受热炒的技术之一,引起了Gartner客户的强烈兴趣。中国企业机构的首席信息官(CIO)在采用该技术之前,须了解生成式AI的安全、风险和治理,以降低风险。

对于中国的生成式AI应用的安全、风险和治理,CIO应了解什么?

-

了解采用生成式AI的潜在风险。

-

明确生成式AI(或AI)应用治理与数据治理之间的关系。

-

采用治理和安全控制措施。

-

了解中国的服务、数据、隐私和安全政策。

详细说明

ChatGPT是OpenAI提供的一项服务,内置了会话式聊天机器人,由生成式预训练转换器(GPT,现已更新到第四代)提供支持。ChatGPT只是利用基础模型和其他技术实现生成式AI的一个例子。

Gartner客户非常关心如何安全地使用生成式AI,经常询问在中国采用生成式AI应用(如ChatGPT)的风险。本文有助于CIO以及安全和风险管理领导者了解在中国采用生成式AI应用的相关安全、风险和治理。

了解采用生成式AI的潜在风险

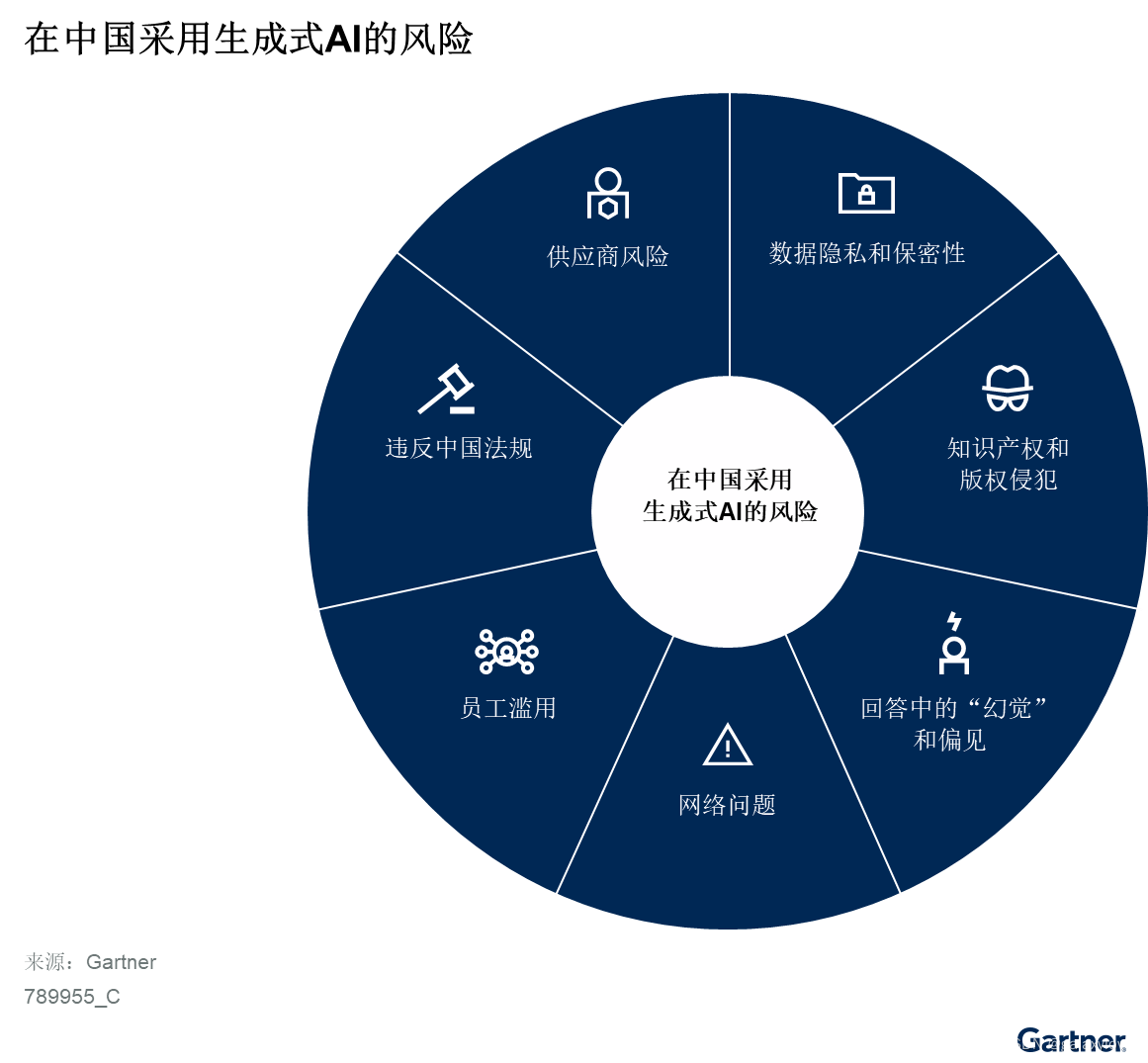

生成式AI的采用并非毫无风险。其中一些风险是普遍性的,而另一些风险则仅针对在中国运营的企业机构(见图1)。

图1:在中国采用生成式AI的风险

1、数据隐私和保密性

生成式AI可在不另行通知的情况下与第三方共享用户信息。例如,提示中使用的任何敏感或机密信息都可用于训练ChatGPT,并且这些信息可能包含在生成的响应中,供企业之外的其他用户使用。虽然OpenAI等一些提供商提供了退出选项,但并非所有提供商都提供灵活选择的空间,并且用户可能意识不到存在这一选项。

2、知识产权(IP)和版权侵犯

生成式AI的输出可包含受版权和知识产权保护的信息,可能会导致知识产权或版权侵犯。

3、回答中的“幻觉”和偏见

生成式AI无法真正“理解”内容,可在不经意间提供不正确的信息。以安全运营领域的生成式AI应用为例,如果生成的配置或代码出错,可能会影响企业机构的安全,甚至影响应用的正常运行。所有输出结果必须由经验丰富的安全分析师审阅,甚至必须在测试环境中进行分析。

4、数据安全问题

黑客不仅能访问存储在生成式AI模型中的数据,而且能通过提示注入的方式,使生成式AI模型泄露本不应泄露的信息。

5、员工滥用

生成式AI技术可能被员工滥用,用于实施非法活动,例如通过模仿特定人士甚至政府的语气制造错误信息。中国的网民数量居全球首位,但只有不到20%的网民拥有大学学历。1因此,许多人容易受到错误信息的影响。

6、违反中国法规

中国制定了多项与数据安全和AI相关的法规。不负责任地使用生成式AI可能会导致违反这些法规。例如,中国对数据出境做出了规定,如果采用在中国境外的生成式AI服务,导致某些类型的数据在未经批准的情况下被转移到海外,就会引发合规风险。

7、供应商风险

虽然ChatGPT不具备企业级安全保障,但Azure OpenAI服务的数据、隐私和安全方面确实具有透明度。例如,使用微软管理的密钥对数据进行静态加密,而且各区域的资源在逻辑上相互隔离,根据Azure订阅和应用编程接口(API)凭证保存在相应区域。2客户提供的训练数据仅用于微调客户模型。虽然中国用户无法使用ChatGPT和Azure OpenAI服务,但还是有一些替代方案可供选择,例如在中国使用国外手机号码创建ChatGPT账户。然而,由于ChatGPT和Azure OpenAI的数据都存储在中国境外,采用上述做法的企业机构将面临违规风险,例如违反数据出境规定。因此,在中国运营的企业需要使用国产生成式AI服务,而这些系统在数据和安全方面可能缺乏透明度,企业应了解采用这些服务的风险。

明确生成式AI(或AI)治理和数据治理之间的关系

数据治理旨在通过改善监督、更清晰地阐明问责和决策权来增加数据和分析(D&A)资产的业务价值。然而,中国企业机构往往认为数据治理是一种被动实践,只能由中心化的IT部门主导。数据治理视野狭窄,加上数据覆盖范围有限,将导致生成式AI的有效采用受到阻碍。负责任的AI工具的采用将在这方面发挥重要作用。

生成式AI赋能的D&A工具将帮助去中心化的团队中的公民用户创建和维护现有企业数据库以外的结构化和非结构化数据,而这只会增加数据治理实践的复杂性。

生成式AI易于使用的特性,要求中国企业机构秉持原型优先心态,采用更具自适应性的数据治理流程。中国企业机构对D&A的普遍态度是以治理为先,这往往会延缓新技术的采用。虽然部分企业机构已将数据治理扩展至AI,但将生成式AI用于内部数据处理仍然是一个新兴的使用场景。随着中国企业机构选择以数据为中心的方法来利用生成式AI,数据治理将成为提供高质量AI生成内容(AIGC)应用的关键。

采用治理和安全控制

中国企业机构可评估以下选择,在降低风险的情况下采用生成式AI:

-

采用负责任的AI和AI伦理原则,制定生成式AI治理政策。企业机构应在反馈循环中使用人工不断验证输出的准确性,将改善AI和数据素养作为企业的长期目标。

-

使用具备企业级安全的云服务。到目前为止,大多数生成式AI服务不具备企业级安全保障,因此在使用时存在风险。Azure OpenAI服务确实提供了一些企业级安全解决方案,如数据加密和数据隔离,但Azure在中国无法提供此类解决方案。如果在中国使用Azure OpenAI服务,可能会面临数据出境的合规问题。例如,用户在未事先获得中国监管机构批准的情况下,向Azure OpenAI平台输入大量重要数据和个人信息。

-

开发本地解决方案,在将信息发送到云端生成式AI之前过滤或屏蔽敏感信息。企业机构应利用快速工程化和基于规则的方法来创建、调整和评估即时输入和输出,以缓解因采用生成式AI而造成的安全风险。

-

本地部署生成式AI功能。中国大多数基于云的生成式AI服务提供商不具备企业级安全保障。此外,中国企业机构如果采用Azure OpenAI等全球性生成式AI服务,很可能面临合规风险。因此,最好选择在私有云或本地部署生成式AI功能,并使用企业数据来训练其生成式AI模型。

了解中国的服务、数据、隐私和安全政策

中国已颁布多项与使用大型语言模块相关的法规。包括:

-

《中华人民共和国数据安全法》:该法涵盖了数据保护、数据生命周期管理、所有数据处理活动中的信任和责任、数据接入点和表面的保护、数据分类及其相关保护制度、数据交易控制、跨境数据传输和违规处罚等方面的内容。在采用生成式AI解决方案时,企业不应忽视数据安全,需要注意重要数据是否用于训练除供应商模型之外的其他模型。

-

《中华人民共和国个人信息保护法》:该法在中国建立了一个保护个人数据的新框架。企业必须获得个人同意才能处理其个人信息。存在个人信息泄漏的风险,因为输入到生成式AI平台中的个人信息可能输出给其他用户,从而导致个人信息泄露。

-

《数据出境安全评估办法》:该办法为数据出境安全评估和审批提供了框架。在中国境外使用ChatGPT等生成式AI服务可能会导致数据出境,从而造成违规。

-

《生成式人工智能服务管理暂行办法》:本办法适用于在中国实施和提供生成式AI服务。