热门标签

热门文章

- 1探索设计模式的魅力:开启智慧之旅,AI与机器学习驱动的微服务设计模式探索

- 2Three.js--》实现3D汽车展厅效果展示_three.js 展厅

- 3Windows 下安装RabbitMQ服务器(超详细)_windows7系统下安装rabbitmq

- 4Github Education Pack申请流程及Wordpress架站网站对比_github educate申请

- 5公司出现这些“高危”征兆,不离职留着过国庆?赶紧走!

- 6江科大STM32学习笔记(上)_stm32博客

- 7稀疏卷积 sparse conv

- 8值得收藏的十个C/C++学习网站_c c++ 网站

- 9手把手教你用python一键抢12306火车票(附代码)_python抢票

- 10沟通表达的实用技巧和练习方法_实用的表达技巧

当前位置: article > 正文

【深度学习 有效炼丹】多GPU使用教程, DP与DDP对比, ray多线程并行处理等 [GPU利用率低的分析]_ray多卡

作者:盐析白兔 | 2024-04-14 17:41:50

赞

踩

ray多卡

⬅️ 前言

更新日志:

20220404:新增一个DDP 加载模型时显存分布不均问题,见目录遇到的问题及解决处

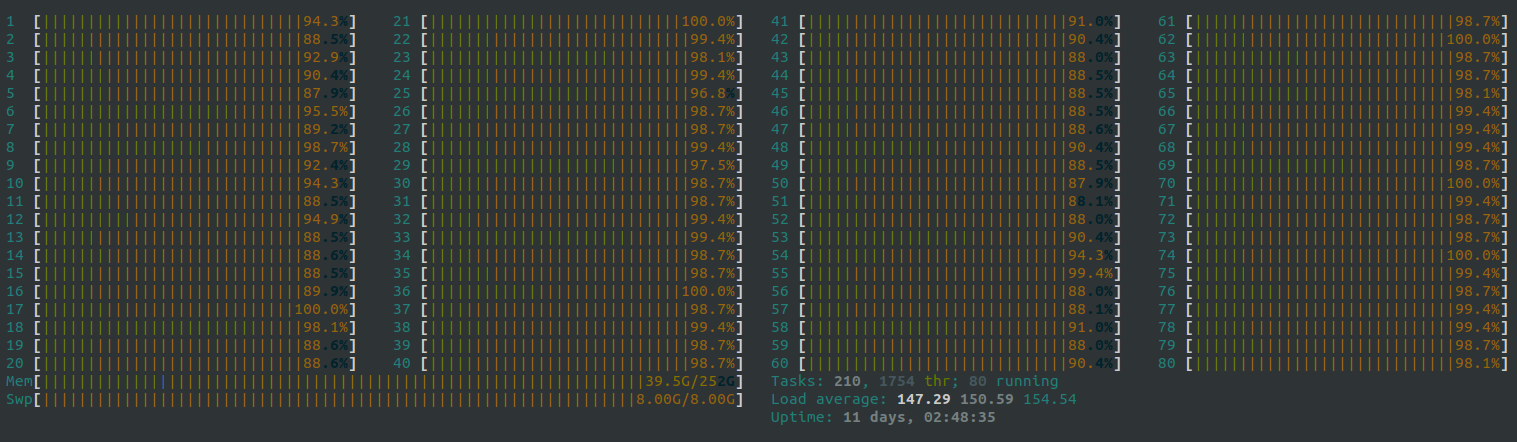

主要是上次server12 被自己一个train 直接线程全部拉满了(没错 … server8 也被拉满过 emm我一开始还没发现 原来是我拉满的)

现场实况

后面刘所就跟我说让我看看是不是dataset里面的处理太多了,这样下来GPU占着 使用率也不高,建议先处理完了再直接由load进来 直接训练;因为server上的cpu都不是很好,一开始那样玩会拉慢训练速度,两种选择:

- 把cpu的操作全部放到gpu上去做

- 先把cpu操作做了保存成数据,这样不用每次epoch都做一次操作了

下面主要就是针对前言里面说的两条进行分析与方案确认

✔️ 1. 预处理

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/盐析白兔/article/detail/423343

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/盐析白兔/article/detail/423343

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。