热门标签

热门文章

- 1leetcode__前k个高频元素__python_leetcode+ 前 k 个高频元素+python

- 2互联网加竞赛 基于深度学习的目标检测算法

- 3python 文本分析库_Python有趣|中文文本情感分析

- 4Leetcode 24:两两交换链表中的节点

- 5[Python]-python画一朵花

- 6ardupilot编译过程记录_chibios build requires g++ version 10.2.1 or later

- 7操作系统刷题_如果一个计算机的硬盘为64g,每个块的大小为4k,如果用位示图来管理硬盘的空间,则位

- 8运行时的用法积累_[self willchangevalueforkey:@"mj_header"]; // kvo

- 9思科、华为、华三认证,网工心中的三大噩梦_国内服务器厂商 华为 思科 华三

- 10CENTOS上的网络安全工具(十五)cascade的部署_centos7 sysmon

当前位置: article > 正文

【LM】轻量化BERT

作者:AI数据灵魂 | 2024-01-30 14:50:33

赞

踩

【LM】轻量化BERT

1.AlBert

通过矩阵分解、共享参数来压缩BERT模型,压缩比主要由共享参数这个策略贡献。从模型参数的角度,AlBert相比BERT压缩了9倍;从inference的计算量的角度,AlBert与相比BERT没有本质的差异 albert/hugging face link。

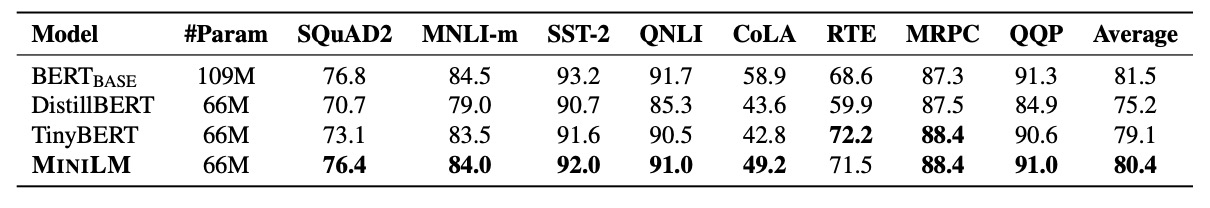

2.DistillBert

通过蒸馏方式压缩BERT模型,预训练阶段,将BERT-base作为teacher, 产生训练DistillBert的soft target,与BERT相比,DistillBert在模型参数和inference的时间上都是BERT的60% ,效果是BERT的96%。distillbert。

3.TinyBERT

同样是通过蒸馏方式压缩模型。在预训练和精调阶段,均采用蒸馏手段。与BERT相比模型参数量减少7.5倍,inference速度提升9.4倍,效果是BERT的96.8%,压缩比和效果优于DistillBert hugging face link。

4.MobileBERT

应用bottleneck思想,在保证层数不变的情况下,参数压缩了4.3倍的参数,inference速度提升5.5倍。仅在预训练阶段蒸馏,除了蒸馏中间层结果外,还蒸馏Attention矩阵。效果优于DistillBert、TinyBERT。

5.MiniLM

只蒸馏最后一层self-attention中的Q-K attention矩阵以及Value矩阵。效果比DistillBert、TinyBERT要好。inference速度是BERT的一半,参数量是BERT的60%,目前还没有中文开源的预训练模型。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/article/detail/46995

推荐阅读

相关标签