热门标签

热门文章

- 1知云文献翻译_知云文献安装步骤

- 2一、Selenium开篇之PyCharm安装selenium及浏览器驱动_pycham驱动

- 3区块链的共识与共识机制_区块链共识机制

- 4安卓系列机型 框架LSP 安装步骤 支持多机型 LSP框架通用安装步骤【二】_lsp框架和模块

- 5什么是自动化测试?自动化测试现状怎么样?_自动化测试行业现状

- 6【愚公系列】2023年12月 HarmonyOS应用开发者基础认证(完美答案)

- 7新版本android studio 2022.2.1 aidl的相关问题_android studio aidl灰色

- 8Go主流框架对比_go日志框架对比

- 92024华为OD机试真题目录汇总 B+C+D卷(484道)(Python语言)_java switch语句

- 10vue2引入Element UI组件去创建新页面的详细步骤--项目阶段2_新建vue页面

当前位置: article > 正文

回归预测 | MATLAB实现PSO-LSSVM粒子群算法优化最小二乘支持向量机多输入单输出

作者:代码独立开发者 | 2024-01-29 17:46:51

赞

踩

pso-lssvm

回归预测 | MATLAB实现PSO-LSSVM粒子群算法优化最小二乘支持向量机多输入单输出

预测效果

基本介绍

MATLAB实现PSO_LSSVM粒子群算法优化最小二乘支持向量机多输入单输出。

Matlab实现PSO-LSSVM粒子群算法优化最小二乘支持向量机多变量回归预测

1.为数据集,输入6个特征,输出一个变量。

2.PSO_LSSVM.m为主程序主文件,其余为函数文件无需运行。

3.命令窗口输出MAE、MSE、R2、RMSEP和RPD,可在下载区获取数据和程序内容。

4.粒子群算法优化最小二乘支持向量机,优化RBF 核函数gam和sig。

注意程序和数据放在一个文件夹,运行环境为Matlab2018及以上.

模型描述

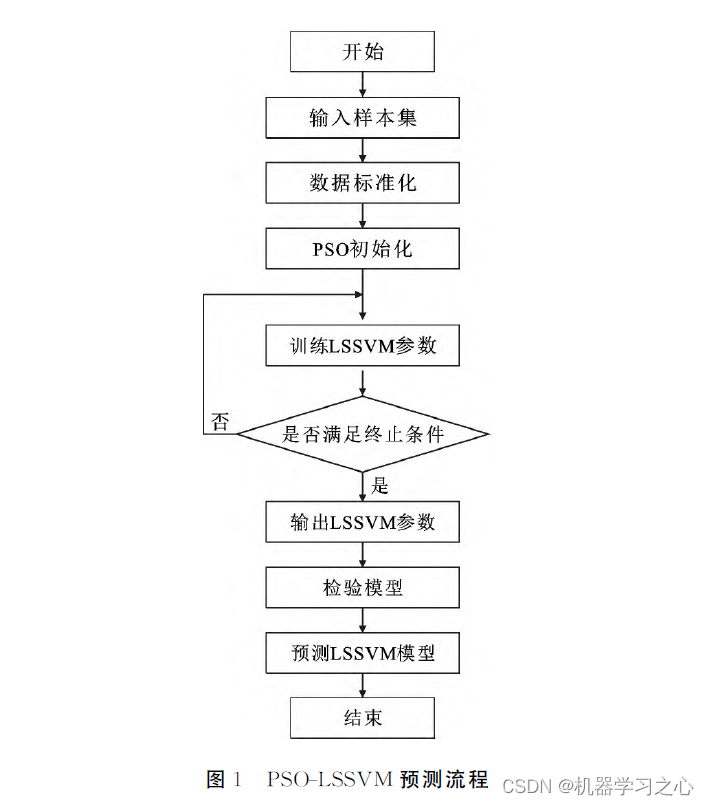

LSSVM参数优化问题没有确定或通用的共识方法。由于智能算法在预测模型参数的选取确定方面具有稳健性和通用性,预测模型参数最优化过程中主要采用了遗传算法、果蝇优化算法、萤火虫算法、粒子群算法(PSO)、网格搜索算法、神经网络等智能算法。粒子群算法不断调整自身和种群最优位置关系,具有更强寻优能力。因此,为进一步得到可靠的模型参数,可沿用粒子群算法进行尝试验证。

程序设计

- 完整程序和数据下载方式1(资源处直接下载):MATLAB实现PSO-LSSVM粒子群算法优化最小二乘支持向量机多输入单输出

- 完整程序和数据下载方式2(订阅《智能学习》专栏,同时获取《智能学习》专栏收录程序6份,数据订阅后私信我获取):MATLAB实现PSO-LSSVM粒子群算法优化最小二乘支持向量机多输入单输出

%% 参数设置 pop = 5; % 种群数目 Max_iter = 50; % 迭代次数 dim = 2; % 优化参数个数 lb = [10, 10]; % 下限 ub = [1000, 1000]; % 上限 %% 优化函数 fobj = @(x)fitnessfunclssvm(x, p_train, t_train); %% 优化 [Best_pos, Best_score, curve] = PSO(pop, Max_iter, lb, ub, dim, fobj); %% LSSVM参数设置 type = 'f'; % 模型类型 回归 kernel = 'RBF_kernel'; % RBF 核函数 proprecess = 'preprocess'; % 是否归一化 %% 建立模型 gam = Best_score(1); sig = Best_score(2); model = initlssvm(p_train, t_train, type, gam, sig, kernel, proprecess); %% 训练模型 model = trainlssvm(model); %% 模型预测 t_sim1 = simlssvm(model, p_train); t_sim2 = simlssvm(model, p_test); %% 数据反归一化 T_sim1 = mapminmax('reverse', t_sim1, ps_output); T_sim2 = mapminmax('reverse', t_sim2, ps_output); %% 定义粒子群算法参数 % N 种群 T 迭代次数 %% 随机初始化种群 D=dim; %粒子维数 c1=1.5; %学习因子1 c2=1.5; %学习因子2 w=0.8; %惯性权重 Xmax=ub; %位置最大值 Xmin=lb; %位置最小值 Vmax=ub; %速度最大值 Vmin=lb; %速度最小值 %% %%%%%%%%%%%%%%%%初始化种群个体(限定位置和速度)%%%%%%%%%%%%%%%% x=rand(N,D).*(Xmax-Xmin)+Xmin; v=rand(N,D).*(Vmax-Vmin)+Vmin; %%%%%%%%%%%%%%%%%%初始化个体最优位置和最优值%%%%%%%%%%%%%%%%%%% p=x; pbest=ones(N,1); for i=1:N pbest(i)=fobj(x(i,:)); end %%%%%%%%%%%%%%%%%%%初始化全局最优位置和最优值%%%%%%%%%%%%%%%%%% g=ones(1,D); gbest=inf; for i=1:N if(pbest(i)<gbest) g=p(i,:); gbest=pbest(i); end end %%%%%%%%%%%按照公式依次迭代直到满足精度或者迭代次数%%%%%%%%%%%%% for i=1:T i for j=1:N %%%%%%%%%%%%%%更新个体最优位置和最优值%%%%%%%%%%%%%%%%% if (fobj(x(j,:))) <pbest(j) p(j,:)=x(j,:); pbest(j)=fobj(x(j,:)); end %%%%%%%%%%%%%%%%更新全局最优位置和最优值%%%%%%%%%%%%%%% if(pbest(j)<gbest) g=p(j,:); gbest=pbest(j); end %%%%%%%%%%%%%%%%%跟新位置和速度值%%%%%%%%%%%%%%%%%%%%% v(j,:)=w*v(j,:)+c1*rand*(p(j,:)-x(j,:))... +c2*rand*(g-x(j,:)); x(j,:)=x(j,:)+v(j,:); %%%%%%%%%%%%%%%%%%%%边界条件处理%%%%%%%%%%%%%%%%%%%%%% if length(Vmax)==1 for ii=1:D if (v(j,ii)>Vmax) | (v(j,ii)< Vmin) v(j,ii)=rand * (Vmax-Vmin)+Vmin; end if (x(j,ii)>Xmax) | (x(j,ii)< Xmin) x(j,ii)=rand * (Xmax-Xmin)+Xmin; end end else for ii=1:D if (v(j,ii)>Vmax(ii)) | (v(j,ii)< Vmin(ii)) v(j,ii)=rand * (Vmax(ii)-Vmin(ii))+Vmin(ii); end if (x(j,ii)>Xmax(ii)) | (x(j,ii)< Xmin(ii)) x(j,ii)=rand * (Xmax(ii)-Xmin(ii))+Xmin(ii); end end end end %%%%%%%%%%%%%%%%%%%%记录历代全局最优值%%%%%%%%%%%%%%%%%%%%% Convergence_curve(i)=gbest;%记录训练集的适应度值

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

- 91

- 92

- 93

- 94

- 95

- 96

- 97

- 98

- 99

- 100

- 101

- 102

- 103

- 104

- 105

- 106

- 107

- 108

参考资料

[1] https://blog.csdn.net/article/details/126072792?spm=1001.2014.3001.5502

[2] https://blog.csdn.net/article/details/126044265?spm=1001.2014.3001.5502

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/blog/article/detail/43930

推荐阅读

- MATLAB——IIR数字滤波器的设计_iir带通滤波器matlab设计iir带通滤波器matlab设计1.基础知识1.1、数字滤波器设计的基本步骤我们知道模拟滤波器的设计是数字滤波器的设计的基础。在学习数字信号处理的过程中,IIR数字滤波... [详细]

赞

踩

- 本文采用Pieper法则和机器人学的通用法则介绍机器人逆运动学及逆解的求解方法。文章首先介绍如何理解逆向运动学,然后利用D-H参数及正向运动学的齐次变换矩阵对机器人运动学逆解进行求解。..._机器人逆运动学求解matlab机器人逆运动学求解... [详细]

赞

踩

- 毕业设计-基于Matlab的电力系统稳定性分析与仿真:随着我国国民经济快速增长和高新技术发展的趋势,我国工业结构的转变和经济发展对电能质量提出了更高更严格的要求。为了建设坚强的智能电网,全国电网互联则是一个行之有效并且充满前途的提高电力系统... [详细]

赞

踩

- 在实际示例中,不同的对象只是对同一数据的不同的访问方式,尽管如此,不同MAT对象的头各不相同。OpenCV2.0引入了一种新的C++接口,无需考虑内存管理问题,使得代码更加简洁,即利用更少的代码量,能够实现更多的功能。Mat基础类包含两部分... [详细]

赞

踩

- 1.订阅本教程用户可以免费获得本博任意1个博文对应代码;2.本课程的所有案例(部分理论知识点除外)均由博主编写而成,供有兴趣的朋友们自己订阅学习使用。3.本课程我们更侧重于各种实例的完整设计介绍。更全面的介绍FPGA,MATLAB,Simu... [详细]

赞

踩

- 该程序完全复现《基于价值认同的需求侧电能共享分布式交易策略》,针对电能共享市场的交易机制进行研究,提出了基于价值认同的需求侧电能共享分布式交易策略,旨在降低电力市场的交易成本并提高市场效率。模型理论分为两部分,程序和理论部分相对应,首先,基... [详细]

赞

踩

- 使用无限冲激响应(IIR,InfiniteImpulseResponse)滤波器进行音频滤波处理【Matlab】音频信号分析及IIR滤波处理——巴特沃斯(Butterworth)一、前言1.1课题内容:利用麦克风采集语音信号(人的声音、或乐... [详细]

赞

踩

- matlabappdesigner系列-容器2-选项卡组matlabappdesigner系列-容器2-选项卡组所谓容器,就是可以放置常有组件的空间,类似一种画布。默认背景画布就是一张画布,选项卡组,可以同时增加好几个画布空间,以满足不的组... [详细]

赞

踩

- 回归预测|Matlab实现CPO-LSSVM【24年新算法】冠豪猪优化最小二乘支持向量机多变量回归预测回归预测|Matlab实现CPO-LSSVM【24年新算法】冠豪猪优化最小二乘支持向量机多变量回归预测回归预测|Matlab实现CPO-L... [详细]

赞

踩

- 回归预测|MATLAB实现LSSVM(最小二乘支持向量机)多输入单输出目录回归预测|MATLAB实现LSSVM(最小二乘支持向量机)多输入单输出最小二乘支持向量机准备工作数据下载函数文件程序设计多变量回归主程序单变量回归主程序拓展学习参考资... [详细]

赞

踩

相关标签