- 1【HarmonyOS】【ArkTS】如何使用HTTP网络请求获取动态数据刷新UI界面_arkts怎么做接口请求

- 2【 This error originates from a subprocess, and is likely not a problem with pip.】_collecting sklearn downloading sklearn-0.0.post12.

- 3一、mac 安装及使用docker_docker for mac

- 4区块链的技术缺陷_区块链技术的缺点

- 5Nodejs前端学习Day1_补档

- 6小程序-uni-app:将页面(html+css)生成图片/海报/名片,进行下载 保存到手机_uniapp页面生成图片

- 7stable diffusion error code:128 stdout:HEAD解决方案_couldn't determine stable diffusion's hash: cf1d67

- 8数据库连接池报错:[ERROR] testWhileIdle is true, validationQuery not set

- 9Java面试——缓存_什么是缓存区间

- 10《UnityAPI.AnimationClip动画剪辑》(Yanlz+Unity+SteamVR+云技术+5G+AI+VR云游戏+AnimationClip+AddEvent+立钻哥哥++OK++)_unity clip 过度

杭州人工智能计算中心率先实现基于昇思MindSpore的LLaMa2、Stablediffusion2.1大模型训练部署_mindspore llama2

赞

踩

杭州人工智能计算中心成功实现LLaMA2、Stablediffusion2.1等主流大模型上线,是全国首个在自主可控环境及自主可控AI框架下成功上线的人工智能计算中心。昇思MindSpore是华为开源的首个业界全场景AI融合框架,原生支持AI大模型与科学智能。杭州人工智能计算中心基于昇思,以及大模型开发套件MindSpore Transformer将LLaMa2 70B、Stablediffusion2.1大模型适配到本地环境中,实现高效运行。

为方便开发者群体高效创新,杭州人工智能计算中心上线了昇思MindSpore全流程使能大模型的工具与方法,从开发、训练、微调到部署,覆盖低参微调算法、分布式推理,让开发者有更多样化的选择快速打造大模型

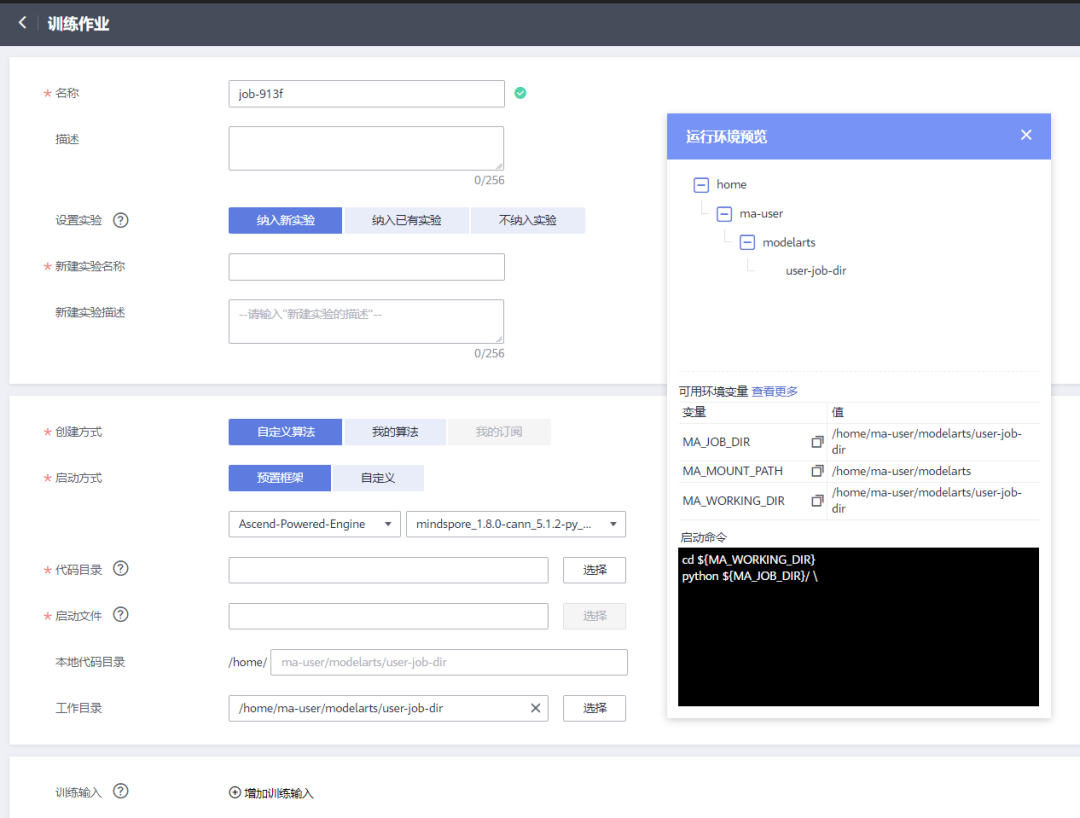

在杭州AICC环境下,开发者可以通过notebook调试,通过训练作业拉起模型训练,几百张卡的分布式训练一键拉起,省去一台台搭建裸机环境的步骤。

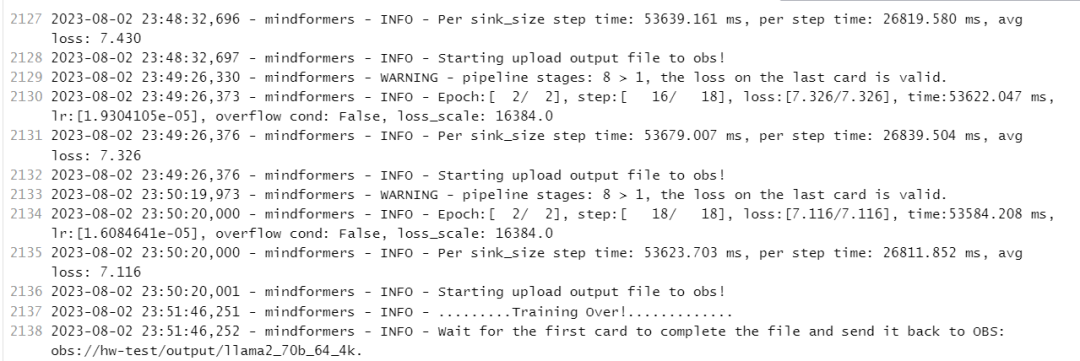

LLaMa2

Llama 2包含了70亿、130亿和700亿参数的模型。Meta正式发布Llama 2后,Llama 2强大的参数规模以及性能表现,对OpenAI带来了不小的压力,人称“GPT-4最强平替”。

Llama-2相比Llama-1有不少技术层面的改进,从而带来了模型性能、推理效率以及安全性等方面的有效提升。具体而言,重要的改进有以下几点:

1、模型架构上使用Group-Query-Attention(GQA)来提高模型推理效率,语境长度从2K增加一倍到4K。

2、预训练语料从1.4T tokens增加到2T tokens。

3、在监督微调(SFT)阶段更加注重数据集质量,使用更少但质量更高的SFT数据相比使用百万量级的公开SFT数据,效果显著提升。

4、引入了三项安全训练技术Supervised Safety Fine-Tuning、Safety RLHF、Safety Context Distillation 提升模型的安全性。

✦

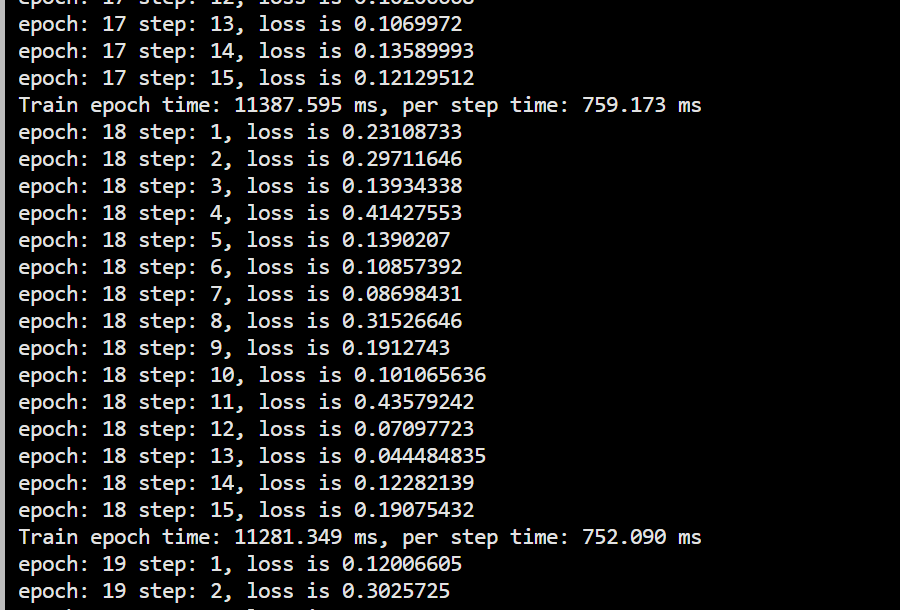

Stablediffusion2.1

Stable diffusion是一个基于Latent Diffusion Models(潜在扩散模型,LDMs)的文图生成(text-to-image)模型. 具体来说,Stable Diffusion采用 UNetModel 这种 Encoder-Decoder 结构来实现扩散的过程. 在Stable Diffusion中,通过将人类语言转换成机器能理解的数学向量,再结合语义向量,从纯噪声开始逐步去除噪声,生成图片信息隐变量,最后将图片信息隐变量转换为一张真正的图片。

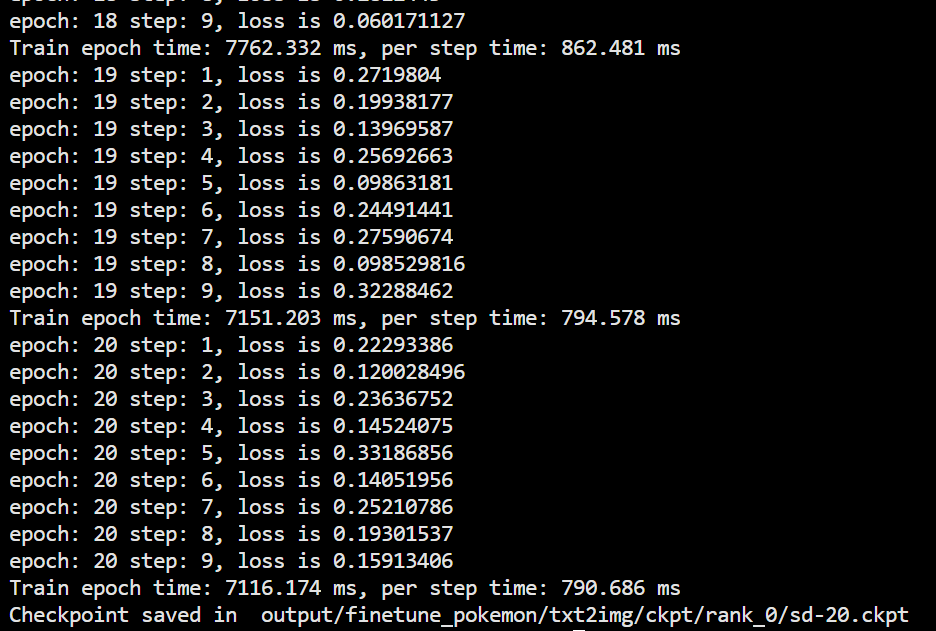

经迁移及优化后,sd2在aicc上支持了全量训练,lora训练,以及flashattention优化

Flashattention作为优化显存的工具,有效的提高了训练batch_size 数量。

以sd2.0为例

未开启flashattention

未开启flashattention后

提升了约60%的数据并发量,耗时仅提升10%

推理效果↓

关键词:克苏鲁和红月

关键词:河边看书的女孩

✦

杭州人工智能计算中心

杭州人工智能计算中心是全市首个公共服务性质的人工智能算力基础设施,致力于打造人工智能产业和数字经济的底座。由杭州高新区(滨江)管委会、政府投资,杭州高新智能科技有限公司建设与运营。一二期面积2700平方米,规模140P,并将逐步扩容。计算中心采用自主可控的昇腾AI集群,为政府、企业、科研机构、高校等提供公共普惠算力。该中心已于2022年5月20日在杭州市滨江区海创基地上线,提供AI模型训练、应用孵化、产业推广和人才培养等服务助力杭州国家新一代人工智能创新发展试验区、应用先导区建设

- 本文全面回顾了目标检测技术的演进历程,从早期的滑动窗口和特征提取方法到深度学习的兴起,再到YOLO系列和Transformer的创新应用。通过对各阶段技术的深入分析,展现了计算机视觉领域的发展趋势和未来潜力。人工智能-目标检测:发展历史、技... [详细]

赞

踩

- 本文全面探讨了人脸识别技术的发展历程、关键方法及其应用任务目标,深入分析了从几何特征到深度学习的技术演进。_人脸识别技术的发展历程人脸识别技术的发展历程目录一、人脸识别技术的发展历程早期探索:20世纪60至80年代技术价值点:自动化与算法化... [详细]

赞

踩

- 材料设计和发现:通过机器学习和深度学习算法,预测材料的性质和特性,在材料研究和开发中起到重要的作用。例如,使用AI算法可以快速分析材料的光学、电学和磁学性能,预测材料的力学性能和耐久性能等。材料制备和加工:AI可以帮助优化材料制备和加工工艺... [详细]

赞

踩

- 关于人类大脑建模的数学公式主要涉及到神经元网络、激活函数、学习算法等方面。这里是一些常见的数学公式(使用Markdown和LaTeX语法)。【人工智能】关于人类大脑模型的一些数学公式关于人类大脑模型的一些数学公式文章目录关于人类大脑模型的一... [详细]

赞

踩

- 大家好,我是微学AI,今天给大家介绍一下人工智能(pytorch)搭建模型13-pytorch搭建RBM(受限玻尔兹曼机)模型,调通模型的训练与测试。RBM(受限玻尔兹曼机)可以在没有人工标注的情况下对数据进行学习。其原理类似于我们人类学习... [详细]

赞

踩

- 本系列旨在普及那些深度学习路上必经的核心概念,文章内容都是博主用心学习收集所写,欢迎大家三联支持!本系列会一直更新,核心概念系列会一直更新!欢迎大家订阅。【人工智能|知识表示】问题规约法&谓词/符号逻辑,良好的知识表示是解题的关键!(笔记总... [详细]

赞

踩

- 作者:王斌谢春宇冷大炜引言目标检测是计算机视觉中的一个非常重要的基础任务,与常见的的图像分类/识别任务不同,目标检测需要模型在给出目标的类别之上,进一步给出目标的位置和大小信息,在CV三大任务(识别、检测、分割)中处于承上启下的关键地位。当... [详细]

赞

踩

- 人工智能的数学基础第一章人工智能与数学基础1.1人工智能简介1.2数学在人工智能中的作用1.3本书内容概述第二章线性代数基础2.1向量与矩阵2.2行列式与矩阵计算2.3线性方程组2.4矩阵分解与特征值分析第三章微积分基础3.1导数与微分3.... [详细]

赞

踩

- 1.Copilot的环境安装与使用都非常简单,可以把它当作一个在IDE中使用的ChatGPT。2.一些明确的代码逻辑,可以交给它完成。3.Copilot并非所有的输出都是正确的,在使用的过程中,需要适当进行纠错。人工智能|结对编程助手Git... [详细]

赞

踩

- 开源中文llama2来了,30分钟搭建130亿参数大模型Llama2-Chinese-13b-Chat_llama2-chinesellama2-chinese【AI实战】开源中文llama2来了,30分钟搭建130亿参数大模型Llama2... [详细]

赞

踩

- 什么是人工智能?机器学习是什么意思?GAN又是什么呢?在本文,你会学习到常用技术术语的清晰定义与解释。如果你考虑计算机的未来,你就不能回避人工智能。人工智能如今无处不在,但我们今天所说的..._ai词汇的描述ai词汇的描述什么是人工智能?机... [详细]

赞

踩

- 这些名词只是AI领域中的一部分,随着技术的不断发展,新的术语和概念也会不断涌现。人工智能(AI)中的一些常见名词-九五小庞包括:人工智能(AI):指让计算机像人类一样思考和行动的科技。生成性人工智能:指能够创造新内容或数据的AI,如生成图像... [详细]

赞

踩

- 龟叔在1989年圣诞节期间,以由荷兰的数学和计算机研究所开发的ABC语言为蓝本,开始开发一门新的编程语言,目标让新语言即能像C语言一样能够全面调用计算机的功能接口,又可以像shell一样可以轻松的编程,并且以龟叔所挚爱的电视剧。Python... [详细]

赞

踩

- Azure认知服务是基于云的人工智能(AI)服务,可帮助开发人员在不具备直接的AI或数据科学技能知识的情况下将认知智能内置于应用程序中。可采用常用开发语言通过RESTAPI和客户端库SDK使用此类服务。借助Azure认知服务,开发人员可以通... [详细]

赞

踩

- article

2023年最具影响力的 10 篇AI论文(Llama2、SAM、LLM、 Pythia、QLoRA、BloombergGPT、DPO、Mistral 7B、Orca 2、transformer)

一、Pythia—大模型该如何训练?2023一年又过去,这一年,AI圈子以一种“狂飙突进”的速度飞速发展,哪怕在这个领域深耕多年的学者们也开始感叹“从没有见过哪个领域在哪一年如同AI领域在2023年这样如此飞速的发展与不断的进化”,毫无疑问... [详细]赞

踩

- 总的来说,云计算、分布式计算、网格计算、对等计算、并行计算都是一种特定的计算方法或架构,它们在实现上有所差异,但都是为了解决大规模的计算问题而发展出来的技术。而雾计算可以看作是云计算的一种延伸和发展。1.物联网是物物相连的互联网,是互联网的... [详细]

赞

踩

- 近年来,人工智能技术的快速发展为图像生成领域带来了许多突破性的进展。本文介绍了一种名为FaceChain-FACT的人像生成技术,该技术通过免训练的方式实现了丝滑体验和秒级别的人像生成。FaceChain-FACT的独特之处在于它不需要进行... [详细]

赞

踩

- 实验四:深度学习算法及应用一、实验目的二、实验要求三、实验的硬件、软件平台四、实验原理1.1.深度学习概述1.2.深度学习的常见结构1.3.卷积神经网络(CNN)**卷积****池化**全连接网络1.4.卷积神经网络的大致结构1.5.参数学... [详细]

赞

踩

- 人工智能(AI)已成为当今世界的热门话题,它的应用范围越来越广泛。其中,Python成为AI开发中最受欢迎的编程语言之一。Python提供了许多功能强大的库和框架,大大简化了开发人员的工作。在本文中,我们将介绍Python在人工智能领域中的... [详细]

赞

踩

- 深度学习是一种机器学习方法,它模仿人类大脑的神经网络结构,通过多层次的神经元来实现对数据的学习和处理。它使用多层神经网络来模拟人脑的神经网络,从而实现对大量数据的复杂抽象和分析。深度学习在计算机视觉、自然语言处理、语音识别等领域取得了显著成... [详细]

赞

踩