热门标签

热门文章

- 1python脚本开机自启_Raspberry pi 树莓派Python脚本开机启动

- 2python查看是否开机_python自动循环定时开关机(非重启)测试

- 3ES操作通用类_es updateresponse

- 4【新手必看】PyCharm2023免费下载安装配置教程+Python环境搭建、图文并茂全副武装学起来才嗖嗖的快,绝对最详细!_pycharm 新配置python环境

- 5(5)【Python/机器学习/深度学习】Machine-Learning模型与算法应用—12种聚类算法说明与归纳

- 6阿里十年架构师用140个案例整合出Java微服务架构实战,看完我直接精通,年轻人你耗子尾汁_java微服务生产案例

- 7博客搭建教程1-Archlinux环境配置_配置archlinux硬件资源的页面是什么样

- 8驱动程序无法通过使用安全套接字层(SSL)加密与 SQL Server 建立安全连接_加载驱动成功! com.microsoft.sqlserver.jdbc.sqlserverexce

- 9Linux中的Screen命令使用技巧详解_linux screen 翻页

- 10上传源文件至虚拟服务器,如何上传源代码到虚拟主机

当前位置: article > 正文

LLM:Vicuna 13B 环境配置(7B需要14G显存,13B需要28G显存)_13b模型 需要多大的显存

作者:编程探险家 | 2024-02-01 11:52:13

赞

踩

13b模型 需要多大的显存

租用服务器3090

配置Fastchat

GitHub项目源地址:https://github.com/lm-sys/FastChat

先进行依赖包安装

pip3 install fschat

下载项目到本地,慢的话可以自己下载好通过FTP上传到服务器

- git clone https://github.com/lm-sys/FastChat.git

- cd FastChat

升级pip并安装依赖包

- # 不升级pip会报错,下面两种方式二选一

- python3 -m pip install --upgrade pip # 方式一

- pip3 install --upgrade pip # 方式二

-

- # 升级之后运行下面命令进行安装

- pip3 install -e .

配置transformers

- # 下载transformers包

- git clone https://github.com/huggingface/transformers.git

-

- # 进入transformers目录

- cd transformers

-

- # 安装transformers

- pip3 install -e .

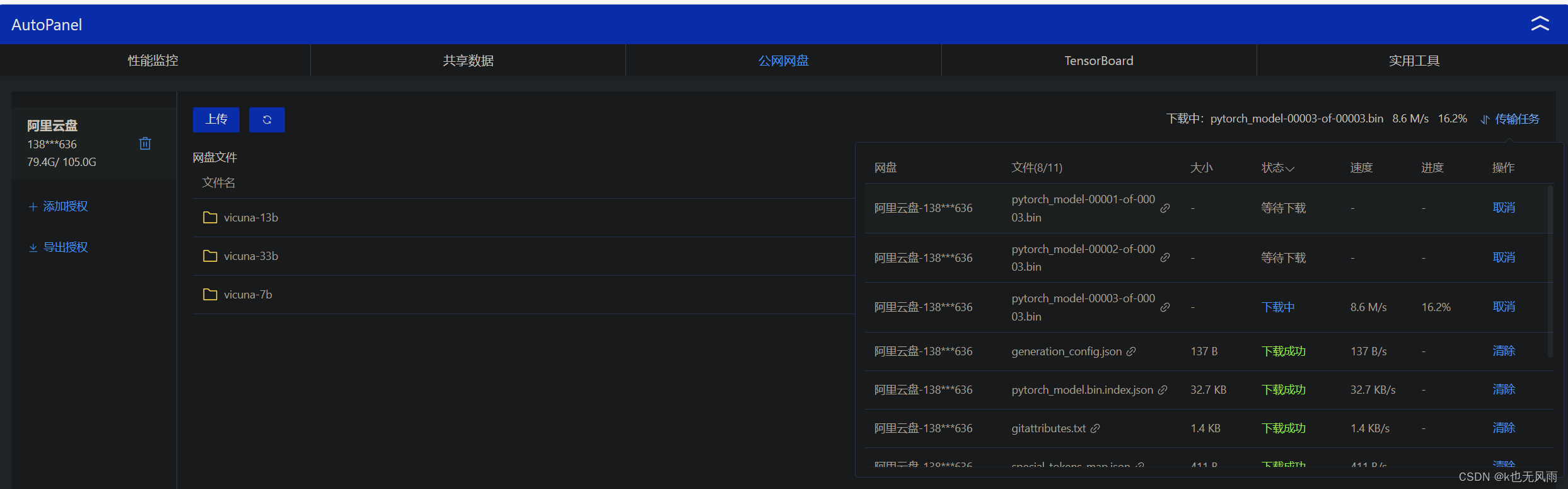

上传模型权重——使用阿里云盘上传到数据盘(自己提前下载模型权重并保存到自己的阿里云盘)

启动vicuna-13b模型

- # 显卡有28G显存用此命令

- python3 -m fastchat.serve.cli --model-path /root/autodl-tmp/vicuna-13b

-

- # 显卡不足28G显存用此命令

- python3 -m fastchat.serve.cli --model-path /root/autodl-tmp/vicuna-13b --load-8bit

-

- # /root/autodl-tmp/vicuna-13b 为模型权重路径,可以根据自己的情况替换为自己的路径

运行成功(7B和33B部署流程也一样,只是每个模型所需要的显存不一样,需要不同配置的显卡)

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/blog/article/detail/53674

推荐阅读

- 这里我们构建了一个16>32>1的神经网络模型,其中16、32、1指的是每一层的神经元数量,第一层与第二层的神经元数量无所谓可以随便写,第三层的1与预测的结果相对应,也就是我们使用前7天的平均温度,预测的是今天这“一个”平均温度。Val_l... [详细]

赞

踩

- [元启发式算法]禁忌搜索(TabuSearch)解决TSP问题(Python)文章目录[元启发式算法]禁忌搜索(TabuSearch)解决TSP问题(Python)1.TabuSearch基本概念2.TabuSearch算法实现细节3.问题... [详细]

赞

踩

- Zookeeper伪集群安装部署操作Java操作Zookeeper实现分布式锁和队列文章目录分布式事物CAP理论CAP定理的应用BASE理论2PC提交3PC提交zookeeper集群的角色ZAB协议的核心思想ZAB协议两种模式ZAB协议消息... [详细]

赞

踩

- git的常用操作(本地项目推送到gitee/github)核心:从gitee/github上拿下来一个文件夹(仓库),把我们要推送的东西放进去,然后推回去)适合新手,如果废话有点多,主要的可以直接看被加粗的字体一、登录gitee,没有就注册... [详细]

赞

踩

- 最近开发深度学习算法的可交互的演示程序,遇到这样一个需求:实时显示每个批次每个epoch的loss值,那么keras模型的fit函数不太能用了,fit函数是把所有的数据喂到model里面,自然就会想到keras会有分批次训练的函数,不需要自... [详细]

赞

踩

- oauth2.0系统学习-springsercurity+oauth2.0+JWT单点登陆设计一、springsercurity+oauth2.0+JWT单点登陆设计认证服务器和资源服务器在同一台机器(网关)密码授权模式去掉客户端信息表去掉... [详细]

赞

踩

- 希尔排序是一种改进的插入排序算法,也称为缩小增量排序。它通过将待排序的数组按照一定的间隔分割成若干个子序列,然后对这些子序列进行插入排序,随着排序进行,逐渐减小间隔,直至间隔为1,最后对整个数组进行一次插入排序。这样做的好处是,在初始阶段,... [详细]

赞

踩

- 本文主要是基于TensorFlow和Keras框架实现的鸢尾花分类,主要包含关于深度学习TensorFlow-GPU环境的搭建,以及实现框架的实现,其实验目的是实现鸢尾花分类,本质是通过简单的实践理解深度学习基本流程,加深对于代码实现的理解... [详细]

赞

踩

- 函数式接口代替策略模式,少写子类,快速开发_函数式接口的作用函数式接口的作用1.什么是函数式接口函数式接口(FunctionalInterface)就是一个有且仅有一个抽象方法,但是可以有多个非抽象方法的接口。函数式接口可以被隐式转换为la... [详细]

赞

踩

- 一种方法,用于显示taxlist对象内容的概述或所选分类组的概述。Arguments参数【object,x】:一个taxlist对象。参数【ConceptID】:要在摘要中显示的概念id。参数【units】:指示在对象的分配空间中显示的单位... [详细]

赞

踩

- Room实现数据统一管理,通过类名找到对应Repo类并进行数据库操作_room百万数据room百万数据目录Room实现数据统一管理-Repo原理Room反射具体实现Repo(Kotlin)BaseRepo(Kotlin)BaseDao(Ja... [详细]

赞

踩

- 1.安装虚拟机本篇博客用的是VMWare和CentOS7开启虚拟机开始安装。。。等很久设置root密码2.复制虚拟机在创建了一个虚拟机后,找到存放地址,直接将虚拟机复制粘贴即可复制虚拟机打开文件夹中的.vmx文件即可打开复制后的虚拟机,会跳... [详细]

赞

踩

- 1.去官网下载一个exe的安装包,可以用命令行安装,但Windows使用exe安装包快很多,所以就不费那个劲了Windows版Composer下载链接2.进入安装流程,一直点Next就行了在这一步安装程序会自动找到电脑上的php.exe的路... [详细]

赞

踩

- 通过上一节的内容,大家已经知道了Git的几个常用命令,这一讲将会给大家介绍GIT的几种文件状态,文件状态和git的索引息息相关,所以该部分的内容可以帮助大家很好的理解git的原理。git的文件状态如下图所示git的文件有如下四种状态:-Un... [详细]

赞

踩

- ©PaperWeekly原创·作者|蔡杰学校|北京大学硕士生研究方向|问答系统近年来预训练模型(ELMo,GPT,BERT,XLNet,ALBERT等)给许多NLP任..._预训练模型和可解释性技术预训练模型和可解释性技术©PaperWee... [详细]

赞

踩

- 我要自学网-视频教程|https://www.51zxw.net/中国机器人网-中国机器人行业专业门户http://www.robot-china.com/七月在线-国内领先的人工智能教育平台https://www.julyedu.com/... [详细]

赞

踩

- 多模态行为质量评估_动作质量评价的主流网络动作质量评价的主流网络持续更新中...欢迎各位大佬点评指教!基本信息clip-level:是16或15帧作为1个clip提取的特征《LearningToScoreOlympicEvents》intr... [详细]

赞

踩

- Flash钓鱼首先将写好的flash.js放在自己的服务器上vars1=document.createElement('script');s1.setAttribute('type','text/javascript');s1.setAtt... [详细]

赞

踩

- Python之binascii中被废弃的函数b2a_hex()和a2b_hex()_a2b_hex()a2b_hex()Python之binascii中被废弃的函数b2a_hex()和a2b_hex()文章目录Python之binascii... [详细]

赞

踩

- 由于每一条#include指令后面都隐藏这一个未知的世界,除非你刻意去探索,否则你永远都不知道,当你把一条条#include指令放置于extern"C"{}里面的时候,到底会产生怎样的结果,会带来何种的风险。C与C++相互调用的“底层原理“... [详细]

赞

踩

相关标签