热门标签

热门文章

- 1前端数据加密的方法_前端加密

- 2小程序中强制页面刷新_小程序强制刷新页面

- 32021年美赛E题目简述(中英文)_2021美赛e题

- 4学习笔记:ACL访问控制列表(包过滤技术)_写出在接口f0/0上应用扩展acl107对应的命令

- 5【11】机器学习算法面试八股_dropout后跟softmax层

- 6Python中时间 & 时间戳之间的转换_python 时间转时间戳

- 72020-10-24 今年的1024_1024地址

- 8巴特沃斯滤波器python实现_butter_bandpass

- 9Maven 仓库国内镜像源收藏_maven 厂库国内镜像

- 10Discuz论坛搭建:Linux宝塔面板一键部署,固定地址畅享公网访问

当前位置: article > 正文

python爬取微博用户信息_python 微博 用户变量

作者:代码优化者 | 2024-02-03 14:36:08

赞

踩

python 微博 用户变量

前言

在当今大数据时代,了解一个人的方式已经发生了变化。我们通常会通过浏览他们的微博、朋友圈以及听取朋友的看法来获取信息。尤其是对于我们喜欢的明星,我们会经常浏览他们的微博,以了解他们的最新动态。随着数据成为不可或缺的一部分,Python已经成为获取数据的首选工具。在这个博客中,我将分享如何通过Python优化数据收集的过程,使我们能够更深入地了解我们关注的人。本文带大家使用python加入代理池爬取微博爱豆信息存入excel。

环境准备

装好我们需要的模块,xlrd、xlutils都是用于excel操作

pip install xlrd

pip install xlutils

程序

使用代理解决反反爬虫问题,免费代理ip自行百度

# -*- coding: utf-8 -*- import urllib.request import json import xlrd from xlutils.copy import copy # 设置IP代理池子 proxy_addr = ["110.52.235.100:9999", "117.95.200.86:9999", "113.128.10.121:9999", "49.86.181.235:9999", "121.225.52.143:9999", "111.177.186.27:9999", "175.155.77.189:9999", "110.52.235.120:9999", "113.128.24.189:9999", "163.204.242.51:9999"] def read_url(num): data = xlrd.open_workbook('readtest.xls') # 打开Excel文件读取数据 table = data.sheet_by_name(u'5000条抖音用户数据') # 通过名称获取工作表 url = str(table.cell(num, 1).value) if url != '': id = url[-10:] return id # 获取单元格 else: return 0 # 定义页面打开函数 def use_proxy(url, proxy_addr): req = urllib.request.Request(url) req.add_header("User-Agent", "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0") # 浏览器标识符 proxy = urllib.request.ProxyHandler({'http': proxy_addr}) opener = urllib.request.build_opener(proxy, urllib.request.HTTPHandler) urllib.request.install_opener(opener) data = urllib.request.urlopen(req).read().decode('utf-8', 'ignore') return data # 获取微博大V账号的用户基本信息,如:微博昵称、微博地址、微博头像、关注人数、粉丝数、性别、等级等 def get_userInfo(id, i): url = 'https://m.weibo.cn/api/container/getIndex?type=uid&value=' + id data = use_proxy(url, proxy_addr[i]) print(proxy_addr[i]) content = json.loads(data).get('data') try: # 试错有没有不存在的url profile_image_url = content.get('userInfo').get('profile_image_url') # 主页地址 description = content.get('userInfo').get('description') # 微博说明 profile_url = content.get('userInfo').get('profile_url') # 头像地址 verified = content.get('userInfo').get('verified') # 认证状态 guanzhu = content.get('userInfo').get('follow_count') # 关注 name = content.get('userInfo').get('screen_name') # 名字 fensi = content.get('userInfo').get('followers_count') # 粉丝 gender = content.get('userInfo').get('gender') # 性别 urank = content.get('userInfo').get('urank') # 微博等级 alldata = name + '+' + profile_url + '+' + profile_image_url + '+' + str( verified) + '+' + description + '+' + str(guanzhu) + '+' + str(fensi) + '+' + gender + '+' + str(urank) list = alldata.split('+') print(list) book = xlrd.open_workbook("savetest.xls") # 打开文件 nr = book.sheet_by_index(0).nrows # 打开工作表的行数 book_copy = copy(book) # 复制原来的文件 sheet = book_copy.get_sheet(0) # 打开复制的工作表 u = list for i in range(u.__len__()): sheet.write(nr, i, u[i]) # 在nr行往后写i个数据,数据在u[i]中 book_copy.save("savetest.xls") except AttributeError: book = xlrd.open_workbook("savetest.xls") # 打开文件 nr = book.sheet_by_index(0).nrows # 打开工作表的行数 book_copy = copy(book) # 复制原来的文件 sheet = book_copy.get_sheet(0) # 打开复制的工作表 u = [' '] for i in range(u.__len__()): sheet.write(nr, i, u[i]) # 在nr行往后写i个数据,数据在u[i]中 book_copy.save("savetest.xls") if __name__ == "__main__": for i in range(0, 50000): print(i) url = read_url(i) i = i // 100 # 输出100个换个ip if url != 0: get_userInfo(url, i) else: book = xlrd.open_workbook("savetest.xls") # 打开文件 nr = book.sheet_by_index(0).nrows # 打开工作表的行数 book_copy = copy(book) # 复制原来的文件 sheet = book_copy.get_sheet(0) # 打开复制的工作表 u = [' '] for i in range(u.__len__()): sheet.write(nr, i, u[i]) # 在nr行往后写i个数据,数据在u[i]中 book_copy.save("savetest.xls")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

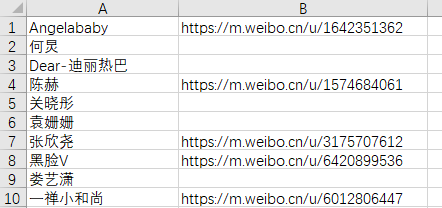

readtest.xls文件内容

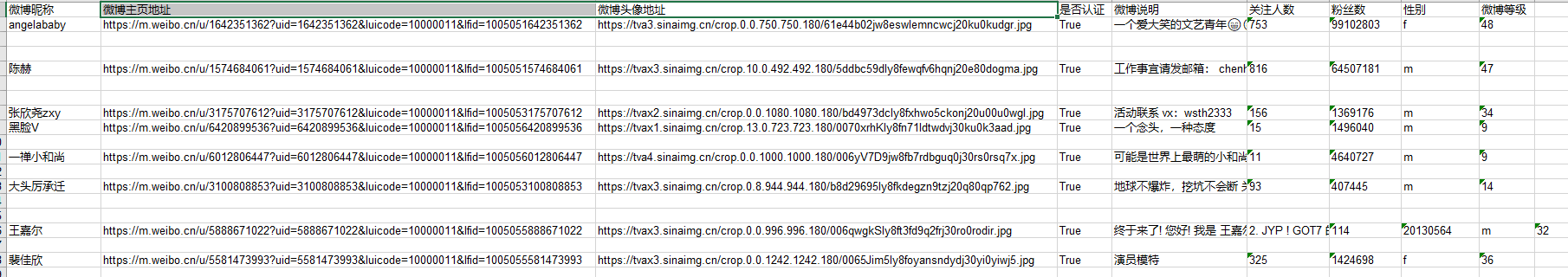

结果

爬取保存的结果savetest.xls

有任何疑问和想法,欢迎在评论区与我交流。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/blog/article/detail/56889

推荐阅读

- 在方法update()中,我们添加了一个if代码块而不是elif代码块,这样如果玩家同时按下了左右箭头键,将先增大飞船的rect.centerx值,再降低这个值,即飞船的位置保持不变。在处,我们修改了游戏在玩家按下右箭头键时响应的方式:不... [详细]

赞

踩

- article

已解决WARNING: pip is configured with locations that require TLS/SSL, however the ssl module in Python

已解决(pip升级报错)WARNING:pipisconfiguredwithlocationsthatrequireTLS/SSL,howeverthesslmoduleinPythonisnotavailable.Lookinginin... [详细]赞

踩

- 本文章利用Python实现一个简单的功能较为完善的区块链系统(包括区块链结构、账户、钱包、转账),采用的共识机制是POW。_python区块链python区块链本文章利用Python实现一个简单的功能较为完善的区块链系统(包括区块链结构、账... [详细]

赞

踩

- Tkinter是Python的标准GUI库,也是最常用的PythonGUI库之一,提供了丰富的组件和功能,包括窗口、按钮、标签、文本框、列表框、滚动条、画布、菜单等,方便开发者进行图形界面的开发。Tkinter库基于TkforUnix/Wi... [详细]

赞

踩

- article

Python flask跨域支持(Access-Control-Allow-Origin(CORS)跨域资源共享(访问控制允许来源:允许指定的来源进行跨域请求)浏览器同源策略、OPTIONS预检请求_flask cors

此外,还可以使用CORS(跨域资源共享)机制来明确指定允许跨域请求的规则,以减少潜在的安全风险。要检测一个Flask接口是否支持跨域请求,可以使用浏览器的开发者工具来查看请求和响应的相关信息。,那么只有GET请求会进入到对应的视图函数中,而... [详细]赞

踩

- 一、命令行安装pyecharts模块1、安装过程2、命令行验证pyecharts模块是否安装成功二、PyCharm安装pyecharts模块1、通过错误提示安装2、在Settings设置界面安装【Python】pyecharts模块②(命令... [详细]

赞

踩

- 最近,用Python给单位里用的“智慧食堂”系统编制了一个餐卡充值文件生成器,自动匹配餐卡号并快速生成导入数据用的Excel表格......使用tkinterToplevel控件弹出子窗口,用作设置备注的子窗口。_toplevelpytho... [详细]

赞

踩

- 随着软件规模和复杂性的增加,手动测试变得越来越繁琐且容易出错。自动化测试通过脚本化测试用例,能够更迅速、一致地验证软件的功能和性能。Selenium是一款强大的自动化测试工具,而Python语言则因其简洁性和易读性而成为自动化测试的首选之一... [详细]

赞

踩

- UI自动化测试实践,随着云计算时代的进一步深入,越来越多的中小企业企业与开发者需要一款简单易用、高能高效的云计算基础设施产品来支撑自身业务运营和创新开发。基于这种需求,华为云焕新推出华为云云服务器实例新品。这边文章由我带大家走一遍华为云云耀... [详细]

赞

踩

- 爬取斗鱼直播照片保存到本地目录【附源码】【python】爬取斗鱼直播照片保存到本地目录【附源码+文末免费送书】一、导入必要的模块: 这篇博客将介绍如何使用Python编写一个爬虫程序,从斗鱼直播网站上获取图... [详细]

赞

踩

- 本文展示如何使用库在Python中使用Excel文件。openpyxl是用于读取和写入Excel2010xlsx/xlsm/xltx/xltm文件的Python库。_pythonopenpyxlpythonopenpyxl各位好,我是轩哥啊... [详细]

赞

踩

- 每2秒获取一次UI控件的内容,实测挂在后台对CPU和内存占用并无明显影响,结合Pythonuiautomation的各种用法,可以做成自动回复的功能。Pythonuiautomation是一个用于自动化GUI测试和操作的库,它可以模拟用户操... [详细]

赞

踩

- UI自动化测试实践,随着云计算时代的进一步深入,越来越多的中小企业企业与开发者需要一款简单易用、高能高效的云计算基础设施产品来支撑自身业务运营和创新开发。基于这种需求,华为云焕新推出华为云云服务器实例新品。这边文章由我带大家走一遍华为云云耀... [详细]

赞

踩

- 如何使用Pycharm进行远程开发只要连接上服务器就能开始干活儿,不用折腾环境,不占用个人笔记本资源,最重要的是不用忍受笔记本的烂风扇噪音。PythonIDEPycharm服务器配置方法并结合内网穿透工具实现远程开发文章目录一、前期准备1.... [详细]

赞

踩

- 【代码】Python面试:单元测试unittesting。Python面试:单元测试unittesting&使用pytest1.对于函数进行单元测试calc.pydefadd(x,y):"""AddFunction"""returnx+yd... [详细]

赞

踩

- 讲解Python实现串口通信的过程和代码,实现了发送字符串(utf-8)数据和十六进制(hex)数据的串口通信,并且与自制stm32核心板实现了串口通信,并在OLED屏上显示通信数据。文章中有完整项目的下载链接。_python串口通信pyt... [详细]

赞

踩

- 你还可以使用RGB颜色模式自定义颜色。要指定自定义颜色,可传递参数c,并将其设置为一个元组,其中包含三个0~1之间的小数值,它们分别表示红色、绿色和蓝色分量。值越接近0,指定的颜色越深,值越接近1,指定的颜色越浅。关于“Python”的核心... [详细]

赞

踩

- 可能性最大的点数不是一个,而是5个,这是因为导致出现最小点数和最大点数的组合都只有一种(1和1以及6和10),但面数较小的骰子限制了得到中间点数的组合数:得到总点数7、8、9、10和11的组合数都是6种。接下来,我们设置hist的属性tit... [详细]

赞

踩

- UI自动化测试实践,随着云计算时代的进一步深入,越来越多的中小企业企业与开发者需要一款简单易用、高能高效的云计算基础设施产品来支撑自身业务运营和创新开发。基于这种需求,华为云焕新推出华为云云服务器实例新品。这边文章由我带大家走一遍华为云云耀... [详细]

赞

踩

- YOLOv8是一种物体检测算法,是YOLO系列算法的最新版本。YOLO(YouOnlyLookOnce)是一种实时物体检测算法,其优势在于快速且准确的检测结果。YOLOv8在之前的版本基础上进行了一系列改进和优化,提高了检测速度和准确性。Y... [详细]

赞

踩

相关标签