- 120210724-flask-跨域调用问题-blocked by CORS policy_python flask has been blocked by cors policy

- 2手把手教你使用Flask框架构建Python接口以及如何请求该接口_flask 接口

- 3Intellij idea 自定义阿尔萨斯arthas热加载插件_基于arthas实现热部署的idea插件

- 4Modern C++ std::bind的实现原理-举例

- 5计算机网络 应用层

- 6Android生成远程服务AIDL对应的java文件失败原因总结_导入itelephony.aidl生成java文件报错

- 7【docker系列】使用docker-compose安装私有镜像仓库Harbor_harbor docker-compose

- 8[力扣 Hot100]Day16 除自身以外数组的乘积

- 9【文心一言】使用飞桨 AI Studio 快速搭建,看图识猜成语应用

- 10kali Linux外网渗透控制Android安卓手机系统。_kali控制安卓手机

论文笔记——Influence Maximization on Undirected Graphs: Toward closing the (1 − 1/e) Gap_im问题最大度启发式算法

赞

踩

从理论计算机角度出发进行Influence MaximizationHeuristic algorithm

Influence Maximization(IM)领域的算法主要分为两类,像是之前看到的VoteRank,K-shell等影响力最大化算法都是启发式算法(Heuristic algorithm),从网络结构出发设计算法选取种子节点。作为IM领域的另一个分支,近似算法(Approximate Algorithm)是从理论计算机(TCS)角度出发解决IM问题,最经典的就是贪心算法(Greedy Algorithm),被证明达到了

1

−

(

1

/

e

)

1-(1/e)

1−(1/e)的近似。这类算法和启发式算法最大的区别就是具有理论保证,也就是这类算法在任何网络上最坏的情况下也能跑到某个近似值,相较而言稳定了许多。这篇论文是发表在计算机经济学顶会上的一篇paper,属于近似算法,从TCS角度进行了IM问题的探讨。其主要贡献为:

IM在IC和LT模型上都是APX-hard(对于任意常数

τ

\tau

τ,IM都存在

1

−

τ

1- \tau

1−τ的不可近似性)。同样,对于特殊的模型如uniform 以及加权的IC模型也具有APX-hardness的近似。 该paper的主要贡献如下:

也就是下图中红色的部分:

1、铺垫

1.1 IC和LT模型

对于这两个非常经典的模型就不展开细讲了,这里主要是对它们的live-edge版本(live-edge interpretation)进行阐述。

IC模型的live-edge版本

设 I C ^ G ( S ) \widehat{IC}_G(S) IC G(S)为集合 S S S通过概率为 p u , v p_{u,v} pu,v的边的可达集,那么 I C ^ G ( S ) \widehat{IC}_G(S) IC G(S)则和IC模型等同。值得一提的是,对于uniform IC模型(所有的边权重相同,为一个参数),节点 u u u到 v v v的信息传递 = = =节点 v v v到 u u u的传递;而在weighted IC模型中节点 u u u到 v v v的信息传递 ≠ \neq =节点 v v v到 u u u的传递, w ( u , v ) = 1 d e g ( v ) , w ( v , u ) = 1 d e g ( u ) w(u,v)=\frac{1}{deg(v)},w(v,u)=\frac{1}{deg(u)} w(u,v)=deg(v)1,w(v,u)=deg(u)1;对于无向图(undirected graph),将它看作特殊的有向图。

LT模型的live-edge版本

较IC模型更复杂。设 L T ^ G ( S ) \widehat{LT}_G(S) LT G(S)为集合 S S S的可达集,其中,对于节点 v v v的邻居 u 1 , . . . , u T u_1,...,u_T u1,...,uT,第 t t t条边被选中的条件为 r ∈ [ ∑ i = 1 t − 1 w u i , v , ∑ i = 1 t w u i , v ] r \in [\sum_{i=1}^{t-1}w_{u_i,v},\sum_{i=1}^{t}w_{u_i,v}] r∈[∑i=1t−1wui,v,∑i=1twui,v],当 r > ∑ i = 1 T w u i , v r > \sum_{i=1}^{T}w_{u_i,v} r>∑i=1Twui,v时, v v v不进行选边。这里的 r r r便为概率, [ ∑ i = 1 t − 1 w u i , v , ∑ i = 1 t w u i , v ] [\sum_{i=1}^{t-1}w_{u_i,v},\sum_{i=1}^{t}w_{u_i,v}] [∑i=1t−1wui,v,∑i=1twui,v]便为LT模型中的阈值。

为了直观地理解这个模型,设 v v v为一个尚未受感染的顶点, I N ( v ) IN(v) IN(v)为其一组已感染的邻居节点, v v v被 I N ( v ) IN(v) IN(v)中的顶点感染的概率为 P r ( θ ≤ ∑ u : u ∈ I N ( v ) w ( u , v ) ) = ∑ u : u ∈ I N ( v ) w ( u , v ) Pr(\theta \leq \sum_{u:u \in IN(v)}w(u,v))=\sum_{u:u \in IN(v)}w(u,v) Pr(θ≤∑u:u∈IN(v)w(u,v))=∑u:u∈IN(v)w(u,v)。同样,节点 u u u和 v v v的传播在uniform LT模型(每条边 ( u , v ) (u,v) (u,v)的权重为 1 d e g ( v ) \frac{1}{deg(v)} deg(v)1)以及undirected LT模型中依然是不对称的。

1.2 PCP定理

对于3-SAT的一个案例

ϕ

\phi

ϕ,存在常数

d

d

d以及

γ

∈

[

0

,

1

]

\gamma \in [0,1]

γ∈[0,1]使得

ϕ

\phi

ϕ中的每个变量最多出现

d

d

d次,则有:

由PCP定理可得出一个extension:对于图

G

=

(

V

,

E

)

G=(V,E)

G=(V,E),同样存在常数

d

d

d以及

γ

∈

[

0

,

1

]

\gamma \in [0,1]

γ∈[0,1]使得图中节点的度最多为

d

d

d,节点个数为

∣

V

∣

=

3

n

|V|=3n

∣V∣=3n,且有:

另一个extension:对于无向图

G

=

(

V

,

E

)

G=(V,E)

G=(V,E),存在常数

d

d

d以及

γ

∈

[

0

,

1

]

\gamma \in [0,1]

γ∈[0,1]使得图中节点的度最多为

d

d

d,对于整数

k

k

k,有:

证明过程详见论文。

2、APX-hardness

对于uniform IC和LT模型,有:

对于加权的IC模型,有:

通过在UIC上引入下面的问题

很明显,这里要证明方法肯定是将IM问题规约到

I

n

d

S

e

t

IndSet

IndSet问题。简单总结一下,通过给一个

I

n

d

S

e

t

IndSet

IndSet的instance添加哑节点,使得所有节点的度都为

d

d

d,那么当

I

n

d

S

e

t

IndSet

IndSet是一个yes instance时(这里用到了公式

a

n

−

b

n

=

(

a

−

b

)

(

a

n

−

1

+

a

n

−

2

b

+

a

n

−

3

b

2

+

.

.

.

+

b

n

−

1

)

a^n-b^n=(a-b)(a^{n-1}+a^{n-2}b+a^{n-3}b^2+...+b^{n-1})

an−bn=(a−b)(an−1+an−2b+an−3b2+...+bn−1)),可以推出:

当

I

n

d

S

e

t

IndSet

IndSet是NO instance时,推出:

不难发现No下的小于yes下的,因此另

同样,在LT模型上也引入了定理:

3.5的证明过程如下:

LT模型难点在于所有边的概率

p

(

u

,

v

)

p(u,v)

p(u,v)已经由节点的度决定了,所以

p

p

p难以进行调整。在这篇paper中,作者使用了一个小技巧:通过给所有的点都连接哑节点(Dummy nodes),使得所有节点的度为

D

D

D,且

D

D

D足够大。如此一来,

p

p

p的影响就会减小。

对于加权的IC模型,则有:

WIC的证明方法和ULT类似。

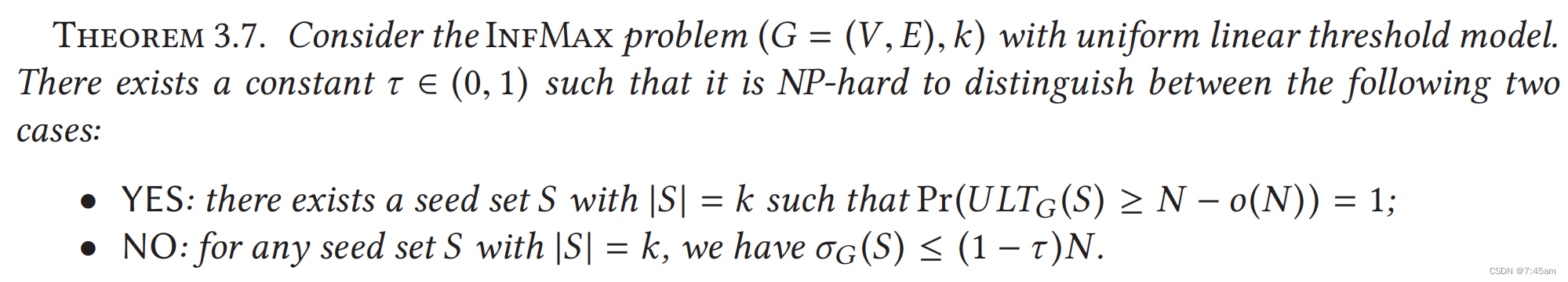

对本章进行总结,也是对定理3.2的总结。这里便是文章观点的核心内容。

这个定理也是一个不可近似性,和前面不一样的情况是,YES instance对应了基本上所有点都会被传染。一般的不可近似性说的是yes和no之间有一个gap,但是并没有保证yes对应了多少,no对应了多少。这个定理说的是,即便是yes对应了几乎是N的值,这个不可近似性结论仍然成立。

3、upper bounds

这一章分别对LT、UIC、WIC进行上界分析。可以理解为从不同角度(节点的局部特征)对

I

n

f

M

a

x

InfMax

InfMax进行了分析。首先引入"lift"这一概念。

如图所示,lift是原图

G

G

G的变种,用

G

^

\widehat{G}

G

表示,存在两个性质:

G

^

\widehat{G}

G

中的节点数目

≥

G

\geq G

≥G中节点数目,且种子节点与非种子节点的连边数目保持一致。

3.1 Uniform IC model

3.2 Linear threshold models

这里要证明的是在LT模型中,每一个种子节点传播个数的上限。可以理解为是从不同角度对我们称该过程为“缩水”。

证明如下:下图为一个非常简单的t树

T

T

T。对于parent节点

u

u

u,一旦

u

u

u被感染,其三个children也会被感染(

p

(

u

,

v

)

=

1

d

e

g

(

v

)

p(u,v)=\frac{1}{deg(v)}

p(u,v)=deg(v)1=1),故左边的图和右边的图有着同样的效果。得证。

Lamma 4.3 的作用:一个节点在添加了dummy nodes之后,其感染节点的期望仍然不变。

这个推论表明,LT模型在无向图中,在树结构上能达到最大程度的传播力度,而往树结构中添加边往往会造成传播能力的下降。该结论与常识相悖,这是因为添加边这一操作,会对LT模型以及WIC(weighted IC)模型中的节点造成度的变化,进而影响了节点的信息传播能力。总而言之,在图中添加边这一操作,弊大于利。

3.3 Weighted IC model

3.4 Refined upper bounds

由于

故定理4.9和4.10进一步缩小了上界。

这里进一步对“lift”进行改造。Seed依然是root,这里与之前“lift”不同的是,与seed相邻的非种子节点作为中间商赚差价,连接了邻居中的seed nodes和非seed nodes。下图中的

G

^

A

b

\widehat{G}_A^{b}

G

Ab便是新的lift。

对定理4.9进行证明:在

G

^

A

b

\widehat{G}_A^{b}

G

Ab中去掉种子节点S,那么

G

^

A

b

\widehat{G}_A^{b}

G

Ab就成了以中间商为root的树了。对这棵树进行缩水(Lamma 4.3),便可得到中间商及其邻居,中间商以

δ

v

d

e

g

(

v

)

\frac{\delta_v}{deg(v)}

deg(v)δv的概率,去感染其非种子邻居,个数为

d

e

g

(

v

)

−

δ

v

deg(v)-\delta_v

deg(v)−δv。故该次感染总期望为:

得证。

接着是对Lamma 4.10的证明:和上述证明一致,在缩水之后,每个中间商感染其邻居的概率为

(

1

−

(

1

−

1

d

e

g

(

v

)

δ

v

)

)

≤

δ

v

d

e

g

(

v

)

(1-(1-\frac{1}{deg(v)}^ {\delta_v})) \leq \frac{\delta_v}{deg(v)}

(1−(1−deg(v)1δv))≤deg(v)δv,个数为

d

e

g

(

v

)

−

δ

v

deg(v)-\delta_v

deg(v)−δv。故该次感染总期望为:

最后,对于Uniform IC,根据假设

p

<

1

d

p < \frac{1}{d}

p<d1,有:

由于实践中基本上不可能有

p

<

1

d

p < \frac{1}{d}

p<d1,故不再展开UIC的讨论。

4 总结

- 通过修改sass变量、class,全局修改element-ui样式。1.安装sass2.判断情况当node版本低于14时,安装以下两个版本,“node-sass”:“4.14.0”,“sass-loader”:“7.1.0”当node版本为... [详细]

赞

踩

- 三行代码帮你实现最简单的病毒用来整蛊小伙伴让你的小伙伴电脑死机快去试一试*首先在桌面建一个记事本输入下面的内容:startstartcmdgotostart然后保存将.txt改为.bat双击运行就OK了运行结果如下:是不是很好玩快去试试原理... [详细]

赞

踩

- Inspector面板扩展(EditorGUILayout)我们的Unity脚本挂在游戏对象上时,右侧会出现它的详细信息面板,这些信息是根据脚本中声明的public可序列化变量而来的。此外,也可以通过EditorGUI来对它进行绘制,让面板... [详细]

赞

踩

- alteruser'root'@'localhost'identifiedby'你的新密码';为了保证数据库目录与文件的所有者为mysql登录用户,如果你是以root身份运行mysql服务。mysql--version或者mysqladmi... [详细]

赞

踩

- 首先要创建两套颜色主题第一步:在根目录下创建存放主题.scss文件的目录,在改目录下创建主题.scss第二步:设置两套背景和文字颜色颜色的设置:尽量少,背景和字体颜色要相反,否则看不清。但是还要看UI的安排。$themes:(light:(... [详细]

赞

踩

- Docker概述Docker为什么出现一款产品从开发到上线,从操作系统,到运行环境,再到应用配置。作为开发+运维之间的协作我们需要关心很多东西,这也是很多互联网公司都不得不面对的问题,特别是各种版本的迭代之后,不同版本环境的兼容,对运维人员... [详细]

赞

踩

- 一.目的1.二.参考三.操作:一:解决商城导入资源出现问题:完成1.问题:商城资源导入后有报错,并且无法解决.1.解决方法a:将原本的工程里面的模型,重新放置文件夹,然后做成预制件,然后导出来,再导入到自己的工程里面, b:导入自己工程里面... [详细]

赞

踩

- 14PIN的JTAG设计,是ADI从2000年至今一直延续下来的一个JTAG标准设计,很多兄弟在做硬件设计的时候,最常问的一个问题就是:JTAG接口定义是什么?更多的只知道抄原厂评估板的参考设计,而并不是非常了解这个JTAG,导致设计的JT... [详细]

赞

踩

- 1:获取想要的镜像方法一:1:访问DockerHub可以获取需要的镜像:https://hub.docker.com2:点击Explore可以在页面选择需要的镜像,我们以node为例需要改镜像我们只需用点击箭头所示进入页面3:进入页面后我们... [详细]

赞

踩

- vue切换主题颜色_vue将字体颜色设置白色,背景色设置为黑色vue将字体颜色设置白色,背景色设置为黑色实现效果 一。应用方法 1.css3伪类选择器 2.CSSStyleDeclaration.s... [详细]

赞

踩

- Unity版本:5.3.4及以上现象:在UnityEditor里,将一个prefab打包成Android平台的assetbundle,再load出来,看到的prefab表现与实际的prefab表现不一致原因:Android平台的assetb... [详细]

赞

踩

- article

module 'cv2.cv2' has no attribute 'xfeatures2d'(问题已解决,亲测有效!)_module 'cv2.cv2' has no attribute 'xfeatures2d

遇到上述问题时,网友多是建议补个包,即pipinstallopencv-contrib-python我在补完之后又出现下面这样的错误:OpenCV(3.4.3)C:\projects\opencv-python\opencv_contrib... [详细]赞

踩

- 在JavaUI框架中,提供了两种编写布局的方式:在XML中声明UI布局和在代码中创建布局。这两种方式创建出的布局没有本质差别,为了熟悉两种方式,我们将通过XML的方式编写第一个页面,通过代码的方式编写第二个页面。一招就行—鸿蒙OS编写第一个... [详细]

赞

踩

- Qt5.12学习笔记--QMLandC++混编概述1简介2优缺点2.1优点2.2缺点3QML使用C++步骤3.1从QObject派生3.2注册方法4C++使用QML步骤5选择正确的混编方法参考1简介QML被设计为可通过C++代码轻松扩展。Q... [详细]

赞

踩

- 浅谈一下qt美化qss功能qt“美颜”要想成为一名优秀的qt工程师学会使用qss编程也是重要的不可获缺的一部分qss简介和优势QSS(QtStyleSheets)是一种用于定义Qt应用程序界面外观和样式的样式表语言。它类似于CSS(层叠样式... [详细]

赞

踩

- 图像拼接(ImageStitching)是一种利用实景图像组成全景空间的技术,它将多幅图像拼接成一幅大尺度图像或360度全景图,接可以看做是场景重建的一种特殊情况,其中图像仅通过平面单应性进行关联。图像拼接在运动检测和跟踪,增强现实,分... [详细]

赞

踩

- cublas库是在NVIDIACUDA上实现blas(基本线性代数子程序),该库是已经封装好的,可以利用该库进行向量和矩阵的多种操作,具体不在赘述。下面来介绍调用cublas库可能会出现的问题以及解决办法。1.首先调用cublas库需要添加... [详细]

赞

踩

- 接上篇《PHY芯片详解》,实例介绍工程中PHY的应用,包括原理图设计、配置和软件设计。五ZYNQPS网络通信5.1PHY芯片原理图设计从原理图可以得知:① 网络控制器使用的是ZYNQ的PS网络控制器。② 关于PHY的配置,大部分通过硬件配置... [详细]

赞

踩

- 使用VS2013+QT5.7新建一个OpenDDS项目,假设已经包含目录和链接库都已经配置好了,编译通过了,但是在链接的时候,还是出现了错误:1>ReadData.obj:errorLNK2001:无法解析的外部符号"__declspec(... [详细]

赞

踩

- 在日常生活中,有好听的翻唱视频或音乐视频可以将其音频分离保存到网易云或QQ音乐中随时听,然而大部分的音频分离软件需要下载和安装,使用起来极其笨重,本文提供了一种提取音频的简便方法。打开Cmd或者PowerShell输入一下命令安装库2.核心... [详细]

赞

踩