- 1【语义分割】分层多尺度注意力 Hierarchical multi-scale attention for semantic segmentation_跨尺度分层注意力网络

- 2彻底卸载微软拼音输入法

- 3论文《Exploring to Prompt for Vision-Language Models》阅读

- 4jvm - Arthas java诊断工具 - 线程相关(thread -b找出当前阻塞其他线程的线程)_arthas thread -b

- 5算法工程师-机器学习-分类回归模型面试常见题_假设一个数据集可以分成g个集合,每个集合中的数据是相似的,g的取值在2和g之间,y是

- 6Spring Boot集成JSch快速入门demo

- 7现在学python容易就业吗?_python好就业吗?

- 8Transformer、Bert、GPT简介_transformer, bert, and gpt including chatgpt and p

- 9探索ORACLE之ASM概念(完整版)_oracleasmlib

- 1020211220使用Hiburn给小熊派刷机_ready to load at 0x10a000 ccstartburn total size:0

性能强,成本低,运行快!最强开源大模型出现,超越ChatGPT和Llama!

赞

踩

大数据人工智能公司 Databricks放大招了! 3月27日,该公司开源了通用大模型 DBRX,并声称该模型是迄今为止全球最强大的开源大型语言模型,比 Meta 的 Llama 2 更为强大。

GPT-3.5研究测试:

https://hujiaoai.cn

GPT-4研究测试:

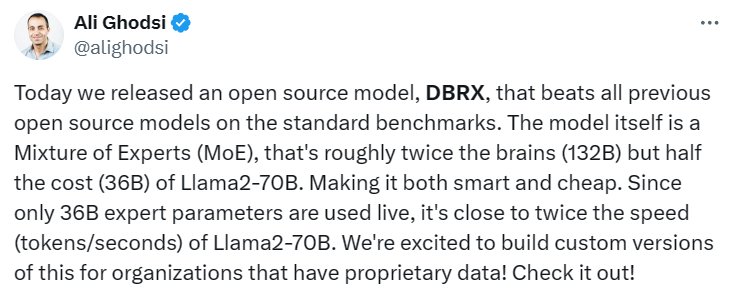

https://higpt4.cn Databricks CEO&创始人 Ali Ghodsi表示,DBRX不仅在测试中超过了所有先前的开源模型,而且该模型本身是一个专家混合模型(MoE),大致上拥有两倍的计算能力(132B),但成本只有Llama2-70B的一半(36B),这使得它既聪明又廉价。并且DBRX的运行速度接近于Llama2-70B的两倍。

DBRX 是在 12 万亿 Token 的文本和代码上预训练的 16×12B MoE LLM,它支持的最大上下文长度为 32k Tokens,并使用了DBRX 使用旋转位置编码 (RoPE)、门控线性单元 (GLU) 和分组查询注意力 (GQA) 等技术来提高模型质量,Hugging Face 工程师 Vaibhav Srivastav 用狂野表示他对DBRX性能的震撼!

知名的机器学习专家、著名书籍《The Hundred-Page Machine Learning Book》的作者Andriy Burkov表示DBRX性能十分强大,如果你有足够多的大型GPU来进行微调,那么结果将是开放式语言模型中最好的。

综合来看,DBRX主要有三个优势,第一性能强,第二成本低,第三运行快!

目前,DBRX的基础版本(DBRX Base)和微调版本(DBRX Instruct)都可以在GitHub和AI开发平台Hugging Face上免费获取,供研究和商业使用。用户可以在公共、自定义或其他专有数据上运行和调整。

DBRX Base Hugging Face地址:

https://huggingface.co/databricks/dbrx-base

DBRX Instruct Hugging Face地址:

https://huggingface.co/databricks/dbrx-instruct

Github链接:

https://github.com/databricks/dbrx

让我们来看看DBRX的具体表现吧~

性能测试

DBRX 与开源模型比较

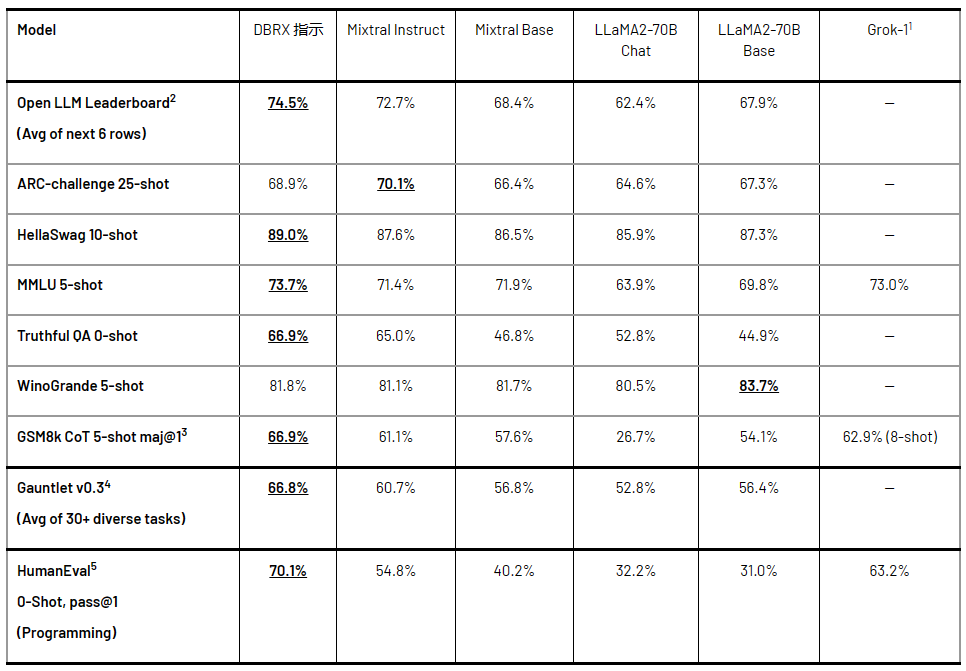

DBRX在语言理解、编程以及数学推理等任务上轻松超越了Meta公司的Llama2-70B、法国Mixtral AI公司的Mixtral以及马斯克刚刚开源的 Grok-1等主流开源大模型。

在两个综合基准测试上评估了DBRX Instruct和其他模型:Hugging Face开放LLM排行榜(包括ARC-Challenge、HellaSwag、MMLU、TruthfulQA、WinoGrande和GSM8k的平均分)和Databricks模型Gauntlet(包含超过30个任务,涵盖世界知识、常识推理、语言理解、阅读理解、符号问题解决和编程等六个类别)。 DBRX Instruct在综合基准测试、编程和数学基准测试以及MMLU方面是领先的。它在标准基准测试中超过了所有聊天或指导微调模型。

DBRX 与闭源模型比较

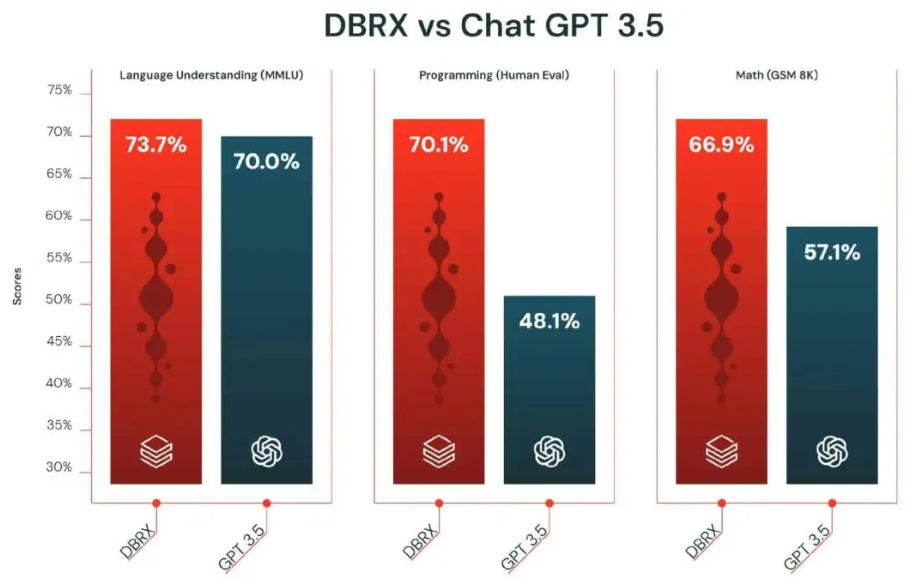

DBRX Instruct 超越了 GPT-3.5(如 GPT-4 论文中所述),并且与 Gemini 1.0 Pro 和 Mistral Medium 具有相当的竞争力。

其中,最让人惊喜的是,在各个评测任务中,DBRX Instruct要么与GPT-3.5持平要么明显超越GPT-3.5,虽然和GPT-4相比仍有一定差距,但是DBRX Instruct毕竟是个开源模型,这样的结果可以让科研工作者一定程度上减少对闭源模型的依赖。看来越来越多的公司可以和OpenAI抗衡了!

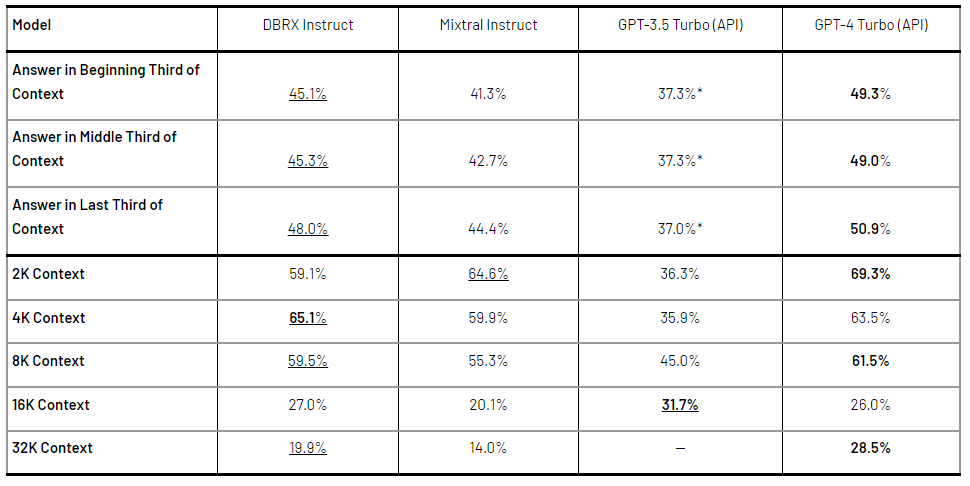

长下文任务和 RAG

DBRX Instruct 训练上下文窗口大小为 32K token。DBRX Instruct 表现比 GPT-3.5 Turbo 好;DBRX Instruct 和 Mixtral Instruct 的整体性能相似。

训练效率

在Databricks的研究中,DBRX Instruct模型在计算效率和质量方面取得了显著进展,通过混合专家模型、改进数据质量和优化策略等手段,有效提高了训练和使用模型的效率。

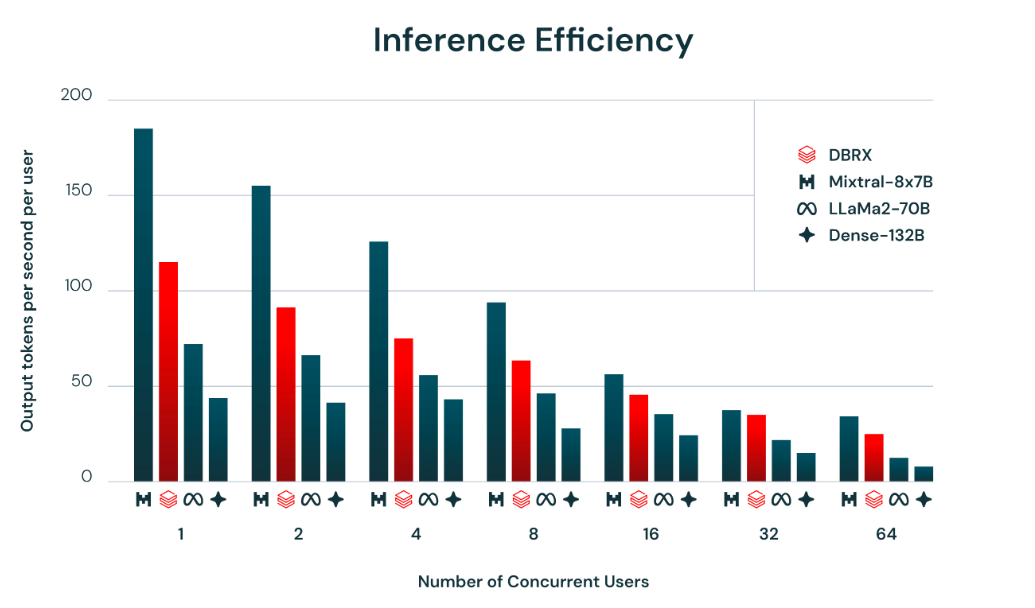

推理效率

DBRX和类似模型在推理效率方面表现出色,MoE架构使得在模型质量和推理效率之间取得更好的平衡,DBRX的推理吞吐量比非MoE模型高2-3倍。

通过测试可以看出,对于同样的输入数据和同样的任务,DBRX Instruct的生成速度要明显快于Llama 2 7B Chat。(图源网络)

结论

本文介绍了DBRX新的开源大模型,该模型在各个任务上都达到了开源大模型的SOTA,并且成功超越或持平了GPT-3.5等常用的闭源大模型,更为重要的是,MoE架构使得DBRX Instruct在模型性能和推理效率之间取得更好的平衡,推理速度也明显快于当前常用的开源大模型,也许,开源的大模型就此崛起!