热门标签

热门文章

- 1pycharm运行正常,但命令行执行提示module不存在的多种解决方式(全)_python 找不到module

- 2解密大模型LLMs出现复读现象的原因_语言模型 一直输出重复的词

- 3Docker pull镜像一直在Waiting无法下载,根本解决方法_docker pull waiting

- 4Selenium基础篇之八大元素定位方式_selenium入门及元素定位

- 5ARM资源记录《AI嵌入式系统:算法优化与实现》第八章(暂时用不到)_ai嵌入式系统:算法优化与实现 pdf下载

- 6Scala的安装与使用_scala.msi是什么文件

- 7Mysql的insert批量插入性能问题_mysql sql过长导致的批量插入性能问题

- 8python调用opencv_Python使用opencv

- 9GEO芯片数据处理、多芯片数据合并、差异分析、核心基因提取、核心基因与免疫细胞相关性_如何查询肿瘤免疫细胞浸润的gse数据

- 10高速串行总线设计基础(三)SERDES的通用结构介绍_哪些结构在高速serdes中比较常见

当前位置: article > 正文

中文微调版llama3来了,附ollama部署方法_ollama 文生图

作者:小桥流水78 | 2024-07-29 15:11:12

赞

踩

ollama 文生图

在人工智能的浩瀚星空中,刚发布不久的Llama 3如同一颗璀璨的星辰,以其强大的能力照亮了智能对话的未来。然而,即便是如此耀眼的存在,也因为某些不可说的原因在中文世界面前显得有些力不从心。但现在,一道曙光划破了这片迷雾——中文微调版的Llama 3正式登场,它的地址是:https://github.com/ymcui/Chinese-LLaMA-Alpaca-3。

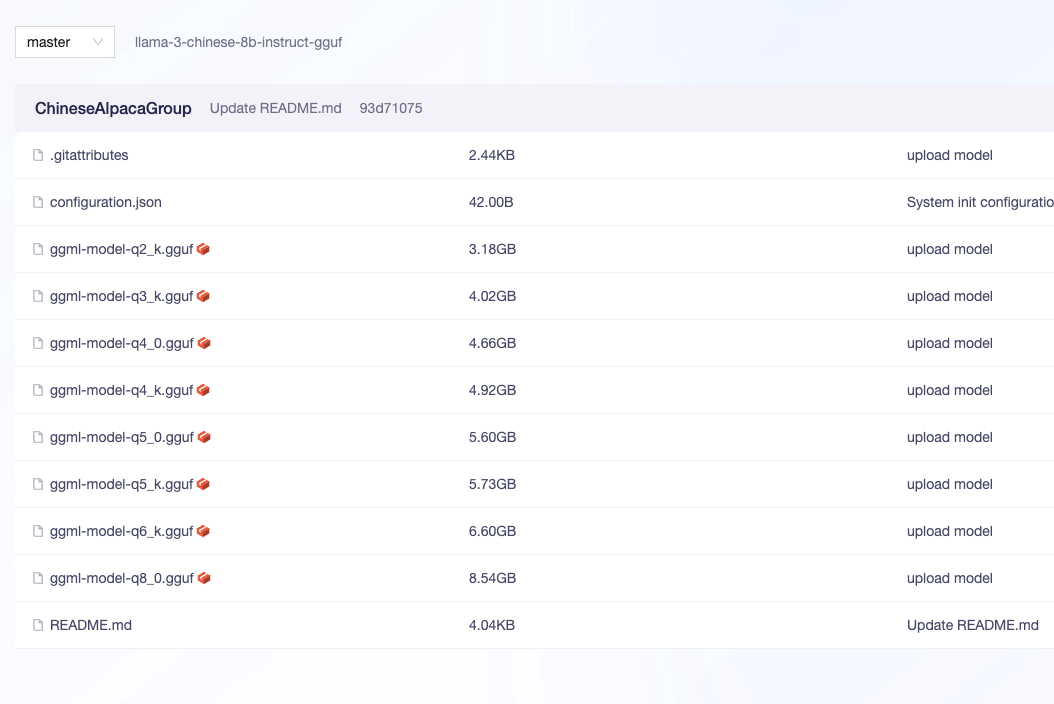

这个版本并非官方出品,因此,我们不能直接使用ollama进行下载。但别担心,魔搭社区为我们提供了下载的途径。只需点击README中的魔搭社区地址,下载ggml-model-q8_0.gguf,然后按照以下步骤操作:

- 编写Modelfile,内容如下:

FROM /models/ollamamodels/ggml-model-q8_0.gguf TEMPLATE """{{ if .System }}<|start_header_id|>system<|end_header_id|> {{ .System }}<|eot_id|>{{ end }}{{ if .Prompt }}<|start_header_id|>user<|end_header_id|> {{ .Prompt }}<|eot_id|>{{ end }}<|start_header_id|>assistant<|end_header_id|> {{ .Response }}<|eot_id|>""" SYSTEM """""" PARAMETER num_keep 24 PARAMETER stop <|start_header_id|> PARAMETER stop <|end_header_id|> PARAMETER stop <|eot_id|> PARAMETER stop assistant PARAMETER stop Assistant

- 1

-

将

FROM后面的路径替换为你自己的路径。 -

运行以下命令创建模型:

ollama create my-llama3 -f Modelfile

- 1

如此一来,一个本地运行的Llama 3模型便诞生了。经过我的亲自测试,这个经过微调的版本在中文支持度上有了显著的提升,不再出现中英文混杂的情况,让智能对话更加流畅自然。

让我们一起拥抱这个更加智能、更加懂中文的Llama 3,开启智能对话的新篇章!

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小桥流水78/article/detail/899357

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小桥流水78/article/detail/899357

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。