- 1微信小程序开发 | 音乐小程序项目_微信小程序音乐小程序项目

- 2Python-OpenCV车牌识别系统_基于opencv的python车牌识别系统

- 3将SQL中几张表设为只读,这是什么奇怪需求?

- 4不安全的HTTP方法_不安全的http请求方法

- 5flask部署到阿里云ECS主机端口冲突问题解决办法_部署两个flask 服务冲突

- 6伪造高清人像——PGGAN原理解析_proggan模型讲解

- 7OpenAI官方的Prompt工程指南:可以这么玩转ChatGPT_openai prompt engineering中文翻译

- 8C++:string类(第一章)

- 9【Python单点知识】类成员汇总讲解——包含类方法、静态方法、私有成员说明_python类中的成员

- 10【计算思维题】少儿编程 蓝桥杯青少组计算思维 数学逻辑思维真题详细解析第7套_.下图中,乐乐家的位置 数对(4,3)表示,学校在乐乐家 南 向。下列选项中,

NLP+图神经网络+推荐领域】最值得看的经典综述文献_pyg书籍

赞

踩

学习永无止境。在本文中我将NLP领域、图神经网络、推荐领域三个技术模块,结合行业技术发展与研究,重新整理历史经典综述文献与最新文献,去其糟粕,取其精华,喜欢记得收藏、点赞、关注。

NLP领域,有哪些值得推荐的综述性文章?

NLP领域覆盖的应用场景较多,其中很多场景都需要对文本进行深度的语义分析才能够较好的完成任务,例如问答、翻译、对话、指代消解等。而其中很多任务由于标注成本非常高,能够获取的有监督语料比较少,传统的序列标注模型能够提升的幅度有限。

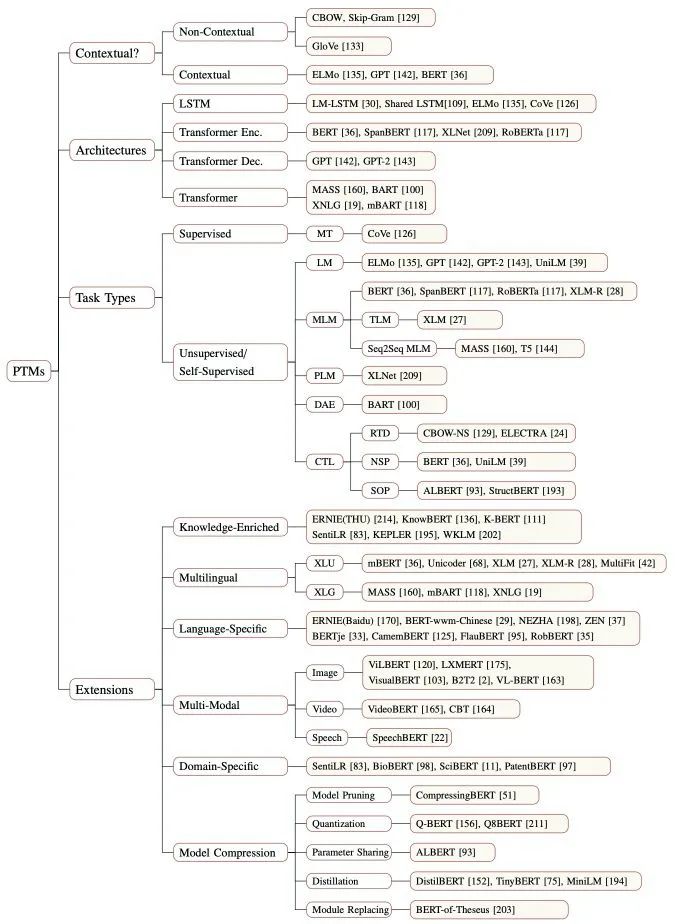

近年来,随着预训练模型的发展,越来越多的NLP任务范式都演变成了先用大规模无监督语料进行预训练或者是使用已经训练好的预训练模型进行初始化,然后在对应的子任务上再次进行参数拟合。

首先,重点可以阅读复旦大学邱锡鹏老师写的

阅读地址:

https://arxiv.org/pdf/2003.08271.pdf

技术提升

论文探讨、算法交流、求职内推、干货分享、解惑答疑,与2000+来自港大、北大、腾讯、科大讯飞、阿里等开发者互动学习。

项目源码、数据、技术交流提升,均可加交流群获取,群友已超过2000人,添加时最好的备注方式为:来源+兴趣方向,方便找到志同道合的朋友

方式①、添加微信号:mlc2060,备注:来自CSDN +研究方向

方式②、微信搜索公众号:机器学习社区,后台回复:加群

邱老师的综述文章对预训练的前因后果做了详细的介绍,针对预训练的模型设计、应用场景相关的论文做了精细的分类和整理:

阅读地址:

https://nndl.github.io/

从工业界应用的角度来看,可以分这些领域和话题重点关注。

▐ 多模态相关

在实际的应用场景中,用户对于外部世界的感知是多模态的,如何利用语音、图像以及一些知识图谱等来提升预训练的效果是未来一个重要的探索、突破方向。

相关的文章可以补充看看近期百度提出的这篇:

阅读地址:

https://arxiv.org/abs/2012.1540

以及阿里巴巴的这篇:

阅读地址:

https://arxiv.org/pdf/2003.13198.pdf

▐ 快速提升模型的训练速度以及在线解码的效率

这篇综述也值得拓展阅读,从模型结构、效率优化、应用场景等多个维度详细介绍了Transformer相关研究的最新进展。

阅读地址:

https://arxiv.org/pdf/2003.13198.pdf

由于Transformer的模型结构简洁、高效,能够充分利用大规模训练语料的优势,目前不仅在NLP领域成为标配,在图像、语音和推荐等重要领域都在朝着SOTA迈进,很有必要持续跟进相关的研究工作进展。

▐ 语言生成

语言生成是NLP领域的重要分支,其中的机器翻译和多轮对话在工业届已经有不错的落地场景,相关的研究工作也值得仔细阅读。

传统的语言生成相关的任务,可以看下前几年的一篇综述:

佛阅读地址:

https://arxiv.org/abs/1703.09902

机器翻译的最新进展可以关注下谷歌AI和谷歌翻译2020的总结 :

阅读地址:

https://ai.googleblog.com/2020/06/recent-advances-in-google-translate.html

阅读地址:

https://ai.googleblog.com/2021/01/google-research-looking-back-at-2020.html#Translation

涉及多语种、低资源和测评多个领域的研究进展,以及Facebook FAIR的NMT进展

阅读地址:

https://arxiv.org/abs/2010.11125

机器翻译的测评。

阅读地址:

http://www.statmt.org/wmt20/

每年国内外知名科研机构和工业界都有团队参加,贡献的技术报告也可以了解到当前实用的提升翻译性能的机器翻译技术。

Philipp Koehn 17年写的这篇,里面提到的挑战是NMT领域未来重点关注的方向。

阅读地址:

https://www.aclweb.org/anthology/W17-3204.pdf

▐ 对话领域

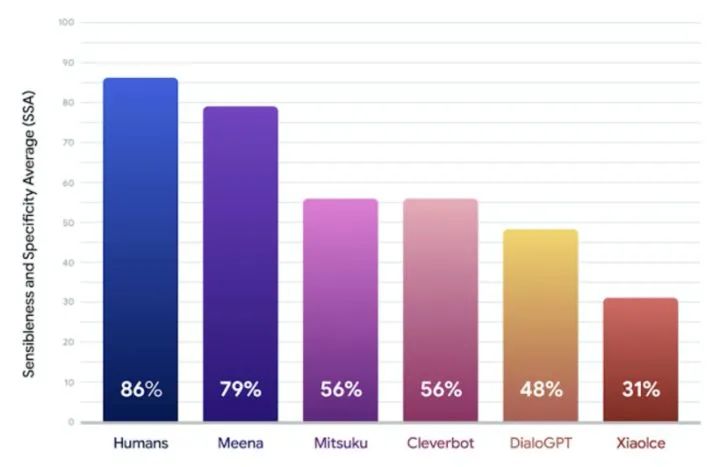

对话领域可以重点关注下谷歌去年的工作,简单粗暴的大模型和大数据直接碾压了之前SOTA的结果。

阅读地址:

https://arxiv.org/abs/2001.09977

谷歌的 Meena 和 Facebook 的Blender 很好地诠释了深度学习在NLP领域的一个发展方向:简单粗暴+大力出奇迹。

阅读地址:

https://ai.googleblog.com/2020/01/towards-conversational-agent-that-can.html

图神经网络,有哪些值得推荐的综述性文章

图神经网络和卷积神经网络有着一脉相承的理论基础,建议可以此先了解卷积神经网络的一些基础理论知识。这个可以直接看吴恩达老师《卷积神经网络》的第一周课程。

至于图神经网络,它是2017年才逐渐火起来的,相应的系统性的资料较少。这里给题主列出一些我自己在学习时使用到的书籍、视频等资料。

《深入浅出图神经网络》,这本书是从原理、算法、实现、应用4个维度详细讲解图神经网络的,整体排版很舒服,对于想快速上手的小伙伴较为友好。

阅读地址:

https://www.zhihu.com/topic/21216055/hot

目前有的两大类较火的GNN方向,一个是谱域的卷积的代表GCN,背后有很深的理论支撑,可以关注问题【如何理解 Graph Convolutional Network(GCN)】(https://www.zhihu.com/question/54504471) ,下面有很多大神的精彩回答。

另一个是空域卷积的代表GraphSAGE和GATs。可以搭配b站上【2020 图神经网络在线研讨】(https://www.bilibili.com/video/BV1hC4y1a7To)视频一起食用,视频中有唐杰老师、石川老师、沈华伟老师以及宋国杰老师四位领域大牛介绍图神经网络,有基础有前沿,适合快速掌握领域科研趋势。

在有了上面知识后,可以尝试去看论文,进一步深入探究。这里给出清华大学在GitHub上的一个必读论文的汇总——

阅读地址:

https://github.com/thunlp/GNNPapers

最后在实现方面,目前已经有很多公司针对图数据的训练推出了图神经网络的框架。这里主要列出三个学术界常用框架,供题主根据实际任务快速实现自己图神经网络。

Deep Graph Library(DGL):由New York University(NYU)和Amazon Web Services(AWS)联合推出,支持PyTorch、MXNet和TensorFlow作为其后端。

github:github.com/dmlc/dgl

帮助文档:docs.dgl.ai/

PyTorch Geometric(PyG):由德国多特蒙德工业大学推出,对PyTorch用户来说是极为友好。

github:github.com/rusty1s/pyto

帮助文档:pytorch-geometric.readthedocs.io

tf_geometric:GNN的TensoFlow版本,适合tf用户。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-liqncOQO-1683386638816)(null)]

github:github.com/CrawlScript/

帮助文档:tf-geometric.readthedocs.io

推荐领域,有哪些值得推荐的综述性文章

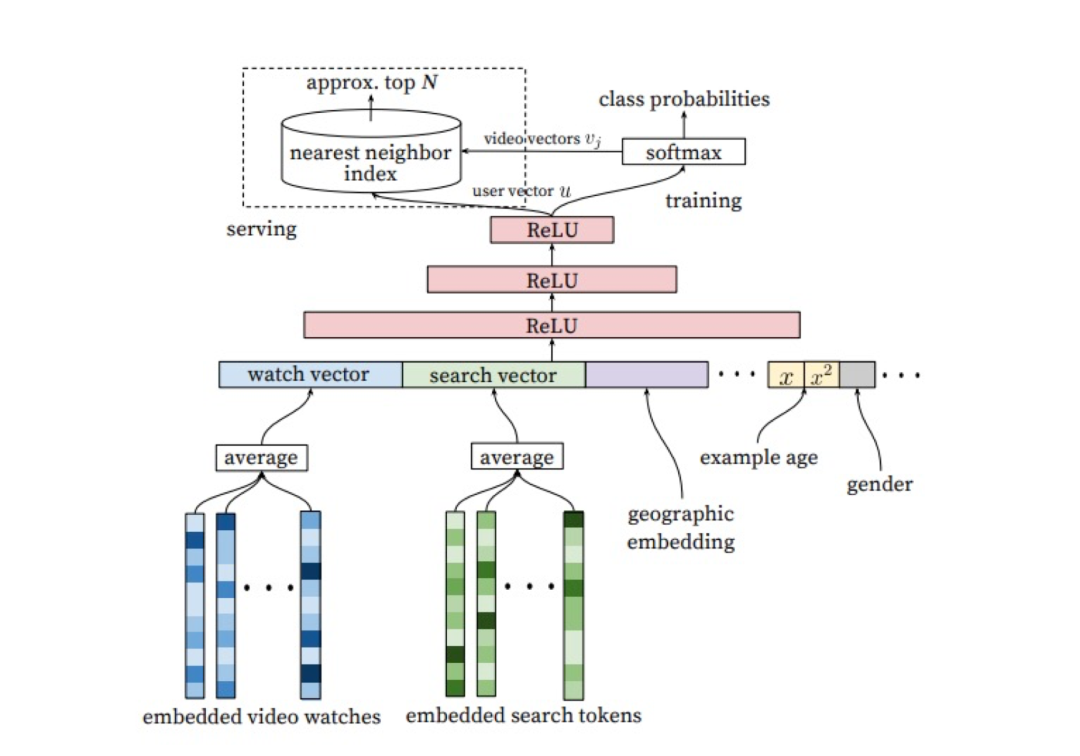

推荐领域覆盖的应用场景较多,工业界的推荐系统架构介绍首推谷歌2016年的论文:Deep Neural Networks for YouTube Recommendations

阅读地址:

https://static.googleusercontent.com/media/research.google.com/zh-CN//pubs/archive/45530.pdf

这是一篇很接地气的文章,以youtube为例,介绍了深度学习在推荐系统中的应用。

此外从应用的角度,有一些综述的论文值得一读:

【经典的协同过滤推荐综述】阅读地址:

https://downloads.hindawi.com/archive/2009/421425.pdf

【深度学习推荐综述】阅读地址:

https://arxiv.org/abs/1707.07435

【图推荐网络综述】阅读地址:

https://arxiv.org/abs/2003.00911

现在召回主要在graph embedding的方向在做一些探索,这里也推荐一些经典的图神经网络相关论文:

【Deep Learning on Graphs综述】阅读地址:

https://arxiv.org/abs/1812.04202

【DeepWalk】阅读地址:

https://dl.acm.org/doi/abs/10.1145/2623330.2623732

【Node2vec】阅读地址:

https://arxiv.org/abs/1607.00653

【GraphSage】阅读地址:

https://papers.nips.cc/paper/2017/file/5dd9db5e033da9c6fb5ba83c7a7ebea9-Paper.pdf

【GAT】阅读地址:

https://arxiv.org/pdf/1710.10903

排序模型方面的文章相对更多一些,这里也推荐几篇相对经典的文章:

【wdl】阅读地址:

https://arxiv.org/pdf/1606.07792.pdf

【deepFM】阅读地址:

http://www.ijcai.org/proceedings/2017/0239.pdf

【DCN】阅读地址:

https://arxiv.org/abs/1708.05123

【DIN】阅读地址:

https://arxiv.org/pdf/1706.06978.pdf

【DIEN】阅读地址:

https://arxiv.org/pdf/1809.03672.pdf

【多目标MMOE】阅读地址:

https://www.kdd.org/kdd2018/accepted-papers/view/modeling-task-relationships-in-multi-task-learning-with-multi-gate-mixture-