- 1stremlit学习前骤_streamlit需要什么编译器

- 2大语言模型微调实践——LoRA 微调细节_lora微调的原理 旁路

- 3基线巡检脚本-启动服务_基线脚本

- 4【Ubuntu】Ubuntu安装微信_微信 ubuntu

- 5PyCharm配置GitHub_pycharm怎么建github

- 6nlp开源库与开源数据集_nlp语义识别 开源

- 7CNN(卷积神经网络)详解

- 8检测图片中的目标尺寸_《图解目标检测》系列之八:目标检测中的Label Assignment...

- 9《Bug系列 2》:完美解决pycharm能在github上创建仓库却无法push的问题_pycharm已经commit但没push的文件怎么push

- 10MTK芯片技术资料大全,各个型号都有,包括原理图数据表等

大模型入门知识点(非常详细)零基础入门到精通,收藏这一篇就够了_大模型基础知识

赞

踩

采用提问方式,从个人知识盲点开始,渐进式掌握大模型入门知识点。

1、大模型中7b、70B代表什么

在讨论人工智能领域特别是大型语言模型(LLMs)时,“7b”和“70B”均用来表示模型所包含的参数数量。这里的“b”是英文“Billion”的缩写,意思是“十亿”。

具体含义如下:

-

7b:代表模型拥有70亿(7,000,000,000)个可训练参数。这些参数包括神经网络中的权重和偏置,它们在模型训练过程中通过反向传播算法进行调整,以使模型能够学习输入数据中的规律并做出准确预测或生成合理的输出。

-

70B:表示模型拥有700亿(70,000,000,000)个可训练参数。相较于7b模型,这是一个规模更大、复杂度更高的模型,理论上具有更强的表达能力和对复杂模式的学习能力。

综上所述,“7b”和“70B”分别指代具有70亿和700亿参数的大型语言模型。模型参数数量通常与其处理复杂任务的能力、泛化性能以及所需的计算资源(如训练时间和显存需求)成正比。研究人员在设计和选择模型时需要权衡模型规模、性能、训练成本以及实际应用需求之间的关系。

2、以Llama3-8B为例,用通俗易懂的方式介绍其8B代表什么意义

以Llama3-8B为例,这里的“8B”指的是该模型具有80亿(8,000,000,000)个可训练参数。为了让这个概念更通俗易懂,我们可以做一个类比来解释:

想象一下,一个大型语言模型就像一个极其复杂的机器,而这个机器是由无数个小零件(参数)精密组装而成的。每个小零件都有其特定的位置和功能,它们相互配合,使得整个机器能够执行特定的任务,比如理解和生成人类语言。

在Llama3-8B这个例子中:

-

“8B”就像是说这个语言处理机器内部包含了80亿个这样的小零件。这些小零件就是模型参数,可以想象成是各种形状和尺寸的螺丝、齿轮、弹簧等,它们共同构成了机器的内部结构。

-

**“参数”**相当于机器内部可调节的部分,决定了各个部件之间如何相互作用和传递信息。在训练过程中,通过不断调整这些参数(比如拧紧某个螺丝、改变齿轮咬合角度等),机器能够逐渐学会识别语言中的模式、理解语义、生成连贯的文本等复杂任务。

-

**“大型”**意味着这个机器不仅零件众多,而且结构复杂,能处理的问题范围广、难度高。相比于小型模型,Llama3-8B这样的大型模型因其庞大的参数数量,通常具备更强的表达能力和泛化能力,能够应对更复杂的语言现象,生成更自然、更丰富的文本,并且可能在某些任务上展现出超越人类的表现。

总结来说,Llama3-8B中的“8B”强调了该模型是一个具有极高复杂度和精细度的语言处理系统,它拥有的80亿个参数如同机器内部的庞大零件库,通过精细调整这些参数,模型得以习得语言的丰富知识和复杂规则,从而在各种自然语言处理任务中展现出卓越的能力。

3、可训练参数是什么

可训练参数是深度学习模型中那些能够在训练过程中被更新和学习的变量。它们构成了模型的核心组成部分,直接影响模型对输入数据的表示学习以及最终的预测或决策能力。以下是关于可训练参数的详细解释:

-

定义与角色: 可训练参数是模型中用于从输入数据中提取特征、建立映射关系或做出预测的关键变量。它们通常是神经网络中的权重(weights)和偏置(biases),但也可能包括其他类型的变量,如批归一化(Batch Normalization, BN)中的缩放因子(scale factors)和偏移量(offsets),以及某些特定层(如LSTM中的门控参数)的额外变量。

-

数学表示: 在数学上,这些参数通常表现为数值型矩阵或向量。例如,神经网络中的权重矩阵表示了不同层神经元之间的连接强度,偏置向量则提供了对每个神经元输出的全局偏移。在前向传播过程中,输入数据与这些参数进行线性或非线性运算,形成模型的中间表示和最终输出。

-

学习过程: 在模型训练时,通过反向传播算法和优化器(如梯度下降、Adam等),根据损失函数对预测结果与真实标签之间的差异(即梯度)来更新这些参数。每次迭代,参数都会朝着减小模型预测误差的方向微小调整。这个迭代过程反复进行,直到模型在训练数据上的性能达到预定标准(如达到特定的损失值或准确率),或者训练轮数达到预设上限。

-

影响模型性能: 可训练参数的质量和数量直接影响模型的性能和泛化能力。合适的参数初始值、良好的参数更新策略以及合理的参数数量可以帮助模型更快地收敛到一个好的解,避免过拟合或欠拟合。参数数量(模型容量)与问题复杂度和可用数据量有关,过多可能导致过拟合,过少可能导致欠拟合。

-

管理与监控: 在实际开发中,对可训练参数的管理包括初始化、更新、保存与加载等。有时还需要定期监测参数的变化情况,如检查梯度是否爆炸、消失,或者观察参数的分布以诊断模型训练状态。此外,正则化技术(如L1、L2正则化)和早停策略也是用来控制参数行为、防止过拟合的手段。

-

编程实现: 在Python深度学习框架如PyTorch和TensorFlow中,可训练参数通常以

torch.nn.Parameter或tf.Variable等形式定义,这样框架会自动跟踪它们的梯度并在反向传播时更新它们。在构建模型时,无论是使用nn.Module、nn.Sequential构造模块化的网络,还是直接定义自定义层,都需要正确地初始化并注册这些可训练参数。

总之,可训练参数是深度学习模型的灵魂,它们是模型学习过程中能够自我调整的关键变量,决定了模型对输入数据的理解程度以及在各种任务上的表现能力。通过训练过程中的反向传播和优化算法,这些参数逐步捕获数据中的规律,从而使模型具备解决问题的智慧。

4、8B代表其在训练的时候将8B的数据装载到GPU显卡中,进行训练的吗

不完全正确。在描述一个深度学习模型时,如“Llama3-8B”,这里的“8B”通常是指模型具有80亿(8,000,000,000)个可训练参数,而非在训练时一次性将8B(8字节,通常表示8位数据)的数据装载到GPU显卡中。

当提到模型训练时的数据加载,通常指的是将训练数据(如图像、文本序列等原始数据或预处理后的数据)分批次(batch)加载到GPU内存中进行训练。这个“batch size”是指每次迭代过程中送入模型进行前向传播和反向传播计算的数据样本数量,通常以样本数来衡量,而不是以字节数(B)表示。

至于将数据加载到GPU的过程,它涉及以下步骤:

-

数据准备:首先,原始数据会被组织成适合模型训练的形式,如转换为张量(tensor),并可能进行预处理,如归一化、编码等。

-

数据加载:使用数据加载器(DataLoader)或类似工具,将预处理后的数据以指定的batch size分批读取。这些数据加载器通常会从硬盘或其他存储设备中高效地读取数据,并将其转换为能够在GPU上运行的张量格式。

-

数据传输:每个批次的数据随后被传输到GPU内存中。这是通过深度学习框架提供的API(如PyTorch的

.to(device)或TensorFlow的.cuda())完成的,这些API将CPU上的张量复制到与之配对的GPU设备上。 -

模型训练:一旦数据在GPU上就绪,模型会在GPU上执行前向传播、计算损失、反向传播和参数更新等操作。这个过程会重复进行,直到完成一个epoch(完整遍历一次训练集)或满足其他停止条件。

综上所述,模型名称中的“8B”通常表示模型参数数量,而非训练时单次加载到GPU的数据量。在训练过程中,数据是以批次为单位加载到GPU的,每个批次的大小通常由batch size决定,以样本数计量,而非字节数。同时,数据加载和训练的具体细节取决于所使用的深度学习框架、硬件配置以及训练策略。

5、型具有80亿(8,000,000,000)个可训练参数是指其在使用阶段,也就是推理阶段其内置了80亿个参数,大模型基于这80亿个参数进行推理输出结果吗

是的,您理解得非常正确。模型具有80亿个可训练参数,不仅在训练阶段起作用,在推理(使用)阶段同样依赖于这80亿个参数来生成预测或输出结果。

具体来说:

-

训练阶段:模型通过反向传播算法和优化器根据训练数据及其对应标签(或目标输出)来更新这80亿个参数。训练过程中,模型通过学习这些参数的最佳取值,使其能够捕捉到数据中的复杂模式和规律。训练完成后,模型的参数值被固定下来,形成所谓的“训练好的模型”。

-

推理阶段(使用阶段):当模型被部署到实际应用场景中进行推理时,它不再进行参数更新,而是利用训练阶段得到的那80亿个固定的参数值来处理新的、未知的输入数据。输入数据经过模型的前向传播过程,其中的每个计算步骤(如加权求和、激活函数应用等)都依赖于这些预先训练好的参数。最终,模型基于这些参数生成输出结果,如分类预测、文本生成、问答响应等。

因此,无论是训练阶段还是推理阶段,这80亿个可训练参数都是模型运作的核心。它们决定了模型的结构、表达能力和对输入数据的响应方式。在推理阶段,虽然模型不再进行学习(参数更新),但其基于训练中学到的知识(参数值)进行有效的推理,为用户提供所需的服务或解决方案。

6、在训练阶段这些参数是通过什么原理生成,生成后是如何存储固定的

在训练阶段,模型的80亿个可训练参数并非由系统原理“生成”,而是通过一个称为学习的过程逐步调整得到。以下是这个过程的简要概述:

-

初始化:首先,模型在开始训练前,所有参数会被随机初始化或按照某种特定规则赋予初始值。这些初始值通常是小的随机数,旨在让模型从一个非确定状态出发,避免所有参数一开始就具有相同或高度相关的值。

-

前向传播:对于每一批训练数据,模型会使用当前的参数值进行计算,生成对应的预测输出。这一过程涉及一系列线性变换、非线性激活函数应用等操作。

-

计算损失:将模型的预测输出与真实标签(ground truth)进行比较,使用一个特定的损失函数(如交叉熵损失、均方误差等)量化预测与真实值之间的差异。

-

反向传播:通过梯度下降或其他优化算法,计算损失函数相对于模型参数的梯度。梯度表示了在当前参数值下,如果要减小损失,各个参数应该朝哪个方向以及以多大幅度进行调整。

-

参数更新:使用优化器(如Adam、SGD等)结合学习率等超参数,根据计算出的梯度更新模型参数。更新公式通常如下:

Code``` 1parameter = parameter - learning_rate * gradient- 1

- 2

- 3

- 4

这个过程在每次迭代(epoch)或 mini-batch 更新中重复进行,直到达到预定的训练轮数、收敛标准或者提前停止条件。- 1

- 2

- 3

-

存储固定:当训练过程结束,模型达到预期性能或满足其他终止条件时,这些经过训练得到的最优(或近似最优)参数值会被固定下来,不再进行进一步更新。为了持久化保存这些参数,通常会使用编程框架提供的函数将模型的状态字典(

state_dict)保存到硬盘上,如在PyTorch中使用torch.save()函数:Python``` 1torch.save(model.state_dict(), 'path_to_save_file.pth')- 1

- 2

- 3

- 4

这样做会将模型的所有参数(包括权重和偏置等)以键值对的形式存储在一个文件中。文件中仅包含模型参数的值,不包括模型的架构定义。这样做的好处在于只需保存参数值,节省存储空间,且能够方便地将参数加载到具有相同架构的模型实例中。- 1

- 2

- 3

- 4

在后续的推理阶段,或者需要继续训练(例如进行微调或迁移学习)时,可以从磁盘加载这些保存的参数,恢复到训练结束时的模型状态:

Python```

1model = ModelClass() # 定义或实例化与保存模型相同架构的新模型

2model.load_state_dict(torch.load('path_to_save_file.pth'))

- 1

- 2

- 3

- 4

- 5

通过上述流程,模型在训练阶段经过学习得到的参数被有效地存储和固定,以便后续使用或进一步处理。

7、大模型在训练的数据准备阶段如何将数据转转为张量,按照每个数据类型进行详细介绍

在训练大模型的过程中,数据预处理阶段通常包括将原始数据转换为深度学习框架(如 PyTorch 或 TensorFlow)所支持的张量格式。针对不同的数据类型,转换过程会有相应的处理方法。以下是对几种常见数据类型的详细介绍:

### 1\. 数值数据(如整数、浮点数)

**整数**:整数型数据可以直接转换为整数张量。例如,在 Python 中,一个整数列表可以通过 PyTorch 的 `torch.tensor()` 函数或 TensorFlow 的 `tf.convert_to_tensor()` 函数转化为张量:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

Python```

1import torch2import tensorflow as tf3

4# 整数列表

5int_list = [1, 2, 3, 4, 5]

6

7# 转换为 PyTorch 整数张量

8torch_int_tensor = torch.tensor(int_list, dtype=torch.int32)

9

10# 转换为 TensorFlow 整数张量

11tf_int_tensor = tf.convert_to_tensor(int_list, dtype=tf.int32)

- 1

- 2

- 3

浮点数:浮点数数据同样直接转换为浮点数张量。例如,一个浮点数列表可以这样转换:

Python```

1# 浮点数列表

2float_list = [1.0, 2.3, 4.5, 5.7]

3

4# 转换为 PyTorch 浮点张量

5torch_float_tensor = torch.tensor(float_list, dtype=torch.float32)

6

7# 转换为 TensorFlow 浮点张量

8tf_float_tensor = tf.convert_to_tensor(float_list, dtype=tf.float32)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

### 2\. 文本数据 文本数据需要经过额外的预处理步骤才能转换为张量: **分词**:将文本分割成单词、子词或字符序列。可以使用内置的分词工具(如 NLTK、spaCy)或特定语言模型要求的分词器。 **编码**:将分词后的文本序列映射为整数或浮点数表示。常见的方法包括: * **词索引编码**:为词汇表中的每个词分配一个唯一的整数ID,文本序列转化为整数序列。 * **词嵌入编码**:使用预训练的词嵌入模型(如 Word2Vec、GloVe、BERT)将词语转换为稠密向量。 * **字符级编码**:对每个字符进行编码,形成整数序列。 **构建张量**:将编码后的整数序列或浮点数向量序列转换为张量。例如,使用 PyTorch 和 TensorFlow:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

Python```

1# 假设 encoded_text 是经过编码的整数序列

2encoded_text = [10, 20, 30, 40, 50]

3

4# PyTorch 文本张量

5torch_text_tensor = torch.tensor(encoded_text, dtype=torch.long)

6

7# TensorFlow 文本张量

8tf_text_tensor = tf.convert_to_tensor(encoded_text, dtype=tf.int32)

- 1

- 2

- 3

对于词嵌入向量,可以创建一个形状为 (num_words, embedding_dim) 的浮点数张量。

3. 图像数据

图像数据通常以像素值形式存在,需要经过以下步骤转换为张量:

读取与解码:使用库(如 PIL、OpenCV)读取图像文件并将其解码为 RGB 或灰度像素值矩阵。

归一化:将像素值从其原始范围(如0-255)归一化到深度学习模型期望的范围,如0-1或-1到1。

转换为张量:将归一化的像素矩阵转换为张量。例如:

Python```

1import torchvision.transforms as transforms2import tensorflow.io as tfio3

4# PIL 图像对象 pil_img

5normalizer = transforms.Normalize(mean=[0.5, 0.5, 0.5], std=[0.5, 0.5, 0.5])

6

7# PyTorch 图像张量

8torch_image_tensor = torch.tensor(np.array(pil_img).astype(np.float32) / 255.0)

9torch_image_tensor = normalizer(torch_image_tensor.permute(2, 0, 1)) # 转为 CHW 顺序

10

11# TensorFlow 图像张量

12tf_image_tensor = tfio.experimental.image.decode_image(tf.read_file(image_path))

13tf_image_tensor = tf_image_tensor / 255.0

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

### 4\. 时间序列数据

时间序列数据(如传感器记录、金融数据等)可能包含多个数值特征随时间变化。转换步骤包括:

**整理数据结构**:确保数据按时间排序,并且可能需要填充缺失值或进行插值。

**堆叠特征**:将多个特征列堆叠为一个二维数组,其中每一行代表一个时间步,每一列对应一个特征。

**转换为张量**:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

Python```

1# 假设 time_series_data 是一个二维 NumPy 数组,形状为 (num_time_steps, num_features)

2time_series_data = np.array([…])

3

4# PyTorch 时间序列张量

5torch_time_series_tensor = torch.tensor(time_series_data, dtype=torch.float32)

6

7# TensorFlow 时间序列张量

8tf_time_series_tensor = tf.convert_to_tensor(time_series_data, dtype=tf.float32)

- 1

- 2

- 3

5. 非结构化数据(如音频、视频)

非结构化数据的转换更为复杂,通常需要专门的库来处理。以下是一些基本步骤:

预处理:根据数据类型执行特定的预处理操作。例如,对于音频数据,可能包括采样率标准化、分帧、提取特征(如梅尔频谱、MFCC);对于视频数据,可能包括解码、帧提取、光流计算等。

转换为张量:将预处理后的数据表示(如特征向量、特征矩阵)转换为张量。例如:

Python```

1# 假设 audio_features 是经过预处理的音频特征序列

2audio_features = np.array([...])

3

4# PyTorch 音频张量

5torch_audio_tensor = torch.tensor(audio_features, dtype=torch.float32)

6

7# TensorFlow 音频张量

8tf_audio_tensor = tf.convert_to_tensor(audio_features, dtype=tf.float32)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

总之,将各种类型的数据转换为张量通常涉及数据清洗、预处理、编码和标准化等步骤,最终使用相应深度学习框架提供的函数将预处理后的数据结构转换为张量。这些张量随后可用于模型的训练和推理。 8、在大模型训练执行和数据准备的时候都是用torch或tensorflow的吗 在大模型训练过程中,数据准备阶段和模型训练执行阶段确实常常使用深度学习框架,如 PyTorch 或 TensorFlow。这些框架提供了一系列工具和API,使得数据预处理、模型定义、训练、评估和部署等工作变得高效且易于管理。下面是关于这两个阶段如何使用这些框架的详细说明: ### 数据准备阶段: **使用 PyTorch 或 TensorFlow**: 1. **数据加载**:框架通常提供数据加载器(如 PyTorch 的 `torch.utils.data.Dataset` 和 `torch.utils.data.DataLoader`,以及 TensorFlow 的 `tf.data.Dataset`)来高效地读取、预处理和批量化数据。用户可以自定义数据集类,封装数据读取逻辑,并通过数据加载器以多线程或多进程方式加载数据,提高I/O效率。 2. **数据转换**:使用框架提供的函数或第三方库(如 `torchvision.transforms`、`tensorflow.image` 等)对数据进行必要的预处理,如图像的归一化、裁剪、resize、数据增强等,或将文本数据转换为词索引、词嵌入等适合模型输入的形式。 3. **数据类型转换**:如前所述,将预处理后的数据转换为框架支持的张量格式,便于模型进行计算。 4. **数据划分**:利用框架提供的工具(如 `sklearn.model_selection.train_test_split` 或框架内建方法)将数据集划分为训练集、验证集和测试集(如果适用),确保模型训练、调参和最终评估的独立性。 ### 模型训练执行阶段: **使用 PyTorch 或 TensorFlow**: 1. **模型定义**:在框架内定义模型架构,通常通过类继承(如 PyTorch 中的 `torch.nn.Module`,TensorFlow 中的 `tf.keras.layers.Layer` 或 `tf.keras.Model`)或函数式API构建。模型包含可训练参数(如权重和偏置),以及前向传播逻辑。 2. **损失函数与优化器**:选择或自定义适合任务的损失函数(如交叉熵、均方误差等),并设置优化器(如 Adam、SGD)以及学习率、动量等超参数。 3. **训练循环**:使用框架提供的训练循环机制(如 PyTorch 中的 `for epoch in range(num_epochs):` 循环和 `model.train()`、`model.eval()` 状态切换,或 TensorFlow 中的 `model.fit()` 方法)进行模型训练。循环中包括: * **前向传播**:将数据加载器提供的批次数据输入模型,得到模型预测。 * **计算损失**:根据真实标签和模型预测计算损失值。 * **反向传播与参数更新**:使用优化器计算梯度,并更新模型参数。 * **指标记录与可视化**:记录训练损失、验证指标(如准确率、AUC等)以及模型内部状态(如权重、梯度分布),并可能使用可视化工具(如 TensorBoard)进行监控。 5. **模型保存与加载**:训练完成后,使用框架提供的方法(如 PyTorch 的 `torch.save()` 和 `torch.load()`,TensorFlow 的 `model.save()` 和 `tf.keras.models.load_model()`)保存和加载模型权重与结构,以便后续使用或部署。 综上所述,在大模型训练过程中,从数据准备到模型训练执行,无论是数据加载、预处理、转换、模型定义、训练循环、参数更新,还是模型保存与加载,通常都会使用 PyTorch 或 TensorFlow 这样的深度学习框架来完成。这些框架提供了丰富的工具和API,极大地简化了大规模模型训练的工作流程,并确保了训练过程的高效性和代码的可维护性。 9、PyTorch 的 torch.save() 会将模型训练后的参数保存到哪里 `torch.save()` 函数允许您将 PyTorch 模型的训练参数(以及其他相关对象,如优化器状态、训练进度等)保存到指定的文件路径。您可以在调用 `torch.save()` 时指定保存的文件路径,模型参数就会被保存到那个位置。具体来说:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

Python```

1torch.save(object_to_save, save_path)

- 1

- 2

- 3

这里:

-

object_to_save是您想要保存的对象,可以是模型的state_dict()(仅保存参数)、整个模型实例,或者其他的 PyTorch 张量、字典、列表等对象。 -

save_path是一个字符串,表示您希望保存文件的完整路径,包括文件名和扩展名。通常,对于模型参数,建议使用.pth或.pt扩展名,以指示这是一个 PyTorch 参数文件。

例如:

Python```

1model = YourModelClass(...) # 定义并训练您的模型

2

3save_path = "./my_model_weights.pth" # 或者指定任何您喜欢的路径,如 "/path/to/save/my_model_weights.pt"

4

5torch.save(model.state_dict(), save_path) # 仅保存模型参数

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

或者,如果您想保存整个模型(包括模型结构和参数):

- 1

- 2

- 3

Python```

1torch.save(model, save_path) # 保存整个模型实例

- 1

- 2

- 3

这样,torch.save() 就会将指定的对象(模型参数或整个模型)保存到您提供的 save_path。如果您指定的是本地文件系统的一个路径(如上述示例所示),那么模型参数就会被保存到您的计算机硬盘上的相应位置。如果您提供了网络路径(如远程服务器的地址),则参数会被保存到相应的网络存储位置。

请注意,确保您有对指定路径的写入权限,并且有足够的磁盘空间来保存模型文件。此外,为了方便管理和版本控制,通常建议将模型文件保存在项目目录下的某个专门的子目录(如 ./models/ 或 ./checkpoints/)中,并为文件命名时包含训练日期、模型版本等信息,以方便后续查找和使用。

10、在数据准备阶段涉及到的数据集标注是什么意思,具体在代码层面是如何操作实现的

数据集标注是在数据准备阶段的一项重要工作,指的是为原始数据(如图像、文本、语音、视频等)添加人工或自动产生的元信息,以便于机器学习或深度学习模型理解、学习和利用这些数据。具体而言,标注可以包括但不限于:

-

对图像中的物体进行边界框、多边形、关键点定位、语义分割等标注;

-

对文本进行实体识别、情感分类、主题标签、关系标注等;

-

对语音数据进行音素标注、情感标注、关键词标定等;

-

对视频进行动作标注、场景分割、目标跟踪等。

在代码层面,数据集标注的具体操作实现通常涉及以下步骤:

1. 标注工具的选择与使用

选择合适的标注工具进行数据标注。这些工具可能包括:

-

专用标注平台:如 LabelMe、Labelbox、Supervisely、Amazon SageMaker Ground Truth、MakeSense、CVAT 等,提供用户友好的图形界面,支持多种标注类型,适用于大规模数据集标注。

-

命令行工具或轻量级脚本:如

labelImg(用于图像边界框标注)或自定义脚本,适用于较小规模或特定需求的标注任务。

使用选定的标注工具,按照项目需求对数据进行人工标注。标注结果通常以特定格式(如 JSON、XML、CSV、YAML 等)的标注文件或数据库记录存储。

2. 标注格式转换与整合

如果标注工具生成的标注文件格式与模型训练框架不兼容,可能需要编写代码将标注数据转换为所需的格式。例如,将 JSON 格式的标注文件转换为 PyTorch 或 TensorFlow 训练所需的 COCO 格式、Pascal VOC 格式、YOLO 格式等。

Python``` 1import json2import cv23from pycocotools.coco import COCO4 5# 加载原始标注数据 6with open('annotations.json', 'r') as f:7 data = json.load(f) 8 9# 创建 COCO 实例并填充数据 10coco = COCO() 11coco.dataset['images'] = data['images'] 12coco.dataset['categories'] = data['categories'] 13coco.dataset['annotations'] = data['annotations'] 14 15# 保存为 COCO 格式 16coco.createIndex() 17coco.save('./converted_annotations.coco')

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

### **3\. 标注数据加载与预处理**

在模型训练代码中,编写数据加载模块或使用现有库(如 `torchvision.datasets`、`tensorflow_datasets`)加载已标注的数据。这部分代码可能包括:

* **读取标注文件**:解析标注文件,提取出与图像(或其他数据)相对应的标注信息。

* **数据加载与预处理**:根据标注信息对原始数据进行必要的预处理,如根据边界框裁剪图像、根据语义分割标签转换为one-hot编码、根据文本标签生成词索引等。

* **构建数据集类**:继承自框架提供的基类(如 `torch.utils.data.Dataset`、`tf.data.Dataset`),重写 `__getitem__` 和 `__len__` 方法,返回经过预处理的样本(包括原始数据和对应的标注信息)。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

Python```

1import torch2from torch.utils.data import Dataset3import json4from PIL import Image5

6class AnnotatedImageDataset(Dataset):

7 def init(self, image_dir, annotation_file, transform=None):

8 self.image_dir = image_dir

9 self.annotation_file = annotation_file

10 self.transform = transform

11 with open(annotation_file, ‘r’) as f:12 self.annotations = json.load(f)

13

14 def len(self):

15 return len(self.annotations)

16

17 def getitem(self, idx):

18 ann = self.annotations[idx]

19 img_path = os.path.join(self.image_dir, ann[‘image_id’])

20 image = Image.open(img_path).convert(‘RGB’)

21

22 if self.transform:23 image = self.transform(image)

24

25 target = {

26 ‘boxes’: torch.tensor(ann[‘boxes’], dtype=torch.float32),

27 ‘labels’: torch.tensor(ann[‘labels’], dtype=torch.int64),

28 # … 其他标注信息

29 }

30

31 return image, target

- 1

- 2

- 3

4. 数据增强与批处理

在数据加载模块中,结合数据增强技术(如随机翻转、缩放、颜色 jittering、随机裁剪等)对标注数据进行进一步处理,以增加模型的泛化能力。同时,使用数据加载器(如 torch.utils.data.DataLoader、tf.data.Dataset.batch())将预处理后的数据分批,供模型训练时使用。

Python```

1from torchvision.transforms import Compose, RandomHorizontalFlip, RandomResizedCrop, ToTensor2

3data_transforms = Compose([

4 RandomHorizontalFlip(),

5 RandomResizedCrop((224, 224)),

6 ToTensor(),

7])

8

9dataset = AnnotatedImageDataset(image_dir='./images', annotation_file='./annotations.json', transform=data_transforms)

10dataloader = torch.utils.data.DataLoader(dataset, batch_size=32, shuffle=True, num_workers=4)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

总结来说,数据集标注在代码层面的操作实现主要包括使用标注工具进行人工标注、进行标注格式转换与整合、编写数据加载模块以加载和预处理标注数据,以及应用数据增强与批处理技术。这些步骤确保标注信息能被有效集成到模型训练流程中,为模型提供有指导意义的监督信号。 11、大模型训练中,什么场景下需要进行数据集标准 大模型训练中,数据集标准化是一个不可或缺的过程,尤其在以下几种场景中显得尤为重要: 1. **数据分布不均或特征尺度差异大**: 当数据集中各特征的数值范围、单位、量纲或统计特性(如均值、方差)存在显著差异时,直接使用这些特征进行训练可能导致模型对某些特征过于敏感,而对其他特征反应不足。标准化通过调整数据分布,如归一化、标准化(如Z-score标准化)或最大最小值缩放等方法,使得所有特征在同一尺度上,有助于模型公平地对待各个特征,提高训练稳定性和收敛速度。 2. **深度学习模型的应用**: 深度神经网络(尤其是基于梯度的优化算法)对输入数据的尺度非常敏感。如果数据未标准化,可能会导致反向传播过程中梯度爆炸或梯度消失问题,严重影响模型的学习过程。标准化可以有效地抑制这些问题,使模型训练更加稳健。 3. **激活函数的性质要求**: 许多常用的激活函数(如sigmoid、tanh、ReLU等)在输入接近0时表现最优。数据标准化有助于将输入数据集中在激活函数响应较灵敏的区域,从而提高模型的非线性表达能力和学习效率。 4. **距离度量或相似性计算**: 在一些基于距离度量的任务中,如聚类、降维(PCA、t-SNE等)、度量学习或使用了距离度量作为损失函数的模型(如对比学习),未经标准化的数据可能导致距离计算受到数值范围的影响而非实际的特征差异。标准化确保了不同特征对总体距离的贡献更为均衡,提高距离度量的合理性。 5. **迁移学习或预训练模型的微调**: 当使用预训练模型进行迁移学习时,预训练数据通常已经过标准化处理。若新任务的数据未经标准化,直接应用预训练模型可能导致模型性能下降。对新数据进行与预训练数据相同的标准化处理,有助于保持模型在预训练阶段学到的特征分布,利于模型快速适应新任务。 6. **模型融合或 Ensemble 学习**: 在多个模型联合训练或预测时,若各自使用的数据集标准化方式不一致,可能导致模型输出结果难以比较和整合。统一的数据标准化确保了各个模型对相同输入的响应一致性,有利于后续的融合策略或 Ensemble 方法的实施。 综上所述,数据集标准化在大模型训练中几乎是一种普遍需求,尤其是在面对特征尺度差异、深度学习模型训练、激活函数约束、距离度量相关任务、迁移学习、以及模型融合等场景时,进行数据标准化是提升模型性能、保证训练稳定性和模型间一致性的重要步骤。 12、数据分布不均或特征尺度差异大是什么意思 数据分布不均或特征尺度差异大是指在数据集中,不同特征(变量)的数值范围、单位、均值、方差等统计特性存在显著差异的现象。这种现象在实际应用中十分常见,特别是在处理多元数据时。下面分别解释这两个方面: ### 数据分布不均(不平衡) **数据分布不均**通常指的是数据集中各类别(或标签)的样本数量严重不均衡。例如,在一个二分类问题中,正类样本数量远远超过负类样本,或者反之。这种情况在医学诊断、欺诈检测、异常检测等领域尤为典型,其中正常样本往往占据主导地位,而异常或感兴趣的样本数量稀少。分布不均可能导致模型在训练过程中偏向于多数类,忽视少数类的特征学习,进而影响模型在少数类上的预测性能。 ### 特征尺度差异大 **特征尺度差异大**是指数据集中不同特征的数值范围、单位或量纲存在显著区别。例如: * 数值范围:一个特征的最大值和最小值之间差距极大,而另一个特征的数值集中在较窄的区间内。 * 单位差异:有的特征以厘米为单位,有的以千米为单位,单位间的差异可能导致模型对具有较大单位的特征过度反应。 * 量纲差异:特征可能是长度、质量、温度、货币等不同物理量或抽象概念,量纲间无法直接比较。 特征尺度差异大的具体表现可能包括: * **数值跨度差异**:某些特征的数值可能在0到1之间,而另一些特征可能在几千到几百万之间。 * **均值和中位数差异**:各特征的均值或中位数相差悬殊,反映出数据重心的位置差异。 * **方差或标准差差异**:某些特征的数值波动较小,方差或标准差较小;而另一些特征的数值波动大,方差或标准差较大,表明数据的离散程度差异显著。 * **偏斜程度差异**:不同特征可能具有不同程度的偏斜(正态分布、左偏、右偏),反映数据分布形态的多样性。 ### 影响与应对措施 数据分布不均或特征尺度差异大会对模型训练产生负面影响,如: * **模型拟合困难**:模型可能因数据分布不均而过度关注多数类,导致在少数类上的表现不佳。特征尺度差异大可能导致模型在反向传播过程中对某些特征梯度过大或过小,影响整体收敛效果。 * **权重更新不均衡**:在优化过程中,特征尺度差异可能导致某些特征对应的权重更新幅度过大或过小,影响模型的整体性能。 * **距离度量失真**:在依赖距离度量的任务中(如聚类、降维、度量学习),特征尺度差异可能使距离计算更多地受制于数值范围较大的特征,而非实际的特征差异。 应对措施包括: * **数据增强或重采样**:对于数据分布不均,可以采用欠采样、过采样、SMOTE( Synthetic Minority Over-sampling Technique)等方法调整类别比例。 * **特征缩放或标准化**:对于特征尺度差异,可以使用归一化(min-max scaling)、标准化(Z-score normalization)、对数变换、Box-Cox变换等方法,使所有特征具有相近的尺度和分布特性,便于模型处理。 通过以上措施,可以减轻数据分布不均或特征尺度差异对模型训练的不利影响,提高模型的泛化能力和预测性能。 13、如何识别样本数据是否存在分布不均或特征尺度差异的问题,包括如何识别样本数据在哪些特征类别存在较大差异 识别样本数据是否存在分布不均或特征尺度差异的问题,通常需要进行数据探索性分析(EDA)。以下是识别这些问题的具体步骤和方法: ### **1\. 分类变量的分布不均检查** 对于分类变量(名义变量或有序变量),主要关注类别数量分布是否均衡。可以采用以下方法: **直方图或饼图**: 绘制分类变量的直方图或饼图,直观地观察各类别的样本数量分布。如果某一类别的样本数量远高于其他类别,表明存在分布不均。 **计算类别频率或占比**: 计算每个类别的样本数量及其占总样本数的比例。如果某个类别的比例远高于其他类别(如超过80%甚至更高),则可以认为数据分布不均衡。 ### **2\. 连续变量的尺度差异检查** 对于连续变量,关注其数值范围、均值、中位数、方差、最大值和最小值等统计指标。可以使用以下方法: **描述性统计**: 计算每个连续变量的统计摘要,包括最小值、最大值、均值、中位数、标准差等。观察这些统计量的差异,判断是否存在尺度上的显著差异。例如,如果某些特征的标准差远大于其他特征,或者最大值与最小值之差非常大,那么这些特征可能存在尺度差异。 **箱线图或小提琴图**: 绘制连续变量的箱线图或小提琴图,展示数据的五数概括(最小值、下四分位数、中位数、上四分位数、最大值)以及分布密度。通过比较不同特征的箱体高度、四分位距(IQR)和须线(异常值)的分布,可以直观地看出特征尺度和分布形状的差异。 **直方图或核密度图**: 绘制连续变量的直方图或核密度图,显示每个特征的数值分布情况。通过比较不同特征的峰值位置、宽度和形状,可以判断它们在数值范围、集中趋势和离散程度上的差异。 ### **3\. 多变量间的关系检查** 除了单独查看每个特征的分布,还需要考虑特征间的相互关系。以下方法有助于识别特征尺度差异对其他特征或目标变量的影响: **相关性矩阵或热力图**: 计算连续变量之间的皮尔逊相关系数(或 Spearman秩相关系数等),并以矩阵或热力图形式呈现。高相关性可能意味着某些特征间存在强关联,且尺度差异可能会影响模型对这些关联的理解。 **散点图矩阵**: 绘制连续变量间的散点图矩阵,直观展示每一对特征间的二维分布及潜在关系。如果某些特征的尺度差异很大,可能会导致散点图中一个方向上的点密集而另一个方向稀疏,掩盖了真实的关联模式。 **主成分分析(PCA)或因子分析**: 进行降维分析,观察特征在主成分或因子上的得分分布。如果某些特征的尺度差异导致它们在主成分上占据主导地位,可能会影响降维结果的有效性。 ### **结论与处理建议** 综合上述分析结果,可以确定样本数据中是否存在分布不均或特征尺度差异的问题,并识别出具体特征。对于分布不均的分类变量,可能需要采取过采样、欠采样或SMOTE等技术平衡类别。对于尺度差异大的连续变量,可以考虑应用归一化、标准化、对数变换等方法进行预处理,使所有特征具有相近的尺度和分布特性,以便于模型训练和解释。同时,关注特征间的相关性,避免因尺度差异导致模型对相关性理解的偏差。 14、模型训练和模型调优具体如何实现,两者在实际执行过程中是什么样的关系 模型训练和模型调优是机器学习和深度学习项目中两个紧密相关的阶段,它们在实际执行过程中相互依赖、迭代进行,共同致力于提升模型的性能和泛化能力。下面详细说明模型训练和模型调优的概念、具体实现步骤以及它们之间的关系。 ### **模型训练** **模型训练**是指使用给定的训练数据集,通过一定的优化算法(如梯度下降、随机梯度下降、Adam等)来调整模型参数的过程,目标是使模型尽可能地拟合训练数据,同时具备较好的泛化能力。具体实现步骤包括: 1. **数据准备**: * 数据清洗:处理缺失值、异常值、重复值等。 * 数据预处理:标准化、归一化、编码分类变量等。 * 划分训练集、验证集(有时还有测试集)。 3. **模型初始化**: * 选择合适的模型架构(如神经网络结构、决策树、SVM等)。 * 设置初始参数值或使用默认值。 5. **前向传播与损失计算**: * 使用训练数据通过模型进行前向传播,得到预测结果。 * 计算预测结果与真实标签之间的损失(如均方误差、交叉熵等)。 7. **反向传播与参数更新**: * 使用优化算法计算损失函数关于模型参数的梯度。 * 根据梯度更新模型参数,朝着减小损失的方向迭代。 9. **训练循环**: * 重复步骤3至4,直至达到预定的训练轮数(epochs)、早期停止条件或收敛标准。 11. **性能评估**: * 在验证集上评估训练好的模型性能(如准确率、AUC、F1分数等)。 ### **模型调优** **模型调优**则是指在模型训练的基础上,通过调整模型结构、学习算法、超参数或采用正则化等手段,进一步改善模型性能和泛化能力的过程。它通常涉及以下几个方面: 1. **超参数调整**: * **网格搜索**:预先定义超参数的取值范围和步长,遍历所有组合,选择最优超参数集。 * **随机搜索**:在超参数空间内随机抽取候选组合,进行有限次数的训练和评估。 * **贝叶斯优化**:基于先前的试验结果,构建概率模型指导后续的超参数搜索,以更高效地找到优秀超参数。 * **使用自动化工具或库**(如`sklearn`的`GridSearchCV`、`RandomizedSearchCV`,或`optuna`等)进行超参数调优。 3. **正则化与正则化参数**: * 添加L1、L2正则项或Dropout层等,防止过拟合,并调整相应的正则化强度参数(如λ、dropout比例等)。 5. **模型复杂度调整**: * 增加或减少神经网络层数、节点数、决策树深度等,控制模型复杂度。 7. **集成学习**: * 使用Bagging、Boosting、Stacking等集成方法,结合多个基础模型提高整体性能。 9. **特征选择与工程**: * 通过相关性分析、特征重要性评估、递归特征消除等方法,筛选、组合或转换特征。 ### **模型训练与调优的关系** * **模型训练是调优的基础**:只有先完成基本的模型训练,才能得到初步的模型性能评估结果,为进一步调优提供参考。 * **调优指导训练**:根据调优过程中发现的问题和改进策略,调整模型结构、超参数或数据预处理方法,然后重新进行模型训练。 * **迭代过程**:模型训练和调优往往不是一次性完成的,而是反复交替进行。先训练一个初始模型,评估其性能;根据评估结果进行调优,调整后再训练;如此反复,直到模型性能满足要求或达到预设的优化上限。 * **协同提升模型性能**:通过有效的模型训练和调优,能够协同提升模型在训练集上的拟合能力和在未知数据上的泛化能力,从而获得更好的预测效果。 综上所述,模型训练和模型调优在实际执行过程中是相辅相成、互相促进的关系。模型训练提供了模型性能的基准,而模型调优则通过一系列策略改进模型结构和参数配置,引导模型训练朝向更高的性能目标进行。这两者共同构成了机器学习项目中不可或缺的优化环节。 15、使用训练数据通过模型进行前向传播,得到预测结果。在代码层面是如何实现的 在代码层面,使用训练数据通过模型进行前向传播并得到预测结果的过程通常涉及到以下步骤。这里以Python编程语言和深度学习框架(如TensorFlow或PyTorch)为例进行说明: ### **假设已有的模型结构如下:**

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

- 91

- 92

- 93

- 94

- 95

- 96

- 97

- 98

- 99

- 100

- 101

- 102

- 103

- 104

- 105

- 106

- 107

- 108

- 109

- 110

- 111

- 112

- 113

- 114

- 115

- 116

- 117

- 118

- 119

- 120

- 121

- 122

- 123

- 124

- 125

- 126

- 127

- 128

- 129

- 130

- 131

- 132

- 133

- 134

- 135

- 136

- 137

- 138

- 139

- 140

- 141

- 142

- 143

- 144

- 145

- 146

- 147

- 148

- 149

- 150

- 151

- 152

- 153

- 154

- 155

- 156

- 157

- 158

- 159

- 160

- 161

- 162

- 163

- 164

- 165

- 166

- 167

- 168

- 169

- 170

- 171

- 172

- 173

- 174

- 175

- 176

- 177

- 178

- 179

- 180

- 181

- 182

- 183

- 184

- 185

- 186

- 187

- 188

- 189

- 190

- 191

- 192

- 193

- 194

- 195

- 196

- 197

- 198

- 199

- 200

- 201

- 202

- 203

- 204

- 205

- 206

- 207

- 208

- 209

- 210

- 211

- 212

- 213

- 214

- 215

- 216

- 217

- 218

- 219

- 220

- 221

- 222

- 223

- 224

- 225

- 226

- 227

- 228

- 229

- 230

- 231

- 232

- 233

- 234

- 235

- 236

- 237

Python```

1import tensorflow as tf # 或者 import torch

2

3# 假设我们有一个简单的全连接神经网络(仅作示例)

4model = tf.keras.Sequential([

5 tf.keras.layers.Dense(64, activation=‘relu’, input_shape=(input_dim,)), # 输入维度为input_dim

6 tf.keras.layers.Dense(32, activation=‘relu’),

7 tf.keras.layers.Dense(output_dim) # 输出维度为output_dim

8])

- 1

- 2

- 3

1. 准备训练数据

Python```

1# 假设训练数据(X_train)是一个形状为 (num_samples, input_dim) 的二维张量(NumPy数组或TensorFlow tensor)

2# 标签数据(y_train)是一个形状为 (num_samples,) 或 (num_samples, output_dim) 的一维或二维张量

3# 示例代码仅展示如何加载数据,实际数据来源可能为文件读取、数据库查询等

4

5X_train = ... # (num_samples, input_dim)

6y_train = ... # (num_samples,) 或 (num_samples, output_dim)

7

8# 如果使用PyTorch,可能需要将数据转换为PyTorch tensors

9# X_train = torch.tensor(X_train, dtype=torch.float32)

10# y_train = torch.tensor(y_train, dtype=torch.float32)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

### **2\. 前向传播**

- 1

- 2

- 3

Python```

1# TensorFlow 示例

2predictions = model(X_train, training=False) # 使用训练数据进行前向传播,training=False表示模型处于推理模式

3

4# PyTorch 示例

5# predictions = model(X_train) # 使用训练数据进行前向传播,无需显式指定training=False

- 1

- 2

- 3

经过以上步骤,predictions变量即包含了模型对训练数据 X_train 的预测结果。其形状与标签数据 y_train相同,可以用于计算损失、评估模型性能等后续操作。

注意

-

上述代码示例假设模型已编译,包括设置损失函数、优化器和评估指标(在TensorFlow中,通常通过

model.compile()方法实现)。 -

在实际应用中,前向传播通常会嵌入到训练循环(如

for epoch in range(num_epochs): ...)或数据加载流程(如使用tf.data.Dataset或PyTorch的DataLoader)中。 -

对于更复杂的模型结构(如卷积神经网络、循环神经网络等),前向传播过程的实现细节会有所不同,但基本逻辑保持一致:将输入数据送入模型,模型自动进行内部计算并返回预测结果。

16、如何将数据和训练任务分派到不同的GPU卡上,做大规模训练,具体代码实现

要将数据和训练任务分派到不同的GPU卡上进行大规模训练,可以利用深度学习框架(如TensorFlow或PyTorch)提供的多GPU支持功能。以下分别给出这两种框架的代码示例:

TensorFlow 2.x

Python``` 1import tensorflow as tf2 3# 设定要使用的GPU设备(如有多个GPU,可替换为相应索引) 4strategy = tf.distribute.MirroredStrategy(devices=["/GPU:0", "/GPU:1", ...]) 5 6# 使用策略创建一个分布式的Keras模型 7with strategy.scope():8 model = tf.keras.Sequential([...]) # 你的模型结构 9 model.compile(optimizer='adam', loss='mse', metrics=['accuracy']) 10 11# 假设你的数据集已经被适配为tf.data.Dataset对象 12train_dataset = ... 13 14# 使用分布式策略进行训练 15model.fit(train_dataset.batch(batch_size), epochs=num_epochs)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

### **PyTorch**

- 1

- 2

- 3

Python```

1import torch2import torch.nn as nn3import torch.optim as optim4from torch.utils.data import DataLoader, Dataset5

6# 设定要使用的GPU设备(如有多个GPU,可替换为相应索引)

7device = torch.device(“cuda:0”) # 或者 device = torch.device(“cuda:0,cuda:1,…”)

8model = YourModel().to(device) # 将模型移动到指定的GPU设备上

9criterion = nn.MSELoss()

10optimizer = optim.Adam(model.parameters(), lr=learning_rate)

11

12# 假设你已经实现了自定义数据集类(Dataset),并创建了DataLoader对象

13train_loader = DataLoader(MyDataset(…), batch_size=batch_size, shuffle=True)

14

15# 在训练循环中,手动将数据移动到指定的GPU设备上

16for epoch in range(num_epochs):

17 for inputs, labels in train_loader:18 inputs, labels = inputs.to(device), labels.to(device) # 将数据移动到GPU

19

20 # 前向传播

21 outputs = model(inputs)

22 loss = criterion(outputs, labels)

23

24 # 反向传播和优化

25 optimizer.zero_grad()

26 loss.backward()

27 optimizer.step()

- 1

- 2

- 3

注意事项:

-

确保你的系统已经正确安装了GPU版本的深度学习框架(如TensorFlow-GPU或PyTorch with CUDA),并正确配置了CUDA环境。

-

在使用多GPU训练时,务必确保数据集足够大,以充分利用多GPU的并行计算能力。否则,由于通信开销,单GPU训练可能更有效率。

-

对于TensorFlow,

tf.distribute.MirroredStrategy会自动将模型参数复制到所有GPU上,并在训练过程中同步更新。对于PyTorch,你需要手动将模型和数据移动到指定的GPU设备上。 -

如果你的任务需要更精细的资源分配或更复杂的并行策略(如数据并行、模型并行、混合并行等),可以考虑使用更高级的库,如Horovod(适用于TensorFlow、PyTorch等多种框架)或DeepSpeed(专为PyTorch设计)。这些库提供了更便捷的API和更强大的功能,但需要额外安装和配置。

17、大模型训练时如何实现数据并行、模型并行、混合并行

在大模型训练时实现数据并行、模型并行和混合并行,通常需要利用深度学习框架(如TensorFlow、PyTorch)提供的多GPU或多节点并行化工具,以及专门针对大规模模型训练优化的库(如Horovod、DeepSpeed、FairScale等)。以下简要介绍如何实现这三种并行策略:

1. 数据并行(Data Parallelism)

数据并行是最常用且实现相对简单的并行策略,它将训练数据集划分为多个子集(批次),每个子集分配给一个GPU或计算节点。所有设备上的模型副本保持相同,各自处理分配的数据子集,计算梯度后通过某种方式(如AllReduce)同步梯度,然后更新模型参数。

TensorFlow 2.x 实现

使用 tf.distribute.MirroredStrategy 自动处理数据并行:

Python``` 1import tensorflow as tf2 3# 创建MirroredStrategy实例,指定可用的GPU设备 4strategy = tf.distribute.MirroredStrategy(["/GPU:0", "/GPU:1", ...]) 5 6# 在策略的上下文中创建模型、编译模型 7with strategy.scope():8 model = tf.keras.Sequential([...]) 9 model.compile(optimizer='adam', loss='mse', metrics=['accuracy']) 10 11# 假设你的数据集已经被适配为tf.data.Dataset对象 12train_dataset = ... 13 14# 使用策略进行训练 15model.fit(train_dataset.batch(batch_size), epochs=num_epochs)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

#### **PyTorch 实现**

使用 `torch.nn.parallel.DistributedDataParallel` 包装模型:

- 1

- 2

- 3

- 4

- 5

Python```

1import torch2import torch.nn as nn3import torch.optim as optim4from torch.utils.data import DataLoader, Dataset5

6# 初始化进程组,指定全局唯一的rank和world_size

7dist.init_process_group(backend=“nccl”, init_method=“env://”, world_size=world_size, rank=rank)

8

9# 创建模型,将其移动到当前GPU设备,并包装为DistributedDataParallel实例

10model = YourModel().to(device)

11model = nn.parallel.DistributedDataParallel(model, device_ids=[device], find_unused_parameters=True)

12

13# 假设你已经实现了自定义数据集类(Dataset),并创建了Dataloader对象

14train_loader = DistributedSampler(MyDataset(…)) # 使用分布式采样器

15train_loader = DataLoader(MyDataset(…), batch_size=batch_size, sampler=train_loader)

16

17# 在训练循环中,DistributedDataParallel会自动将数据和梯度在各个GPU之间进行同步

18for epoch in range(num_epochs):

19 for inputs, labels in train_loader:20 outputs = model(inputs)

21 loss = criterion(outputs, labels)

22

23 # 反向传播和优化

24 optimizer.zero_grad()

25 loss.backward()

26 optimizer.step()

- 1

- 2

- 3

2. 模型并行(Model Parallelism)

模型并行是指将模型的不同部分(如层、模块)分布在不同GPU或节点上。每个设备负责模型的一部分计算,通过通信接口(如NCCL)交换中间结果。

PyTorch 实现

使用 nn.Module 的子类手动划分模型,并使用 torch.cuda.device 和 torch.distributed API进行通信:

Python``` 1import torch2import torch.nn as nn3import torch.optim as optim4from torch.utils.data import DataLoader, Dataset5 6# 初始化进程组,指定全局唯一的rank和world_size 7dist.init_process_group(backend="nccl", init_method="env://", world_size=world_size, rank=rank) 8 9# 定义模型并明确划分到不同GPU 10class Model(nn.Module): 11 def __init__(self): 12 super().__init__() 13 self.part1 = Part1().to(rank * num_layers_per_gpu) 14 self.part2 = Part2().to((rank + 1) * num_layers_per_gpu) 15 16 def forward(self, x): 17 x = self.part1(x) 18 x = self.part2(x) 19 return x20 21model = Model() 22 23# 假设你已经实现了自定义数据集类(Dataset),并创建了Dataloader对象 24train_loader = MyDataset(...) 25train_loader = DataLoader(train_loader, batch_size=batch_size) 26 27# 在训练循环中,需要手动在GPU之间交换中间结果 28for epoch in range(num_epochs): 29 for inputs, labels in train_loader:30 inputs = inputs.to(rank * num_layers_per_gpu) 31 labels = labels.to(rank * num_layers_per_gpu) 32 33 part1_output = model.part1(inputs) 34 part1_output = part1_output.to((rank + 1) * num_layers_per_gpu) 35 36 part2_output = model.part2(part1_output) 37 loss = criterion(part2_output, labels) 38 39 # 反向传播和优化 40 optimizer.zero_grad() 41 loss.backward() 42 optimizer.step()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

### **3\. 混合并行(Mixed Parallelism)**

**混合并行**结合了数据并行和模型并行的优点,既能有效利用多GPU处理大规模数据,又能分散大模型的计算负担。通常,模型的某些部分(如大矩阵乘法、注意力机制)进行模型并行,其余部分进行数据并行。

#### **使用专门库(如DeepSpeed、FairScale)实现**

使用DeepSpeed或FairScale库,它们提供了简化混合并行配置和管理的API:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

Python```

1import deepspeed2

3# 使用DeepSpeed配置文件(deepspeed_config.json)定义混合并行策略

4model, _, _, _ = deepspeed.initialize(args=…, model=model, model_parameters=…)

5

6# 或者使用FairScale的FullyShardedDataParallel(FSDP)进行混合并行

7from fairscale.nn.data_parallel import FullyShardedDataParallel as FSDP8

9model = FSDP(model, …)

10

11# 假设你已经实现了自定义数据集类(Dataset),并创建了Dataloader对象

12train_loader = MyDataset(…)

13train_loader = DataLoader(train_loader, batch_size=batch_size)

14

15# 在训练循环中,模型并行和数据并行由DeepSpeed/FairScale自动处理

16for epoch in range(num_epochs):

17 for inputs, labels in train_loader:18 outputs = model(inputs)

19 loss = criterion(outputs, labels)

20

21 # 反向传播和优化

22 optimizer.zero_grad()

23 loss.backward()

24 optimizer.step()

- 1

- 2

- 3

总之,实现数据并行、模型并行和混合并行需要根据所选深度学习框架和具体任务需求,合理配置并行策略和通信机制。使用专门的并行库可以极大地简化并行训练的实现过程和管理复杂性。记得确保系统已正确安装所需库和依赖,并配置好多GPU或多节点环境。

18、反向传播和优化具体是执行什么处理工作,对训练起到什么具体的作用

反向传播和优化是深度学习模型训练过程中的两个关键环节,它们紧密配合,共同推动模型参数的更新以降低损失函数的值,进而提升模型的预测能力。下面分别阐述这两个环节的具体处理工作及其在训练中的作用:

反向传播(Backpropagation)

处理工作:

反向传播是一种计算梯度(或偏导数)的方法,它利用链式法则,根据前向传播计算得到的模型输出(预测值)和目标值(ground truth),从输出层开始,逐层向输入层反向传播误差信号,计算出每个参数对损失函数的贡献(梯度)。具体步骤包括:

-

计算损失:前向传播完成后,计算模型预测值与目标值之间的损失函数值,如均方误差(MSE)、交叉熵(Cross-Entropy)等。

-

初始化梯度:为模型的所有可训练参数(权重和偏置)初始化对应的梯度变量,通常设置为零。

-

反向传播误差:从输出层开始,根据损失函数相对于该层激活值的梯度(损失梯度),以及该层的激活函数的梯度(激活梯度),计算出损失相对于该层权重和偏置的梯度。接着,将这些梯度沿着网络的反向路径,逐层向上传递,计算出所有隐藏层的权重和偏置的梯度。

-

收集梯度:完成反向传播后,所有参数的梯度已经计算完毕,这些梯度反映了每个参数对当前损失函数值的敏感度,即改变一个参数的微小量将如何影响损失函数的变化。

作用:

反向传播为优化过程提供了指导信息,它计算出的梯度指示了模型参数应如何调整以减小损失函数。具体作用包括:

-

误差分析:通过反向传播,可以量化模型在每个层、每个参数上对预测错误的“责任”,有助于理解模型在何处出现误差以及为何产生误差。

-

参数更新指引:梯度给出了每个参数优化的方向(增大或减小)和幅度(梯度的大小),为后续的参数更新提供了依据。

优化(Optimization)

处理工作:

优化是根据反向传播得到的梯度,更新模型参数的过程。常见的优化算法包括梯度下降法(Gradient Descent)、随机梯度下降(SGD)、动量SGD、RMSProp、Adam等。这些算法根据梯度信息和内部状态(如动量、指数移动平均等)来决定每次更新的步长和方向。具体步骤如下:

-

初始化优化器:根据选定的优化算法(如Adam),创建优化器对象,并传入模型参数作为优化目标。

-

应用梯度:在每次反向传播结束后,使用优化器提供的方法(如

optimizer.step()),根据当前梯度和优化算法的规则更新模型参数。优化器可能还会应用学习率衰减策略、权重衰减(L2正则化)等。 -

清除梯度:更新完参数后,通常需要清零梯度累积变量,准备进行下一轮前向传播和反向传播。

作用:

优化环节实现了模型参数的迭代更新,其主要作用在于:

-

减少损失:按照梯度方向更新参数,旨在使损失函数值在每次迭代后逐渐减小,从而逐步提高模型对训练数据的拟合能力。

-

防止过拟合:通过结合正则化策略(如L1、L2正则化)和学习率调整,优化器有助于控制模型复杂度,防止模型过度适应训练数据而忽视一般规律,从而提高模型的泛化能力。

综上所述,反向传播和优化在深度学习训练中相辅相成。反向传播计算出模型参数对损失函数的梯度,揭示了参数应该如何调整以减小损失;而优化则根据这些梯度信息,实际执行参数更新操作,驱动模型在训练数据上的表现逐步提升,并在一定程度上防止过拟合。这两个环节反复迭代,共同驱动模型训练过程的进行。

19、损失函数是什么,具体执行什么具体的操作,有什么作用

损失函数(Loss Function),在机器学习和深度学习中扮演着核心角色,它是衡量模型预测输出与真实目标值之间偏差程度的量化指标。具体来说:

具体执行的操作:

-

计算差异:损失函数接收模型的预测输出(对于分类任务可能是概率分布,对于回归任务可能是连续数值)和对应的真实目标值(如实际类别标签或真实数值),并计算二者之间的差异。

-

量化误差:将上述差异转化为一个单一的数值(标量),这个数值反映了模型在当前样本上的预测效果好坏。损失函数的设计通常考虑了预测误差的性质(如均方误差对误差平方敏感,适用于注重误差绝对值的场景;交叉熵损失对预测概率与真实概率的对数差敏感,适用于分类任务中概率分布的匹配)。

-

整合批量样本:在训练过程中,损失函数不仅计算单个样本的误差,还可能对一个批次(batch)内的所有样本的损失进行求和或平均,得到批量损失(Batch Loss),用以反映模型在一个小数据集片段上的总体表现。

作用:

损失函数的主要作用体现在以下几个方面:

-

评估模型性能:损失函数值直接反映了模型在特定样本或一批样本上的预测准确性,低损失值意味着模型预测接近真实值,高损失值则表示预测偏差较大。通过观察训练过程中的损失曲线,可以直观了解模型学习进度和收敛情况。

-

指导参数更新:在训练过程中,损失函数是优化算法(如梯度下降法)的目标函数。通过计算损失函数关于模型参数的梯度(即反向传播),可以确定参数更新的方向和步长。模型参数在每次迭代中朝着减小损失的方向调整,从而逐步改善模型的表现。

-

模型选择与比较:不同的任务和数据特性可能适用不同的损失函数。选择合适的损失函数有助于捕捉特定任务的关键误差特性,如分类任务中类别间的不对称性、回归任务中的异常值惩罚等。在模型开发过程中,通过比较不同损失函数下模型的训练和验证表现,可以辅助选择最适合当前任务的模型架构和参数设置。

-

避免过拟合与正则化:某些损失函数包含正则化项(如L1、L2正则化),这些项在计算损失时增加了模型参数的大小惩罚,有助于控制模型复杂度,防止模型在训练数据上过度拟合,提高模型在未见过数据上的泛化能力。

总之,损失函数是深度学习训练过程中的关键组件,它负责量化模型预测与实际目标之间的差距,指导参数更新以降低这种差距,从而推动模型学习和优化。通过精心设计和选择损失函数,可以有效地训练模型以适应各种机器学习任务,并确保模型具有良好的泛化性能。

20、大模型训练在需要多机多GPU卡的场景下,其训练过程是如何协同工作的,代码机制具体是什么样的

在大模型训练中,面对多机多GPU卡的场景,为了高效利用计算资源并确保模型训练的正确性和一致性,通常需要采用分布式训练框架。以下概述了在这样的环境下,训练过程如何协同工作以及相关的代码机制:

分布式训练的核心组件与机制

-

通信后端:如NCCL(NVIDIA Collective Communications Library)或MPI(Message Passing Interface),提供高效的点对点和集体通信操作,用于在多GPU间同步模型参数和梯度。

-

进程组与全局排名(Rank):每个参与训练的GPU或计算节点被赋予一个全局唯一的rank标识,形成一个进程组。进程间通过rank进行通信和协调。

-

参数服务器模式与数据并行模式:

-

参数服务器模式:一部分进程作为参数服务器(PS),负责存储和更新模型参数;其他进程作为工作进程(Worker),计算梯度并发送给PS更新参数。

-

数据并行模式:每个进程拥有模型的完整副本,各自处理不同数据分区(通常是数据集的子集),计算梯度后通过集体通信操作(如AllReduce)同步梯度,然后各自更新模型参数。

- 同步与异步更新:

-

同步更新(Synchronous Training):所有进程在同一训练步(iteration)内计算梯度、同步梯度并更新模型参数,保证了模型的一致性但可能增加等待时间。

-

异步更新(Asynchronous Training):进程独立计算梯度并更新本地模型参数,无需等待其他进程,可能提高训练速度但可能导致模型参数不一致。

代码机制举例

以PyTorch为例,使用其内置的torch.distributed模块进行多机多GPU卡的分布式训练:

Python``` 1import torch2import torch.nn as nn3import torch.distributed as dist4from torch.nn.parallel import DistributedDataParallel as DDP5from torch.utils.data import DataLoader, Dataset6 7# 1. 初始化分布式环境 8dist.init_process_group(backend="nccl", init_method="env://", world_size=world_size, rank=rank) 9 10# 2. 创建模型,并将其封装为DistributedDataParallel实例 11model = YourModel().to(device) 12model = DDP(model, device_ids=[device], find_unused_parameters=True) 13 14# 3. 定义优化器 15optimizer = torch.optim.SGD(model.parameters(), lr=learning_rate) 16 17# 4. 数据加载器:使用DistributedSampler进行数据划分 18train_sampler = torch.utils.data.distributed.DistributedSampler(MyDataset(...)) 19train_loader = DataLoader(MyDataset(...), batch_size=batch_size, sampler=train_sampler) 20 21# 5. 训练循环 22for epoch in range(num_epochs): 23 for inputs, labels in train_loader:24 inputs = inputs.to(device) 25 labels = labels.to(device) 26 27 # 前向传播 28 outputs = model(inputs) 29 loss = criterion(outputs, labels) 30 31 # 反向传播与优化 32 optimizer.zero_grad() 33 loss.backward() 34 optimizer.step()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

在这个例子中:

-

初始化分布式环境:通过

dist.init_process_group设置通信后端、全局rank和world_size(总进程数),这是多GPU卡协同工作的基础。 -

模型封装:使用

DistributedDataParallel将模型封装起来,它会自动处理梯度的同步和参数更新。device_ids指定了当前进程使用的GPU设备。 -

数据划分:使用

DistributedSampler将数据集均匀地分配给各个进程,确保每个进程只处理自己分到的数据子集。 -

训练循环:在循环中,模型前向传播、计算损失、反向传播和优化步骤与单GPU训练类似,但数据并行的实现细节(如梯度同步)由

DistributedDataParallel自动处理。

其他注意事项

-

多机环境:除了以上代码,还需要在启动脚本中设置适当的环境变量(如

MASTER_ADDR、MASTER_PORT),以便进程间能正确建立通信。 -

超参数调整:在分布式训练中,可能需要调整学习率、批量大小等超参数以适应新的计算环境和通信开销。

-

同步屏障:在训练结束或特定检查点处,可能需要使用

dist.barrier()进行全局同步,确保所有进程都到达同一状态。 -

故障恢复:对于长时间运行的大规模训练任务,可能需要实现checkpointing和故障恢复机制,以应对个别节点或GPU故障。

综上所述,大模型训练在多机多GPU卡场景下的协同工作依赖于分布式计算框架提供的通信后端、进程管理和数据划分工具。通过封装模型、使用分布式数据加载器,并遵循特定的训练循环逻辑,可以实现高效、一致的大规模模型训练。

采用提问方式,从个人知识盲点开始,渐进式掌握大模型入门知识点。

21、前向传播是指什么,具体执行任务是什么,有什么作用。在循环训练时和非循环训练时有什么差异

前向传播(Forward Propagation)是深度学习中神经网络模型进行预测或计算损失时的一种核心计算流程。具体来说:

具体执行任务:

-

输入处理:将训练数据(如图像、文本、表格数据等)或测试数据作为输入,传递给神经网络模型的输入层。

-

逐层计算:从输入层开始,网络的每一层依次对前一层的输出进行线性变换(如加权求和,权重由模型参数决定)和非线性变换(通过激活函数,如ReLU、Sigmoid等)。这一过程逐层推进,直至到达输出层。

-

生成预测:在输出层,模型计算出最终的预测结果,对于分类任务可能是类别概率分布,对于回归任务则是连续数值预测。

-

计算损失(仅在训练时):如果是在训练阶段,会将模型的预测结果与实际目标值(如标签、真值)对比,通过损失函数(如交叉熵、均方误差等)计算出预测与目标之间的差异度量,即损失值。

作用:

前向传播的主要作用包括:

-

模型预测:为给定的输入数据生成模型的预测输出,这是模型在推理阶段的核心功能。

-

评估模型性能:在训练过程中,通过计算损失值来评估模型对当前样本的预测准确度,为后续的反向传播和参数更新提供依据。

-

特征提取:在深度网络中,前向传播过程中各隐藏层的输出可以被视为对输入数据的抽象特征表示,这些特征可用于进一步的任务(如特征可视化、迁移学习等)。

循环训练与非循环训练的差异:

- 循环训练(如RNN、LSTM):

-

时间序列处理:前向传播过程中,网络不仅要处理当前时间步的输入,还需考虑前一时间步(或更多历史时间步)的隐藏状态,形成对序列数据的动态建模。

-

状态传递:在每个时间步,网络都会计算出一个新的隐藏状态,并将其作为下一个时间步的输入之一。这种状态的递归传递是循环网络区别于非循环网络的重要特征。

-

序列损失计算:损失函数可能基于整个序列的预测结果与目标值的对比(如CTC loss),或者基于每个时间步的局部损失的累计(如序列标注任务)。

- 非循环训练(如CNN、MLP):

-

独立样本处理:前向传播对每个样本独立进行计算,无需考虑样本间的顺序或时间关系。

-

无状态传递:每个样本的前向传播过程互不影响,网络状态在处理完一个样本后不会保留到下一个样本。

-

样本级损失计算:损失函数通常基于单个样本的预测结果与目标值的差异,所有样本的损失可以简单求和或平均得到整个批次的损失。

总结来说,无论是循环训练还是非循环训练,前向传播的核心都是基于模型结构和参数计算输入数据的预测输出。但在循环训练中,前向传播需要处理时间序列数据并维护隐藏状态,同时损失计算可能涉及整个序列或序列中的每个时间步。而非循环训练则更关注独立样本的处理和单个样本级别的损失计算。

22、在大模型训练过程中涉及到的分组参数切片,是指什么,具体如何实现,有什么作用

在大模型训练过程中,分组参数切片(Parameter Group Sharding or Parameter Partitioning)是一种分布式训练策略,用于应对模型参数量过大、单个设备内存不足以容纳全部模型的情况。这种方法将庞大的模型参数集分割成多个较小的子集(切片),每个子集分配给不同的计算设备(如GPU或TPU)进行存储和运算。以下是分组参数切片的具体含义、实现方式以及其作用:

具体实现:

-

参数划分:首先,将模型的所有参数按一定规则划分为多个不重叠的子集。划分方式可以是均匀分配(如每块设备存储相同数量的参数),也可以基于参数的大小、关联性或其他优化准则进行非均匀分配。

-

设备分配:每个参数子集(切片)被指定到一个特定的计算设备上。这通常由分布式训练框架(如TensorFlow、PyTorch的分布式数据并行库)自动完成,或者通过编程接口显式指定。

-

通信协调:在前向传播和反向传播过程中,当计算依赖于不同设备上的参数时,需要通过高效的通信协议(如NCCL、Gloo等)在设备之间交换必要的梯度或中间结果。例如,在前向传播中,如果一个层的权重在设备A上,而其输入来自设备B,则需要跨设备传输输入数据;在反向传播中,设备间的梯度同步至关重要。

-

编程接口与优化:现代深度学习框架提供了高级API(如

DistributedDataParallel)来简化分组参数切片的实现。这些API通常封装了底层的通信细节,使得用户只需关注模型定义和训练逻辑,而不必直接处理低级的设备间通信。此外,框架还可能采用各种优化技术(如梯度累积、异步更新等)来减少通信开销,提升训练效率。

作用:

-

内存管理:分组参数切片允许在内存有限的单个设备上训练大规模模型,通过分散存储和计算,避免了单个设备内存不足的问题。

-

并行加速:将模型分布在多个设备上,可以实现数据并行训练,即同时处理不同的数据批次,从而显著加快训练速度。每个设备负责其参数切片对应的计算,并通过集体通信同步梯度,共同更新全局模型参数。

-

硬件利用率:充分利用集群中的多台设备,提高硬件资源的整体利用率,特别是在拥有大量GPU/TPU节点的高性能计算环境中。

-

扩展性:随着模型规模的增长或训练需求的变化,可以通过增加设备数量来线性地扩展计算能力,保持训练效率不受模型大小限制。

综上所述,分组参数切片是大模型训练中应对模型参数规模过大的一种有效手段,通过参数的划分、设备分配、通信协调以及高层编程接口的支持,实现了内存管理优化、并行加速、硬件利用率提升及良好的扩展性,确保了大规模模型在有限硬件资源下的高效训练。

23、在前向传播和反向传播过程中,当计算依赖于不同设备上的参数时,需要通过高效的通信协议(如NCCL、Gloo等)在设备之间交换必要的梯度或中间结果。这个过程中是如何进行跨设备数据传输的,另外什么是梯度同步

在前向传播和反向传播过程中,当计算依赖于不同设备上的参数时,跨设备数据传输通常通过高效的通信库(如NCCL、Gloo等)来实现。这些库提供了底层的点对点和集体通信操作,支持在多GPU、多节点环境下高效且准确地交换数据。以下是对跨设备数据传输和梯度同步的具体说明:

跨设备数据传输

步骤概述:

-

数据封装:待传输的数据(如梯度、中间结果、参数切片)通常会被封装为通信库支持的数据类型或容器。这可能涉及将张量(tensor)转换为适合传输的格式。

-

通信操作发起:调用通信库提供的API(如

allreduce、broadcast、scatter、gather等),指定发送方、接收方、待传输数据以及通信模式。例如,在梯度同步中,可能使用allreduce操作将所有设备上的梯度加在一起并平均,确保所有设备得到相同的梯度结果。 -

硬件层面传输:通信库在底层与硬件(如GPU、网络接口卡)交互,执行实际的数据传输。这涉及数据从源设备的内存复制到网络接口卡的缓冲区,通过网络发送到目标设备,再从目标设备的网络接口卡缓冲区复制到目标设备内存。

-

同步与回调:某些通信操作(特别是异步操作)可能返回后立即继续执行下一条指令,而数据传输仍在后台进行。在这种情况下,可能需要使用同步原语(如

wait函数)确保数据传输完成后再继续依赖该数据的计算。另外,通信库也可能提供回调机制,当数据传输完成后触发特定函数执行。

优化技术:

-

流水线并行:在反向传播过程中,可以交错进行计算和通信,即在等待一个梯度传输的同时计算下一个梯度,以此减少通信带来的阻塞。

-

异步通信:允许计算和通信操作重叠执行,设备可以在等待数据传输完成的同时进行其他计算任务,提高整体效率。

-

低级优化:通信库可能利用硬件特性和网络特性(如RDMA、GPU Direct)减少数据复制次数,优化数据路径,降低延迟。

梯度同步

梯度同步是指在分布式训练中,确保所有参与训练的设备(如GPU)在某一轮迭代结束时,都拥有相同的全局梯度值。这是因为每个设备通常只计算其本地数据批次对应的梯度,如果不进行同步,各设备上的参数更新将基于不同的局部梯度,导致模型状态不一致。

实现方式:

-

AllReduce操作:最常用的梯度同步方法是使用

allreduce操作。此操作将所有设备上的同名梯度相加,然后除以设备数量,得到全局平均梯度。每个设备都会收到这个全局梯度,用于后续的参数更新。 -

Parameter Server模式:另一种方法是使用参数服务器架构。部分设备作为参数服务器,负责存储和更新全局参数。其他设备(工作者)计算梯度后发送给参数服务器,参数服务器汇总所有梯度并更新参数,然后将新参数广播回所有工作者。

梯度同步是分布式训练中的关键环节,它确保了所有设备在进行参数更新时使用的是同一个全局梯度,从而维持模型在多设备间的同步状态,保证了训练的正确性和一致性。通过高效通信库提供的通信操作和优化技术,可以有效实现跨设备数据传输和梯度同步,支撑大规模模型在多GPU或多节点环境下的高效训练。

24、上述跨设备数据传输的说明改用代码示例进行说明

由于具体的跨设备数据传输代码取决于所使用的深度学习框架和通信库,这里以PyTorch和其内置的torch.distributed模块为例,展示如何使用all_reduce进行梯度同步。假设我们已经初始化了分布式环境,并且模型已经封装为DistributedDataParallel实例。

Python``` 1import torch2import torch.distributed as dist3 4# 假设 model 是已封装为 DDP 的模型实例,optimizer 是优化器实例 5model = ... 6optimizer = ... 7 8# 在训练循环中 9for inputs, labels in dataloader:10# 前向传播 11 outputs = model(inputs) 12 loss = criterion(outputs, labels) 13 14# 反向传播与梯度计算 15 optimizer.zero_grad() 16 loss.backward() 17 18# 梯度同步(AllReduce) 19for param in model.parameters():20if param.requires_grad and param.grad isnotNone: 21 dist.all_reduce(param.grad, op=torch.distributed.ReduceOp.SUM) # 累加所有设备的梯度 22 param.grad /= dist.get_world_size() # 平均化梯度 23 24# 参数更新 25 optimizer.step()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

在这个示例中:

* **反向传播**:计算损失关于模型参数的梯度。

* **梯度累加**:遍历模型参数列表,对每个需要梯度且梯度不为空的参数,调用`dist.all_reduce`函数,使用`ReduceOp.SUM`操作将所有设备上该参数的梯度累加在一起。

* **梯度平均**:由于`all_reduce`操作将所有梯度加在一起,为了得到全局平均梯度,需要将每个设备上的梯度值除以设备总数(`dist.get_world_size()`)。

* **参数更新**:应用优化器更新参数,此时所有设备上使用的是相同的全局平均梯度。

注意,实际上在使用`DistributedDataParallel`封装的模型时,梯度同步通常由框架自动处理,无需手动编写上述代码。上述示例仅用于说明跨设备梯度同步的基本原理。在实际应用中,直接使用`DistributedDataParallel`进行训练即可:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

Python```

1model = DDP(model)

2for inputs, labels in dataloader:3# 前向传播、损失计算、反向传播(自动触发梯度同步)、参数更新…

4 outputs = model(inputs)

5 loss = criterion(outputs, labels)

6 loss.backward()

7 optimizer.step()

- 1

- 2

- 3

在这段简化后的代码中,DDP模型实例在反向传播时会自动进行梯度同步,无需手动调用all_reduce。

25、什么是梯度?

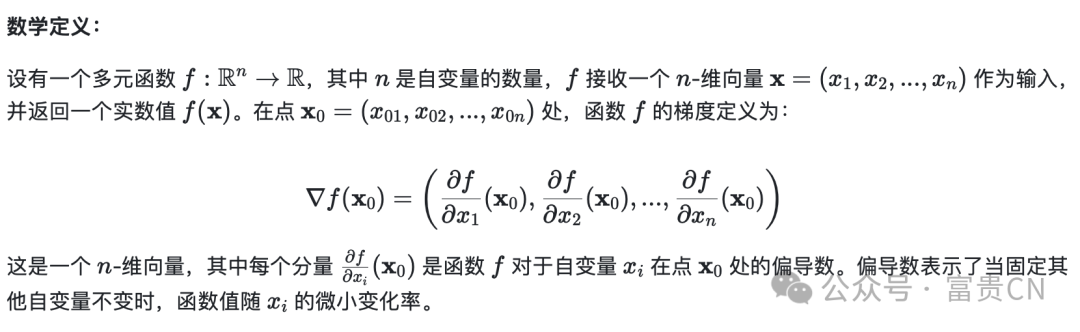

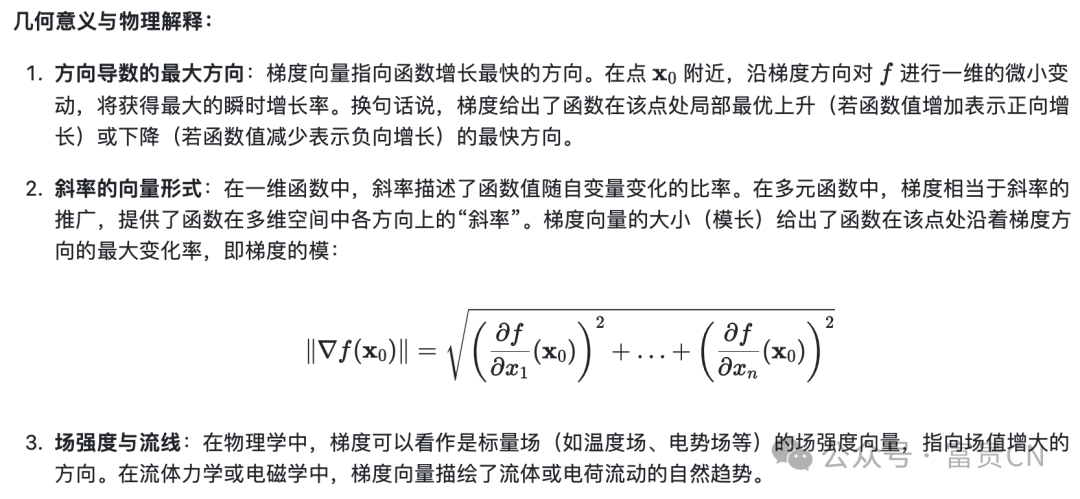

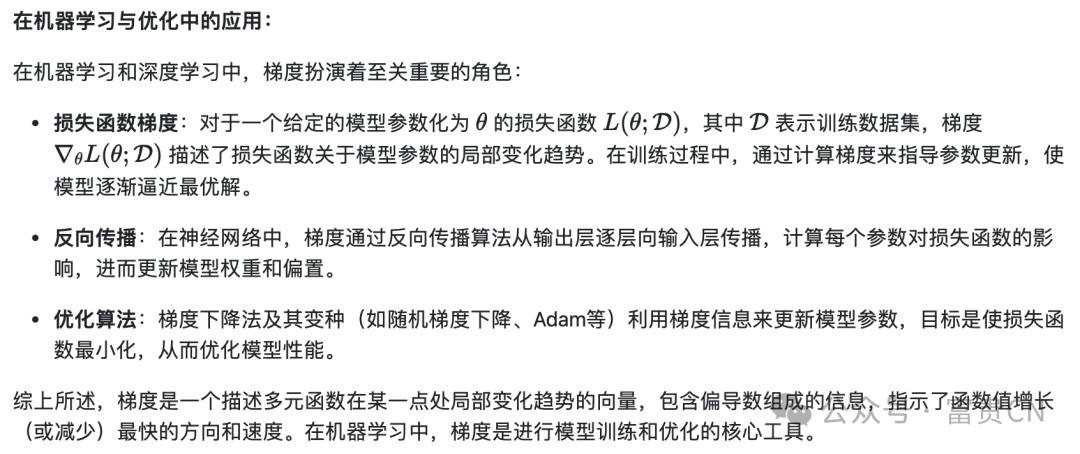

梯度(Gradient)在数学和工程领域中,特别是机器学习和优化理论中,是一个非常重要的概念。它描述了一个多元函数在其定义域内某一点处的局部变化趋势,具体表现为一个向量,包含了函数在该点处各个自变量方向上的偏导数信息。下面是对梯度概念的详细解释:

26、目前业界有哪些主流针对大模型能力的评估方法,分别介绍其具体的评估思路

针对大模型能力的评估方法,业界通常会采用一系列综合性的指标和技术手段来全面考察模型的性能、泛化能力、鲁棒性、效率等多个方面。以下是一些主流的评估方法及其具体评估思路:

- 准确性与误差指标:

-

准确率(Accuracy):对于分类任务,准确率是正确分类样本占总样本数的比例。它是最直观的性能指标,但可能受到类别不平衡问题的影响。

-

精确率(Precision)、召回率(Recall)与F1分数(F1 Score):对于二分类或多分类任务,精确率衡量模型预测为正类的样本中实际为正类的比例,召回率衡量实际为正类的样本中被正确识别的比例。F1分数是精确率和召回率的调和平均数,用于平衡两者。

-

混淆矩阵(Confusion Matrix):提供更详细的分类结果统计,包括各类别的真正例(TP)、假正例(FP)、真反例(TN)和假反例(FN),可据此计算上述各项指标及特定场景下的性能。

- 损失函数评估:

-

交叉熵损失(Cross-Entropy Loss):广泛应用于分类任务,衡量模型预测概率分布与真实标签之间的距离,越低说明模型预测越接近真实标签。

-

均方误差(Mean Squared Error, MSE):主要用于回归任务,计算模型预测值与真实值之差的平方均值,反映模型预测的偏差程度。

- 分割数据集评估:

-

留出验证法(Holdout Validation):将数据集划分为训练集、验证集和测试集(或仅训练集与测试集),训练模型在训练集上,然后在未见过的验证集或测试集上评估模型的泛化能力。

-

交叉验证(Cross-validation):如K折交叉验证,通过多次划分数据集并交换训练/验证集的角色,得到多个模型性能估计的平均值,以减小样本划分带来的偶然性影响。

- 不确定性量化:

-

预测概率分布:对于概率型模型,可以分析其输出的概率分布,如softmax输出的熵,来评估模型对不同类别判断的确定程度。

-

蒙特卡洛 Dropout:在推理阶段保留Dropout层,通过多次前向传播得到模型输出的分布,以此量化模型的不确定性。

- 鲁棒性评估:

-

对抗攻击(Adversarial Attacks):通过构造对模型输入的微小扰动,测试模型在面临针对性攻击时的稳定性。如FGSM、PGD等攻击方法。

-

噪声注入:在输入数据中加入随机噪声,观察模型性能的变化,评估其对噪声的抵抗能力。

- 公平性与偏见评估:

-

组间性能差异:比较不同敏感属性(如性别、种族)分组下模型的性能,检查是否存在显著的不公平现象。

-

公平性指标:如平等机会差异(Equal Opportunity Difference)、均等 Odds 指数(Equalized Odds)、整体公平度(Demographic Parity)等,用于量化模型决策对不同群体的公平程度。

- 效率评估:

-

计算资源消耗:记录模型训练和推理所需的硬件资源(如GPU内存、CPU使用率、运行时间等)。

-

模型大小:统计模型参数数量或模型文件大小,作为衡量模型存储和传输成本的指标。

-

推理速度:测量模型对单个样本或批量样本进行预测所需的时间,用于评估其在实时应用中的可行性。

- 可解释性评估:

-

特征重要性:通过如SHAP、LIME等方法计算模型中各个特征对预测结果的贡献度,评估模型的可解释性。

-

注意力机制可视化:对于使用注意力机制的模型,可视化其注意力分布,了解模型在做出决策时关注输入的哪些部分。

- 人类评估:

- 人工标注对比:邀请专家或用户对模型输出进行主观评价,或者与人工标注结果直接对比,评估模型在实际应用中的表现。

综上所述,针对大模型能力的评估方法涵盖了从基础性能指标、泛化能力、鲁棒性、公平性到效率、可解释性等多个维度,旨在全面、客观地评价模型在各种应用场景下的表现。实际评估时,应根据具体任务需求和模型特点选择合适的评估方法组合。

27、在多机多GPU卡的大模型训练场景下,并行文件存储主要用来解决什么问题,具体是如何解决的

在多机多GPU卡的大模型训练场景下,使用并行文件存储系统主要是为了解决以下几个关键问题:

- 海量数据访问效率:

- 并行读写:并行文件系统支持多个计算节点同时读取或写入同一数据集的不同部分,极大地提升了数据访问速度,尤其对于大型数据集而言,可以显著减少训练开始前的数据加载时间以及训练过程中数据迭代的延迟。

- 数据一致性与同步:

- 强一致性模型:并行文件系统通常提供强一致性保证,确保所有计算节点看到的数据视图是一致的,这对于分布式训练中多节点同时读取同一份训练数据至关重要,避免因数据不一致导致的模型训练错误。

- 大文件支持与扩展性:

- 分块存储与分布式索引:大模型训练往往需要处理TB甚至PB级别的数据,传统文件系统难以有效管理和存储。并行文件系统将大文件划分为多个数据块,分散存储在不同的物理节点上,并使用分布式索引来管理这些数据块,从而实现对超大规模数据集的有效支持。

- 高可用性与容错性:

- 数据冗余与故障恢复:并行文件系统通常采用数据冗余(如RAID、Erasure Coding)和副本策略来保证数据的高可用性。即使部分存储节点出现故障,系统仍能通过备份数据快速恢复服务,确保训练任务的连续性。

- I/O带宽优化:

- 数据缓存与预取:并行文件系统通常具备智能缓存和预取机制,能够预测和提前加载即将被访问的数据,减少磁盘I/O操作,提升数据访问速度,尤其是对于存在局部性访问规律的训练任务。

- 易于管理与扩展:

- 统一命名空间:提供单一的逻辑视图,用户无需关心数据在物理上的分布,简化了数据管理与访问。随着训练规模扩大,只需增加存储节点即可无缝扩展存储容量和I/O性能。

具体解决方式如下:

-

数据分区与负载均衡:训练数据集被划分为多个分片,按照某种策略(如哈希、范围等)均匀分布到各个存储节点上。训练过程中,不同计算节点(GPU卡)可以从各自负责的分片中并行读取数据,实现数据访问的并行化。

-

元数据服务与分布式锁:并行文件系统通常有专门的元数据服务器管理文件系统的目录结构、权限控制等信息,并通过分布式锁机制确保在多节点并发访问时的数据一致性。当多个节点请求同一数据块时,通过锁机制协调读写操作,防止冲突。

-

网络优化与数据 locality:利用高速网络(如InfiniBand、RoCE)连接存储节点和计算节点,减少数据传输延迟。同时,尽量将数据分片存储在靠近计算节点的位置(数据局部性),减少跨网络的数据传输,提高I/O性能。

-

故障检测与自我修复:系统持续监控存储节点的状态,一旦检测到节点故障,自动触发数据恢复流程,从冗余副本中重建丢失的数据,确保数据完整性和服务连续性。

综上所述,通过上述设计和功能,并行文件存储系统在多机多GPU卡的大模型训练场景下,解决了大规模数据高效访问、一致性维护、高可用性、易管理与扩展等问题,为大规模分布式深度学习训练提供了强大的数据存储后盾。

28、在多机多GPU卡的大模型训练场景下遇到的上述问题,用块存储、对象存储或文件存储是否也能解决,和传统存储服务相比并行文件存储有哪些优势

在多机多GPU卡的大模型训练场景下,块存储、对象存储和文件存储确实可以解决部分问题,但它们在应对大规模并行训练的需求时,相比并行文件存储存在一些局限性。以下是各存储类型在解决相关问题上的表现,以及并行文件存储相对于传统存储服务的优势:

块存储:

-

数据访问:块存储提供原始的块级访问接口,适用于直接挂载到操作系统作为本地磁盘使用。在多GPU卡训练中,每个节点可以独立访问其挂载的块存储卷,但通常不支持多节点间高效并行读写同一数据集。这意味着节点间需要通过其他机制(如数据分发服务)来实现数据的协同访问。

-

一致性:块存储通常不直接负责跨节点的数据一致性管理,需要上层应用程序(如分布式文件系统)或用户自行设计协调机制来确保数据一致性。对于大规模分布式训练,这可能带来额外的复杂性和性能开销。

-

扩展性:块存储可通过LVM、RAID等技术进行本地扩展,但在跨节点的水平扩展方面能力有限。对于大规模分布式训练,需要额外的分布式文件系统或数据管理软件来配合。

对象存储:

-

数据访问:对象存储提供键值对形式的接口,适合存储大量非结构化数据,并支持大规模并行读写。然而,对象存储接口与深度学习框架通常期望的文件系统接口不完全匹配,可能需要额外的适配层来模拟文件系统行为。这可能导致额外的开发工作和潜在的性能损耗。

-

一致性:对象存储通常提供最终一致性保证,即写操作完成后,所有后续读操作最终会看到最新的写入数据。这对于某些应用场景可能足够,但对于要求强一致性的分布式训练(如需要立即反映全局梯度更新的状态)可能不够理想。

-

扩展性:对象存储天然具有出色的水平扩展能力,可以轻松应对PB乃至EB级别的数据存储需求。然而,其接口特性可能导致在大规模训练场景下的数据访问效率低于专门设计的并行文件系统。

文件存储:

-

数据访问:文件存储提供标准的文件系统接口,支持目录结构和文件属性。多节点可以访问同一文件系统,但并发访问性能受限于文件系统的并发处理能力和网络带宽,对于大规模并行读写可能存在瓶颈。此外,传统文件系统可能不适应深度学习工作负载的特定访问模式(如顺序扫描和随机访问混合)。

-

一致性:文件存储一般提供一定的数据一致性保证,但对极高并发访问的处理能力以及在大规模分布式环境下的数据一致性管理可能不如专门设计的并行文件系统。

-

扩展性:虽然传统的文件系统如NFS、CIFS可以进行一定程度的扩展,但对于超大规模数据集和高并发访问,它们在性能、容量扩展和数据分布上的灵活性可能不足。

并行文件存储的优势:

-

高度并行化:并行文件系统专为大规模并行计算设计,能够支持数千乃至数万个客户端的并发访问,提供极高的I/O带宽和低延迟,非常适合大规模分布式训练场景。

-

高效数据分布:并行文件系统通过智能的数据布局策略(如基于文件大小、访问频率的动态分布)和数据缓存机制,最大限度地利用网络和存储资源,减少数据迁移,提高训练效率。

-

强一致性保障:针对分布式训练中的同步需求,许多并行文件系统提供强一致性保证,确保所有计算节点看到的数据视图是一致的,避免因数据不一致导致的训练错误。

-

无缝扩展性:并行文件系统能够透明地扩展存储容量和处理能力,无需更改应用程序代码或重新配置系统,适应训练规模的增长。

-

深度学习优化:一些并行文件系统针对深度学习工作负载进行了特定优化,如支持稀疏文件、提供高效的checkpoint和模型版本管理功能,进一步提升训练效率。

综上所述,虽然块存储、对象存储和文件存储能够在一定程度上解决多机多GPU卡大模型训练中遇到的问题,但并行文件存储因其高度并行化、高效数据分布、强一致性保障、无缝扩展性和深度学习优化等特性,更适合应对大规模分布式训练的挑战。

29、除大模型训练场景外,并行文件存储还存在哪些应用场景

并行文件存储因其高效的数据访问、大规模扩展能力、以及对高并发访问的良好支持,不仅在大模型训练场景中发挥关键作用,还适用于多种对数据密集型计算、高吞吐量、低延迟及大规模数据共享有严格要求的应用场景。以下列举了一些并行文件存储的典型应用领域:

- 高性能计算(HPC):

- 科学模拟:如气候建模、流体动力学、材料科学、分子动力学等领域,需要处理大规模的数值模拟数据,涉及大量的并行计算和频繁的I/O操作。并行文件系统能支持数百上千个计算节点同时读写数据,确保大规模模拟任务的高效执行。

- 生命科学与生物信息学:

- 基因组学:基因组测序产生的海量数据(如FASTQ、BAM文件)需要高效存储和处理。并行文件系统能够支撑大规模序列比对、变异检测、基因表达分析等工作,加速生物医学研究进程。

- 金融与商业智能:

- 数据分析与挖掘:在金融交易、风险管理、市场预测等领域,需要处理大规模的交易历史、市场数据、用户行为数据等。并行文件系统有助于快速加载、处理和查询这些数据,支持实时或近实时的决策支持系统。

- 地理信息系统(GIS)与遥感:

- 地球观测数据处理:卫星遥感图像、无人机航拍数据、地理空间矢量数据等,数据量庞大且需要进行复杂的地理空间分析。并行文件系统能支持快速访问、处理和存储这些数据,服务于灾害监测、城市规划、环境监测等应用。

- 影视制作与视觉特效(VFX):

- 高清视频编辑与渲染:高清电影、电视剧、动画制作过程中产生大量高清素材,以及渲染过程中的中间帧和最终输出文件。并行文件系统支持高带宽、低延迟的数据访问,加快视频剪辑、特效合成和渲染流水线。

- 云计算与大数据:

- 云原生应用:在云环境中,尤其是容器化和微服务架构下,应用可能需要快速启动大量实例并共享数据。并行文件系统提供高并发访问能力,支持弹性伸缩和按需分配存储资源。

- 物联网(IoT)与边缘计算:

- 实时数据处理:在大规模物联网部署中,传感器设备产生的海量数据需要实时汇聚、处理和存储。并行文件系统能够高效接收、存储和分析边缘节点的数据流,支持实时决策和报警系统。

- 人工智能(AI)与机器学习(ML):

- 除了大模型训练外,还包括大规模数据预处理(如特征提取、数据清洗)、模型验证、在线推理等环节。并行文件系统提供快速的数据加载和结果保存能力,支持整个AI/ML工作流程的高效运转。

总之,任何涉及大规模数据处理、高性能计算、高并发访问、以及需要高效数据共享的场景,都可能是并行文件存储的重要应用领域。这些场景覆盖科研、医疗、金融、媒体娱乐、地理信息、云计算、物联网等多个行业,凸显了并行文件存储技术在现代数据密集型应用中的广泛适用性和重要价值。

30、目前国内企业在自研的通用大模型和行业大模型,其底层是基于哪些主流的开源大模型进行封装的

虽然具体的企业自研通用大模型和行业大模型底层所基于的开源大模型可能因企业而异,但根据行业趋势和公开信息,可以推测国内企业在研发这类模型时可能会选择以下几种主流的开源大模型作为基础或参考进行封装与定制:

- Transformer架构:

- GPT-3:由OpenAI发布的具有里程碑意义的预训练语言模型,以其强大的语言理解和生成能力闻名。国内企业可能会借鉴GPT-3的架构设计、训练方法和超大规模数据集的使用策略,开发类似的基于Transformer的通用或行业大模型。

- BERT及其变种:

- BERT(Bidirectional Encoder Representations from Transformers)由Google提出,是预训练-微调范式的代表作,广泛应用于各类自然语言处理任务。许多企业可能会基于BERT或其衍生模型(如RoBERTa、DistilBERT、ALBERT等)进行定制化训练,以适应特定行业的文本理解需求。

- Turing-NLG与Megatron-LM:

- Turing-NLG是Microsoft研发的超大规模语言模型,而Megatron-LM则是NVIDIA推出的多GPU并行训练框架及对应的预训练模型。这些模型展现了在大规模训练和分布式计算上的技术实力,可能被国内企业借鉴以构建高性能的自研大模型。

- 阿里云通义千问:

- 阿里云的通义千问系列模型属于国内自主研发的大规模预训练模型,具有较高的知名度和影响力。其他企业可能会参考通义千问的设计思路和技术路线,结合自身资源和业务需求开发类似模型。

- 百度文心系列:

- 百度的文心(ERNIE)模型家族是中国自主研发的预训练语言模型系列,涵盖多个版本和特定领域的模型。其他企业可能会基于文心模型的架构、训练策略或所使用的中文数据集来构建自己的通用或行业大模型。

- 华为盘古系列:

- 华为提出的盘古大模型系列,包括通用语言模型、多模态模型等,展现了在跨模态和多语言理解方面的技术实力。国内企业可能会借鉴盘古模型的技术特点,特别是在跨领域知识融合和多任务学习方面的设计。

- 开源社区项目:

- 开源社区中还有诸如Hugging Face Transformers库中的众多预训练模型,如GPT-Neo、GPT-J、GPT-NeoX等,这些模型提供了不同的性能-资源平衡点,可能被企业选作基础模型进行二次开发。

企业在基于这些开源大模型进行封装时,通常会进行以下操作:

-

微调:使用特定行业的标注数据对基础模型进行微调,使其更好地理解行业术语、规范和语境。

-

迁移学习:将开源模型的知识迁移到新的任务或领域,通过少量额外训练使模型适应新场景。

-

模型压缩与蒸馏:针对资源有限的部署环境,可能对开源大模型进行压缩,如知识蒸馏,生成更小、更高效的版本。

-

融合与集成:将多个开源模型的优势结合,通过模型融合或 Ensemble 技术提高整体性能。

-

定制化设计:根据业务需求,可能对模型架构进行调整,添加特定层或模块以增强特定功能。

需要注意的是,实际的自研过程可能涉及保密信息,公开资料中并不一定会详尽披露底层所基于的开源模型细节。上述推测基于已知的主流开源模型和常见的技术路线,具体某家企业的做法还需参照其官方公告或技术文献。

31、模型压缩与蒸馏操作中,知识蒸馏是指什么,具体是如何实现的,可以结合代码示例介绍

知识蒸馏(Knowledge Distillation, KD)是模型压缩技术的一种,其核心思想是将一个复杂且性能优良的大型模型(称为教师模型,Teacher Model)的知识转移给一个结构更为精简、参数量更少的小型模型(称为学生模型,Student Model),从而使学生模型在保持较低计算成本的同时,尽可能地逼近教师模型的性能。知识蒸馏的具体实现主要包括以下几个步骤:

-

教师模型训练:

-

首先,需要有一个已经经过充分训练且表现优秀的教师模型。教师模型通常是一个深度较大、参数量较多的复杂模型,如深度神经网络、BERT、GPT等。教师模型的训练通常使用大量的标注数据,并通过标准的损失函数(如交叉熵损失)达到较高的测试集性能。

-

学生模型设计:

-

学生模型通常是一个结构更为简单、参数量更少的模型,例如,具有更少层数或更小隐藏单元的神经网络,或者经过简化设计的Transformer模型。学生模型的目的是在保持较低计算复杂性和存储需求的前提下,尽可能模拟教师模型的行为。

-

蒸馏目标设定:

-

在知识蒸馏过程中,学生模型不仅学习原始数据集的硬标签(如分类任务中的真实类别),还学习教师模型的“软”输出,即预测的概率分布。这是因为教师模型的输出包含了丰富的决策边界信息和类间关系,这些知识对于提升学生模型的泛化能力至关重要。

-

蒸馏训练:

-

在训练学生模型时,除了使用常规的交叉熵损失(针对硬标签)外,还会引入一个蒸馏损失(Distillation Loss),它通常是教师模型输出概率分布与学生模型输出概率分布之间的某种距离度量。最常见的是KL散度(Kullback-Leibler Divergence),它衡量两个概率分布之间的差异。蒸馏损失鼓励学生模型模仿教师模型在每个样本上的输出概率分布。

-

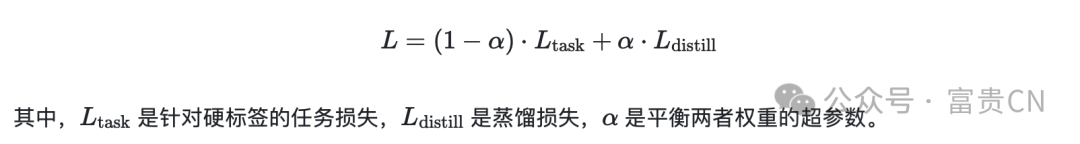

整体的损失函数通常是一个加权组合,包括常规任务损失(如分类任务的交叉熵损失)和蒸馏损失:

-

-

代码示例(以Python和PyTorch为例):

Python``` 1import torch2from torch.nn import KLDivLoss3from torch.optim import Adam4 5class StudentModel(nn.Module): 6 # 定义学生模型结构... 7 8student = StudentModel() 9teacher = TeacherModel() # 假设已有预训练好的教师模型 10 11# 蒸馏损失函数(使用KL散度) 12distillation_loss_fn = KLDivLoss(reduction='batchmean') 13 14optimizer = Adam(student.parameters()) 15 16for epoch in range(num_epochs): 17 for inputs, targets in dataloader:18 # 前向传播 19 with torch.no_grad():20 teacher_outputs = teacher(inputs) 21 student_outputs = student(inputs) 22 23 # 计算蒸馏损失 24 soft_targets = torch.softmax(teacher_outputs / temperature, dim=-1) 25 student_logits = student_outputs / temperature 26 distillation_loss = distillation_loss_fn(student_logits, soft_targets) 27 28 # 基于硬标签的常规任务损失(假设是分类任务) 29 task_loss = F.cross_entropy(student_outputs, targets) 30 31 # 组合损失 32 total_loss = (1 - alpha) * task_loss + alpha * distillation_loss33 34 # 反向传播和优化 35 optimizer.zero_grad() 36 total_loss.backward() 37 optimizer.step()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

上述代码展示了如何在训练循环中同时计算任务损失和蒸馏损失,并使用Adam优化器更新学生模型的参数。`temperature` 参数用于平滑教师模型的输出分布,通常设置为大于1的值,以增加软标签的多样性,帮助学生模型学习更精细的决策边界。- 1

- 2

- 3

-

模型评估与部署:

- 训练完成后,评估学生模型在验证集或测试集上的性能。如果性能满足要求,即可部署压缩后的学生模型,以较低的计算成本实现接近教师模型的预测效果。

总结来说,知识蒸馏通过让学生模型模仿教师模型的输出概率分布,实现了从复杂教师模型到精简学生模型的知识转移,从而实现模型压缩。代码示例展示了如何在实际训练过程中计算和优化蒸馏损失,以实现这一知识迁移过程。

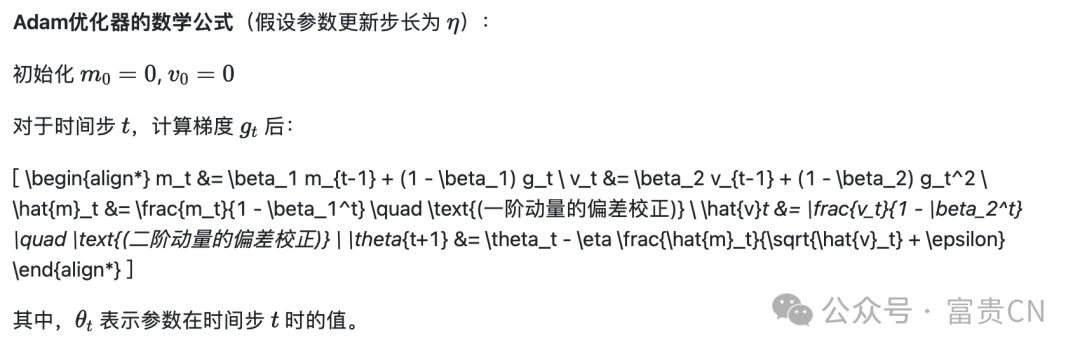

32、Adam优化器介绍,介绍常用场景的代码示例

Adam(Adaptive Moment Estimation)优化器是一种非常流行的深度学习优化算法,由Diederik P. Kingma和Jimmy Ba在2014年提出。Adam结合了RMSProp(Root Mean Square Propagation)算法对二阶矩估计的使用和动量法对一阶矩估计的运用,具备自适应学习率调整、高效收敛以及对稀疏梯度的良好处理能力,特别适用于大规模训练数据和高维参数空间的模型。

Adam算法的主要特点:

-

自适应学习率:对每个参数分别维护一个一阶动量 mtmt 和二阶动量 vtvt,前者相当于梯度的一阶矩(动量),后者则是梯度的未中心化二阶矩(平方梯度的指数移动平均)。这两个动量用于自适应地调整每个参数的学习率。

-

动量项:类似传统的动量优化器,Adam通过一阶动量 mtmt 进行累积历史梯度,以加速在梯度方向一致的区域的收敛速度。

-

二阶矩估计:类似RMSProp,Adam利用二阶动量 vtvt 对不同参数的梯度方差进行适应性调整,有助于抑制在梯度波动大的维度上的学习率,从而稳定训练过程。

-

偏差校正:由于初始化时一阶动量和二阶动量的估计可能偏差较大,Adam引入了偏差校正项,使得前期的估计更加准确。

-

参数超参数:Adam包含几个可调节的超参数,如学习率(

lr)、一阶动量的衰减率(beta1)、二阶动量的衰减率(beta2)以及为了数值稳定性添加的常数项(eps)。

代码示例(以PyTorch为例):

Python``` 1import torch2from torch import optim3 4# 假设模型已定义,如 `model = MyNeuralNetwork()` 5# 假设数据加载器已准备,如 `dataloader = get_data_loader()` 6 7# 初始化模型参数 8optimizer = optim.Adam(model.parameters(), lr=0.001, betas=(0.9, 0.999), eps=1e-08) 9 10for epoch in range(num_epochs): 11 for inputs, targets in dataloader:12 # 清零梯度 13 optimizer.zero_grad() 14 15 # 前向传播计算损失 16 outputs = model(inputs) 17 loss = criterion(outputs, targets) 18 19 # 反向传播计算梯度 20 loss.backward() 21 22 # 使用Adam优化器更新模型参数 23 optimizer.step()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

在这个示例中: * `model.parameters()` 返回模型的所有可学习参数。 * `optim.Adam` 创建了一个Adam优化器实例,设置了学习率为 `lr=0.001`,一阶动量和二阶动量的衰减率分别为 `(0.9, 0.999)`,以及数值稳定性参数 `eps=1e-08`。 * 在训练循环中,每完成一次前向传播计算损失后,使用 `optimizer.zero_grad()` 清零梯度。 * `loss.backward()` 执行反向传播计算梯度。 * 最后,`optimizer.step()` 调用Adam算法根据当前梯度更新模型参数。 **常用场景**: Adam优化器因其良好的综合性能,被广泛应用于各种深度学习任务,包括但不限于: * 图像分类(如ResNet、DenseNet等在ImageNet上的训练) * 自然语言处理(如Transformer、BERT、GPT等模型的训练) * 生成对抗网络(GANs)的训练 * 语音识别、强化学习等领域的模型训练 总的来说,Adam优化器因其自适应学习率调整机制和对梯度噪声的稳健性,成为深度学习训练中的首选优化器之一,尤其在面对复杂模型和大规模数据时表现出色。上述代码示例展示了如何在PyTorch中设置并使用Adam优化器进行模型训练。 33、企业在基于开源大模型进行封装时,将多个开源模型的优势结合,通过模型融合或 Ensemble 技术提高整体性能。模型融合和 Ensemble 技术分别指什么,具体是如何实现封装的,可以结合代码示例进行介绍 模型融合(Model Fusion)和 Ensemble 技术都是将多个独立构建的模型结合起来,以期获得比单个模型更好的预测性能或泛化能力。虽然这两个术语有时可以互换使用,但它们通常指的是两种不同的策略: ### 模型融合(Model Fusion) 模型融合通常是指将多个模型的输出直接合并成一个新的输出,或者将多个模型的内部表示(如中间层特征)整合,形成一个更复杂的模型结构。这种技术强调的是模型之间的深度集成,而非简单地并行或序列地使用模型。 **实现方式**: * **特征级融合**:将不同模型提取的特征合并,共同作为新模型的输入。例如,在计算机视觉领域,可以将多个预训练模型(如ResNet、VGG、Inception等)的最后一层特征图堆叠起来,作为新模型的输入特征。 * **决策级融合**:将多个模型的最终决策(如分类概率或回归值)通过特定规则或学习算法合并成单一决策。例如,可以采用加权平均、最大投票、最小均方误差组合等方式来融合模型输出。 ### Ensemble 方法 Ensemble 方法是一种统计学概念,它指的是通过构建并结合多个模型(称为“个体学习器”)的预测来提高整体预测精度的技术。Ensemble 方法的核心思想是利用模型间的差异性来减少整体预测误差,常见的策略包括: * **Bagging**(Bootstrap Aggregating):通过自举采样(Bootstrap Sampling)的方式创建多个训练集,分别训练相同类型的模型,然后取所有模型预测结果的平均(对于回归)或多数表决(对于分类)。 * **Boosting**:逐步训练一系列弱学习器,每个新学习器都着重关注前一轮中被错误分类的数据,最终将所有弱学习器以加权的方式组合起来。 * **Stacking**(堆叠):先用一组基学习器对原始数据进行预测,然后将这些预测结果作为新的特征输入到一个元学习器(如逻辑回归、随机森林等)中,元学习器负责整合底层模型的输出,生成最终预测。 **代码示例**: 下面以 Scikit-Learn 库中的一个简单 Ensemble 示例来说明模型融合与 Ensemble 方法的实现: #### 模型融合(加权平均) 假设我们有两个预训练模型 `model1` 和 `model2`,要融合它们的分类概率输出:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

Python```

1from sklearn.metrics import accuracy_score2import numpy as np3

4# 假设我们已经得到了两个模型的预测概率

5predictions1 = model1.predict_proba(test_data)

6predictions2 = model2.predict_proba(test_data)

7

8# 定义模型权重

9weights = [0.6, 0.4]

10

11# 加权平均融合

12ensemble_predictions = np.average([predictions1, predictions2], axis=0, weights=weights)

13

14# 将融合后的概率转化为类别标签

15ensemble_labels = np.argmax(ensemble_predictions, axis=1)

16

17# 计算准确性

18accuracy_ensemble = accuracy_score(true_labels, ensemble_labels)

- 1

- 2

- 3

Ensemble 方法(Stacking)

以下是一个简单的 Stacking 示例,使用 Logistic Regression 作为元学习器来融合 Random Forest 和 SVM 的预测结果:

Python``` 1from sklearn.ensemble import RandomForestClassifier, SVC2from sklearn.linear_model import LogisticRegression3from sklearn.model_selection import train_test_split4 5# 基学习器 6base_models = [ 7 ('rf', RandomForestClassifier(n_estimators=100)), 8 ('svm', SVC(probability=True)) 9] 10 11# 训练基学习器 12X_train, X_val, y_train, y_val = train_test_split(X, y, test_size=0.3, random_state=42) 13for name, model in base_models:14 model.fit(X_train, y_train) 15 16# 预测验证集 17val_predictions = {} 18for name, model in base_models:19 val_predictions[name] = model.predict_proba(X_val)[:, 1] 20 21# 堆叠层(元学习器) 22stacking_layer = LogisticRegression() 23stacking_layer.fit(val_predictions, y_val) 24 25# 使用全部数据重新训练基学习器和元学习器 26for name, model in base_models:27 model.fit(X, y) 28stacking_layer.fit({name: model.predict_proba(X)[:, 1] for name, model in base_models}, y)29 30# 现在可以使用整个 Ensemble(基学习器+元学习器)进行预测 31ensemble_predictions = stacking_layer.predict({name: model.predict_proba(test_data)[:, 1] for name, model in base_models})

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

总结来说,模型融合通常涉及将模型的输出或内部表示直接合并,而 Ensemble 方法则侧重于构建多个模型并设计特定规则或学习算法来整合它们的预测。企业封装开源大模型时,可以根据应用场景选择合适的融合或 Ensemble 策略,并通过代码实现模型间的整合与交互。上述代码示例展示了如何在 Python 和 Scikit-Learn 中实现这两种技术。 34、大模型中token、prompt分别是指什么,和大模型是什么关系,在实际使用时和大模型是如何交互的 **大模型中的 Token** 在大模型(通常指大规模语言模型)中,**Token** 是文本表示的基本单位,用于将自然语言文本转换成机器可理解和处理的形式。Token 可以是: * **单个词**:如英文单词 "cat"、中文词语 "猫"。 * **子词或分词**:对于多音节词或复杂语言中的复合词,可能被细分为多个Token,如 "unbelievable" 分为 "un"、"believ"、"able"。 * **标点符号**:如句号 "."、逗号 ","。 * **特殊符号或标记**:如开始/结束标记(`<s>`、`</s>`)、数字、特殊实体标记(如人名、地名的特殊编码)。 Tokenization 是将原始文本分割成Token序列的过程,通常由预处理步骤完成。这些Token随后会被编码为数值(如整数ID),以便输入到神经网络模型中进行训练和推理。在大模型中,Token是模型处理的最基本元素,模型通过学习Token序列之间的关联来理解和生成语言。 **大模型中的 Prompt** **Prompt** 是与大模型交互时提供的输入文本或指令,旨在引导模型生成特定类型或主题的输出。Prompt 可以是: * **问题**:如 "What is the capital of France?",用于获取特定事实性答案。 * **描述**:如 "Compose a poem about autumn leaves",请求模型创作文学作品。 * **任务说明**:如 "Translate this text into Spanish: 'The quick brown fox jumps over the lazy dog.'",指示模型执行翻译任务。 * **对话片段**:在对话式应用中,prompt可能是前几轮对话的历史记录,帮助模型维持上下文连贯性并做出恰当回应。 Prompt 是与大模型交互的关键接口,它的设计直接影响模型生成结果的质量和相关性。在实际使用中,用户或应用程序会精心构造prompt,确保其清晰、具体且符合预期目标,同时注意控制prompt的长度,避免超出模型的最大Token限制。 **大模型、Token与Prompt的关系** 1. **大模型** 是一个高度复杂的神经网络架构,能够根据输入的Token序列(即Prompt)进行条件性文本生成或文本分析任务。 2. **Token** 是大模型处理的原子单元,它们被编码后输入模型作为基本输入数据。模型通过学习Token之间的关系来捕捉语言的语法、语义和上下文信息。 3. **Prompt** 作为用户与大模型交互的媒介,是由Token组成的特定文本片段,用来触发模型产生所需响应。Prompt的设计和质量直接影响模型输出的效果。 **实际使用中的交互过程** 在实际使用大模型时,与模型的交互通常遵循以下步骤: 1. **构造Prompt**:根据所需的任务或问题,编写或生成一个适当的Prompt。这可能涉及明确的问题表述、背景信息提供、风格或主题设定等。 2. **Tokenization**:将Prompt文本通过预定义的Tokenization规则或工具转换成Token序列。这一步可能包括分词、大小写标准化、特殊字符处理等。 3. **Encoding**:将Token序列映射为模型能理解的数值表示(通常是整数ID)。这通常涉及查找表(lookup table)或嵌入矩阵(embedding matrix),将每个Token ID对应到一个稠密向量。 4. **模型推理**:将编码后的Token序列输入到大模型中,模型根据内部参数计算出输出序列的概率分布。对于生成任务,通常采用某种采样策略(如贪心采样、Top-K采样、 nucleus sampling等)从概率分布中抽取实际输出Token序列。 5. **Decoding**:将模型输出的Token ID序列解码回原始文本形式。这包括逆向查找表操作以及必要的后处理(如拼接标点、去除模型生成的开始/结束标记等)。 6. **评估与反馈**:检查模型生成的结果是否满足需求,如有必要,调整Prompt设计或使用其他交互策略(如迭代提问、提供额外约束等)以优化输出。 综上所述,Token和Prompt在大模型中分别扮演着基本数据单元和交互接口的角色,二者紧密配合使得用户能够有效地利用大模型进行各种自然语言处理任务。 35、上述实际使用的交互过程,在企业级的大模型商业化产品上,是如何实现的,可以结合应用 架构、代码示例说明 企业级大模型商业化产品在实现与用户的交互过程中,通常会构建一个包含前端界面、后端服务、模型服务及数据库等组件的完整应用架构。以下是对这一过程的简化描述,并结合伪代码示例说明: ### 应用架构概览 1. **前端界面**:用户与产品的交互界面,负责呈现提示输入框、输出区域、设置选项等,通过HTTP/HTTPS协议发送请求至后端服务。 2. **后端服务**:接收前端请求,处理业务逻辑(如身份验证、权限管理、付费验证等),调用模型服务,并将模型返回结果返回给前端。 3. **模型服务**:封装大模型,提供统一的API接口供后端调用,负责Tokenization、模型推理、Decoding等具体模型交互工作。 4. **数据库**(可选):存储用户信息、历史交互记录、模型配置参数等。 ### 交互流程与伪代码示例 #### 1\. 用户在前端输入Prompt 用户在前端界面的提示输入框中键入或选择一个Prompt(例如,通过下拉菜单选择预设模板),点击“生成”按钮提交请求。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

Html```

1

2

3

4 生成

5

6

7

- 1

- 2

- 3

2. 前端发送请求至后端

前端通过AJAX、Fetch API或其他库(如axios)向后端服务发送POST请求,包含用户输入的Prompt。

Javascript```

1function sendRequestToBackend(prompt) {

2 fetch('/api/generate', {

3 method: 'POST',

4 headers: {

5 'Content-Type': 'application/json',

6 },

7 body: JSON.stringify({ prompt }),

8 })

9 .then(response => response.json())10 .then(handleResponse) // 处理后端返回的数据

11 .catch(handleError); // 处理错误

12}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

#### 3\. 后端调用模型服务

后端收到请求后,验证用户权限、处理业务逻辑(如计费),然后通过RPC(如gRPC、RESTful API)或消息队列(如RabbitMQ、Kafka)等方式调用模型服务。

- 1

- 2

- 3

- 4

- 5

Python```

1# 后端Python示例(使用Flask框架)

2from flask import Flask, request, jsonify3import grpc4from model_service_pb2 import GenerateRequest5from model_service_pb2_grpc import ModelServiceStub6

7app = Flask(name)

8

9@app.route(‘/api/generate’, methods=[‘POST’])

10def generate():

11 prompt = request.json[‘prompt’]

12

13 # 连接到模型服务

14 channel = grpc.insecure_channel(‘model-service:50051’)

15 stub = ModelServiceStub(channel)

16

17 # 构造请求参数

18 generate_request = GenerateRequest(prompt=prompt)

19

20 # 调用模型服务

21 response = stub.Generate(generate_request)

22

23 return jsonify(response.to_dict()) # 将模型响应转化为JSON返回给前端

- 1

- 2

- 3

4. 模型服务与大模型交互

模型服务接收到请求后,对Prompt进行Tokenization、编码、模型推理、Decoding等操作,并返回结果给后端。

Python``` 1# 模型服务示例 2class ModelService(ModelServiceServicer): 3 def Generate(self, request, context): 4 prompt = request.prompt 5 6 # Tokenization 7 tokens = tokenizer.tokenize(prompt) 8 9 # Encoding 10 token_ids = [vocab.get_token_index(token) for token in tokens]11 12 # 模型推理 13 output_tokens = model.generate(input_ids=token_ids, max_length=100) 14 15 # Decoding 16 generated_text = tokenizer.decode(output_tokens, skip_special_tokens=True) 17 18 return GenerateResponse(text=generated_text)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

#### 5\. 后端返回结果给前端

后端收到模型服务返回的结果后,将其转换为JSON格式并通过HTTP响应返回给前端。

- 1

- 2

- 3

- 4

- 5

Javascript```

1function handleResponse(response) {

2 const generatedText = response.text;3 displayGeneratedText(generatedText); // 在前端显示生成的文本

4}

5

6function handleError(error) {

7 console.error(‘Error:’, error);

8 displayError(error.message); // 显示错误信息

9}

- 1

- 2

- 3

总结

企业级大模型商业化产品通过构建包含前端界面、后端服务、模型服务等组件的应用架构,实现了用户与大模型的交互。用户在前端输入Prompt,前端发送请求至后端,后端调用模型服务与大模型进行Tokenization、模型推理、Decoding等操作,最后将结果返回给前端展示。整个过程涉及HTTP/HTTPS、RPC、消息队列等多种通信方式,以及前后端数据交换的JSON格式。具体的代码实现会根据选用的技术栈(如编程语言、框架、库等)有所不同。

36、模型服务是如何操作向量数据库的,生产级业务会涉及哪些具体操作,结合代码示例说明

模型服务在操作向量数据库时,通常会涉及以下几种典型操作:

-

向量写入:将模型生成的向量或者经过预处理后的数据向量存储到向量数据库中。

-

向量检索:根据输入查询向量,从数据库中找出最相似的向量集合。

-

更新向量:在必要时更新已存储向量的数据或其元数据。

-

删除向量:移除不再需要的向量记录。

-

索引管理:创建、更新或删除索引来优化查询性能。

-

监控与调整:监控数据库性能、调整索引参数以适应查询负载变化。

下面结合伪代码示例,展示模型服务如何使用Python操作向量数据库进行这些操作,以Pinecone、Milvus和Qdrant为例:

1. Pinecone

Python``` 1import pinecone2 3# 初始化Pinecone服务 4pinecone.init(api_key='YOUR_API_KEY') 5 6# 创建向量空间 7space_name = 'my_vector_space' 8pinecone.create_space(space_name, dimension=256) 9 10# 写入向量 11vector_data = [0.1, 0.2, ..., 0.255] 12pinecone.upsert(vector_id='item_1', vector=vector_data, space_name=space_name) 13 14# 检索向量 15query_vector = [0.½, 0.3, ..., 0.26] 16results = pinecone.query(query=query_vector, top_k=10, space_name=space_name) 17 18# 更新向量 19updated_vector = [0.2, 0.3, ..., 0.27] 20pinecone.update(vector_id='item_1', vector=updated_vector, space_name=space_name) 21 22# 删除向量 23pinecone.delete(vector_id='item_1', space_name=space_name) 24 25# 索引管理一般由Pinecone服务自动维护,无需直接操作 26 27# 监控与调整可通过Pinecone提供的API或Web界面完成

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

#### 2\. Milvus

- 1

- 2

- 3

Python```

1from milvus import MilvusClient, IndexType, MetricType2

3# 连接Milvus服务

4milvus = MilvusClient(host=‘localhost’, port=19530)

5

6# 创建或连接向量空间

7collection_name = ‘my_collection’

8param = {‘collection_name’: collection_name, ‘dimension’: 256, ‘index_file_size’: 1024, ‘metric_type’: MetricType.L2}

9milvus.create_collection(param)

10

11# 写入向量

12vector_data = [0.1, 0.2, …, 0.255]

13entities = [{“id”: “item_1”, “vector”: vector_data}]

14milvus.insert(collection_name, entities)

15

16# 检索向量

17query_vector = [0.½, 0.3, …, 0.26]

18search_params = {“topk”: 10, “nprobe”: 32}

19results = milvus.search(collection_name, query_vector, search_params)

20

21# 更新向量(需先删除再插入)

22milvus.delete_entity_by_id(collection_name, [‘item_1’])

23updated_vector = [0.2, 0.3, …, 0.27]

24updated_entities = [{“id”: “item_1”, “vector”: updated_vector}]

25milvus.insert(collection_name, updated_entities)

26

27# 删除向量

28milvus.delete_entity_by_id(collection_name, [‘item_1’])

29

30# 创建或更新索引

31index_param = {“index_type”: IndexType.IVF_SQ8, “metric_type”: MetricType.L2, “params”: {“nlist”: 1024}}

32milvus.create_index(collection_name, index_param)

33

34# 监控与调整可通过Milvus提供的API或Milvus Dashboard完成

- 1

- 2

- 3

3. Qdrant

Python``` 1from qdrant_client import QdrantClient, Vector2from qdrant_client.models.model import Distance3 4# 连接Qdrant服务 5client = QdrantClient("localhost:6333") 6 7# 创建或连接向量集合 8collection_name = 'my_collection' 9client.collection(collection_name).create( 10 vector_size=256, 11 distance=Distance.Cosine, 12) 13 14# 写入向量 15vector_data = [0.1, 0.2, ..., 0.255] 16vector = Vector(data=vector_data) 17client.collection(collection_name).upsert( 18 vectors=[vector], 19 ids=["item_1"], 20 partition_tags=["default"], 21) 22 23# 检索向量 24query_vector = [0.½, 0.3, ..., 0.26] 25result = client.collection(collection_name).nearest( 26 vector=query_vector, 27 num=10, 28 filter={"partition_tags": ["default"]}, 29 distance=Distance.Cosine, 30) 31 32# 更新向量(需先删除再插入) 33client.collection(collection_name).delete(id=["item_1"]) 34updated_vector = [0.2, 0.3, ..., 0.27] 35updated_vector_obj = Vector(data=updated_vector) 36client.collection(collection_name).upsert( 37 vectors=[updated_vector_obj], 38 ids=["item_1"], 39 partition_tags=["default"], 40) 41 42# 删除向量 43client.collection(collection_name).delete(id=["item_1"]) 44 45# 索引管理:Qdrant默认使用HNSW索引,创建集合时指定距离度量即可 46 47# 监控与调整可通过Qdrant提供的API或Qdrant Dashboard完成

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48