- 1Unity编辑器工具制作(二)——制作一键打包工具_unity一键打包 packagegui

- 2软件测试全套教程,软件测试自学线路图_httqs//w.url.cn/aoezrr8

- 3【UE4 009】江河海洋水体材质_motion_4waychaos

- 4scada java_SCADA开源项目lite版本

- 5ExtJs实现阻止冒泡,以及再次允许冒泡——stopPropagation的正确使用

- 6FFTW介绍

- 7opencv编译(cuda支持)_opencv cuda 编译

- 8【Unity3D】无法正确获取RectTransform的属性值导致计算出错_some values driven by canvas

- 9echarts-环形图基础(一)_echarts环形图逆时针

- 10element UI 父组件验证子组件form表单_element 父子组件 表单校验

Pandas数据库大揭秘:read_sql、to_sql 参数详解与实战篇【第81篇—Pandas数据库】

赞

踩

Pandas数据库大揭秘:read_sql、to_sql 参数详解与实战篇

Pandas是Python中一流的数据处理库,而数据库则是数据存储和管理的核心。将两者结合使用,可以方便地实现数据的导入、导出和分析。本文将深入探讨Pandas中用于与数据库交互的两个关键方法:read_sql和to_sql。通过详细解析这两个方法的参数,我们将为读写数据库提供清晰的指导,并附带实际代码演示,以帮助读者更好地理解和运用这些功能。

Pandas读取数据库(read_sql)

read_sql方法简介

read_sql是Pandas提供的用于从数据库读取数据的方法。它允许我们执行SQL查询并将结果直接转换为DataFrame。下面我们将深入探讨read_sql的关键参数:

- sql:SQL查询语句,必须提供。

- con:数据库连接对象,可以是字符串(表示连接字符串)或SQLAlchemy引擎。

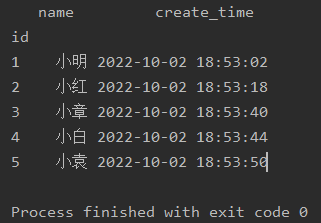

- index_col:指定作为DataFrame索引的列。

- parse_dates:指定需要解析为日期时间的列。

- params:SQL查询中的参数,可以使用字典形式提供。

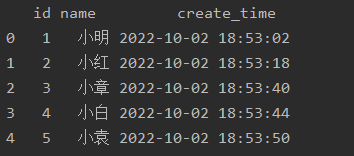

实例演示

假设我们有一个SQLite数据库,其中包含一张名为employees的表,结构如下:

CREATE TABLE employees (

id INTEGER PRIMARY KEY,

name TEXT,

salary REAL,

hire_date DATE

);

- 1

- 2

- 3

- 4

- 5

- 6

我们可以使用以下代码查询并将结果存储到Pandas DataFrame中:

import pandas as pd

from sqlalchemy import create_engine

# 创建SQLite引擎

engine = create_engine('sqlite:///example.db')

# 定义SQL查询语句

sql_query = 'SELECT * FROM employees'

# 使用read_sql读取数据

df = pd.read_sql(sql_query, con=engine)

# 打印结果

print(df)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

Pandas写入数据库(to_sql)

to_sql方法简介

to_sql是Pandas用于将DataFrame数据写入数据库的方法。它允许我们将DataFrame中的数据插入到数据库表中。下面我们将深入探讨to_sql的关键参数:

- name:目标数据库表的名称。

- con:数据库连接对象,可以是字符串(表示连接字符串)或SQLAlchemy引擎。

- if_exists:如果表已存在,指定处理方式(‘fail’、‘replace’、‘append’)。

- index:是否将DataFrame的索引写入数据库。

实例演示

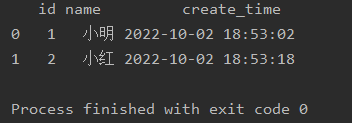

假设我们有一个名为new_employees的DataFrame,我们希望将其写入数据库中的employees表:

# 创建一个新的DataFrame

new_employees = pd.DataFrame({

'name': ['John', 'Alice'],

'salary': [60000, 70000],

'hire_date': ['2024-01-15', '2024-02-01']

})

# 使用to_sql写入数据库

new_employees.to_sql(name='employees', con=engine, if_exists='append', index=False)

# 验证写入结果

df_updated = pd.read_sql('SELECT * FROM employees', con=engine)

print(df_updated)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

通过这两个实例,我们展示了如何使用read_sql和to_sql方法与数据库进行交互。这些方法的参数提供了灵活性,使得可以轻松处理各种数据库操作需求。读者可以根据实际情况调整参数以满足自己的数据处理需求。

高级用法和注意事项

参数优化

除了上述提到的必要参数外,read_sql和to_sql还有一些其他参数,如chunksize和dtype,用于优化性能和数据类型的处理。

- chunksize:当从数据库读取数据时,可以指定每次读取的行数,以避免内存溢出。

- dtype:在将数据写入数据库时,可以为列指定数据类型,以提高写入的效率。

事务管理

在使用to_sql写入数据库时,默认情况下是在一个事务中执行的。如果想要控制事务的开始和结束,可以使用if_exists='replace'参数,并结合index参数为True,在写入数据前使用SQL语句先删除表中的数据,然后再插入新数据。

# 删除表中的所有数据

engine.execute('DELETE FROM employees')

# 使用to_sql写入新数据

new_employees.to_sql(name='employees', con=engine, if_exists='append', index=False)

- 1

- 2

- 3

- 4

- 5

支持的数据库类型

read_sql和to_sql方法不仅仅支持SQLite,还支持多种数据库,如MySQL、PostgreSQL、SQL Server等。只需更改create_engine中的连接字符串即可实现与其他数据库的交互。

进阶技巧与扩展应用

自定义数据类型映射

在实际应用中,有时数据库中的数据类型可能与Pandas默认的数据类型不完全匹配。这时,可以使用dtype参数进行自定义数据类型映射,确保数据正确地写入数据库。

# 自定义数据类型映射

dtype_mapping = {'salary': sqlalchemy.types.FLOAT, 'hire_date': sqlalchemy.types.Date}

# 使用to_sql写入数据库,指定dtype参数

new_employees.to_sql(name='employees', con=engine, if_exists='append', index=False, dtype=dtype_mapping)

- 1

- 2

- 3

- 4

- 5

使用 SQLAlchemy 进行更复杂的数据库操作

在实际项目中,可能需要进行更复杂的数据库操作,如事务管理、批量插入等。此时,可以使用SQLAlchemy库进行更灵活和强大的数据库交互。

from sqlalchemy import text

# 使用SQLAlchemy执行复杂的SQL语句

sql_statement = text("UPDATE employees SET salary = salary * 1.1 WHERE hire_date < '2024-02-01'")

engine.execute(sql_statement)

# 通过SQLAlchemy进行事务管理

with engine.begin() as connection:

connection.execute("INSERT INTO employees (name, salary, hire_date) VALUES ('Bob', 75000, '2024-02-15')")

connection.execute("DELETE FROM employees WHERE hire_date < '2024-01-01'")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

多数据库支持

有时,一个项目可能需要同时连接多个数据库,可以通过创建多个create_engine对象实现。这为在不同数据库之间进行数据转移和分析提供了便利。

# 连接第一个数据库

engine_db1 = create_engine('sqlite:///database1.db')

# 连接第二个数据库

engine_db2 = create_engine('mysql://user:password@localhost/database2')

# 从第一个数据库读取数据

df_db1 = pd.read_sql('SELECT * FROM table1', con=engine_db1)

# 将数据写入第二个数据库

df_db1.to_sql(name='table2', con=engine_db2, if_exists='replace', index=False)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

性能优化与最佳实践

批量插入数据

在大数据量的情况下,使用to_sql方法批量插入数据可能会比逐行插入更高效。可以通过将DataFrame分割成小块,并使用chunksize参数来实现批量插入。

chunk_size = 1000

# 将DataFrame拆分为小块,每块包含1000行

for chunk in pd.read_sql('SELECT * FROM large_table', con=engine, chunksize=chunk_size):

chunk.to_sql(name='new_large_table', con=engine, if_exists='append', index=False)

- 1

- 2

- 3

- 4

- 5

数据预处理

在从数据库读取数据或将数据写入数据库之前,进行适当的数据预处理是提高性能的关键。这包括处理缺失值、调整数据类型、进行索引优化等。

# 处理缺失值

df.fillna(value=0, inplace=True)

# 调整数据类型

df['hire_date'] = pd.to_datetime(df['hire_date'])

# 创建索引

df.set_index('id', inplace=True)

# 使用to_sql写入数据库

df.to_sql(name='employees', con=engine, if_exists='replace', index=True)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

使用索引加速查询

在读取数据时,可以通过在SQL查询中使用索引来提高检索速度。确保数据库表中的字段上有适当的索引,可以显著减少查询时间。

# 在数据库表的name字段上创建索引

engine.execute('CREATE INDEX idx_name ON employees (name)')

- 1

- 2

异步操作

在处理大量数据时,考虑使用异步操作来提高效率。可以使用asyncio库与异步数据库驱动(如aiomysql、aiopg)结合,实现并发的数据读取和写入。

import asyncio

import aiomysql

async def async_read_sql():

async with aiomysql.create_pool(host='localhost', user='root', password='password', db='database') as pool:

async with pool.acquire() as conn:

async with conn.cursor() as cur:

await cur.execute("SELECT * FROM table")

result = await cur.fetchall()

return result

# 使用异步读取数据

loop = asyncio.get_event_loop()

data = loop.run_until_complete(async_read_sql())

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

异常处理与安全性

在与数据库交互时,合理的异常处理是至关重要的。通过使用try-except块,可以捕获可能的数据库操作异常,从而更好地处理错误情况。

try:

# 读取数据库

df = pd.read_sql('SELECT * FROM table', con=engine)

# 写入数据库

df.to_sql(name='new_table', con=engine, if_exists='replace', index=False)

except Exception as e:

print(f"An error occurred: {e}")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

另外,要确保在连接数据库时,使用安全的认证方式和正确的权限设置,以保障数据库的安全性。

数据库连接池与长连接管理

在实际应用中,频繁地打开和关闭数据库连接会增加系统开销。为了提高效率,可以使用数据库连接池管理数据库连接,减少连接的创建和销毁次数。SQLAlchemy库提供了create_engine函数的pool_size和max_overflow参数,用于配置数据库连接池的大小和溢出策略。

from sqlalchemy import create_engine, pool

# 创建带连接池的引擎

engine = create_engine('sqlite:///example.db', pool_size=10, max_overflow=20)

- 1

- 2

- 3

- 4

pool_size:指定连接池中保持的连接数。max_overflow:指定允许在连接池外创建的连接数,超过该数目的连接会在连接使用后被回收。

长连接管理

在某些情况下,长连接可能是一种优化性能的方法。通过使用SQLAlchemy的pool_pre_ping参数,可以在每次连接使用前检查连接的健康状态,并在连接失效时重新连接。

# 创建带连接池的引擎,开启连接健康检查

engine = create_engine('sqlite:///example.db', pool_size=10, max_overflow=20, pool_pre_ping=True)

- 1

- 2

数据加密与安全传输

当连接到远程数据库或者在需要保护数据隐私的情况下,确保数据的传输是加密的是非常重要的。可以通过使用安全的协议和加密选项来保护数据传输。

# 使用安全连接,例如SSL/TLS

engine = create_engine('postgresql+psycopg2://user:password@localhost/database', connect_args={'sslmode': 'require'})

- 1

- 2

确保数据库服务器支持安全协议,并正确配置,以保证数据在传输过程中的机密性。

多线程与多进程操作

在多线程或多进程环境下,需要注意数据库连接的共享与同步问题。SQLAlchemy的create_engine函数提供了pool_pre_ping和pool_use_lifo等参数,用于管理连接池的多线程或多进程使用。

# 创建带连接池的引擎,适用于多线程环境

engine = create_engine('sqlite:///example.db', pool_size=10, pool_use_lifo=True, pool_pre_ping=True)

- 1

- 2

pool_use_lifo:指定连接池使用LIFO(后进先出)策略,适用于多线程环境。

数据库备份与恢复

在关键数据的场景中,定期进行数据库备份是一种良好的实践。可以使用数据库管理系统提供的备份工具,也可以通过编写脚本实现自动化备份。

import subprocess

# 使用系统命令备份SQLite数据库

subprocess.run(['sqlite3', 'example.db', '.backup', 'backup.db'])

- 1

- 2

- 3

- 4

确保备份的数据得以加密和安全存储,以防止数据泄露和损坏。

数据库版本管理

在实际开发中,数据库结构可能随着时间的推移而发生变化。为了确保应用程序与数据库的兼容性,可以使用数据库版本管理工具。其中,Alembic是一个常用的数据库迁移工具,它可以帮助记录数据库结构的变更并协助执行这些变更。

安装 Alembic

首先,安装 Alembic:

pip install alembic

- 1

创建 Alembic 配置文件

创建一个 alembic.ini 配置文件,用于指定数据库连接信息和迁移脚本存放的路径:

# alembic.ini

[alembic]

script_location = alembic

sqlalchemy.url = sqlite:///example.db

- 1

- 2

- 3

- 4

- 5

创建迁移脚本

使用以下命令初始化 Alembic:

alembic init alembic

- 1

然后在 alembic/versions 目录下创建迁移脚本,例如 alembic/versions/001_initial_migration.py:

# alembic/versions/001_initial_migration.py

from alembic import op

import sqlalchemy as sa

def upgrade():

op.create_table(

'new_table',

sa.Column('id', sa.Integer, primary_key=True),

sa.Column('name', sa.String),

sa.Column('value', sa.Integer)

)

def downgrade():

op.drop_table('new_table')

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

执行迁移

通过以下命令执行迁移:

alembic upgrade head

- 1

这将根据定义的迁移脚本更新数据库结构。Alembic会自动跟踪当前数据库版本,以便在将来进行进一步的迁移。

数据库监控与性能优化

使用数据库监控工具来监视数据库的性能,并识别潜在的性能瓶颈。一些流行的数据库监控工具包括 Prometheus、Grafana 等。通过监测关键性能指标,可以及时发现和解决性能问题,确保数据库运行的稳定性。

数据库自动化测试

在开发和维护数据库应用时,编写自动化测试是至关重要的。使用测试框架,例如 pytest,编写测试用例来验证数据库查询、更新和删除等操作的正确性。这有助于捕获潜在的问题,并确保代码的稳定性。

# 示例 pytest 测试用例

import pytest

from sqlalchemy import create_engine

@pytest.fixture

def db_engine():

return create_engine('sqlite:///:memory:')

def test_database_operations(db_engine):

# 编写测试用例

# ...

# 断言期望的结果

assert True

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

总结:

在本文中,我们深入探讨了与数据库交互时的关键技术,主要聚焦于使用Pandas库进行数据读写,以及一系列性能优化、安全性、多线程/多进程操作、数据库版本管理、监控与性能优化以及自动化测试等最佳实践。以下是本文的主要要点:

-

Pandas与数据库交互: 我们详细介绍了Pandas中的

read_sql和to_sql方法,通过这两个方法实现了从数据库读取数据和将数据写入数据库的操作,并提供了参数详解和实际代码演示。 -

性能优化与最佳实践: 我们探讨了在数据库操作中的性能优化技巧,包括批量插入数据、数据预处理、使用索引加速查询等。同时,介绍了异常处理、安全传输、数据库连接池与长连接管理等方面的最佳实践,以提高效率和可靠性。

-

进阶技巧与扩展应用: 我们深入研究了一些进阶技巧,如自定义数据类型映射、使用SQLAlchemy进行更复杂的数据库操作、多数据库支持等。这些技巧为读者在实际项目中处理复杂数据库操作提供了更多选择。

-

数据库版本管理: 引入了数据库版本管理工具Alembic,通过迁移脚本的创建和执行,使数据库结构的变更更加可控和可维护。

-

数据库监控与性能优化: 强调了使用数据库监控工具,如Prometheus、Grafana等,来监测数据库性能,并提到了性能优化的一些建议。

-

数据库自动化测试: 强调了编写自动化测试用例的重要性,使用测试框架如pytest,以确保数据库操作的正确性和稳定性。

通过本文的指导,读者可以更全面地了解如何高效、安全地进行数据库操作,并在实际项目中应用这些最佳实践,以构建出稳定、高效的数据库应用。这些技巧和建议有助于提高开发和维护数据库应用的效率,同时确保数据的可靠性和安全性。希望本文能够为读者在数据库交互方面提供有益的指导。