- 1vue2公众号跳转小程序 wx-open-launch-weapp 超完整流程

- 2Unity用ZXing插件生成二维码_zxing unity

- 3获取本机软件安装目录_获取软件安装目录

- 48- app如何修改包名_raname

- 5sqoop导入mysql到hbase报错 java.lang.NoSuchMethodError: org.apache.hadoop.hbase.client.HBaseAdmin.

- 6基于MATLAB的遗传算法优化卡车和两架无人机的配送路径规划_卡车无人机协同配送代码

- 7Spring Boot Actuator未授权访问远程代码执行_eureka_XStream反序列化_springeureka平台未授权访问

- 8zookeeper连接不上/Session 0x0 for server null, unexpected error, closing socket connection

- 9AI-如何有效测试机器学习模型_机器学习测试

- 10必须要掌握的【Hbase Shell】_create 'scores2',{name=>'course',versions=>3},{nam

群体优化算法---灰狼优化算法学习介绍以及在卷积神经网络训练上的应用

赞

踩

**长文预警**

- 1

介绍

在自然界中,狼群的社会结构和捕猎策略展现了高度的智能和协调性,灰狼优化算法(Grey Wolf Optimizer, GWO)正是受此启发提出的一种群体智能优化算法。GWO主要模拟了灰狼的社会等级制度和捕猎行为,其核心在于利用灰狼群的捕猎策略来搜索全局最优解

灰狼的社会等级与行为

1. 社会等级

灰狼的社会结构主要分为四个等级:

α狼:群体的领导者,负责做出决策,如捕猎、睡觉地点的选择等。

β狼:辅助α狼管理狼群,通常是次级领导者。

δ狼:地位较低的成员,服从α和β狼。

ω狼:最低等级的狼,主要负责跟随和服从群体。

2. 捕猎行为

灰狼的捕猎过程大致可分为三个阶段:

围捕(Encircling):狼群包围猎物。

追踪与骚扰(Hunting and Harassment):通过不断接近和干扰猎物,逐步削弱其体力。

攻击(Attacking):最终发起攻击捕获猎物。

灰狼优化算法的基本原理

1.初始种群的生成

GWO从一组随机生成的灰狼个体开始。每个个体对应一个候选解,在解空间中进行搜索。种群大小一般固定为n。

2. 社会等级的划分

在GWO中,α、β、δ狼分别代表当前搜索到的最优解、次优解和第三优解,其余的狼则作为ω狼。通过不断迭代更新,狼群中的个体逐渐靠近全局最优解。

3. 模拟围捕行为

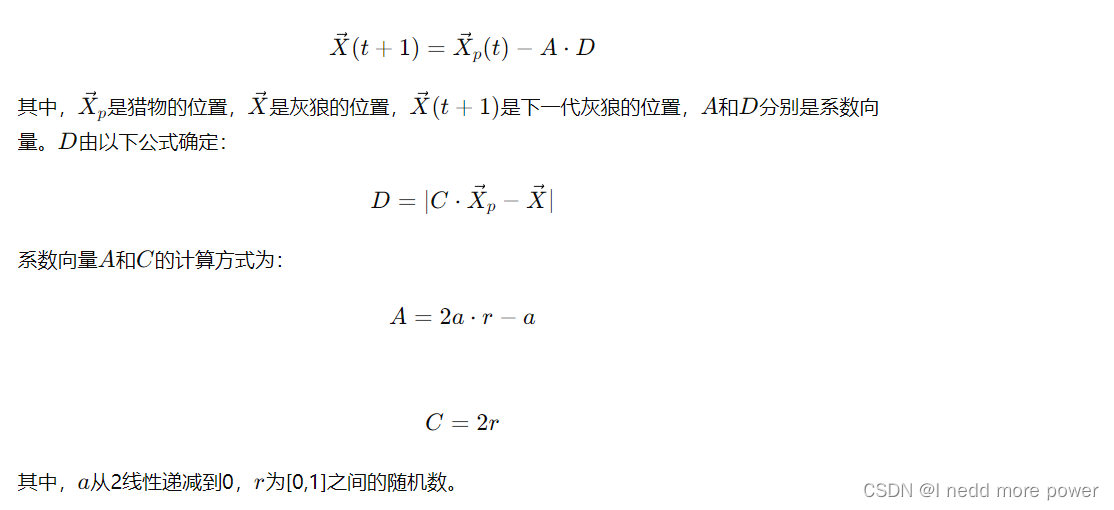

围捕行为通过数学公式进行模拟:

4. 位置更新

灰狼的位置更新不仅仅依赖于单一的α狼,而是通过α、β、δ狼的位置来共同决定,这样可以避免陷入局部最优。位置更新公式如下:

灰狼优化算法步骤

1.初始化:设定种群大小、最大迭代次数,并初始化灰狼种群的位置。

2.适应度评价:计算每个个体的适应度值,并确定α、β、δ狼的位置。

3.位置更新:根据围捕、追踪与骚扰行为更新灰狼的位置。

4.迭代:重复适应度评价和位置更新步骤,直到达到最大迭代次数或收敛条件。

5.输出最优解。

应用领域

GWO因其简洁性和高效性,广泛应用于各类优化问题,包括但不限于:

函数优化:如多峰函数的全局优化。

工程优化:如结构设计优化、调度问题等。

机器学习:如神经网络的参数优化。

图像处理:如图像分割、特征选择等

优势与局限性

优势

简洁性:算法实现简单,不需要复杂的参数设置。

全局搜索能力强:通过模拟灰狼的捕猎行为,有效避免陷入局部最优。

适应性强:适用于连续和离散优化问题,具有广泛的应用前景。

局限性

参数依赖性:虽然参数较少,但参数的设置对算法性能有一定影响。

收敛速度:在某些复杂问题上,收敛速度可能不够理想,需要结合其他优化方法

改进与发展

为了提升GWO的性能,研究者提出了多种改进算法,如:

混合算法:将GWO与其他优化算法(如遗传算法、粒子群优化)结合,增强搜索能力。

动态参数调整:根据迭代过程中的反馈信息,动态调整算法参数,提高适应性。

多种群协作:利用多个种群协同搜索,提高全局搜索能力和收敛速度

代码

由于本文示例涉及到的代码有三个脚本,所以建议在matlab新建一个文件夹,命名随意

gwo_optimize.cnn.m

function best_params = gwo_optimize_cnn(train_data, train_labels, val_data, val_labels, max_iter, n_wolves) % Initialize the population dim = 2; % Example: learning rate, number of conv layers lb = [1e-4, 1]; % Lower bounds for the parameters ub = [1e-2, 5]; % Upper bounds for the parameters wolves = repmat(lb, n_wolves, 1) + rand(n_wolves, dim) .* (repmat(ub, n_wolves, 1) - repmat(lb, n_wolves, 1)); alpha = inf; beta = inf; delta = inf; alpha_pos = zeros(1, dim); beta_pos = zeros(1, dim); delta_pos = zeros(1, dim); for iter = 1:max_iter for i = 1:n_wolves % Calculate fitness for each wolf fitness = evaluate_cnn(wolves(i, :), train_data, train_labels, val_data, val_labels); % Update alpha, beta, delta wolves if fitness < alpha delta = beta; delta_pos = beta_pos; beta = alpha; beta_pos = alpha_pos; alpha = fitness; alpha_pos = wolves(i, :); elseif fitness < beta delta = beta; delta_pos = beta_pos; beta = fitness; beta_pos = wolves(i, :); elseif fitness < delta delta = fitness; delta_pos = wolves(i, :); end end % Update positions a = 2 - iter * (2 / max_iter); for i = 1:n_wolves for j = 1:dim A1 = 2 * a * rand() - a; C1 = 2 * rand(); D_alpha = abs(C1 * alpha_pos(j) - wolves(i, j)); X1 = alpha_pos(j) - A1 * D_alpha; A2 = 2 * a * rand() - a; C2 = 2 * rand(); D_beta = abs(C2 * beta_pos(j) - wolves(i, j)); X2 = beta_pos(j) - A2 * D_beta; A3 = 2 * a * rand() - a; C3 = 2 * rand(); D_delta = abs(C3 * delta_pos(j) - wolves(i, j)); X3 = delta_pos(j) - A3 * D_delta; wolves(i, j) = (X1 + X2 + X3) / 3; end end end best_params = alpha_pos; end function fitness = evaluate_cnn(params, train_data, train_labels, val_data, val_labels) % Extract parameters learning_rate = params(1); num_conv_layers = round(params(2)); % Create CNN layers = [ imageInputLayer([28 28 1]); ]; for i = 1:num_conv_layers layers = [layers; convolution2dLayer(3, 8 * i, 'Padding', 'same'); batchNormalizationLayer(); reluLayer(); maxPooling2dLayer(2, 'Stride', 2); ]; end layers = [layers; fullyConnectedLayer(10); % The output size should match the number of classes (10 for MNIST) softmaxLayer(); classificationLayer()]; % Training options options = trainingOptions('sgdm', ... 'InitialLearnRate', learning_rate, ... 'MaxEpochs', 10, ... 'MiniBatchSize', 64, ... 'Shuffle', 'every-epoch', ... 'ValidationData', {val_data, val_labels}, ... 'ValidationFrequency', 30, ... 'Verbose', false, ... 'Plots', 'training-progress'); % Train the network net = trainNetwork(train_data, train_labels, layers, options); % Evaluate the network predicted_labels = classify(net, val_data); accuracy = sum(predicted_labels == val_labels) / numel(val_labels); % Fitness is defined as 1 - accuracy to minimize the fitness fitness = 1 - accuracy; end

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

- 91

- 92

- 93

- 94

- 95

- 96

- 97

- 98

load_dataset.m

function [train_data, train_labels, val_data, val_labels] = load_dataset()

% 加载MNIST数据集作为示例

% 这里假设数据已经预处理为[28 28 1]大小的灰度图像

% 你可以使用MATLAB提供的内置函数加载MNIST数据集

[XTrain, YTrain] = digitTrain4DArrayData;

[XValidation, YValidation] = digitTest4DArrayData;

% 转换标签格式

train_data = XTrain;

train_labels = YTrain;

val_data = XValidation;

val_labels = YValidation;

end

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

main.m

% main.m % 加载数据 [train_data, train_labels, val_data, val_labels] = load_dataset(); % 设置GWO参数 max_iter = 20; n_wolves = 10; % 运行GWO优化 best_params = gwo_optimize_cnn(train_data, train_labels, val_data, val_labels, max_iter, n_wolves); % 显示最佳参数 disp('最佳参数:'); disp(['学习率: ', num2str(best_params(1))]); disp(['卷积层数: ', num2str(round(best_params(2)))]);

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

在命令行窗口使用cd命令进入刚创建的文件夹,然后执行 run(‘main.m’)

说明

GWO核心算法:通过不断迭代更新狼群的位置,模拟灰狼围捕猎物的行为,最终找到最优解。

CNN架构定义与训练:根据GWO优化的参数(如学习率、卷积层数、全连接层数),定义CNN的架构并进行训练。

适应度计算:在每次迭代中,通过计算验证集上的准确率,评估当前参数的优劣,并更新狼群位置。

效果