热门标签

热门文章

- 1学习 Rust 的第一天:基础知识

- 2分辨率、帧率和码率三者之间的关系_码率和分辨率的关系

- 3Linux平台利用Ollama和Open WebUI部署大模型_open webui 如何添加模型

- 4当vue项目运行时,控制台出现“WebSocketClient.js:13 WebSocket connection to ‘ws://10.10.244.95:8080/ws‘ failed: E”_websocketclient.js:13 websocket connection to 'ws:

- 5基础笔记(三):网络协议之Tcp、Http

- 6idea中使用git合并分支_idea合并分支

- 7神经网络与深度学习(邱锡鹏)-学习笔记_深度学习是指一类模型吗

- 8github上想要下载单个文件 方法_git lfs 下载单个文件

- 9【Pycharm中python调用另一个文件类或者函数】_pycharm怎么引用其他py文件

- 10【前端素材】推荐优质在线茶叶电商Tea House平台模板(附源码)

当前位置: article > 正文

无GPU搭建开源大模型--LLAMA2_开源 大模型 图像识别 c++ 不需要gpu

作者:AllinToyou | 2024-04-25 22:06:53

赞

踩

开源 大模型 图像识别 c++ 不需要gpu

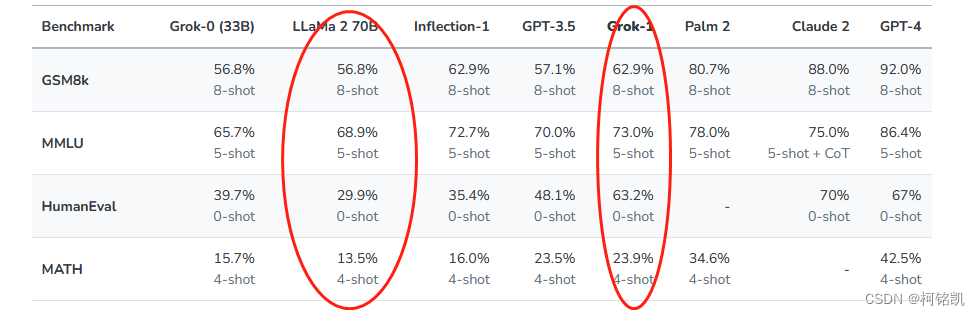

在Grok之前,脸书就开源了LLAMA2的大模型,从第三方数据来看Grok各方面都碾压LLAMA2

但如果是初学AI,llama无疑还是一个很好的突破口,在Grok没有到来之前,就让我们先向LLAMA2开刀。

本次介绍如何在无需GPU参与的情况下,在本地部署llama2,方法来自国外大神:Georgi Gerganov、让我们向大神致敬,向开源致敬,开源万岁。

我们可以通过使用Github上的llama.cpp模块来使用LLAMA。

llama.cpp除了LLAMA2外还支持Alpaca、chiness-llama、WizardLM等模型,而且支持Python、Go、Node.js等语言的接口。

本文使用的还是LLAMA2的模型,通过Python对其进行调用。

首先我们要提前下载一些必须的软件,用于我们搭建本地大模型:

1.visual studio,当前版本为2022;下载链接:https://visualstudio.microsoft.com/zh-hans/downloads/;电脑空间多的有多少勾多少就行,空间不够,可以自行评估,记得一定要勾选C++的桌面开发组件。

2.anaconda,用于搭建环境和安装llama_cpp的包;下载链接:https://www.anaconda.com/download/;直接无脑下一步。

3.llama2轻量化模型,阉割版于LLAMA2 70B不是一个概念,玩玩就好;下载链接

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/AllinToyou/article/detail/487464

推荐阅读

相关标签