- 1Databend 开源周报 第 79 期_周报 what's new

- 2芯片程序编写用什么工具?_芯片编程软件

- 3一位硕士毕业生三个月求职经历与经验结晶【转帖】_这家公司的面经详见本版2448贴

- 4大模型笔记之-Qwen1.5-72B-chat | 4卡A800 推理_qwen1.5-72b-chat-gptq-int4

- 5【解决】如何在远程Jupyterlab环境中使用Gradio时自定义分享链接地址,通过本地浏览器访问结果的web页面_gradio得到公共网址

- 6Leetcode1319. 连通网络的操作次数(medium,BFS,DFS)_leetcode 1319. 连通网络的操作次数

- 7hive篇-----【Hive基础】_hive in 和like

- 8苹果电脑(Mac)怎么清理 itunes 备份?

- 9前端(五)——从 Vue.js 到 UniApp:开启一次全新的跨平台开发之旅_vue uniapp

- 10(给自己挖坑中)一些还比较有趣的AIGC开源项目和部署教程

提高大型语言模型 (LLM) 性能的四种数据清理技术_llm数据清洗

赞

踩

原文地址:four-data-cleaning-techniques-to-improve-large-language-model-llm-performance

2024 年 4 月 2 日

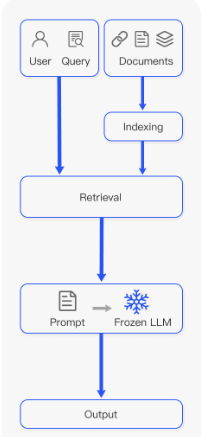

检索增强生成(RAG)过程因其增强对大语言模型(LLM)的理解、为它们提供上下文并帮助防止幻觉的潜力而受到欢迎。 RAG 过程涉及几个步骤,从分块摄取文档到提取上下文,再到用该上下文提示 LLM 模型。虽然 RAG 可以显着改善预测,但有时也会导致错误的结果。摄取文档的方式在此过程中起着至关重要的作用。例如,如果我们的“上下文文档”包含LLM的拼写错误或不寻常的字符(例如表情符号),则可能会混淆LLM对所提供上下文的理解。

在这篇文章中,我们将演示如何使用四种常见的自然语言处理 (NLP)技术来清理文本,然后再将文本摄取并转换为块以供LLM进一步处理。我们还将说明这些技术如何显着增强模型对提示的响应。

RAG 过程的步骤改编自RAG-Survey。

为什么清理文档很重要?

在将文本输入任何类型的机器学习算法之前清理文本是标准做法。无论您使用的是监督算法还是无监督算法,甚至是为生成 AI (GAI) 模型构建上下文,使文本保持良好状态都有助于:

确保准确性:通过消除错误并使一切保持一致,您就不太可能混淆模型或最终出现模型幻觉。

提高质量:更清晰的数据确保模型能够使用可靠且一致的信息,帮助我们的模型从准确的数据中进行推断。

促进分析:干净的数据易于解释和分析。例如,使用纯文本训练的模型可能难以理解表格数据。

通过清理我们的数据(尤其是非结构化数据),我们为模型提供了可靠且相关的上下文,从而改进了生成,降低了幻觉的可能性,并提高了 GAI 速度和性能,因为大量信息会导致更长的等待时间。

如何实现数据清洗?

为了帮助您构建数据清理工具箱,我们将探讨四种 NLP 技术以及它们如何帮助模型。

步骤1:数据清洗和降噪

我们将首先删除不提供含义的符号或字符,例如 HTML 标签(在抓取的情况下)、XML 解析、JSON、表情符号和主题标签。不必要的字符通常会混淆模型,并增加上下文标记的数量,从而增加计算成本。

认识到没有一刀切的解决方案,我们将使用常见的清理技术来调整我们的方法以适应不同的问题和文本类型:

标记化:将文本分割成单独的单词或标记。

消除噪音:消除不需要的符号、表情符号、主题标签和 Unicode 字符。

规范化:将文本转换为小写以保持一致性。

删除停用词:丢弃不会增加含义的常见或重复的单词,例如“a”、“in”、“of”和“the”。

词形还原或词干提取:将单词简化为其基本形式或词根形式。

我们以这条推文为例:

“I love coding!

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。