热门标签

热门文章

- 1@程序员 千万不能错过!这项政策让你有每年多赚20万的能力!

- 2java报错状态码_java 错误码规范

- 3建立SFTP服务器

- 4博客改版,迎接新的一年!

- 5【AI大模型应用开发】【LangChain系列】实战案例2:通过URL加载网页内容 - LangChain对爬虫功能的封装_langchain 爬虫

- 6在Docker中安装RabbitMQ_docker里面安装rabbitmq

- 7MobileNet实战:tensorflow2(1),2024年最新跳槽 面试

- 8华为OD机试C、D卷 - 最多购买宝石数目(Java & JS & Python & C & C++)_attributeerror: 'str' object has no attribute 'dec

- 9REACT实战项目从0到1搭建(仅供参考)_react项目搭建

- 10凸多边形的最优三角划分最详细求解步骤演示[动态规划]_凸多边形三角化 最优解

当前位置: article > 正文

[nlp] Word2vec模型 skip-gram和CBOW区别_word2vec 比较skipgram和cbow

作者:AllinToyou | 2024-06-05 15:49:16

赞

踩

word2vec 比较skipgram和cbow

Word2Vec是将 单词转换为向量 的算法,该算法使得具有相似含义的单词表示为相互靠近的向量。

Word2Vec分为 Skip-Gram 和 CBOW 两种模型。Skip-Gram是中心词来预测上下文,CBOW是上下文来预测中心词。

其中Skip-Gram 建模不是目的,第一个hidden_layer的权重矩阵W,才是我们要求的词嵌入。用周围词来反向传播训练得到中心词的词嵌入。

CBOW可以看作Skip-Gram反过来。

关于Word2vec

word2vec是Google与2013年开源推出的一个用于获取word vecter的工具包,利用神经网络为单词寻找一个连续向量看空间中的表示。word2vec是将单词转换为向量的算法,该算法使得具有相似含义的单词表示为相互靠近的向量。

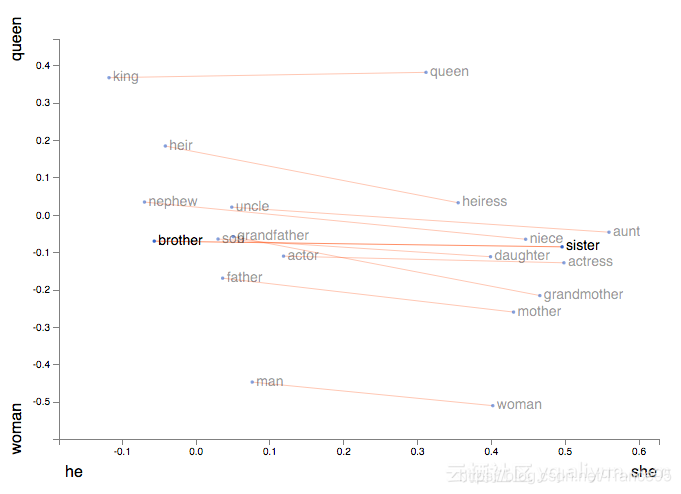

此外,它能让我们使用向量算法来处理类别,例如着名等式King−Man+Woman=Queen。

区别

word2vec一般分为CBOW</

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/AllinToyou/article/detail/677127

推荐阅读

相关标签