热门标签

热门文章

- 1一个简易的QQ魔法卡片炼卡消耗计算器_魔法卡片计算器

- 2黑马redis学习笔记_黑马redis原理篇笔记

- 3万亿国债消防救援——北斗应急通讯设备类目推荐

- 4【论文笔记】机器遗忘:错误标签方法_扰动标签的方法,该方法在每一次迭代过程中,将部分标签随机替换为错误标签

- 5jquery实现app开发闹钟功能_智能闹钟APP方案开发, 自己设定有趣铃声, 舒适唤醒效果!...

- 6无缝迁移!数亿MySQL数据顺利迁移到MongoDB_mysql 转mongofb

- 7基于Python爬虫的豆瓣电影影评数据可视化分析_电影影评分析及可视化

- 8网易Java面试必问:月薪20k+的Java面试都问些什么_java面试20k

- 9回忆自己的大学四年得与失_大学的得与失

- 10【深度学习】资源:最全的 Pytorch 资源大全_pytorch pt模型大全

当前位置: article > 正文

解决idea运行Spark报错Failed to locate the winutils binary in the hadoop binary path_error shell: failed to locate the winutils binary

作者:AllinToyou | 2024-06-07 16:14:16

赞

踩

error shell: failed to locate the winutils binary in the hadoop binary path

1. 报错原因:运行Spark时需要Hadoop的环境支持。

2. 解决方法:在windows上配置hadoop环境然后重启idea即可解决。

3. 解决步骤:

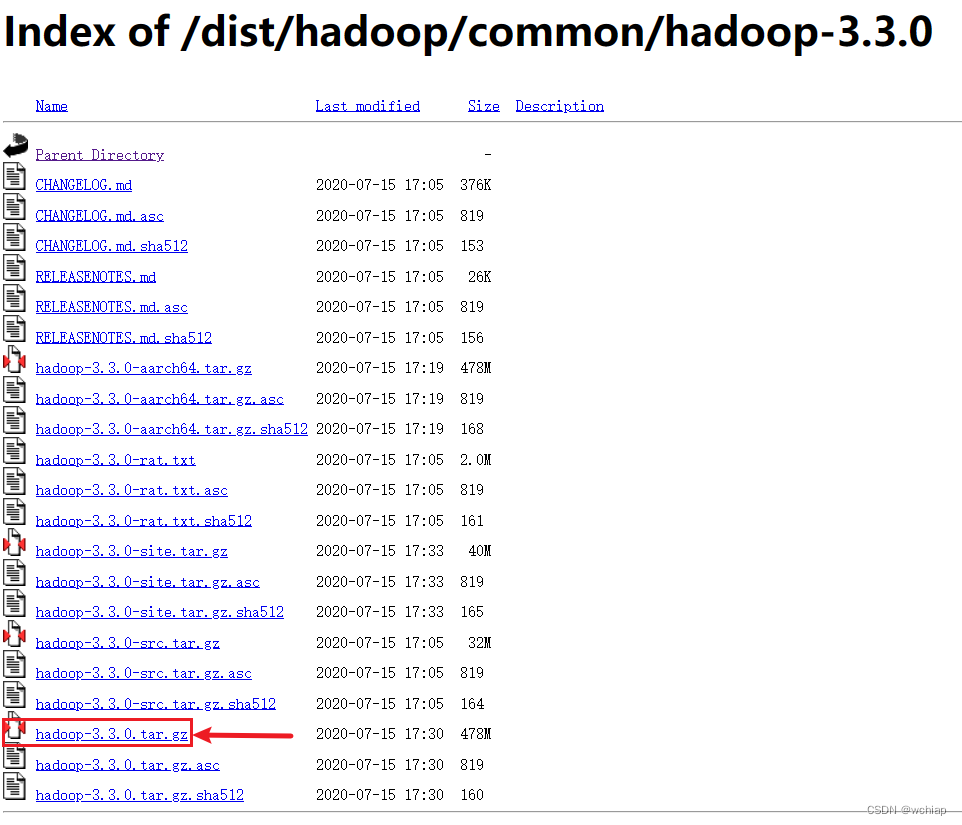

3.1 在官网上下载所需要的Hadoop的版本,然后解压到任意盘符下,路径不能有中文或者空格,下载链接:Index of /dist/hadoop/common/hadoop-3.3.0 (apache.org)

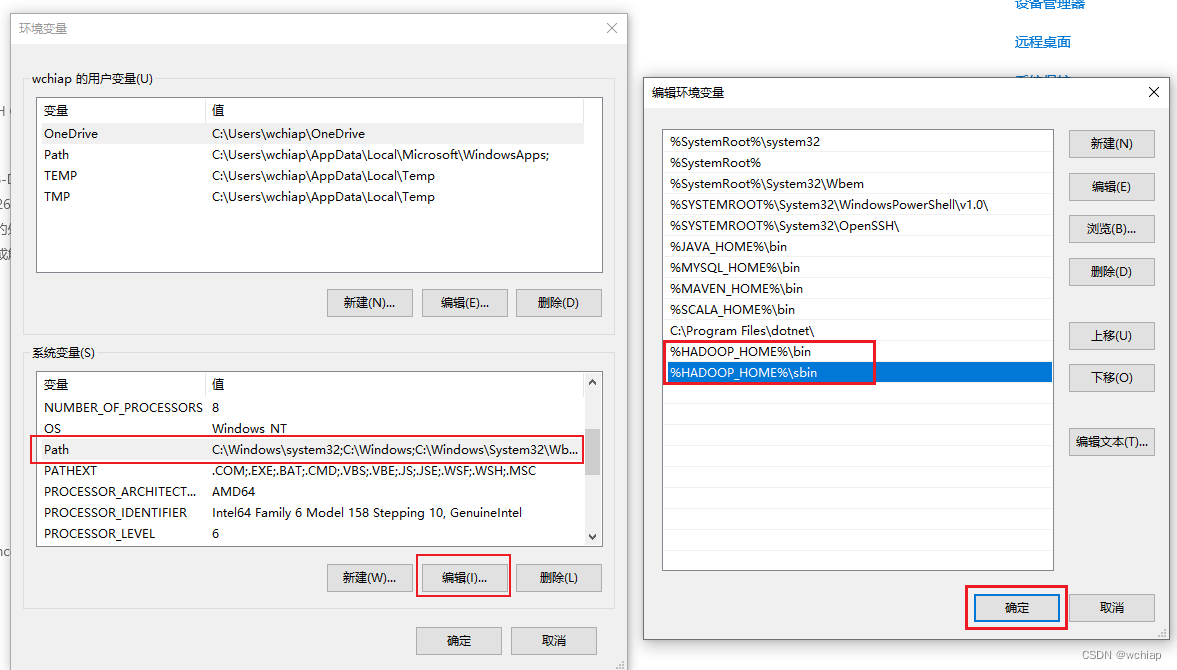

3.2 配置hadoop环境变量

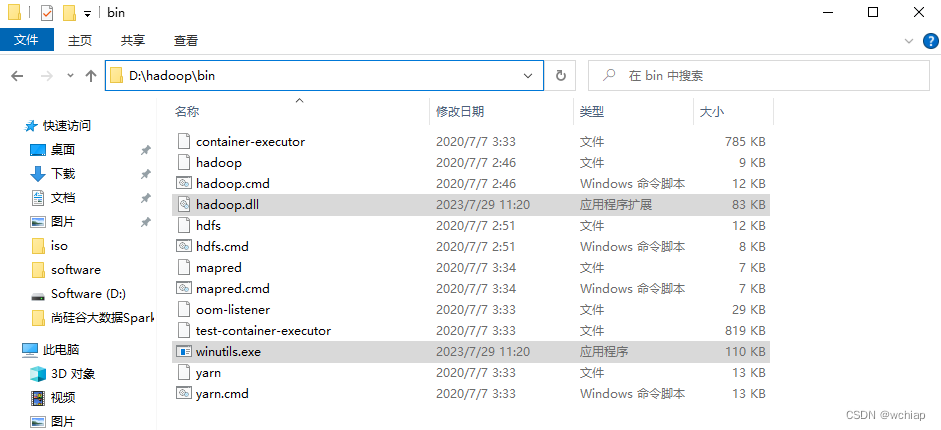

3.3 将 hadoop.dll 和 winutils.exe 两个文件弄到bin目录下

对应文件请链接自取,找自己所对应的版本号,我的是版本是3.3.0,我用的是3.3.5版本的也可以,自行类比。

https://gitee.com/systemwjp/dll-and-exe-file.git

3.4 cmd查看hadoop版本

hadoop version

3.5 重启idea重新运行即可

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/AllinToyou/article/detail/686106

推荐阅读

相关标签