- 1SLAM和里程计评估工具——evo使用方法全解_evo_traj

- 2学习笔记(4)——BP神经网络原理_bp神经网络训练时是一个接一个还是一个

- 3二分查找:万能模板及详细例题_二分查找案例

- 4iOS开发 ipa包的重签名_ipa签名能覆盖吗

- 5Python 文本特征提取_python文本特征提取

- 6WordPress用代码实现弹窗广告功能_wordpress 网页3秒弹窗代码

- 7小程序微信登陆实现流程_小程序微信登录

- 8数字三角形问题-简短_数字三角形,n行(n<=10)输出1 23 456

- 9qstring比较两个字符串完全相等_比较:equal和==

- 10学习Hi3516EV200的第一天——安装环境_[ 251.324871] udc-core: couldn't find an available

gram矩阵_MIT 18.065—机器学习中的矩阵方法02 矩阵乘法与矩阵分解

赞

踩

数据分析、信号处理和机器学习中的矩阵方法

第02讲 矩阵乘法与矩阵分解

新MIT 线性代数|机器学习(中英机翻字幕)18.065 by Gilbert Strang_哔哩哔哩 (゜-゜)つロ 干杯~-bilibiliwww.bilibili.com

18.065是线性代数和数学问题的混合。在这第一至两个星期中会回顾线性代数的亮点。

前面讨论了使用列乘行的矩阵相乘的方法。现在通过矩阵的五个关键分解来说明这一点。其中一些分解法(例如LU或QR)是线性代数中使用最广泛的MATLAB命令。

矩阵的LU分解与消元有关,是求解线性方程组的基本方法。LU代表下三角阵乘以上三角阵。

QR分解得到矩阵Q是正交矩阵,列向量是标准正交的,其产生过程与Gram-Schmidt正交化有关。

S代表对称,这是对称矩阵的特殊分解,Λ是对角特征值矩阵,这里的Q矩阵具有特征向量。记住两个事实-一个关于特征值的事实,另一个关于特征向量的事实。特征向量是正交的。对称矩阵有n个实数的特征值,矩阵可以对角线化。

S=QΛQT=

用矩阵QΛQT分解来讨论一下矩阵乘法。将矩阵分解视为两个矩阵相乘(QΛ)QT。两个矩阵相乘的一种规则是,QΛ的一个列向量乘以Q转置的一个行向量得出一个矩阵,然后将这些矩阵相加。这是一个特殊的秩一矩阵,矩阵所有的列都是该列向量的倍数,所有行都是那个行向量的倍数。例:

这是一种不错的矩阵分解,称为谱定理。我们将对称矩阵S分为一些秩一矩阵的和。

验证一下:

注意第五个分解,其中矩阵U是正交矩阵,V也是。所以是正交矩阵乘以对角阵乘以正交矩阵,它叫做SVD-奇异值分解,适用于长方形矩阵。前面的有些分解取决于是否有足够的特征向量,并非每个矩阵都有足够的特征向量来完成这项工作,而SVD可以为每个矩阵工作。它有两个矩阵,而不是一组向量,它有两个不同的奇异向量集。

关于LU分解插几句,LU分解与消元有关,是求解线性方程组Ax=b的基本方法。高斯消元所做的所有行操作都用L乘以U来完美表示,这是18.06中的关键点,如果矩阵可逆的,则消元的过程一切顺利,并且主元不为零。

可参考18.06第二课三少爷的贱男春:MIT—线性代数笔记02 矩阵消元zhuanlan.zhihu.com

例:

将矩阵分解为秩一矩阵之和,则有

第一行和第一列保持原矩阵的行与列向量,然后将它扩展成为第一个秩一矩阵

对于高阶矩阵,就是先通过第一行第一列构造第一个秩一矩阵矩阵,注意除以主元,剥离后剩下

本课程中我们会有很多关于QR、对称矩阵和SVD分解的讨论。

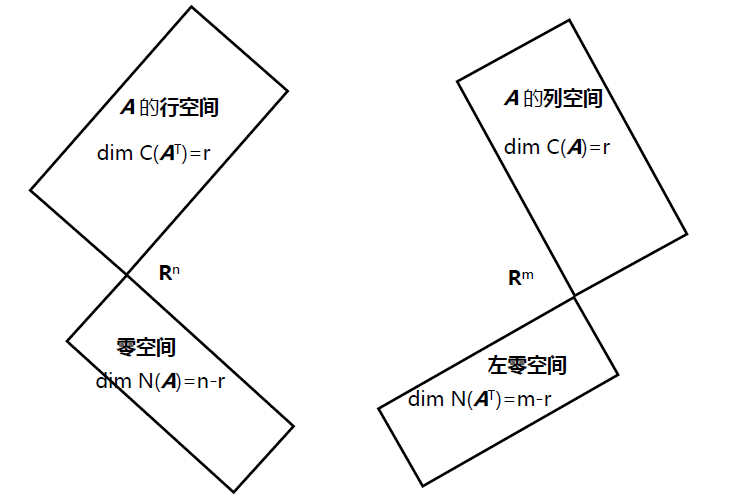

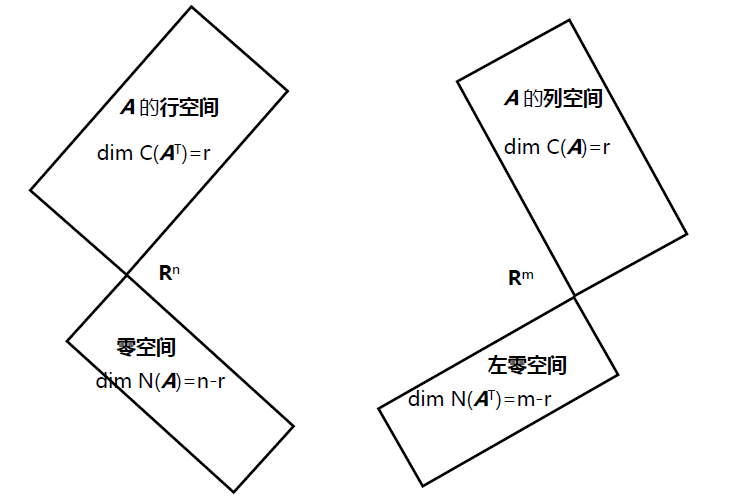

下面讨论线性代数的基本定理,本主题的基本思想。我发明了名称“四个基本子空间”。任意的m x n矩阵A(秩为r)定义了四个子空间。

可以参考课程:三少爷的贱男春:MIT—线性代数笔记10 四个基本子空间zhuanlan.zhihu.com

列空间 Column space C(A)

矩阵A的列空间是A的列向量的线性组合在Rm空间中构成的子空间,空间维度为r。

行空间Row space C(AT)

矩阵A的行空间是A的行向量的线性组合在Rn空间中构成的子空间,也就是矩阵AT的列空间,空间维度为r。

零空间Nullspace N(A)

矩阵A的零空间是Ax=0的所有解x在Rn空间中构成的子空间。向量x和y都在矩阵的零空间中,则有A(x+y)=0,A(cx)=0。在矩阵A的方程中,只有r个是真正线性无关的方程,它们能约束解向量里的r个元素,而未加约束的元素为n-r个,因此零空间维度为n-r。

左零空间Left nullspace N(AT)

我们称矩阵AT的零空间为矩阵A的左零空间,它是Rm空间中的子空间,左零空间维度为m-r。

例:

可知m=2,n=3,r=1。因此n-r=2,零空间中可找到两个满足Ax=0的线性无关的解,例如

这就是线性代数基本定理的图像,除了空间维度,还有子空间之间的相互关联。