- 1mysql与sim900a_sim900a和sim800a的区别是什么

- 2Jemter篇之Jemter环境变量配置(满满干货)_如何设置下jittorllm的环境变量

- 3在Visual Studio中使用GitHub扩展插件【1】——安装插件&新建仓库_github extension for

- 4人工智能之深度学习常见应用方向你都了解吗?(文末福利)_深度学习方向

- 5【人工智能 Open AI】通用 API 开放平台的系统架构设计_ai开放架构

- 62023-2024年信息管理专业毕设题目推荐汇总_信管专业毕业设计选题

- 7word2vec-词向量模型_代码实现word2vec词向量模型

- 8图像篡改检测初学笔记_双流图像篡改检测

- 9CURE算法和Matlab实现_cure向中心收缩

- 10Pytorch实现中文文本分类任务(Bert,ERNIE,TextCNN,TextRNN,FastText,TextRCNN,BiLSTM_Attention, DPCNN, Transformer)_dpcnn模型pytorch实现

windows10搭建llama大模型

赞

踩

背景

随着人工时代的到来及日渐成熟,大模型已慢慢普及,可以为开发与生活提供一定的帮助及提升工作及生产效率。所以在新的时代对于开发者来说需要主动拥抱变化,主动成长。

LLAMA介绍

llama全称:Large Language Model Meta AI是由meta(原facebook)开源的一个聊天对话大模型。根据参数规模,Meta提供了70亿、130亿、330亿和650亿四种不同参数规模的LLaMA模型,并使用20种语言进行了训练。与现有最佳的大型语言模型相比,LLaMA模型在性能上具有竞争力。

官网:https://github.com/facebookresearch/llama

注意:本文是llama不是llama2,原理一致!

硬件要求

硬件名称 | 要求 | 备注 |

磁盘 | 单盘最少120g以上 | 模型很大的 |

| 内存 | 最少16g | 最好32g |

| gpu | 可以没有 | 当然最好有(要英伟达的) |

安装软件

涉及软件版本

软件名称 | 版本 | 备注 |

anaconda3 | conda 22.9.0 | https://www.anaconda.com/ |

python | 3.9.16 | anaconda自带 |

peft | 0.2.0 | 参数有效微调 |

sentencepiece | 0.1.97 | 分词算法 |

transformers | 4.29.2 | 下载有点久 |

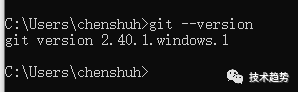

git | 2.40.1 | |

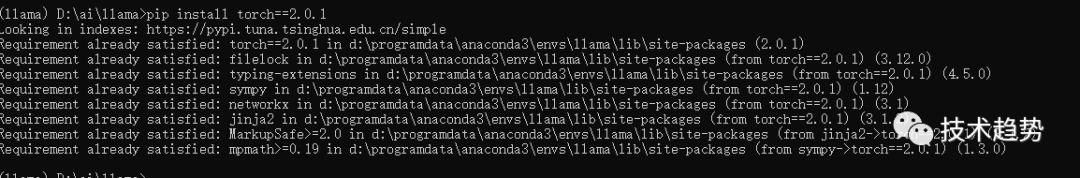

torch | 2.0.1 | |

mingw | 用window安装 | |

protobuf | 3.19.0 | |

cuda | https://blog.csdn.net/zcs2632008/article/details/127025294 | 有gpu才需要安装 |

anaconda3安装

安装这个anaconda建议不要在c盘,除非你的c盘够大。

请参考:https://blog.csdn.net/scorn_/article/details/106591160?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522168601805516800197073452%2522%252C%2522scm%2522%253A%252220140713.130102334..%2522%257D&request_id=168601805516800197073452&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~all~sobaiduend~default-1-106591160-null-null.142^v88^control,239^v2^insert_chatgpt&utm_term=windows10%E5%AE%89%E8%A3%85anaconda3%E6%95%99%E7%A8%8B&spm=1018.2226.3001.4187

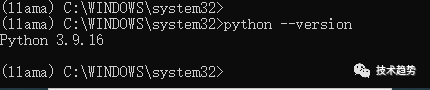

创建环境

- conda create -n llama python=3.9.16

- conda init

进入环境

- conda info -e

- conda activate llama

后面验证python

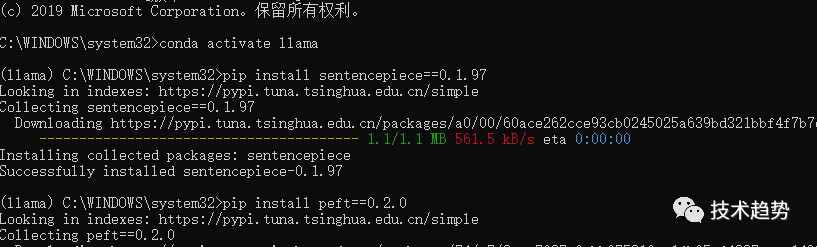

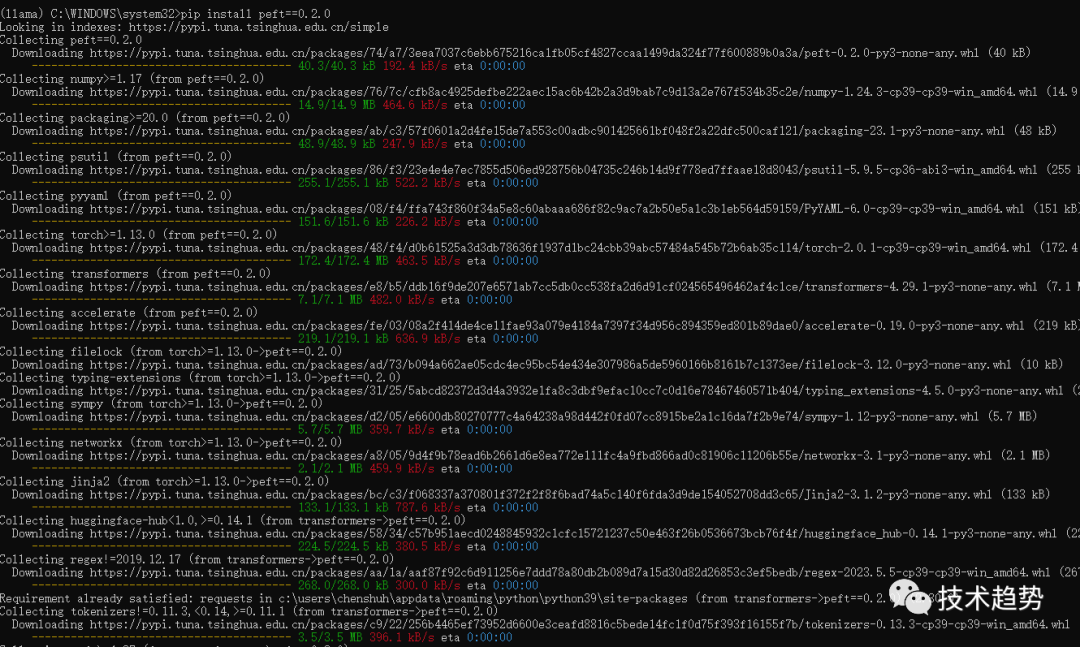

peft安装

pip install peft==0.2.0

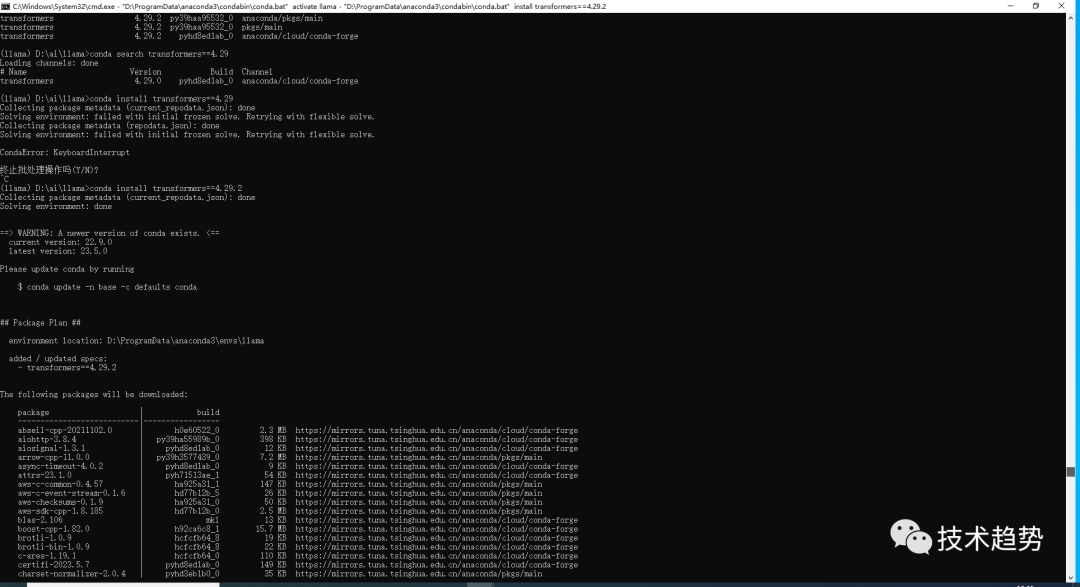

transformers安装

注意:这个会很大~有点久~

conda install transformers==4.29.2

安装git

https://blog.csdn.net/dou3516/article/details/121740303

安装torch

pip install torch==2.0.1

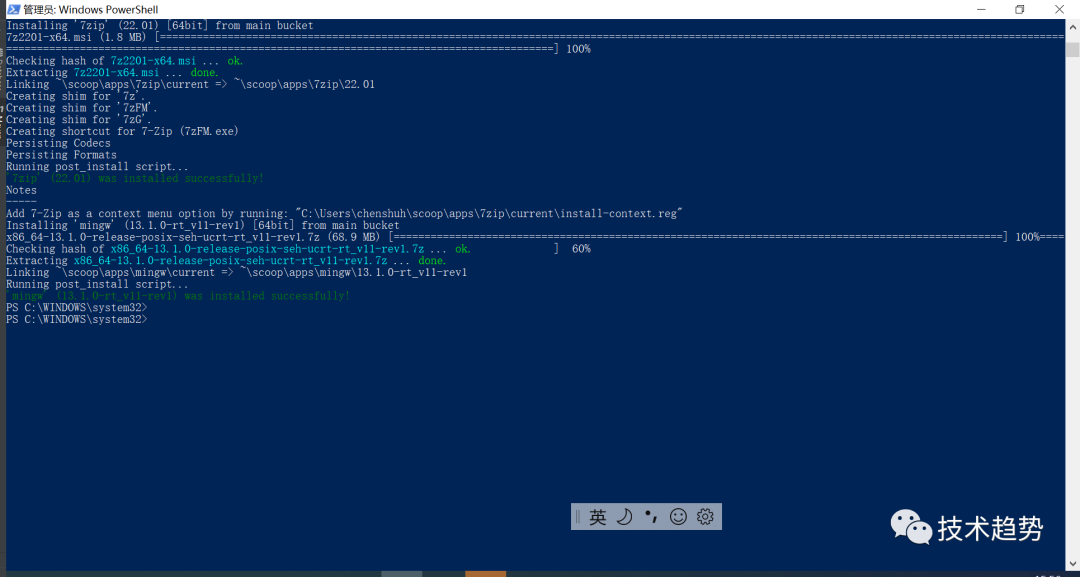

安装mingw

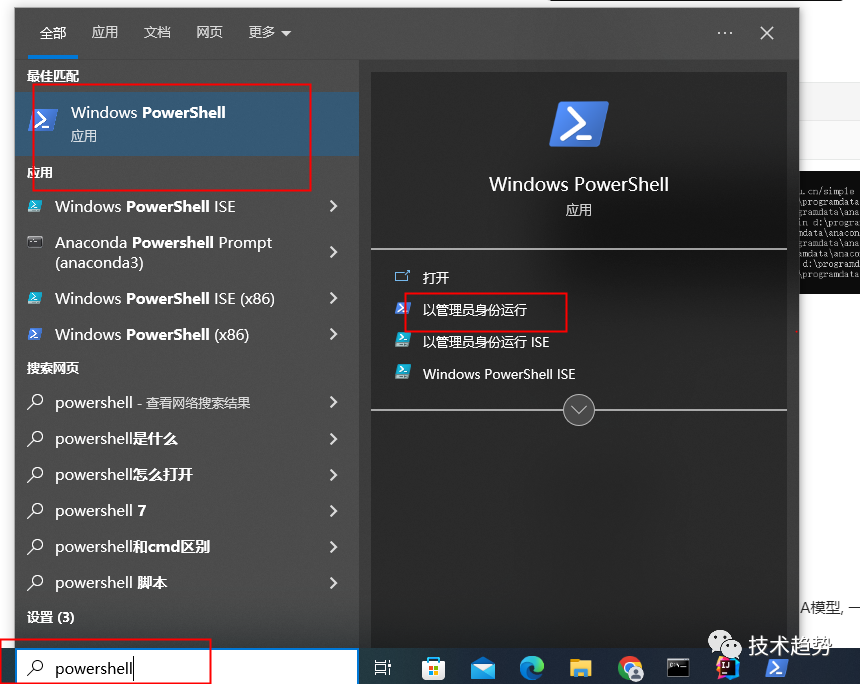

win+r输入powershell

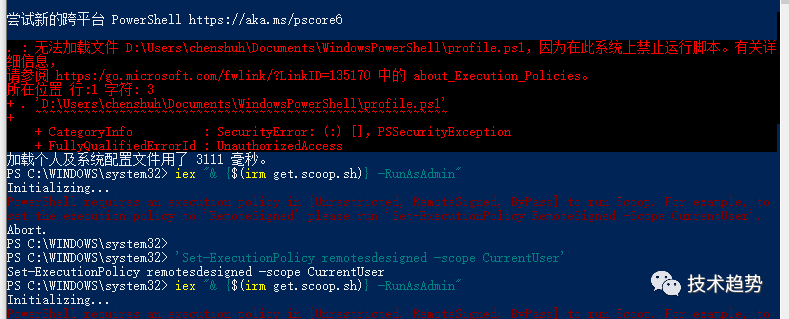

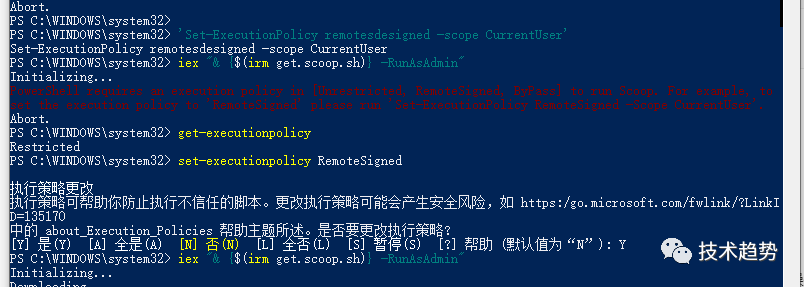

遇到禁止执行脚本问题:(如果没有异常请跳出这步)

参考

https://blog.csdn.net/weixin_43999496/article/details/115871373

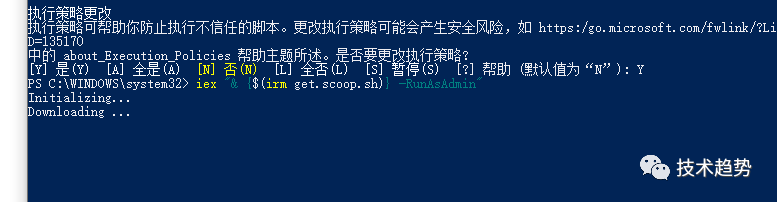

配置权限

- get-executionpolicy

- set-executionpolicy RemoteSigned

然后输入Y

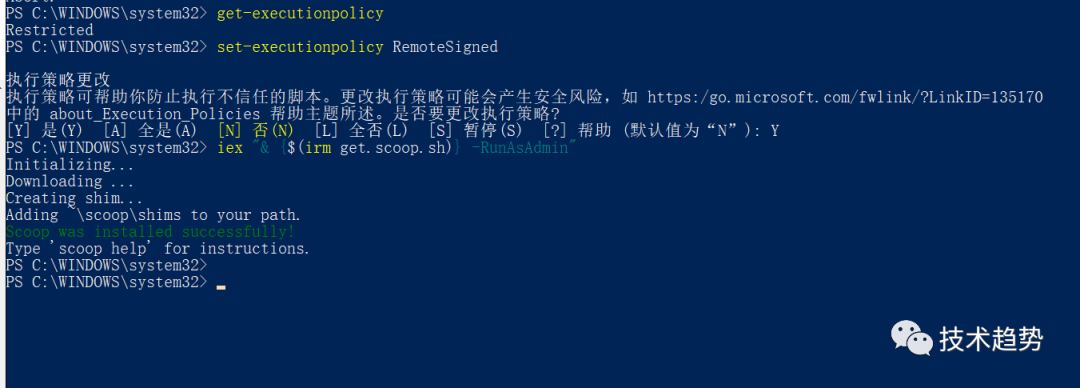

安装 mingw

iex "& {$(irm get.scoop.sh)} -RunAsAdmin"

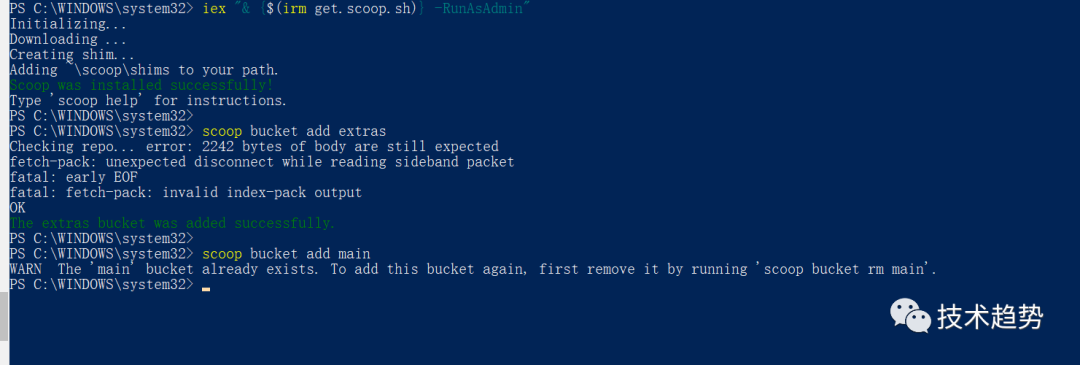

安装好后分别运行下面两个命令(添加库):

scoop bucket add extrasscoop bucket add main

输入命令安装mingw

scoop install mingw

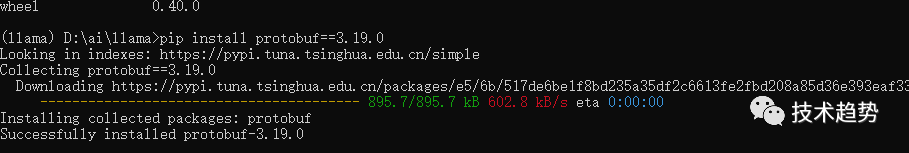

安装:protobuf

pip install protobuf==3.19.0

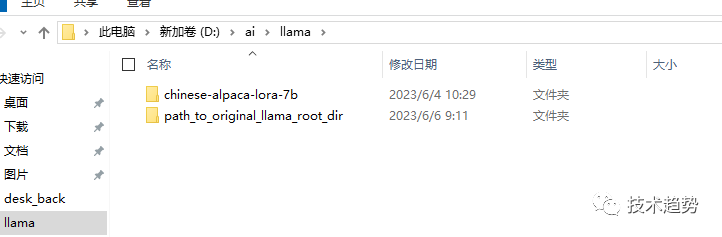

项目配置

下载代码

需要下载两个模型, 一个是原版的LLaMA模型, 一个是扩充了中文的模型, 后续会进行一个合并模型的操作

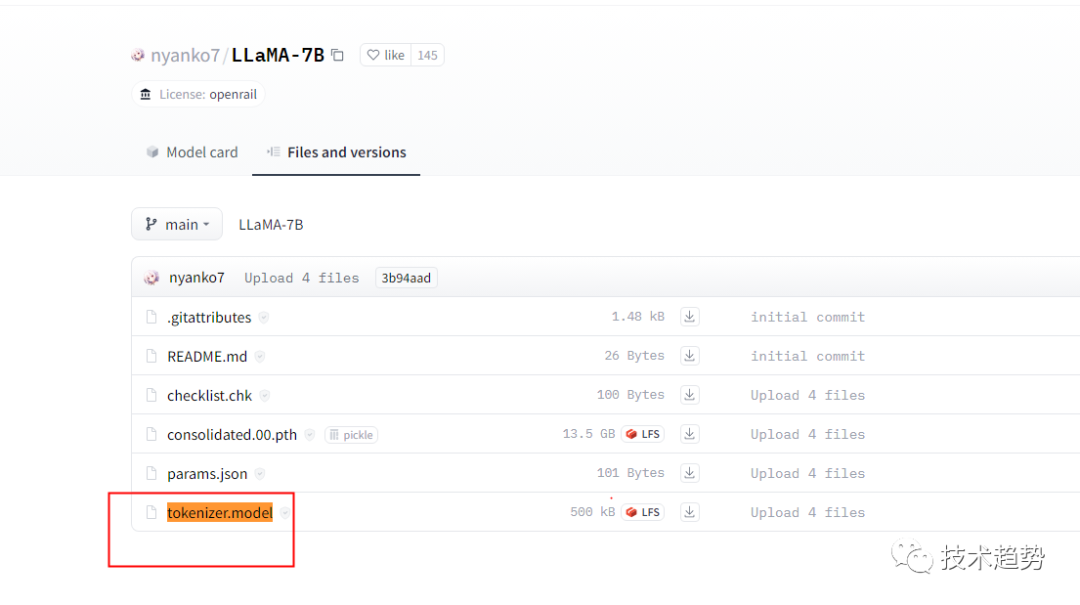

原版模型下载地址(要代理):https://ipfs.io/ipfs/Qmb9y5GCkTG7ZzbBWMu2BXwMkzyCKcUjtEKPpgdZ7GEFKm/

备用:nyanko7/LLaMA-7B at main

下载不了的话,请关注【技术趋势】回复llama1获取。

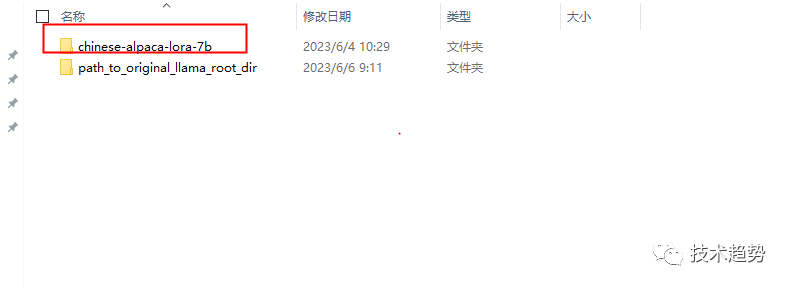

创建文件夹

git lfs install下载中文模型

git clone https://huggingface.co/ziqingyang/chinese-alpaca-lora-7b

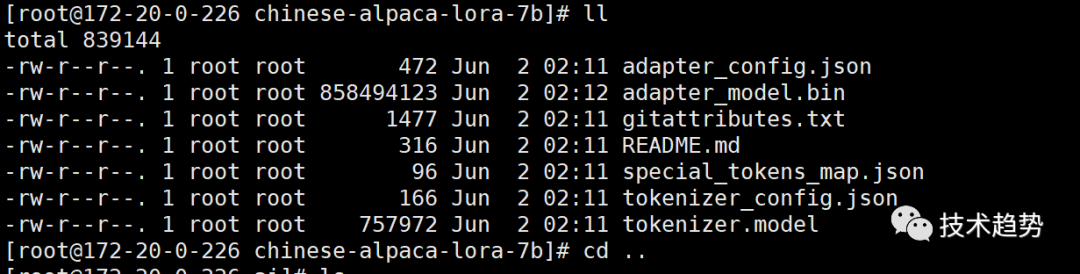

补充Linux图:

下载羊驼模型(有点大)

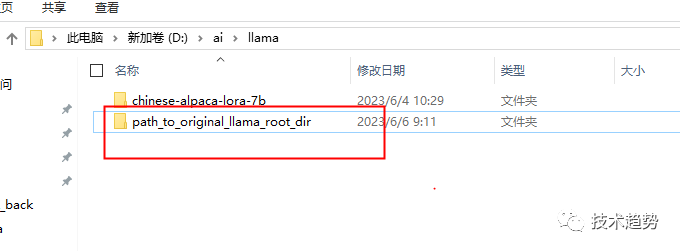

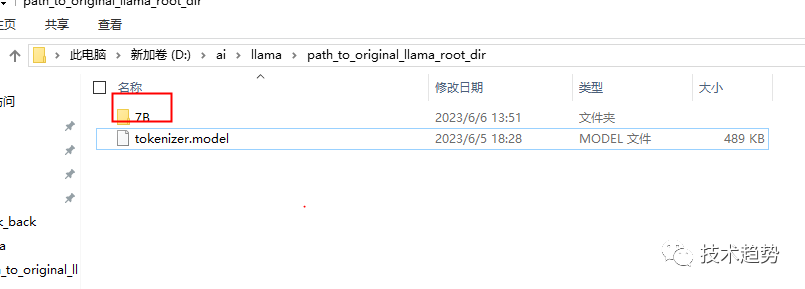

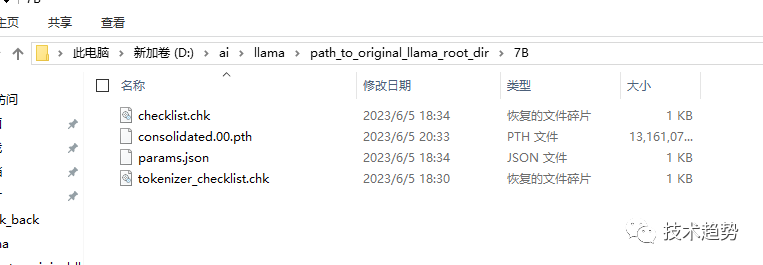

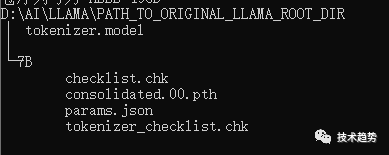

先建一个文件夹:path_to_original_llama_root_dir

在里面再建一个7B文件夹并把tokenizer.model挪进来。

7B里面放的内容

最终需要的内容如下:

合并模型

下载:convert_llama_weights_to_hf.py

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。