- 1redis的基础底层篇 zset的详解_redis zset

- 2离线数仓数据导出-hive数据同步到mysql

- 3VR全景在线虚拟展厅实现全方位沉浸式互动体验_vr在线体验瑟瑟

- 4怎么自学python自动化测试-Python移动自动化测试面试 学习 教程

- 5vscode的launch.json是什么_vscode launch.json

- 6Git error: cannot lock ref_error: cannot lock ref 'refs/heads/main': is at

- 7MySql重点复习——删除表的方式_mysql删除表

- 8YOLOv9改进策略 | 损失函数篇 | 利用真实边界框损失之MPDIoU助力YOLOv9精度更上一层楼_pred_bboxes_pos = torch.masked_select

- 9华为OD机试统一考试D卷C卷 - 查找接口成功率最优时间段(C++ Java JavaScript Python C语言)

- 10【Git】本地仓库关联远程仓库_git本地仓库关联远程

突发!马斯克3140亿参数Grok开源!Grok原理大公开!_马斯克开源grok 原理

赞

踩

BIG NEWS: 全球最大开源大模型!马斯克Grok-1参数量3410亿,正式开源!!!

说到做到,马斯克xAI的Grok,果然如期开源了!

就在刚刚,马斯克的AI创企xAI正式发布了此前备受期待大模型Grok-1,其参数量达到了3140亿,远超OpenAI GPT-3.5的1750亿。

PS:如果你要升级为GPT-4的话,可以参考这篇教程:ChatGPT Plus升级,直接用虚拟卡进行订阅升级也很简单方便。

这是迄今参数量最大的开源大语言模型,遵照Apache 2.0协议开放模型权重和架构。

Grok-1

目前,xAI关于Grok-1没有透露更多信息。

官网放出的信息如下——

- 基础模型在大量文本数据上训练,未针对任何特定任务进行微调。

- 314B参数的MoE,有25%的权重在给定token上处于激活状态。

- 2023年10月,xAI使用JAX和Rust之上的自定义训练堆栈从头开始训练。

- 截至到目前为止,,Grok在Github上就狂揽了6k星,620个Fork。

3140亿的参数,让Grok-1成为迄今参数量最大的开源LLM,是Llama 2的4倍。

全球首个最大模型开源

这次xAI开源Grok-1,遵守的是Apache-2.0许可证,因此,用户可以自由使用、修改和分发软件。

存储库包含了用于加载和运行Grok-1开源权重模型的JAX示例代码。

由于模型较大,参数达到了314B参数,因此需要具有足够GPU内存的计算机,才能使用示例代码测试模型。

一般人估计是很难在个人PC上运行起来。

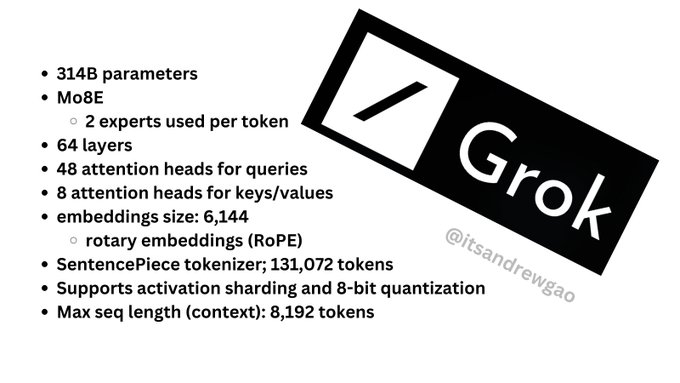

斯坦福研究者Andrew Kean Gao浏览了model.py介绍了更多Grok的架构信息,3140亿参数没有更多附加条款。

8个混合专家(2个活跃专家),860B活跃参数。它使用旋转嵌入,而不是固定位置嵌入。

-

tokenizer词汇量:131,072(于GPT-4类似)相当于2^17

-

嵌入大小:6144(48*128)

-

Transformer层:64(每一层都有一个解码层:多头注意块和密度块)

-

键值大小:128

最后大家可以直接看Andrew Kean Gao针对Grok-1的总结版图。

开源争霸

AI社区已经沸腾了!

连OpenAI的员工,都表示了自己对Grok的强烈兴趣。

PS:LFG:LFG 的意思是“Let’s Fxxking Go”,大致意思是“冲冲冲”,经常用来形容社区对某个事件非常兴奋。

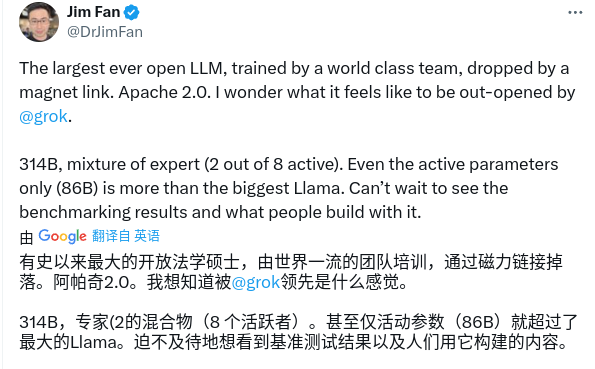

英伟达高级科学家Jim Fan表示,「有史以来最大的开源大模型,由世界级团队训练,通过磁力链Apache 2.0发布。

xAI表示,Grok的设计灵感来源于《银河系漫游指南》,它能够回答几乎所有问题,助力人类不分背景或政治立场地追求理解和知识。

Grok最初的版本Grok-0拥有330亿参数,紧接着xAI推出了经过数次改进的Grok-1,为X上的Grok聊天机器人提供支持。

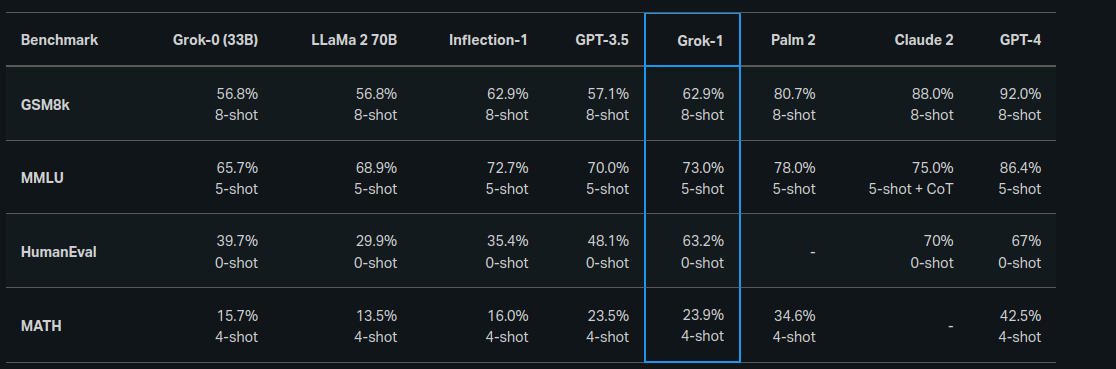

根据xAI公布的数据,在GSM8K、HumanEval和MMLU等一系列基准测试中,Grok-1的表现超过了Llama-2-70B和GPT-3.5,虽然跟GPT-4还差得远。

referer:https://x.ai/blog/grok

但此次xAI并没有放出Grok-1的具体测试成绩,其与OpenAI即将发布的GPT-5的大模型王者之战,必将成为业内关注的焦点。

总结

科技巨头之间AI之间的大规模竞争,争相发布各种最厉害最前沿的大语言模型,然后最终受益的却还是我们普通个人。就想前几年的手机竞争,厂商们都在制作各种旗舰机型,所以后面就有了越来越大的手机,屏幕越来越高清,摄像头的像素越来越大,手机摄像头也越来越多。

除了了解这些最前沿的科技之外,我们还可以思考如何更好地将这些技术应用在我们日常的工作和生活之中。