热门标签

热门文章

- 1新版本IDEA2023.2没有Git快捷图标_23版idea为什么配置git后没有git的快捷键方式

- 2ARM:2024/4/11

- 3【scrapy框架】scrapy框架自带图片下载的管道ImagePipeline_这是一个scrapy中的image pipeline,用于处理爬虫下载的图片。它继承自scrapy中

- 4历经70+场面试,我发现了大厂面试的bug,并总结其中心得_赛码网会检测屏幕共享吗

- 5Kafka常见错误及解决办法_为什么kafka导入软件包失败

- 6K近邻(KNN)算法(算法原理+简单的实现)_数据集make_forge模型用k邻近算法求精确度

- 7HarmonyOS Next,你真的足够了解它么?_harmonyos next 开发语言(2)_arkts与仓颉编程语言

- 8Log4j2的JNDI注入漏洞原理分析与思考_jndi 漏洞 无法下载文件

- 92024QS《亚洲大学前100强排名榜》(1-100)

- 10这是个超级好用的免费无损放大软件 Topaz Gigapixel AI

当前位置: article > 正文

用 Python 抓取 bilibili 弹幕并分析!_python爬取b站弹幕并进行数据分析

作者:Cpp五条 | 2024-04-23 01:37:22

赞

踩

python爬取b站弹幕并进行数据分析

01 实现思路

首先,利用哔哩哔哩的弹幕接口,把数据保存到本地。接着,对数据进行分词。最后,做了评论的可视化。

02 弹幕数据

平常我们在看视频时,弹幕是出现在视频上的。实际上在网页中,弹幕是被隐藏在源代码中,以XML的数据格式进行加载的。

比如:

https://comment.bilibili.com/123072475.xml

一个固定的url地址 + 视频的cid + .xml

只要找到你想要的视频cid,替换这个url就可以爬取所有弹幕了(b站大部分网页给出的字幕限制是1000条)。

一个视频的cid在哪里呢?

右键网页,打开网页源代码,搜索 "cid": 就能找到:

03 保存数据到本地

有了数据的接口链接,我们就可以利用request模块,获取数据了。

然后,再利用xpath简单的解析xml,就可以把所有的弹幕信息汇总到一个列表里了。最后,把列表转化成dataframe,保存到本地。

- # 许嵩新歌《雨幕》

- # bilibili视频弹幕文件

- url = 'https://comment.bilibili.com/123072475.xml'

-

- # 发送请求

- response = requests.get(url)

- xml = etree.fromstring(response.content)

-

- # 解析数据

- dm = xml.xpath("/i/d/text()")

- print(dm) # list

-

- # 把列表转换成 dataframe

- dm_df = pd.DataFrame(dm, columns=['弹幕内容'])

- print(dm_df)

-

- # 存到本地

- # 解决了中文乱码问题

- dm_df.to_csv('雨幕-弹幕.csv', encoding='utf_8_sig')

保存的csv数据:

![]()

04 对数据进行分词

制作词云前,需要把弹幕数据进行分词。

关于jieba分词,可以参考:

https://blog.csdn.net/dnxbjyj/article/details/72854460

- # jieba分词

- dm_str = " ".join(dm)

- words_list = jieba.lcut(dm_str) # 切分的是字符串,返回的是列表

- words_str = " ".join(words_list)

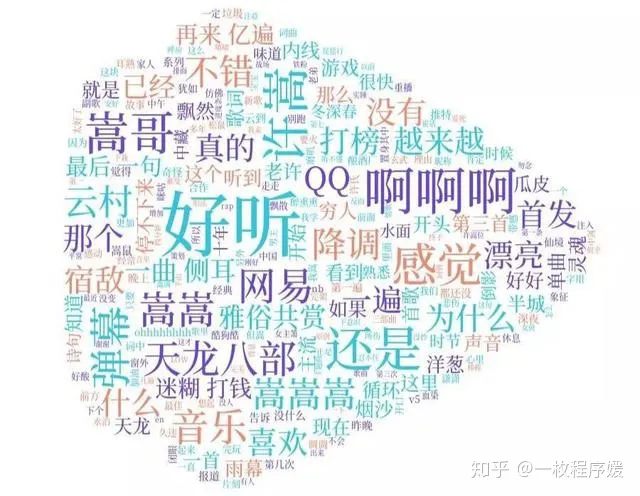

05 词云可视化

通过创建词云对象、设置词云参数,最终生成图片,保存到本地。

- # 读取本地文件

- backgroud_Image = plt.imread('1.jpg')

-

- # 创建词云

- wc = WordCloud(

- background_color='white',

- mask=backgroud_Image,

- font_path='./SourceHanSerifCN-Medium.otf', # 设置本地字体

-

- max_words=2000,

- max_font_size=100,

- min_font_size=10,

- color_func=random_color_func,

- random_state=50,

- )

-

- word_cloud = wc.generate(words_str) # 产生词云

- word_cloud.to_file("yumu.jpg") #保存图片

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Cpp五条/article/detail/471498

推荐阅读

相关标签