- 1【Java面试题】八、String str = “hello“ 和 String str = new String(“hello“) 一样吗?_string s="hello"; 与string s=new string("hello");有何

- 2麻烦不断!盘点苹果过去的一年惹上的“幺蛾子”

- 3从运维到运营,信息安全进化论_asa模型 自适应

- 4大型零售企业,适合什么样的企业邮箱大文件解决方案?

- 52022秋 C理论A_ 编程练习2 - 选择结构_7-3 输出英文字母的前驱和后继字母 分数 10 作者 李民 单位 武汉理工大学 从键盘

- 6PV、EV、AC、BAC、EAC、ETC等的含义及计算公式_bac ac

- 7元学习在元图神经网络中的应用

- 8Rust的Copy与Clone_rust clone copy

- 9【LLMs 入门实战 】第一式:Vicuna 模型学习与实战_vicuna模型

- 10CTFHub-sql注入_ctfhub sql注入

干货 | 2024 年 Elasticsearch 常见面试题集锦

赞

踩

当涉及到 Elasticsearch 开发者的面试时,问题通常会更专注于软件开发生命周期内与 Elasticsearch 集成的具体技术细节和实际应用场景。

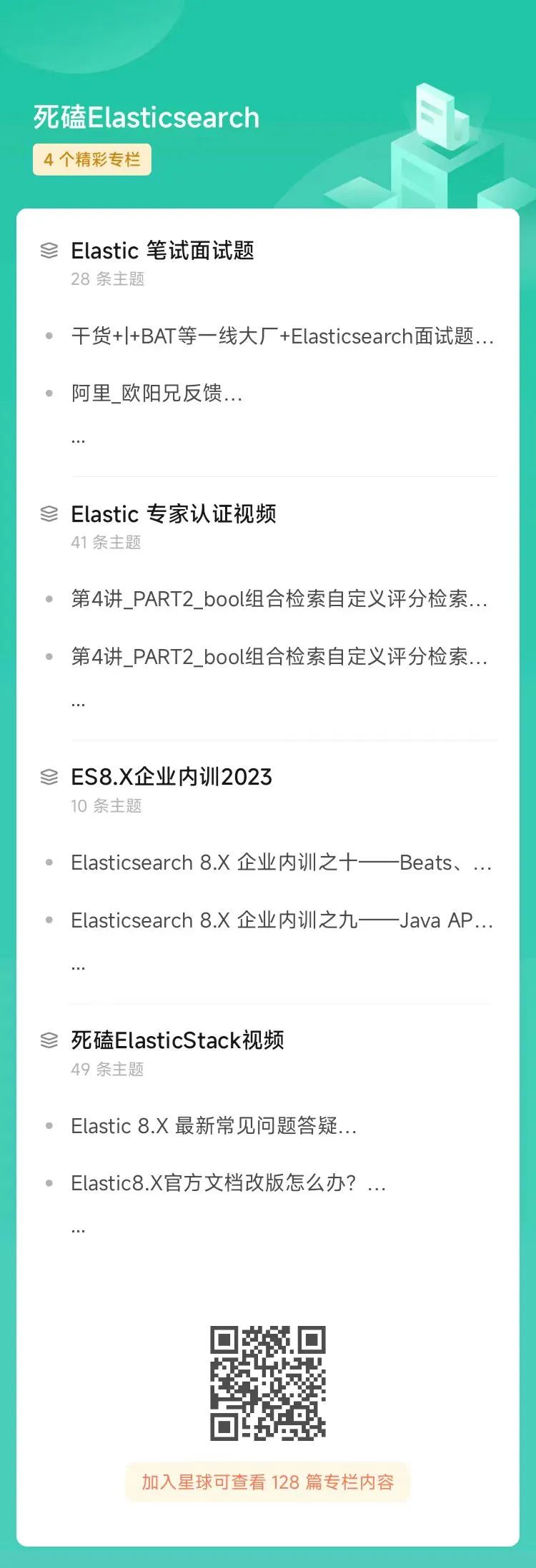

以下是一些Elasticsearch开发相关的面试题目,题目来自死磕 Elasticsearch 知识星球。

1、Elasticsearch数据建模相关问题

问题描述:

Q1:描述如何设计 Elasticsearch 索引以支持高效的全文搜索和聚合操作。

Q2:在数据建模过程中,你如何决定使用嵌套类型还是平面结构?

A1:

A2:关于嵌套结构、平面结构——实践表明:

如果能平面宽表存储,咱们就宽表,空间换时间的方式是非常有效的数据建模方式;

除非特殊情况,当子文档更新不频繁的场景,推荐使用 Nested 类型;

子文档更新频繁的场景,推荐使用:Join 类型。

2、Elasticsearch 查询和分析相关问题

描述你如何优化复杂的 Elasticsearch 查询,以提高性能。

如果需要对大数据集进行实时分析,你会采取哪些策略?

回答如下:

(1)硬件资源层面,要给到位。

能 SSD 磁盘的,咱们优先SSD磁盘。这样,写入、检索性能均比普通磁盘要好。

能内存高配的尽量高配,多高呢?推荐64GB,且堆内存设置32GB之内;如果更高配置,有待商榷和验证性能。

CPU核数决定并发支持力度,这个和“线程池队列调优”有关系,也不能太低。

尤其云服务器场景,受限于硬件资源的分配,别太低。云服务器也要考虑网络带宽,不能太低。

否则,即便所谓各种检索技巧,也无处可施。比如:买个1核1GB的云服务器学生机,神仙也帮不了优化。

(2)数据建模层面,做足文章。

不推荐上来就直接优化DSL,因为某些情况,优化空间非常少。

多考虑:字段层面是否最优化设置了?字段类型是否设置合理?

多考虑:有没有字段借助预处理 ingest pipeline再继续拆分会更好?

多考虑:所谓的多表关联,能不能不关联的宽表空间换时间实现呢?

(3)复杂检索考虑优化点

那些耗费性能的检索,有没有替代方案?

比如:wildcard 能否通过 ngram 分词修改检索方式?能不用,咱们尽量不用。

如果能用 filter 过滤提升缓存性能的,咱们是否用了?

“profile:true”,看看哪个环节出问题了,咱们有针对性的进行优化。

(4)其他因素

检索的时候,是否有大量的写入操作?看有没有优化空间。

是否采取必要的段合并的策略,以优化检索。

其他业务场景细节有针对的调优。

3、Elasticsearch 集成与开发问题

你如何在现有的 Web 应用程序中集成 Elasticsearch?

解释在微服务架构中如何利用 Elasticsearch 来提供搜索服务。

回答:

基本上说一下自己 Java 或者 Python层面集成 Elasticsearch 实践就可以。

咱们怎么做的,就怎么说就可以。

比如:使用的 Java 官方客户端 Java-api(8.x),还是早期的 HighLevelREST API, 更早起的 LowLevelREST API 等。或者使用的 SpringBoot 相关的 API。

干货 | Elasticsearch Java 客户端演进历史和选型指南

或者Python 框架下的 elasticsearch.py、elasticsearch-DSL等。

4、Elasticsearch DSL 相关应用选型等问题

Q1:你对 Elasticsearch Query DSL 有多熟悉?请给出一个你认为高效的查询例子。

Q2:使用 Elasticsearch DSL 编写一个可以处理模糊搜索和自动完成功能的查询。

回答:

这是两个大类问题。

A1——问题1:你对 Elasticsearch Query DSL有多熟悉?请给出一个你认为高效的查询例子。

回答:其实就说出 DSL 分类就可以:精确匹配查询(term、exists等)、全文检索(match、match_phrase 等)、Bool 组合检索(must、must_not、filter、should)等。

高效查询比如:基于 filter 的过滤缓存检索,性能比普通没有 filter 好很多,因为有效使用了缓存。

A2——问题2:编写一个可以处理模糊搜索和自动完成功能的查询。

回答:与面试官交流一下这里模糊查询的含义,比如:match_phrase 和 slop 结合可以实现,比如:wildcard 可以实现,但有性能问题,比如:regex 正则检索可以实现,也有性能问题。

自动完成功能,需要沟通是不是自动补全功能,这点 ES 支持 auto complete 类似的 API——completion-suggester。

Elasticsearch 8.X 有哪些自动补全的检索方式?

补充参见:

[1] https://www.elastic.co/guide/en/elasticsearch/reference/8.12/search-suggesters.html#completion-suggester

[2]https://docs.elastic.co/search-ui/solutions/ecommerce/autocomplete

[3]https://taranjeet.medium.com/elasticsearch-building-autocomplete-functionality-494fcf81a7cf

[4]https://opster.com/guides/elasticsearch/how-tos/elasticsearch-auto-complete-guide/

[5]https://taranjeet.medium.com/elasticsearch-using-completion-suggester-to-build-autocomplete-e9c120cf6d87

5、Elasticsearch 索引数据同步相关问题

Q1:描述如何保证数据库和 Elasticsearch 索引间的数据同步。

Q2:你是如何处理批量索引和更新大量文档的?

回答:

这也是两个问题。

对于问题1:保证同步——我用 logstash 多,主要基于时间戳和自增id实现同步。

这两种机制单纯自己实现方式都能有效保障同步。

如果出现同步异常,也可以通过两侧(源头、目的端)通过ID比对的方式进行排查和核实。

对于问题2:

批量索引——就是基于 bulk API 批量导入或者写入数据。

这里要注意的点就是:bulk 值不适宜上来调整的非常大,比如:上来就10万、100万等。

而是根据线程池和队列:逐步调大进行性能测试,不如:5000、10000、20000这种,直到找到性能接近瓶颈且合适的值即可。

更新大量文档——非必要不使用更新操作。

6、Elasticsearch 性能调优和索引维护相关问题

在开发过程中,你会如何处理 Elasticsearch 的索引碎片化?

有没有经验进行索引的映射迁移或重建?

回答:

第一个问题:索引碎片化不是专有词汇,ES 官方文档并没有这种称呼。

需要和面试官核实,多大是碎片?

这里,咱们推荐两个维度考虑这个问题。

维度1:架构层面,单分片的最大值尽量控制在 30 GB- 50GB,过大了不便于维护,过小了性能会有影响。

维度2:不定期在非业务密集区域实现段合并,以保证性能优化。

第二个问题:有没有经验进行索引的映射迁移或重建?

看数据量大小:

如果数据量不大,直接 reindex 数据迁移;

如果数据量适中,使用 reindex + slice 的方式迁移;

如果数据过大,推荐 elasticdump(适合跨集群同步),索引快照和恢复的方式保障数据迁移的高可用性。

如果跨集群,其实也可以使用:reindex, 但是要配置白名单。

如果版本兼容,快照和恢复机制也是推荐的!

7、Elasticsearch 错误处理和日志相关问题

Q1:如何处理 Elasticsearch 相关的异常和错误?

Q2:在你的开发工作中,你是如何进行日志记录和监控 Elasticsearch 行为的?

回答:

这个问题也非常大。

一般几个维度考量:

第一,不定期查看日志或者出了问题第一时间查看日志,普通日志会记录集群故障。比如:wildcard 出错,出问题日志能看到。

第二,必要时候,开启慢日志查询。比如:想知道哪个IP地址近期操作频繁,想知道近期哪个聚合比较拉胯。

第三,日志可视化,ELKB实现,日志通过logstash 同步到 Elasticsearch,并借助 Kibana 进行数据的可视化。

以上维度,保障集群问题及时发现也便于我们提前发现问题并解决问题。

8、Elasticsearch API使用和最佳实践相关问题

Q1:描述你使用Elasticsearch REST API时的一些最佳实践。

Q2:如何使用 Elasticsearch 的聚合 API来提取关键业务指标?

REST API 举例:

能用 filter 的咱们就走缓存过滤。

将核心 API 脚本实现,监控内存使用率,磁盘使用率、CPU使用率,一旦出问题及时邮件预警。

聚合API:这个没有问题,聚合核心就三个维度:

Metric 指标聚合;

bucket 分桶聚合;

pipeline 基于聚合的子聚合。

三种方式都可以,需要结合业务灵活使用聚合方式。

9、Elasticsearch 安全性和权限控制相关问题

Q1:描述在应用程序中实现 Elasticsearch 安全性的策略。

Q2:你是如何在 Elasticsearch 中管理细粒度的访问控制?

回答:

描述在应用程序中实现 Elasticsearch 安全性的策略?——针对这个问题,

我这边一般是 8.X 高版本,已经自带强调 SSL 证书访问,Kibana 也是安全配置的。

这样之后,Http访问就变成了 Https 访问。

那么在 Python 和 Java 客户端的程序访问也是需要把 Elasticsearch 配置的证书拷贝到给定的工程路径下的。

A2:你是如何在Elasticsearch中管理细粒度的访问控制?——针对这个问题,ES 是能支持到字段级别,不过是收费功能。实际项目中我们使用的开源版本,并未使用这功能。

10、Elasticsearch 容错性和高可用性:

Q1:你如何确保你开发的Elasticsearch应用具备高容错性?

Q2:当 Elasticsearch 集群不可用时,你的应用程序如何处理?

回答:

A:高容错性?——这个词我的理解是高可用性。需要表达清楚后,咱们和面试官进行核对,确保理解题目是正确的。

如果是,高可用性的策略可以安排如下:

第一:副本策略,多节点集群至少一个副本,确保某个节点宕机后,副本提升为主分片,确保集群的高可用性。

但是,实践验证过,副本不是越多越好,副本越多,意味着牺牲的存储空间越大,一般数据量大的集群扛不住那么多的冗余存储。一般至少一个即可(个人理解的经验值)。除非极其高可用要求的场景,可以超过1个副本,其他不建议。

第二:集群的不定时快照和恢复策略,确保集群万一故障能恢复到某一个时刻的可用状态。

高版本支持 SLM 快照生命周期管理功能,这一切的自动化和定时机制变得更加方便和快捷。

11、Elasticsearch 监控和警报机制

Q1:在开发过程中,你如何利用监控工具如 Elasticsearch 的 X-Pack 或其他插件来观察集群的健康状况?

Q2:你如何设置和处理与 Elasticsearch 相关的警报?

回答:

A1:x-pack 插件高版本 7.X 版本已经集成,不再需要二次安装。

我一般借助 kibana 的可视化,使用 Metricbeat 收集指标数据,同步到 Elasticsearch ,借助kibana 进行集群数据监控的可视化。

A2:你如何设置和处理与 Elasticsearch 相关的警报?——警报部分是收费功能,成本原因没有用。

不过第三方的 yelp 公司的开源 elasticalert 插件可以用和集成,不确认最新版本是否支持,早期版本用过。

https://github.com/jertel/elastalert2

还有,自己开发了必要的 python+shell 脚本,监控集群的健康状态,确保集群出现:cpu、磁盘、内存警戒线一到(自己定义的),就能第一时间收到预警邮件信息。

这些问题旨在评估候选人的技术能力、解决问题的方法以及对Elasticsearch 开发生命周期的理解。通过这样的问题,面试官可以了解候选人在 Elasticsearch 项目的规划、实施和维护方面的深度和广度。

欢迎大家一起完善补充!

7年积累,只为你少走不必要弯路!

7 年+积累、 Elastic 创始人Shay Banon 等 15 位专家推荐的 Elasticsearch 8.X新书已上线