- 1初识Windows8应用商店开发

- 2spring框架学习记录(1)

- 3《ClickHouse企业级应用:入门、进阶与实战》5 ClickHouse函数_clickhouse进阶

- 4git多人协作用户权限配置_gitshare权限

- 5使用微软Phi-3-mini模型快速创建生成式AI应用_phi3 本地 部署 安装 csdn

- 6如何部署一个chat copilot服务_copilot本地化部署

- 7关于pytorch模型猫狗图片识别 以及代码和数据集_pytorch猫狗识别

- 8多个API接口

- 9如何在mysql中执行sql脚本文件_mysql执行sql文件

- 10在Ubuntu上搭建并通过systemctl和Nginx管理Minecraft Java版服务器

一文读懂 LLM 训练:从预训练到微调【大模型行业应用入门系列】

赞

踩

自然语言处理(NLP)是人工智能领域中一项重要的研究方向,涉及机器对人类语言进行理解和生成。然而,语言的复杂性和多样性使得处理自然语言任务成为一项极具挑战性的任务。在这个领域中,LLM Training 扮演着至关重要的角色。

LLM Training 可以被看作是一次模型的深度学习之旅,通过高质量的训练,LLM 模型能够准确理解上下文,并生成自然流畅的文本,在各种自然语言处理任务中展现出卓越的性能。

随着技术的不断进步和计算资源的提升,LLM Training 正在取得突破性的进展。研究人员致力于改进训练算法、优化数据处理技术,并提出新的训练策略,以进一步提升模型的性能和应用效果。

1. 什么是 LLM 训练?

LLM Training 是指大型语言模型(LLM)的训练过程。作为一种采用超大规模数据进行预训练的深度学习模型,LLM 训练目标是培养出一个能够理解和生成自然语言文本的模型。在这个过程中,LLM 通过处理海量文本数据来学习语言的规律、语义和上下文关系等训练方式,可以获得丰富的语言知识和智能,从而使得能够自动理解和生成人类语言。

通常而言,这种训练过程通常需要大量的计算资源和时间,以便模型能够充分地学习语言的各个方面。LLM Training 的结果是一个高度智能和适应性强的语言模型,可以应用于各种自然语言处理任务,如机器翻译、文本生成、对话系统等不同场景领域以支撑业务发展。

2. 为什么要进行 LLM 训练?

LLM Training 是 LLM 发挥其能力的关键环节。通过充分的训练,LLM 可以深入学习语言的统计规律、语义信息和上下文关系,并将这些知识应用于各种自然语言处理任务中。LLM Training 的质量直接决定了 LLM 模型的性能和应用效果的好坏。

在训练过程中,LLM 通过处理大规模的文本数据来学习语言的模式和规律。LLM 通过预测下一个词或下一个句子等任务,从数据中捕捉到词汇之间的关联、句子的结构和语义上下文等信息。这样,模型可以逐渐建立起对语言的理解和生成能力。

LLM Training 的质量对 LLM 模型的性能和应用效果影响深远。一个经过高质量训练的 LLM 模型能够更准确、流畅地理解和生成自然语言文本。它能够准确把握词汇的语义关系、短语的语法结构以及上下文的推理,从而在各种自然语言处理任务中展现出卓越的性能。

为了实现高质量的 LLM Training,需要充足的计算资源和时间,以确保模型能够充分学习到语言的各个方面。同时,合理的数据选择和预处理也是提高训练质量的关键因素。通过不断改进和优化训练算法,研究人员可以进一步提高 LLM 的性能和应用效果,使其成为处理自然语言任务的强大工具。

通常而言,针对训练后的LLM 能够带来以下几个关键的好处和原因,具体可参考:

1、理解和生成自然语言文本

LLM Training 的目标是训练出一个能够理解和生成自然语言文本的模型。通过大规模数据的训练,LLM 可以学习语言的统计规律、语义信息和上下文关系,从而使模型能够对语言进行准确理解,并能够生成自然流畅的文本。

2、自然语言处理任务应用

LLM Training 使得模型能够应用于各种自然语言处理任务,如机器翻译、文本摘要、问题回答、情感分析等。通过训练,LLM 能够获取丰富的语言知识和智能,从而在这些任务中展现出出色的性能,帮助人们更高效地处理和理解大量的自然语言数据。

3、增强上下文理解和推理能力

LLM Training 使得模型具备了理解和利用上下文信息的能力。通过分析大量的语料库,LLM 可以学习到词汇之间的关联、句子的语法结构和语义关系,以及上下文推理等技能。这使得模型在处理自然语言时能够更好地理解上下文,并做出更准确的推理和判断。

4、数据驱动的学习能力的提高

LLM Training 利用了大量的数据来驱动学习过程。通过处理海量文本数据,模型可以从数据中学习到丰富的语言知识和模式,并逐渐提升自己的表现。数据驱动的学习使得模型能够从大规模的语料库中发现规律和模式,从而提高对语言的理解和生成能力。

5、模型性能和应用效果的提升

LLM Training 的质量直接影响着模型的性能和应用效果。通过充分的训练和优化,LLM 可以获得更高的准确性、流畅性和自然度,使其在各种自然语言处理任务中表现更出色。通过不断改进训练算法和数据处理技术,研究人员可以提高模型的性能,使其成为处理自然语言任务的强大工具。

3. LLM Training的不同步骤阶段

调整语言模型是训练过程中至关重要的环节,其目标是使模型能够更好地满足特定任务的需求。

在大型语言模型(LLM)的广阔领域中,存在多种不同的训练技术可供选择。这些技术包括但不限于预训练、微调、人类反馈强化学习(RLHF)以及适配器的使用。每种技术都有其独特的方法、要求和目标。接下来,我们将着重对LLM Training的核心阶段进行深入解析,以便更好地理解其工作原理和关键步骤。

3.1 Pre-Training-预训练

LLM Pre-Training(大型语言模型预训练)是指在特定任务上进行微调之前,对大型语言模型进行的初始训练阶段。这个阶段的目标是通过处理大规模的语料库数据,让模型学习到语言的统计规律、语义信息和上下文关系,从而为后续的微调任务提供强大的语言理解和生成能力。

LLM Pre-Training 的过程可以被视为一次模型的深度学习之旅。在这个阶段,我们从一个未经训练的模型开始,即模型的权重是随机初始化的。然后,模型被训练来根据前面的令牌序列预测即将出现的令牌。

具体而言,LLM Pre-Training 通常采用自监督学习的方式。自监督学习是一种无需人工标注数据的训练方法,它利用大量的未标记数据来生成训练样本。在 LLM Pre-Training 中,模型根据输入的上下文信息,预测被遮盖或掩盖的部分文本,以此来学习词汇之间的关联和句子的结构。这种预测任务可以是掩盖词语恢复、下一个句子预测等。

为了进行 LLM Pre-Training,研究人员收集和整理来自不同来源的大量文本数据,如维基百科、互联网新闻、书籍等。这些数据被组织成语料库,然后被分成适当的片段输入到模型中进行训练。通常情况下,LLM Pre-Training 需要大量的计算资源和时间,以确保模型能够充分学习到语言的各个方面。

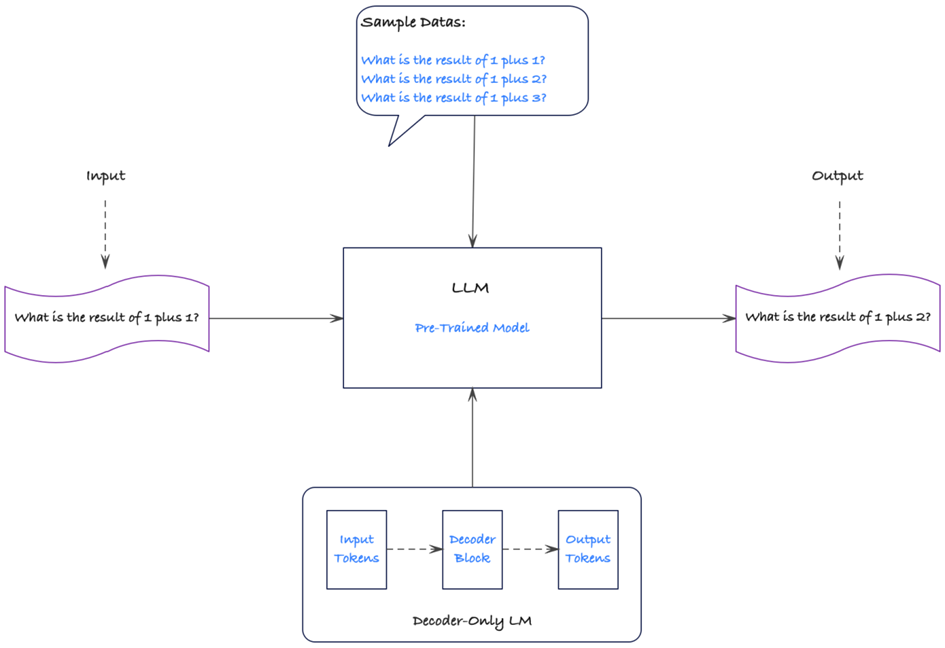

针对LLM Pre-Training工作流程,我们可以参考如下图所示,具体:

阶段一:Pre-Training-预训练活动流程

基于上述图,可以得知:LLM Pre-Training 阶段是大型语言模型的初始训练阶段,它是在特定任务微调之前进行的。在这个阶段,模型通过处理大规模的语料库数据来学习语言的统计规律、语义信息和上下文关系,从而获得广泛的语言理解和生成能力。

3.2 Fine-Tuning-微调

预训练的大型语言模型(LLM)虽然具备丰富的知识和多任务执行能力,但也存在一些局限性,这主要体现在以下几个方面:

1、输出结构限制:LLM的主要训练目标是预测文本中的后续标记,因此在生成其他结构化输出(如分类标签或答案)方面可能存在一定的限制。这意味着在某些任务上,LLM可能无法直接生成所需的输出结构,需要采取其他方法来适应不同的任务需求。

2、知识缺乏:LLM的知识是通过训练数据获得的,如果训练数据未包含特定领域的信息,那么LLM在该领域的表现可能会受到限制。这意味着LLM在陌生领域的知识和理解可能相对不足,需要进一步调整或微调以提升在特定领域的性能。

为了应对LLM输出结构的限制问题,通常,在实际的业务场景中,我们可以通过如下两种主要解决方案进行选择:

1、Prompting (提示工程):通过设计巧妙的提示信息,利用LLM内部的能力来引导生成符合特定任务要求的输出。这种方法通过巧妙地设置输入和提示信息,使LLM能够生成期望的输出,从而适应不同结构的任务需求。

2、Fine-Tuning(微调):通过修改LLM的最后一层输出结构,使其能够适应特定任务的需求。例如,对于分类任务,可以修改LLM的输出层为包含相应类别数量的神经元,并通过最高激活的神经元来推断预测的类别。这种微调的方法可以在特定任务上获得更好的性能和适应性。

针对LLM知识缺乏的问题,可以通过微调来提升LLM在特定领域的知识和表现。通过使用特定领域的数据对LLM进行微调训练,可以使其更好地理解和处理该领域的语言和知识,从而提高在该领域任务上的性能和准确性。

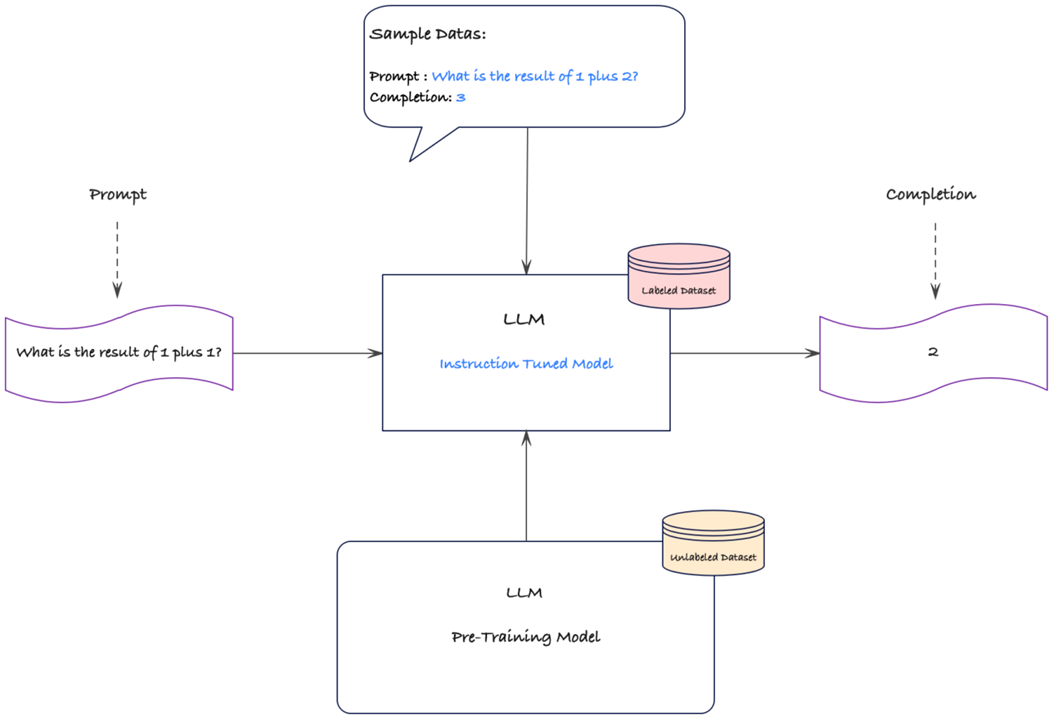

针对LLM Fine-Tuning工作流程,我们可以参考如下图所示,具体:

阶段二:Fine-Tuning(微调)活动流程

在FT( Fine-Tuning,微调)或指令调优阶段,模型以用户的消息作为输入,并以人工智能培训师的响应作为目标。通过最小化模型生成的响应与提供的目标响应之间的差异,模型学习生成更准确的响应。

在这个阶段,模型不仅能够理解指令的含义,还能够根据提供的指令从内存中检索知识。这意味着模型可以利用先前训练过程中获得的知识,并结合针对特定任务的指令进行调优,以生成更加准确和有针对性的响应。

通过FT或指令调优,模型可以更好地适应特定任务的要求,并根据提供的响应示例进行调整,以生成更符合预期的回复。这个阶段的训练过程允许模型从人工智能培训师的反馈中不断学习和改进,以提供更高质量的响应。

从本质上来讲,Fine-Tuning(微调)是一种使用预训练模型并结合新数据进行进一步训练的方法,主要集中在调整模型的最后一层权重。相比于初始训练,微调所需的资源要少得多,因此速度更快、效率更高。此外,预训练过程中学到的结构在模型的初始层中得以保留,这为微调带来了优势。

设想您想要指导模型理解不属于原始训练数据的鲜为人知的奇幻小说。通过微调,您可以利用模型对自然语言的理解能力,将其应用于这些奇幻小说这样一个新颖的领域。这样,模型可以更好地理解并适应奇幻小说中的语言特点和主题,因为它已经通过预训练过程获得了一定的语言理解能力。通过微调,模型可以更快地适应新数据,并在鲜为人知的奇幻小说领域表现出更高的准确性和表达能力。

3.3 RLHF-Tuning-人类反馈的强化学习微调

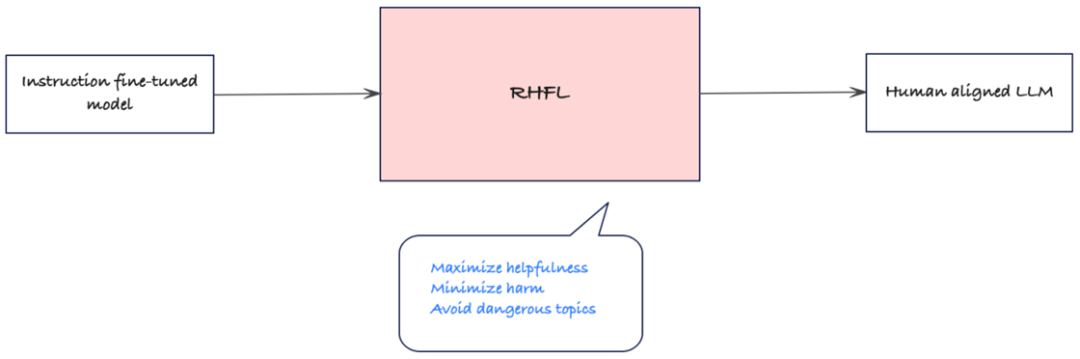

来自人类反馈的强化学习 (RLHF) 微调是一种独特的微调方法,专为 GPT 模型和 Chat-GPT 等聊天机器人而设计。该方法旨在使模型生成的响应对人类用户更有益。

通常而言,RLHF 微调结合了强化学习(RL)和高阶微调(HF)这两个概念,旨在通过强化学习和高阶微调的方式来微调模型,以进一步优化模型的性能。在RLHF微调中,模型通过与环境进行交互来学习最佳的策略,并通过高阶微调方法对模型的参数进行优化。这种方法可以更充分地利用模型的信息和结构,以及与环境的交互,从而提高模型在特定任务上的性能。

相比传统的微调方法,RLHF微调能够更好地适应环境和任务要求,因为它考虑了更高阶的参数。通过结合强化学习和高阶微调,RLHF微调可以使模型更快地收敛到最佳策略,并提高模型在复杂任务中的表现能力。

从本质上来讲,RHFL的主要目标是为用户提供安全、可靠的支持和指导,确保他们在与模型进行互动时能够获得积极的体验。通过强调最大限度地提供帮助,RHFL确保了模型的回答和建议能够尽可能地满足用户的需求,促进他们的理解和解决问题的能力。

同时,RHFL也非常注重尽量减少伤害。这意味着模型会避免使用冒犯性、侮辱性或激进的语言,并尽量避免引发用户的负面情绪或造成心理上的伤害。通过谨慎选择措辞和提供温和的建议,RHFL确保与用户的互动不会产生不良后果。

另外,RHFL还致力于避免危险话题的讨论。这意味着模型会避免介入敏感、争议或可能引发风险的话题,如暴力、自杀、恶意行为等。通过避免这些话题,RHFL旨在保护用户的安全和福祉,确保互动环境的良好和谐。

针对LLM RLHF-Tuning工作流程,我们可以参考如下图所示,具体:

阶段三:RLHF-Tuning(微调)活动流程

在此阶段,RHFL作为第二个微调步骤,旨在使模型与人类偏好保持一致,核心目标为关注乐于助人、诚实和无害。整个过程主要涉及两个子步骤,具体如下:

1、使用人类反馈训练奖励模型

通过由人类标记者生成的多个模型输出并对其排序,创建一个奖励模型。这个模型学习人类对乐于助人、诚实和无害内容的偏好。通过将人类反馈作为标准,奖励模型能够更好地理解和模拟人类的价值观。

2、用奖励模型代替人类进行大规模训练

在奖励模型完成训练后,可以将其用于取代人类标记数据进行大规模微调。奖励模型的反馈被用来指导模型的学习过程,进一步提高模型的性能。通过这种方式,RHFL确保模型的行为更加符合人类的期望和偏好。

因此,从某种意义上而言,RHFL的引进主要改进模型的行为,并使其与人类的价值观保持一致,以确保模型提供有用、真实和安全的响应。通过使用奖励模型进行微调,RHFL能够将人类的反馈和偏好融入到模型的训练中,从而使模型更好地满足用户的需求,并提供与人类价值观相一致的回答。

基于上述所述,通过结合这些不同的训练方法,我们能够提高 LLM 的性能和适应性。预训练提供了广泛的语言知识,微调使模型更专注于特定任务,而基于人类反馈的强化学习使模型的行为更符合人类期望。通过不断探索和改进这些方法,我们能够不断提高LLM的能力,使其成为一个强大而可靠的自然语言处理工具。

大模型岗位需求

大模型时代,企业对人才的需求变了,AIGC相关岗位人才难求,薪资持续走高,AI运营薪资平均值约18457元,AI工程师薪资平均值约37336元,大模型算法薪资平均值约39607元。

掌握大模型技术你还能拥有更多可能性:

• 成为一名全栈大模型工程师,包括Prompt,LangChain,LoRA等技术开发、运营、产品等方向全栈工程;

• 能够拥有模型二次训练和微调能力,带领大家完成智能对话、文生图等热门应用;

• 薪资上浮10%-20%,覆盖更多高薪岗位,这是一个高需求、高待遇的热门方向和领域;

• 更优质的项目可以为未来创新创业提供基石。

可能大家都想学习AI大模型技术,也想通过这项技能真正达到升职加薪,就业或是副业的目的,但是不知道该如何开始学习,因为网上的资料太多太杂乱了,如果不能系统的学习就相当于是白学。为了让大家少走弯路,少碰壁,这里我直接把全套AI技术和大模型入门资料、操作变现玩法都打包整理好,希望能够真正帮助到大家。

-END-

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Gausst松鼠会/article/detail/558612

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。