- 1markdown语法_hackmd文档标题命名规则为

- 2HarmonyOS NEXT应用开发——Navigation开发 页面切换场景范例

- 3淘宝店铺虚拟项目:新玩法_淘宝虚拟项目

- 4SSH远程连接MacOS catalina并进行终端颜色配置_ssh终端不能显示彩色

- 5java to_date(),to_char() 转换函数

- 6Hdfs NameNode中数据块、数据节点及副本状态概述_hdfs中的节点数和副本数的联系

- 7c++动态调用dll_c++ 动态调用dll

- 8Cannot preview this file. Previews are available for files in .ets, .js, .css, .hml, or .visual form

- 9管道机制

- 10HDMI接口和DP接口的区别_hdmi2.0 dp1.4 带宽

AI+医疗专题:人工智能大模型赋能医疗健康产业白皮书_ai+医疗专题:人工智能大模型赋能医疗健康产业白皮书

赞

踩

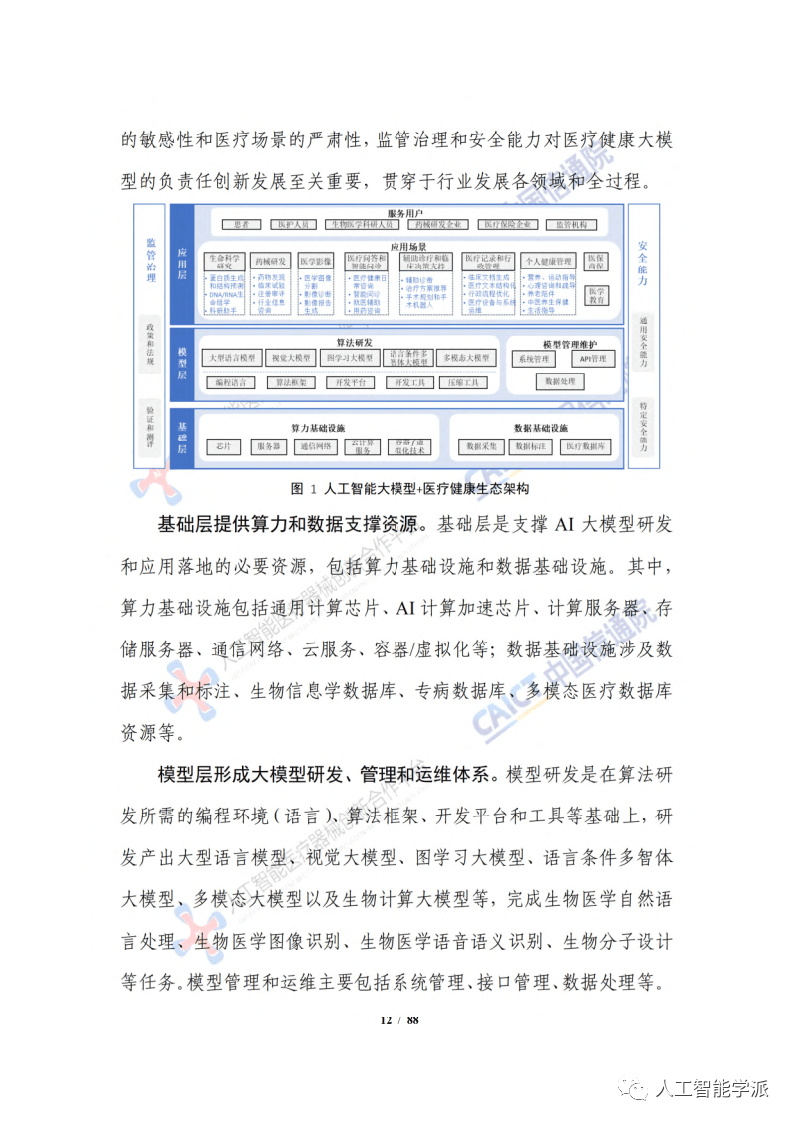

今天分享的是AI系列深度研究报告:《AI+医疗专题:人工智能大模型赋能医疗健康产业白皮书》。

——————

随着全球新一轮科技革命和产业变革深入发展,以人工智能(ArtificialIntelligence,AI)为代表的数字技术加速演进,成为经济增长的核心驱动力。近年来,人工智能大规模预训练模型( 以下简称“大模型”)在知识、数据、算法和算力等关键要素的共同推动下,呈现爆发式增长,从自然语言处理逐步扩展、迁移到计算机视觉、多模态科学计算等领域,增强了人工智能的泛化性、通用性,开启了人工智能发展新范式。人工智能大模型有望成为未来新型基础设施,赋能千行百业新一轮增长,落地应用和价值实现成为大模型下一步发展方向生命科学和医疗健康是大模型等 AI 技术最重要的应用领域之一,大模型可赋能生命科学研究和新药研发,促进医疗器械创新,提升医疗智能化水平。

——————

(报告出品方:中国信息通信研究院)

报告共计:88页

医疗健康大模型的概念和优势

人工智能大模型 (AI 大模型)是“大数据+大算力+强算法”结合的深度神经网络模型,通过“预训练+微调”模式增强了人工智能的通用性、泛化性,带来人工智能研发新范式,成为迈向通用人工智能(Artificial General Intelligence,AGI)的重要技术路径。AI大模型基于海量无标注数据进行预训练,提升模型前期学习的广度、深度和知识水平,从而能够低成本、高适应性地赋能大模型在后续下游任务中的应用。当模型参数规模足够大时,AI 大模型出现“智能涌现(Intelligence Emerging )”,例如“少样本”或“零样本”等能力。因此,基于 AI大模型进行下游应用开发时,对预训练好的大模型进行领域知识微调训练(在下游特定任务上的小规模有标注数据进行二次训练 ) 或使用提示词工程,即可高水平地完成多个应用场景的任务,实现通用的智能能力。AI 大模型是实现多种人工智能应用的通用载体,或成为未来整个人工智能生态的核心。

医疗健康大模型是面向复杂、开放医疗健康场景的基础大模型具有人数据、人算力、人参数等关键要素,至观涌观能力和良好的泛化性、通用性,可以根据不同的医疗健康任务,利用语言、视觉、语音乃至多模态融合的生物医学数据进行“预训练-微调”,从而为医疗健康领域提供高效、准确、个性化的服务和支持。

一是大模型可应用于多个下游任务。现有医疗人工智能模型主要采用针对特定任务的模型开发方法,在标记数据上进行训练,用于单任务学习。在美国食品和药品管理局 (FDA)批准的 521 款临床医疗人工智能模型产品中,大多数仅获得了1或 2个任务的批准。大模型具有较强的泛化能力和上下文学习能力,可以灵活、直接地应用于多个医疗任务,而无需特定任务的训练和标注数据。

二是大模型突破数据标注的困境。开发传统有监督的医疗人工智能模型时,需要大规模的标注数据才能形成运行良好的模型。大规模高质量的标注数据集需要医疗领域专家的参与,成本高、时间长。大模型利用自监督学习或强化学习方式,在无标注数据上进行预训练在一定程度上减轻了标注负担和创建大规模标注数据集的工作量,也更加适配生物医学、临床和健康相关各类数据爆炸式增长的时代在一些可用数据较少的临床场景,大模型可带来显著的人工智能效果提升。

三是大模型更加用户友好和易于使用。大模型具有接受人类的自然语言(汉语、英语等 ) 作为输入的能力,这使得外行和医疗专业人员都能够方便地访问大模型,也使得复杂的医疗信息更易于访问和理解。大模型还提供通过自定义查询与模型进行交互的能力。

四是大模型有望支持更加灵活的多种数据模态组合运用。一些严格的多模态模型通常将预定义的模态集合作为输入和输出(例如,必须始终同时输入图像、文本和实验室结果 )。相比之下,大模型具有更灵活的多模态交互方式,有望使用各种数据模态接受输入和产生输出(例如,可以接受文本、图像、实验室结果或任何组合 ),支持用户自由地组合各种医疗数据模态类型。

五是大模型具有更深入理解医学知识的潜力。与临床医生不同医学 AI 模型在接受特定任务训练之前通常缺乏医学领域知识,必须仅依赖于输入数据特征与预测目标之间的统计关联,来推导数据关系当针对特定医学任务的数据很少时,模型表现不佳。而大模型具有更复杂的网络结构和更多参数,通过结合知识图谱结构、检索式方法等技术,可以学习大量医学知识,更深入、更全面地理解医学概念和它们之间的关系,检索上下文中类似案例。这使得大模型能够推理出以前未见过的任务,并使用医学准确的语言解释相关的输出。

大模型特点突出,赋能通用医疗人工智能发展

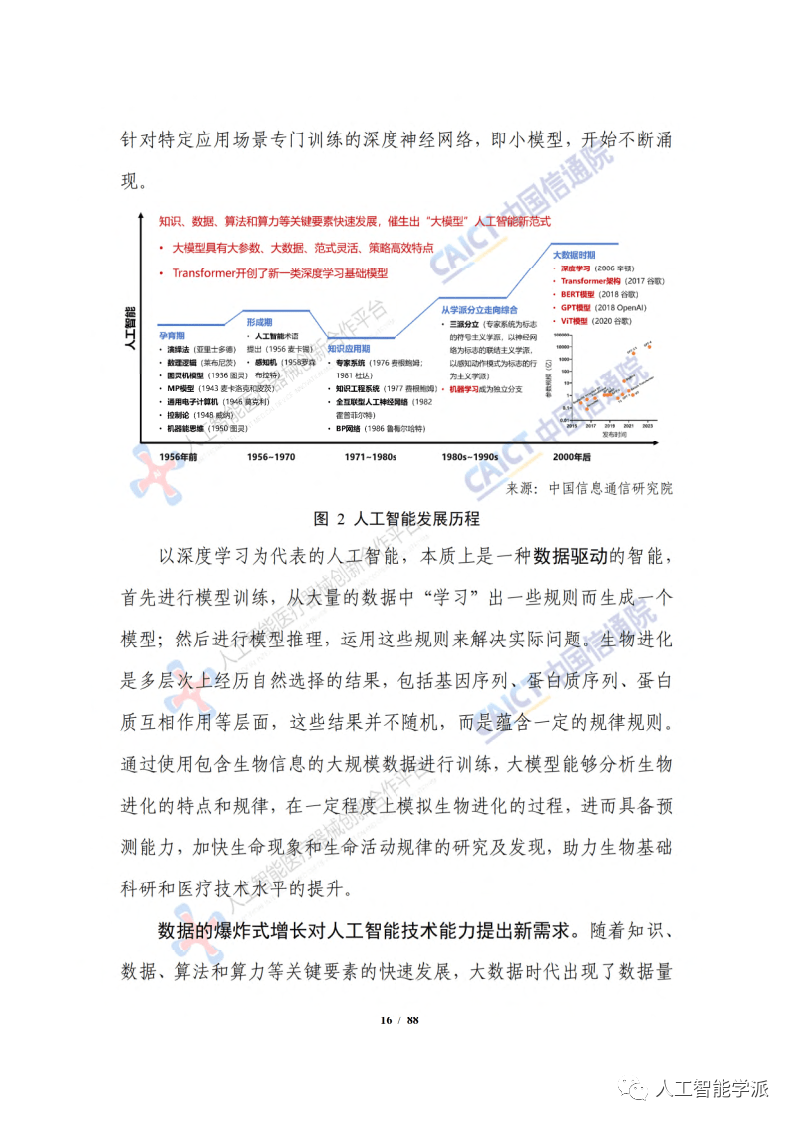

大模型具有大参数、大数据、范式灵活、策略高效等特点。大模型是一种利用海量、多元化数据预训练的深度神经网络模型,能够在不同任务中实现信息生成和推理等能力,具有涌现能力和较强的泛化性、通用性、实用性,在医疗、交通、金融等众多垂直行业场景上,初步展现了惊艳的性能表现和巨大的发展潜力。大模型通常基于Transformer 等主流架构,通过自注意力机制和并行计算提高性能和泛化能力。大模型的主要特点有:1)参数规模巨大,从数亿到百万亿不等;2)数据量庞大,无标签数据用于预训练,数据规模可达数亿至万亿 Token; 3)范式灵活,先用无监督学习预训练,再微调和适应各种下游任务;4)学习策略高效,能够在零样本、单样本或少样本的情况下,提取、总结、翻译和生成文本信息,甚至支持推理

大模型有望成为通用医疗人工智能的核心技术和基础设施。大模型具有高度灵活、可重复使用的技术特点,为通用医疗人工智能( Generalist Medical Artificial Intelligence,GMAI)2 提供了新的可能性。

Transformer 架构奠定大模型主流算法架构基础

Transformer 引入注意力机制,提高了深度学习模型的性能和效率。2017 年,谷歌首次提出了 Transformer 架构,其摒弃了此前 MLP、RNN和 CNN的处理结构,而是利用自注意力 (Self-Attention) 机制来得到输入和输出之间的全局依赖关系,能够捕捉到长距离的依赖关系和上下文信息,具备并行性、灵活性和可拓展性等优点6Transformer 架构引入了并行化,可以结合图形处理单元(GPU)或张量处理单元 (TPU)在大规模的数据集上进行训练,从而提高了计算效率。基于 Transformer 的模型具有多用途,不局限于单一模态 (文本)上,也演化出了可以用于语音、图像、视频等多模态任务的版本,灵活地进行数据融合和交互。

Transformer 架构为医疗健康大模型的发展提供了强大基础和支撑。2018年,谷歌提出了基于 Transformer 的双向编码器表示模型(BERT),它是第一个基于 Transformer 架构的大模型,在 11 个自然语言理解任务上取得了当时最好的结果,引发了基于 Transformer 的大模型研究和应用热潮。同样在 2018 年,OpenAI 提出了基于Transformer的生成式预训练模型(GPT)。2020 年,谷歌进一步提出了VisionTransformer ( ViT),打通了自然语言处理和计算机视觉之间的壁垒。

大型语言模型

大型语言模型是当前医疗健康大模型中数量最多、最为活跃的模型类型。大型语言模型在语言数据上进行预训练,并应用于语言下游任务。不同环境下的语言可以有不同的解释,如蛋白质是生命的语言代码是计算机的语言。大型语言模型能通过自监督学习,从大量未标记数据中提取有用的语义特征和模式,随后通过微调生成符合人类期望的响应。大型语言模型通常基于Transformer 架构打造。Transformcr可以分为编码器和解码器两部分,编码器提取输入序列的语义表示,大多用于“翻译”,解码器根据编码器的输出生成目标序列,大多用于“生成”。大型语言模型根据模型架构和执行的任务类型分为三个类别":第一类是纯编码器模型,如 BERT 及其变体。第二类是纯解码器模型,如 GPT 系列。GPT 是一种基于Transformer 的生成式预训练语言模型,主要利用自回归模型来捕捉语言中的上下文信息,并利用 Transformer 解码器来提取深层的语义特征,从而实现高质量的文本生成,可以用于文本生成、摘要、翻译等任务。纯解码器模型通常使用下一个标记预测(NTP) 或置换语言建模(PLM)等自回归或自监督的目标进行预训练。第三类是编码器-解码器模型,如文本到文本传输转换器 (15)和双向自回归转换器(BART)。编码器-解码器模型通常使用序列到序列 (Seq2Seq)或去噪自编码 (DAE) 等自监督或半监督的目标进行预训练。

医疗健康大型语言模型是基于通用大型语言模型的领域增强模型。为了提高大型语言模型在医疗健康领域的专业性和可靠性,通常需要在 GPT、BERT、T5 等大型语言模型基础上,利用基因或蛋白质序列信息、医学文本数据或脱敏后的患者全记录周期内的医疗代码序列,进行再训练或微调,以适应特定领域或任务的需求。例如,ChatDoctor、BioBERT12MedGPT 针对生物医学领域的预训练模型分别基于 HealthCareMagic 网站的医患对话、PubMed 摘要和 PubMedCentral (PMC)全文、MIMIC-III 临床电子健康记录进行预训练。