- 1如何使用OpenAI的GPT-3 API构建一个基于Python的大模型接口应用

- 2python爬取微信小程序,如何爬取小程序数据_微信小程序爬虫

- 3数字三角形【动态规划(含手工运算及多种源码)】_数字三角形问题动态规划

- 4Poison Frogs! Targeted Clean-Label Poisoning Attacks on Neural Networks 多任务学习 多任务关系学习

- 5拉链表和快照表的选择_快照表和拉链表的区别

- 624个Transformer模型高效魔改变体盘点,无bug拿来即用_transformer变体

- 7LangChain 79 LangGraph 从入门到精通一_tavily

- 8Git创建本地项目推送至Gitee_gitte推送代码

- 9text-generation-webui搭建大模型运行环境与踩坑记录

- 10SpringBoot使用自定义注解+AOP+Redis实现接口限流_springboot jedis aop实现ratelimit

探索自然语言处理领域的最新进展与挑战_自然语言处理涉及领域,主要研究方法,主要存在问题,现有解决方案

赞

踩

自然语言处理(NLP)是人工智能领域中最受关注的领域之一,它涉及计算机和人类语言之间的交互。NLP的应用范围非常广泛,包括机器翻译、语音识别、文本分类、情感分析等等。本文将介绍NLP的基本概念和入门知识,以帮助初学者快速上手。

首先,我们需要了解NLP中的一些基本概念。NLP主要涉及自然语言处理和自然语言生成两个方面。自然语言处理是指对文本进行分析和处理,以使计算机能够理解自然语言。而自然语言生成则是指将计算机生成的信息转化为自然语言。在这两个方面中,有几个重要的概念需要了解:

- Tokenization:将文本拆分成词语或单词的过程。

- Part-of-speech tagging:将每个词语标记为名词、动词、形容词等等。

- Named entity recognition:识别文本中的人名、地名、组织名等等。

- Sentiment analysis:分析文本中的情感和态度。

除了这些基本概念之外,还有一些必要的工具和框架需要掌握,例如Python编程语言、NLTK(自然语言工具包)、spaCy等等。掌握这些工具和框架可以帮助您更好地进行NLP实验和研究。

接下来,让我们来看看如何开始学习NLP。首先,您需要了解NLP领域的一些常用技术和算法,例如基于规则的方法、朴素贝叶斯算法、支持向量机(SVM)等等。您还需要掌握一些数据处理和可视化技能,例如数据清理、数据可视化和探索性数据分析。这些技能将帮助您更好地理解和处理自然语言数据。

除了掌握技能和算法之外,还需要进行实际的项目练习。您可以选择一些经典的NLP项目,例如垃圾邮件过滤、情感分析、文本分类等等。通过这些实际项目,您可以更好地理解NLP技术和算法,并且获得实际项目经验。

在自然语言处理(NLP)的领域中,深度学习模型已经被证明是非常成功的。这些模型可以学习自然语言的语义和结构,并在诸如情感分析、机器翻译、自动问答等任务上取得出色的表现。下面将介绍一些常用的深度学习模型以及它们在NLP中的应用。

-

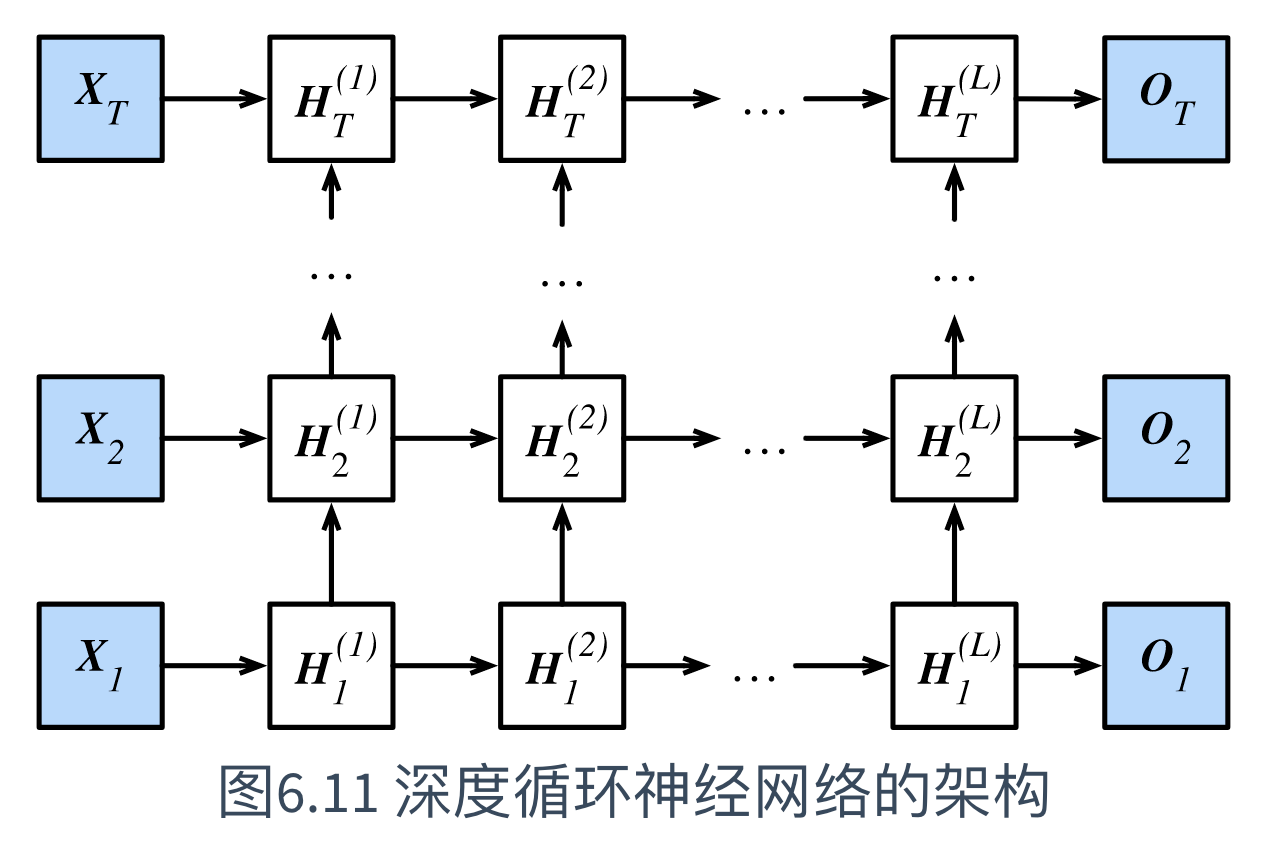

循环神经网络(RNN) 循环神经网络是一种递归神经网络,它的前一个输出会被作为下一个输入的一部分,以此实现对序列数据的处理。由于自然语言是一种序列数据,因此循环神经网络在NLP中得到了广泛应用。其中,长短时记忆网络(LSTM)和门控循环单元(GRU)是两种常用的循环神经网络结构。

-

卷积神经网络(CNN) 卷积神经网络是一种用于图像处理的神经网络,但是它也可以用于NLP中的文本分类任务。在文本分类任务中,我们可以将文本看做是一维序列数据,将卷积神经网络应用于文本数据中,并使用一维卷积操作提取特征,然后将这些特征传递到全连接层进行分类。

-

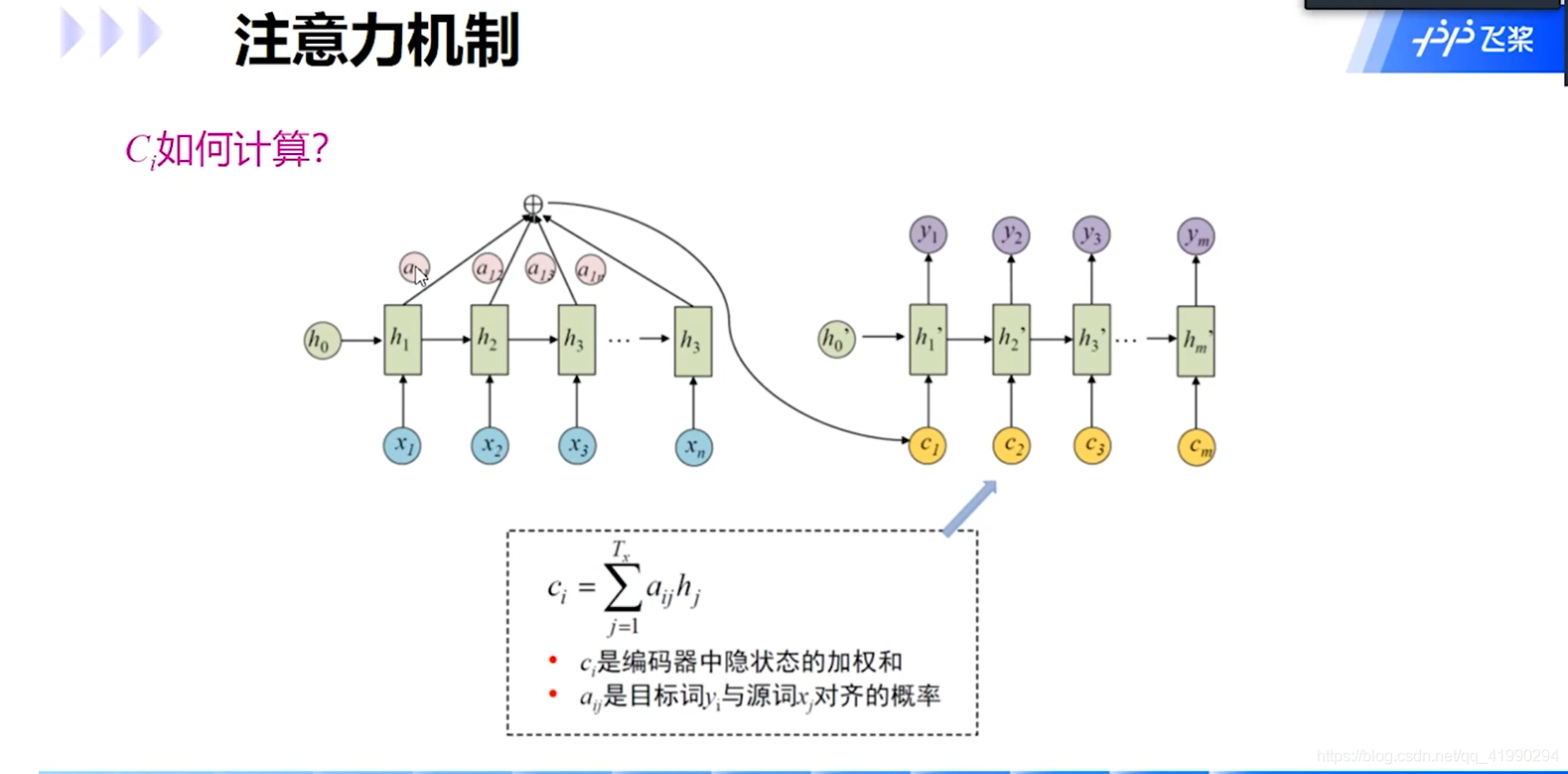

注意力机制(Attention Mechanism) 注意力机制是一种能够将不同部分的信息组合在一起的方法。在NLP中,我们可以使用注意力机制来解决机器翻译任务。当我们将一个句子从一种语言翻译到另一种语言时,某些单词在目标语言中可能不存在,而某些单词可能有多种翻译。在这种情况下,我们需要一种机制来选择正确的单词进行翻译。注意力机制就是这样一种机制,它可以根据上下文中的单词选择正确的翻译单词。

-

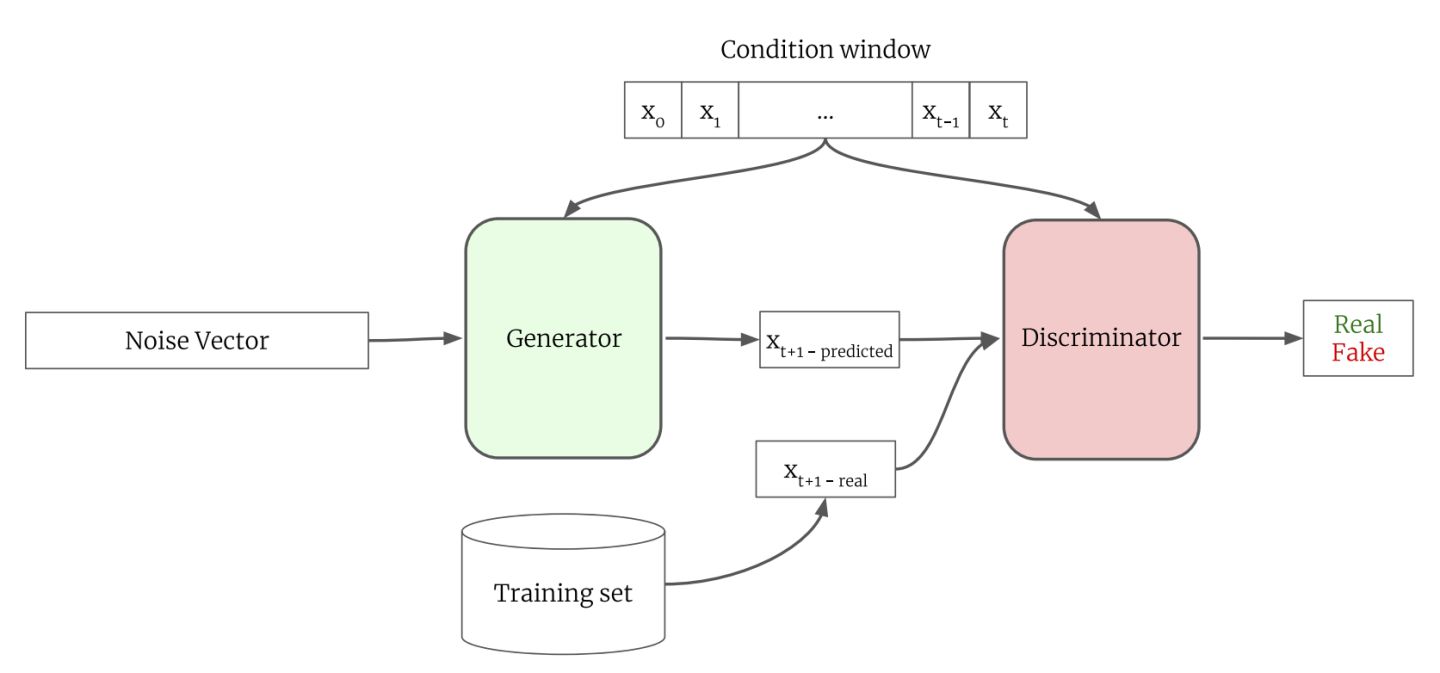

生成对抗网络(GAN) 生成对抗网络是一种能够生成新样本的深度学习模型,它由生成器和判别器两部分组成。在NLP中,生成对抗网络可以用于生成文本,例如自动写作、聊天机器人等。生成器会根据一些输入数据生成新的文本,而判别器则会判断这个文本是否为真实的文本。通过不断优化生成器和判别器,生成对抗网络可以不断生成更加逼真的文本。

另外,NLP 研究还涉及到自然语言生成 (Natural Language Generation, NLG)、对话系统 (Dialogue Systems)、情感分析 (Sentiment Analysis)、文本分类 (Text Classification)、信息抽取 (Information Extraction)、机器翻译 (Machine Translation) 等方面。在这些方向上,也有很多经典的论文值得一读。

除了阅读论文,还有一些其他的学习方法可以帮助你更好地掌握 NLP 知识。比如,你可以参加 NLP 的相关课程,如斯坦福大学的 CS224N 或者多伦多大学的 CSC413/2516。此外,参加相关的竞赛和项目也是一个很好的学习方式,如Kaggle、NLPCC、SemEval 等竞赛。

最后,如果你想要深入研究 NLP,还可以考虑阅读相关的专业书籍,如《Speech and Language Processing》、《Foundations of Statistical Natural Language Processing》、《Neural Network Methods in Natural Language Processing》等。

总之,要想学好 NLP,阅读论文是必不可少的一步。通过阅读经典论文,你可以更好地了解 NLP 的基本概念和最新进展,同时也可以学习到一些重要的技术和方法。同时,结合其他学习方法,如参加相关的课程、竞赛和项目,阅读相关的书籍,可以帮助你更好地掌握 NLP 知识,成为一名优秀的 NLP 研究者或者从业者。

希望这篇文章能够帮助你更好地入门 NLP,同时也为你提供了一些学习 NLP 的有效方法。

-

需要相关z料可以关注g众Hao【Ai技术星球】回复(123)必领 还有500g人工智能学习z料领(内含电子书、论文合集、最新技术资料、行业报告等)~~