- 1NLP-情感分析_情感程度分级nlp

- 2arm架构安装docker-compose_docker-compose arm

- 3拥挤场景中的渐进式端到端目标检测(Deformable-DETR 实现)含源码_跑deformabledetr的源代码

- 4STM32单片机-LED灯_stm32控制大功率led灯

- 5吴恩达Coursera深度学习课程_coursera吴恩达《深度学习》课

- 6maven项目eclipse提示Cannot change version of project facet Dynamic web module to...

- 7受裁员大环境影响,2024年要不要入坑鸿蒙?_2024鸿蒙开发失业(1)_鸿蒙开发就是骗局2024

- 8基于docker安装Nessus(win10系统)_nessus docker ubuntu安装

- 9r语言逻辑回归_R语言机器学习 | 3 逻辑回归

- 10java hh24_java校验框架里YYYY-MM-DD HH24:mm:ss格式怎么校验

回归预测 | MATLAB实现BO-CNN-BiLSTM贝叶斯优化卷积双向长短期记忆网络数据回归预测_基于贝叶斯优化算法优化双向长短期记忆网络的数据回归预测 bo-bilstm

赞

踩

回归预测 | MATLAB实现BO-CNN-BiLSTM贝叶斯优化卷积双向长短期记忆网络数据回归预测

效果一览

基本介绍

基于贝叶斯优化卷积双向长短期记忆网络(CNN-BiLSTM)回归预测,BO-CNN-BiLSTM/Bayes-CNN-BiLSTM多输入单输出模型。

1.优化参数为:学习率,隐含层节点,正则化参数。

2.评价指标包括:R2、MAE、MSE、RMSE和MAPE等,方便学习和替换数据。

3.运行环境matlab2020b及以上。

模型搭建

-

CNN-BiLSTMLSTM模型结合了CNN和BiLSTMLSTM的优点,本文使用的CNN-BiLSTM模型的第一部分是由卷积层和最大值组成的CNN部分池化层,对原始数据进行预处理并输入CNN卷积层,利用卷积核自适应提取生命特征,卷积层将遍历输入信息,将卷积核权重与局部序列进行卷积运算体管信息得到初步的特征矩阵,比原始序列数据(矩阵)更具表现力。

-

本文使用的池化层是最大池化层,池化操作对提取的特征进行数据降维,避免模型过拟合,保留主要特征。最大池化层将前一个卷积层得到的特征矩阵作为输入,在这个矩阵上滑动一个池化窗口,在每一次滑动中取池化窗口的最大值,输出一个更具表现力的特征矩阵。

-

池化后,连接一个BiLSTM 层,提取相关向量由CNN构造成一个长期的时间序列作为BiLSTM的输入数据。卷积层将卷积层的数据展平(Flatten),模型中加入Flatten,将(height,width,channel)的数据压缩成一个长高宽通道的一维数组,然后我们可以添加直接密集层。

-

对卷积池化数据压缩特征操作,多个卷积特征提取框架提取的特征融合或从输出层融合,全连接层聚合学习到的特征,激活函数使用Relu。

-

通常,在模型训练过程中需要对超参数进行优化,为模型选择一组最优的超参数,以提高预测的性能和有效性。 凭经验设置超参数会使最终确定的模型超参数组合不一定是最优的,这会影响模型网络的拟合程度及其对测试数据的泛化能力。

-

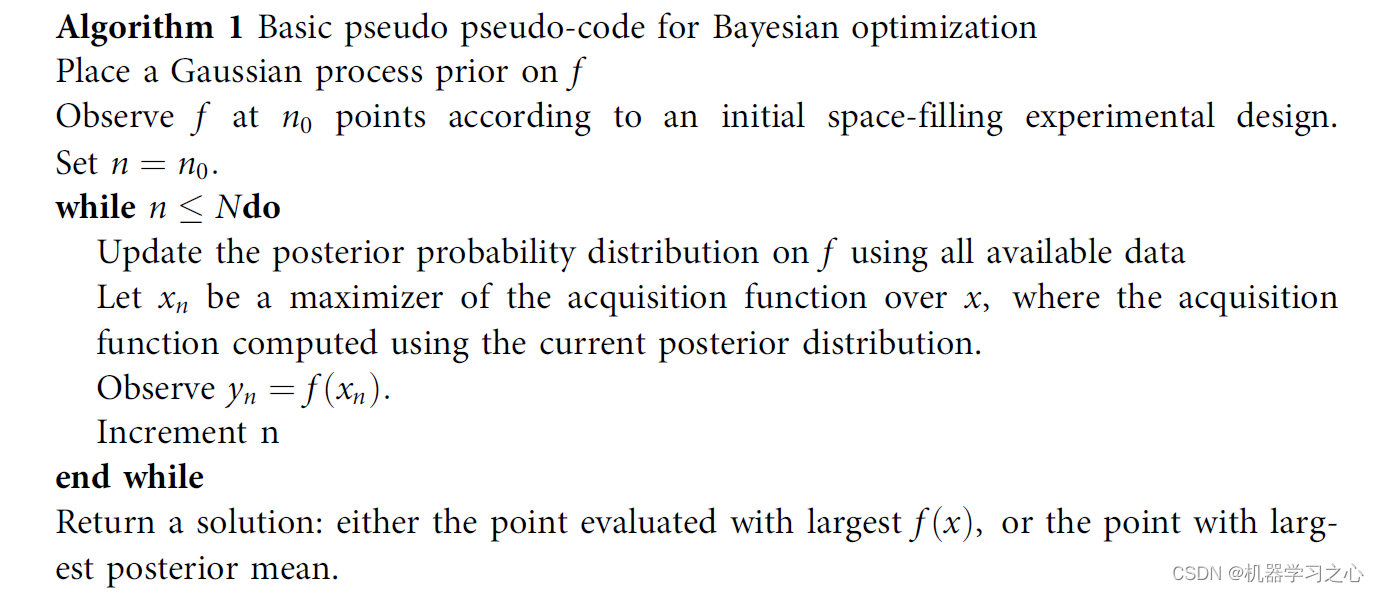

伪代码

-

通过调整优化算法调整模型参数,学习重复率和贝叶斯优化超参数来调整模型参数。

程序设计

- 完整程序和数据获取方式1:私信博主,同等价值程序兑换;

- 完整程序和数据下载方式2(资源处直接下载):MATLAB实现BO-CNN-BiLSTM贝叶斯优化卷积双向长短期记忆网络数据回归预测

- 完整程序和数据下载方式3(订阅《组合优化》专栏,同时获取《组合优化》专栏收录的所有程序,数据订阅后私信我获取):MATLAB实现BO-CNN-BiLSTM贝叶斯优化卷积双向长短期记忆网络数据回归预测

%% 贝叶斯优化网络参数 bayesopt(fitness, optimVars, ... % 优化函数,和参数范围 'MaxTime', Inf, ... % 优化时间(不限制) 'IsObjectiveDeterministic', false, ... 'MaxObjectiveEvaluations', 10, ... % 最大迭代次数 'Verbose', 1, ... % 显示优化过程 'UseParallel', false); %% 得到最优参数 NumOfUnits = BayesObject.XAtMinEstimatedObjective.NumOfUnits; % 最佳隐藏层节点数 InitialLearnRate = BayesObject.XAtMinEstimatedObjective.InitialLearnRate; % 最佳初始学习率 L2Regularization = BayesObject.XAtMinEstimatedObjective.L2Regularization; % 最佳L2正则化系数 %% 创建混合CNN-BiLSTM网络架构 % 输入特征维度 numFeatures = f_; % 输出特征维度 numResponses = 1; FiltZise = 10; % 创建"CNN-BiLSTM"模型 layers = [... % 输入特征 sequenceInputLayer([numFeatures 1 1],'Name','input') sequenceFoldingLayer('Name','fold') % CNN特征提取 convolution2dLayer([FiltZise 1],32,'Padding','same','WeightsInitializer','he','Name','conv','DilationFactor',1); batchNormalizationLayer('Name','bn') eluLayer('Name','elu') averagePooling2dLayer(1,'Stride',FiltZise,'Name','pool1') % 展开层 sequenceUnfoldingLayer('Name','unfold') % 平滑层 flattenLayer('Name','flatten') % BiLSTM特征学习 bilstmLayer(50,'Name','bilstm1','RecurrentWeightsInitializer','He','InputWeightsInitializer','He') % BiLSTM输出 bilstmLayer(NumOfUnits,'OutputMode',"last",'Name','bil4','RecurrentWeightsInitializer','He','InputWeightsInitializer','He') dropoutLayer(0.25,'Name','drop3') % 全连接层 fullyConnectedLayer(numResponses,'Name','fc') regressionLayer('Name','output') ]; layers = layerGraph(layers); layers = connectLayers(layers,'fold/miniBatchSize','unfold/miniBatchSize'); %% CNNBiLSTM训练选项 % 批处理样本 MiniBatchSize =128; % 最大迭代次数 MaxEpochs = 500;

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/129036772?spm=1001.2014.3001.5502

[2] https://blog.csdn.net/kjm13182345320/article/details/128690229