热门标签

热门文章

- 1vite和webpacke的常规配置

- 2计算机毕业设计 jsp校园OTO超市系统ssm 毕设

- 3python课后题答案第二单元_Python自然语言处理课后习题第二单元解答

- 4关于butterknife10.0.0的更新和AndroidX的使用_安卓升級androidx butterknife不能使用

- 5(含源码)「自然语言处理(NLP)」社区问答评估&&Bert模型优化_bert优化 论文

- 6N皇后问题(DFS解决)

- 7数学建模——阅读论文的重要性_数学建模要看优秀论文吗

- 8如何制作自己的R包_library("roxygen2") roxygenize("dailytools") # 对r包

- 9Diffbot号称排名第一的网页智能解析真有那么强大嘛?

- 10Kafka是什么?你理解吗?必知必会_kafka有什么意义

当前位置: article > 正文

Spark_SQL-DataFrame数据写出以及读写数据库(以MySQl为例)_pyspark dataframe写mysql

作者:Gausst松鼠会 | 2024-05-12 11:09:14

赞

踩

pyspark dataframe写mysql

一、数据写出

(1)SparkSQL统一API写出DataFrame数据

统一API写法:

常见源写出:

- # cording:utf8

-

- from pyspark.sql import SparkSession

- from pyspark.sql.types import StructType, IntegerType, StringType

- import pyspark.sql.functions as F

- if __name__ == '__main__':

- spark = SparkSession.builder.\

- appName('write').\

- master('local[*]').\

- getOrCreate()

-

- sc = spark.sparkContext

-

- # 1.读取文件

- schema = StructType().add('user_id', StringType(), nullable=True).\

- add('movie_id', IntegerType(), nullable=True).\

- add('rank', IntegerType(), nullable=True).\

- add('ts', StringType(), nullable=True)

-

- df = spark.read.format('csv').\

- option('sep', '\t').\

- option('header', False).\

- option('encoding', 'utf-8').\

- schema(schema=schema).\

- load('../input/u.data')

-

- # write text 写出,只能写出一个列的数据,需要将df转换为单列df

- df.select(F.concat_ws('---', 'user_id', 'movie_id', 'rank', 'ts')).\

- write.\

- mode('overwrite').\

- format('text').\

- save('../output/sql/text')

-

- # write csv

- df.write.mode('overwrite').\

- format('csv').\

- option('sep',';').\

- option('header', True).\

- save('../output/sql/csv')

-

- # write json

- df.write.mode('overwrite').\

- format('json').\

- save('../output/sql/json')

-

- # write parquet

- df.write.mode('overwrite').\

- format('parquet').\

- save('../output/sql/parquet')

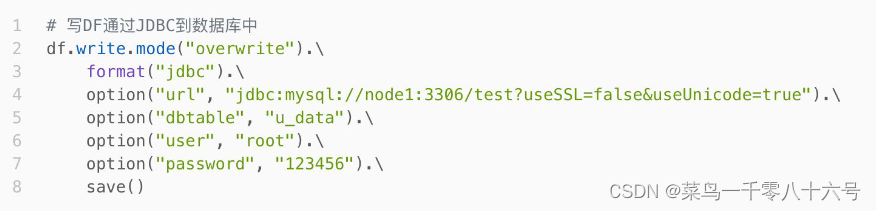

二、写出MySQL数据库

API写法:

注意:

①jdbc连接字符串中,建议使用useSSL=false 确保连接可以正常连接( 不使用SSL安全协议进行连接)

②jdbc连接字符串中,建议使用useUnicode=true 来确保传输中不出现乱码

③save()不要填参数,没有路径,是写出数据库

④dbtable属性:指定写出的表名

- # cording:utf8

-

- from pyspark.sql import SparkSession

- from pyspark.sql.types import StructType, IntegerType, StringType

- import pyspark.sql.functions as F

- if __name__ == '__main__':

- spark = SparkSession.builder.\

- appName('write').\

- master('local[*]').\

- getOrCreate()

-

- sc = spark.sparkContext

-

- # 1.读取文件

- schema = StructType().add('user_id', StringType(), nullable=True).\

- add('movie_id', IntegerType(), nullable=True).\

- add('rank', IntegerType(), nullable=True).\

- add('ts', StringType(), nullable=True)

-

- df = spark.read.format('csv').\

- option('sep', '\t').\

- option('header', False).\

- option('encoding', 'utf-8').\

- schema(schema=schema).\

- load('../input/u.data')

-

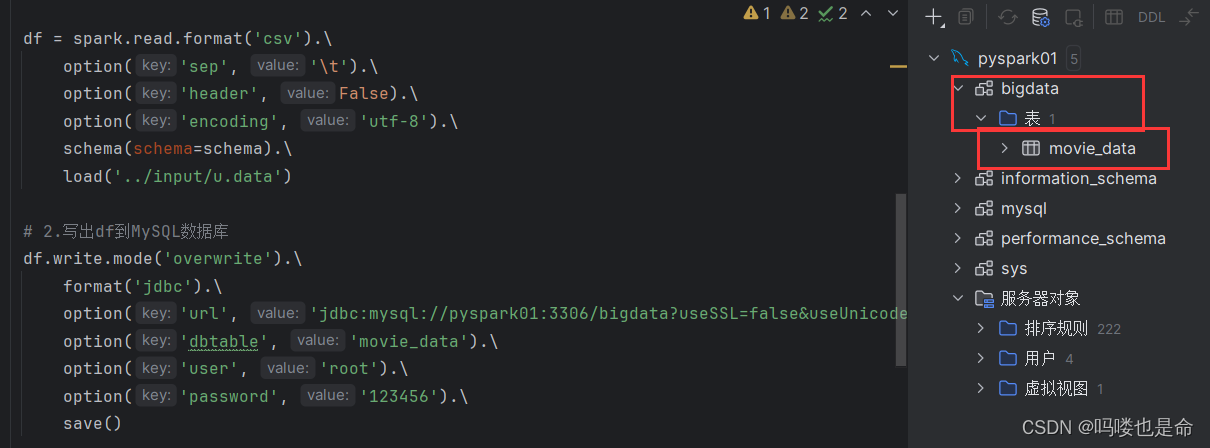

- # 2.写出df到MySQL数据库

- df.write.mode('overwrite').\

- format('jdbc').\

- option('url', 'jdbc:mysql://pyspark01:3306/bigdata?useSSL=false&useUnicode=true&serverTimezone=GMT%2B8').\

- option('dbtable', 'movie_data').\

- option('user', 'root').\

- option('password', '123456').\

- save()

-

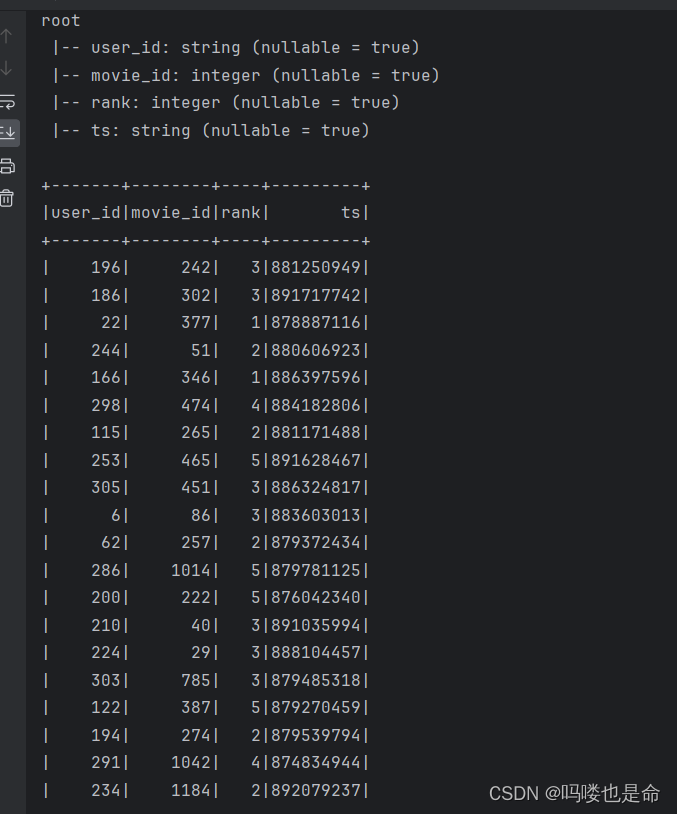

- # 读取

- df2 = spark.read.format('jdbc'). \

- option('url', 'jdbc:mysql://pyspark01:3306/bigdata?useSSL=false&useUnicode=true&serverTimezone=GMT%2B8'). \

- option('dbtable', 'movie_data'). \

- option('user', 'root'). \

- option('password', '123456'). \

- load()

-

- # 查看读取结果

- df2.printSchema()

- df2.show()

- '''

- JDBC写出,会自动创建表的

- 因为DataFrame中的有表结构信息,StructType记录的 各个字段的名称 类型 和是否运行为空

- '''

保存结果:

读取结果:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Gausst松鼠会/article/detail/558710

推荐阅读

相关标签