- 1CTF技能学习笔记(内容摘抄总结于[CTF Wiki](https://ctf-wiki.org/))_ctf笔记

- 2【Linux学习】深入了解Linux中进程状态及其转换_linux 任务状态转换图 挂起属于一种状态吗

- 3搜java题的公众号_知到智慧树_Java程序设计_搜题公众号

- 4【突发】MDPI再出事!23本期刊84篇论文存在“审稿人工厂”问题,4本被中科院预警!_mdpi 论文工厂

- 5jadx-gui-1.5 反编译工具使用教程 反混淆 Java android 查看签名

- 6DJI 大疆高德地图与航点任务功能实现

- 7Linux下安装jdk、tomcat_tomcat linux版

- 8git 分支 提交 回滚 命令_git的分支提交及回滚

- 9手把手教你使用 Python 制作贪吃蛇游戏_贪吃蛇py,阿里P7亲自教你_用python编写一个可视化的贪吃蛇游戏

- 10SpringBoot中编写MybatisPlus配置类_springboot mybatisplus 配置类

手把手带你实现ChatGLM2-6B的P-Tuning微调_chatglm-tuning

赞

踩

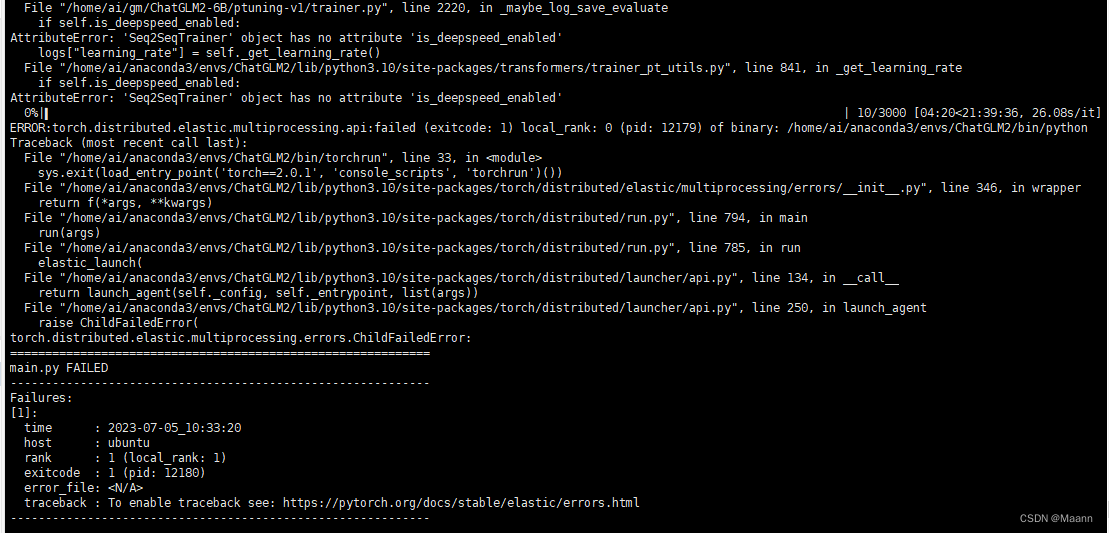

注意问题1:AttributeError: ‘Seq2SeqTrainer’ object has no attribute 'is_deepspeed_enabl

torch.distributed.elastic.multiprocessing.errors.ChildFailedError:

可能是版本太高,可以参考chatglm2的环境

1. ChatGLM2-6B的P-Tuning微调

ChatGLM2-6B:https://github.com/THUDM/ChatGLM2-6B

模型地址:https://huggingface.co/THUDM/chatglm2-6b

详细步骤同:ChatGLM-6B的P-Tuning微调详细步骤及结果验证

注:ChatGLM2-6B官网给的环境P-Tuning微调报错 (python3.8.10/3.10.6 + torch 2.0.1 + transformers 4.30.2),

AttributeError: ‘Seq2SeqTrainer’ object has no attribute 'is_deepspeed_enabl

torch.distributed.elastic.multiprocessing.errors.ChildFailedError:

应该是transformers版本太高了,用ChatGLM-6B环境(ChatGLM-6B部署教程)即可,即

Python 3.8.10

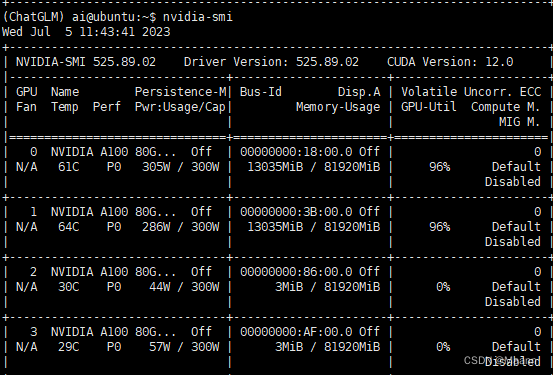

CUDA Version: 12.0

torch 2.0.1

transformers 4.27.1

- 1

- 2

- 3

- 4

- 1

- 2

- 3

- 4

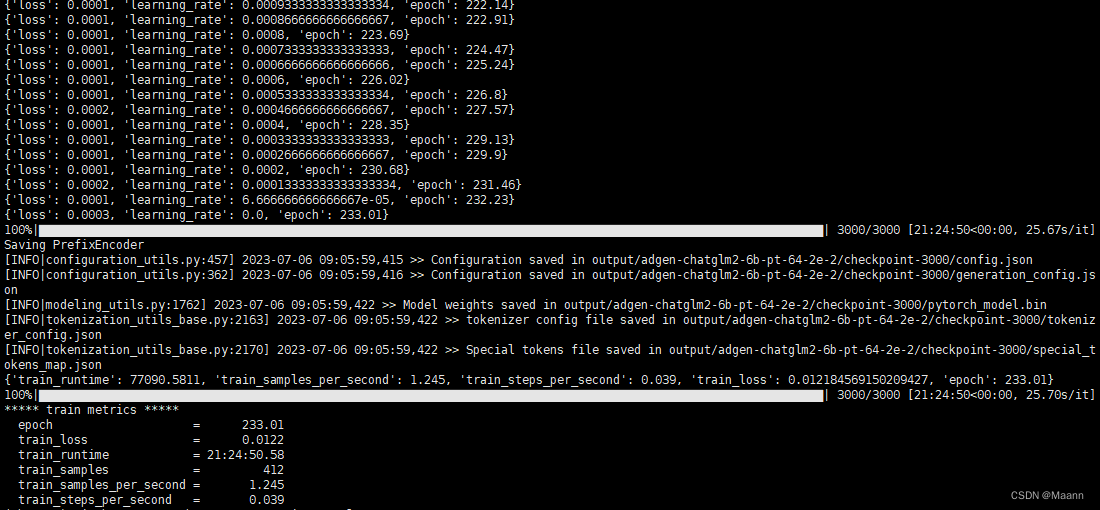

2. 模型微调情况

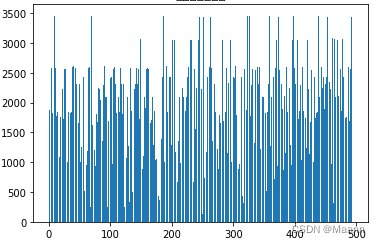

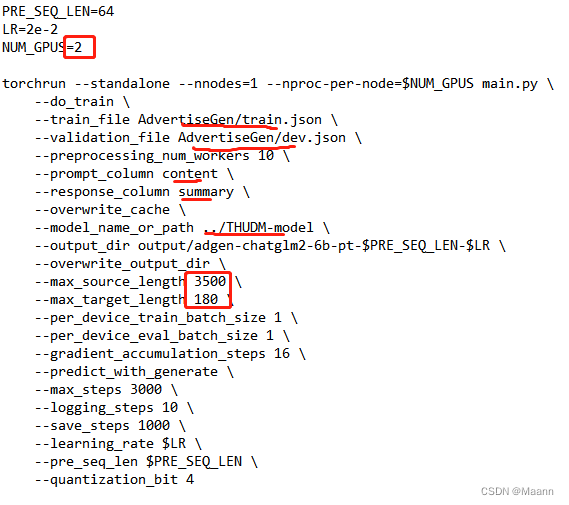

2.1 数据集&调参

训练集:412条

验证集:83条

max_source_length:3500

max_target_length:180

问题长度:

2.2 模型训练

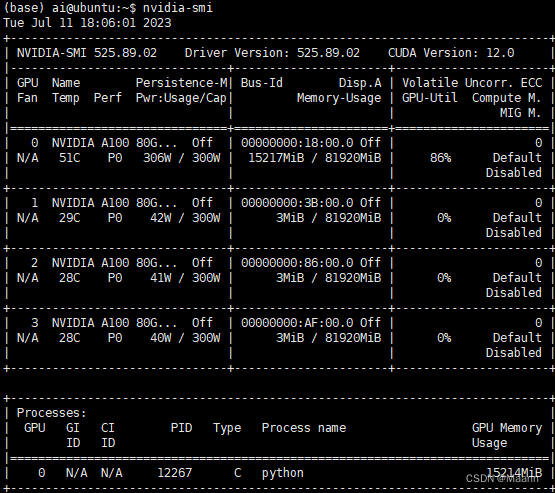

A100 80G 2块,占用率16%,3000轮训练时间21h

2.3 模型预测

from transformers import AutoConfig, AutoModel, AutoTokenizer

import torch

import os

- 1

- 2

- 3

tokenizer = AutoTokenizer.from_pretrained(“…/THUDM-model”, trust_remote_code=True)

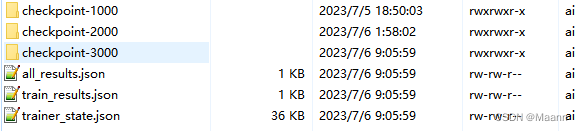

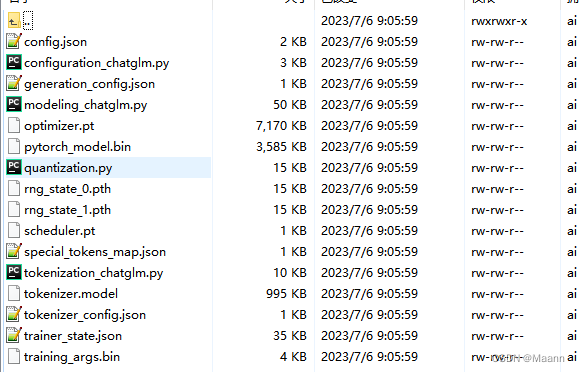

CHECKPOINT_PATH = ‘./output/adgen-chatglm2-6b-pt-64-2e-2/checkpoint-3000’

PRE_SEQ_LEN = 64

config = AutoConfig.from_pretrained(“…/THUDM-model”, trust_remote_code=True, pre_seq_len=PRE_SEQ_LEN)

model = AutoModel.from_pretrained(“…/THUDM-model”, config=config, trust_remote_code=True).half().cuda()

prefix_state_dict = torch.load(os.path.join(CHECKPOINT_PATH, “pytorch_model.bin”))

new_prefix_state_dict = {

}

for k, v in prefix_state_dict.items():

if k.startswith(“transformer.prefix_encoder.”):

new_prefix_state_dict[k[len(“transformer.prefix_encoder.”):]] = v

model.transformer.prefix_encoder.load_state_dict(new_prefix_state_dict)

#model = AutoModel.from_pretrained(CHECKPOINT_PATH, trust_remote_code=True)

model = model.eval()

response, history = model.chat(tokenizer, “你好”, history=[]

参照p-tuning readme,需注意:

(1) 注意可能需要将 pre_seq_len 改成训练时的实际值。

(2) 如果是从本地加载模型的话,需要将 THUDM/chatglm2-6b 改成本地的模型路径(注意不是checkpoint路径); CHECKPOINT_PATH路径需要修改。

(3) 报错”RuntimeError: “addmm_impl_cpu_” not implemented for ‘Half’“

需要在model = AutoModel.from_pretrained(“…/THUDM-model”, config=config, trust_remote_code=True) 后加 .half().cuda()

495条数据,无history,单轮,模型加载+预测时间3min