热门标签

热门文章

- 1基于STM32与TB6600的机械臂项目(代码开源)_步进电机驱动的机械臂控制系统设计

- 2MFC常规DLL的创建与使用实例_创建mfc dll 串口通信

- 3可解释性人工智能(XAI):揭秘人工智能的“黑匣子”_人工智能黑匣子

- 4给定一个非空的整数数组,返回其中出现频率前 k 高的元素。(PHP)_给定一个非空的整数数组,请编程返回其中出现频率前k高的元素

- 5【转载】flink 在 flink standalone模式下元空间内存溢出排查及问题解决_元空间内存溢出解决问题

- 6简单操作让你的网站不受恶意流量恶意爬虫威胁!Cloudflare防火墙部署指南_cloudflare部署

- 7gStore入选BenchCouncil年度世界开源系统杰出成果

- 8CORS跨域问题(前后端全栈解决方式讲解)_后端在本地运行前端代码cors

- 9rabbitMq确认机制之ConfirmType_publisher-confirm-type

- 10【WFA】【WIFI6】HE-5.31.2_6G Fail_wifi 测试 data capture fail

当前位置: article > 正文

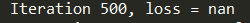

loss=nan解决办法_lora训练loss=nan

作者:Gausst松鼠会 | 2024-05-24 15:04:50

赞

踩

lora训练loss=nan

训练网络时出现loss=nan的情况,caffe不会报错,但是显然这样是不对的。

将solver.prototxt文件中的base_lr减小一点之后,这个问题就不再出现了。我一般先将base_lr降为原来的0.1倍,一般这样就可以了,如果实在不行的话就再降10倍。

好像知道为什么这样就可以,learning rate到底是怎么影响整个网络的捏?

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Gausst松鼠会/article/detail/617944

推荐阅读

相关标签