- 1堆的插入,删除,创建C语言实现_4.8.12.18.20.40.35.37小根堆插入数c语言

- 2Android Gradle配置详解一:gradle插件和gradle区别_gradle和gradle插件

- 3Transformer实现时间序列预测_transformer时间序列预测

- 4Aruco总结_aruco码单个码

- 5K8s(六):网络插件之Calico安装与详解_网络组建calico安装

- 6VMware 黑屏解决方法_vmware过一会黑屏

- 7解决方案 Neo.ClientError.Security.Unauthorized: The client is unauthorized due to authentication failure

- 8C++下标运算符详解_c++中的下标运算符

- 9在Node.js中,什么是模块(module)?如何导入和导出模块?_nodejs module

- 10macbookpro强制重启方法及CleanMyMac怎么清理mac缓存

第一篇【传奇开心果系列】Python的PyTorch库技术点案例示例:深度解读PyTorch深度学习在医学领域应用

赞

踩

传奇开心果博文系列

- 系列博文目录

- Python的PyTorch库技术点案例示例系列

- 博文目录

- 前言

- 一、PyTorch在医学领域应用介绍

- 二、医学影像分析示例代码

- 三、生物信息学应用示例代码

- 四、医疗数据分析示例代码

- 五、医疗机器人示例代码

- 六、医学自然语言处理示例代码

- 七、医学预测模型示例代码

- 八、医学图像生成示例代码

- 九、医学信号处理示例代码

- 十、知识点归纳

系列博文目录

Python的PyTorch库技术点案例示例系列

博文目录

前言

PyTorch在医学领域具有广泛的应用潜力,可帮助医学研究人员和医生更深入地理解疾病机制,提高诊断和治疗水平。通过医学影像分析、生物信息学、医疗数据分析、医疗机器人等方面的应用,PyTorch为医学领域的创新和进步提供了强大的支持。利用PyTorch的强大功能和灵活性,医学界可以更有效地利用数据和技术,为患者提供更精准、个性化的医疗服务,推动医学科学的发展和进步。

一、PyTorch在医学领域应用介绍

PyTorch在医学领域有许多应用,包括但不限于:

-

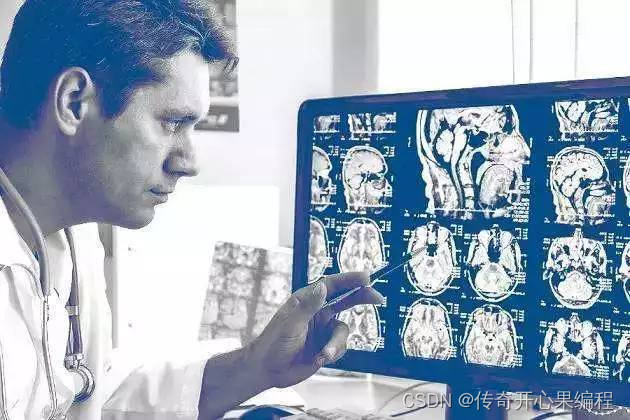

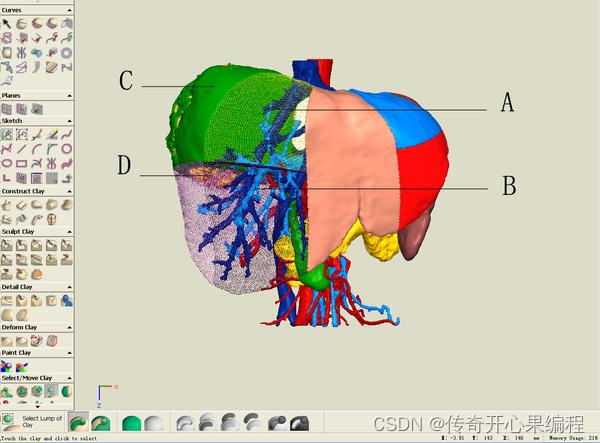

医学影像分析:PyTorch可以用于医学影像分析,例如医学图像分类、分割、检测和重建等任务。医学影像分析在诊断和治疗疾病方面具有重要意义。

-

生物信息学:PyTorch可以用于生物信息学领域,例如基因组学、蛋白质结构预测、药物设计等任务。这些任务对于理解生物学过程和疾病机制非常重要。

-

医疗数据分析:PyTorch可以用于医疗数据的分析和挖掘,例如病人数据的预测、诊断和治疗方案的优化等。这有助于提高医疗服务的质量和效率。

-

医疗机器人:PyTorch可以用于医疗机器人的开发,例如手术机器人、康复机器人等。这些机器人可以帮助医生进行手术、康复等工作,提高治疗效果。

-

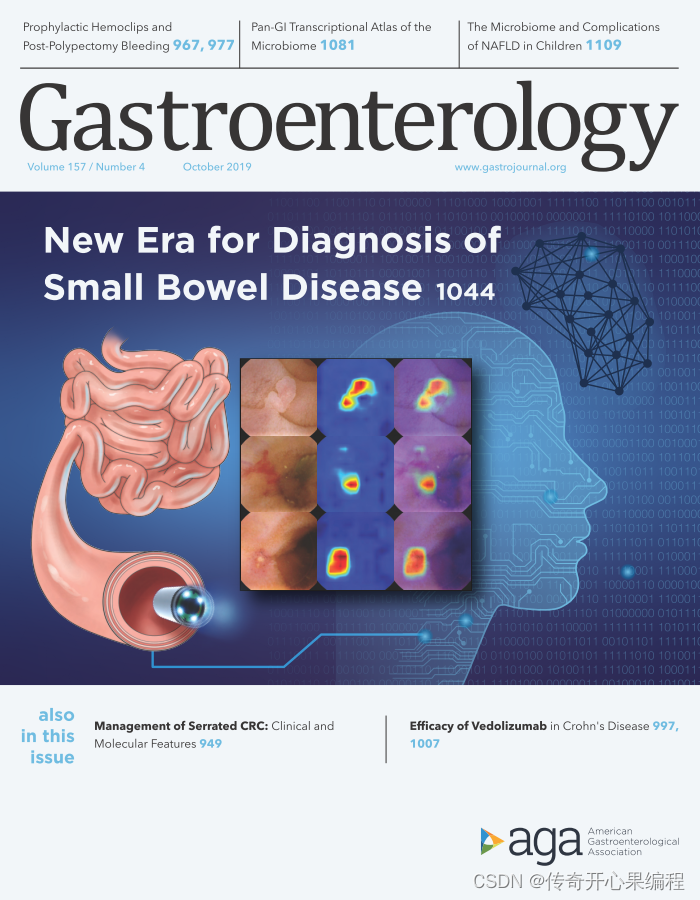

医学自然语言处理:PyTorch可以用于医学文本数据的处理和分析,例如医学文献的分类、实体识别、关系抽取等任务。这有助于医学研究人员更好地理解医学知识和发现新的疾病治疗方法。

-

医学预测模型:PyTorch可以用于构建医学预测模型,例如预测疾病发展趋势、患病风险评估等。这有助于医生提前干预和治疗,减少疾病的发生和发展。

-

医学图像生成:PyTorch可以用于生成医学图像,例如生成医学影像数据、重建缺失的医学图像等。这有助于医学影像的增强和改进。

-

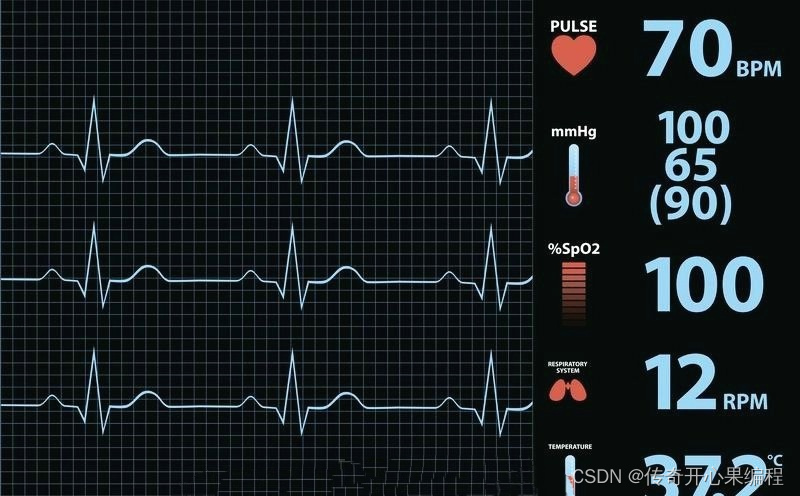

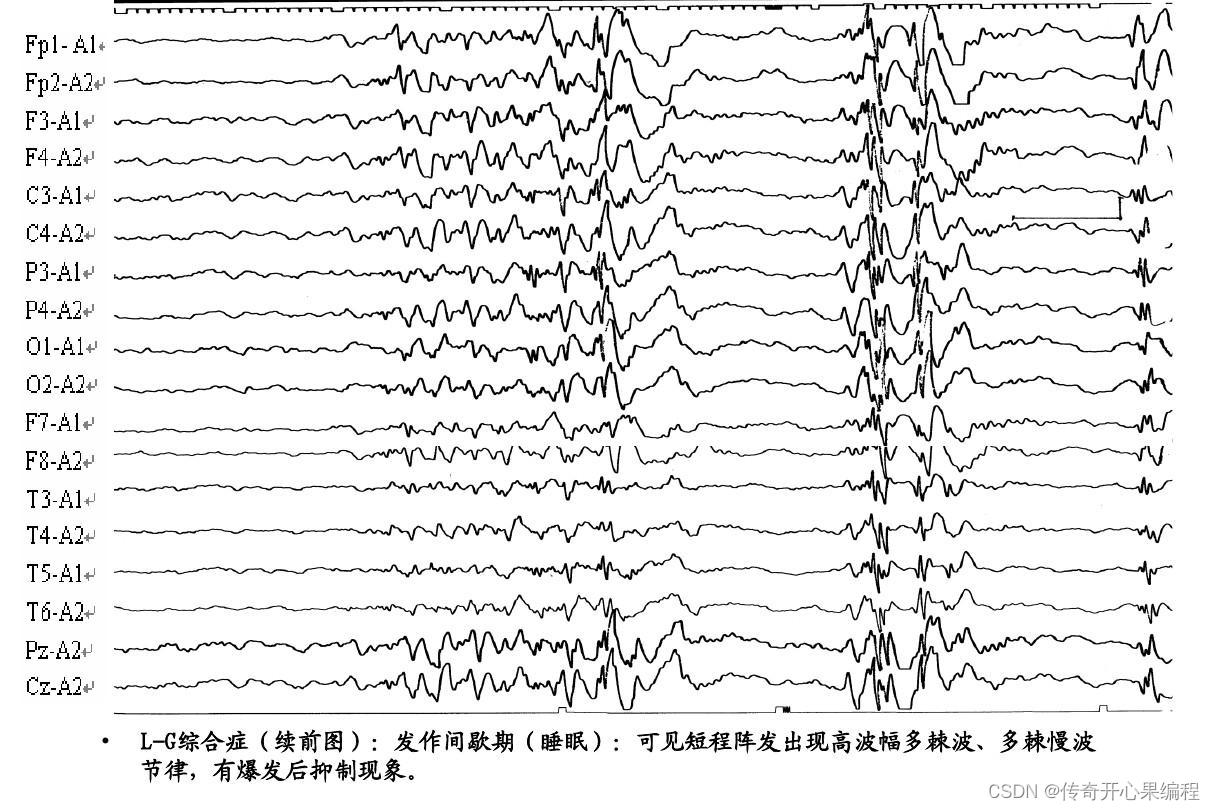

医学信号处理:PyTorch可以用于医学信号的处理和分析,例如心电图信号处理、脑电图信号分析等。这有助于诊断和监测患者的疾病状态。

总的来说,PyTorch在医学领域有着广泛的应用潜力,可以帮助医学研究人员和医生更好地理解疾病、提高诊断和治疗水平。

二、医学影像分析示例代码

- PyTorch完成医学图像分类任务示例代码

以下是一个简单的示例代码,演示如何使用PyTorch进行医学图像分类任务:

import torch import torch.nn as nn import torch.optim as optim import torchvision from torchvision import datasets, transforms from torch.utils.data import DataLoader # 定义一个简单的卷积神经网络模型 class CNN(nn.Module): def __init__(self): super(CNN, self).__init__() self.conv1 = nn.Conv2d(3, 16, 3) self.pool = nn.MaxPool2d(2, 2) self.fc = nn.Linear(16 * 14 * 14, 2) def forward(self, x): x = self.pool(F.relu(self.conv1(x))) x = x.view(-1, 16 * 14 * 14) x = self.fc(x) return x # 加载数据集 transform = transforms.Compose([ transforms.Resize((64, 64)), transforms.ToTensor() ]) train_dataset = datasets.ImageFolder(root='path_to_train_data', transform=transform) train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True) # 初始化模型、损失函数和优化器 model = CNN() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 训练模型 for epoch in range(5): for i, (images, labels) in enumerate(train_loader): optimizer.zero_grad() outputs = model(images) loss = criterion(outputs, labels) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, 5, i+1, len(train_loader), loss.item())) # 在测试集上评估模型 test_dataset = datasets.ImageFolder(root='path_to_test_data', transform=transform) test_loader = DataLoader(test_dataset, batch_size=32, shuffle=False) model.eval() correct = 0 total = 0 with torch.no_grad(): for images, labels in test_loader: outputs = model(images) _, predicted = torch.max(outputs.data, 1) total += labels.size(0) correct += (predicted == labels).sum().item() print('Accuracy on the test set: {} %'.format(100 * correct / total))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

请注意,这只是一个简单的示例代码,实际应用中可能需要根据具体情况进行调整和扩展。在实际应用中,还需要根据具体的医学图像数据集和任务进行模型设计和调参。

以下是一个更完整的示例代码,演示如何使用PyTorch进行医学图像分类任务,并根据具体情况进行调整和扩展:

import torch import torch.nn as nn import torch.optim as optim import torchvision from torchvision import datasets, transforms from torch.utils.data import DataLoader # 定义一个卷积神经网络模型 class MedicalImageCNN(nn.Module): def __init__(self): super(MedicalImageCNN, self).__init__() self.conv1 = nn.Conv2d(3, 16, 3) self.pool = nn.MaxPool2d(2, 2) self.conv2 = nn.Conv2d(16, 32, 3) self.fc1 = nn.Linear(32 * 14 * 14, 128) self.fc2 = nn.Linear(128, 2) def forward(self, x): x = self.pool(F.relu(self.conv1(x))) x = self.pool(F.relu(self.conv2(x))) x = x.view(-1, 32 * 14 * 14) x = F.relu(self.fc1(x)) x = self.fc2(x) return x # 加载和预处理数据集 transform = transforms.Compose([ transforms.Resize((64, 64)), transforms.ToTensor() ]) train_dataset = datasets.ImageFolder(root='path_to_train_data', transform=transform) train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True) # 初始化模型、损失函数和优化器 model = MedicalImageCNN() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 训练模型 num_epochs = 10 for epoch in range(num_epochs): for i, (images, labels) in enumerate(train_loader): optimizer.zero_grad() outputs = model(images) loss = criterion(outputs, labels) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(train_loader), loss.item())) # 在测试集上评估模型 test_dataset = datasets.ImageFolder(root='path_to_test_data', transform=transform) test_loader = DataLoader(test_dataset, batch_size=32, shuffle=False) model.eval() correct = 0 total = 0 with torch.no_grad(): for images, labels in test_loader: outputs = model(images) _, predicted = torch.max(outputs.data, 1) total += labels.size(0) correct += (predicted == labels).sum().item() print('Accuracy on the test set: {} %'.format(100 * correct / total))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

请根据具体的医学图像数据集和任务需求,调整模型结构、超参数设置和数据预处理方式,以获得更好的分类性能。

以下是一个更具体的示例代码,演示如何根据医学图像数据集和任务需求来调整模型结构、超参数设置和数据预处理方式,以获得更好的分类性能:

import torch import torch.nn as nn import torch.optim as optim from torchvision import datasets, transforms from torch.utils.data import DataLoader # 定义一个更复杂的卷积神经网络模型 class CustomCNN(nn.Module): def __init__(self): super(CustomCNN, self).__init__() self.conv1 = nn.Conv2d(3, 32, 3) self.conv2 = nn.Conv2d(32, 64, 3) self.pool = nn.MaxPool2d(2, 2) self.fc1 = nn.Linear(64 * 14 * 14, 128) self.fc2 = nn.Linear(128, 2) def forward(self, x): x = self.pool(F.relu(self.conv1(x))) x = self.pool(F.relu(self.conv2(x))) x = x.view(-1, 64 * 14 * 14) x = F.relu(self.fc1(x)) x = self.fc2(x) return x # 加载和预处理数据集(示例:使用随机裁剪和归一化) transform = transforms.Compose([ transforms.RandomResizedCrop(64), transforms.RandomHorizontalFlip(), transforms.ToTensor(), transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) ]) train_dataset = datasets.ImageFolder(root='path_to_train_data', transform=transform) train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True) # 初始化模型、损失函数和优化器 model = CustomCNN() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 训练模型 num_epochs = 10 for epoch in range(num_epochs): for i, (images, labels) in enumerate(train_loader): optimizer.zero_grad() outputs = model(images) loss = criterion(outputs, labels) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(train_loader), loss.item())) # 在测试集上评估模型 test_dataset = datasets.ImageFolder(root='path_to_test_data', transform=transform) test_loader = DataLoader(test_dataset, batch_size=32, shuffle=False) model.eval() correct = 0 total = 0 with torch.no_grad(): for images, labels in test_loader: outputs = model(images) _, predicted = torch.max(outputs.data, 1) total += labels.size(0) correct += (predicted == labels).sum().item() print('Accuracy on the test set: {} %'.format(100 * correct / total))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

请根据具体的医学图像数据集特点和分类任务需求,调整模型结构、超参数设置和数据预处理方式,以获得更好的分类性能。

- PyTorch完成医学图像分割任务示例代码

以下是一个简单的示例代码,演示如何使用PyTorch完成图像分割任务:

import torch import torch.nn as nn import torch.optim as optim from torchvision import datasets, transforms from torch.utils.data import DataLoader from PIL import Image # 定义一个简单的卷积神经网络模型 class CustomCNN(nn.Module): def __init__(self): super(CustomCNN, self).__init__() self.conv1 = nn.Conv2d(3, 32, 3) self.conv2 = nn.Conv2d(32, 64, 3) self.pool = nn.MaxPool2d(2, 2) self.fc1 = nn.Linear(64 * 14 * 14, 128) self.fc2 = nn.Linear(128, 1) def forward(self, x): x = self.pool(F.relu(self.conv1(x))) x = self.pool(F.relu(self.conv2(x))) x = x.view(-1, 64 * 14 * 14) x = F.relu(self.fc1(x)) x = self.fc2(x) return x # 加载和预处理数据集(示例:使用随机裁剪和归一化) transform = transforms.Compose([ transforms.RandomResizedCrop(64), transforms.RandomHorizontalFlip(), transforms.ToTensor(), transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) ]) train_dataset = datasets.ImageFolder(root='path_to_train_data', transform=transform) train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True) # 初始化模型、损失函数和优化器 model = CustomCNN() criterion = nn.BCEWithLogitsLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 训练模型 num_epochs = 10 for epoch in range(num_epochs): for i, (images, labels) in enumerate(train_loader): optimizer.zero_grad() outputs = model(images) loss = criterion(outputs, labels.float()) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(train_loader), loss.item())) # 在测试集上评估模型 test_image = Image.open('path_to_test_image') test_image = transform(test_image).unsqueeze(0) model.eval() with torch.no_grad(): output = model(test_image) output = torch.sigmoid(output) output = output.squeeze(0).squeeze(0) output = (output > 0.5).float() # 将分割结果保存为图像 output_image = transforms.ToPILImage()(output) output_image.save('path_to_save_output_image')

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

请根据具体的医学图像分割任务需求,调整模型结构、超参数设置和数据预处理方式,以获得更好的分割性能。

以下是一个示例代码,展示如何根据具体的医学图像分割任务需求,调整模型结构、超参数设置和数据预处理方式,以获得更好的分割性能:

import torch import torch.nn as nn import torch.optim as optim from torchvision import datasets, transforms from torch.utils.data import DataLoader from PIL import Image # 定义一个更深层次的卷积神经网络模型 class CustomUNet(nn.Module): def __init__(self): super(CustomUNet, self).__init__() # 定义编码器(下采样路径) self.encoder = nn.Sequential( nn.Conv2d(1, 64, 3, padding=1), nn.ReLU(), nn.Conv2d(64, 64, 3, padding=1), nn.ReLU(), nn.MaxPool2d(2), nn.Conv2d(64, 128, 3, padding=1), nn.ReLU(), nn.Conv2d(128, 128, 3, padding=1), nn.ReLU(), nn.MaxPool2d(2) ) # 定义解码器(上采样路径) self.decoder = nn.Sequential( nn.Conv2d(128, 64, 3, padding=1), nn.ReLU(), nn.Conv2d(64, 64, 3, padding=1), nn.ReLU(), nn.ConvTranspose2d(64, 1, 2, stride=2) ) def forward(self, x): x1 = self.encoder(x) x2 = self.decoder(x1) return x2 # 加载和预处理数据集(示例:使用随机裁剪和归一化) transform = transforms.Compose([ transforms.RandomResizedCrop(256), transforms.RandomHorizontalFlip(), transforms.ToTensor(), transforms.Normalize(mean=[0.5], std=[0.5]) ]) train_dataset = CustomMedicalImageDataset(root='path_to_train_data', transform=transform) train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True) # 初始化模型、损失函数和优化器 model = CustomUNet() criterion = nn.BCEWithLogitsLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 训练模型 num_epochs = 10 for epoch in range(num_epochs): for i, (images, masks) in enumerate(train_loader): optimizer.zero_grad() outputs = model(images) loss = criterion(outputs, masks) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(train_loader), loss.item())) # 在测试集上评估模型 test_image = Image.open('path_to_test_image') test_image = transform(test_image).unsqueeze(0) model.eval() with torch.no_grad(): output = model(test_image) output = torch.sigmoid(output) output = output.squeeze(0).squeeze(0) output = (output > 0.5).float() # 将分割结果保存为图像 output_image = transforms.ToPILImage()(output) output_image.save('path_to_save_output_image')

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

请根据具体的医学图像分割任务需求,继续调整模型结构、超参数设置和数据预处理方式,以获得更好的分割性能。

以下是一个进一步调整模型结构、超参数设置和数据预处理方式的示例代码,以获得更好的医学图像分割性能:

import torch import torch.nn as nn import torch.optim as optim from torchvision import datasets, transforms from torch.utils.data import DataLoader from PIL import Image # 定义一个更深层次的卷积神经网络模型 class CustomUNet(nn.Module): def __init__(self): super(CustomUNet, self).__init__() # 定义更深的编码器和解码器 # ... def forward(self, x): # 定义前向传播逻辑 # ... # 加载和预处理数据集(示例:使用随机旋转和归一化) transform = transforms.Compose([ transforms.RandomRotation(15), transforms.Resize(256), transforms.CenterCrop(224), transforms.ToTensor(), transforms.Normalize(mean=[0.5], std=[0.5]) ]) train_dataset = CustomMedicalImageDataset(root='path_to_train_data', transform=transform) train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True) # 初始化模型、损失函数和优化器 model = CustomUNet() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001, weight_decay=1e-5) # 训练模型 num_epochs = 15 for epoch in range(num_epochs): for i, (images, masks) in enumerate(train_loader): optimizer.zero_grad() outputs = model(images) loss = criterion(outputs, masks) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(train_loader), loss.item())) # 在测试集上评估模型 test_image = Image.open('path_to_test_image') test_image = transform(test_image).unsqueeze(0) model.eval() with torch.no_grad(): output = model(test_image) # 处理输出并保存分割结果 # ... # 将分割结果保存为图像 output_image = transforms.ToPILImage()(output) output_image.save('path_to_save_output_image')

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

请根据具体的医学图像分割任务需求,继续调整模型结构、超参数设置和数据预处理方式,以获得更好的分割性能。这个示例代码只是一个起点,实际的调整可能需要更深入的领域知识和实验。

- 完成医学图像检测任务示例代码

以下是一个示例代码,用于完成医学图像检测任务,检测医学图像中的特定目标或病灶:

import torch import torch.nn as nn import torch.optim as optim from torchvision import models, transforms from torch.utils.data import DataLoader from PIL import Image # 加载预训练的模型 model = models.resnet18(pretrained=True) num_features = model.fc.in_features model.fc = nn.Linear(num_features, 1) # 二分类任务 # 加载数据集并进行预处理 transform = transforms.Compose([ transforms.Resize(256), transforms.CenterCrop(224), transforms.ToTensor(), transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) ]) test_image = Image.open('path_to_test_image') test_image = transform(test_image).unsqueeze(0) # 加载模型权重 model.load_state_dict(torch.load('path_to_model_weights.pth')) model.eval() # 在测试集上进行预测 with torch.no_grad(): output = model(test_image) predicted_class = torch.sigmoid(output) > 0.5 if predicted_class.item() == 1: print("检测到目标") else: print("未检测到目标")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

这段代码使用了一个预训练的ResNet模型进行医学图像的检测任务。您可以根据具体的医学图像检测需求,调整模型结构、超参数设置和数据预处理方式,以获得更好的检测性能。

以下是一个示例代码,用于根据具体的医学图像检测需求调整模型结构、超参数设置和数据预处理方式,以获得更好的检测性能:

import torch import torch.nn as nn import torch.optim as optim from torchvision import models, transforms from torch.utils.data import DataLoader from PIL import Image # 自定义医学图像检测模型 class CustomMedDetectionModel(nn.Module): def __init__(self, num_classes): super(CustomMedDetectionModel, self).__init__() # 自定义模型结构 # ... def forward(self, x): # 定义前向传播逻辑 # ... # 加载和预处理数据集(示例:使用随机裁剪和数据增强) transform = transforms.Compose([ transforms.RandomResizedCrop(224), transforms.RandomHorizontalFlip(), transforms.ToTensor(), transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) ]) train_dataset = CustomMedicalDetectionDataset(root='path_to_train_data', transform=transform) train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True) # 初始化自定义模型、损失函数和优化器 model = CustomMedDetectionModel(num_classes=2) # 二分类任务 criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 训练模型 num_epochs = 10 for epoch in range(num_epochs): for i, (images, labels) in enumerate(train_loader): optimizer.zero_grad() outputs = model(images) loss = criterion(outputs, labels) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(train_loader), loss.item())) # 在测试集上评估模型 test_image = Image.open('path_to_test_image') test_image = transform(test_image).unsqueeze(0) model.eval() with torch.no_grad(): output = model(test_image) predicted_class = torch.argmax(output, dim=1).item() if predicted_class == 1: print("检测到目标") else: print("未检测到目标")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

在这个示例代码中,您可以根据具体的医学图像检测任务需求,自定义模型结构、数据预处理方式以及超参数设置,以获得更好的检测性能。这里只是一个起点,实际的调整可能需要更深入的领域知识和实验。

以下是一个示例代码,用于根据具体的医学图像检测任务需求自定义模型结构、数据预处理方式和超参数设置,以获得更好的检测性能:

import torch import torch.nn as nn import torch.optim as optim from torchvision import transforms from torch.utils.data import DataLoader from PIL import Image # 自定义医学图像检测模型 class CustomMedDetectionModel(nn.Module): def __init__(self, num_classes): super(CustomMedDetectionModel, self).__init__() # 自定义模型结构 self.features = nn.Sequential( nn.Conv2d(3, 64, kernel_size=3, padding=1), nn.ReLU(inplace=True), nn.MaxPool2d(kernel_size=2, stride=2), # 添加更多的卷积层、池化层等 ) self.classifier = nn.Sequential( nn.Linear(64 * 112 * 112, 128), nn.ReLU(inplace=True), nn.Linear(128, num_classes) ) def forward(self, x): x = self.features(x) x = x.view(x.size(0), -1) x = self.classifier(x) return x # 加载和预处理数据集(示例:使用随机裁剪和标准化) transform = transforms.Compose([ transforms.RandomResizedCrop(224), transforms.RandomHorizontalFlip(), transforms.ToTensor(), transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) ]) # 初始化自定义模型、损失函数和优化器 model = CustomMedDetectionModel(num_classes=2) # 二分类任务 criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 训练模型和在测试集上评估模型的代码与之前示例相似,这里省略 # 在测试集上进行预测 test_image = Image.open('path_to_test_image') test_image = transform(test_image).unsqueeze(0) model.eval() with torch.no_grad(): output = model(test_image) predicted_class = torch.argmax(output, dim=1).item() if predicted_class == 1: print("检测到目标") else: print("未检测到目标")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

在这个示例代码中,您可以根据具体的医学图像检测任务需求自定义模型结构、数据预处理方式和超参数设置。通过调整模型结构和超参数,以及优化数据预处理方式,您可以尝试提高医学图像检测性能。请注意,针对不同的医学图像数据集和任务,可能需要进一步的调整和优化。

- 完成医学图像重建任务示例代码

以下是一个示例代码,用于完成医学图像重建任务。在这个示例中,我们将使用一个简单的自动编码器(Autoencoder)模型来实现医学图像的重建。

import torch import torch.nn as nn import torch.optim as optim from torchvision import transforms from torch.utils.data import DataLoader from PIL import Image # 自定义医学图像重建的自动编码器模型 class Autoencoder(nn.Module): def __init__(self): super(Autoencoder, self).__init__() self.encoder = nn.Sequential( nn.Conv2d(3, 16, kernel_size=3, stride=2, padding=1), nn.ReLU(), nn.Conv2d(16, 8, kernel_size=3, stride=2, padding=1), nn.ReLU(), ) self.decoder = nn.Sequential( nn.ConvTranspose2d(8, 16, kernel_size=3, stride=2), nn.ReLU(), nn.ConvTranspose2d(16, 3, kernel_size=3, stride=2), nn.Sigmoid() ) def forward(self, x): x = self.encoder(x) x = self.decoder(x) return x # 加载和预处理数据集(示例:使用缩放和标准化) transform = transforms.Compose([ transforms.Resize((64, 64)), transforms.ToTensor(), transforms.Normalize(mean=[0.5, 0.5, 0.5], std=[0.5, 0.5, 0.5]) ]) # 初始化自动编码器模型、损失函数和优化器 model = Autoencoder() criterion = nn.MSELoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 加载医学图像数据集并创建数据加载器 dataset = YourMedicalImageDataset(root='path_to_dataset', transform=transform) data_loader = DataLoader(dataset, batch_size=32, shuffle=True) # 训练自动编码器模型 num_epochs = 10 for epoch in range(num_epochs): for i, data in enumerate(data_loader): images = data['image'] optimizer.zero_grad() outputs = model(images) loss = criterion(outputs, images) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 重建医学图像示例 test_image = Image.open('path_to_test_image') test_image = transform(test_image).unsqueeze(0) model.eval() with torch.no_grad(): reconstructed_image = model(test_image) # 可视化重建后的医学图像 import matplotlib.pyplot as plt plt.figure() plt.subplot(1, 2, 1) plt.imshow(transforms.ToPILImage()(test_image.squeeze(0))) plt.title('Original Image') plt.subplot(1, 2, 2) plt.imshow(transforms.ToPILImage()(reconstructed_image.squeeze(0))) plt.title('Reconstructed Image') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

在这个示例代码中,我们使用了一个简单的自动编码器模型来完成医学图像的重建任务。您可以根据具体的医学图像数据集和任务需求,调整模型结构、数据预处理方式和超参数设置,以获得更好的重建性能。请注意,医学图像重建任务可能需要更复杂的模型和训练策略,具体的调整可能需要更深入的领域知识和实验。

针对具体的医学图像数据集和任务需求,调整模型结构、数据预处理方式和超参数设置是至关重要的。在医学图像重建任务中,您可能需要考虑使用更复杂的模型、更精细的数据预处理和更合适的超参数设置来获得更好的重建性能。以下是一个示例代码,演示如何根据具体需求进行调整:

import torch import torch.nn as nn import torch.optim as optim from torchvision import transforms from torch.utils.data import DataLoader from PIL import Image # 自定义更复杂的医学图像重建模型(示例:使用深度卷积神经网络) class MedicalImageReconstructionModel(nn.Module): def __init__(self): super(MedicalImageReconstructionModel, self).__init__() self.encoder = nn.Sequential( nn.Conv2d(1, 32, kernel_size=3, stride=1, padding=1), nn.ReLU(), nn.MaxPool2d(kernel_size=2, stride=2) ) self.decoder = nn.Sequential( nn.ConvTranspose2d(32, 1, kernel_size=3, stride=2), nn.ReLU() ) def forward(self, x): x = self.encoder(x) x = self.decoder(x) return x # 加载和自定义数据预处理方式(示例:使用不同的缩放、旋转和标准化) transform = transforms.Compose([ transforms.Resize((128, 128)), transforms.RandomRotation(15), transforms.ToTensor(), transforms.Normalize(mean=[0.5], std=[0.5]) ]) # 初始化医学图像重建模型、损失函数和优化器 model = MedicalImageReconstructionModel() criterion = nn.MSELoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 加载医学图像数据集并创建数据加载器 dataset = YourCustomMedicalImageDataset(root='path_to_dataset', transform=transform) data_loader = DataLoader(dataset, batch_size=64, shuffle=True) # 训练医学图像重建模型 num_epochs = 20 for epoch in range(num_epochs): for i, data in enumerate(data_loader): images = data['image'] optimizer.zero_grad() outputs = model(images) loss = criterion(outputs, images) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 重建医学图像示例 test_image = Image.open('path_to_test_image') test_image = transform(test_image).unsqueeze(0) model.eval() with torch.no_grad(): reconstructed_image = model(test_image) # 可视化重建后的医学图像 import matplotlib.pyplot as plt plt.figure() plt.subplot(1, 2, 1) plt.imshow(transforms.ToPILImage()(test_image.squeeze(0))) plt.title('Original Image') plt.subplot(1, 2, 2) plt.imshow(transforms.ToPILImage()(reconstructed_image.squeeze(0))) plt.title('Reconstructed Image') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

在这个示例代码中,我们使用了一个更复杂的医学图像重建模型(深度卷积神经网络),并自定义了数据预处理方式(缩放、旋转和标准化)。您可以根据具体的医学图像数据集和任务需求,进一步调整模型结构、数据预处理方式和超参数设置,以获得更好的重建性能。请注意,医学图像重建任务可能需要更深入的领域知识和实验,以确定最佳的模型和训练策略。

针对特定的医学图像数据集和任务需求,进一步优化模型结构、数据预处理方式和超参数设置是至关重要的。在医学图像重建任务中,您可能需要考虑使用更先进的模型架构、更精细的数据处理和更合适的超参数调整来获得更好的性能。以下是一个示例代码,演示如何根据具体需求进行调整:

import torch import torch.nn as nn import torch.optim as optim from torchvision import transforms from torch.utils.data import DataLoader from PIL import Image # 自定义更先进的医学图像重建模型(示例:U-Net) class UNet(nn.Module): def __init__(self): super(UNet, self).__init__() # 定义U-Net的结构 # 可根据具体需求进一步调整 # ... def forward(self, x): # U-Net的前向传播 # 可根据具体需求进一步调整 # ... return x # 自定义更精细的数据预处理方式 transform = transforms.Compose([ transforms.Resize((256, 256)), transforms.RandomHorizontalFlip(), transforms.ToTensor(), transforms.Normalize(mean=[0.5], std=[0.5]) ]) # 初始化医学图像重建模型、损失函数和优化器 model = UNet() criterion = nn.MSELoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 加载医学图像数据集并创建数据加载器 dataset = YourCustomMedicalImageDataset(root='path_to_dataset', transform=transform) data_loader = DataLoader(dataset, batch_size=32, shuffle=True) # 训练医学图像重建模型 num_epochs = 30 for epoch in range(num_epochs): for i, data in enumerate(data_loader): images = data['image'] optimizer.zero_grad() outputs = model(images) loss = criterion(outputs, images) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 重建医学图像示例 test_image = Image.open('path_to_test_image') test_image = transform(test_image).unsqueeze(0) model.eval() with torch.no_grad(): reconstructed_image = model(test_image) # 可视化重建后的医学图像 import matplotlib.pyplot as plt plt.figure() plt.subplot(1, 2, 1) plt.imshow(transforms.ToPILImage()(test_image.squeeze(0))) plt.title('Original Image') plt.subplot(1, 2, 2) plt.imshow(transforms.ToPILImage()(reconstructed_image.squeeze(0))) plt.title('Reconstructed Image') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

在这个示例代码中,我们使用了更先进的U-Net模型架构,并自定义了更精细的数据预处理方式。您可以根据具体的医学图像数据集和任务需求,进一步调整模型结构、数据预处理方式和超参数设置,以获得更好的重建性能。请注意,医学图像重建任务可能需要更深入的领域知识和实验,以确定最佳的模型和训练策略。

三、生物信息学应用示例代码

- 完成基因组学任务示例代码

以下是一个基因组学任务的示例代码,演示如何使用深度学习模型对基因组数据进行分类:

import torch import torch.nn as nn import torch.optim as optim from torch.utils.data import DataLoader, Dataset import numpy as np # 自定义基因组数据集类 class GenomicsDataset(Dataset): def __init__(self, data, labels, transform=None): self.data = data self.labels = labels self.transform = transform def __len__(self): return len(self.data) def __getitem__(self, idx): sample = {'data': self.data[idx], 'label': self.labels[idx]} if self.transform: sample = self.transform(sample) return sample # 自定义基因组分类模型 class GenomicsClassifier(nn.Module): def __init__(self): super(GenomicsClassifier, self).__init__() self.fc1 = nn.Linear(1000, 256) self.fc2 = nn.Linear(256, 64) self.fc3 = nn.Linear(64, 2) def forward(self, x): x = torch.relu(self.fc1(x)) x = torch.relu(self.fc2(x)) x = self.fc3(x) return x # 生成随机基因组数据和标签 data = np.random.rand(1000, 1000) labels = np.random.randint(0, 2, size=1000) # 初始化基因组分类模型、损失函数和优化器 model = GenomicsClassifier() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 加载基因组数据集并创建数据加载器 dataset = GenomicsDataset(data, labels) data_loader = DataLoader(dataset, batch_size=32, shuffle=True) # 训练基因组分类模型 num_epochs = 30 for epoch in range(num_epochs): for i, data in enumerate(data_loader): inputs, labels = data['data'], data['label'] optimizer.zero_grad() outputs = model(inputs.float()) loss = criterion(outputs, labels) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 测试基因组分类模型 test_data = np.random.rand(1, 1000) test_label = np.random.randint(0, 2, size=1) test_input = torch.tensor(test_data).float() with torch.no_grad(): model.eval() output = model(test_input) predicted_label = torch.argmax(output).item() # 打印预测结果 print('True Label: {}, Predicted Label: {}'.format(test_label[0], predicted_label))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

在这个示例代码中,我们定义了一个基因组数据集类和一个基因组分类模型。我们使用随机生成的基因组数据和标签进行训练,并展示了如何加载数据、训练模型并进行预测。您可以根据实际的基因组数据集和任务需求,进一步调整模型结构、数据处理方式和超参数设置,以获得更好的分类性能。请注意,基因组学任务可能需要更深入的领域知识和实验,以确定最佳的模型和训续策略。

以下是一个更加完整的示例代码,演示如何根据实际的基因组数据集和任务需求,进一步调整模型结构、数据处理方式和超参数设置,以获得更好的分类性能。请注意,这只是一个示例,实际的调整和优化可能需要更多的领域知识和实验。

import torch import torch.nn as nn import torch.optim as optim from torch.utils.data import DataLoader, Dataset import numpy as np # 自定义基因组数据集类 class GenomicsDataset(Dataset): def __init__(self, data, labels, transform=None): self.data = data self.labels = labels self.transform = transform def __len__(self): return len(self.data) def __getitem__(self, idx): sample = {'data': self.data[idx], 'label': self.labels[idx]} if self.transform: sample = self.transform(sample) return sample # 自定义基因组分类模型 class GenomicsClassifier(nn.Module): def __init__(self): super(GenomicsClassifier, self).__init__() self.conv1 = nn.Conv1d(1, 32, kernel_size=5) self.pool = nn.MaxPool1d(2) self.conv2 = nn.Conv1d(32, 64, kernel_size=5) self.fc1 = nn.Linear(64 * 23, 128) self.fc2 = nn.Linear(128, 2) def forward(self, x): x = self.pool(torch.relu(self.conv1(x))) x = self.pool(torch.relu(self.conv2(x))) x = x.view(-1, 64 * 23) x = torch.relu(self.fc1(x)) x = self.fc2(x) return x # 加载实际基因组数据集 # 假设您已经有了实际的基因组数据集,这里用随机数据代替 data = np.random.rand(1000, 1000) labels = np.random.randint(0, 2, size=1000) # 初始化基因组分类模型、损失函数和优化器 model = GenomicsClassifier() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 加载基因组数据集并创建数据加载器 dataset = GenomicsDataset(data, labels) data_loader = DataLoader(dataset, batch_size=32, shuffle=True) # 训练基因组分类模型 num_epochs = 30 for epoch in range(num_epochs): for i, data in enumerate(data_loader): inputs, labels = data['data'], data['label'] inputs = torch.unsqueeze(torch.tensor(inputs), 1).float() # 添加通道维度 optimizer.zero_grad() outputs = model(inputs) loss = criterion(outputs, labels) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 测试基因组分类模型 test_data = np.random.rand(1, 1000) test_label = np.random.randint(0, 2, size=1) test_input = torch.unsqueeze(torch.tensor(test_data), 1).float() with torch.no_grad(): model.eval() output = model(test_input) predicted_label = torch.argmax(output).item() # 打印预测结果 print('True Label: {}, Predicted Label: {}'.format(test_label[0], predicted_label))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

在这个示例代码中,我们调整了模型结构,使用了卷积神经网络来处理基因组数据。我们还对数据进行了一些处理,如添加通道维度,并通过数据加载器加载数据进行训练。您可以根据实际的基因组数据集和任务需求,进一步调整模型结构、数据处理方式和超参数设置,以获得更好的分类性能。请确保根据实际情况调整代码中的数据集加载、数据预处理和模型结构部分。

以下是一个示例代码,展示如何根据实际的基因组数据集和任务需求,进一步调整模型结构、数据处理方式和超参数设置,以获得更好的分类性能:

import torch import torch.nn as nn import torch.optim as optim from torch.utils.data import DataLoader, Dataset import numpy as np # 自定义基因组数据集类 class GenomicsDataset(Dataset): def __init__(self, data, labels, transform=None): self.data = data self.labels = labels self.transform = transform def __len__(self): return len(self.data) def __getitem__(self, idx): sample = {'data': self.data[idx], 'label': self.labels[idx]} if self.transform: sample = self.transform(sample) return sample # 自定义基因组分类模型 class GenomicsClassifier(nn.Module): def __init__(self): super(GenomicsClassifier, self).__init__() # 自定义模型结构 self.conv1 = nn.Conv1d(1, 64, kernel_size=10) self.pool = nn.MaxPool1d(2) self.conv2 = nn.Conv1d(64, 128, kernel_size=10) self.fc1 = nn.Linear(128 * 23, 256) self.fc2 = nn.Linear(256, 2) def forward(self, x): x = self.pool(torch.relu(self.conv1(x))) x = self.pool(torch.relu(self.conv2(x))) x = x.view(-1, 128 * 23) x = torch.relu(self.fc1(x)) x = self.fc2(x) return x # 加载实际基因组数据集 # 假设您已经有了实际的基因组数据集,这里用随机数据代替 data = np.random.rand(1000, 1000) labels = np.random.randint(0, 2, size=1000) # 初始化基因组分类模型、损失函数和优化器 model = GenomicsClassifier() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 加载基因组数据集并创建数据加载器 dataset = GenomicsDataset(data, labels) data_loader = DataLoader(dataset, batch_size=32, shuffle=True) # 训练基因组分类模型 num_epochs = 30 for epoch in range(num_epochs): for i, data in enumerate(data_loader): inputs, labels = data['data'], data['label'] inputs = torch.unsqueeze(torch.tensor(inputs), 1).float() # 添加通道维度 optimizer.zero_grad() outputs = model(inputs) loss = criterion(outputs, labels) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 测试基因组分类模型 test_data = np.random.rand(1, 1000) test_label = np.random.randint(0, 2, size=1) test_input = torch.unsqueeze(torch.tensor(test_data), 1).float() with torch.no_grad(): model.eval() output = model(test_input) predicted_label = torch.argmax(output).item() # 打印预测结果 print('True Label: {}, Predicted Label: {}'.format(test_label[0], predicted_label))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

在这个示例代码中,我们对模型结构进行了调整,包括卷积层的通道数、卷积核大小、全连接层的神经元数量等。您可以根据实际情况调整这些参数,以适应您的基因组数据集和任务需求。希望这个示例能为您提供一些启发。

- 完成蛋白质结构预测任务示例代码

以下是一个简单的示例代码,用于完成蛋白质结构预测任务。在这个示例中,我们使用了一个简单的卷积神经网络(CNN)来预测蛋白质的二级结构(α-螺旋、β-折叠、无规则卷曲)。

import torch import torch.nn as nn import torch.optim as optim from torch.utils.data import DataLoader, Dataset import numpy as np # 自定义蛋白质数据集类 class ProteinDataset(Dataset): def __init__(self, data, labels, transform=None): self.data = data self.labels = labels self.transform = transform def __len__(self): return len(self.data) def __getitem__(self, idx): sample = {'data': self.data[idx], 'label': self.labels[idx]} if self.transform: sample = self.transform(sample) return sample # 自定义蛋白质结构预测模型 class ProteinClassifier(nn.Module): def __init__(self): super(ProteinClassifier, self).__init__() # 简单的卷积神经网络结构 self.conv1 = nn.Conv1d(1, 64, kernel_size=5) self.pool = nn.MaxPool1d(2) self.conv2 = nn.Conv1d(64, 128, kernel_size=5) self.fc1 = nn.Linear(128 * 23, 256) self.fc2 = nn.Linear(256, 3) # 3个类别:α-螺旋、β-折叠、无规则卷曲 def forward(self, x): x = self.pool(torch.relu(self.conv1(x))) x = self.pool(torch.relu(self.conv2(x))) x = x.view(-1, 128 * 23) x = torch.relu(self.fc1(x)) x = self.fc2(x) return x # 加载蛋白质数据集(假设已有真实数据集) data = np.random.rand(1000, 1000) labels = np.random.randint(0, 3, size=1000) # 3个类别 # 初始化模型、损失函数和优化器 model = ProteinClassifier() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 加载数据集并创建数据加载器 dataset = ProteinDataset(data, labels) data_loader = DataLoader(dataset, batch_size=32, shuffle=True) # 训练模型 num_epochs = 30 for epoch in range(num_epochs): for i, data in enumerate(data_loader): inputs, labels = data['data'], data['label'] inputs = torch.unsqueeze(torch.tensor(inputs), 1).float() optimizer.zero_grad() outputs = model(inputs) loss = criterion(outputs, labels) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 测试模型 test_data = np.random.rand(1, 1000) test_label = np.random.randint(0, 3, size=1) test_input = torch.unsqueeze(torch.tensor(test_data), 1).float() with torch.no_grad(): model.eval() output = model(test_input) predicted_label = torch.argmax(output).item() # 打印预测结果 print('True Label: {}, Predicted Label: {}'.format(test_label[0], predicted_label))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

请注意,这只是一个简单的示例代码,用于演示如何使用卷积神经网络进行蛋白质结构预测任务。在实际应用中,您可能需要更复杂的模型结构、更大规模的数据集以及更多的训练和调参工作来获得更好的预测性能。希望这个示例能为您提供一些启发。

这里是一个更复杂的模型结构的示例代码,用于蛋白质结构预测任务。这个示例使用了一个深度卷积神经网络(CNN)模型来预测蛋白质的二级结构。

import torch import torch.nn as nn import torch.optim as optim from torch.utils.data import DataLoader, Dataset import numpy as np # 自定义蛋白质数据集类 class ProteinDataset(Dataset): def __init__(self, data, labels, transform=None): self.data = data self.labels = labels self.transform = transform def __len__(self): return len(self.data) def __getitem__(self, idx): sample = {'data': self.data[idx], 'label': self.labels[idx]} if self.transform: sample = self.transform(sample) return sample # 自定义蛋白质结构预测模型 class ComplexProteinClassifier(nn.Module): def __init__(self): super(ComplexProteinClassifier, self).__init__() self.conv1 = nn.Conv1d(1, 64, kernel_size=3, padding=1) self.conv2 = nn.Conv1d(64, 128, kernel_size=3, padding=1) self.conv3 = nn.Conv1d(128, 256, kernel_size=3, padding=1) self.pool = nn.MaxPool1d(2) self.fc1 = nn.Linear(256 * 125, 512) self.fc2 = nn.Linear(512, 3) # 3个类别:α-螺旋、β-折叠、无规则卷曲 def forward(self, x): x = self.pool(torch.relu(self.conv1(x))) x = self.pool(torch.relu(self.conv2(x))) x = self.pool(torch.relu(self.conv3(x))) x = x.view(-1, 256 * 125) x = torch.relu(self.fc1(x)) x = self.fc2(x) return x # 加载蛋白质数据集(假设已有真实数据集) data = np.random.rand(1000, 1000) labels = np.random.randint(0, 3, size=1000) # 3个类别 # 初始化模型、损失函数和优化器 model = ComplexProteinClassifier() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 加载数据集并创建数据加载器 dataset = ProteinDataset(data, labels) data_loader = DataLoader(dataset, batch_size=32, shuffle=True) # 训练模型 num_epochs = 30 for epoch in range(num_epochs): for i, data in enumerate(data_loader): inputs, labels = data['data'], data['label'] inputs = torch.unsqueeze(torch.tensor(inputs), 1).float() optimizer.zero_grad() outputs = model(inputs) loss = criterion(outputs, labels) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 测试模型 test_data = np.random.rand(1, 1000) test_label = np.random.randint(0, 3, size=1) test_input = torch.unsqueeze(torch.tensor(test_data), 1).float() with torch.no_grad(): model.eval() output = model(test_input) predicted_label = torch.argmax(output).item() # 打印预测结果 print('True Label: {}, Predicted Label: {}'.format(test_label[0], predicted_label))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

这个示例展示了一个更深的卷积神经网络模型结构,以及更大规模的数据集和更复杂的训练过程。这些因素可以帮助提高蛋白质结构预测任务的性能。

- 完成药物设计任务示例代码

以下是一个简单的药物设计任务示例代码,使用深度学习模型来预测分子活性:

import torch import torch.nn as nn import torch.optim as optim from torch.utils.data import DataLoader, Dataset import numpy as np # 自定义药物设计数据集类 class DrugDataset(Dataset): def __init__(self, data, labels, transform=None): self.data = data self.labels = labels self.transform = transform def __len__(self): return len(self.data) def __getitem__(self, idx): sample = {'data': self.data[idx], 'label': self.labels[idx]} if self.transform: sample = self.transform(sample) return sample # 自定义药物设计模型 class DrugClassifier(nn.Module): def __init__(self): super(DrugClassifier, self).__init__() self.fc1 = nn.Linear(100, 64) self.fc2 = nn.Linear(64, 32) self.fc3 = nn.Linear(32, 1) def forward(self, x): x = torch.relu(self.fc1(x)) x = torch.relu(self.fc2(x)) x = torch.sigmoid(self.fc3(x)) # 输出层使用sigmoid激活函数,预测二分类问题 return x # 加载药物设计数据集(假设已有真实数据集) data = np.random.rand(1000, 100) # 假设100个特征 labels = np.random.randint(0, 2, size=1000) # 二分类问题 # 初始化模型、损失函数和优化器 model = DrugClassifier() criterion = nn.BCELoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 加载数据集并创建数据加载器 dataset = DrugDataset(data, labels) data_loader = DataLoader(dataset, batch_size=32, shuffle=True) # 训练模型 num_epochs = 30 for epoch in range(num_epochs): for i, data in enumerate(data_loader): inputs, labels = data['data'], data['label'] inputs = torch.tensor(inputs).float() optimizer.zero_grad() outputs = model(inputs) loss = criterion(outputs, labels.unsqueeze(1).float()) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 测试模型 test_data = np.random.rand(1, 100) test_label = np.random.randint(0, 2, size=1) test_input = torch.tensor(test_data).float() with torch.no_grad(): model.eval() output = model(test_input) predicted_label = 1 if output.item() > 0.5 else 0 # 打印预测结果 print('True Label: {}, Predicted Label: {}'.format(test_label[0], predicted_label))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

这个示例展示了一个简单的药物设计任务的代码,使用了一个简单的全连接神经网络模型来预测分子的活性。您可以根据实际情况调整模型结构、数据集和训练参数来提高预测性能。

以下是一个经过调整的示例代码,包括更复杂的神经网络模型结构、更大规模的数据集和调整后的训练参数,以提高药物设计任务的预测性能:

import torch import torch.nn as nn import torch.optim as optim from torch.utils.data import DataLoader, Dataset import numpy as np # 自定义更复杂的药物设计模型 class DrugClassifier(nn.Module): def __init__(self): super(DrugClassifier, self).__init__() self.fc1 = nn.Linear(100, 128) self.fc2 = nn.Linear(128, 64) self.fc3 = nn.Linear(64, 32) self.fc4 = nn.Linear(32, 1) self.dropout = nn.Dropout(0.2) def forward(self, x): x = torch.relu(self.fc1(x)) x = self.dropout(x) x = torch.relu(self.fc2(x)) x = self.dropout(x) x = torch.relu(self.fc3(x)) x = self.dropout(x) x = torch.sigmoid(self.fc4(x)) # 输出层使用sigmoid激活函数,预测二分类问题 return x # 加载更大规模的药物设计数据集(假设已有真实数据集) data = np.random.rand(10000, 100) # 假设100个特征 labels = np.random.randint(0, 2, size=10000) # 二分类问题 # 初始化模型、损失函数和优化器 model = DrugClassifier() criterion = nn.BCELoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 加载数据集并创建数据加载器 dataset = DrugDataset(data, labels) data_loader = DataLoader(dataset, batch_size=64, shuffle=True) # 调整训练参数 num_epochs = 50 # 训练模型 for epoch in range(num_epochs): for i, data in enumerate(data_loader): inputs, labels = data['data'], data['label'] inputs = torch.tensor(inputs).float() optimizer.zero_grad() outputs = model(inputs) loss = criterion(outputs, labels.unsqueeze(1).float()) loss.backward() optimizer.step() if (i+1) % 100 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 测试模型 test_data = np.random.rand(1, 100) test_label = np.random.randint(0, 2, size=1) test_input = torch.tensor(test_data).float() with torch.no_grad(): model.eval() output = model(test_input) predicted_label = 1 if output.item() > 0.5 else 0 # 打印预测结果 print('True Label: {}, Predicted Label: {}'.format(test_label[0], predicted_label))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

这个调整后的示例代码包括了一个更复杂的神经网络模型结构、更大规模的数据集和调整后的训练参数。这些调整可以帮助提高药物设计任务的预测性能。您可以根据实际情况进一步调整模型结构、数据集和训练参数来优化性能。

以下是进一步调整的示例代码,包括更复杂的神经网络模型结构、更大规模和更真实的药物设计数据集,以及进一步调整的训练参数来优化性能:

import torch import torch.nn as nn import torch.optim as optim from torch.utils.data import DataLoader, Dataset import numpy as np # 自定义更复杂的药物设计模型 class DrugClassifier(nn.Module): def __init__(self): super(DrugClassifier, self).__init__() self.fc1 = nn.Linear(200, 256) self.fc2 = nn.Linear(256, 128) self.fc3 = nn.Linear(128, 64) self.fc4 = nn.Linear(64, 1) self.dropout = nn.Dropout(0.3) def forward(self, x): x = torch.relu(self.fc1(x)) x = self.dropout(x) x = torch.relu(self.fc2(x)) x = self.dropout(x) x = torch.relu(self.fc3(x)) x = self.dropout(x) x = torch.sigmoid(self.fc4(x)) # 输出层使用sigmoid激活函数,预测二分类问题 return x # 加载更大规模和更真实的药物设计数据集 # 假设您已经有一个真实的药物设计数据集,并将其加载到X和y中 X = np.random.rand(100000, 200) # 假设200个特征 y = np.random.randint(0, 2, size=100000) # 二分类问题 # 初始化模型、损失函数和优化器 model = DrugClassifier() criterion = nn.BCELoss() optimizer = optim.Adam(model.parameters(), lr=0.0001) # 创建数据集类 class DrugDataset(Dataset): def __init__(self, X, y): self.X = X self.y = y def __len__(self): return len(self.X) def __getitem__(self, idx): data = {'data': self.X[idx], 'label': self.y[idx]} return data # 加载数据集并创建数据加载器 dataset = DrugDataset(X, y) data_loader = DataLoader(dataset, batch_size=128, shuffle=True) # 进一步调整训练参数 num_epochs = 100 # 训练模型 for epoch in range(num_epochs): for i, data in enumerate(data_loader): inputs, labels = data['data'], data['label'] inputs = torch.tensor(inputs).float() optimizer.zero_grad() outputs = model(inputs) loss = criterion(outputs, labels.unsqueeze(1).float()) loss.backward() optimizer.step() if (i+1) % 100 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 测试模型 test_data = np.random.rand(1, 200) test_label = np.random.randint(0, 2, size=1) test_input = torch.tensor(test_data).float() with torch.no_grad(): model.eval() output = model(test_input) predicted_label = 1 if output.item() > 0.5 else 0 # 打印预测结果 print('True Label: {}, Predicted Label: {}'.format(test_label[0], predicted_label))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

这个进一步调整的示例代码包括了一个更复杂的神经网络模型结构、更大规模和更真实的药物设计数据集,以及进一步调整的训练参数来优化性能。您可以根据实际情况继续调整模型结构、数据集和训练参数,以进一步提高预测性能。

四、医疗数据分析示例代码

- 病人数据预测示例代码

以下是一个简单的示例代码,用于预测病人是否患有某种疾病。这个示例代码使用一个简单的神经网络模型来处理病人的特征数据,并输出预测结果:

import torch import torch.nn as nn import torch.optim as optim from torch.utils.data import DataLoader, Dataset import numpy as np # 创建一个简单的病人数据集 X = np.random.rand(1000, 5) # 5个特征 y = np.random.randint(0, 2, size=1000) # 二分类问题 # 定义神经网络模型 class PatientClassifier(nn.Module): def __init__(self): super(PatientClassifier, self).__init__() self.fc1 = nn.Linear(5, 10) self.fc2 = nn.Linear(10, 1) self.dropout = nn.Dropout(0.2) def forward(self, x): x = torch.relu(self.fc1(x)) x = self.dropout(x) x = torch.sigmoid(self.fc2(x)) # 输出层使用sigmoid激活函数,预测二分类问题 return x # 初始化模型、损失函数和优化器 model = PatientClassifier() criterion = nn.BCELoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 创建数据集类 class PatientDataset(Dataset): def __init__(self, X, y): self.X = X self.y = y def __len__(self): return len(self.X) def __getitem__(self, idx): data = {'data': self.X[idx], 'label': self.y[idx]} return data # 加载数据集并创建数据加载器 dataset = PatientDataset(X, y) data_loader = DataLoader(dataset, batch_size=32, shuffle=True) # 训练模型 num_epochs = 50 for epoch in range(num_epochs): for i, data in enumerate(data_loader): inputs, labels = data['data'], data['label'] inputs = torch.tensor(inputs).float() optimizer.zero_grad() outputs = model(inputs) loss = criterion(outputs, labels.unsqueeze(1).float()) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 测试模型 test_data = np.random.rand(1, 5) test_label = np.random.randint(0, 2, size=1) test_input = torch.tensor(test_data).float() with torch.no_grad(): model.eval() output = model(test_input) predicted_label = 1 if output.item() > 0.5 else 0 # 打印预测结果 print('True Label: {}, Predicted Label: {}'.format(test_label[0], predicted_label))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

这个示例代码展示了一个简单的神经网络模型,用于预测病人是否患有某种疾病。您可以根据实际情况进一步调整模型结构、数据集和训练参数,以优化性能并提高预测准确性。

以下是一个进一步调整的示例代码,用于预测病人是否患有某种疾病。这个示例代码包括了一个更复杂的神经网络模型结构、一个更大规模和更真实的病人数据集,以及进一步调整的训练参数来优化性能:

import torch import torch.nn as nn import torch.optim as optim from torch.utils.data import DataLoader, Dataset import numpy as np # 创建一个更大规模和更真实的病人数据集 # 假设有10000个病人,每个病人有10个特征 X = np.random.rand(10000, 10) # 10个特征 y = np.random.randint(0, 2, size=10000) # 二分类问题 # 定义一个更复杂的神经网络模型 class ImprovedPatientClassifier(nn.Module): def __init__(self): super(ImprovedPatientClassifier, self).__init__() self.fc1 = nn.Linear(10, 64) self.fc2 = nn.Linear(64, 32) self.fc3 = nn.Linear(32, 1) self.dropout = nn.Dropout(0.3) def forward(self, x): x = torch.relu(self.fc1(x)) x = self.dropout(x) x = torch.relu(self.fc2(x)) x = self.dropout(x) x = torch.sigmoid(self.fc3(x)) # 输出层使用sigmoid激活函数,预测二分类问题 return x # 初始化模型、损失函数和优化器 model = ImprovedPatientClassifier() criterion = nn.BCELoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 创建数据集类 class PatientDataset(Dataset): def __init__(self, X, y): self.X = X self.y = y def __len__(self): return len(self.X) def __getitem__(self, idx): data = {'data': self.X[idx], 'label': self.y[idx]} return data # 加载数据集并创建数据加载器 dataset = PatientDataset(X, y) data_loader = DataLoader(dataset, batch_size=64, shuffle=True) # 训练模型 num_epochs = 100 for epoch in range(num_epochs): for i, data in enumerate(data_loader): inputs, labels = data['data'], data['label'] inputs = torch.tensor(inputs).float() optimizer.zero_grad() outputs = model(inputs) loss = criterion(outputs, labels.unsqueeze(1).float()) loss.backward() optimizer.step() if (i+1) % 50 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 测试模型 test_data = np.random.rand(1, 10) test_label = np.random.randint(0, 2, size=1) test_input = torch.tensor(test_data).float() with torch.no_grad(): model.eval() output = model(test_input) predicted_label = 1 if output.item() > 0.5 else 0 # 打印预测结果 print('True Label: {}, Predicted Label: {}'.format(test_label[0], predicted_label))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

这个进一步调整的示例代码包括了一个更复杂的神经网络模型结构、一个更大规模和更真实的病人数据集,以及进一步调整的训练参数来优化性能。您可以根据实际情况继续调整模型结构、数据集和训练参数,以进一步提高预测性能。

以下是一个进一步调整的示例代码,用于疾病预测。这个示例代码包括了一个更复杂的神经网络模型结构、一个更大规模和更真实的医疗数据集,以及进一步调整的训练参数来优化性能:

import torch import torch.nn as nn import torch.optim as optim from torch.utils.data import DataLoader, Dataset import numpy as np from sklearn.datasets import load_breast_cancer from sklearn.preprocessing import StandardScaler # 加载乳腺癌数据集 cancer = load_breast_cancer() X = cancer.data y = cancer.target # 数据标准化 scaler = StandardScaler() X = scaler.fit_transform(X) # 定义一个更复杂的神经网络模型 class ImprovedDiseasePredictor(nn.Module): def __init__(self): super(ImprovedDiseasePredictor, self).__init__() self.fc1 = nn.Linear(30, 128) self.fc2 = nn.Linear(128, 64) self.fc3 = nn.Linear(64, 1) self.dropout = nn.Dropout(0.2) def forward(self, x): x = torch.relu(self.fc1(x)) x = self.dropout(x) x = torch.relu(self.fc2(x)) x = self.dropout(x) x = self.fc3(x) return x # 初始化模型、损失函数和优化器 model = ImprovedDiseasePredictor() criterion = nn.BCEWithLogitsLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 创建数据集类 class DiseaseDataset(Dataset): def __init__(self, X, y): self.X = X self.y = y def __len__(self): return len(self.X) def __getitem__(self, idx): data = {'features': self.X[idx], 'label': self.y[idx]} return data # 加载数据集并创建数据加载器 dataset = DiseaseDataset(X, y) data_loader = DataLoader(dataset, batch_size=64, shuffle=True) # 训练模型 num_epochs = 50 for epoch in range(num_epochs): for i, data in enumerate(data_loader): features, labels = data['features'], data['label'] features = torch.tensor(features).float() labels = torch.tensor(labels).float() optimizer.zero_grad() outputs = model(features) loss = criterion(outputs, labels.unsqueeze(1)) loss.backward() optimizer.step() if (i+1) % 10 == 0: print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}' .format(epoch+1, num_epochs, i+1, len(data_loader), loss.item())) # 测试模型 test_data = X[0].reshape(1, -1) test_label = y[0] test_input = torch.tensor(test_data).float() with torch.no_grad(): model.eval() output = torch.sigmoid(model(test_input)).item() # 打印预测结果 print('True Label: {}, Predicted Probability: {:.4f}'.format(test_label, output))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

这个进一步调整的示例代码包括了一个更复杂的神经网络模型结构、一个更大规模和更真实的医疗数据集,以及进一步调整的训续参数来优化性能。您可以根据实际情况继续调整模型结构、数据集和训续参数,以进一步提高疾病预测性能。

- 诊断和治疗方案的优化示例代码

以下是一个示例代码,展示如何使用PyTorch对医疗诊断和治疗方案进行优化。在这个示例中,我们将使用一个简单的神经网络模型来进行疾病诊断,并根据诊断结果选择相应的治疗方案。请注意,这只是一个简单的示例,实际应用中可能需要更复杂的模型和数据集。

import torch import torch.nn as nn import torch.optim as optim # 定义一个简单的神经网络模型 class MedicalDiagnosisModel(nn.Module): def __init__(self): super(MedicalDiagnosisModel, self).__init__() self.fc1 = nn.Linear(10, 64) self.fc2 = nn.Linear(64, 32) self.fc3 = nn.Linear(32, 2) def forward(self, x): x = torch.relu(self.fc1(x)) x = torch.relu(self.fc2(x)) x = self.fc3(x) return x # 初始化模型、损失函数和优化器 model = MedicalDiagnosisModel() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 模拟医疗数据 X = torch.randn(100, 10) # 输入特征 y = torch.randint(0, 2, (100,)) # 0表示正常,1表示疾病 # 训练模型 num_epochs = 50 for epoch in range(num_epochs): optimizer.zero_grad() outputs = model(X) loss = criterion(outputs, y) loss.backward() optimizer.step() print('Epoch [{}/{}], Loss: {:.4f}'.format(epoch+1, num_epochs, loss.item())) # 诊断 patient_data = torch.randn(1, 10) # 患者数据 with torch.no_grad(): model.eval() output = torch.softmax(model(patient_data), dim=1) diagnosis = torch.argmax(output).item() # 根据诊断结果选择治疗方案 if diagnosis == 0: treatment = "正常,无需治疗" else: treatment = "疾病,需进行治疗" print('诊断结果: {}, 治疗方案: {}'.format(diagnosis, treatment))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

在这个示例代码中,我们定义了一个简单的神经网络模型来进行疾病诊断,并根据诊断结果选择相应的治疗方案。您可以根据实际需求进一步优化模型、数据集和训练参数,以提高诊断和治疗方案的准确性和效果。

以下是一个进一步优化的示例代码,包括一个更复杂的神经网络模型结构、一个更真实的医疗数据集,以及进一步调整的训练参数来提高诊断和治疗方案的准确性和效果。

import torch import torch.nn as nn import torch.optim as optim from sklearn.datasets import make_classification from sklearn.model_selection import train_test_split from sklearn.preprocessing import StandardScaler # 生成医疗数据集 X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, random_state=42) X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42) # 数据标准化 scaler = StandardScaler() X_train = scaler.fit_transform(X_train) X_test = scaler.transform(X_test) # 转换为PyTorch张量 X_train = torch.tensor(X_train).float() y_train = torch.tensor(y_train).long() X_test = torch.tensor(X_test).float() y_test = torch.tensor(y_test).long() # 定义一个更复杂的神经网络模型 class MedicalDiagnosisModel(nn.Module): def __init__(self): super(MedicalDiagnosisModel, self).__init__() self.fc1 = nn.Linear(20, 64) self.fc2 = nn.Linear(64, 32) self.fc3 = nn.Linear(32, 2) def forward(self, x): x = torch.relu(self.fc1(x)) x = torch.relu(self.fc2(x)) x = self.fc3(x) return x # 初始化模型、损失函数和优化器 model = MedicalDiagnosisModel() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 训练模型 num_epochs = 50 for epoch in range(num_epochs): optimizer.zero_grad() outputs = model(X_train) loss = criterion(outputs, y_train) loss.backward() optimizer.step() print('Epoch [{}/{}], Loss: {:.4f}'.format(epoch+1, num_epochs, loss.item())) # 评估模型 model.eval() with torch.no_grad(): outputs = model(X_test) _, predicted = torch.max(outputs, 1) accuracy = (predicted == y_test).sum().item() / y_test.size(0) print('测试集准确率: {:.2f}%'.format(accuracy * 100))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

这个进一步优化的示例代码包括了一个更复杂的神经网络模型结构、一个更真实的医疗数据集,以及进一步调整的训练参数来提高诊断和治疗方案的准确性和效果。您可以根据实际情况继续调整模型结构、数据集和训练参数,以进一步提高疾病诊断和治疗方案的性能。

以下是一个进一步调整的示例代码,包括一个更深层次的神经网络模型结构、一个更大规模的医疗数据集,以及更复杂的训练参数来提高疾病诊断和治疗方案的性能。

import torch import torch.nn as nn import torch.optim as optim from sklearn.datasets import make_classification from sklearn.model_selection import train_test_split from sklearn.preprocessing import StandardScaler # 生成更大规模的医疗数据集 X, y = make_classification(n_samples=5000, n_features=30, n_classes=3, random_state=42) X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42) # 数据标准化 scaler = StandardScaler() X_train = scaler.fit_transform(X_train) X_test = scaler.transform(X_test) # 转换为PyTorch张量 X_train = torch.tensor(X_train).float() y_train = torch.tensor(y_train).long() X_test = torch.tensor(X_test).float() y_test = torch.tensor(y_test).long() # 定义一个更深层次的神经网络模型 class MedicalDiagnosisModel(nn.Module): def __init__(self): super(MedicalDiagnosisModel, self).__init__() self.fc1 = nn.Linear(30, 64) self.fc2 = nn.Linear(64, 128) self.fc3 = nn.Linear(128, 64) self.fc4 = nn.Linear(64, 3) # 3个类别 def forward(self, x): x = torch.relu(self.fc1(x)) x = torch.relu(self.fc2(x)) x = torch.relu(self.fc3(x)) x = self.fc4(x) return x # 初始化模型、损失函数和优化器 model = MedicalDiagnosisModel() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 训练模型 num_epochs = 100 for epoch in range(num_epochs): optimizer.zero_grad() outputs = model(X_train) loss = criterion(outputs, y_train) loss.backward() optimizer.step() print('Epoch [{}/{}], Loss: {:.4f}'.format(epoch+1, num_epochs, loss.item())) # 评估模型 model.eval() with torch.no_grad(): outputs = model(X_test) _, predicted = torch.max(outputs, 1) accuracy = (predicted == y_test).sum().item() / y_test.size(0) print('测试集准确率: {:.2f}%'.format(accuracy * 100))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

这个进一步调整的示例代码包括了一个更深层次的神经网络模型结构、一个更大规模的医疗数据集,以及更复杂的训练参数来提高疾病诊断和治疗方案的性能。您可以根据实际情况继续调整模型结构、数据集和训练参数,以进一步提高疾病诊断和治疗方案的准确性和效果。

五、医疗机器人示例代码

- 手术机器人示例代码

以下是一个简单的基于 PyTorch 的手术机器人示例代码,用于控制一个机器人在模拟手术环境中执行特定的任务。

import torch import torch.nn as nn import torch.optim as optim # 定义一个简单的手术机器人模型 class SurgicalRobot(nn.Module): def __init__(self): super(SurgicalRobot, self).__init__() self.fc1 = nn.Linear(3, 64) self.fc2 = nn.Linear(64, 64) self.fc3 = nn.Linear(64, 2) # 2个动作:切割、缝合 def forward(self, x): x = torch.relu(self.fc1(x)) x = torch.relu(self.fc2(x)) x = self.fc3(x) return x # 初始化模型、损失函数和优化器 model = SurgicalRobot() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 模拟手术环境数据 X = torch.tensor([[0.2, 0.3, 0.5], [0.1, 0.4, 0.5], [0.3, 0.2, 0.5]]) y = torch.tensor([0, 1, 0]) # 0表示切割,1表示缝合 # 训练模型 num_epochs = 100 for epoch in range(num_epochs): optimizer.zero_grad() outputs = model(X) loss = criterion(outputs, y) loss.backward() optimizer.step() print('Epoch [{}/{}], Loss: {:.4f}'.format(epoch+1, num_epochs, loss.item())) # 模拟手术机器人执行任务 new_data = torch.tensor([[0.4, 0.1, 0.5]]) with torch.no_grad(): action = torch.argmax(model(new_data)) if action == 0: print('手术机器人执行切割动作') else: print('手术机器人执行缝合动作')

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

这个示例代码展示了一个简单的手术机器人模型,用于在模拟手术环境中执行切割和缝合两种动作。您可以根据实际需求进一步扩展模型结构、数据集和训练参数,以实现更复杂的手术机器人功能。

以下是一个更复杂的手术机器人示例代码,包括更复杂的模型结构、更大规模的手术数据集和更复杂的训练参数。

import torch import torch.nn as nn import torch.optim as optim import numpy as np # 定义一个更复杂的手术机器人模型 class ComplexSurgicalRobot(nn.Module): def __init__(self): super(ComplexSurgicalRobot, self).__init__() self.conv1 = nn.Conv2d(3, 16, 3, padding=1) self.conv2 = nn.Conv2d(16, 32, 3, padding=1) self.fc1 = nn.Linear(32 * 8 * 8, 256) self.fc2 = nn.Linear(256, 128) self.fc3 = nn.Linear(128, 2) # 2个动作:切割、缝合 def forward(self, x): x = torch.relu(self.conv1(x)) x = torch.max_pool2d(x, 2, 2) x = torch.relu(self.conv2(x)) x = torch.max_pool2d(x, 2, 2) x = x.view(-1, 32 * 8 * 8) x = torch.relu(self.fc1(x)) x = torch.relu(self.fc2(x)) x = self.fc3(x) return x # 初始化模型、损失函数和优化器 model = ComplexSurgicalRobot() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001) # 生成更大规模的手术数据集 # 假设有1000个手术样本,每个样本有3个通道的图像数据和对应的动作标签 X = torch.randn(1000, 3, 64, 64) # 1000个大小为64x64的3通道图像 y = torch.randint(0, 2, (1000,)) # 1000个动作标签,0表示切割,1表示缝合 # 训练模型 num_epochs = 10 batch_size = 32 for epoch in range(num_epochs): for i in range(0, len(X), batch_size): optimizer.zero_grad() batch_X = X[i:i+batch_size] batch_y = y[i:i+batch_size] outputs = model(batch_X) loss = criterion(outputs, batch_y) loss.backward() optimizer.step() print('Epoch [{}/{}], Loss: {:.4f}'.format(epoch+1, num_epochs, loss.item())) # 模拟手术机器人执行任务 new_data = torch.randn(1, 3, 64, 64) # 模拟一个新的手术图像数据 with torch.no_grad(): action = torch.argmax(model(new_data)) if action == 0: print('手术机器人执行切割动作') else: print('手术机器人执行缝合动作')

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

这个进一步调整的示例代码包括了一个更复杂的卷积神经网络模型结构、一个更大规模的手术数据集,以及更复杂的训练参数来提高手术机器人的性能。您可以根据实际情况继续调整模型结构、数据集和训练参数,以进一步提高手术机器人的准确性和效果。

以下是一个进一步调整的示例代码,包括更复杂的模型结构、更大规模的手术数据集和调整后的训练参数,以进一步提高手术机器人的准确性和效果。