热门标签

热门文章

- 1MySql系列六:MySQL索引详解_空间索引不能是主引

- 2MySQL索引原理及优化_mysql 索引优化原理

- 3滑雪 【记忆化搜索】

- 4Cause: com.mysql.cj.jdbc.exceptions.MySQLTransactionRollbackException: Lock wait timeout exceeded;

- 5解决CenOS7自带的yum不能直接使用问题_one of the configured repositories failed (unknown

- 6Mac 和 Windows 共享一套鼠标键盘_sharemouse

- 7# Spring Cloud Alibaba Nacos_配置中心与服务发现(四)_nacos1.x的springcloud的配置文件

- 8MySQL InnoDB Cluster

- 9电脑CPU速度很快,为什么3dMax还会出现卡顿的情况?_3dmax卡死,但是电脑一点不卡

- 10IT行业34个最新专业术语_it专业词缩写解释

当前位置: article > 正文

Linux:ollama+Dify大模型本地化部署打造个人知识库 (2)_dify镜像拉不下来

作者:Guff_9hys | 2024-08-22 22:36:18

赞

踩

dify镜像拉不下来

上一章我们部署了ollama大模型,Dify和ollama可以结合使用,以快速开发和部署AI应用。开发人员可以使用ollama在本地部署LLM,然后使用Dify进行应用开发和模型管理。

Dify介绍:

Dify 是一款开源的大语言模型(LLM)应用开发平台。它融合了后端即服务(Backend as Service)和 LLMOps 的理念,使开发者可以快速搭建生产级的生成式 AI 应用。即使是非技术人员,也能参与到 AI 应用的定义和数据运营过程中。

Dify 内置了构建 LLM 应用所需的关键技术栈,包括对数百个模型的支持、直观的 Prompt 编排界面、高质量的 RAG 引擎以及灵活的 Agent 框架,并同时提供了一套易用的界面和 API。这为开发者节省了许多重复造轮子的时间,使其可以专注于创新和业务需求。

通俗的讲dify就像一个壳是为了更方便的去使用大模型并可以将大模型本地化部署,打造个人知识库

功能比较

如果你想了解更多关于 Dify 的信息,可以访问其官方网站:https://dify.ai/

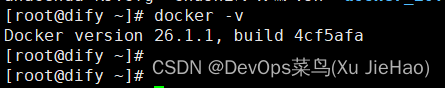

1.检查是否拥有Docker环境

docker -v

2.从gitlab上克隆代码到服务器

#由于网站在国外很有可能拉取不下来,可能要多尝试几次,实在不行就配置镜像加速器

Docker配置国内镜像加速-2_配置docker加速-CSDN博客

git clone https://github.com/langgenius/dify.git3.进入 dify 源代码的 docker 目录,执行一键启动命令:

- [root@dify ~]# cd dify/docker

- [root@dify docker]# docker compose up -d

部署结果:

#如果全是对钩代表镜像拉取成功

4.浏览器访问:

服务器IP地址

(1)注册管理员账号

密码:123.com!

#注意:密码必须满足复杂度(数字字母+特殊符号不少于8为)

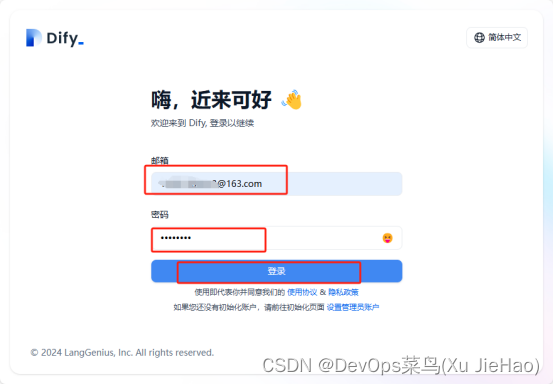

(2)登录账号

这样就进入了它的管理界面

5.添加ollama大模型

所测选择‘模型供应商’------ ‘ollama添加模型’

6.创建智能助手

(1)设置提示词

(2)尝试对话

(3)添加扩展工具

(4)添加开场白

声明:本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:【wpsshop博客】

推荐阅读

相关标签