热门标签

热门文章

- 1React Native A/libc: Fatal signal 11 (SIGSEGV), code 1 (SEGV_MAPERR), fault addr

- 2AI Mass人工智能大模型即服务时代:大模型即服务的性能优化_ai大模型对话接口响应需要在多少秒内

- 3解决explorer.exe 应用程序错误,内存不能为 read或written的解决方法小结

- 4cassandra安装配置_cassandra 9042 对外开放

- 5R语言保存png,pdf文件出现文件损坏或空白问题的解决方案_r语言图片保存成功,为什么里面是空白的

- 6python神经网络回归_python MLPRegressor神经网络回归预测

- 7vue组织树(树形组件vue3)_vue-power-tree

- 8基于Java+SpringBoot+Vue中学生日常行为评分管理系统设计和实现

- 9Qt 设置:两个窗口位置重合_qt 重叠布局

- 10ElasticSearch——详解主从模式,以及主节点的选取算法(二)_es 主从如何切换的

当前位置: article > 正文

vllm 推理可商用智源Aquila;openai api使用、及langchain使用接口聊天_vllm提供openai接口形式的http服务。然后langchain直接当做openai调用可以的

作者:IT小白 | 2024-03-01 17:14:45

赞

踩

vllm提供openai接口形式的http服务。然后langchain直接当做openai调用可以的了

如果vllm版本升级到0.2.0及以后,下面更改代码部分就不用了

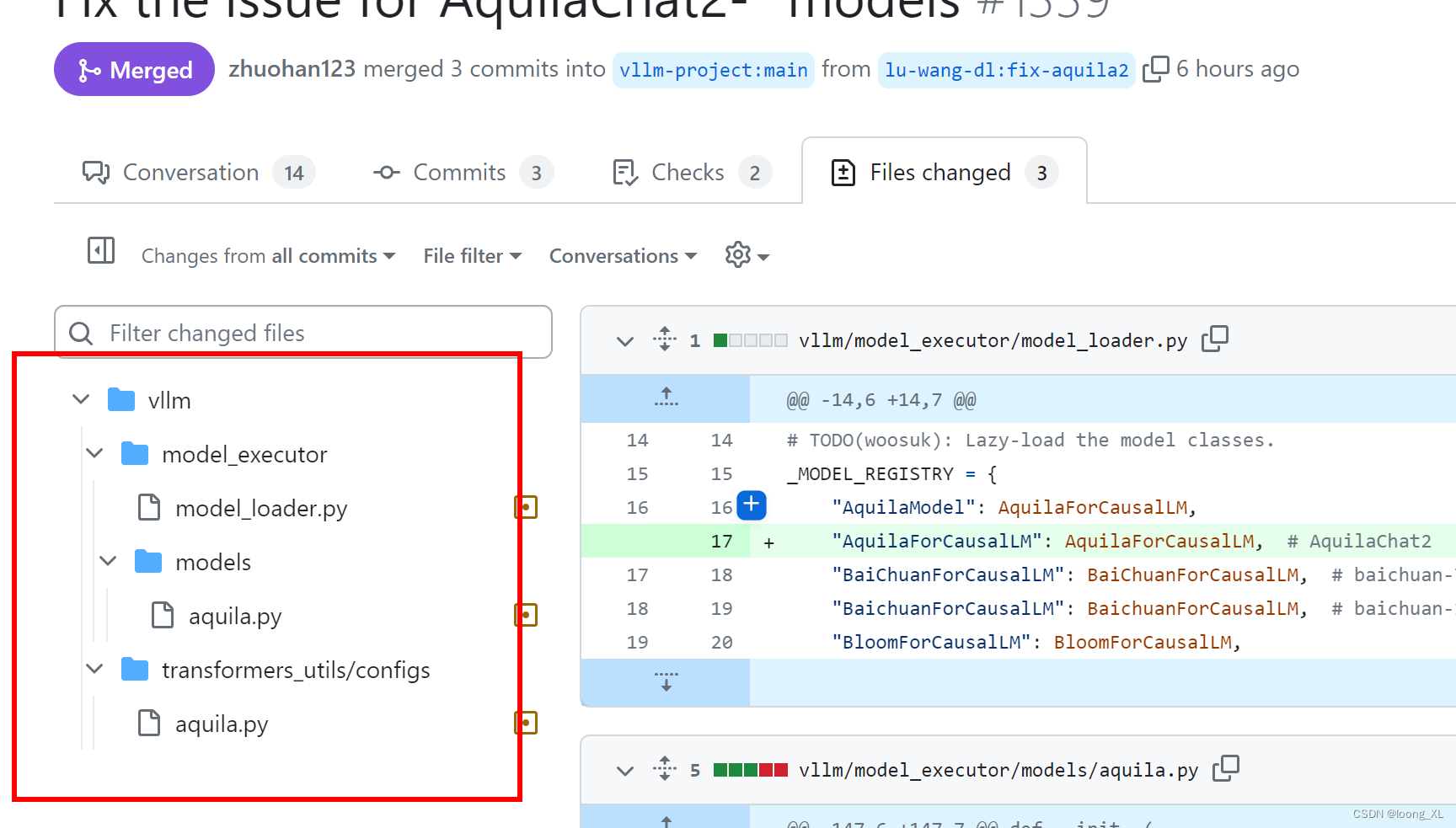

vllm需要更新支持Aquila2的commit:(需要安装包里文件替换换新增下面新的支持Aquila2的修改文件)

https://github.com/vllm-project/vllm/pull/1339/files

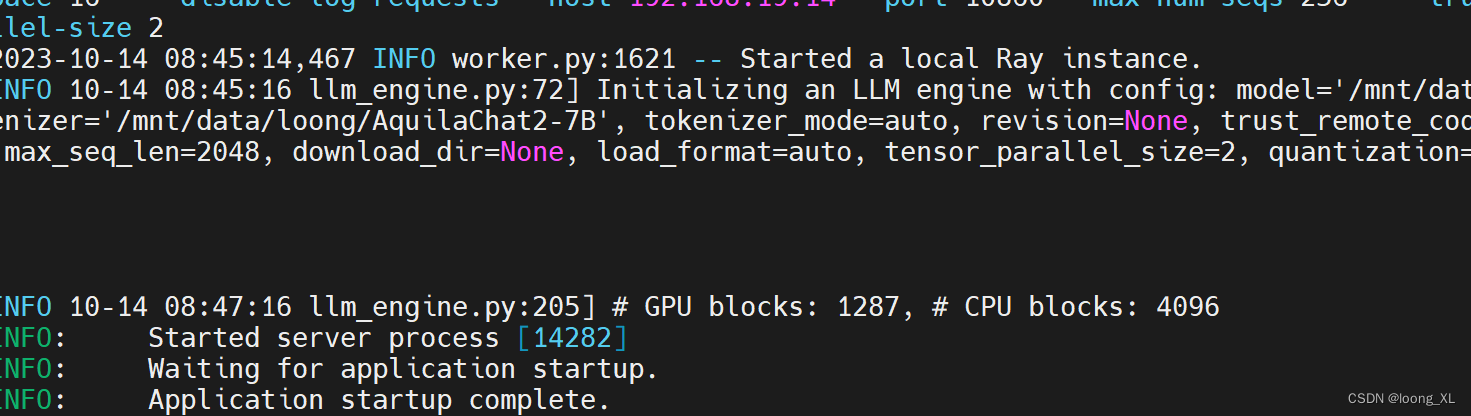

1、运行

python -m vllm.entrypoints.api_server --model ****/AquilaChat2-7B --swap-space 16 --disable-log-requests --host 1***** --port 10860 --max-num-seqs 256 --trust-remote-code --tensor-parallel-size 2

- 1

2、api

隧道:

ssh -p 31022 -NL 7860:192.168.1.1:10860 root@18***12

- 1

- 2

import requests

import json

# from vllm import LLM, SamplingParams

headers = {"User-Agent": "Test Client"}

pload = {

"prompt- 1

- 2

- 3

- 4

- 5

- 6

- 7

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/IT小白/article/detail/175585

推荐阅读

相关标签