- 1B端产品需求分析与挖掘

- 22022年博客之星排行榜 日榜 2022-12-30博客之星总磅_lycc3353.monster290.top

- 3Matlab2012a的图像处理工具箱的imshow函数_matlab imshow

- 4【深入理解计算机系统第3版】有符号数和无符号数转换以及移位运算练习题2.23

- 5数据结构算法 - 1 算法简介_数据结构中算法的定义

- 6自我摸索:如何运营并玩转CSDN?_怎么运营csdn

- 7蓝桥杯考前突击(C++允许使用的api与存储结构)_蓝桥杯复习c++

- 8逐行对比LLaMA2和LLaMA模型源代码_llama2 论文

- 9使用 nvm 管理 node.js 版本_nvm管理nodejs

- 10软考中级——数据库系统工程师

如何入门多视角人脸正面化生成?不得不看的超详细最新综述!

赞

踩

作者丨宁欣,南方哲,许少辉,于丽娜,张丽萍

审稿丨邓富城

编辑丨极市平台

导读

本文将重点对近些年来基于3D模型和深度学习模型的人脸正面化生成方法的主要进展和部分具有代表性的研究成果进行介绍,并通过实验对比和分析,总结了人脸正面化生成研究中的难点和热点,以及可能的发展趋势。

论文下载地址:

https://www.researchgate.net/publication/347731732_Multi-view_frontal_face_image_generation_A_survey

目录

引言

基于3D的人脸模型

1.1 3D模型介绍

1.2 基于3D的正面化生成

基于深度学习的正面化生成

2.1基于自编码器的模型

2.2基于神经网络的模型

2.3基于生成式对抗网络的模型

基于混合人脸正面化的生成模型

常用数据集介绍

结论

摘要

不同视角的人脸图像降低了人脸识别的精度,人脸正面化图像生成是人脸识别领域中重要的研究课题。为深入了解人脸正面化生成模型的发展,把握当前研究的热点和趋势,针对现有基于3D模型、基于深度学习和基于混合模型的方法进行了归纳总结,介绍了现有人脸正面化生成常用的数据集,并通过实验对比分析现有模型的性能。其目的在于从本质上了解现有人脸正面化生成的优势; 对人脸正面化生成的关键问题进行梳理,并对未来的发展趋势进行展望。

0. 引言

多视角人脸正面化图像生成指从一个或多个视角的非正面图像生成正面化的人脸图像。正面化的人脸图像在人脸识别,视频监控,身份验证等方面有较广泛的应用,尤其是人脸识别领域。近年来,人脸识别技术得到了广泛的发展如人脸考勤,人脸侦察,人脸支付,随着机器学习和深度学习技术热潮,人脸识别的应用和准确率更是达到了一个较高的水准。然而由于非正面的面部识别纹理信息通常比正面面部识别性差、正面和侧面的共同特征非常有限、姿态变化会导致面部实质变形等原因,现有的许多人脸识别算法在大姿态的非正面人脸图像中识别人脸仍然是具有挑战性的问题,姿态问题也成了限制非受限环境下人脸识别效果的主要因素,因此如何从大姿态的非正面人脸图像中恢复出正面人脸图像是一项很有价值的研究。

目前,人脸正面化图像生成问题在国内外已经得到了广泛的研究,如Lee等利用特征空间中的线性变换在2004年和2006年结合主成分分析提出了生成正面视图图像的方法。2012年li Y等基于最小二乘法实现了人脸正面化转正。2005侯榆青等[14]利用边缘点集的协方差矩阵的特征值与特征矢量实现了人脸正面化图像的生成;李海彦等利用仿射变换和成像原理相结合对待识别的多姿态人脸图像进行姿态调整,将其调整为近似于正面人脸的方法;王科俊等结合图像旋转公式实现了人脸图像的平面旋转校正;上述传统的人脸正面化成技术主要是对不同姿态的人脸进行几何代数变换得到矫正后的正面人脸,这种基于几何代数变换的正面化生成方法计算简单快速,但是生成效果并不理想,会存在局部扭曲的问题,且有很大的局限性,只能解决小角度(小姿态)情况下的人脸正面化生成。随着3D模型的提出和深度学习的发展,一些研究者将3D模型和深度学习模型运用到了人脸正面化生成领域。

基于此,本文将重点对近些年来基于3D模型和深度学习模型的人脸正面化生成方法的主要进展和部分具有代表性的研究成果进行介绍,并通过实验对比和分析,总结了人脸正面化生成研究中的难点和热点,以及可能的发展趋势。

1. 基于3D建模的人脸正面化生成模型

1.1 3D模型介绍

由于3D数据对视角变化天然的鲁棒性,基于3D的方法可以十分理想地解决正脸生成问题。其中三维形变模型(3D morphable model,3DMM) 是由Blanz等提出的一种人脸3D可变形的人脸模型,3DMM作为描述人脸形状的平均模型,是实现3D人脸重建和3D人脸识别常用的模型之一。该算法的思路是利用一个人脸数据库构造一个平均人脸形变模型,在给出新的人脸图像后,将人脸图像与模型进行匹配结合,修改模型相应的参数,将模型进行形变,直到模型与人脸图像的差异减到最小,然后对纹理进行优化调整,即可完成人脸建模。因此算法主要有两个步骤,第一步是从人脸数据库中所有脸构建出一个平均的脸部模型,第二步完成形变模型与照片的匹配。针对步骤一,首先将人脸分成两种向量:形状向量和纹理向量。形状向量S包含了X,Y,Z的坐标信息,定义如公式1所示,其中n表示模型的定点数:

纹理信息T包含了R,G,B颜色值信息,定义如公式2所示:

然后由m个脸部模型建立三维形变的脸部模型,其中每一个都包含相应的S~i~, T~i~两种向量。新的三维形变脸部模型公式定义如下:

其中 ,m表示采集的人脸样本数,a和b为参数系数。

最后由公式(3)和公式(4)线性组合成新的脸部模型,如公式5所示:

针对步骤二,在形变模型的基础上,对于一张给定的人脸照片,首先将模型与人脸照片进行配准,然后对模型的参数进行调整,使其与照片中的人脸差异值达到最小即可,即模型 与输入的图像 之间的欧氏 距离最小。

1.2. 基于3D模型的正面化生成模型

基于3D模型生成人脸正面化的思路是通过构建三维人脸模型,对测试人脸图像进行模型参数的匹配,进而获得完整的三维人脸数据,从而获得正面人脸图像。

现有一些方法直接基于3DMM进行正面人脸图像的生成如王钱庆等提出了BFM-3DMM模型,先利用改进的AAM模型进行人脸对齐,然后利用BFM-3DMM模型进行初步校正,最后利用SFS算法进行人脸再校正,实验表明该算法不仅能生成欧洲人的正面图像,同样能够实现亚洲人脸的正面化生成。

Seung-Hyuk Jeon等基于3DMM模型提出了一种从单个图像中的非正面人脸生成正面人脸的方法。该方法的前视3DMM由非前视旋转3DMM生成。3DMM表面的可见性通过对应3DMM前视与非前视的可见面积比来测量。正面视图3DMM的可见区域是通过对人脸图像进行分段仿射扭曲来绘制的,同时利用人脸的对称特性绘制不可见区域。

Asthana等提出了一种新颖的3D姿势归一化方法,将非正面人脸图像映射到一个对齐的三维人脸模型上, 通过调整这个三维模型的姿态获得正面人脸图像。该方法自动将3D人脸模型稳固地拟合到2D输入图像而无需任何人工干预的情况。此外,该方法可以处理连续范围的姿势,因此不限于一组离散的预定姿势角,以成功运用到标准人脸识别测试仪上,并可产生出色的结果。

Hassner等[21]提供了一种简单有效的人脸正面化生成方法,该方法首先寻找查询照片与三维人脸模型表面2D-3D对应关系,然后通过使用一种健壮的面部特征检测方法在两幅图像中寻找相同的地标,将查询点与渲染的模型正面视图上的点进行匹配,最后通过使用3D模型的几何图形将查询的面部特征投影回参考坐标系,可以生成正面人脸图像。

还有一些方法考虑到3DMM模型本身存在的问题,在3DMM模型的基础上提出了人脸正面化生成模型。如Fang等提出了一种基于姿态估计的正面人脸图像合成方法,该方法通过建立平均三维人脸模型进行姿态估计,以避免3DMM方法中复杂的迭代计算;采用压缩感知理论对原型 样本进行筛选,以提高形变模型的精度;将原始纹理与重建纹理相结合构建综合纹理,以保留人脸图像的细节信息。

Zhu等考虑到传统的3DMM存在运算速率慢等问题,提出一种基于三维变形模型(3DMM)的高保真位姿和表情归一化(HPEN)方法,通过估计整个图像的深度信息,从而可以很容易地修正姿态和表情的三维变换,以保留尽可能多的身份信息。为了保证姿态归一化后的人脸区域到背景的平滑过渡,除了人脸区域外,HPEN还对人脸外部区域和背景的深度进行了估计。该方法可以自动生成具有正面位姿和中性表情的自然人脸图像。

除上述方法外基于3DMM进行人脸正面化生成的方法还有FPCA模型,MDF模型等。

1.3 讨论

基于3DMM的方法由于使用的是致密的3D数据,因而可以实现正脸形状和纹理的理想合成,但是基于3D模型方法的人脸矫正一般是利用3DMM模型来拟合人脸,然后通过对称操作或者其他操作来补全侧脸图像由于自遮挡导致的信息缺失,这样在矫正大角度人脸时会出现明显的人为对称痕迹。而且3DMM需要大量扫描后的人脸模型进行平均人脸模型的创建,因此也存在计算量大,生成速度慢等缺点。

2. 基于深度学习的人脸正面化生成模型

深度学习作为机器学习研究的新领域,通过模仿人脑的机制来解释数据,让机器自动学习良好的特征,免去人工选取过程,相较于基于3D的模型,基于深度学习的模型减少了计算的复杂度,提高了生成速率,在一定程度上解决了人为对称带来的生成图像的质量问题。根据所用网络模型的不同,基于深度学习的人脸正面化生成模型又可细分为基于自编码器的模型,基于卷积神经网络的模型和基于生成式对抗网络的模型。

2.1 基于自编码器的模型

2.1.1自编码器介绍

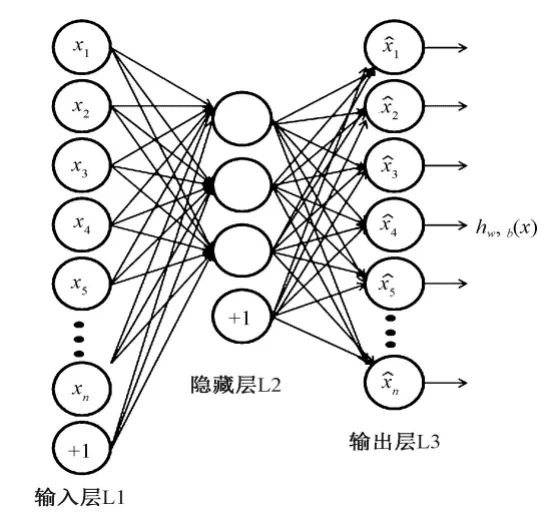

自编码器(Autoencoder,AE),是一种利用反向传播算法使得输出值等于输入值的神经网络,它先将输入压缩成潜在空间表征,然后通过这种表征来重构输出,简单讲,AE可以被视为一个三层神经网络结构:一个输入层、一个隐藏层和一个输出层,其网络结构如图1所示。该网络可以看作由两部分组成: 一个由函数表示的编码器和一个生成重构的解码器。

自编码器在训练的过程中需要加入一些约束,使它只能近似地复制,并只能复制与训练数据相似的输入。这些约束强制模型考虑输入数据的哪些部分需要被优先复制,因此,它往往能学习到数据的有用特征。近年来,自编码器与潜变量模型理论的联系将自编码器带到了生成式建模的前沿。

2.1.2基于自编码器的模型

基于3D重建的模型由于依赖于已有的3D模型,所以生成的正面化图像存在伪影的问题,而基于自编码器的多视角人脸正面化图像生成模型中编码器负责提取图像的特征,解码器负责合成人脸正面图像,不依赖于先验知识,可以更好的合成人脸正面图像,因此自编码器现已成功运用到人脸正面化生成中。

如2014年Kan等针对由姿态差异引起的脸部外表变化比由身份差异引起的变化大的问题,提出了堆叠步进自编码器 ( Stacked Progressive Auto-Encoder,SPAE)的非正面人脸图像转换为正面人脸图像的方法。具体来说,堆叠网络的每个浅渐进式自动编码器被设计为将处于较大姿势的面部图像映射到处于较小姿势的面部图像,同时将那些图像以较小的姿势保持不变。然后,堆叠多个这些浅自动编码器可以将非正面人脸图像逐步转换为正面人脸图像,这意味着姿势变化逐步缩小为零。因此,堆叠网络的最顶层隐藏层的输出包含非常小的姿势变化,可用作姿势识别的姿势稳健特征。

2017年欧阳宁等在堆叠自编码器的基础上,结合多任务学习( Multi- task Learning,MtL),提出了基于多任务学习的多姿态人脸重建与识别方法,即多任务学习堆叠自编码器( Multi-task Learning Stacked Auto-Encoder,MtLSAE)。2019年徐海月等基于编解码网络提出了一种多姿态人脸图像正面化方法-多任务卷积编解码网络(MCEDN)。

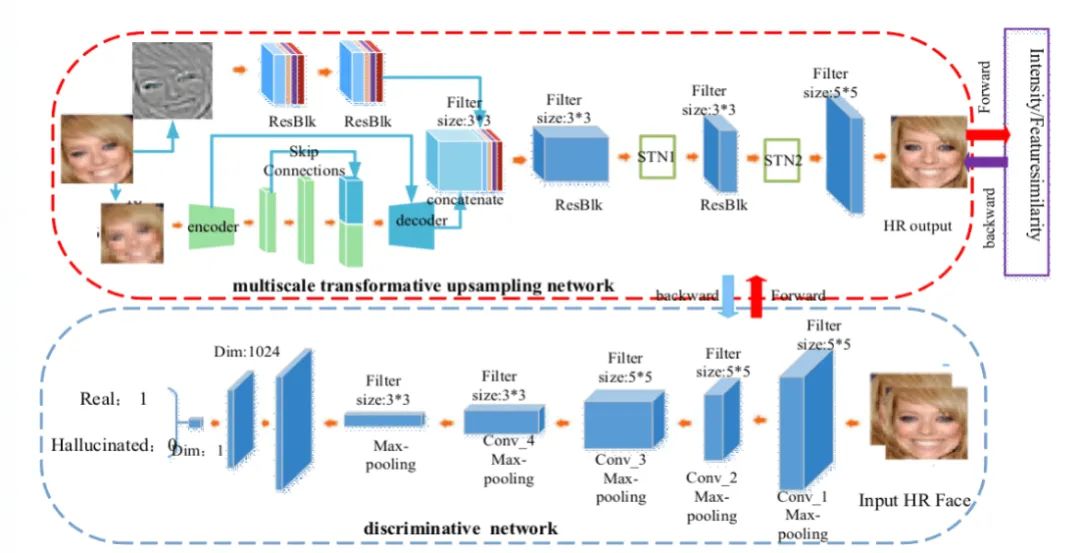

2020年Xin Yu等提出了一种可同时实现图像正面化生成和超分辨率的变换判别神经网络(MTDN)。MTDN由两部分组成:一个组合了自动编码器,空间转换网络层,上采样层和残差块层的多尺度变换上采样网络,以及一个由卷积层,最大池化层和全连接层组成的判别网络。多尺度变换上采样网络旨在以不同分辨率接收和超分辨LR图像,而判别网络的发展则是迫使超分辨脸部变得逼真。MIDN能够在不同的大姿势中有效地对齐和升采样低分辨率图像,并且升采样的图像类似于其对应的高分辨率的图像。

2.2 基于神经网络的模型

2.2.1 卷积神经网络基本概念

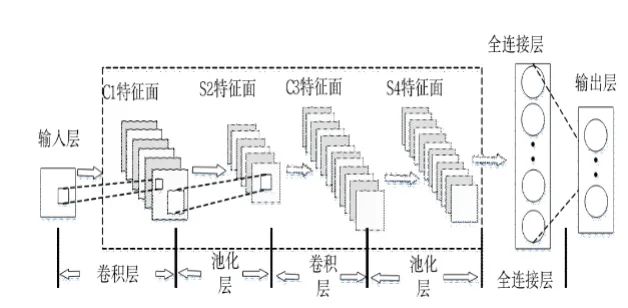

借鉴人脑超大规模的、复杂互联的结构,神经网络经历了从浅层神经网络到深度神经网络的重要变革。卷积神经网络(Convolutional neural network,CNNs)作为最重要的深度模型之一, 由于具有良好的特征提取能力和泛化能力, 在通用图像分类、图像检测、光学字符识别等领域都是表现最好的,在人脸识别、视觉跟踪、自然语言处理、自动驾驶、图像超分重建等问题上相较浅层模型具有显著优势。

CNN由输入层、卷积层、激活函数、池化层、全连接层组成,其结构如图4所示,其中卷积层遵循权值共享原则,来进行特征提取,通常会使用多层卷积层得到更深层次的特征图;激活函数的作用是保证数据输入与输出是可微的;池化层往往在卷积层之后,其作用是对输入的特征图进行压缩提取主要特征,防止过拟合发生;全连接层的作用是连接所有的特征,将输出值送给分类器,达到分类的目的。

图4. 卷积神经网络结构图

2.2.2 基于卷积神经网络的模型

通过结合局部感受野、共享权重、空间或时间上的池化降采样三大特点,CNN可充分利用人脸图像本身包含的局部性等特征,所具有的强鲁棒性和容错能力可保证对空间平移、扭曲、缩放一定程度上的位移的不变性[37,40]。此外CNN的局部连接、权值共享及池化操作也可有效降低网络模型的复杂度、减少训练参数数目,更易于训练和优化。

Nourabadi等在2013年提出了一种基于CNN的利用单张人脸图像来解决姿态变化问题的方法。首先,通过姿势分类器模型估计每个图像的姿势。然后,除了使用2D图像信息以外,还使用估计的姿势代码来重构深度图。最后,使用估计的深度图和姿势代码提供用于身份识别的人脸正面化图像。该方法通过深度重建双向模型将图像旋转到正面,获得了最佳的身份识别精度。

Zhu等在2014年基于CNN提出一种新的深度学习框架恢复人脸图像的正面图像。与在受控2D环境中评估或使用3D信息的现有人脸正面化生成方法不同,该框架可直接从具有复杂变体的人脸图像到其标准视图中学习变换。在训练阶段,为避免手动训练从标准视图图像标记标签的昂贵过程,设计了一种新的度量标准,可以自动为每个身份选择或合成标准视图图像。

Yim J等在2015年提出了一个多任务学习框架,通过训练一个DNN网络,将一幅人脸和一个表示目标姿态的二值编码作为输入,在保持人脸ID同时将任意姿态和光照人脸旋转到目标姿态,且目标姿态可以人为控制。

Aaron S等在2017年通过在包含2D图像和3D面部模型或扫描的适当数据集上训练CNN来解决人脸重建中大型面部姿势,表情和不均匀照明上建立密集的对应关系局限性的问题。该方法的CNN只需处理单个2D面部图像,不需要精确对齐,也无需建立图像之间的密集对应关系,就可以用于任意的面部姿势和表情的生成,并且可以用于绕过3D可变形模型的构建和拟合来重建整个3D面部几何形状包括面部的不可见部分。

ZhangZhihong等在2018年在2014年提出了一种基于外观流的人脸正面卷积神经网络(A3F-CNN)。具体来说,A3F-CNN学习在非正面和正面之间建立密集的对应关系。一旦建立了对应关系,就可以通过显式地"移动"来自非正面像素的像素来合成正面。通过这种方式,合成的正脸可以保留精细的面部纹理。为了提高训练的收敛性,提出了一种由外流引导的学习策略。另外,应用生成对抗性网络损失来获得更具真实感的面部,并引入了面部镜像方法来处理自遮挡问题。结果表明,在受控和非受控照明环境下,A3F-CNN都可以合成更多逼真的人脸。

图5. A3F-CNN网络结构图

Yudong Guo等在2019年提出了一种新颖的基于CNN的框架来实现实时的详细人脸逆向渲染。具体来说,该框架为每个帧使用两个CNN,即CoarseNet和FineNet。第一个完全估计粗尺度几何,反照率,照明和姿势参数,第二个重建在像素级别编码的精细尺度几何。借助结构良好的大规模训练数据,该框架可以实时恢复详细的几何形状,反照率,照明,姿势和投影参数。

2.3 基于生成式对抗网络的模型

2.3.1 生成式对抗网络基本概念

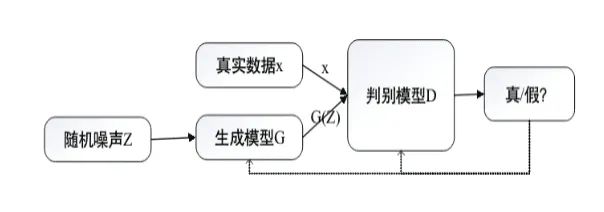

Goodfellow等在2014年首次提出了生成式对抗网络( generative adversarial networks,GAN),GAN采用了博弈论中二人零和博弈的思想(即二人的利益之和为零,一方的所得正是另一方的所失),由一个生成器和一个判别器构成。生成器捕捉真实数据样本的潜在分布,并生成新的数据样本;判别器是一个二分类器,判别输入的是真实数据还是生成数据。生成器和判别器均可采用深度神经网络模型实现,其结构如图6所示。

图6. GAN网络结构图

近年来,专家学者针对原始GAN框架本身存在的问题和在实际应用中存在的问题,在原始GAN的基础上做出改进,如针对原始GAN的输入隐变量z是非结构化的,不知道隐变量中的每一位数分别控制着什么属性的问题,CGAN采用监督学习的方式,将随机噪声z和类别标签c作为生成器的输入,判别器则将生成的样本/真实样本与类别标签作为输入,以此学习标签和图片之间的关联性;针对GAN网络在训练过程中需要成对的训练样本的问题,CycleGAN采用两个镜像对称的GAN构成了一个环形网络,形成一个由数据域A到数据域B的普适性映射,学习数据域A和B的风格之间的变换而非具体的数据a和b之间的一一映射关系,实现了输入的两张图片可以是任意的两张图片,也就是非对称图片的目的。

2.3.2 基于生成式对抗网络的模型

相比其他深度学习模型,GAN生成的数据的复杂度和维度是线性相关的,要生成一个更大的图像,不会像传统模型一样面临指数上升的计算量,它只是一个神经网络线性增大的过程。其次,GAN先验假设非常少,可以在不对人脸图像进行任何的显式参数分布假设的情况下生成更高质量的正面化人脸图像^[74]^。因此相较于其他网络,GAN更适合用于人脸正面化生成。

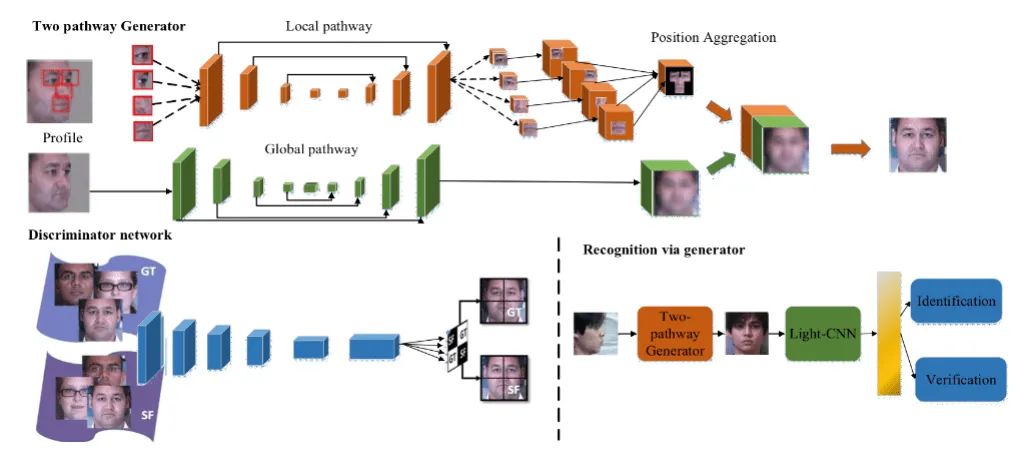

Rui Huang等基于GAN网络提出了一种同时感知全局结构和局部细节的双通道生成对抗网络(TP_GAN),用于人脸正面化生成。TP_GAN网络为了很好地约束病态合成问题,进一步在训练过程中引入了对抗性损失、对称性损失和身份保持损失。提出的TP-GAN不仅能获得令人信服的感知结果,而且在大姿态人脸识别方面也能取得较好的效果。

图7. TP_GAN网络结构图

Jiaxin Ma提出的PWGAN是一种基于姿态加权的生成对抗网络,该网络增加了一个预先训练好的姿态认证模块来学习人脸姿态信息。充分利用了位姿信息,使生成网络更加了解人脸特征,获得更好的生成效果。

Jie Cao等观察到现有模型生成的人脸正面化图像的真实感和身份保持之间没有明确的关系定义,因此基于GAN,提出了一种三维辅助双生成对抗网络(AD-GAN)来精确地将输入人脸图像的偏航角旋转到任意指定的角度。该模型可以改变输入人脸图像的姿态,同时保持图像的真实感。

传统的姿态不变人脸识别方法要么是对非正面人脸图像进行逐型正面化,要么是从非正面人脸图像中学习姿态不变的再现。Luan Tran等认为更可取的做法是联合执行这两项任务,以允许它们相互利用,基于此提出了具有三种不同新奇性的纠缠表示学习生成对抗网络(DR-GAN)。DR-GAN在CGAN网络的基础上,增加了一些新的特性,包括编码器-解码器结构生成器、位姿编码、鉴别器中的位姿分类以及一个集成的多图像融合方案。

图8. DR_GAN网络结构图

Zhu-Liang Chen等提出了一种基于条件生成对抗网络(cGAN)的视频监控场景中用于识别人脸的方法,该方法可以从视频中输入多个姿势变化的人脸。实验结果表明,该方法可以从真实视频监控场景收集的来自19个人的43276张面部图像的数据集上,生成合适的正面面部并将面部识别能力提高20%左右。

基于生成式对抗网络进行人脸正面化生成的模型还有FIGAN,PIGAN,PPN-GAN,CAPG-GAN,FNM等,在GAN网络的基础上,针对生成对抗网络存在训练难和训练不稳定,对于身份信息也无法很好地保持等问题,对GAN网络进行了改进和优化,使得模型适用于所有角度的人脸正面化生成。

2.4 讨论

综上,基于深度学习的人脸生成方法,是借助深度学习强大的拟合能力来合成虚拟视角的人脸,以生成正面化的人脸图像,表1罗列了基于深度学习模型优缺点。

3. 基于混合模型人脸正面化生成模型

单一的网络模型,往往所提取的特征类别单一,不能覆盖所有的特征信息。采用多个模型融合的方式,可以利用不同模型的特性,发挥不同模型的生成人脸正面化图像的优势。同时权衡不同模型的相关与制约关系,考虑到不同模型的优化目标,可以获得更好的生成效果。现有基于混合模型的人脸正面化生成模型大多是3D模型和深度学习模型的集合,如3D模型+自编码器,3D模型+卷积网络,3D模型+GAN网络。

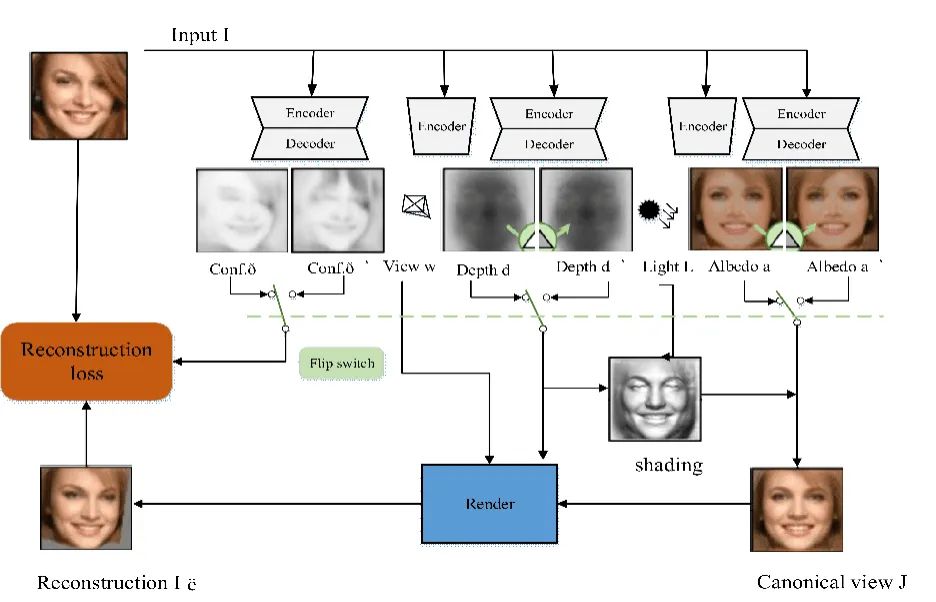

3D模型+自编码器的模型如Shangzhe Wu等基于自动编码器和3D神经渲染模型提出了一种不需要外部超视觉,直接从单视图图像中学习三维可变形物体信息的方法。该方法通过预测对称映射来对可能对称但不一定对称的对象进行建模,并使用模型的其他组件端到端的学习。

图9. Shangzhe Wu等提出的方法

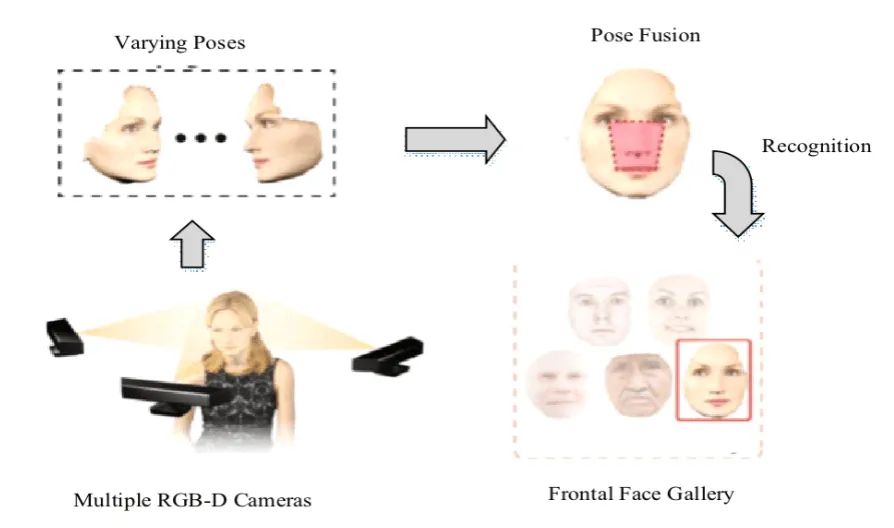

3D模型+卷积网络的模型如Ding Y等为了提高3D人脸识别算法的准确率,开发了一种有效的姿势融合算法,该算法可将人脸正面化并组合多个输入。该算法基于深度特征提取器的卷积神经网络(CNN)从规范化的规范彩色图像中提取2D特征。然后,将在3D面部网格上计算出的面部界标之间的表达不变测地距离作为3D几何特征。最后,我们将这些2D和3D功能连接起来,以训练人脸识别的SVM模型。针对人脸转正部分该算法使用3D旋转矩阵为这些变化建模,并反转旋转以使人脸正面化。同时为了估算旋转参数,将3D面部的鼻子区域与标准正面平均面部的鼻子模板进行比较,然后将它们融合以获得具有完整面部标志集的正面模型。通过实验和与最先进方法的比较,我们证明了我们的方法可以实现最高的面部识别率,并且对于姿势和表情变化具有鲁棒性。

图10. Ding等提出的方法

3D模型+GAN网络的模型如Xi Yin等基于3DMM模型和GAN网络提出了一种新颖的深度3D可变形模型条件化的人脸正面化生成对抗网络FF-GAN,该框架融合了来自深度3DMM和面部识别CNN的元素。Cao等^[63]^提出了一种高保真位姿不变模型(HF-PIM),以获得高分辨率的真实感和保身份的正面化结果。HF-PIM结合了3D和基于GAN的方法的优点,通过一种新的面部纹理融合扭曲程序对轮廓图像进行正面处理。

Hang Zhou等为解决生成结果受到数据源的规模和范围的限制,提出了一种新颖的无监督框架,该框架利用3D人脸建模和CycleGAN来构成我们的构建块,可以在不损失细节的情况下将3D旋转和面部渲染应用到任意角度。

图11. hangzhou等提出的方法

3.1讨论

综上,现有基于混合模型的方法,充分利用了3D模型,卷积网络模型,编码器模型和生成式对抗网络模型的优点,通过两个模型或者多个模型的组合,达到了不同模型之间的优势互补,解决了单一模型中数据源规模和范围受限制,生成图像细节丢失,人脸正面图像存在伪影等问题。由于GAN网络能够重建图像细节,3D模型和GAN网络的组合是近年来广泛使用的模型。

4. 常用数据集介绍

本节针对近年来人脸正面化生成常用的数据集进行了详细的介绍。

FERET是由FERET项目创建,此图像集包含大量的人脸图像,并且每幅图中均只有一个人脸。该数据集中,同一个人的照片有不同表情、光照、姿态和年龄的变化。包含1万多张多姿态和光照的人脸图像,是人脸识别领域应用最广泛的人脸数据库之一。但是其中的多数人是西方人,且每个人所包含的人脸图像的变化比较单一。

Multi_PIE是由美国卡耐基梅隆大学建立。所谓"PIE"就是姿态(Pose),光照(Illumination)和表情(Expression)的缩写。CMU Multi-PIE人脸数据库是在CMU-PIE人脸数据库的基础上发展起来的。包含337位志愿者的75000多张多姿态,光照和表情的面部图像。其中的姿态和光照变化图像也是在严格控制的条件下采集的,目前已经逐渐成为人脸识别领域的一个重要的测试集合。

LFW提供的人脸图片均来源于生活中的自然场景,包含了5749名受试者的13000多张面部图像,这些图像中存在不同的姿势,表情,光照和遮挡方式。

CelebA是CelebFaces Attribute的缩写,意即名人人脸属性数据集,其包含10177个名人身份的202599张人脸图片,每张图片都做好了特征标记,包含人脸bbox标注框、5个人脸特征点坐标以及40个属性标记,CelebA由香港中文大学开放提供,广泛用于人脸相关的计算机视觉训练任务。

CFP由500名受试者组成,每个受试者有10张正面和4张侧面图像。

CAS-PEAL是中科院计算技术研究所在2003年完成的包含1040位志愿者的共99450幅人脸的图片的数据库。该数据库涵盖了手势,表情,装饰,光照,背景,距离和时间等特征的变化。

IJB-A包括5396张图像和20412个视频帧,用于500个受试者,这是一个不受控制的姿态变化的挑战。与以前的数据库不同,IJB-A定义了人脸模板匹配,其中每个模板包含不同数量的图像。它由10个文件夹组成,每个文件夹是整个集合的一个不同的分区。

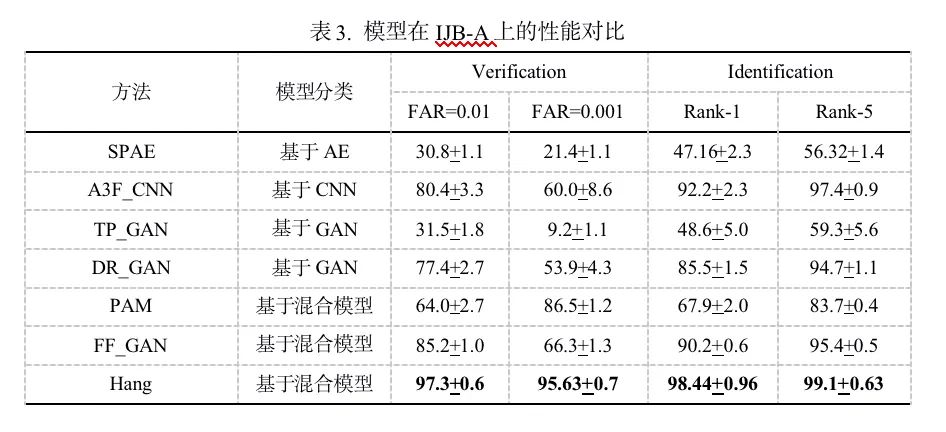

表2和表3给出了不同模型在LFW和IJB-A数据集上的ACC,AUC,Verification和Identification的结果。

综合上述分析,基于3D重建模型的方法依赖于大量扫描的人脸三维数据实现目标人脸的正面化生成,此方法的缺陷在于依赖大量,准确且精细的三维扫描数据,计算量大,比较耗时;基于CNN端到端的方法,不需要大量的三维扫描人脸数据从输入人脸图像中提取对应的参数向量,可通过一系列网络约束,还原出各个角度下的人脸图像,但形变可控性不强,完全依赖于网络中的监督信息;基于GAN的模型充分利用了生成式对抗网络的优点,实现了大姿态人脸的正面化生成,但是生成的图像容易出现身份信息丢失的现象。基于混合模型的方法在定量和定性分析中均表现较优。

5. 总结与展望

本文针对人脸正面化生成问题进行了分析,分别从基于3D模型的方法,基于深度学习的方法和基于混合模型的方法三个方面进行了详细的介绍,并通过实验对比分析了不同模型的实验效果,从目前基于发展状况来看,以下几个方面的工作仍然值得关注:

现有算法优化。现有人脸正面化生成模型在大多数场景和自然环境下具有较好的稳健性和鲁棒性,但是对于极端的坏境(如图片具有嘈杂的纹理和阴影,具有极端的关照等),生成的正面人脸的质量偏低,因此对更加复杂的图像,可以在现有算法的基础上使用多个规范视图或者不同的3D模型结合新提出的算法或模型,构建更加稳定高效的人脸正面化生成模型。

与人脸属性编辑的组合。人脸属性包括表情,姿态,性别,年龄等。单一的对姿态进行矫正虽然能够提高识别的准确率,但是忽略了其他属性对人脸识别的影响,考虑对多种属性进行编辑,同时解耦各个属性之间的相关性,使得生成的人脸图像更符合真实图像,进一步提高识别的准确率。

实际应用场景需求。目前人脸正面化生成研究在人脸识别领域已经得到了认可,但是该研究大多是以理论研究为基础,应用于实际场景的较少,因此如何把现有的模型和具体的实际场景如视频监控,刑侦识别等需求相结合是一个非常有价值的研究方向。

总之,在未来的工作中,在人脸正面化工作的基础上,重点需要在信息融合,真实场景应用等方面展开研究,因此仍需研究者提出更多有创新性、实用性的模型和方法。

作者: 宁欣^1,2,3^,南方哲^2,3^,许少辉^2,3^,于丽娜^1^,张丽萍^1,2,3^

单位信息: 1、中国科学院半导体研究所 高速电路与神经网络实验室,2、威富集团形象认知计算联合实验室,3、深圳市威富视界有限公司

引用本文为: Ning Xin, Nan Fangzhe, Xu Shaohui, Yua Lina, Liping, Zhang. Multi‐view frontal face image generation: A survey.[J]. Concurrency and Computation: Practice and Experience, 2020:e6147.https://doi.org/10.1002/cpe.6147

本文仅做学术分享,如有侵权,请联系删文。

下载1

在「3D视觉工坊」公众号后台回复:3D视觉,即可下载 3D视觉相关资料干货,涉及相机标定、三维重建、立体视觉、SLAM、深度学习、点云后处理、多视图几何等方向。

下载2

在「3D视觉工坊」公众号后台回复:3D视觉github资源汇总,即可下载包括结构光、标定源码、缺陷检测源码、深度估计与深度补全源码、点云处理相关源码、立体匹配源码、单目、双目3D检测、基于点云的3D检测、6D姿态估计源码汇总等。

下载3

在「3D视觉工坊」公众号后台回复:相机标定,即可下载独家相机标定学习课件与视频网址;后台回复:立体匹配,即可下载独家立体匹配学习课件与视频网址。

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的知识点汇总、入门进阶学习路线、最新paper分享、疑问解答四个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近3000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、可答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~