- 1优秀智慧园区案例 - 青岛自贸片区·中德生态园智慧园区,万字长文解析先进智慧园区建设方案经验_青岛中德智慧谷

- 2空指针在java中的环境配置,轻松搞定项目中的空指针异常Caused by: java.lang.NullPointerException: null...

- 3如何使用python对BigQuery进行操作_python3 t_bigquery.py -type=h5_marketing

- 4Pickit 3 - MPLAB Target device ID does not match 解决办法之一_pckit3 id不匹配

- 5Android音频模块启动流程分析_audioserver.rc

- 6文心ERNIE 3.0 Zeus千亿参数大模型,一键生成“学术范儿”论文标题

- 7python 如何查找文件_Python 如何查找特定类型文件

- 8掌握命令提示符(CMD):Windows命令行工具的基本指南

- 9Django数据库——objects_django objects

- 10Nodejs实现的戏曲购票微信小程序

2022最新!基于深度transformer的时间序列异常检测模型

赞

踩

- 点击上方“python与机器智能”,选择“星标”公众号

- 重磅干货,第一时间送达

论文:TranAD: Deep Transformer Networks for Anomaly Detection in Multivariate Time Series Data

代码链接:来源:VLDB 2022

文章链接:https://arxiv.org/abs/2201.07284

代码链接:https://github.com/imperial-qore/tranad

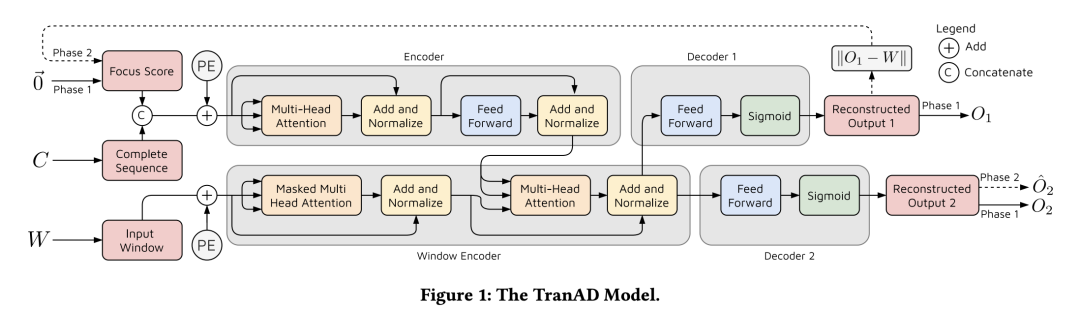

在本文中,作者提出了 TranAD,这是一种基于深度transformer的异常检测和诊断模型,它使用基于注意力的序列编码器来快速执行推理,并了解数据中更广泛的时间趋势。TranAD 使用基于焦点分数的自我调节来实现强大的多模态特征提取和对抗训练以获得稳定性。此外,与模型无关的元学习 (MAML) 使得可以使用有限的数据训练模型。对六个公开可用数据集的广泛实证研究表明,TranAD 可以通过数据和高效的训练在检测和诊断性能方面优于最先进的基线方法。具体来说,与基线相比,TranAD 将 F1 分数提高了 17%,将训练时间减少了 99%。

01

研究背景

多变量时间序列数据中的有效异常检测和诊断对于现代工业应用具有重要意义。然而,构建一个能够快速准确地查明异常观察的系统是一个具有挑战性的问题。这是由于缺乏异常标签、高数据波动性以及现代应用程序中对超低推理时间的需求。尽管很多出现了用于异常检测的深度学习方法,但其中只有少数能够解决所有这些挑战。

02

方法原理

Transformer 是流行的深度学习模型,已用于各种自然语言和视觉处理任务。在这篇论文中,作者使用对Transformer架构的深度重构来完成时间序列数据中的异常检测任务。就像其他编码器-解码器模型一样,在转换器中,输入序列会经历多次基于注意力的转换。图 1 显示了 TranAD 中使用的神经网络的架构。编码器对完整序列进行编码。窗口编码器使用它来创建输入窗口

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。