- 1/etc/security/cacerts 只读权限_cp: /system/etc/security/cacerts/9a5ba575.0: read-

- 2(十)VUE侧边菜单栏导航--基于SpringBoot+MySQL+Vue+ElementUI+Mybatis前后端分离面向小白管理系统搭建_elementui侧边导航栏

- 3Python 使用mysql.connector、pymysql和 MYSQLdb(MysqlClient)操作MySQL数据库_python使用mysqlclient

- 4蓝桥杯嵌入式第十五届省赛模拟赛第三场——程序设计部分_蓝桥杯嵌入式15届模拟题

- 5【Protobuf协议】003-嵌套类型、更新一个消息类型、Any、Oneof、Map(映射)、包_protobuf any

- 6估值一亿的AI核心代码现已开源_7-2 估值一亿的ai核心代码 c语言

- 7idea中怎么忽略(ignore)掉 .idea等文件(亲测)_idea忽略.idea文件

- 8【Git】说说Git中开发测试的使用&Git分支&Git标签的使用场景_git 什么时候使用标签什么时候使用分支

- 9spring计划任务 向webSocket发送心跳包_spring websocket 心跳

- 10花 2 个月备战字节跳动Java岗,3 轮面试拿下 60W Offer_字节跳动java面试几轮

kimi开放API使用了,来看如何使用_kimi api

赞

踩

更多精彩内容在公众号。

kimi现在算是国内火得不行的AI工具。最近使用人太多,都经常出现响应不过来的情况。借助这波热潮,kimi顺势推出了API使用。

来看kimi的官方介绍使用。https://platform.moonshot.cn

文本生成模型

Moonshot的文本生成模型(指moonshot-v1)是训练用于理解自然语言和书面语言的,它可以根据输入生成文本输出。对模型的输入也被称为“prompt”。通常我们建议您提供明确的指令以及给出一些范例,来让模型能够完成既定的任务,设计 prompt 本质上就是学会如何“训练”模型。moonshot-v1模型可以用于各种任务,包括内容或代码生成、摘要、对话、创意写作等。

Token

文本生成模型以 Token 为基本单位来处理文本。Token 代表常见的字符序列。例如,单个汉字"夔"可能会被分解为若干 Token 的组合,而像"中国"这样短且常见的短语则可能会使用单个 Token 。大致来说,对于一段通常的中文文本,1 个 Token 大约相当于 1.5-2 个汉字。

需要注意的是,对于我们的文本模型,Input 和 Output 的总和长度不能超过模型的最大上下文长度。

模型列表

你可以使用我们的 List Models API 来获取当前可用的模型列表。

当前的,我们支持的模型有:

-

moonshot-v1-8k: 它是一个长度为 8k 的模型,适用于生成短文本。 -

moonshot-v1-32k: 它是一个长度为 32k 的模型,适用于生成长文本。 -

moonshot-v1-128k: 它是一个长度为 128k 的模型,适用于生成超长文本。

以上模型的区别在于它们的最大上下文长度,这个长度包括了输入消息和生成的输出,在效果上并没有什么区别。这个主要是为了方便用户选择合适的模型。

使用方法:

需要提供一个 API 密钥和一个模型名称。模型名称在前面已经列出。那么首先申请一个API密钥

API密钥申请在kimi的控制台:https://platform.moonshot.cn/console/info

账号登录后看到账户总览里面,送了15元

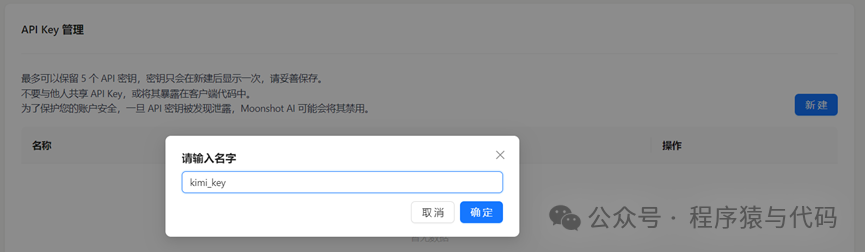

在API key管理界面中新建一个key

生成后可以看到创建的key,注意:密钥是不会在界面上显示的,创建成功后需要自己保存。

python调用方法:

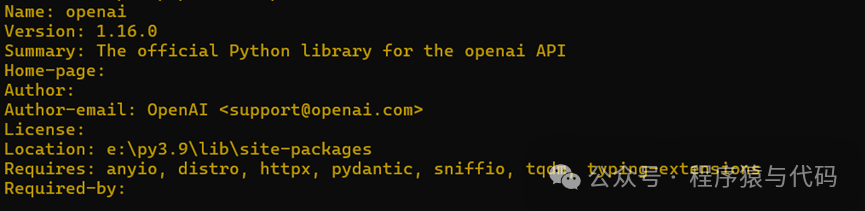

首先安装openai库

pip3 install openaipip3 show openai可以查看openai的版本.openai的版本要大于1.0

来看一个代码示例,在这个例子中让kimi给出了python lxml库的介绍以及使用方法。其中api_key替换成自己申请的密钥

- from openai import OpenAI

-

- client = OpenAI(

- api_key="api_key",

- base_url="https://api.moonshot.cn/v1",

- )

-

- completion = client.chat.completions.create(

- model="moonshot-v1-8k",

- messages=[

- {"role": "system",

- "content": "你是 Kimi,由 Moonshot AI 提供的人工智能助手,你更擅长中文和英文的对话。你会为用户提供安全,有帮助,准确的回答。同时,你会拒绝一切涉及恐怖主义,种族歧视,黄色暴力等问题的回答。Moonshot AI 为专有名词,不可翻译成其他语言。"},

- {"role": "user", "content": "你好,请给出python库lxml的介绍以及详细用法"}

- ],

- temperature=0.3,

- )

-

- print(completion.choices[0].message)

返回的结果如下。格式需要另外整理下

ChatCompletionMessage(content="你好!`lxml` 是一个用 Python 编写的库,它提供了一个简单而强大的方式来处理 XML 和 HTML 数据。`lxml` 具有多种功能,包括解析、创建、修改、查询和转换 XML 和 HTML 文档。它支持 XPath 和 XSLT,并且通常被认为是 Python 中处理 XML 数据最快的库之一。\n\n### 特点:\n- 高性能:`lxml` 使用 C 语言编写核心解析器,因此它比纯 Python 解决方案更快。\n- 易用性:`lxml` 提供了一个简洁的 API,使得处理 XML 和 HTML 变得简单。\n- 功能全面:支持 XPath 表达式进行数据查询,XSLT 转换,以及轻松处理命名空间。\n\n### 安装:\n你可以使用 pip 来安装 `lxml` 库。在命令行中运行以下命令:\n\n```bash\npip install lxml\n```\n\n### 基本用法:\n\n#### 解析 XML/HTML:\n```python\nfrom lxml import etree\n\n# 解析字符串\nxml_string = '<root><element>Content</element></root>'\ntree = etree.fromstring(xml_string)\n\n# 解析文件\nwith open('example.xml', 'r') as file:\n tree = etree.parse(file)\n\n# 遍历 XML 元素\nfor element in tree.iter('element'):\n print(element.text)\n```\n\n#### 创建 XML:\n```python\n# 创建一个新的 XML 树\nroot = etree.Element('root')\nchild = etree.Element('child')\ntext = etree.SubElement(child, 'text', text='Some content')\n\n# 添加子元素到根元素\nroot.append(child)\n\n# 将 XML 树写入字符串\nxml_string = etree.tostring(root, pretty_print=True)\nprint(xml_string)\n```\n\n#### 使用 XPath 查询:\n```python\n# 假设我们已经解析了一个 XML 文档到 tree 变量\n# 使用 XPath 查询选择所有 <element> 标签\nfor element in tree.xpath('//root/element'):\n print(element.text)\n\n# 使用 XPath 选择第一个 <element> 标签\nelement = tree.xpath('//root/element[1]')\nprint(element[0].text if element else None)\n```\n\n#### 应用 XSLT 转换:\n```python\nfrom lxml import xslt\n\n# 假设我们有一个 XSLT 文件 transform.xslt\nxslt_string = 'transform.xslt'\n\n# 编译 XSLT\ntransform = xslt.parse(", rolxslt_string)\n\n# 应用 XSLT 转换到 XML 文档\nresult_tree = transform(tree)\nprint(etree.tostring(result_tree, pretty_print=True))\n```\n\n这些是 `lxml` 的一些基本用法。`lxml` 的功能非常强大,可以处理复杂的 XML 和 HTML 数据,包括但不限于数据抓取、数据清洗、模板转换等。如果你需要更详细的文档和高级用法,可以查看 `lxml` 的官方文档。e='assistant', function_call=None, tool_calls=None)上传文档并解析的方法:

- from pathlib import Path

- from openai import OpenAI

-

- client = OpenAI(

- api_key="MOONSHOT_API_KEY",

- base_url="https://api.moonshot.cn/v1",

- )

-

- # xlnet.pdf 是一个示例文件, 我们支持 pdf, doc 以及图片等格式, 对于图片和 pdf 文件,提供 ocr 相关能力

- # xlnet.pdf 是一个示例文件, 我们支持 pdf, doc 以及图片等格式, 对于图片和 pdf 文件,提供 ocr 相关能力

- file_object = client.files.create(file=Path("xlnet.pdf"), purpose="file-extract")

-

- # 获取结果

- # file_content = client.files.retrieve_content(file_id=file_object.id)

- # 注意,之前 retrieve_content api 在最新版本标记了 warning, 可以用下面这行代替

- # 如果是旧版本,可以用 retrieve_content

- file_content = client.files.content(file_id=file_object.id).text

-

- # 把它放进请求中

- messages=[

- {

- "role": "system",

- "content": "你是 Kimi,由 Moonshot AI 提供的人工智能助手,你更擅长中文和英文的对话。你会为用户提供安全,有帮助,准确的回答。同时,你会拒绝一切涉及恐怖主义,种族歧视,黄色暴力等问题的回答。Moonshot AI 为专有名词,不可翻译成其他语言。",

- },

- {

- "role": "system",

- "content": file_content,

- },

- {"role": "user", "content": "请简单介绍 xlnet.pdf 讲了啥"},

- ]

-

- # 然后调用 chat-completion, 获取 kimi 的回答

- completion = client.chat.completions.create(

- model="moonshot-v1-32k",

- messages=messages,

- temperature=0.3,

- )

-

- print(completion.choices[0].message)

更多的使用方法参考API文档:

收费限速标准

kimi的收费标准参考下表

限速标准如下

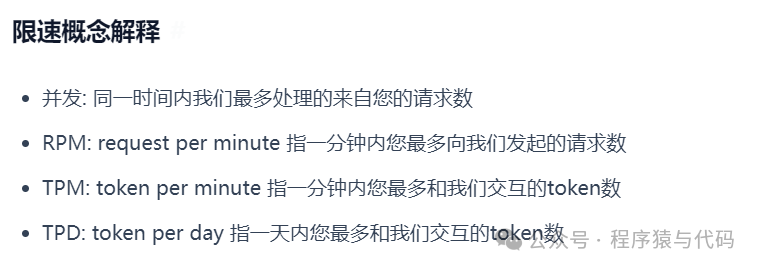

官方的解释:

速率限制通过4种方式衡量:并发、RPM(每分钟请求数)、TPM(每分钟 Token 数)、TPD(每天 Token 数)。速率限制可能会在任何一种选项中达到,取决于哪个先发生。例如,你可能向 ChatCompletions 发送了 20 个请求,每个请求只有 100 个 Token ,那么你就达到了限制(如果你的 RPM 限制是 20),即使你在这些 20 个请求中没有发满 200k 个 Token (假设你的TPM限制是 200k)。

对网关,出于方便考虑,我们会基于请求中的 max_tokens 参数来计算速率限制。这意味着,如果你的请求中包含了 max_tokens 参数,我们会使用这个参数来计算速率限制。如果你的请求中没有包含 max_tokens 参数,我们会使用默认的 max_tokens 参数来计算速率限制。当你发出请求后,我们会基于你请求的 token 数量加上你 max_tokens 参数的数量来判断你是否达到了速率限制。而不考虑实际生成的 token 数量。

而在计费环节中,我们会基于你请求的 token 数量加上实际生成的 token 数量来计算费用。

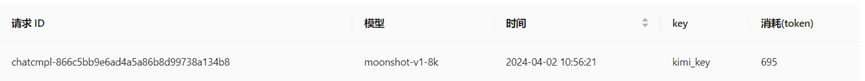

我刚才的查询消耗695个token,还没到1M的标准

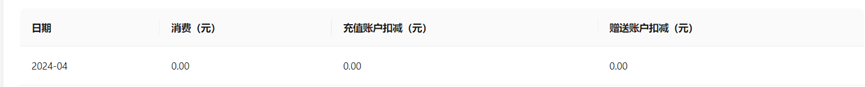

因此还没扣钱

这收费和限速标准还是略贵