- 12024年Q1季度冰箱行业线上市场销售数据分析

- 22021爱分析·云计算厂商全景报告_博云谐云

- 3快速入门 KBQA问答系统的实现_neo4j kbqa

- 4Node.js 开发者需要知道的 13 个常用库

- 5Yolov8优化:融合注意力机制与卷积的最新移动端高效网络架构_cloformer速度

- 6开源模型应用落地-解锁大语言模型的无限潜能

- 7记一次虚拟机CentOs设置静态IP_虚拟机centos设置ip地址

- 8HDFS的Java API操作_hdfs的java apl 操作

- 9verilog I2C_eeprom 手册分析及代码编写思路_eeprom代码

- 10GPIO模拟I2C通信协议(二)_摸拟24c08页读写

redis黑马外卖实战项目源码实现_外卖项目消息队列

赞

踩

文章目录

- 1.项目介绍

- 源码后端地址

- yaml配置

- pom文件

- 1、短信登录

- 2、商户查询缓存

- 3、优惠卷秒杀

- 4、分布式锁

- 5、分布式锁-redission

- 6、秒杀优化

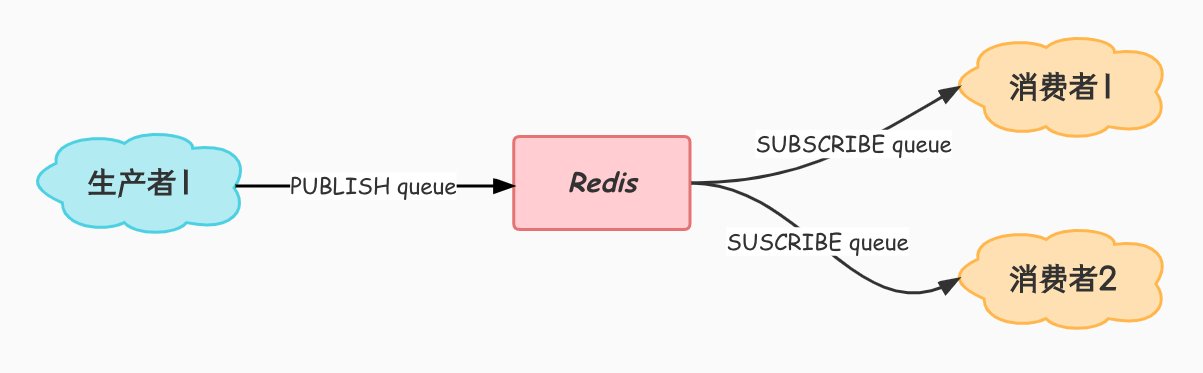

- 7、Redis消息队列

- 秒杀下单 Ultimate VER

- 8. 点赞相关

- 9. 关注相关

- 10、附近商户

- 11、用户签到

- 12、UV统计

- 完整代码

- 代码总思路

- 1.redis实现验证码缓存,token更新

- 2.商铺缓存

- 3.缓存穿透,缓存雪崩,缓存击穿

- 4. 基于互斥锁解决缓存击穿问题

- 5.逻辑过期解决缓存击穿

- 6.超卖问题

- 7.一人一单

- 8.分布式锁集群项目

- 9.redission分布式锁

- 10.秒杀优化基于阻塞队列

- 11.秒杀优化基于消息队列

- 12.点赞用sortedSet

- 13.关注互关用set

- 14.Feed流推送

- 15GEO实现附近商务功能

- 16.BitMap实现用户签到

- 17.UV统计-HyperLogLog

1.项目介绍

- Spring 相关:

Spring Boot 2.x

Spring MVC

数据存储层:

MySQL:存储数据

MyBatis Plus:数据访问框架

Redis 相关:

spring-data-redis:操作 Redis

Lettuce:操作 Redis 的高级客户端

Apache Commons Pool:用于实现 Redis 连接池

Redisson:基于 Redis 的分布式数据网格

工具库:

HuTool:工具库合集

Lombok:注解式代码生成工具

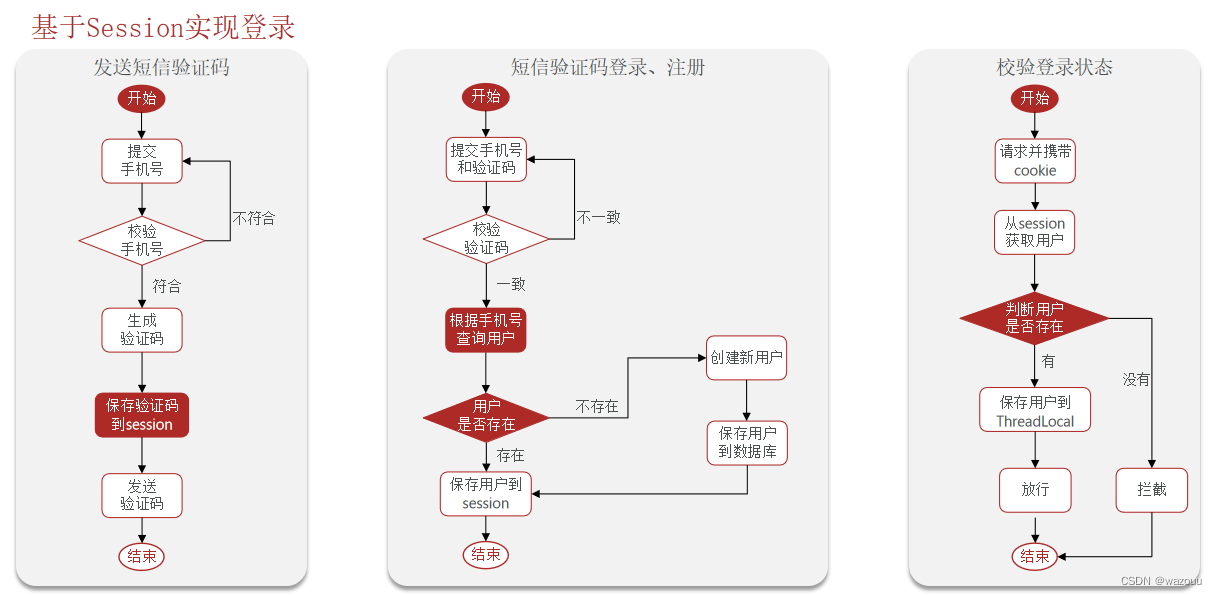

- 短信登录

这一块我们会使用redis共享session来实现

- 商户查询缓存

通过本章节,我们会理解缓存击穿,缓存穿透,缓存雪崩等问题,让小伙伴的对于这些概念的理解不仅仅是停留在概念上,更是能在代码中看到对应的内容

- 优惠卷秒杀

通过本章节,我们可以学会Redis的计数器功能, 结合Lua完成高性能的redis操作,同时学会Redis分布式锁的原理,包括Redis的三种消息队列

- 附近的商户

我们利用Redis的GEOHash来完成对于地理坐标的操作

- UV统计

主要是使用Redis来完成统计功能

- 用户签到

使用Redis的BitMap数据统计功能

- 好友关注

基于Set集合的关注、取消关注,共同关注等等功能,这一块知识咱们之前就讲过,这次我们在项目中来使用一下

- 打人探店

基于List来完成点赞列表的操作,同时基于SortedSet来完成点赞的排行榜功能

源码后端地址

github源码地址

gitee源码地址

yaml配置

server: port: 8081 spring: application: name: hmdp datasource: driver-class-name: com.mysql.cj.jdbc.Driver # url: jdbc:mysql://127.0.0.1:3306/hmdp?useSSL=false&serverTimezone=UTC username: root password: 123456 url: jdbc:mysql://localhost:3306/hmdp?serverTimezone=Asia/Shanghai&useUnicode=true&characterEncoding=utf-8&zeroDateTimeBehavior=convertToNull&useSSL=false&allowPublicKeyRetrieval=true redis: host: 192.168.8.130 port: 6379 password: yangroot lettuce: pool: max-active: 10 max-idle: 10 min-idle: 1 time-between-eviction-runs: 10s jackson: default-property-inclusion: non_null # JSON处理时忽略非空字段 mybatis-plus: type-aliases-package: com.hmdp.entity # 别名扫描包 logging: level: com.hmdp: debug pattern: dateformat: mm:ss.SSS

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

pom文件

<?xml version="1.0" encoding="UTF-8"?> <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd"> <modelVersion>4.0.0</modelVersion> <parent> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-parent</artifactId> <version>2.7.5</version> <relativePath/> <!-- lookup parent from repository --> </parent> <groupId>com.hmdp</groupId> <artifactId>hm-dianping</artifactId> <version>0.0.1-SNAPSHOT</version> <name>hm-dianping</name> <description>Demo project for Spring Boot</description> <properties> <java.version>1.8</java.version> </properties> <dependencies> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-data-redis</artifactId> <exclusions> <exclusion> <artifactId>spring-data-redis</artifactId> <groupId>org.springframework.data</groupId> </exclusion> <exclusion> <artifactId>lettuce-core</artifactId> <groupId>io.lettuce</groupId> </exclusion> </exclusions> </dependency> <dependency> <groupId>org.springframework.data</groupId> <artifactId>spring-data-redis</artifactId> </dependency> <dependency> <groupId>org.apache.commons</groupId> <artifactId>commons-pool2</artifactId> </dependency> <dependency> <groupId>io.lettuce</groupId> <artifactId>lettuce-core</artifactId> <version>6.1.6.RELEASE</version> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-web</artifactId> </dependency> <!-- <dependency>--> <!-- <groupId>mysql</groupId>--> <!-- <artifactId>mysql-connector-java</artifactId>--> <!-- <scope>runtime</scope>--> <!-- <version>5.1.47</version>--> <!-- </dependency>--> <dependency> <groupId>mysql</groupId> <artifactId>mysql-connector-java</artifactId> <scope>runtime</scope> </dependency> <dependency> <groupId>org.projectlombok</groupId> <artifactId>lombok</artifactId> <optional>true</optional> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-test</artifactId> <scope>test</scope> </dependency> <dependency> <groupId>com.baomidou</groupId> <artifactId>mybatis-plus-boot-starter</artifactId> <version>3.4.3</version> </dependency> <!--hutool--> <dependency> <groupId>cn.hutool</groupId> <artifactId>hutool-all</artifactId> <version>5.7.17</version> </dependency> <!--redisson--> <dependency> <groupId>org.redisson</groupId> <artifactId>redisson</artifactId> <version>3.13.6</version> </dependency> <!-- https://mvnrepository.com/artifact/org.aspectj/aspectjweaver --> <dependency> <groupId>org.aspectj</groupId> <artifactId>aspectjweaver</artifactId> <version>1.9.9.1</version> </dependency> </dependencies> <build> <plugins> <plugin> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-maven-plugin</artifactId> <configuration> <excludes> <exclude> <groupId>org.projectlombok</groupId> <artifactId>lombok</artifactId> </exclude> </excludes> </configuration> </plugin> </plugins> </build> </project>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

- 91

- 92

- 93

- 94

- 95

- 96

- 97

- 98

- 99

- 100

- 101

- 102

- 103

- 104

- 105

- 106

- 107

- 108

- 109

- 110

- 111

- 112

- 113

- 114

- 115

- 116

- 117

1、短信登录

1.1、基于Session实现登录流程

@Override public Result sendCode(String phone, HttpSession session) { // 1.校验手机号 if (RegexUtils.isPhoneInvalid(phone)) { // 2.如果不符合,返回错误信息 return Result.fail("手机号格式错误!"); } // 3.符合,生成验证码 String code = RandomUtil.randomNumbers(6); // 4.保存验证码到 session session.setAttribute("code",code); // 5.发送验证码 log.debug("发送短信验证码成功,验证码:{}", code); // 返回ok return Result.ok(); }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

1.2.基于session实现登陆的问题

单体应用时用户的会话信息保存在session中,session存在于服务器端的内存中,由于前前后后用户只针对一个web服务器,所以没啥问题。但是一到了web服务器集群的环境下(我们一般都是用Nginx做负载均衡,若是使用了轮询等这种请求分配策略),就会导致用户小a在A服务器登录了,session存在于A服务器中,但是第二次请求被分配到了B服务器,由于B服务器中没有用户小a的session会话,导致用户小a还要再登陆一次.

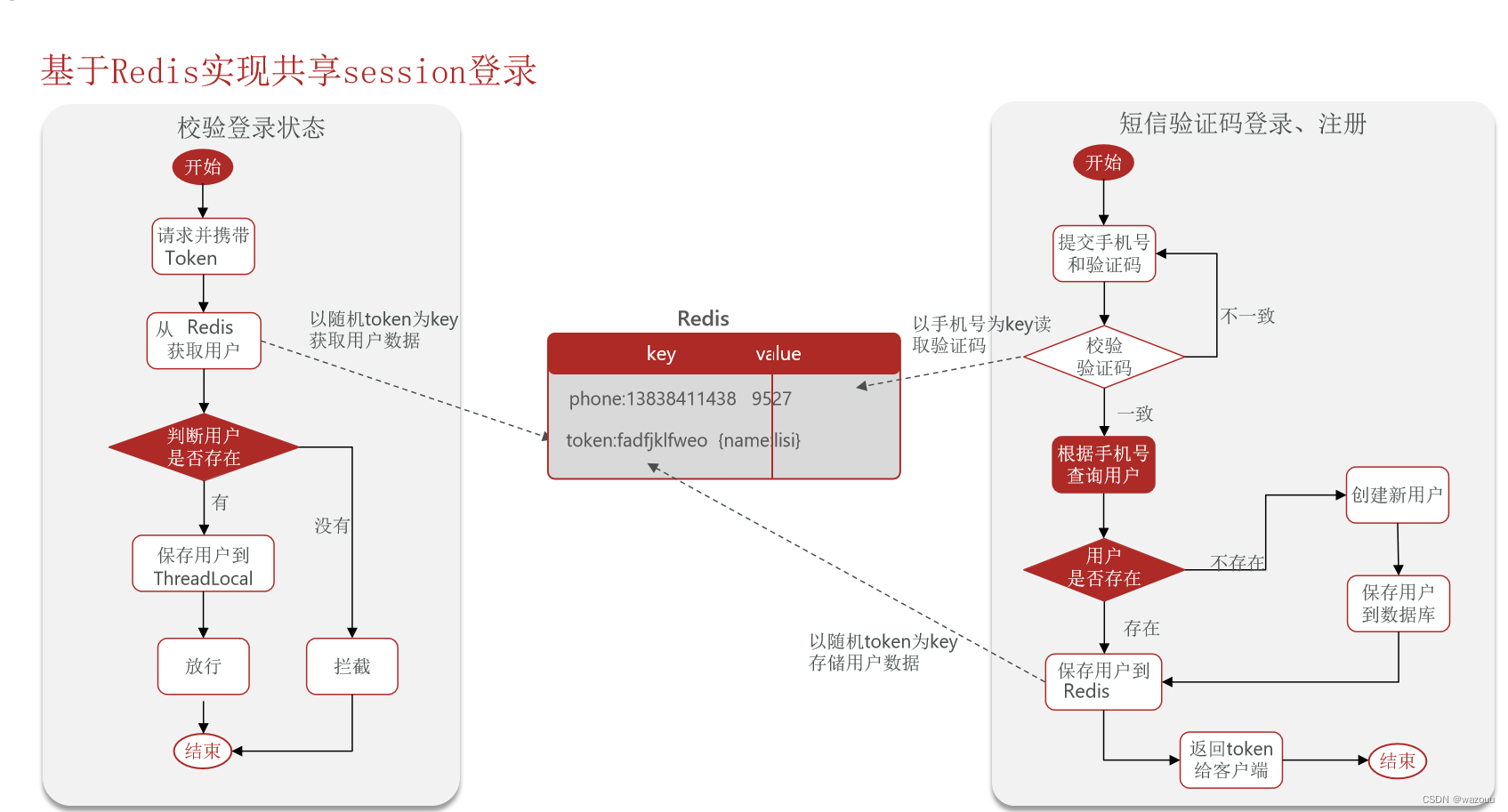

session 的替代方案 应该满足:数据共享;内存存储;key、value 结构(Redis 恰好就满足这些情况)

1.3 Redis 实现共享 session

@Resource private StringRedisTemplate stringRedisTemplate; @Override public Result sendCode(String phone, HttpSession session) { // 1.校验手机号 if (RegexUtils.isPhoneInvalid(phone)) { // 2.如果不符合,返回错误信息 return Result.fail("手机号格式错误!"); } // 3.符合,生成验证码 String code = RandomUtil.randomNumbers(6); // 4.保存验证码到 session stringRedisTemplate.opsForValue().set(LOGIN_CODE_KEY + phone, code, LOGIN_CODE_TTL, TimeUnit.MINUTES); // 5.发送验证码 log.debug("发送短信验证码成功,验证码:{}", code); // 返回ok return Result.ok(); }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

1.4、实现登录拦截功能

在这个方案中,对应路径的拦截,同时刷新登录token令牌的存活时间,但是现在这个拦截器他只是拦截需要被拦截的路径,假设当前用户访问了一些不需要拦截的路径,那么这个拦截器就不会生效,所以此时令牌刷新的动作实际上就不会执行,所以这个方案他是存在问题的.

既然之前的拦截器无法对不需要拦截的路径生效,那么我们可以添加一个拦截器,在第一个拦截器中拦截所有的路径,把第二个拦截器做的事情放入到第一个拦截器中,同时刷新令牌,因为第一个拦截器有了threadLocal的数据,所以此时第二个拦截器只需要判断拦截器中的user对象是否存在即可,完成整体刷新功能。

public class RefreshTokenInterceptor implements HandlerInterceptor { private StringRedisTemplate stringRedisTemplate; public RefreshTokenInterceptor(StringRedisTemplate stringRedisTemplate) { this.stringRedisTemplate = stringRedisTemplate; } @Override public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) throws Exception { // 1.获取请求头中的token String token = request.getHeader("authorization"); if (StrUtil.isBlank(token)) { return true; } // 2.基于TOKEN获取redis中的用户 String key = LOGIN_USER_KEY + token; Map<Object, Object> userMap = stringRedisTemplate.opsForHash().entries(key); // 3.判断用户是否存在 if (userMap.isEmpty()) { return true; } // 5.将查询到的hash数据转为UserDTO UserDTO userDTO = BeanUtil.fillBeanWithMap(userMap, new UserDTO(), false); // 6.存在,保存用户信息到 ThreadLocal UserHolder.saveUser(userDTO); // 7.刷新token有效期 stringRedisTemplate.expire(key, LOGIN_USER_TTL, TimeUnit.MINUTES); // 8.放行 return true; } @Override public void afterCompletion(HttpServletRequest request, HttpServletResponse response, Object handler, Exception ex) throws Exception { // 移除用户 UserHolder.removeUser(); } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

public class LoginInterceptor implements HandlerInterceptor { @Override public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) throws Exception { // 1.判断是否需要拦截(ThreadLocal中是否有用户) if (UserHolder.getUser() == null) { // 没有,需要拦截,设置状态码 response.setStatus(401); // 拦截 return false; } // 有用户,则放行 return true; } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

@Configuration public class MvcConfig implements WebMvcConfigurer { @Resource private StringRedisTemplate stringRedisTemplate; @Override public void addInterceptors(InterceptorRegistry registry) { // 登录拦截器 registry.addInterceptor(new LoginInterceptor()) .excludePathPatterns( "/shop/**", "/voucher/**", "/shop-type/**", "/upload/**", "/blog/hot", "/user/code", "/user/login" ).order(1); // token刷新的拦截器 registry.addInterceptor(new RefreshTokenInterceptor(stringRedisTemplate)).addPathPatterns("/**").order(0); } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

1.5、隐藏用户敏感信息

我们通过浏览器观察到此时用户的全部信息都在,这样极为不靠谱,所以我们应当在返回用户信息之前,将用户的敏感信息进行隐藏,采用的核心思路就是书写一个UserDto对象,这个UserDto对象就没有敏感信息了,我们在返回前,将有用户敏感信息的User对象转化成没有敏感信息的UserDto对象,那么就能够避免这个尴尬的问题了

1.6 思路

第一次登录 :

两个拦截器都通过(login send)

发送验证码,验证码保存到redis

loginformDto( phone,code, password)从redis获得验证码进行验证

成功后根据phone从数据库查出user,如果不存在创建新用户

得到用户之后,随机生成taken,vlaue是 user>userdto>usermap

返回是taken

第二次刷新:

1.拦截器1,获得token,在redis得到usermap > userdto >保存到线程,刷新token有效期

2.拦截器2,判断用户是否存在,存在就放行。

logininterceper inplement handlerintercept 在pre保存线程 after移除线程(防止线程的泄露)

在mvcconfig里面addIntercepter 用registry.addinterceper(new logininter()).excluepath(需要排除 的路径)

/me返回了user(内存压力过大而且返回容易泄露),可以用.copyProperties(user,userDto.classs),现在存拿都是dto

1.7 UserController(/ login /logout /code )

@Slf4j @RestController @RequestMapping("/user") public class UserController { @Resource private IUserService userService; @Resource private IUserInfoService userInfoService; /** * 发送手机验证码 */ @PostMapping("code") public Result sendCode(@RequestParam("phone") String phone, HttpSession session) { // 发送短信验证码并保存验证码 return userService.sendCode(phone, session); } /** * 登录功能 * @param loginForm 登录参数,包含手机号、验证码;或者手机号、密码 */ @PostMapping("/login") public Result login(@RequestBody LoginFormDTO loginForm, HttpSession session){ // 实现登录功能 return userService.login(loginForm, session); } /** * 登出功能 * @return 无 */ @PostMapping("/logout") public Result logout(){ UserHolder.removeUser(); return Result.fail("退出登录"); } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

1.8 UserServiceImpl

@Slf4j @Service public class UserServiceImpl extends ServiceImpl<UserMapper, User> implements IUserService { @Resource private StringRedisTemplate stringRedisTemplate; @Override public Result sendCode(String phone, HttpSession session) { // 1.校验手机号 if (RegexUtils.isPhoneInvalid(phone)) { // 2.如果不符合,返回错误信息 return Result.fail("手机号格式错误!"); } // 3.符合,生成验证码 String code = RandomUtil.randomNumbers(6); // 4.保存验证码到 session stringRedisTemplate.opsForValue().set(LOGIN_CODE_KEY + phone, code, LOGIN_CODE_TTL, TimeUnit.MINUTES); // 5.发送验证码 log.debug("发送短信验证码成功,验证码:{}", code); // 返回ok return Result.ok(); } @Override public Result login(LoginFormDTO loginForm, HttpSession session) { // 1.校验手机号 String phone = loginForm.getPhone(); if (RegexUtils.isPhoneInvalid(phone)) { // 2.如果不符合,返回错误信息 return Result.fail("手机号格式错误!"); } // 3.从redis获取验证码并校验 String cacheCode = stringRedisTemplate.opsForValue().get(LOGIN_CODE_KEY + phone); String code = loginForm.getCode(); if (cacheCode == null || !cacheCode.equals(code)) { // 不一致,报错 return Result.fail("验证码错误"); } // 4.一致,根据手机号查询用户 select * from tb_user where phone = ? User user = query().eq("phone", phone).one(); // 5.判断用户是否存在 if (user == null) { // 6.不存在,创建新用户并保存 user = createUserWithPhone(phone); } // 7.保存用户信息到 redis中 // 7.1.随机生成token,作为登录令牌 String token = UUID.randomUUID().toString(true); // 7.2.将User对象转为HashMap存储 UserDTO userDTO = BeanUtil.copyProperties(user, UserDTO.class); Map<String, Object> userMap = BeanUtil.beanToMap(userDTO, new HashMap<>(), CopyOptions.create() .setIgnoreNullValue(true) .setFieldValueEditor((fieldName, fieldValue) -> fieldValue.toString())); // 7.3.存储 String tokenKey = LOGIN_USER_KEY + token; stringRedisTemplate.opsForHash().putAll(tokenKey, userMap); // 7.4.设置token有效期 stringRedisTemplate.expire(tokenKey, LOGIN_USER_TTL, TimeUnit.MINUTES); // 8.返回token return Result.ok(token); } private User createUserWithPhone(String phone) { // 1.创建用户 User user = new User(); user.setPhone(phone); user.setNickName(USER_NICK_NAME_PREFIX + RandomUtil.randomString(10)); // 2.保存用户 save(user); return user; } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

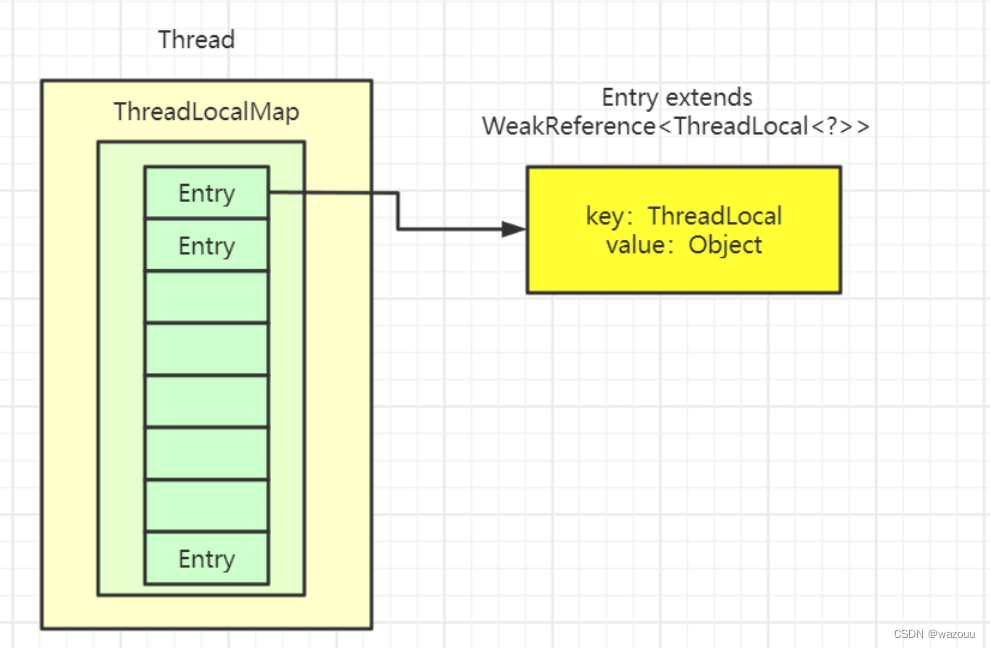

温馨小贴士:关于threadlocal

如果小伙伴们看过threadLocal的源码,你会发现在threadLocal中,无论是他的put方法和他的get方法, 都是先从获得当前用户的线程,然后从线程中取出线程的成员变量map,只要线程不一样,map就不一样,所以可以通过这种方式来做到线程隔离

补充ThreadLocal相关知识22

a.ThreadLocal的数据结构

- Thread类有一个类型为ThreadLocal.ThreadLocalMap的实例变量threadLocals,也就是说每个线程有一个自己的ThreadLocalMap。

- ThreadLocalMap有自己的独立实现,可以简单地将它的key视作ThreadLocal,value为代码中放入的值(实际上key并不是ThreadLocal本身,而是它的一个弱引用)。

- 每个线程在往ThreadLocal里放值的时候,都会往自己的ThreadLocalMap里存,读也是以ThreadLocal作为引用,在自己的map里找对应的key,从而实现了线程隔离。

- ThreadLocalMap有点类似HashMap的结构,只是HashMap是由数组+链表实现的,而ThreadLocalMap中并没有链表结构。

- 我们还要注意Entry, 它的key是ThreadLocal<?> k ,继承自WeakReference, 也就是我们常说的弱引用类型。

b.内存泄露问题

- 由于ThreadLocal的key是弱引用,故在gc时,key会被回收掉,但是value是强引用没有被回收,所以在我们拦截器的方法里必须手动remove()。

原文链接:https://blog.csdn.net/qq_45733304/article/details/126443684

2、商户查询缓存

2.1 认识缓存

缓存(Cache),就是数据交换的缓冲区,俗称的缓存就是缓冲区内的数据,一般从数据库中获取,存储于本地代码(例如:

例1:Static final ConcurrentHashMap<K,V> map = new ConcurrentHashMap<>(); 本地用于高并发

例2:static final Cache<K,V> USER_CACHE = CacheBuilder.newBuilder().build(); 用于redis等缓存

例3:Static final Map<K,V> map = new HashMap(); 本地缓存

- 1

- 2

- 3

- 4

- 5

由于其被Static修饰,所以随着类的加载而被加载到内存之中,作为本地缓存,由于其又被final修饰,所以其引用(例3:map)和对象(例3:new HashMap())之间的关系是固定的,不能改变,因此不用担心赋值(=)导致缓存失效;

缓存数据存储于代码中,而代码运行在内存中,内存的读写性能远高于磁盘,缓存可以大大降低用户访问并发量带来的服务器读写压力

2.1.1 如何使用缓存

实际开发中,会构筑多级缓存来使系统运行速度进一步提升,例如:本地缓存与redis中的缓存并发使用

浏览器缓存:主要是存在于浏览器端的缓存

**应用层缓存:**可以分为tomcat本地缓存,比如之前提到的map,或者是使用redis作为缓存

**数据库缓存:**在数据库中有一片空间是 buffer pool,增改查数据都会先加载到mysql的缓存中

**CPU缓存:**当代计算机最大的问题是 cpu性能提升了,但内存读写速度没有跟上,所以为了适应当下的情况,增加了cpu的L1,L2,L3级的缓存

磁盘缓存:

2.2 添加商户缓存

2.2.1 、缓存模型和思路

标准的操作方式就是查询数据库之前先查询缓存,如果缓存数据存在,则直接从缓存中返回,如果缓存数据不存在,再查询数据库,然后将数据存入redis。

2.1.2、代码如下

代码思路:如果缓存有,则直接返回,如果缓存不存在,则查询数据库,然后存入redis。

@Override public Result queryById(Long id) { String key =CACHE_SHOP_KEY + id; //1.从redis查询商铺缓存 String shopJson = stringRedisTemplate.opsForValue().get(key); //2.判断是否存在 if (StrUtil.isNotBlank(shopJson)){ //3.存在直接返回 Shop shop = JSONUtil.toBean(shopJson, Shop.class); return Result.ok(shop); } //4.不存在返,根据id查询数据库 Shop shop = getById(id); //5.不存在返回错误 if (shop==null){ return Result.fail("店铺不存在"); } //6.存在写入rdis stringRedisTemplate.opsForValue().set("cache:shop:" + id,JSONUtil.toJsonStr(shop)); return Result.ok(shop); }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

//缓存练习,写shop-type/list的缓存

@Service public class ShopTypeServiceImpl extends ServiceImpl <ShopTypeMapper, ShopType> implements IShopTypeService { @Resource private StringRedisTemplate stringRedisTemplate; public Result queryshopTypeList(){ //展示所有的店铺信息 String key =CACHE_SHOPTYPE_KEY ; //1.从redis查询商铺缓存 // String shopJson = stringRedisTemplate.opsForValue().get(key); List<String> strshopTypeList = stringRedisTemplate.opsForList().range(key, 0, -1); ArrayList<ShopType> shopTypes = new ArrayList<>(); //2.判断是否存在 if (!strshopTypeList.isEmpty()){ //3.存在直接返回 for (String s:strshopTypeList) { ShopType shopType = JSONUtil.toBean(s, ShopType.class); shopTypes.add(shopType); } return Result.ok(shopTypes); } //4.不存在,查询数据库 List<ShopType> typeList = query().orderByAsc("sort").list(); //5.不存在直接返回错误 if(typeList.isEmpty()){ return Result.fail("不存在分类"); } //6.存在写入rdis for (ShopType s:typeList) { String shopjson = JSONUtil.toJsonStr(s); strshopTypeList.add(shopjson); } stringRedisTemplate.opsForList().rightPushAll(key,strshopTypeList); return Result.ok(typeList); } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

2.3 缓存更新策略

缓存更新是redis为了节约内存而设计出来的一个东西,主要是因为内存数据宝贵,当我们向redis插入太多数据,此时就可能会导致缓存中的数据过多,所以redis会对部分数据进行更新,或者把他叫为淘汰更合适。

**内存淘汰:**redis自动进行,当redis内存达到咱们设定的max-memery的时候,会自动触发淘汰机制,淘汰掉一些不重要的数据(可以自己设置策略方式)

**超时剔除:**当我们给redis设置了过期时间ttl之后,redis会将超时的数据进行删除,方便咱们继续使用缓存

**主动更新:**我们可以手动调用方法把缓存删掉,通常用于解决缓存和数据库不一致问题

| 内存淘汰 | 超时剔除 | 主动更新 | |

|---|---|---|---|

| 说明 | 不用自己维护。利用 Redis 的内存淘汰机制: 当内存不足时自动淘汰部分数据。 | 下次查询时更新缓存。 给缓存数据添加 TTL 时间,到期后自动删除缓存。 | 编写业务逻辑,在修改数据库的同时,更新缓存。 |

2.3.1 、数据库缓存不一致解决方案:

由于我们的缓存的数据源来自于数据库,而数据库的数据是会发生变化的,因此,如果当数据库中数据发生变化,而缓存却没有同步,此时就会有一致性问题存在,其后果是:

用户使用缓存中的过时数据,就会产生类似多线程数据安全问题,从而影响业务,产品口碑等;怎么解决呢?有如下几种方案

Cache Aside Pattern 人工编码方式:缓存调用者在更新完数据库后再去更新缓存,也称之为双写方

Read/Write Through Pattern : 由系统本身完成,数据库与缓存的问题交由系统本身去处理

Write Behind Caching Pattern :调用者只操作缓存,其他线程去异步处理数据库,实现最终一致

2.3.2 、数据库和缓存不一致采用什么方案

综合考虑使用方案一,但是方案一调用者如何处理呢?

操作缓存和数据库时有三个问题需要考虑:

如果采用第一个方案,那么假设我们每次操作数据库后,都操作缓存,但是中间如果没有人查询,那么这个更新动作实际上只有最后一次生效,中间的更新动作意义并不大,我们可以把缓存删除,等待再次查询时,将缓存中的数据加载出来

-

删除缓存还是更新缓存?

- 更新缓存:每次更新数据库都更新缓存,无效写操作较多

- 删除缓存:更新数据库时让缓存失效,查询时再更新缓存

-

如何保证缓存与数据库的操作的同时成功或失败?

- 单体系统,将缓存与数据库操作放在一个事务

- 分布式系统,利用TCC等分布式事务方案

应该具体操作缓存还是操作数据库,我们应当是先操作数据库,再删除缓存,原因在于,如果你选择第一种方案,在两个线程并发来访问时,假设线程1先来,他先把缓存删了,此时线程2过来,他查询缓存数据并不存在,此时他写入缓存,当他写入缓存后,线程1再执行更新动作时,实际上写入的就是旧的数据,新的数据被旧数据覆盖了。

- 第一种方案:先删除缓存,再输出数据库

异常情况介绍:在线程 1 删除缓存后,完成对数据库的更新(目标是更新为 v = 20)前。线程 2 恰好此时也查询了缓存,但是这时的缓存已经被线程 1 删除了,所以线程 1 它又直接去查询了数据库,并将数据库中的数据(v = 10)写入了缓存。在线程 2 进行完了上述的操作后,线程 1 才终于完成了对数据库中的数据的更新(v = 20)。此时,缓存中的数据为 v = 10,数据库中的数据为 v = 20,此时数据库和缓存中的数据不一致。

- 第二种方案:先操作数据库,再删除缓存

异常情况介绍:由于某种原因(不如过期时间到了),缓存此时恰好失效了,线程 1 查询不到缓存,线程 1 它需要再去数据库中查询数据后再写入缓存。但是就在线程 1 完成写入缓存的操作前,恰好此时线程 2 来更新数据库的数据(更新 v = 20),之后线程 2 又删除了缓存(此时缓存是空的,所以这里相当于删除了个寂寞)。在线程 2 完成这些操作后,线程 1 才终于将数据库中的旧数据写入了缓存(v = 10)。此时数据库中的数据(v = 20)和缓存中的数据(v = 10)不一致。

可以看出两种方法都有各自的问题,但是由于写的时间要远大于读的时间,所以先操作db再删除cache的出现问题的几率非常小。

- 先操作缓存还是先操作数据库?

- 先删除缓存,再操作数据库

- 先操作数据库,再删除缓存

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-7TENK60n-1671001492385)(.\Redis实战篇.assets\1653323595206.png)]

2.4 实现商铺和缓存与数据库双写一致

核心思路如下:

修改ShopController中的业务逻辑,满足下面的需求:

根据id查询店铺时,如果缓存未命中,则查询数据库,将数据库结果写入缓存,并设置超时时间

根据id修改店铺时,先修改数据库,再删除缓存

修改重点代码1:修改ShopServiceImpl的queryById方法

设置redis缓存时添加过期时间

修改重点代码2

代码分析:通过之前的淘汰,我们确定了采用删除策略,来解决双写问题,当我们修改了数据之后,然后把缓存中的数据进行删除,查询时发现缓存中没有数据,则会从mysql中加载最新的数据,从而避免数据库和缓存不一致的问题

@Override

@Transactional

public Result update(Shop shop) {

Long id = shop.getId();

if (id == null) {

return Result.fail("店铺id不能为空");

}

// 1.更新数据库

updateById(shop);

// 2.删除缓存

stringRedisTemplate.delete(CACHE_SHOP_KEY + id);

return Result.ok();

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

小结 缓存更新策略

缓存更新策略的最佳实践方案:

低一致性需求:使用 Redis 自带的内存淘汰机制

高一致性需求:主动更新,并以超时剔除作为兜底方案

读操作:

缓存命中则直接返回

缓存未命中则查询数据库,并写入缓存,设定超时时间

写操作:

先写数据库,然后再删除缓存

要确保数据库与缓存操作的原子性

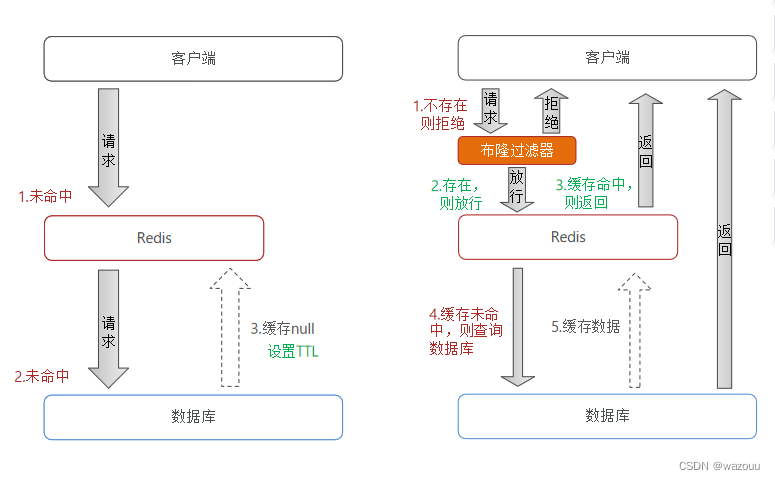

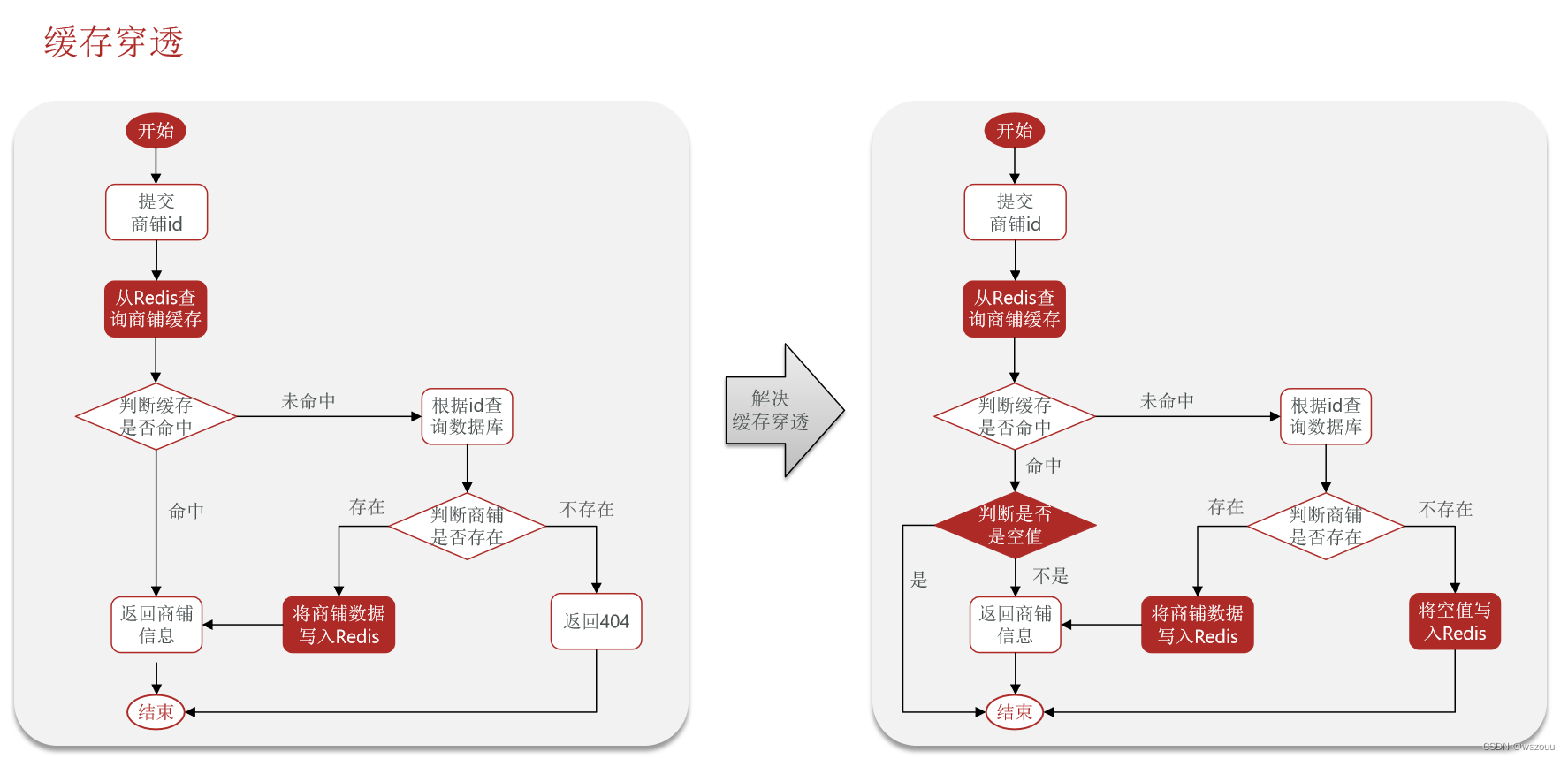

2.5 缓存穿透问题的解决思路

缓存穿透 :缓存穿透是指客户端请求的数据在缓存中和数据库中都不存在,这样缓存永远不会生效,这些请求都会打到数据库。

常见的解决方案有两种:

-

缓存空对象

-

优点:实现简单,维护方便

-

缺点:

- 额外的内存消耗

- 可能造成短期的不一致

适合命中不高,但可能被频繁更新的数据

-

-

布隆过滤

-

优点:内存占用较少,没有多余key

-

缺点:

- 实现复杂

- 存在误判可能

适合命中不高,但是更新不频繁的数据

-

**缓存空对象思路分析:**当我们客户端访问不存在的数据时,先请求redis,但是此时redis中没有数据,此时会访问到数据库,但是数据库中也没有数据,这个数据穿透了缓存,直击数据库,我们都知道数据库能够承载的并发不如redis这么高,如果大量的请求同时过来访问这种不存在的数据,这些请求就都会访问到数据库,简单的解决方案就是哪怕这个数据在数据库中也不存在,我们也把这个数据存入到redis中去,这样,下次用户过来访问这个不存在的数据,那么在redis中也能找到这个数据就不会进入到缓存了

**布隆过滤:**布隆过滤器其实采用的是哈希思想来解决这个问题,通过一个庞大的二进制数组,走哈希思想去判断当前这个要查询的这个数据是否存在,如果布隆过滤器判断存在,则放行,这个请求会去访问redis,哪怕此时redis中的数据过期了,但是数据库中一定存在这个数据,在数据库中查询出来这个数据后,再将其放入到redis中,

假设布隆过滤器判断这个数据不存在,则直接返回

这种方式优点在于节约内存空间,存在误判,误判原因在于:布隆过滤器走的是哈希思想,只要哈希思想,就可能存在哈希冲突(布隆过滤器算的哈希值,但不是百分百存在)

2.6 编码解决商品查询的缓存穿透问题:

核心思路如下:

在原来的逻辑中,我们如果发现这个数据在mysql中不存在,直接就返回404了,这样是会存在缓存穿透问题的

现在的逻辑中:如果这个数据不存在,我们不会返回404 ,还是会把这个数据写入到Redis中,并且将value设置为空,欧当再次发起查询时,我们如果发现命中之后,判断这个value是否是null,如果是null,则是之前写入的数据,证明是缓存穿透数据,如果不是,则直接返回数据。

//写的null缓存 @Override public Result queryById(Long id) { String key =CACHE_SHOP_KEY + id; //1.从redis查询商铺缓存 String shopJson = stringRedisTemplate.opsForValue().get(key); //2.判断是否存在 if (StrUtil.isNotBlank(shopJson)){ //isnotBlank只有"abc"true,null "" \t\n都是false //3.存在直接返回 Shop shop = JSONUtil.toBean(shopJson, Shop.class); return Result.ok(shop); } //2.3判断命中的是否是空值 if(shopJson ==null){ //返回一个错误信息 return Result.fail("店铺不存在"); } //4.不存在返,根据id查询数据库 Shop shop = getById(id); //5.不存在返回错误 if (shop==null){ //将空值写入redis stringRedisTemplate.opsForValue().set(key,"",CACHE_NULL_TTL,TimeUnit.MINUTES); return Result.fail("店铺不存在"); } //6.存在写入rdis stringRedisTemplate.opsForValue().set(key,JSONUtil.toJsonStr(shop),CACHE_SHOP_TTL,TimeUnit.MINUTES); return Result.ok(shop); }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

小结 缓存穿透解决

缓存穿透产生的原因是什么?

- 用户请求的数据在缓存中和数据库中都不存在,不断发起这样的请求,给数据库带来巨大压力

缓存穿透的解决方案有哪些?

- 缓存null值

- 布隆过滤

- 增强id的复杂度,避免被猜测id规律

- 做好数据的基础格式校验

- 加强用户权限校验

- 做好热点参数的限流

2.7 缓存雪崩问题及解决思路

缓存雪崩是指在同一时段大量的缓存key同时失效或者Redis服务宕机,导致大量请求到达数据库,带来巨大压力。

解决方案:

- 给不同的Key的TTL添加随机值

- 利用Redis集群提高服务的可用性

- 给缓存业务添加降级限流策略

- 给业务添加多级缓存(比如nginx,redis,jvm,数据库)

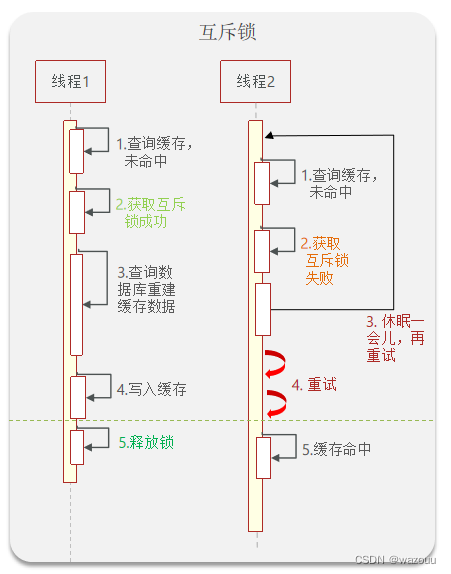

2.8 缓存击穿问题及解决思路

缓存击穿问题也叫热点Key问题,就是一个被高并发访问并且缓存重建业务较复杂的key突然失效了,无数的请求访问会在瞬间给数据库带来巨大的冲击。

常见的解决方案有两种:

- 互斥锁

- 逻辑过期

逻辑分析:假设线程1在查询缓存之后,本来应该去查询数据库,然后把这个数据重新加载到缓存的,此时只要线程1走完这个逻辑,其他线程就都能从缓存中加载这些数据了,但是假设在线程1没有走完的时候,后续的线程2,线程3,线程4同时过来访问当前这个方法, 那么这些线程都不能从缓存中查询到数据,那么他们就会同一时刻来访问查询缓存,都没查到,接着同一时间去访问数据库,同时的去执行数据库代码,对数据库访问压力过大

- 解决方案一、使用锁来解决:

因为锁能实现互斥性。假设线程过来,只能一个人一个人的来访问数据库,从而避免对于数据库访问压力过大,但这也会影响查询的性能,因为此时会让查询的性能从并行变成了串行,我们可以采用tryLock方法 + double check来解决这样的问题。

假设现在线程1过来访问,他查询缓存没有命中,但是此时他获得到了锁的资源,那么线程1就会一个人去执行逻辑,假设现在线程2过来,线程2在执行过程中,并没有获得到锁,那么线程2就可以进行到休眠,直到线程1把锁释放后,线程2获得到锁,然后再来执行逻辑,此时就能够从缓存中拿到数据了。

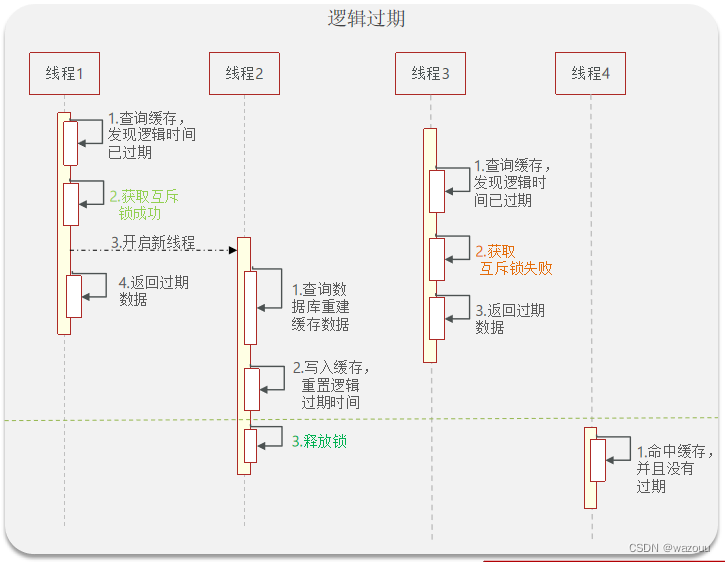

解决方案二、逻辑过期方案

方案分析:我们之所以会出现这个缓存击穿问题,主要原因是在于我们对key设置了过期时间,假设我们不设置过期时间,其实就不会有缓存击穿的问题,但是不设置过期时间,这样数据不就一直占用我们内存了吗,我们可以采用逻辑过期方案。

我们把过期时间设置在 redis的value中,注意:这个过期时间并不会直接作用于redis,而是我们后续通过逻辑去处理。假设线程1去查询缓存,然后从value中判断出来当前的数据已经过期了,此时线程1去获得互斥锁,那么其他线程会进行阻塞,获得了锁的线程他会开启一个 线程去进行 以前的重构数据的逻辑,直到新开的线程完成这个逻辑后,才释放锁, 而线程1直接进行返回,假设现在线程3过来访问,由于线程线程2持有着锁,所以线程3无法获得锁,线程3也直接返回数据,只有等到新开的线程2把重建数据构建完后,其他线程才能走返回正确的数据。

这种方案巧妙在于,异步的构建缓存,缺点在于在构建完缓存之前,返回的都是脏数据。

进行对比

**互斥锁方案:**由于保证了互斥性,所以数据一致,且实现简单,因为仅仅只需要加一把锁而已,也没其他的事情需要操心,所以没有额外的内存消耗,缺点在于有锁就有死锁问题的发生,且只能串行执行性能肯定受到影响

逻辑过期方案: 线程读取过程中不需要等待,性能好,有一个额外的线程持有锁去进行重构数据,但是在重构数据完成前,其他的线程只能返回之前的数据,且实现起来麻烦

2.9 利用互斥锁解决缓存击穿问题

核心思路:相较于原来从缓存中查询不到数据后直接查询数据库而言,现在的方案是 进行查询之后,如果从缓存没有查询到数据,则进行互斥锁的获取,获取互斥锁后,判断是否获得到了锁,如果没有获得到,则休眠,过一会再进行尝试,直到获取到锁为止,才能进行查询

如果获取到了锁的线程,再去进行查询,查询后将数据写入redis,再释放锁,返回数据,利用互斥锁就能保证只有一个线程去执行操作数据库的逻辑,防止缓存击穿

基于 互斥锁 方式解决缓存击穿问题

- 需求:修改根据 id 查询商铺的业务,基于互斥锁方式来解决缓存击穿问题

- 自定义互斥锁(Redis 中的

setnx就可以办到这点)

操作锁的代码:

核心思路就是利用redis的setnx方法来表示获取锁,该方法含义是redis中如果没有这个key,则插入成功,返回1,在stringRedisTemplate中返回true, 如果有这个key则插入失败,则返回0,在stringRedisTemplate返回false,我们可以通过true,或者是false,来表示是否有线程成功插入key,成功插入的key的线程我们认为他就是获得到锁的线程。

private boolean tryLock(String key) {

Boolean flag = stringRedisTemplate.opsForValue().setIfAbsent(key, "1", 10, TimeUnit.SECONDS);

return BooleanUtil.isTrue(flag);这里最好不要直接返回flag,拆箱容易空指针

}

private void unlock(String key) {

stringRedisTemplate.delete(key);

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

操作代码:

public Shop queryWithMutex(Long id) { String key = CACHE_SHOP_KEY + id; // 1、从redis中查询商铺缓存 String shopJson = stringRedisTemplate.opsForValue().get("key"); // 2、判断是否存在 if (StrUtil.isNotBlank(shopJson)) { // 存在,直接返回 return JSONUtil.toBean(shopJson, Shop.class); } //判断命中的值是否是空值 if (shopJson != null) { //返回一个错误信息 return null; } // 4.实现缓存重构 //4.1 获取互斥锁 String lockKey = "lock:shop:" + id; Shop shop = null; try { boolean isLock = tryLock(lockKey); // 4.2 判断否获取成功 if(!isLock){ //4.3 失败,则休眠重试 Thread.sleep(50); return queryWithMutex(id); } //4.4 成功,根据id查询数据库 shop = getById(id); // 5.不存在,返回错误 if(shop == null){ //将空值写入redis stringRedisTemplate.opsForValue().set(key,"",CACHE_NULL_TTL,TimeUnit.MINUTES); //返回错误信息 return null; } //6.写入redis stringRedisTemplate.opsForValue().set(key,JSONUtil.toJsonStr(shop),CACHE_NULL_TTL,TimeUnit.MINUTES); }catch (Exception e){ throw new RuntimeException(e); } finally { //7.释放互斥锁 unlock(lockKey); } return shop; }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

自写的,利用jmeter进行测试

@Override

public Result queryById(Long id) {

//互斥锁解决缓存击穿

Shop shop = queryWithNutex(id);

if (shop==null){

return Result.fail("店铺不存在1");

}

// 7.返回

return Result.ok(shop);

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

总结用互斥锁解决缓存击穿

1.商户数据从redis中获得缓存,存在就返回。不存在发现是否为空值(判断缓存穿透)

2.实现缓存重构:

2.1 获得互斥锁(没有获得互斥锁,休眠,再调用方法回溯)

2.2 从数据库查询数据,(数据不存在写null值),存在写入缓存,释放锁

3.0 、利用逻辑过期解决缓存击穿问题

需求:修改根据id查询商铺的业务,基于逻辑过期方式来解决缓存击穿问题

思路分析:当用户开始查询redis时,判断是否命中,如果没有命中则直接返回空数据,不查询数据库,而一旦命中后,将value取出,判断value中的过期时间是否满足,如果没有过期,则直接返回redis中的数据,如果过期,则在开启独立线程后直接返回之前的数据,独立线程去重构数据,重构完成后释放互斥锁。

基于逻辑过期方式解决缓存击穿问题

- 需求:修改根据id查询商铺的业务,基于逻辑过期方式来解决缓存击穿问题

如果封装数据:因为现在redis中存储的数据的value需要带上过期时间,此时要么你去修改原来的实体类,要么你

步骤一、

新建一个实体类,我们采用第二个方案,这个方案,对原来代码没有侵入性。

@Data

public class RedisData {

private LocalDateTime expireTime;

private Object data;

}

- 1

- 2

- 3

- 4

- 5

步骤二、

在ShopServiceImpl 新增此方法,利用单元测试进行缓存预热

#

public void saveShop2Redis(Long id,Long expireSeconds){

//1.查询店铺的数据

Shop shop= getById(id);

//2.封装逻辑过期时间

RedisData redisData = new RedisData();

redisData.setData(shop);

redisData.setExpireTime(LocalDateTime.now().plusSeconds(expireSeconds));

//3.写入Redis

stringRedisTemplate.opsForValue().set(CACHE_SHOP_KEY+id,JSONUtil.toJsonStr(redisData));

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

在测试类中

@Test

void testSaveShop(){

shopService.saveShop2Redis(1L,10L);

}

- 1

- 2

- 3

- 4

步骤三:正式代码

ShopServiceImpl

private static final ExecutorService CACHE_REBUILD_EXECUTOR = Executors.newFixedThreadPool(10); public Shop queryWithLogicalExpire( Long id ) { String key = CACHE_SHOP_KEY + id; // 1.从redis查询商铺缓存 String json = stringRedisTemplate.opsForValue().get(key); // 2.判断是否存在 if (StrUtil.isBlank(json)) { // 3.存在,直接返回 return null; } // 4.命中,需要先把json反序列化为对象 RedisData redisData = JSONUtil.toBean(json, RedisData.class); Shop shop = JSONUtil.toBean((JSONObject) redisData.getData(), Shop.class); LocalDateTime expireTime = redisData.getExpireTime(); // 5.判断是否过期 if(expireTime.isAfter(LocalDateTime.now())) { // 5.1.未过期,直接返回店铺信息 return shop; } // 5.2.已过期,需要缓存重建 // 6.缓存重建 // 6.1.获取互斥锁 String lockKey = LOCK_SHOP_KEY + id; boolean isLock = tryLock(lockKey); // 6.2.判断是否获取锁成功 if (isLock){ CACHE_REBUILD_EXECUTOR.submit( ()->{ try{ //重建缓存 this.saveShop2Redis(id,20L); }catch (Exception e){ throw new RuntimeException(e); }finally { unlock(lockKey); } }); } // 6.4.返回过期的商铺信息 return shop; }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

# 自写 @Override public Result queryById(Long id) { //解决缓存穿透 // Shop shop = queryWithPassThrough(id); //互斥锁解决缓存击穿 // Shop shop = queryWithNutex(id); //逻辑过期解决缓存击穿 Shop shop=queryWithLogicalExpire(id); if (shop==null){ return Result.fail("店铺不存在1"); } // 7.返回 return Result.ok(shop); } //做一个线程池 private static final ExecutorService CACHE_REBULD_EXECUTOR= Executors.newFixedThreadPool(10); public Shop queryWithLogicalExpire(Long id){ String key =CACHE_SHOP_KEY + id; //1.从redis查询商铺缓存 String shopJson = stringRedisTemplate.opsForValue().get(key); //2.判断是否存在 if (StrUtil.isBlank(shopJson)){ //isnotBlank只有"abc"true,null "" \t\n都是false //3.不存在直接返回 return null; } //4.命中,先把json反序列化为对象, RedisData redisData = JSONUtil.toBean(shopJson, RedisData.class); JSONObject data = (JSONObject)redisData.getData();//强转 Shop shop=JSONUtil.toBean(data,Shop.class);//因为之前的是RedisData.data是object类型 //合并为 // Shop shop=JSONUtil.toBean((JSONObject) redisData.getData(),Shop.class); LocalDateTime expireTime = redisData.getExpireTime(); //5判断是否过期 if (expireTime.isAfter(LocalDateTime.now())){ //5.1未过期,直接返回店铺信息 return shop; } //5.2已过期,需要缓存重建 //6.缓存重建 //6.1获得互斥锁 String lockkey=LOCK_SHOP_KEY+id; Boolean isLock = tryLock(lockkey); //6.2判断获取锁是否成功 if (isLock){ //6.3成功,开启新线程,实现缓存重建 CACHE_REBULD_EXECUTOR.submit(() ->{ try { this.saveShop2Redis(id,20L); } catch (Exception e) { throw new RuntimeException(e); } finally { //释放锁 unLock(lockkey); } }); //注意获取锁成功的时候应该再次检车redis缓存是否过期,做doublecheck //如果存在则无需重建缓存 } //6.4返回过期商铺信息 return shop; } private Boolean tryLock(String key){ Boolean flag = stringRedisTemplate.opsForValue(). setIfAbsent(key, "1", 10, TimeUnit.SECONDS); return BooleanUtil.isTrue(flag); } private void unLock(String key){ stringRedisTemplate.delete(key);

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

总结逻辑过期解决缓存穿透

前期准备:

1.存入的redis数据,value是RedisDate封装类(含data属性(shop)和time(逻辑过期时间))

( redisData.setExpireTime(LocalDateTime.now().plusSeconds(expireSeconds));)

调用queryById(id)方法,进行逻辑过期的方法queryWithLogicalExpire(Long id)

查询redis中的数据,不存在直接返回(注意因为redisData没有设置ttl,如果没有就不存在)

存在,将缓存数据redisdata反序列化为对象,根据data获得shop

判断携带的逻辑过期时间与此刻时间比较,如果存在就返回

如果此刻时间已经过期,开始缓存重建

2.进行缓存重建

获得互斥锁,如果互斥锁获得不成功,返回旧数据。

获得互斥锁成功,开启新线程(从线程池中得到)

private static final ExecutorService CACHE_REBUILD_EXECUTOR = Executors.newFixedThreadPool(10);

- 1

//6.3成功,开启新线程,实现缓存重建 CACHE_REBULD_EXECUTOR.submit(() ->{ try { this.saveShop2Redis(id,20L); } catch (Exception e) { throw new RuntimeException(e); } finally { //释放锁 unLock(lockkey); }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

新线程执行 this.saveShop2Redis(id,20L);存入数据和逻辑过期时间到redis缓存

释放锁

关于返回值的问题:

submit:有返回值,返回值(包括异常)被封装于FutureTask对象。适用于有返回结果的任务。

execute:void类型的函数,没有返回值,适用于没有返回的任务。

关于异常处理的问题吗,在业务逻辑必定出异常的情况下:submit:submit的时候并不会抛出异常(此时线程可能处于就绪状态)。只有在get操作的时候会抛出。因为get操作会阻塞等待线程的执行完毕。

execute:在执行的时候会直接抛出。可以通过实现UncaughtExceptionHandler接口来完成异常的捕获。

3.1、封装Redis工具类

基于StringRedisTemplate封装一个缓存工具类,满足下列需求:

- 方法1:将任意Java对象序列化为json并存储在string类型的key中,并且可以设置TTL过期时间

- 方法2:将任意Java对象序列化为json并存储在string类型的key中,并且可以设置逻辑过期时间,用于处理缓

存击穿问题

- 方法3:根据指定的key查询缓存,并反序列化为指定类型,利用缓存空值的方式解决缓存穿透问题

- 方法4:根据指定的key查询缓存,并反序列化为指定类型,需要利用逻辑过期解决缓存击穿问题

将逻辑进行封装

@Slf4j @Component public class CacheClient { private final StringRedisTemplate stringRedisTemplate; private static final ExecutorService CACHE_REBUILD_EXECUTOR = Executors.newFixedThreadPool(10); public CacheClient(StringRedisTemplate stringRedisTemplate) { this.stringRedisTemplate = stringRedisTemplate; } public void set(String key, Object value, Long time, TimeUnit unit) { stringRedisTemplate.opsForValue().set(key, JSONUtil.toJsonStr(value), time, unit); } public void setWithLogicalExpire(String key, Object value, Long time, TimeUnit unit) { // 设置逻辑过期 RedisData redisData = new RedisData(); redisData.setData(value); redisData.setExpireTime(LocalDateTime.now().plusSeconds(unit.toSeconds(time))); // 写入Redis stringRedisTemplate.opsForValue().set(key, JSONUtil.toJsonStr(redisData)); } public <R,ID> R queryWithPassThrough( String keyPrefix, ID id, Class<R> type, Function<ID, R> dbFallback, Long time, TimeUnit unit){ String key = keyPrefix + id; // 1.从redis查询商铺缓存 String json = stringRedisTemplate.opsForValue().get(key); // 2.判断是否存在 if (StrUtil.isNotBlank(json)) { // 3.存在,直接返回 return JSONUtil.toBean(json, type); } // 判断命中的是否是空值 if (json != null) { // 返回一个错误信息 return null; } // 4.不存在,根据id查询数据库 R r = dbFallback.apply(id); // 5.不存在,返回错误 if (r == null) { // 将空值写入redis stringRedisTemplate.opsForValue().set(key, "", CACHE_NULL_TTL, TimeUnit.MINUTES); // 返回错误信息 return null; } // 6.存在,写入redis this.set(key, r, time, unit); return r; } public <R, ID> R queryWithLogicalExpire( String keyPrefix, ID id, Class<R> type, Function<ID, R> dbFallback, Long time, TimeUnit unit) { String key = keyPrefix + id; // 1.从redis查询商铺缓存 String json = stringRedisTemplate.opsForValue().get(key); // 2.判断是否存在 if (StrUtil.isBlank(json)) { // 3.存在,直接返回 return null; } // 4.命中,需要先把json反序列化为对象 RedisData redisData = JSONUtil.toBean(json, RedisData.class); R r = JSONUtil.toBean((JSONObject) redisData.getData(), type); LocalDateTime expireTime = redisData.getExpireTime(); // 5.判断是否过期 if(expireTime.isAfter(LocalDateTime.now())) { // 5.1.未过期,直接返回店铺信息 return r; } // 5.2.已过期,需要缓存重建 // 6.缓存重建 // 6.1.获取互斥锁 String lockKey = LOCK_SHOP_KEY + id; boolean isLock = tryLock(lockKey); // 6.2.判断是否获取锁成功 if (isLock){ // 6.3.成功,开启独立线程,实现缓存重建 CACHE_REBUILD_EXECUTOR.submit(() -> { try { // 查询数据库 R newR = dbFallback.apply(id); // 重建缓存 this.setWithLogicalExpire(key, newR, time, unit); } catch (Exception e) { throw new RuntimeException(e); }finally { // 释放锁 unlock(lockKey); } }); } // 6.4.返回过期的商铺信息 return r; } public <R, ID> R queryWithMutex( String keyPrefix, ID id, Class<R> type, Function<ID, R> dbFallback, Long time, TimeUnit unit) { String key = keyPrefix + id; // 1.从redis查询商铺缓存 String shopJson = stringRedisTemplate.opsForValue().get(key); // 2.判断是否存在 if (StrUtil.isNotBlank(shopJson)) { // 3.存在,直接返回 return JSONUtil.toBean(shopJson, type); } // 判断命中的是否是空值 if (shopJson != null) { // 返回一个错误信息 return null; } // 4.实现缓存重建 // 4.1.获取互斥锁 String lockKey = LOCK_SHOP_KEY + id; R r = null; try { boolean isLock = tryLock(lockKey); // 4.2.判断是否获取成功 if (!isLock) { // 4.3.获取锁失败,休眠并重试 Thread.sleep(50); return queryWithMutex(keyPrefix, id, type, dbFallback, time, unit); } // 4.4.获取锁成功,根据id查询数据库 r = dbFallback.apply(id); // 5.不存在,返回错误 if (r == null) { // 将空值写入redis stringRedisTemplate.opsForValue().set(key, "", CACHE_NULL_TTL, TimeUnit.MINUTES); // 返回错误信息 return null; } // 6.存在,写入redis this.set(key, r, time, unit); } catch (InterruptedException e) { throw new RuntimeException(e); }finally { // 7.释放锁 unlock(lockKey); } // 8.返回 return r; } private boolean tryLock(String key) { Boolean flag = stringRedisTemplate.opsForValue().setIfAbsent(key, "1", 10, TimeUnit.SECONDS); return BooleanUtil.isTrue(flag); } private void unlock(String key) { stringRedisTemplate.delete(key); } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

- 91

- 92

- 93

- 94

- 95

- 96

- 97

- 98

- 99

- 100

- 101

- 102

- 103

- 104

- 105

- 106

- 107

- 108

- 109

- 110

- 111

- 112

- 113

- 114

- 115

- 116

- 117

- 118

- 119

- 120

- 121

- 122

- 123

- 124

- 125

- 126

- 127

- 128

- 129

- 130

- 131

- 132

- 133

- 134

- 135

- 136

- 137

- 138

- 139

- 140

- 141

- 142

- 143

- 144

- 145

- 146

- 147

- 148

- 149

- 150

- 151

- 152

- 153

- 154

- 155

- 156

- 157

- 158

在ShopServiceImpl 中

@Resource private CacheClient cacheClient; @Override public Result queryById(Long id) { // 解决缓存穿透 Shop shop = cacheClient .queryWithPassThrough(CACHE_SHOP_KEY, id, Shop.class, this::getById, CACHE_SHOP_TTL, TimeUnit.MINUTES); // 互斥锁解决缓存击穿 // Shop shop = cacheClient // .queryWithMutex(CACHE_SHOP_KEY, id, Shop.class, this::getById, CACHE_SHOP_TTL, TimeUnit.MINUTES); // 逻辑过期解决缓存击穿 // Shop shop = cacheClient // .queryWithLogicalExpire(CACHE_SHOP_KEY, id, Shop.class, this::getById, 20L, TimeUnit.SECONDS); if (shop == null) { return Result.fail("店铺不存在!"); } // 7.返回 return Result.ok(shop); }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

//Function<ID,R> dbFallback 是函数,参数ID ,返回值R

//isnotBlank只有"abc"true,null "" \t\n都是false

//lobandaB表达式 id2 -> getById(id2)简写this::getById

//4.命中,先把json反序列化为对象,

RedisData redisData = JSONUtil.toBean(json, RedisData.class);

JSONObject data = (JSONObject)redisData.getData();//强转

R r=JSONUtil.toBean(data,type);//因为之前的是RedisData.data是object类型

//合并为

// Shop shop=JSONUtil.toBean((JSONObject) redisData.getData(),Shop.class);

LocalDateTime expireTime = redisData.getExpireTime();

//5判断是否过期

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

3、优惠卷秒杀

3.1 -全局唯一ID

每个店铺都可以发布优惠券:

全局ID生成器,是一种在分布式系统下用来生成全局唯一ID的工具,一般要满足下列特性:

为了增加ID的安全性,我们可以不直接使用Redis自增的数值,而是拼接一些其它信息:

8个字节,64个bit

ID的组成部分:符号位:1bit,永远为0

时间戳:31bit,以秒为单位,可以使用69年

序列号:32bit,秒内的计数器,支持每秒产生2^32个不同ID

3.2 -Redis实现全局唯一Id

@Component public class RedisIdWorker { /** * 开始时间戳 */ private static final long BEGIN_TIMESTAMP = 1640995200L; /** * 序列号的位数 */ private static final int COUNT_BITS = 32; private StringRedisTemplate stringRedisTemplate; public RedisIdWorker(StringRedisTemplate stringRedisTemplate) { this.stringRedisTemplate = stringRedisTemplate; } public long nextId(String keyPrefix) { // 1.生成时间戳 LocalDateTime now = LocalDateTime.now(); long nowSecond = now.toEpochSecond(ZoneOffset.UTC); long timestamp = nowSecond - BEGIN_TIMESTAMP; // 2.生成序列号 // 2.1.获取当前日期,精确到天 String date = now.format(DateTimeFormatter.ofPattern("yyyy:MM:dd")); // 2.2.自增长 long count = stringRedisTemplate.opsForValue().increment("icr:" + keyPrefix + ":" + date); // 3.拼接并返回 return timestamp << COUNT_BITS | count; } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

测试类

知识小贴士:关于countdownlatch

countdownlatch名为信号枪:主要的作用是同步协调在多线程的等待于唤醒问题

我们如果没有CountDownLatch ,那么由于程序是异步的,当异步程序没有执行完时,主线程就已经执行完了,然后我们期望的是分线程全部走完之后,主线程再走,所以我们此时需要使用到CountDownLatch

CountDownLatch 中有两个最重要的方法

1、countDown

2、await

await 方法 是阻塞方法,我们担心分线程没有执行完时,main线程就先执行,所以使用await可以让main线程阻塞,那么什么时候main线程不再阻塞呢?当CountDownLatch 内部维护的 变量变为0时,就不再阻塞,直接放行,那么什么时候CountDownLatch 维护的变量变为0 呢,我们只需要调用一次countDown ,内部变量就减少1,我们让分线程和变量绑定, 执行完一个分线程就减少一个变量,当分线程全部走完,CountDownLatch 维护的变量就是0,此时await就不再阻塞,统计出来的时间也就是所有分线程执行完后的时间。

@Test void testIdWorker() throws InterruptedException { CountDownLatch latch = new CountDownLatch(300); Runnable task = () -> { for (int i = 0; i < 100; i++) { long id = redisIdWorker.nextId("order"); System.out.println("id = " + id); } latch.countDown(); }; long begin = System.currentTimeMillis(); for (int i = 0; i < 300; i++) { es.submit(task); } latch.await(); long end = System.currentTimeMillis(); System.out.println("time = " + (end - begin)); }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

#自写 package com.hmdp.utils; import lombok.extern.slf4j.Slf4j; import org.springframework.data.redis.core.StringRedisTemplate; import org.springframework.stereotype.Component; import javax.annotation.Resource; import java.time.LocalDateTime; import java.time.ZoneOffset; import java.time.format.DateTimeFormatter; @Component @Slf4j public class RedisIdWorker2 { /** * 开始时间戳 * @param keyPrefix * @return */ private static final long BEGIN_TIMESTAMP=1640995200L; /** * 序列号的位数 */ private static final int COUNT_BITS=32; @Resource private StringRedisTemplate stringRedisTemplate; public long nextId(String keyPrefix){ //1.生成时间戳 LocalDateTime now = LocalDateTime.now(); long nowSecond = now.toEpochSecond(ZoneOffset.UTC); long timestamp = nowSecond - BEGIN_TIMESTAMP; //2.生成序列号 //2.1获取当前的日期,精确到天 String data = now.format(DateTimeFormatter.ofPattern("yyyy:MM:dd")); //2.2自增长 Long count = stringRedisTemplate.opsForValue().increment("icr:" + keyPrefix + ":" + data); //3.拼接且返回 return timestamp << COUNT_BITS | count; //利用的是位运算,(UUID是16进制的长串值,是字符串而且不是自增,用的比较少) } // public static void main(String[] args) { // LocalDateTime time = LocalDateTime.of(2022, 1, 1, 0, 0); // long secend = time.toEpochSecond(ZoneOffset.UTC); // System.out.println(secend); // // // } } #测试 private ExecutorService es = Executors.newFixedThreadPool(300); @Resource private RedisIdWorker2 redisIdWorker2; /** * 自测 * @throws InterruptedException */ @Test void testIDwoker2() throws InterruptedException { CountDownLatch latch = new CountDownLatch(300); Runnable task=() ->{ for (int i = 0; i <100 ; i++) { long id = redisIdWorker2.nextId("order"); System.out.println("id="+id); } latch.countDown(); }; long begin = System.currentTimeMillis(); for (int i = 0; i <300 ; i++) { es.submit(task); } latch.await(); long end = System.currentTimeMillis(); System.out.println("time="+(end-begin)); }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

总结生成订单号

1.利用8个字节,64个bits :0+31时间戳+32序列hao

2.利用时间戳,利用天数的自增长做序号

3.做位运算实现拼接

3.3 添加优惠卷

每个店铺都可以发布优惠券,分为平价券和特价券。平价券可以任意购买,而特价券需要秒杀抢购:

tb_voucher:优惠券的基本信息,优惠金额、使用规则等

tb_seckill_voucher:优惠券的库存、开始抢购时间,结束抢购时间。特价优惠券才需要填写这些信息

平价卷由于优惠力度并不是很大,所以是可以任意领取

而代金券由于优惠力度大,所以像第二种卷,就得限制数量,从表结构上也能看出,特价卷除了具有优惠卷的基本信息以外,还具有库存,抢购时间,结束时间等等字段

接下来我们来看@TableField(exist=false)的作用

比如在实体类中有一个属性为remark,但是在数据库中没有这个字段,但是在执行插入操作时给实体类的remark属性赋值了,那么可以通过在实体类的remark属性上添加

@TableField(exist=false) private String remark;

- 1

- 2

**新增普通卷代码: **VoucherController

@PostMapping

public Result addVoucher(@RequestBody Voucher voucher) {

voucherService.save(voucher);

return Result.ok(voucher.getId());

}

- 1

- 2

- 3

- 4

- 5

新增秒杀卷代码:

VoucherController

@PostMapping("seckill")

public Result addSeckillVoucher(@RequestBody Voucher voucher) {

voucherService.addSeckillVoucher(voucher);

return Result.ok(voucher.getId());

}

- 1

- 2

- 3

- 4

- 5

VoucherServiceImpl

@Override

@Transactional

public void addSeckillVoucher(Voucher voucher) {

// 保存优惠券

save(voucher);

// 保存秒杀信息

SeckillVoucher seckillVoucher = new SeckillVoucher();

seckillVoucher.setVoucherId(voucher.getId());

seckillVoucher.setStock(voucher.getStock());

seckillVoucher.setBeginTime(voucher.getBeginTime());

seckillVoucher.setEndTime(voucher.getEndTime());

seckillVoucherService.save(seckillVoucher);

// 保存秒杀库存到Redis中

stringRedisTemplate.opsForValue().set(SECKILL_STOCK_KEY + voucher.getId(), voucher.getStock().toString());

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

#利用postman做增加优惠券

post http://localhost:8081/voucher/seckill

{

"shopId":1,

"title":"3300秒杀",

"subTitle":"周1",

"rules":"全场通用",

"payValue":8000,

"actualValue":10000,

"type":1,

"stock":200,

"beginTime":"2022-11-10T10:09:17",

"endTime":"2022-12-01T14:09:17"

}

注意这个endtime要长于你的真实事件,不然不显示

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

3.4 实现秒杀下单

下单时需要判断两点:

- 秒杀是否开始或结束,如果尚未开始或已经结束则无法下单

- 库存是否充足,不足则无法下单

下单核心逻辑分析:

当用户开始进行下单,我们应当去查询优惠卷信息,查询到优惠卷信息,判断是否满足秒杀条件

比如时间是否充足,如果时间充足,则进一步判断库存是否足够,如果两者都满足,则扣减库存,创建订单,然后返回订单id,如果有一个条件不满足则直接结束。

VoucherOrderServiceImpl

@Override public Result seckillVoucher(Long voucherId) { // 1.查询优惠券 SeckillVoucher voucher = seckillVoucherService.getById(voucherId); // 2.判断秒杀是否开始 if (voucher.getBeginTime().isAfter(LocalDateTime.now())) { // 尚未开始 return Result.fail("秒杀尚未开始!"); } // 3.判断秒杀是否已经结束 if (voucher.getEndTime().isBefore(LocalDateTime.now())) { // 尚未开始 return Result.fail("秒杀已经结束!"); } // 4.判断库存是否充足 if (voucher.getStock() < 1) { // 库存不足 return Result.fail("库存不足!"); } //5,扣减库存 boolean success = seckillVoucherService.update() .setSql("stock= stock -1") .eq("voucher_id", voucherId).update(); if (!success) { //扣减库存 return Result.fail("库存不足!"); } //6.创建订单 VoucherOrder voucherOrder = new VoucherOrder(); // 6.1.订单id long orderId = redisIdWorker.nextId("order"); voucherOrder.setId(orderId); // 6.2.用户id Long userId = UserHolder.getUser().getId(); voucherOrder.setUserId(userId); // 6.3.代金券id voucherOrder.setVoucherId(voucherId); save(voucherOrder); return Result.ok(orderId); }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

3.5 库存超卖问题分析

有关超卖问题分析:在我们原有代码中是这么写的

if (voucher.getStock() < 1) {

// 库存不足

return Result.fail("库存不足!");

}

//5,扣减库存

boolean success = seckillVoucherService.update()

.setSql("stock= stock -1")

.eq("voucher_id", voucherId).update();

if (!success) {

//扣减库存

return Result.fail("库存不足!");

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

假设线程1过来查询库存,判断出来库存大于1,正准备去扣减库存,但是还没有来得及去扣减,此时线程2过来,线程2也去查询库存,发现这个数量一定也大于1,那么这两个线程都会去扣减库存,最终多个线程相当于一起去扣减库存,此时就会出现库存的超卖问题。

超卖问题是典型的多线程安全问题,针对这一问题的常见解决方案就是加锁:而对于加锁,我们通常有两种解决方案:见下图:

悲观锁:

悲观锁可以实现对于数据的串行化执行, Synchronized、Lock 都属于悲观锁都是悲观锁的代表,同时,悲观锁中又可以再细分为公平锁,非公平锁,可重入锁,等等

乐观锁:

认为线程安全问题不一定会发生,因此不加锁,只是在更新数据时去判断有没有其它线程对数据做了修改。如果没有修改则认为是安全的,自己才更新数据。

如果已经被其它线程修改说明发生了安全问题,此时可以重试或异常

乐观锁的关键是判断之前查询得到的数据是否有被修改过,常见的处理方式有两种:版本号 和 CAS

乐观锁:会有一个版本号,每次操作数据会对版本号+1,再提交回数据时,会去校验是否比之前的版本大1 ,如果大1 ,则进行操作成功,这套机制的核心逻辑在于,如果在操作过程中,版本号只比原来大1 ,那么就意味着操作过程中没有人对他进行过修改,他的操作就是安全的,如果不大1,则数据被修改过,当然乐观锁还有一些变种的处理方式比如cas

CAS是英文单词

Compare And Swap的缩写,翻译过来就是比较并替换。

CAS机制当中使用了3个基本操作数:内存地址V,旧的预期值A,要修改的新值B。

更新一个变量的时候,只有当变量的预期值A和内存地址V当中的实际值相同时,才会将内存地址V对应的值修改为B。

int var5;

do {

var5 = this.getIntVolatile(var1, var2);

} while(!this.compareAndSwapInt(var1, var2, var5, var5 + var4));

return var5;

- 1

- 2

- 3

- 4

- 5

- 6

课程中的使用方式:

课程中的使用方式是没有像cas一样带自旋的操作,也没有对version的版本号+1 ,他的操作逻辑是在操作时,对版本号进行+1 操作,然后要求version 如果是1 的情况下,才能操作,那么第一个线程在操作后,数据库中的version变成了2,但是他自己满足version=1 ,所以没有问题,此时线程2执行,线程2 最后也需要加上条件version =1 ,但是现在由于线程1已经操作过了,所以线程2,操作时就不满足version=1 的条件了,所以线程2无法执行成功

给数据添加一个 version,当该数据被修改时,version 数值就会被加一。

比如下图的情况:线程一修改过数据,version 已经变成了 2;线程二再去查找 version,发现已经不为 1 了,不会再修改数据了。

3.6 乐观锁解决超卖问题

修改代码方案一、

VoucherOrderServiceImpl 在扣减库存时,改为:

boolean success = seckillVoucherService.update()

.setSql("stock= stock -1") //set stock = stock -1

.eq("voucher_id", voucherId).eq("stock",voucher.getStock()).update(); //where id = ? and stock = ?

- 1

- 2

- 3

以上逻辑的核心含义是:只要我扣减库存时的库存和之前我查询到的库存是一样的,就意味着没有人在中间修改过库存,那么此时就是安全的,但是以上这种方式通过测试发现会有很多失败的情况,失败的原因在于:在使用乐观锁过程中假设100个线程同时都拿到了100的库存,然后大家一起去进行扣减,但是100个人中只有1个人能扣减成功,其他的人在处理时,他们在扣减时,库存已经被修改过了,所以此时其他线程都会失败

修改代码方案二、

之前的方式要修改前后都保持一致,但是这样我们分析过,成功的概率太低,所以我们的乐观锁需要变一下,改成stock大于0 即可

boolean success = seckillVoucherService.update()

.setSql("stock= stock -1")

.eq("voucher_id", voucherId).update().gt("stock",0); //where id = ? and stock > 0

- 1

- 2

- 3

知识小扩展:

针对cas中的自旋压力过大,我们可以使用Longaddr这个类去解决

Java8 提供的一个对AtomicLong改进后的一个类,LongAdder

大量线程并发更新一个原子性的时候,天然的问题就是自旋,会导致并发性问题,当然这也比我们直接使用syn来的好

所以利用这么一个类,LongAdder来进行优化

如果获取某个值,则会对cell和base的值进行递增,最后返回一个完整的值

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-IozzPgqM-1671001492389)(.\Redis实战篇.assets\1653370271627.png)]

CAS的缺点:

1.CPU开销较大

在并发量比较高的情况下,如果许多线程反复尝试更新某一个变量,却又一直更新不成功,循环往复,会给CPU带来很大的压力。2.不能保证代码块的原子性

CAS机制所保证的只是一个变量的原子性操作,而不能保证整个代码块的原子性。比如需要保证3个变量共同进行原子性的更新,就不得不使用Synchronized了。

3.6 优惠券秒杀-一人一单

需求:修改秒杀业务,要求同一个优惠券,一个用户只能下一单

现在的问题在于:

优惠卷是为了引流,但是目前的情况是,一个人可以无限制的抢这个优惠卷,所以我们应当增加一层逻辑,让一个用户只能下一个单,而不是让一个用户下多个单

具体操作逻辑如下:比如时间是否充足,如果时间充足,则进一步判断库存是否足够,然后再根据优惠卷id和用户id查询是否已经下过这个订单,如果下过这个订单,则不再下单,否则进行下单

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-w3RMbaCk-1671001492390)(https://itsawaysu.oss-cn-shanghai.aliyuncs.com/note/一人一单.jpg)]

VoucherOrderServiceImpl

初步代码:增加一人一单逻辑

@Override public Result seckillVoucher(Long voucherId) { // 1.查询优惠券 SeckillVoucher voucher = seckillVoucherService.getById(voucherId); // 2.判断秒杀是否开始 if (voucher.getBeginTime().isAfter(LocalDateTime.now())) { // 尚未开始 return Result.fail("秒杀尚未开始!"); } // 3.判断秒杀是否已经结束 if (voucher.getEndTime().isBefore(LocalDateTime.now())) { // 尚未开始 return Result.fail("秒杀已经结束!"); } // 4.判断库存是否充足 if (voucher.getStock() < 1) { // 库存不足 return Result.fail("库存不足!"); } // 5.一人一单逻辑 // 5.1.用户id Long userId = UserHolder.getUser().getId(); int count = query().eq("user_id", userId).eq("voucher_id", voucherId).count(); // 5.2.判断是否存在 if (count > 0) { // 用户已经购买过了 return Result.fail("用户已经购买过一次!"); } //6,扣减库存 boolean success = seckillVoucherService.update() .setSql("stock= stock -1") .eq("voucher_id", voucherId).update(); if (!success) { //扣减库存 return Result.fail("库存不足!"); } //7.创建订单 VoucherOrder voucherOrder = new VoucherOrder(); // 7.1.订单id long orderId = redisIdWorker.nextId("order"); voucherOrder.setId(orderId); voucherOrder.setUserId(userId); // 7.3.代金券id voucherOrder.setVoucherId(voucherId); save(voucherOrder); return Result.ok(orderId); }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

**存在问题:**高并发的情况下,查询数据库时,都不存在订单,仍然会出现一人多单的情况,仍需加锁。乐观锁比较适合更新操作,此处的插入操作选择悲观锁。

**注意:**在这里提到了非常多的问题,我们需要慢慢的来思考,首先我们的初始方案是封装了一个createVoucherOrder方法,同时为了确保他线程安全。首先,初始方案是在 createVoucherOrder 方法上添加 synchronized,这样导致锁的粒度过大。

在seckillVoucher 方法中,添加以下逻辑,这样就能保证事务的特性,同时也控制了锁的粒度

public synchronized Result createVoucherOrder(Long voucherId) {

}

- 1

- 2

于是选择 “一个用户一把锁” 这样的方案。但是必须先保证 锁是同一把:userId.toString() 方法锁获取到的字符串是不同的对象,底层是 new 出来的,intern() 方法是从常量池里获取数据,保证了同一个用户的 userId.toString() 值相同。

@Transactional

@Override

public Result createVoucherOrder(Long voucherId) {

Long userId = UserHolder.getUser().getId();

synchronized(userId.toString().intern()) {

...

}

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

此外,还需要注意一个点,我们需要将 createVoucherOrder 方法整体包裹起来,确保事务不会出问题;否则会出现 “synchronized 包裹的代码片段执行完毕,事务还未提交,但是锁已经释放了” 的情况。

但是以上代码还是存在问题,问题的原因在于当前方法被spring的事务控制,如果你在方法内部加锁,可能会导致当前方法事务还没有提交,但是锁已经释放也会导致问题,所以我们选择将当前方法整体包裹起来,确保事务不会出现问题:如下:

synchronized (userId.toString().intern()) {

return createVoucherOrder(voucherId);

}

- 1

- 2

- 3

最后,createVoucherOrder 方法实际上是通过 this.createVoucherOrder() 的方式调用的,this 拿到的是原始对象,没有经过动态代理,事务要生效,需要使用代理对象来执行。

synchronized (userId.toString().intern()) {

// 获取代理对象

VoucherOrderService currentProxy = (VoucherOrderService) AopContext.currentProxy();

return currentProxy.createVoucherOrder(voucherId);

}

- 1

- 2

- 3

- 4

- 5

终极版本

@Override public Result seckillVoucher(Long voucherId) { // 1. 根据 优惠券 id 查询数据库 SeckillVoucher seckillVoucher = seckillVoucherService.getById(voucherId); // 2. 判断秒杀是否开始或结束(未开始或已结束,返回异常结果) if (LocalDateTime.now().isBefore(seckillVoucher.getBeginTime())) { return Result.fail("秒杀尚未开始.."); } if (LocalDateTime.now().isAfter(seckillVoucher.getEndTime())) { return Result.fail("秒杀已经结束.."); } // 3. 判断库存是否充足(不充足返回异常结果) if (seckillVoucher.getStock() < 1) { return Result.fail("库存不足.."); } Long userId = UserHolder.getUser().getId(); synchronized (userId.toString().intern()) { // 获取代理对象 VoucherOrderService currentProxy = (VoucherOrderService) AopContext.currentProxy(); return currentProxy.createVoucherOrder(voucherId); } } @Transactional @Override public Result createVoucherOrder(Long voucherId) { Long userId = UserHolder.getUser().getId(); // 4. 一人一单(根据 优惠券id 和 用户id 查询订单;存在,则直接返回) Integer count = query().eq("voucher_id", voucherId).eq("user_id", userId).count(); if (count > 0) { return Result.fail("不可重复下单!"); } // 5. 减扣库存 boolean isAccomplished = seckillVoucherService.update() // SET stock= stock - 1 .setSql("stock = stock - 1") // WHERE voucher_id = ? AND stock > 0 .eq("voucher_id", voucherId).gt("stock", 0) .update(); if (!isAccomplished) { return Result.fail("库存不足.."); } // 6. 创建订单 VoucherOrder voucherOrder = new VoucherOrder(); long orderId = redisIdWorker.nextId("order"); voucherOrder.setId(orderId); voucherOrder.setUserId(userId); voucherOrder.setVoucherId(voucherId); boolean isSaved = save(voucherOrder); if (!isSaved) { return Result.fail("下单失败.."); } // 7. 返回 订单 id return Result.ok(orderId); }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

#自写 Long usrId = UserHolder.getUser().getId(); synchronized(usrId.toString().intern()) { IVoucherOrderService proxy = (IVoucherOrderService)AopContext.currentProxy(); return proxy.createVoucherOrder(voucherId); } //但是这个时候的事务优点问题调用的是this剩下,拿到当前的oder对象不是代理对象, // 所以没有事务功能,所以拿到事务的代理对象 同时在pom.xml引入依赖 <!-- https://mvnrepository.com/artifact/org.aspectj/aspectjweaver --> <dependency> <groupId>org.aspectj</groupId> <artifactId>aspectjweaver</artifactId> <version>1.9.9.1</version> <scope>runtime</scope> </dependency> # 同时在springboot开注解 @EnableAspectJAutoProxy(exposeProxy = true)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Rf3Ehjw7-1671001492391)(https://itsawaysu.oss-cn-shanghai.aliyuncs.com/note/一人一单的并发安全问题.jpg)]

总结超卖和一人一单

超卖:

悲观锁一定发生

乐观锁:认为线程安全不一定会发生因此不加锁,只是在更新数据时去判断有没有其它线程对数据做了修改。如果没有修改则认为是安全的,自己才更新数据。如果已经被其它线程修改说明发生了安全问题,此时可以重试或异常

乐观锁的关键是判断之前查询得到的数据是否有被修改过,常见的处理方式有两种:版本号 和 CAS

CAS机制当中使用了3个基本操作数:内存地址V,旧的预期值A,要修改的新值B。

更新一个变量的时候,只有当变量的预期值A和内存地址V当中的实际值相同时,才会将内存地址V对应的值修改为B。但是1.CPU开销较大

在并发量比较高的情况下,如果许多线程反复尝试更新某一个变量,却又一直更新不成功,循环往复,会给CPU带来很大的压力。2.不能保证代码块的原子性

CAS机制所保证的只是一个变量的原子性操作,而不能保证整个代码块的原子性。比如需要保证3个变量共同进行原子性的更新,就不得不使用Synchronized了。

seckillVoucher(Long voucherId) 根据id查询数据库找到秒杀的券,判断时间,库存

获得当前用户,进入synchronized锁,

Long userId = UserHolder.getUser().getId(); synchronized (userId.toString().intern()) { // 获取代理对象 VoucherOrderService currentProxy = (VoucherOrderService) AopContext.currentProxy(); return currentProxy.createVoucherOrder(voucherId); }

- 1

- 2

- 3

- 4

- 5

- 6

(userId.toString() 方法锁获取到的字符串是不同的对象,底层是 new 出来的,intern() 方法是从常量池里获取数据,保证了同一个用户的 userId.toString() 值相同。

createVoucherOrder 方法实际上是通过 this.createVoucherOrder() 的方式调用的,this 拿到的是原始对象,没有经过动态代理,事务要生效,需要使用代理对象来执行。)

调用.createVoucherOrder(voucherId)方法,实现1人1单

查询当前用户,找数据库中是否已经存在订单。没有订单开始创建然后返回。

3.7 集群环境下的并发问题

通过加锁可以解决在单机情况下的一人一单安全问题,但是在集群模式下就不行了。

1、我们将服务启动两份,端口分别为8081和8082:

2、然后修改nginx的conf目录下的nginx.conf文件,配置反向代理和负载均衡:

具体操作(略)

# 自写

service找到该项目的/8081 ctrl+d 在VM options输入 -Dserver.port=8082

在not start 会找到两个,一起启动形成集群

一个81 一个80

#修改server之后如上

注意要把下面两个的注释修改,不然没用

#proxy_pass http://127.0.0.1:8081;

proxy_pass http://backend;

cmd中加载

nginx.exe -s reload

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

有关锁失效原因分析。

一人一单的集群环境下的并发安全问题

由于部署了多个 Tomcat,每个 Tomcat 中都有属于自己的 JVM。

在 服务器A 的 Tomcat 内部,有两个线程,这两个线程使用的是同一份代码,他们的锁对象是同一个,可以实现互斥(线程1 和 线程2);

在 服务器B 的 Tomcat 内部,有两个线程,这两个线程使用的是同一份代码,他们的锁对象是同一个,可以实现互斥(线程3 和 线程4);

线程1/2 和 线程3/4 使用的不是同一份代码,锁对象不是同一个,于是线程1/2 与 线程3/4 之间无法实现互斥;导致 synchronized 锁失效,这种情况下就需要 分布式锁 来解决。通过加锁可以解决在单机情况下的一人一单安全问题,但是在集群模式下就不行了(每个jvm都有自己的锁监视器,集群模式下各个服务器的锁不共享)。

因此,我们的解决方案就是实现一个共享的锁监视器,即:

分布式锁:满足分布式系统或集群模式下多进程可见并且互斥的锁。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-YsAYvuXC-1671001492392)(https://itsawaysu.oss-cn-shanghai.aliyuncs.com/note/一人一单的集群环境下并发的安全问题.jpg)]

4、分布式锁

4.1 、基本原理和实现方式对比

分布式锁:满足分布式系统或集群模式下的多进程可见并互斥的锁。

分布式锁的核心思想:所有线程都使用同一把锁,让程序串行执行。

分布式锁需要满足的条件

可见行:多个线程都能看到相同的结果,也就是感知到变化;

互斥:分布式锁的最基本条件,为了让程序串行执行;

高可用:保证程序不易崩溃;

高性能:加锁本身会让性能降低,因此需要分布式锁具有较高的加锁性能和释放锁性能;

安全性。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-beGRxl0N-1671001492395)(https://itsawaysu.oss-cn-shanghai.aliyuncs.com/note/分布式锁.jpg)]

常见的分布式锁有三种

常见的分布式锁

MySQL:MySQL 本身带有锁机制,但是由于 MySQL 性能一般,所以采用分布式锁的情况下,使用 MySQL 作为分布式锁比较少见。

Redis:Redis 作为分布式锁比较常见,利用 setnx 方法,如果 Key 插入成功,则表示获取到锁,插入失败则表示无法获取到锁。

Zookeeper:Zookeeper 也是企业级开发中比较好的一个实现分布式锁的方案。

| MySQL | Redis | Zookeeper | |

|---|---|---|---|

| 互斥 | 利用 MySQL 本身的互斥锁机制 | 利用 setnx 互斥命令 | 利用节点的唯一性和有序性 |

| 高可用 | 好 | 好 | 好 |

| 高性能 | 一般 | 好 | 一般 |

| 安全性 | 断开链接,自动释放锁 | 利用锁超时时间,到期释放 | 临时节点,断开链接自动释放 |

4.2 、Redis分布式锁的实现核心思路

实现分布式锁时需要实现的两个基本方法:

-

获取锁:

-

互斥:确保只能有一个线程获取锁

-

非阻塞:尝试一次,成功返回true,失败返回false

# 添加锁 NX 互斥 EX 设置超时时间 SET lock thread1 NX EX 10- 1

- 2

- 3

-

-

释放锁:

-

手动释放

-

超时释放:获取锁时添加一个超时时间

del key- 1

-

核心思路:

我们利用redis 的setNx 方法,当有多个线程进入时,我们就利用该方法,第一个线程进入时,redis 中就有这个key 了,返回了1,如果结果是1,则表示他抢到了锁,那么他去执行业务,然后再删除锁,退出锁逻辑,没有抢到锁的哥们,等待一定时间后重试即可

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-uJ9oaLnz-1671001492396)(https://itsawaysu.oss-cn-shanghai.aliyuncs.com/note/基于 Redis 的分布式锁的实现思路.jpg)]

4.3 实现分布式锁版本

- 加锁逻辑

锁的基本接口

public interface DistributedLock {

/**

* 尝试获取锁

* @param timeoutSeconds 锁的超时时间,过期后自动释放

* @return true 代表获取锁成功;false 代表获取锁失败

*/

boolean tryLock(long timeoutSeconds);

/**

* 释放锁

*/

void unlock();

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

SimpleRedisLock

利用setnx方法进行加锁,同时增加过期时间,防止死锁,此方法可以保证加锁和增加过期时间具有原子性

public class SimpleDistributedLockBasedOnRedis implements DistributedLock { private String name; private StringRedisTemplate stringRedisTemplate; public SimpleDistributedLockBasedOnRedis(String name, StringRedisTemplate stringRedisTemplate) { this.name = name; this.stringRedisTemplate = stringRedisTemplate; } private static final String KEY_PREFIX = "lock:"; @Override public boolean tryLock(long timeoutSeconds) { String threadName = Thread.currentThread().getId(); Boolean isSucceeded = stringRedisTemplate.opsForValue().setIfAbsent(KEY_PREFIX + name, threadName, timeoutSeconds, TimeUnit.SECONDS); return Boolean.TRUE.equals(isSucceeded); } @Override public void unlock() { stringRedisTemplate.delete(KEY_PREFIX + name); } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

测试

将断点打到 “判断是否获取到锁” 处,发送两次 http://localhost:8080/api/voucher-order/seckill/10 请求,第一次请求打到 8081,第二次请求打到 8082。

8081 获取到的 isLocked 为 true,8082 获取到 isLocked 为 false;

Redis 中存储的 Key 为 lock:order:userId,Value 为 http-nio-8081-exec-1。

- 修改业务代码

@Override public Result seckillVoucher(Long voucherId) { // 1.查询优惠券 SeckillVoucher voucher = seckillVoucherService.getById(voucherId); // 2.判断秒杀是否开始 if (voucher.getBeginTime().isAfter(LocalDateTime.now())) { // 尚未开始 return Result.fail("秒杀尚未开始!"); } // 3.判断秒杀是否已经结束 if (voucher.getEndTime().isBefore(LocalDateTime.now())) { // 尚未开始 return Result.fail("秒杀已经结束!"); } // 4.判断库存是否充足 if (voucher.getStock() < 1) { // 库存不足 return Result.fail("库存不足!"); } Long userId = UserHolder.getUser().getId(); //创建锁对象(新增代码) SimpleRedisLock lock = new SimpleRedisLock("order:" + userId, stringRedisTemplate); //获取锁对象 boolean isLock = lock.tryLock(1200); //加锁失败 if (!isLock) { return Result.fail("不允许重复下单"); } try { //获取代理对象(事务) IVoucherOrderService proxy = (IVoucherOrderService) AopContext.currentProxy(); return proxy.createVoucherOrder(voucherId); } finally { //释放锁 lock.unlock(); } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

将rediss锁代替悲观锁

4.4 Redis分布式锁误删情况说明

逻辑说明:

线程1 获取到锁,持有锁的线程碰到了业务阻塞,业务阻塞的时间超过了该锁的超时时间,触发锁的超时释放。

此时,线程2 获取到锁,执行业务;在线程2 执行业务的过程中,线程1 的业务执行完毕并且释放锁,但是释放的是线程2 的锁。

之后,线程3 获取到锁,执行业务;导致此时有两个线程同时在并行执行业务。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-oca9TgJ4-1671001492397)(https://itsawaysu.oss-cn-shanghai.aliyuncs.com/note/Redis 分布式锁的误删问题.jpg)]

解决方案:

解决方案:在每个线程释放锁的时候,需要判断一下当前这把锁是否属于自己,如果不属于自己,就不会进行锁的释放(删除)。

线程1 获取到锁,持有锁的线程碰到了业务阻塞,业务阻塞的时间超过了该锁的超时时间,触发锁的超时释放。

此时,线程2 获取到锁,执行业务;在线程2 执行业务的过程中,线程1 的业务执行完毕并且释放锁,但是此时线程1 需要判断当前这把锁是否属于自己,不属于则不会删除锁。于是线程2 一直持有这把锁直至其业务执行结束后才会释放,并且在释放的时候也需要判断当前要释放的锁是否属于自己。

之后,线程3 获取到锁,执行业务。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-pbZqzViX-1671001492398)(https://itsawaysu.oss-cn-shanghai.aliyuncs.com/note/解决Redis 分布式锁误删问题.jpg)]

4.5 解决Redis分布式锁误删问题

核心逻辑:在存入锁时,放入自己线程的标识,在删除锁时,判断当前这把锁的标识是不是自己存入的,如果是,则进行删除,如果不是,则不进行删除。

改进 Redis 分布式锁:

- 在获取锁的时候存入线程标识(用 UUID 表示);

- 在释放锁时先获取锁中的线程标识,判断是否与当前的线程标识一致;

- 一致则释放锁;

- 不一致则不释放锁。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-P1GfsTLF-1671001492399)(.\Redis实战篇.assets\1653387398820.png)]

具体代码如下:加锁

private static final String ID_PREFIX = UUID.randomUUID().toString(true) + "-";

@Override

public boolean tryLock(long timeoutSec) {

// 获取线程标示

String threadId = ID_PREFIX + Thread.currentThread().getId();

// 获取锁

Boolean success = stringRedisTemplate.opsForValue()

.setIfAbsent(KEY_PREFIX + name, threadId, timeoutSec, TimeUnit.SECONDS);

return Boolean.TRUE.equals(success);

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

释放锁

public void unlock() {

// 获取线程标示

String threadId = ID_PREFIX + Thread.currentThread().getId();

// 获取锁中的标示

String id = stringRedisTemplate.opsForValue().get(KEY_PREFIX + name);

// 判断标示是否一致

if(threadId.equals(id)) {

// 释放锁

stringRedisTemplate.delete(KEY_PREFIX + name);

}

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

public class SimpleDistributedLockBasedOnRedis implements DistributedLock { private String name; private StringRedisTemplate stringRedisTemplate; public SimpleDistributedLockBasedOnRedis(String name, StringRedisTemplate stringRedisTemplate) { this.name = name; this.stringRedisTemplate = stringRedisTemplate; } private static final String KEY_PREFIX = "lock:"; private static final String ID_PREFIX = UUID.randomUUID().toString(true) + "-"; /** * 获取锁 */ @Override public boolean tryLock(long timeoutSeconds) { // 线程标识 String threadIdentifier = ID_PREFIX + Thread.currentThread().getId(); Boolean isSucceeded = stringRedisTemplate.opsForValue() .setIfAbsent(KEY_PREFIX + name, threadIdentifier, timeoutSeconds, TimeUnit.SECONDS); return Boolean.TRUE.equals(isSucceeded); } /** * 释放锁 */ @Override public void unlock() { // 线程标识 String threadIdentifier = ID_PREFIX + Thread.currentThread().getId(); String threadIdentifierFromRedis = stringRedisTemplate.opsForValue().get(KEY_PREFIX + name); // 比较 锁中的线程标识 与 当前的线程标识 是否一致 if (StrUtil.equals(threadIdentifier, threadIdentifierFromRedis)) { // 释放锁标识 stringRedisTemplate.delete(KEY_PREFIX + name); } } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

有关代码实操说明:

在我们修改完此处代码后,我们重启工程,然后启动两个线程,第一个线程持有锁后,手动释放锁,第二个线程 此时进入到锁内部,再放行第一个线程,此时第一个线程由于锁的value值并非是自己,所以不能释放锁,也就无法删除别人的锁,此时第二个线程能够正确释放锁,通过这个案例初步说明我们解决了锁误删的问题。

4.6 分布式锁的原子性问题

分布式锁的原子性问题

线程1 执行业务并且判断 “当前 Redis 中的线程标识 与 获取锁时存入 Redis 的线程标识” 一致后,执行 释放锁操作 时出现阻塞,导致锁并未释放。在阻塞的过程中,又因为超时原因导致锁的释放。

此时 线程2 获取到锁,并且执行业务,执行业务的过程锁被中线程 1 释放。

于是 线程3 也能够获取到锁,并且执行业务。最终,又一次导致此时有两个线程同时在并行执行业务。

因此,需要保证 “判断线程标识的一致性 与 释放锁” 操作的原子性。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-rZKFNtod-1671001492399)(https://itsawaysu.oss-cn-shanghai.aliyuncs.com/note/分布式锁的原子性问题.jpg)]

4.7 Lua脚本解决多条命令原子性问题

Redis提供了Lua脚本功能,在一个脚本中编写多条Redis命令,确保多条命令执行时的原子性。Lua是一种编程语言,它的基本语法大家可以参考网站:https://www.runoob.com/lua/lua-tutorial.html,这里重点介绍Redis提供的调用函数,我们可以使用lua去操作redis,又能保证他的原子性,这样就可以实现拿锁比锁删锁是一个原子性动作了,作为Java程序员这一块并不作一个简单要求,并不需要大家过于精通,只需要知道他有什么作用即可。

这里重点介绍Redis提供的调用函数,语法如下:

redis.call('命令名称', 'key', '其它参数', ...)

- 1

例如,我们要执行set name jack,则脚本是这样:

# 执行 set name jack

redis.call('set', 'name', 'jack')

- 1

- 2

例如,我们要先执行set name Rose,再执行get name,则脚本如下:

# 先执行 set name jack

redis.call('set', 'name', 'Rose')

# 再执行 get name

local name = redis.call('get', 'name')

# 返回

return name

- 1

- 2

- 3

- 4

- 5

- 6

编写完脚本后,需要使用 Redis 命令来调用脚本:EVAL script numkeys key [key ...] arg [arg ...]

-

执行

redis.call('set', 'name', 'Michael')# 双引号中间的值为 脚本;后面的 0 代表的是 脚本需要的 Key 类型的参数个数 127.0.0.1:6379> EVAL "return redis.call('set', 'name', 'Michael')" 0 OK 127.0.0.1:6379> get name "Michael"- 1

- 2

- 3

- 4

- 5

如果脚本中的key、value不想写死,可以作为参数传递。key类型参数会放入KEYS数组,其它参数会放入ARGV数组,在脚本中可以从KEYS和ARGV数组获取这些参数:

# name ==> KEYS[1] 、Annabelle ==> ARGV[1] (Lua 的数组下标从 1 开始)

127.0.0.1:6379> EVAL "return redis.call('set', KEYS[1], ARGV[1])" 1 name Annabelle

OK

127.0.0.1:6379> get name

"Annabelle"

- 1

- 2

- 3

- 4

- 5

- 6

接下来我们来回一下我们释放锁的逻辑:

#自写

EVAL "return redis.call('set','name','jack')" 0

EVAL "return redis.call('set',KEYS[1],ARGV[1])" 1 name rose

- 1

- 2

- 3

- 4

- 5

释放锁的业务流程是这样的

1、获取锁中的线程标示

2、判断是否与指定的标示(当前线程标示)一致

3、如果一致则释放锁(删除)

4、如果不一致则什么都不做

如果用Lua脚本来表示则是这样的:

最终我们操作redis的拿锁比锁删锁的lua脚本就会变成这样

-- 这里的 KEYS[1] 就是锁的key,这里的ARGV[1] 就是当前线程标示

-- 获取锁中的标示,判断是否与当前线程标示一致

if (redis.call('GET', KEYS[1]) == ARGV[1]) then

-- 一致,则删除锁

return redis.call('DEL', KEYS[1])

end

-- 不一致,则直接返回

return 0

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

4.8 利用Java代码调用Lua脚本改造分布式锁

lua脚本本身并不需要大家花费太多时间去研究,只需要知道如何调用,大致是什么意思即可,所以在笔记中并不会详细的去解释这些lua表达式的含义。

我们的RedisTemplate中,可以利用execute方法去执行lua脚本,参数对应关系就如下图股