- 1【算法】求一个数字在给定的已排序数组中出现的起始、终止索引号_用函数求某个值所在的起始 终止序号

- 2sql_exporter mysql_【最佳实践】prometheus 监控 sql server (使用sql_exporter)

- 3clickhouse Kafka表引擎使用_clickhouse kafka kafka_max_block_size

- 4A*算法走迷宫_迷宫a*算法c++代码

- 5【PTA】C课程设计(6)

- 6目标检测正负样本区分和平衡

- 7Python 嵌套函数_嵌套函数python

- 8python之AI视频去码&图片修复CodeFormer,把你的老照片变漂亮_python codeformer

- 9C/C++:变长参数技巧汇总_c++ 变长参数

- 10动态规划——石子合并问题_编程堆石子围一圈算最少步数

大语言模型Ollama

赞

踩

版权声明

- 本文原创作者:谷哥的小弟

- 作者博客地址:http://blog.csdn.net/lfdfhl

Ollama简介

Ollama是一个开源的大语言模型平台,它允许用户在本地环境中运行、创建和共享大型语言模型。Ollama提供了丰富的功能和特性,使得用户可以在自己的计算机上轻松地部署和运行大型语言模型。

Ollama官方网站

https://github.com/ollama/ollama

Ollama的主要特点和优势

-

1、本地部署:Ollama提供了一个类似于Docker的CLI界面,使得用户可以快速地在本地进行大语言模型的推理部署。这意味着用户可以在自己的计算机上运行大型语言模型,而不需要依赖云服务或远程服务器。

-

2、丰富的API接口和聊天界面:Ollama提供了类似OpenAI的API接口和聊天界面,支持热加载模型文件,使得用户可以通过接口使用最新版本的GPT模型,并且无需重新启动即可切换不同的模型。

-

3、模型库支持:Ollama提供了一个模型库,用户可以在这里下载和运行不同的大型语言模型,如Llama 2、Mistral等。此外,它还支持自定义和创建模型,满足用户的个性化需求。

-

4、多平台支持和灵活扩展:Ollama支持macOS、Windows和Linux平台,几乎覆盖了所有主流操作系统。同时,它具备灵活的扩展性,支持与很多工具集成,可以通过编写Modelfile来导入更多的自定义模型。

-

5、社区和文档支持:Ollama得到了积极的维护和更新,拥有一个庞大而活跃的社区,为用户提供支持和资源。此外,其官方网站和GitHub页面提供了详细的安装和使用指南,帮助用户更好地使用平台。

Ollama的应用场景

Ollama可以应用于各种自然语言处理任务,如文本生成、翻译、问答等。通过本地部署和运行大型语言模型,用户可以更加高效地处理大量文本数据,提高工作效率和准确性。同时,Ollama还支持自定义和创建模型,使得用户可以根据自己的需求定制专属的语言模型,进一步拓展其应用场景。

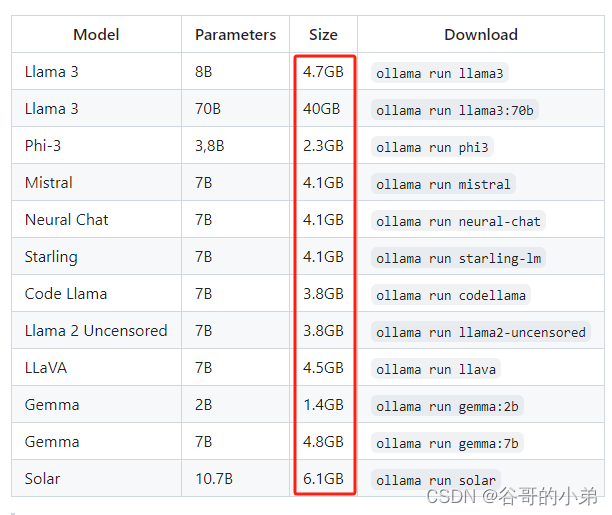

Ollama本地部署的配置要求

如果打算将Ollama部署到本地,它对本地设备的配置有一定的要求;图示如下:

请注意: You should have at least 8 GB of RAM available to run the 7B models, 16 GB to run the 13B models, and 32 GB to run the 33B models.