- 1Android输入法IME(三)之 管理端(IMMS)启动流程

- 2HBase高可用集群踩坑总结以及hbase-site.xml配置文件分享_配置hbase-site.xml出现的问题

- 3数据结构~~排序

- 4从零开始学习CANoe(一)—— 新建工程_canoe新建工程

- 5【计算机视觉 | 图像分割】arxiv 计算机视觉关于图像分割的学术速递(7 月 4 日论文合集)_hrsegnet

- 6FPGA - 4位数值比较器电路

- 7Python 一步一步教你用pyglet制作汉诺塔游戏(终篇)_python汉诺塔

- 8输入十个姓名,按首字母的大小排列顺序!_c 语言 人名按字母排序

- 9毕业设计:基于python动漫数据分析推荐系统+可视化+协同过滤推荐算法 Django框架(源码)✅

- 10前端大文件分片下载解决方案,没用你来砍我

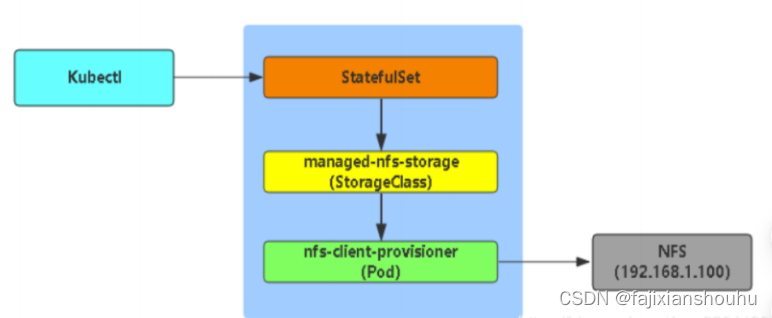

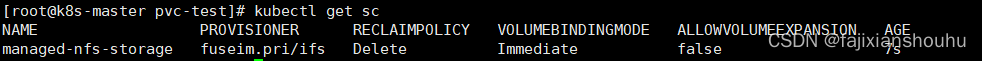

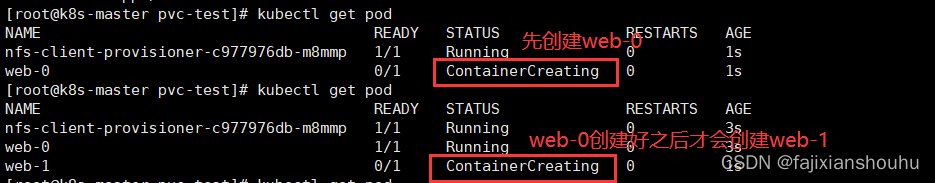

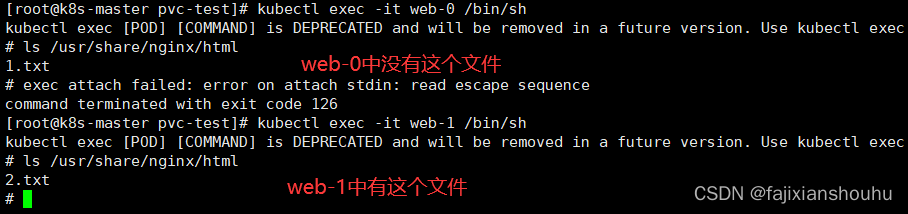

容器编排之战——kubernetes

赞

踩

目录

3、容器编排工具中的战斗机--------Kubernetes

2、k8s 对 Container 的定义,和 Docker 相比并没有什么太大区别。

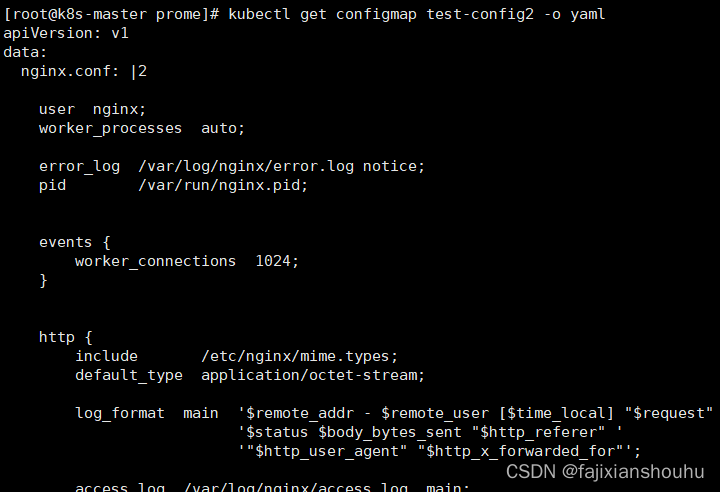

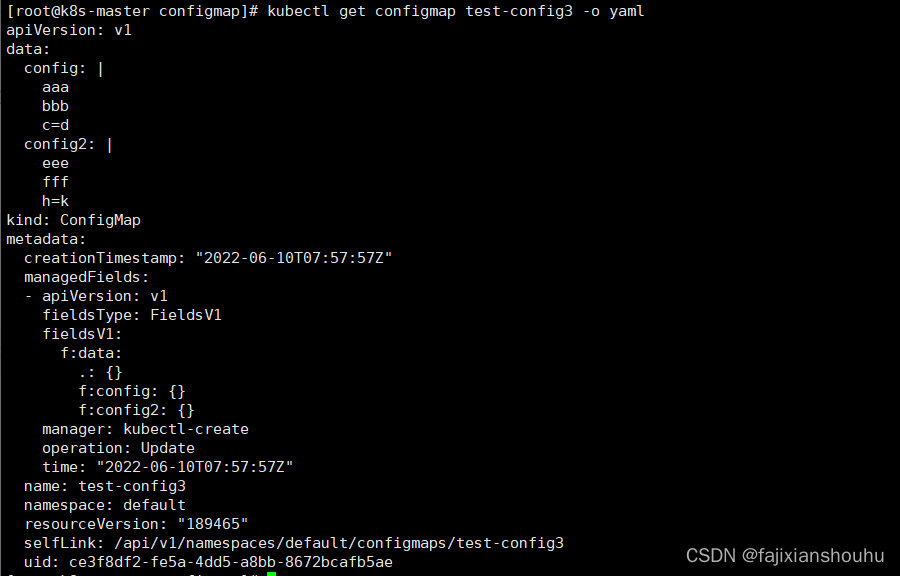

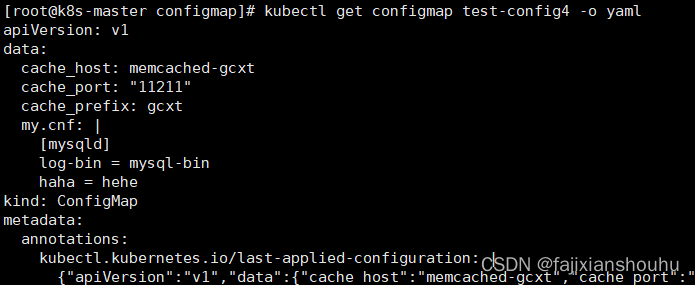

8、通过envFrom、configMapRef、name使得configmap中的所有key/value对儿 都自动变成环境变量:

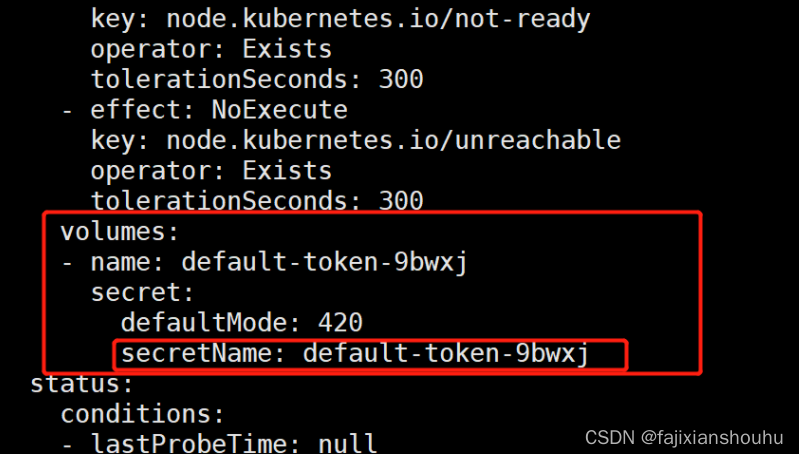

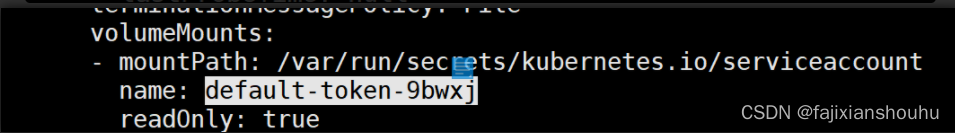

2、ServiceAccount与UserAccount区别

一、kubernetes简介

1、基本概念

kubernetes,简称k8s,是一个开源的,用于管理云平台中多个主机上的容器化的应用,kubernetes的目标是让部署容器化的应用简单且高效,kubernetes提供了应用部署、规划、更新、维护的一种机制。

1、传统的应用部署方式

通过插件或脚本来安装应用。这样做的缺点是应用的运行、配 置、管理、所有生存周期将与当前操作系统绑定,这样做并不利于应用的升级更新/回滚等操作,当然也可以通过创建虚拟机的方式来实现某些功能,但是虚拟机非常重,并不利于 可移植性。

2、新的应用部署方式(部署容器)

通过部署容器方式实现,每个容器之间互相隔离,每个容器有自己的文件系统 ,容器之间进程不会相互影响,能区分计算资源。相对于虚拟机,容器能快速部署, 由于容器与底层设施、机器文件系统解耦的,所以它能在不同云、不同版本操作系统间进行迁移。

容器占用资源少、部署快,每个应用可以被打包成一个容器镜像,每个应用与容器间成一对一关系也使容器有更大优势,使用容器可以在 build 或 release 的阶段,为应用创建容器镜像,因为每个应用不需要与其余的应用堆栈组合,也不依赖于生产环境基础结构, 这使得从研发到测试、生产能提供一致环境。类似地,容器比虚拟机轻量、更“透明”, 这更便于监控和管理。

3、容器编排工具中的战斗机--------Kubernetes

Kubernetes 是 Google 开源的一个容器编排引擎,它支持自动化部署、大规模可伸缩、 应用容器化管理。在生产环境中部署一个应用程序时,通常要部署该应用的多个实例以便 对应用请求进行负载均衡。

在 Kubernetes 中,我们可以创建多个容器,每个容器里面运行一个应用实例,然后通过内置的负载均衡策略,实现对这一组应用实例的管理、发现、访问,而这些细节都不需要运维人员去进行复杂的手工配置和处理。

2、Kubernetes核心概念

Master

master主要负责资源调度,控制副本,和提供统一访问集群的入口。--核心节点,也是管理节点

- master nginx Pod

- node1 容器

- node2 容器

Node

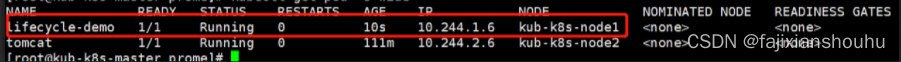

node是kubernetes集群架构中运行pod的服务节点。node是kubernetes集群操作的单元,用来承载被分配pod的运行,是pod运行的宿主机,有master管理,并汇报容器状态个master,同时根据master要求管理容器生命周期。

Node IP

node节点的ip地址,是kubernetes集群中每个节点的物理网卡的ip地址,是真实存在的物理网络,所有属于这个网络的服务器之间都能够通过这个网络直接通信。

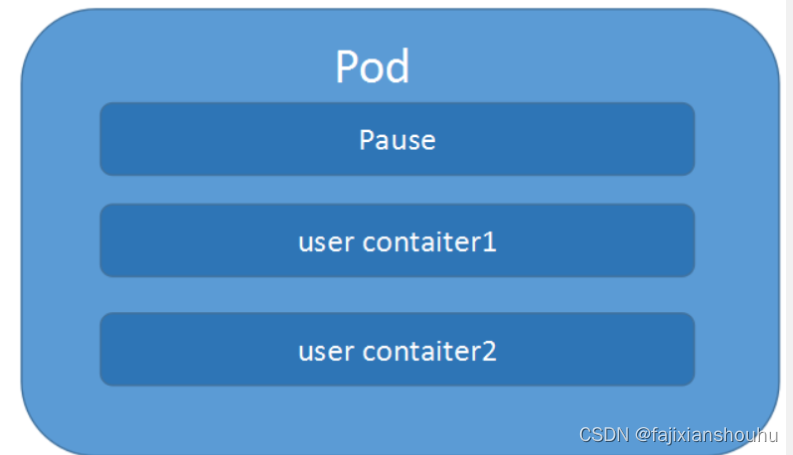

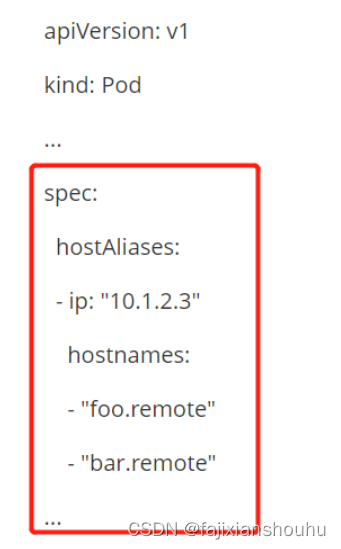

Pod

pod直译是豆荚,可以把容器想象成豆荚里的豆子,把一个或多个关系紧密的豆子包在一起就是豆荚(一个pod)。在k8s中我们不会直接操作容器,而是把容器包装成pod进行管理

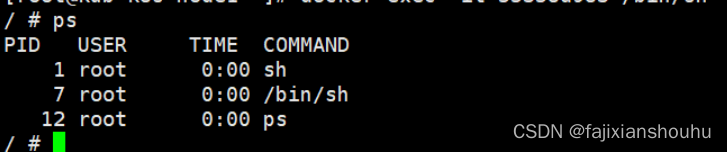

运行在node节点上,若干相关容器的组合。pod内包含的容器运行在同一台宿主机上,使用相同的网络命名空间、ip地址和端口,能够通过localhost进行通信。pod是k8s进行创建、调度和管理的最小单位,他提供了比容器更高层次的抽象,使得部署和管理更加灵活。一个pod可以包含一个或多个容器。在公司一般一个pod只运行一个容器,加上自带的pause容器一共两个。

pod就是k8s集群里的“应用”;而一个平台应用,可以由多个容器组成。

pause容器

pause容器

每个pod中都有一个pause容器,pause容器作为pod的网络接入点,pod中其他的容器会使用容器映射模式启动并接入到这个pause容器。

- 属于同一个pod的所有容器共享网络的namespace。

- 如果pod所在的node宕机,会将这个node上的pod重新调度到其他节点上。

Pod Volume

- docker volume对应kubernetes中的pod volume;

- 数据卷,挂载宿主机文件、目录或者外部存储到pod中,为应用服务提供存储,也可以解决pod中容器之间共享数据。

资源限制:每个pod可以设置限额的计算机资源,有cpu和memory;

Pod IP

pod的ip地址,是docker engine根据docker0网桥的ip地址段进行分配的,通常是一个虚拟的二层网络,位于不同的node上的pod能够彼此通信,需要通过pod ip所在的虚拟二层网络进行通信,而真实的tcp流量则是通过node ip所在的物理网卡流出的

Event

是一个事件记录,记录了时间最早产生的原因、最后重复时间、重复次数、发起者、类型,以及导致此事件的原因等信息。event通常关联到具体资源对象上,是排查故障的重要参考信息

Namespace

命名空间将资源对象逻辑上分配到不同的namespace,可以是不同的项目、用户等区分管理,并设定控制策略,从而实现多租户。命名空间也称为虚拟集群

Replica Set

确保在任何给定时间制定的pod副本数量,并提供声明式更新等功能

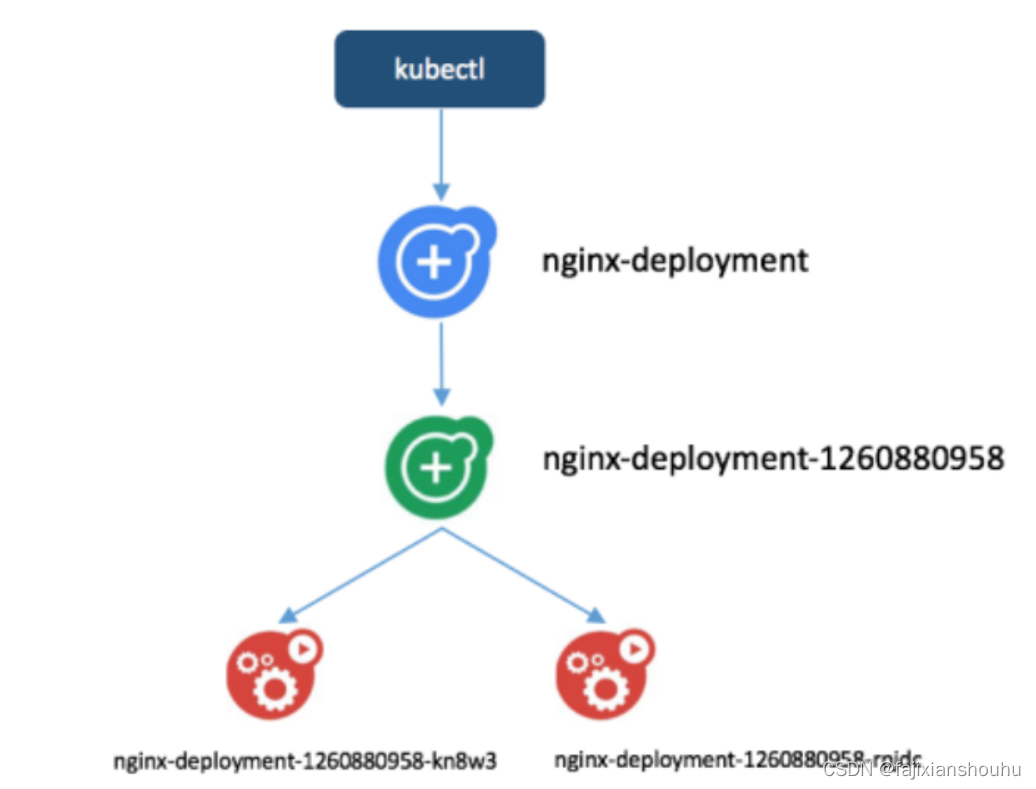

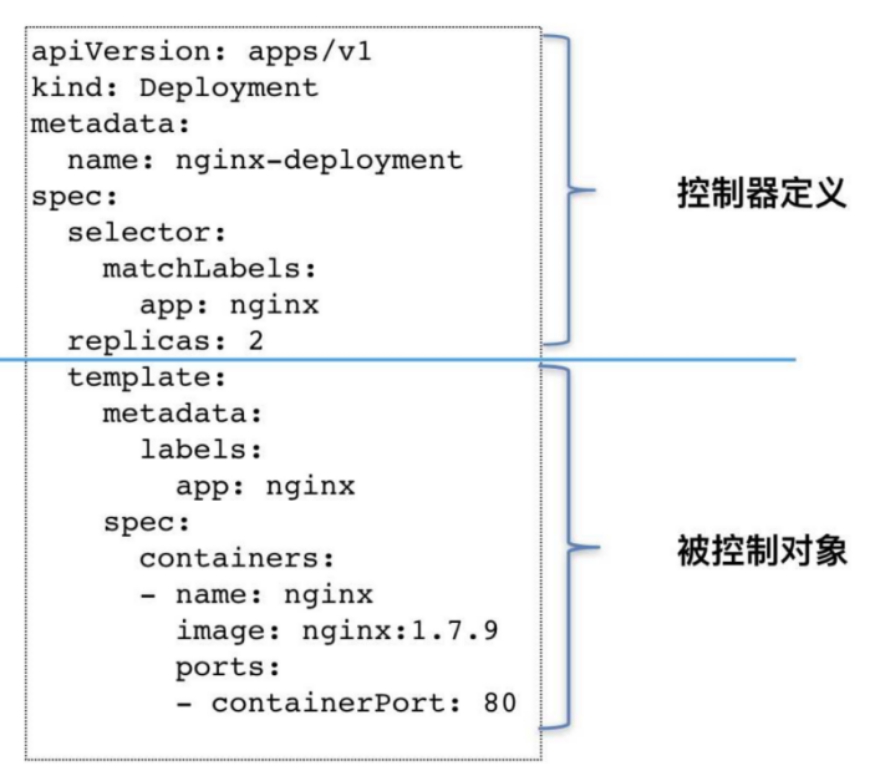

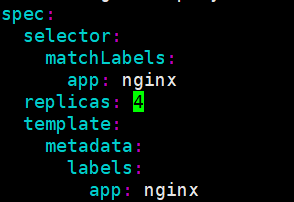

Deployment

deployment是一个更高层次的API/资源对象,他管理replicasets和pod,并提供声明式更新等功能

官方建议使用deployment管理replicasets,而不是直接使用replicasets,这就意味着可能永远不需要直接操作replicasets对象,因此deployment将会是使用最频繁的资源对象。

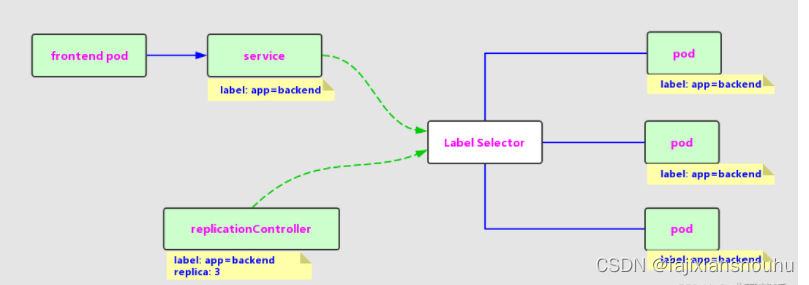

RC-Replication Controller

replication Controller用来管理pod的副本,保证集群中存在指定数量的pod副本。集群副本中的数量大于指定数量,则会停止指定数量之外的多余pod数量,反之,则会启动少于指定数量个数的容器,保证数量不变,replication Controller是实现弹性伸缩、动态扩容和 滚动升级的核心

部署和升级pod,声明某种pod的副本数量在任意时刻都符合某个预期值;

- pod期待的副本数

- 用于筛选目标pod的label selector

- 当pod副本数量小于预期数量的时候,用于创建pod的pod模板

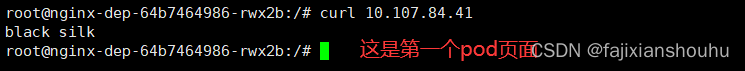

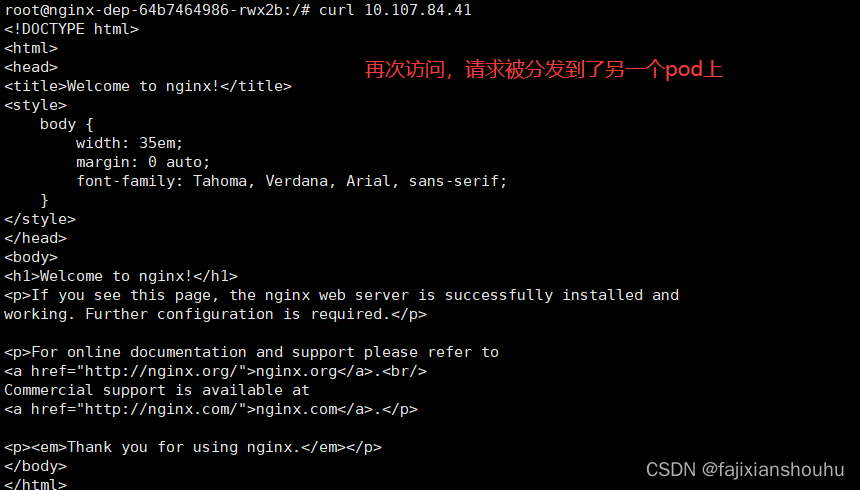

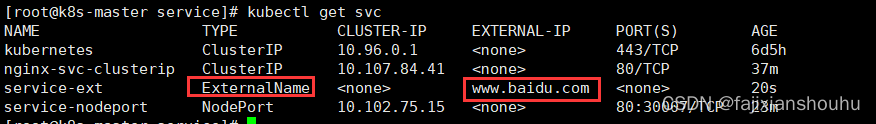

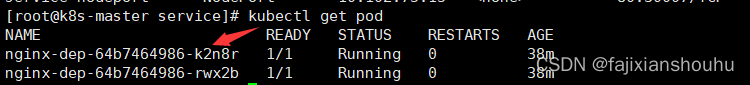

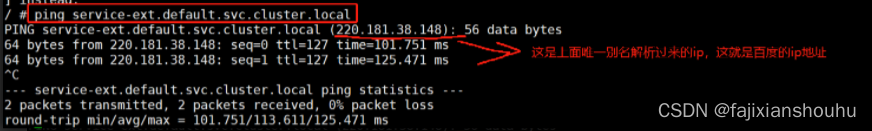

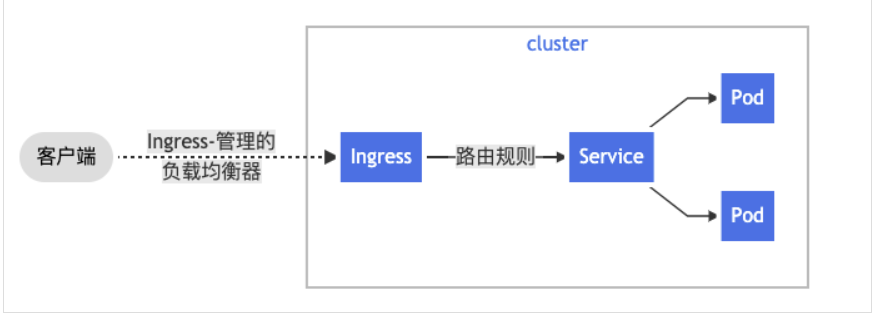

Service

service定义了pod的逻辑集合和访问集合的策略,是真实服务的抽象

service提供了一个统一的服务访问入口以及服务代理和发现机制,用户不需要了解后台pod是如何运行。

一个service定义了访问pod的方式,就像单个固定的ip地址和与其对应的dns名之间的关系

Service其实就是我们经常提起的微服务架构中的一个"微服务",通过分析、识别并建模系统中的所有服务为微服务——Kubernetes Service,最终我们的系统由多个提供不同业务能力而又彼此独立的微服务单元所组成,服务之间通过TCP/IP进行通信,从而形成了我们强大而又灵活的弹性网络,拥有了强大的分布式能力、弹性扩展能力、容错能力;

如图示,每个Pod都提供了一个独立的Endpoint(Pod IP+ContainerPort)以被客户端访问,多个Pod副本组成了一个集群来提供服务,一般的做法是部署一个负载均衡器来访问它们,为这组Pod开启一个对外的服务端口如8000,并且将这些Pod的Endpoint列表加入8000端口的转发列表中,客户端可以通过负载均衡器的对外IP地址+服务端口来访问此服务。运行在Node上的kube-proxy其实就是一个智能的软件负载均衡器,它负责把对Service的请求转发到后端的某个Pod实例上,并且在内部实现服务的负载均衡与会话保持机制。Service不是共用一个负载均衡器的IP地址,而是每个Servcie分配一个全局唯一的虚拟IP地址,这个虚拟IP被称为Cluster IP。

Cluster IP

Service的IP地址,特性:

- 仅仅作用于Kubernetes Servcie这个对象,并由Kubernetes管理和分配IP地址;

- 无法被Ping,因为没有一个"实体网络对象"来响应;

- 只能结合Service Port组成一个具体的通信端口;

- Node IP网、Pod IP网与Cluster IP网之间的通信,采用的是Kubernetes自己设计的一种编程方式的特殊的路由规则,与IP路由有很大的不同

Lable

Kubernetes中的任意API对象都是通过Label进行标识,Label的实质是一系列的K/V键值对。Label是Replication Controller和Service运行的基础,二者通过Label来进行关联Node上运行的Pod。

一个label是一个被附加到资源上的键/值对,譬如附加到一个Pod上,为它传递一个用户自定的并且可识别的属性.Label还可以被应用来组织和选择子网中的资源

Endpoint(IP+Port)

标识服务进程的访问点;

注:Node、Pod、Replication Controller和Service等都可以看作是一种"资源对象",几乎所有的资源对象都可以通过Kubernetes提供的kubectl工具执行增、删、改、查等操作并将其保存在etcd中持久化存储。

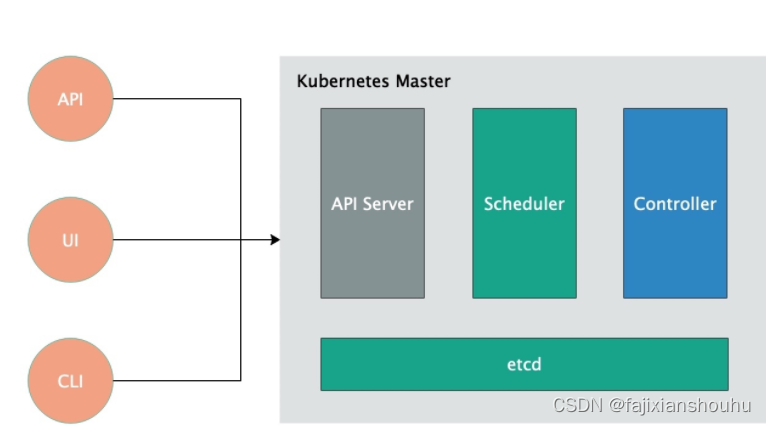

3、Kubernetes架构和组件

主从分布式架构,Master/Node

组件:

- Kubernetes Master:

-

- 集群控制节点,负责整个集群的管理和控制,基本上Kubernetes所有的控制命令都是发给它,它来负责具体的执行过程,我们后面所有执行的命令基本都是在Master节点上运行的;

-

- 包含如下组件:

- 1.Kubernetes API Server

- 作为Kubernetes系统的入口,其封装了核心对象的增删改查操作,以RESTful API接口方式提供给外部客户和内部组件调用。维护的REST对象持久化到Etcd中存储。

-

- 2.Kubernetes Scheduler

- 为新建立的Pod进行节点(node)选择(即分配机器),负责集群的资源调度。组件抽离,可以方便替换成其他调度器。

-

- 3.Kubernetes Controller

- 负责执行各种控制器,目前已经提供了很多控制器来保证Kubernetes的正常运行。

- - Replication Controller

- 管理维护Replication Controller,关联Replication Controller和Pod,保证Replication Controller定义的副本数量与实际运行Pod数量一致。

- - Deployment Controller

- 管理维护Deployment,关联Deployment和Replication Controller,保证运行指定数量的Pod。当Deployment更新时,控制实现Replication Controller和 Pod的更新。

- - Node Controller

- 管理维护Node,定期检查Node的健康状态,标识出(失效|未失效)的Node节点。

- - Namespace Controller

- 管理维护Namespace,定期清理无效的Namespace,包括Namesapce下的API对象,比如Pod、Service等。

- - Service Controller

- 管理维护Service,提供负载以及服务代理。

- - EndPoints Controller

- 管理维护Endpoints,关联Service和Pod,创建Endpoints为Service的后端,当Pod发生变化时,实时更新Endpoints。

- - Service Account Controller

- 管理维护Service Account,为每个Namespace创建默认的Service Account,同时为Service Account创建Service Account Secret。

- - Persistent Volume Controller

- 管理维护Persistent Volume和Persistent Volume Claim,为新的Persistent Volume Claim分配Persistent Volume进行绑定,为释放的Persistent Volume执行清理回收。

- - Daemon Set Controller

- 管理维护Daemon Set,负责创建Daemon Pod,保证指定的Node上正常的运行Daemon Pod。

- - Job Controller

- 管理维护Job,为Jod创建一次性任务Pod,保证完成Job指定完成的任务数目

- - Pod Autoscaler Controller

- 实现Pod的自动伸缩,定时获取监控数据,进行策略匹配,当满足条件时执行Pod的伸缩动作。

-

-

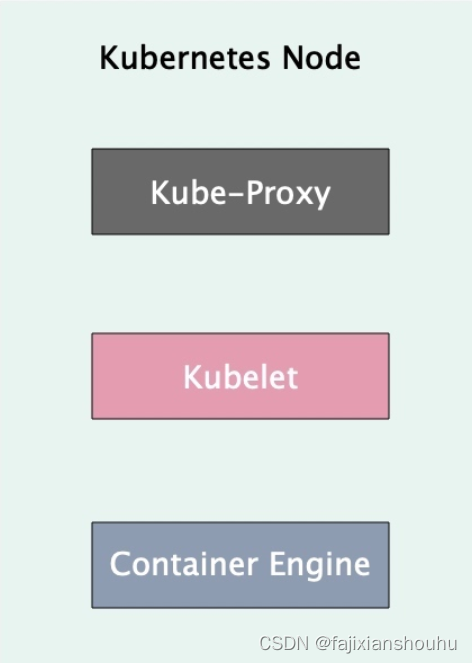

- Kubernetes Node:

- 除了Master,Kubernetes集群中的其他机器被称为Node节点,Node节点才是Kubernetes集群中的工作负载节点,每个Node都会被Master分配一些工作负载(Docker容器),当某个Node宕机,其上的工作负载会被Master自动转移到其他节点上去;

-

- 包含如下组件:

-

- 1.Kubelet

- 负责管控容器,Kubelet会从Kubernetes API Server接收Pod的创建请求,启动和停止容器,监控容器运行状态并汇报给Kubernetes API Server。

-

- 2.Kubernetes Proxy

- 负责为Pod创建代理服务,Kubernetes Proxy会从Kubernetes API Server获取所有的Service信息,并根据Service的信息创建代理服务,实现Service到Pod的请求路由和转发,从而实现Kubernetes层级的虚拟转发网络。

-

- 3.Docker Engine(docker),Docker引擎,负责本机的容器创建和管理工作;

-

- 4.Flannel网络插件

-

- 数据库

-

- etcd数据库,可以部署到master上,也可以独立部署

- 分布式键值存储系统。用于保存集群状态数据,比如Pod、Service等对象信息

1、Master节点

etcd:etcd存放的就是集群的状态,一般把所有的集群信息都存放到etcd当中,etcd不属于Kubernetes的某一个部分,而是单独集群部署的,API Server是它唯一的入口,可以直接访问etcd。

API Server:API Server提供了操作资源的唯一入口,例如认证、授权、访问控制、注册或者发现,都是通过API Server来完成的。

Controller Manager:负责管理集群各种资源,保证资源处于预期的状态。Controller Manager由多种controller组成,包括replication controller、endpoints controller、namespace controller、serviceaccounts controller等 。由控制器完成的主要功能主要包括生命周期功能和API业务逻辑,具体如下:

生命周期功能:包括Namespace创建和生命周期、Event垃圾回收、Pod终止相关的垃圾回收、级联垃圾回收及Node垃圾回收等。

API业务逻辑:例如,由ReplicaSet执行的Pod扩展等。

Scheduler:Scheduler调度控制器负责整个集群的资源调度,按照默认或者指定的调度策略将Pod调度到符合要求的Node节点上运行

2、Node节点

Kubelet:Kubelet维护整个容器的生命周期,API Server创建Pod,Scheduler将Pod调度到符合要求的Node节点上,该节点上的Kubelet就会去运行Pod以及Docker,Pod的存储以及网络都是Kubelet进行管理的

Docker:Docker负责镜像的管理,例如镜像的拉取、启动容器等

Kube-proxy:Kube-proxy主要是提供整个集群内部Service的负载均衡和服务发现

3、组件之间的通信

API Server是etcd访问的唯一入口,只有API Server才能访问和操作etcd集群;API Server对内和对外都提供了统一的REST API,其他组件都是通过API Server进行通信的

用户使用kubectl命令来请求API Server接口完成相应操作

Kubernetes内部组件都是通过一种watch机制去监控API Server中的资源变化,然后对其做一些相应的操作

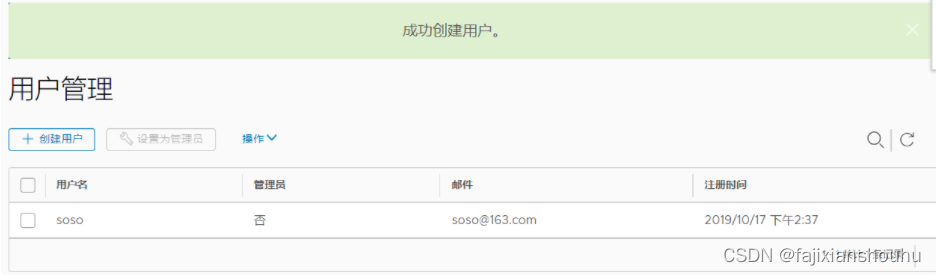

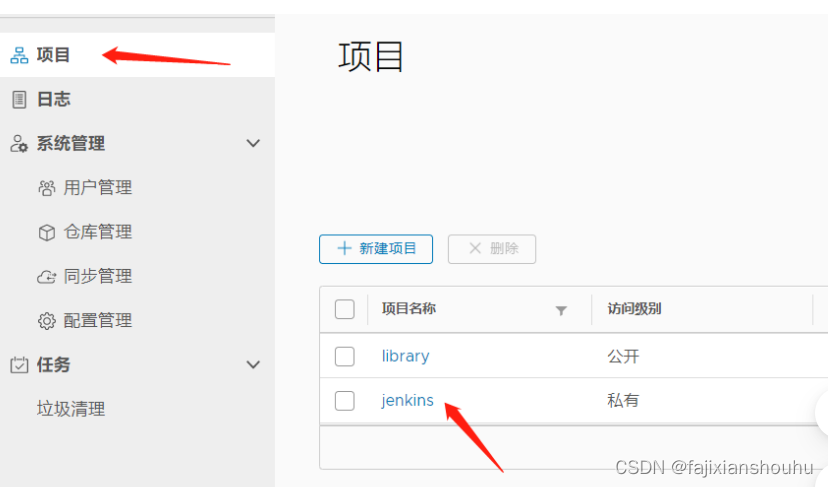

三、常用镜像仓库

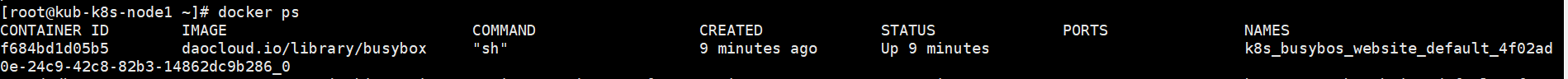

- daocloud的docker镜像库:daocloud.io/library

-

- docker-hub的k8s镜像库:mirrorgooglecontainers

-

- aliyun的k8s镜像库:registry.cn-hangzhou.aliyuncs.com/google-containers

-

- aliyun的docker镜像库web页面:https://cr.console.aliyun.com/cn-hangzhou/images

-

- google的镜像库web页面:https://console.cloud.google.com/gcr/images/google-containers?project=google-containers

四、Kubernetes集群部署方式

方式1、minikube

- Minikube是一个工具,可以在本地快速运行一个单点的Kubernetes,尝试Kubernetes或日常开发的用户使用。不能用于生产环境。

- 官方地址:https://kubernetes.io/docs/setup/minikube/

方式2、 kubeadm

- Kubeadm也是一个工具,提供kubeadm init和kubeadm join,用于快速部署Kubernetes集群。

- 官方地址:https://kubernetes.io/docs/reference/setup-tools/kubeadm/kubeadm/

方式3、 直接使用epel-release yum源,缺点就是版本较低 1.5

方式4、 二进制包

- 从官方下载发行版的二进制包,手动部署每个组件,组成Kubernetes集群。

- 官方也提供了一个互动测试环境供大家测试:https://kubernetes.io/cn/docs/tutorials/kubernetes-basics/cluster-interactive/

二进制方式部署k8s集群

目标任务:

- 1、Kubernetes集群部署架构规划

- 2、部署Etcd集群

- 3、在Node节点安装Docker

- 4、部署Flannel网络插件

- 5、在Master节点部署组件

- 6、在Node节点部署组件

- 7、查看集群状态

- 8、运行一个测试示例

- 9、部署Dashboard(Web UI)

准备环境

- 三台机器,所有机器相互做解析 centos7.4

- 关闭防火墙和selinux

- [root@k8s-master ~]# vim /etc/hosts

- 10.0.0.130 k8s-master

- 10.0.0.131 k8s-node1

- 10.0.0.132 k8s-node2

1、部署Etcd集群

使用cfssl来生成自签证书,任何机器都行,证书这块儿知道怎么生成、怎么用即可,暂且不用过多研究(这个证书随便在那台机器生成都可以。哪里用将证书拷贝到哪里就可以了。)

- 下载cfssl工具:下载的这些是可执行的二进制命令直接用就可以了

- [root@k8s-master ~]# wget https://pkg.cfssl.org/R1.2/cfssl_linux-amd64

- [root@k8s-master ~]# wget https://pkg.cfssl.org/R1.2/cfssljson_linux-amd64

- [root@k8s-master ~]# wget https://pkg.cfssl.org/R1.2/cfssl-certinfo_linux-amd64

- [root@k8s-master ~]# chmod +x cfssl_linux-amd64 cfssljson_linux-amd64 cfssl-certinfo_linux-amd64

- [root@k8s-master ~]# mv cfssl_linux-amd64 /usr/local/bin/cfssl

- [root@k8s-master ~]# mv cfssljson_linux-amd64 /usr/local/bin/cfssljson

- [root@k8s-master ~]# mv cfssl-certinfo_linux-amd64 /usr/bin/cfssl-certinfo

-

- 生成Etcd证书:

- 创建以下三个文件:

- [root@k8s-master ~]# mkdir cert

- [root@k8s-master ~]# cd cert/

- [root@k8s-master cert]# vim ca-config.json #生成ca中心的

- [root@k8s-master cert]# cat ca-config.json

- {

- "signing": {

- "default": {

- "expiry": "87600h"

- },

- "profiles": {

- "www": {

- "expiry": "87600h",

- "usages": [

- "signing",

- "key encipherment",

- "server auth",

- "client auth"

- ]

- }

- }

- }

- }

-

- [root@k8s-master cert]# vim ca-csr.json #生成ca中心的证书请求文件

- [root@k8s-master cert]# cat ca-csr.json

- {

- "CN": "etcd CA",

- "key": {

- "algo": "rsa",

- "size": 2048

- },

- "names": [

- {

- "C": "CN",

- "L": "Beijing",

- "ST": "Beijing"

- }

- ]

- }

-

- [root@k8s-master cert]# vim server-csr.json #生成服务器的证书请求文件

- [root@k8s-master cert]# cat server-csr.json

- {

- "CN": "etcd",

- "hosts": [

- "10.0.0.130",

- "10.0.0.131",

- "10.0.0.132"

- ],

- "key": {

- "algo": "rsa",

- "size": 2048

- },

- "names": [

- {

- "C": "CN",

- "L": "BeiJing",

- "ST": "BeiJing"

- }

- ]

- }

-

- 生成证书:

- [root@k8s-master cert]# cfssl gencert -initca ca-csr.json | cfssljson -bare ca -

- [root@k8s-master cert]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=www server-csr.json | cfssljson -bare server

- [root@k8s-master cert]# ls *pem

- ca-key.pem ca.pem server-key.pem server.pem

安装Etcd

二进制包下载地址:https://github.com/coreos/etcd/releases/tag/v3.2.12

- 一下步骤三台机器都操作

- [root@k8s-master ~]# wget https://github.com/etcd-io/etcd/releases/download/v3.2.12/etcd-v3.2.12-linux-amd64.tar.gz

- [root@k8s-master ~]# mkdir /opt/etcd/{bin,cfg,ssl} -p

- [root@k8s-master ~]# tar zxvf etcd-v3.2.12-linux-amd64.tar.gz

- [root@k8s-master ~]# mv etcd-v3.2.12-linux-amd64/{etcd,etcdctl} /opt/etcd/bin/

-

- 创建etcd配置文件

- [root@k8s-master ~]# cd /opt/etcd/cfg/

- [root@k8s-master cfg]# vim etcd

- #[Member]

- ETCD_NAME="etcd01" #节点名称,各个节点不能相同

- ETCD_DATA_DIR="/var/lib/etcd/default.etcd"

- ETCD_LISTEN_PEER_URLS="https://10.0.0.130:2380" #写当前节点的ip

- ETCD_LISTEN_CLIENT_URLS="https://10.0.0.130:2379" #写当前节点的ip

-

- #[Clustering]

- ETCD_INITIAL_ADVERTISE_PEER_URLS="https://10.0.0.130:2380" #写当前节点的ip

- ETCD_ADVERTISE_CLIENT_URLS="https://10.0.0.130:2379" #写当前节点的ip

- ETCD_INITIAL_CLUSTER="etcd01=https://10.0.0.130:2380,etcd02=https://10.0.0.131:2380,etcd03=https://10.0.0.132:2380" #每个节点的ip

-

- ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster"

- ETCD_INITIAL_CLUSTER_STATE="new"

-

- 参数解释:

- * ETCD_NAME 节点名称,每个节点名称不一样

- * ETCD_DATA_DIR 存储数据目录(他是一个数据库,不是存在内存的,存在硬盘中的,所有和k8s有关的信息都会存到etcd里面的)

- * ETCD_LISTEN_PEER_URLS 集群通信监听地址

- * ETCD_LISTEN_CLIENT_URLS 客户端访问监听地址

- * ETCD_INITIAL_ADVERTISE_PEER_URLS 集群通告地址

- * ETCD_ADVERTISE_CLIENT_URLS 客户端通告地址

- * ETCD_INITIAL_CLUSTER 集群节点地址

- * ETCD_INITIAL_CLUSTER_TOKEN 集群Token

- * ETCD_INITIAL_CLUSTER_STATE 加入集群的当前状态,new是新集群,existing表示加入已有集群

- systemd管理etcd:

- [root@k8s-master cfg]# vim /usr/lib/systemd/system/etcd.service

- [Unit]

- Description=Etcd Server

- After=network.target

- After=network-online.target

- Wants=network-online.target

-

- [Service]

- Type=notify

- EnvironmentFile=/opt/etcd/cfg/etcd

- ExecStart=/opt/etcd/bin/etcd \

- --name=${ETCD_NAME} \

- --data-dir=${ETCD_DATA_DIR} \

- --listen-peer-urls=${ETCD_LISTEN_PEER_URLS} \

- --listen-client-urls=${ETCD_LISTEN_CLIENT_URLS},http://127.0.0.1:2379 \

- --advertise-client-urls=${ETCD_ADVERTISE_CLIENT_URLS} \

- --initial-advertise-peer-urls=${ETCD_INITIAL_ADVERTISE_PEER_URLS} \

- --initial-cluster=${ETCD_INITIAL_CLUSTER} \

- --initial-cluster-token=${ETCD_INITIAL_CLUSTER_TOKEN} \

- --initial-cluster-state=new \

- --cert-file=/opt/etcd/ssl/server.pem \

- --key-file=/opt/etcd/ssl/server-key.pem \

- --peer-cert-file=/opt/etcd/ssl/server.pem \

- --peer-key-file=/opt/etcd/ssl/server-key.pem \

- --trusted-ca-file=/opt/etcd/ssl/ca.pem \

- --peer-trusted-ca-file=/opt/etcd/ssl/ca.pem

- Restart=on-failure

- LimitNOFILE=65536

-

- [Install]

- WantedBy=multi-user.target

- 把刚才生成的证书拷贝到配置文件中的位置:(将master上面生成的证书scp到剩余两台机器上面)

- [root@k8s-master cfg]# cd /root/cert/

- [root@k8s-master cert]# cp ca*pem server*pem /opt/etcd/ssl

- 直接拷贝到剩余两台etcd机器:

- [root@k8s-master cert]# scp ca*pem server*pem k8s-node1:/opt/etcd/ssl

- [root@k8s-master cert]# scp ca*pem server*pem k8s-node2:/opt/etcd/ssl

-

- 全部启动并设置开启启动:

- [root@k8s-master cert]# systemctl daemon-reload

- [root@k8s-master cert]# systemctl start etcd

- [root@k8s-master cert]# systemctl enable etcd

-

- 都部署完成后,三台机器都检查etcd集群状态:

- [root@k8s-master cert]# /opt/etcd/bin/etcdctl --ca-file=/opt/etcd/ssl/ca.pem --cert-file=/opt/etcd/ssl/server.pem --key-file=/opt/etcd/ssl/server-key.pem --endpoints="https://10.0.0.130:2379,https://10.0.0.130:2379,https://10.0.0.130:2379" cluster-health

- member 3db8bdf3a21a92c4 is healthy: got healthy result from https://10.0.0.132:2379

- member 455016c4da9c6bbd is healthy: got healthy result from https://10.0.0.131:2379

- member 8f696e193713398b is healthy: got healthy result from https://10.0.0.130:2379

- cluster is healthy

- 如果输出上面信息,就说明集群部署成功。

- 如果有问题第一步先看日志:/var/log/messages 或 journalctl -u etcd

-

- 报错:

- Jan 15 12:06:55 k8s-master1 etcd: request cluster ID mismatch (got 99f4702593c94f98 want cdf818194e3a8c32)

- 解决:因为集群搭建过程,单独启动过单一etcd,做为测试验证,集群内第一次启动其他etcd服务时候,是通过发现服务引导的,所以需要删除旧的成员信息,所有节点作以下操作

- [root@k8s-master default.etcd]# pwd

- /var/lib/etcd/default.etcd

- [root@k8s-master1 default.etcd]# rm -rf member/

- ========================================================

node节点安装docker(过程略)

2、部署Flannel网络

Flannel要用etcd存储自身一个子网信息,所以要保证能成功连接Etcd,写入预定义子网段:

在node节点部署,如果没有在master部署应用,那就不要在master部署flannel,他是用来给所有的容器用来通信的。

- [root@k8s-master ~]# cd cert/

- [root@k8s-master cert]# /opt/etcd/bin/etcdctl \

- --ca-file=ca.pem --cert-file=server.pem --key-file=server-key.pem \

- --endpoints="https://10.0.0.130:2379,https://10.0.0.130:2379,https://10.0.0.130:2379" \

- set /coreos.com/network/config '{ "Network": "172.17.0.0/16", "Backend": {"Type": "vxlan"}}'

- { "Network": "172.17.0.0/16", "Backend": {"Type": "vxlan"}}

-

- 以下部署步骤在规划的每个node节点都操作。

- 下载二进制包:

- [root@k8s-node1 ~]# wget https://github.com/coreos/flannel/releases/download/v0.10.0/flannel-v0.10.0-linux-amd64.tar.gz

- [root@k8s-node1 ~]# tar zxvf flannel-v0.10.0-linux-amd64.tar.gz

- [root@k8s-node1 ~]# mkdir -pv /opt/kubernetes/bin

- [root@k8s-node1 ~]# mv flanneld mk-docker-opts.sh /opt/kubernetes/bin

-

- 配置Flannel:

- [root@k8s-node1 ~]# mkdir -pv /opt/kubernetes/cfg/

- [root@k8s-node1 ~]# vim /opt/kubernetes/cfg/flanneld

- FLANNEL_OPTIONS="--etcd-endpoints=https://10.0.0.130:2379,https://10.0.0.130:2379,https://10.0.0.130:2379 -etcd-cafile=/opt/etcd/ssl/ca.pem -etcd-certfile=/opt/etcd/ssl/server.pem -etcd-keyfile=/opt/etcd/ssl/server-key.pem"

-

- systemd管理Flannel:

- [root@k8s-node1 ~]# vim /usr/lib/systemd/system/flanneld.service

- [Unit]

- Description=Flanneld overlay address etcd agent

- After=network-online.target network.target

- Before=docker.service

-

- [Service]

- Type=notify

- EnvironmentFile=/opt/kubernetes/cfg/flanneld

- ExecStart=/opt/kubernetes/bin/flanneld --ip-masq $FLANNEL_OPTIONS

- ExecStartPost=/opt/kubernetes/bin/mk-docker-opts.sh -k DOCKER_NETWORK_OPTIONS -d /run/flannel/subnet.env

- Restart=on-failure

-

- [Install]

- WantedBy=multi-user.target

-

- 配置Docker启动指定子网段:可以将源文件直接覆盖掉

- [root@k8s-node1 ~]# vim /usr/lib/systemd/system/docker.service

- [Unit]

- Description=Docker Application Container Engine

- Documentation=https://docs.docker.com

- After=network-online.target firewalld.service

- Wants=network-online.target

-

- [Service]

- Type=notify

- EnvironmentFile=/run/flannel/subnet.env

- ExecStart=/usr/bin/dockerd $DOCKER_NETWORK_OPTIONS

- ExecReload=/bin/kill -s HUP $MAINPID

- LimitNOFILE=infinity

- LimitNPROC=infinity

- LimitCORE=infinity

- TimeoutStartSec=0

- Delegate=yes

- KillMode=process

- Restart=on-failure

- StartLimitBurst=3

- StartLimitInterval=60s

-

- [Install]

- WantedBy=multi-user.target

-

- 重启flannel和docker:

- # systemctl daemon-reload

- # systemctl start flanneld

- # systemctl enable flanneld

- # systemctl restart docker

-

- 注意:如果flannel启动不了请检查设置ip网段是否正确

-

- 检查是否生效:

- [root@k8s-node1 ~]# ps -ef | grep docker

- root 3632 1 1 22:19 ? 00:00:00 /usr/bin/dockerd --bip=172.17.77.1/24 --ip-masq=false --mtu=1450

-

- 注:

- 1. 确保docker0与flannel.1在同一网段。

- 2. 测试不同节点互通,在当前节点访问另一个Node节点docker0 IP:案例:node1机器pingnode2机器的docker0上面的ip地址

- [root@k8s-node1 ~]# ping 172.17.33.1

- PING 172.17.33.1 (172.17.33.1) 56(84) bytes of data.

- 64 bytes from 172.17.33.1: icmp_seq=1 ttl=64 time=0.520 ms

- 64 bytes from 172.17.33.1: icmp_seq=2 ttl=64 time=0.972 ms

- 64 bytes from 172.17.33.1: icmp_seq=3 ttl=64 time=0.642 ms

- 如果能通说明Flannel部署成功。如果不通检查下日志:journalctl -u flannel(快照吧!!!)

3、在Master节点部署组件

在部署Kubernetes之前一定要确保etcd、flannel、docker是正常工作的,否则先解决问题再继续。

生成证书

- master节点操作--给api-server创建的证书。别的服务访问api-server的时候需要通过证书认证

- 创建CA证书:

- [root@k8s-master ~]# mkdir -p /opt/crt/

- [root@k8s-master ~]# cd /opt/crt/

- # vim ca-config.json

- {

- "signing": {

- "default": {

- "expiry": "87600h"

- },

- "profiles": {

- "kubernetes": {

- "expiry": "87600h",

- "usages": [

- "signing",

- "key encipherment",

- "server auth",

- "client auth"

- ]

- }

- }

- }

- }

-

- # vim ca-csr.json

- {

- "CN": "kubernetes",

- "key": {

- "algo": "rsa",

- "size": 2048

- },

- "names": [

- {

- "C": "CN",

- "L": "Beijing",

- "ST": "Beijing",

- "O": "k8s",

- "OU": "System"

- }

- ]

- }

-

- [root@k8s-master crt]# cfssl gencert -initca ca-csr.json | cfssljson -bare ca -

-

- 生成apiserver证书:

- [root@k8s-master1 crt]# vim server-csr.json

- # cat server-csr.json

- {

- "CN": "kubernetes",

- "hosts": [

- "10.0.0.1", //这是后面dns要使用的虚拟网络的网关,不用改,就用这个切忌

- "127.0.0.1",

- "10.0.0.130", // master的IP地址。

- "10.0.0.131",

- "10.0.0.132",

- "kubernetes",

- "kubernetes.default",

- "kubernetes.default.svc",

- "kubernetes.default.svc.cluster",

- "kubernetes.default.svc.cluster.local"

- ],

- "key": {

- "algo": "rsa",

- "size": 2048

- },

- "names": [

- {

- "C": "CN",

- "L": "BeiJing",

- "ST": "BeiJing",

- "O": "k8s",

- "OU": "System"

- }

- ]

- }

-

- [root@k8s-master crt]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes server-csr.json | cfssljson -bare server

-

- 生成kube-proxy证书:

- [root@k8s-master crt]# vim kube-proxy-csr.json

- # cat kube-proxy-csr.json

- {

- "CN": "system:kube-proxy",

- "hosts": [],

- "key": {

- "algo": "rsa",

- "size": 2048

- },

- "names": [

- {

- "C": "CN",

- "L": "BeiJing",

- "ST": "BeiJing",

- "O": "k8s",

- "OU": "System"

- }

- ]

- }

-

- [root@k8s-master crt]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes kube-proxy-csr.json | cfssljson -bare kube-proxy

-

- 最终生成以下证书文件:

- [root@k8s-master crt]# ls *pem

- ca-key.pem ca.pem kube-proxy-key.pem kube-proxy.pem server-key.pem server.pem

部署apiserver组件---在master节点进行 下载二进制包:https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG-1.11.md 下载这个包(kubernetes-server-linux-amd64.tar.gz)就够了,包含了所需的所有组件。

- [root@k8s-master ~]# wget https://dl.k8s.io/v1.11.10/kubernetes-server-linux-amd64.tar.gz

- [root@k8s-master ~]# mkdir /opt/kubernetes/{bin,cfg,ssl} -pv

- [root@k8s-master ~]# tar zxvf kubernetes-server-linux-amd64.tar.gz

- [root@k8s-master ~]# cd kubernetes/server/bin

- [root@k8s-master bin]# cp kube-apiserver kube-scheduler kube-controller-manager kubectl /opt/kubernetes/bin

-

- [root@k8s-master bin]# cd /opt/crt/

- [root@k8s-master crt]# cp server.pem server-key.pem ca.pem ca-key.pem /opt/kubernetes/ssl/

-

- 创建token文件:

- [root@k8s-master1 crt]# cd /opt/kubernetes/cfg/

- [root@k8s-master1 cfg]# vim token.csv

- 674c457d4dcf2eefe4920d7dbb6b0ddc,kubelet-bootstrap,10001,"system:kubelet-bootstrap"

- 第一列:随机字符串,自己可生成

- 第二列:用户名

- 第三列:UID

- 第四列:用户组

-

- 创建apiserver配置文件:

- [root@k8s-master cfg]# pwd

- /opt/kubernetes/cfg

- [root@k8s-master cfg]# vim kube-apiserver

- KUBE_APISERVER_OPTS="--logtostderr=true \

- --v=4 \

- --etcd-servers=https://10.0.0.130:2379,https://10.0.0.131:2379,https://10.0.0.132:2379 \

- --bind-address=10.0.0.130 \ #master的ip地址,就是安装api-server的机器地址

- --secure-port=6443 \

- --advertise-address=10.0.0.130 \

- --allow-privileged=true \

- --service-cluster-ip-range=10.0.0.0/24 \ #这里就用这个网段切记不要修改

- --enable-admission-plugins=NamespaceLifecycle,LimitRanger,ServiceAccount,ResourceQuota,NodeRestriction \

- --authorization-mode=RBAC,Node \

- --enable-bootstrap-token-auth \

- --token-auth-file=/opt/kubernetes/cfg/token.csv \

- --service-node-port-range=30000-50000 \

- --tls-cert-file=/opt/kubernetes/ssl/server.pem \

- --tls-private-key-file=/opt/kubernetes/ssl/server-key.pem \

- --client-ca-file=/opt/kubernetes/ssl/ca.pem \

- --service-account-key-file=/opt/kubernetes/ssl/ca-key.pem \

- --etcd-cafile=/opt/etcd/ssl/ca.pem \

- --etcd-certfile=/opt/etcd/ssl/server.pem \

- --etcd-keyfile=/opt/etcd/ssl/server-key.pem"

-

- 配置好前面生成的证书,确保能连接etcd。

-

- 参数说明:

- * --logtostderr 启用日志

- * --v 日志等级

- * --etcd-servers etcd集群地址

- * --bind-address 监听地址

- * --secure-port https安全端口

- * --advertise-address 集群通告地址

- * --allow-privileged 启用授权

- * --service-cluster-ip-range Service虚拟IP地址段

- * --enable-admission-plugins 准入控制模块

- * --authorization-mode 认证授权,启用RBAC授权和节点自管理

- * --enable-bootstrap-token-auth 启用TLS bootstrap功能,后面会讲到

- * --token-auth-file token文件

- * --service-node-port-range Service Node类型默认分配端口范围

-

- systemd管理apiserver:

- [root@k8s-master cfg]# cd /usr/lib/systemd/system

- [root@k8s-master system]# vim kube-apiserver.service

- [Unit]

- Description=Kubernetes API Server

- Documentation=https://github.com/kubernetes/kubernetes

-

- [Service]

- EnvironmentFile=-/opt/kubernetes/cfg/kube-apiserver

- ExecStart=/opt/kubernetes/bin/kube-apiserver $KUBE_APISERVER_OPTS

- Restart=on-failure

-

- [Install]

- WantedBy=multi-user.target

-

-

- 启动:

- # systemctl daemon-reload

- # systemctl enable kube-apiserver

- # systemctl start kube-apiserver

- # systemctl status kube-apiserver

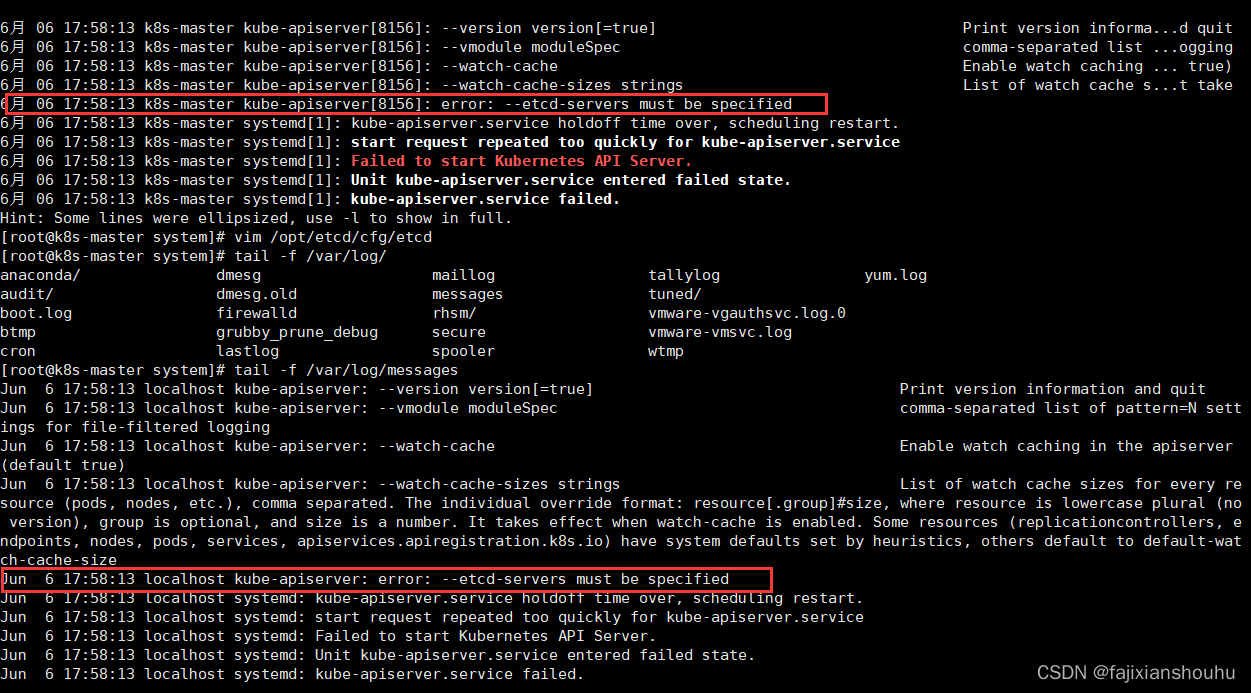

如果出现以下错误

去kube-apiserver配置文件中看一下行尾有没有空格,使用set list查看

部署schduler组件---master节点

- 创建schduler配置文件:

- [root@k8s-master cfg]# vim /opt/kubernetes/cfg/kube-scheduler

- KUBE_SCHEDULER_OPTS="--logtostderr=true \

- --v=4 \

- --master=127.0.0.1:8080 \

- --leader-elect"

- 参数说明:

- * --master 连接本地apiserver

- * --leader-elect 当该组件启动多个时,自动选举(HA)

-

- systemd管理schduler组件:

- [root@k8s-master cfg]# cd /usr/lib/systemd/system/

- [root@k8s-master system]# vim kube-scheduler.service

- [Unit]

- Description=Kubernetes Scheduler

- Documentation=https://github.com/kubernetes/kubernetes

-

- [Service]

- EnvironmentFile=-/opt/kubernetes/cfg/kube-scheduler

- ExecStart=/opt/kubernetes/bin/kube-scheduler $KUBE_SCHEDULER_OPTS

- Restart=on-failure

-

- [Install]

- WantedBy=multi-user.target

-

- 启动:

- # systemctl daemon-reload

- # systemctl enable kube-scheduler

- # systemctl start kube-scheduler

- # systemctl status kube-scheduler

部署controller-manager组件--控制管理组件

- master节点操作:创建controller-manager配置文件:

- [root@k8s-master ~]# cd /opt/kubernetes/cfg/

- [root@k8s-master cfg]# vim kube-controller-manager

- KUBE_CONTROLLER_MANAGER_OPTS="--logtostderr=true \

- --v=4 \

- --master=127.0.0.1:8080 \

- --leader-elect=true \

- --address=127.0.0.1 \

- --service-cluster-ip-range=10.0.0.0/24 \ //这是后面dns要使用的虚拟网络,不用改,就用这个 切忌

- --cluster-name=kubernetes \

- --cluster-signing-cert-file=/opt/kubernetes/ssl/ca.pem \

- --cluster-signing-key-file=/opt/kubernetes/ssl/ca-key.pem \

- --root-ca-file=/opt/kubernetes/ssl/ca.pem \

- --service-account-private-key-file=/opt/kubernetes/ssl/ca-key.pem"

-

- systemd管理controller-manager组件:

- [root@k8s-master cfg]# cd /usr/lib/systemd/system/

- [root@k8s-master system]# vim kube-controller-manager.service

- # cat /usr/lib/systemd/system/kube-controller-manager.service

- [Unit]

- Description=Kubernetes Controller Manager

- Documentation=https://github.com/kubernetes/kubernetes

-

- [Service]

- EnvironmentFile=-/opt/kubernetes/cfg/kube-controller-manager

- ExecStart=/opt/kubernetes/bin/kube-controller-manager $KUBE_CONTROLLER_MANAGER_OPTS

- Restart=on-failure

-

- [Install]

- WantedBy=multi-user.target

-

- 启动:

- # systemctl daemon-reload

- # systemctl enable kube-controller-manager

- # systemctl start kube-controller-manager

- # systemctl status kube-controller-manager.service

- 所有组件都已经启动成功,通过kubectl工具查看当前集群组件状态:

- [root@k8s-master ~]# /opt/kubernetes/bin/kubectl get cs

- NAME STATUS MESSAGE ERROR

- scheduler Healthy ok

- controller-manager Healthy ok

- etcd-2 Healthy {"health": "true"}

- etcd-1 Healthy {"health": "true"}

- etcd-0 Healthy {"health": "true"}

- 如上输出说明组件都正常。

4、在Node节点部署组件

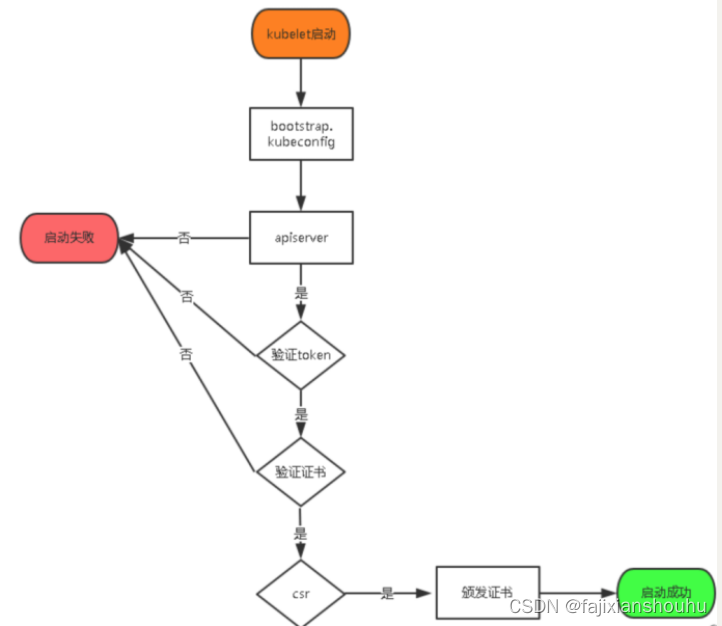

Master apiserver启用TLS认证后,Node节点kubelet组件想要加入集群,必须使用CA签发的有效证书才能与apiserver通信,当Node节点很多时,签署证书是一件很繁琐的事情,因此有了TLS Bootstrapping机制,kubelet会以一个低权限用户自动向apiserver申请证书,kubelet的证书由apiserver动态签署。

认证大致工作流程如图所示:

- ----------------------下面这些操作在master节点完成:---------------------------

- 将kubelet-bootstrap用户绑定到系统集群角色

- [root@k8s-master ~]# /opt/kubernetes/bin/kubectl create clusterrolebinding kubelet-bootstrap \

- --clusterrole=system:node-bootstrapper \

- --user=kubelet-bootstrap

- clusterrolebinding.rbac.authorization.k8s.io/kubelet-bootstrap created

-

- 创建kubeconfig文件:

- 在生成kubernetes证书的目录下执行以下命令生成kubeconfig文件:

- [root@k8s-master ~]# cd /opt/crt/

- 指定apiserver 内网负载均衡地址

- [root@k8s-master crt]# KUBE_APISERVER="https://10.0.0.130:6443" #写你master的ip地址,集群中就写负载均衡的ip地址

- [root@k8s-master1 crt]# BOOTSTRAP_TOKEN=674c457d4dcf2eefe4920d7dbb6b0ddc 这个就是前面我们在token.csv文件中写的

-

- # 设置集群参数

- [root@k8s-master crt]# /opt/kubernetes/bin/kubectl config set-cluster kubernetes \

- --certificate-authority=ca.pem \

- --embed-certs=true \

- --server=${KUBE_APISERVER} \

- --kubeconfig=bootstrap.kubeconfig

-

- # 设置客户端认证参数

- [root@k8s-master crt]# /opt/kubernetes/bin/kubectl config set-credentials kubelet-bootstrap \

- --token=${BOOTSTRAP_TOKEN} \

- --kubeconfig=bootstrap.kubeconfig

-

- # 设置上下文参数

- [root@k8s-master crt]# /opt/kubernetes/bin/kubectl config set-context default \

- --cluster=kubernetes \

- --user=kubelet-bootstrap \

- --kubeconfig=bootstrap.kubeconfig

-

- # 设置默认上下文

- [root@k8s-master crt]# /opt/kubernetes/bin/kubectl config use-context default --kubeconfig=bootstrap.kubeconfig

-

- #====================================================================================

-

- # 创建kube-proxy kubeconfig文件

-

- [root@k8s-master crt]# /opt/kubernetes/bin/kubectl config set-cluster kubernetes \

- --certificate-authority=ca.pem \

- --embed-certs=true \

- --server=${KUBE_APISERVER} \

- --kubeconfig=kube-proxy.kubeconfig

-

- [root@k8s-master crt]# /opt/kubernetes/bin/kubectl config set-credentials kube-proxy \

- --client-certificate=kube-proxy.pem \

- --client-key=kube-proxy-key.pem \

- --embed-certs=true \

- --kubeconfig=kube-proxy.kubeconfig

-

- [root@k8s-master crt]# /opt/kubernetes/bin/kubectl config set-context default \

- --cluster=kubernetes \

- --user=kube-proxy \

- --kubeconfig=kube-proxy.kubeconfig

-

- [root@k8s-master crt]# /opt/kubernetes/bin/kubectl config use-context default --kubeconfig=kube-proxy.kubeconfig

-

-

- [root@k8s-master crt]# ls

- bootstrap.kubeconfig kube-proxy.kubeconfig

-

- #必看:将这两个文件拷贝到Node节点/opt/kubernetes/cfg目录下。

- [root@k8s-master crt]# scp *.kubeconfig k8s-node1:/opt/kubernetes/cfg/

- [root@k8s-master crt]# scp *.kubeconfig k8s-node2:/opt/kubernetes/cfg/

- ----------------------下面这些操作在node节点完成:---------------------------

- 部署kubelet组件

- #将前面下载的二进制包中的kubelet和kube-proxy拷贝到/opt/kubernetes/bin目录下。

- 将master上面的包拷贝过去

- [root@k8s-master ~]# scp kubernetes-server-linux-amd64.tar.gz k8s-node1:/root/

- [root@k8s-master ~]# scp kubernetes-server-linux-amd64.tar.gz k8s-node2:/root/

- [root@k8s-node1 ~]# tar xzf kubernetes-server-linux-amd64.tar.gz

- [root@k8s-node1 ~]# cd kubernetes/server/bin/

- [root@k8s-node1 bin]# cp kubelet kube-proxy /opt/kubernetes/bin/

- 或者直接在master上将解压后的kubernetes/server/bin/目录中的kubelet kube-proxy这两个文件远程拷贝到node节点的/opt/kubernetes/bin目录中

- #=====================================================================================

- 在两个node节点创建kubelet配置文件:

- [root@k8s-node1 ~]# vim /opt/kubernetes/cfg/kubelet

- KUBELET_OPTS="--logtostderr=true \

- --v=4 \

- --hostname-override=10.0.0.131 \ #每个节点自己的ip地址

- --kubeconfig=/opt/kubernetes/cfg/kubelet.kubeconfig \

- --bootstrap-kubeconfig=/opt/kubernetes/cfg/bootstrap.kubeconfig \

- --config=/opt/kubernetes/cfg/kubelet.config \

- --cert-dir=/opt/kubernetes/ssl \

- --pod-infra-container-image=registry.cn-hangzhou.aliyuncs.com/google-containers/pause-amd64:3.0" #这个镜像需要提前下载

-

- [root@k8s-node1 ~]# docker pull registry.cn-hangzhou.aliyuncs.com/google-containers/pause-amd64:3.0

- [root@k8s-node2 ~]# docker pull registry.cn-hangzhou.aliyuncs.com/google-containers/pause-amd64:3.0

- 参数说明:

- * --hostname-override 在集群中显示的主机名

- * --kubeconfig 指定kubeconfig文件位置,会自动生成

- * --bootstrap-kubeconfig 指定刚才生成的bootstrap.kubeconfig文件

- * --cert-dir 颁发证书存放位置

- * --pod-infra-container-image 管理Pod网络的镜像

-

- 其中/opt/kubernetes/cfg/kubelet.config配置文件如下:

- [root@k8s-node1 ~]# vim /opt/kubernetes/cfg/kubelet.config

- kind: KubeletConfiguration

- apiVersion: kubelet.config.k8s.io/v1beta1

- address: 10.0.0.131 #写你机器的ip地址

- port: 10250

- readOnlyPort: 10255

- cgroupDriver: cgroupfs

- clusterDNS: ["10.0.0.2"] #不要改,就是这个ip地址

- clusterDomain: cluster.local.

- failSwapOn: false

- authentication:

- anonymous:

- enabled: true

- webhook:

- enabled: false

-

- systemd管理kubelet组件:

- # vim /usr/lib/systemd/system/kubelet.service

- [Unit]

- Description=Kubernetes Kubelet

- After=docker.service

- Requires=docker.service

-

- [Service]

- EnvironmentFile=/opt/kubernetes/cfg/kubelet

- ExecStart=/opt/kubernetes/bin/kubelet $KUBELET_OPTS

- Restart=on-failure

- KillMode=process

-

- [Install]

- WantedBy=multi-user.target

-

- 启动:

- # systemctl daemon-reload

- # systemctl enable kubelet

- # systemctl start kubelet

- [root@k8s-master ~]# /opt/kubernetes/bin/kubectl get csr

- NAME AGE REQUESTOR CONDITION

- node-csr-F5AQ8SeoyloVrjPuzSbzJnFKQaUsier7EGvNFXLKTqM 17s kubelet-bootstrap Pending

- node-csr-bjeHSWXOuUDSHganJPL_hDz_8jjYhM2FQyTkbA9pM0Q 18s kubelet-bootstrap Pending

-

- 在Master审批Node加入集群:

- 启动后还没加入到集群中,需要手动允许该节点才可以。在Master节点查看请求签名的Node:

- [root@k8s-master ~]# /opt/kubernetes/bin/kubectl certificate approve XXXXID

- 注意:xxxid 指的是上面的NAME这一列

- [root@k8s-master ~]# /opt/kubernetes/bin/kubectl get csr

- NAME AGE REQUESTOR CONDITION

- node-csr--1TVDzcozo7NoOD3WS2t9xLQqNunsVXj_i2AQ5x1mbs 1m kubelet-bootstrap Approved,Issued

- node-csr-L0wqvr69oy8rzXwFm1u1uNx4aEMOOvd_RWPxaAERn_w 27m kubelet-bootstrap Approved,Issued

-

-

- 查看集群节点信息:

- [root@k8s-master ~]# /opt/kubernetes/bin/kubectl get node

- NAME STATUS ROLES AGE VERSION

- 10.0.0.131 Ready <none> 1m v1.11.10

- 10.0.0.132 Ready <none> 17s v1.11.10

部署kube-proxy组件

- 创建kube-proxy配置文件:还是在所有node节点 node1、node2都做

- [root@k8s-node1 ~]# vim /opt/kubernetes/cfg/kube-proxy

- # cat /opt/kubernetes/cfg/kube-proxy

- KUBE_PROXY_OPTS="--logtostderr=true \

- --v=4 \

- --hostname-override=10.0.0.131 \ #写每个node节点ip

- --cluster-cidr=10.0.0.0/24 \ //不要改,就是这个ip

- --kubeconfig=/opt/kubernetes/cfg/kube-proxy.kubeconfig"

-

- systemd管理kube-proxy组件:

- [root@k8s-node1 ~]# cd /usr/lib/systemd/system

- # cat /usr/lib/systemd/system/kube-proxy.service

- [Unit]

- Description=Kubernetes Proxy

- After=network.target

-

- [Service]

- EnvironmentFile=-/opt/kubernetes/cfg/kube-proxy

- ExecStart=/opt/kubernetes/bin/kube-proxy $KUBE_PROXY_OPTS

- Restart=on-failure

-

- [Install]

- WantedBy=multi-user.target

-

- 启动:

-

- # systemctl daemon-reload

- # systemctl enable kube-proxy

- # systemctl start kube-proxy

-

- 在master查看集群状态

- [root@k8s-master1 ~]# /opt/kubernetes/bin/kubectl get node

- NAME STATUS ROLES AGE VERSION

- 10.0.0.131 Ready <none> 19m v1.11.10

- 10.0.0.132 Ready <none> 18m v1.11.10

-

- 查看集群状态

- [root@k8s-master ~]# /opt/kubernetes/bin/kubectl get cs

- NAME STATUS MESSAGE ERROR

- scheduler Healthy ok

- controller-manager Healthy ok

- etcd-0 Healthy {"health": "true"}

- etcd-1 Healthy {"health": "true"}

- etcd-2 Healthy {"health": "true"}

- =====================================================================================

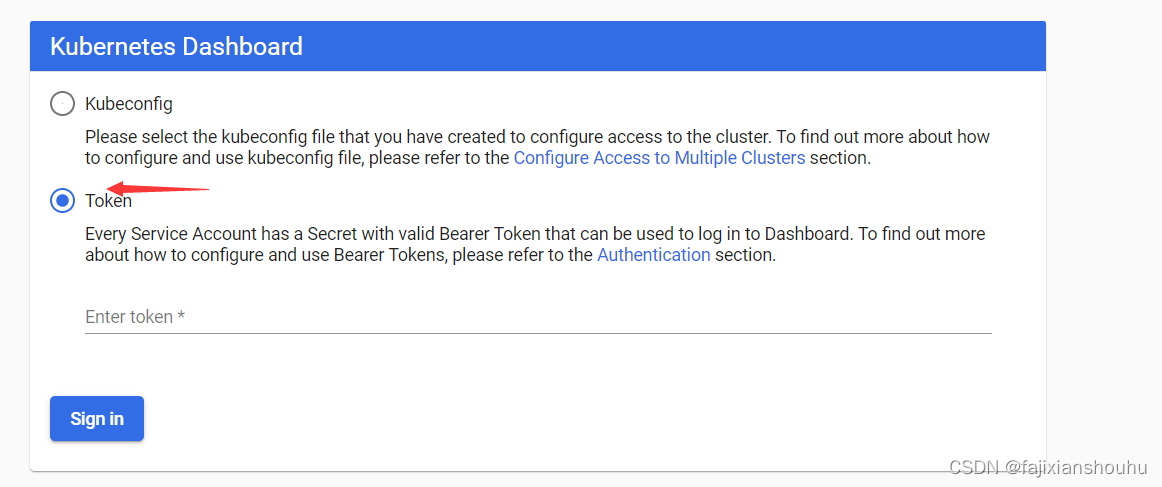

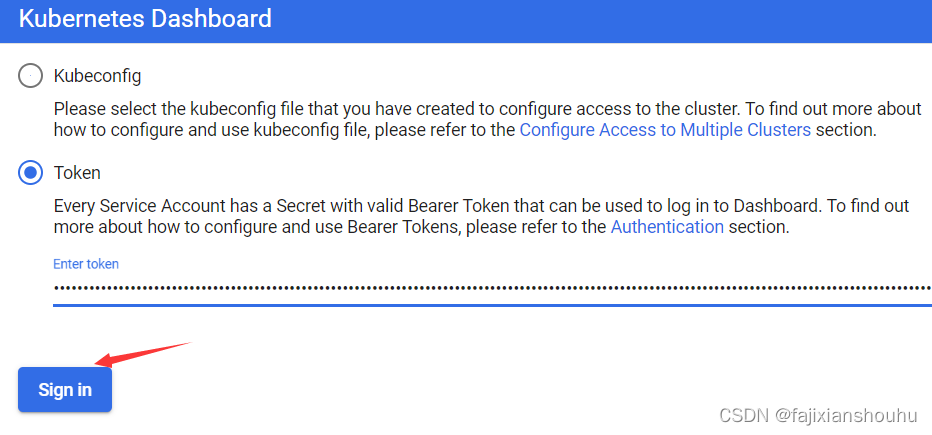

部署dashboard(web ui)

在msater上部署

- * dashboard-deployment.yaml #部署Pod,提供Web服务

- * dashboard-rbac.yaml #授权访问apiserver获取信息

- * dashboard-service.yaml #发布服务,提供对外访问

-

- 创建一个目录

- [root@k8s-master ~]# mkdir webui

- [root@k8s-master ~]# cd webui/

- [root@k8s-master webui]# cat dashboard-deployment.yaml

- apiVersion: v1

- kind: Deployment

- metadata:

- name: kubernetes-dashboard

- namespace: kube-system

- labels:

- k8s-app: kubernetes-dashboard

- kubernetes.io/cluster-service: "true"

- addonmanager.kubernetes.io/mode: Reconcile

- spec:

- selector:

- matchLabels:

- k8s-app: kubernetes-dashboard

- template:

- metadata:

- labels:

- k8s-app: kubernetes-dashboard

- annotations:

- scheduler.alpha.kubernetes.io/critical-pod: ''

- spec:

- serviceAccountName: kubernetes-dashboard

- containers:

- - name: kubernetes-dashboard

- image: registry.cn-hangzhou.aliyuncs.com/kube_containers/kubernetes-dashboard-amd64:v1.8.1

- resources:

- limits:

- cpu: 100m

- memory: 300Mi

- requests:

- cpu: 100m

- memory: 100Mi

- ports:

- - containerPort: 9090

- protocol: TCP

- livenessProbe:

- httpGet:

- scheme: HTTP

- path: /

- port: 9090

- initialDelaySeconds: 30

- timeoutSeconds: 30

- tolerations:

- - key: "CriticalAddonsOnly"

- operator: "Exists"

-

- [root@k8s-master webui]# cat dashboard-rbac.yaml

- apiVersion: v1

- kind: ServiceAccount

- metadata:

- labels:

- k8s-app: kubernetes-dashboard

- addonmanager.kubernetes.io/mode: Reconcile

- name: kubernetes-dashboard

- namespace: kube-system

- ---

-

- kind: ClusterRoleBinding

- apiVersion: rbac.authorization.k8s.io/v1beta1

- metadata:

- name: kubernetes-dashboard-minimal

- namespace: kube-system

- labels:

- k8s-app: kubernetes-dashboard

- addonmanager.kubernetes.io/mode: Reconcile

- roleRef:

- apiGroup: rbac.authorization.k8s.io

- kind: ClusterRole

- name: cluster-admin

- subjects:

- - kind: ServiceAccount

- name: kubernetes-dashboard

- namespace: kube-system

-

- [root@k8s-master webui]# cat dashboard-service.yaml

- apiVersion: v1

- kind: Service

- metadata:

- name: kubernetes-dashboard

- namespace: kube-system

- labels:

- k8s-app: kubernetes-dashboard

- kubernetes.io/cluster-service: "true"

- addonmanager.kubernetes.io/mode: Reconcile

- spec:

- type: NodePort

- selector:

- k8s-app: kubernetes-dashboard

- ports:

- - port: 80

- targetPort: 9090

-

- [root@k8s-master webui]# /opt/kubernetes/bin/kubectl create -f dashboard-rbac.yaml

- [root@k8s-master webui]# /opt/kubernetes/bin/kubectl create -f dashboard-deployment.yaml

- [root@k8s-master webui]# /opt/kubernetes/bin/kubectl create -f dashboard-service.yaml

- 等待数分钟,查看资源状态:

-

- 查看名称空间:

- [root@k8s-master webui]# /opt/kubernetes/bin/kubectl get all -n kube-system

- NAME READY STATUS RESTARTS AGE

- pod/kubernetes-dashboard-d9545b947-442ft 1/1 Running 0 21m

-

- NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

- service/kubernetes-dashboard NodePort 10.0.0.143 <none> 80:47520/TCP 21m

-

- NAME DESIRED CURRENT UP-TO-DATE AVAILABLE AGE

- deployment.apps/kubernetes-dashboard 1 1 1 1 21m

-

- NAME DESIRED CURRENT READY AGE

- replicaset.apps/kubernetes-dashboard-d9545b947 1 1 1 21m

- 查看访问端口:

-

- 查看指定命名空间的服务

- [root@k8s-master webui]# /opt/kubernetes/bin/kubectl get svc -n kube-system

- NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

- kubernetes-dashboard NodePort 10.0.0.143 <none> 80:47520/TCP 22m

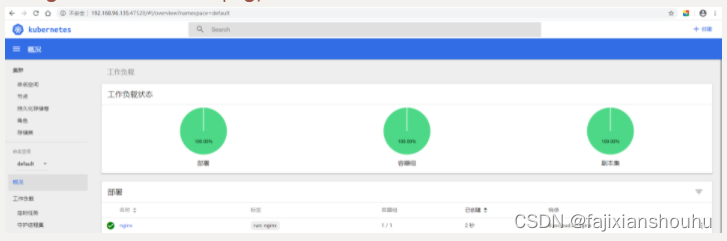

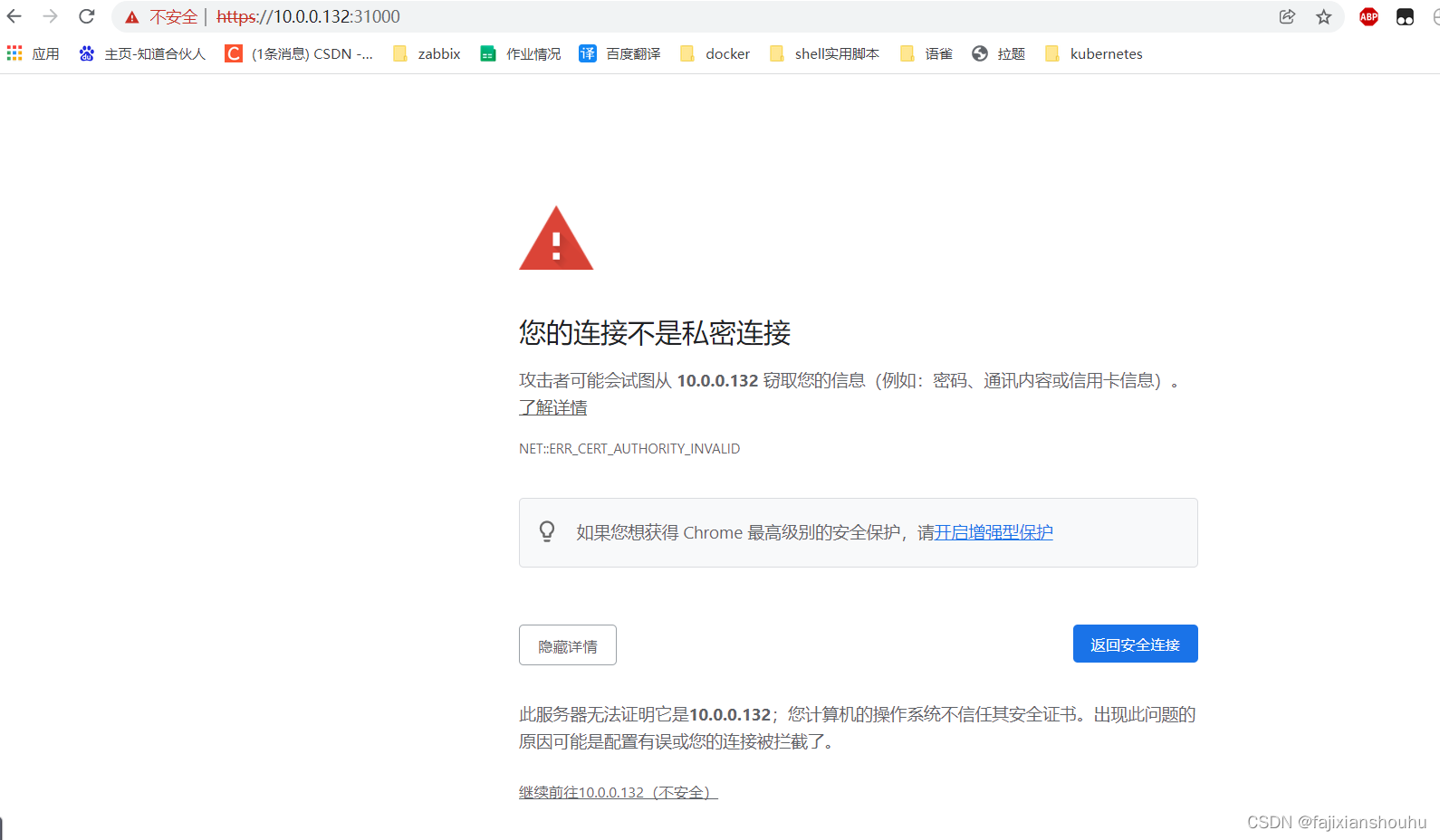

访问node节点的ip

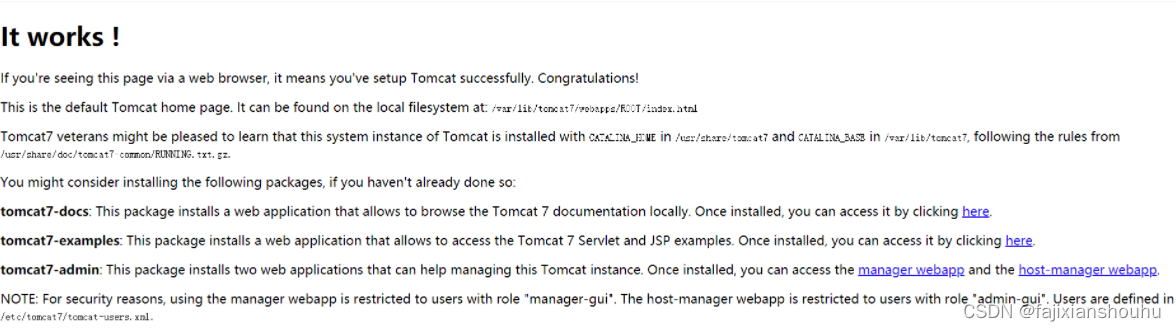

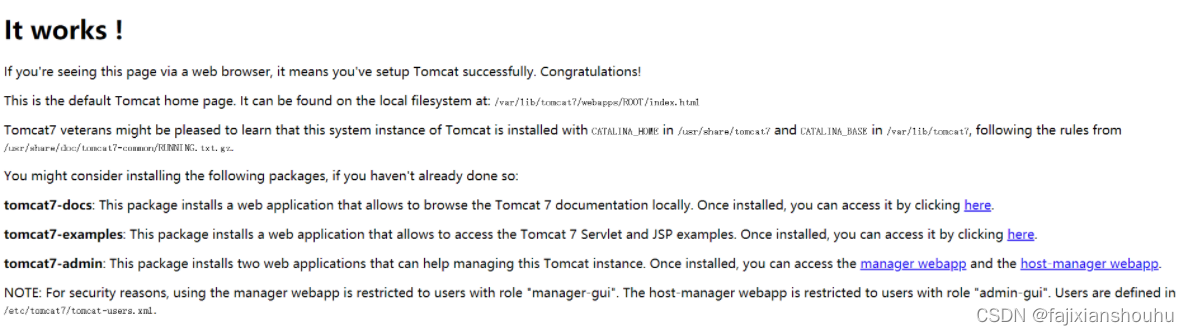

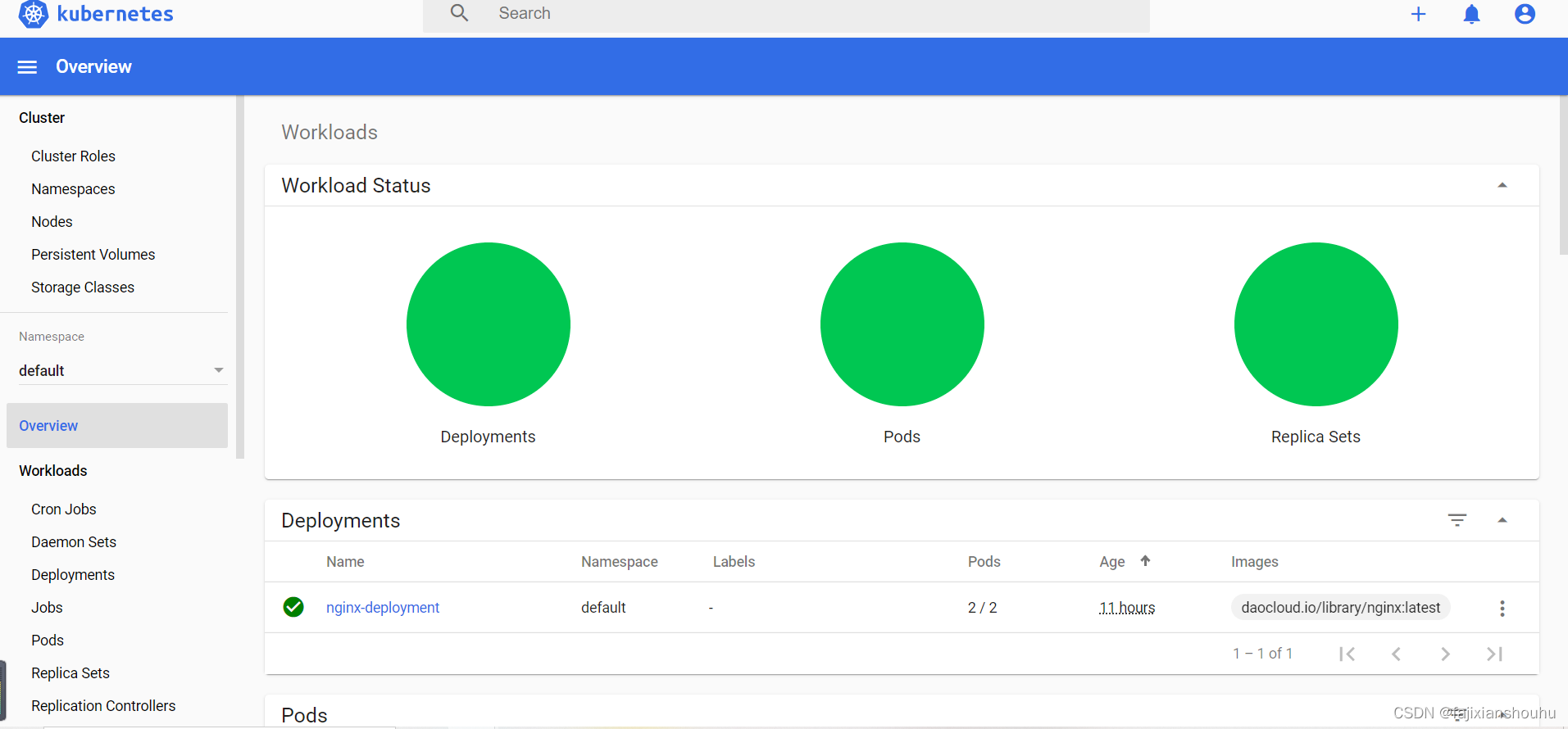

测试

- ==========================================================

- 运行一个测试示例--在master节点先安装docker服务

- 创建一个Nginx Web,判断集群是否正常工

- # /opt/kubernetes/bin/kubectl run nginx --image=daocloud.io/nginx --replicas=3

- # /opt/kubernetes/bin/kubectl expose deployment nginx --port=88 --target-port=80 --type=NodePort

-

- # /opt/kub.../bin/kubectl delete -f deployment --all

-

- 在master上面查看:

- 查看Pod,Service:

- # /opt/kubernetes/bin/kubectl get pods #需要等一会

- NAME READY STATUS RESTARTS AGE

- nginx-64f497f8fd-fjgt2 1/1 Running 3 28d

- nginx-64f497f8fd-gmstq 1/1 Running 3 28d

- nginx-64f497f8fd-q6wk9 1/1 Running 3 28d

-

- 查看pod详细信息:

- # /opt/kubernetes/bin/kubectl describe pod nginx-64f497f8fd-fjgt2

-

- # /opt/kubernetes/bin/kubectl get svc

- NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

- kubernetes ClusterIP 10.0.0.1 <none> 443/TCP 28d

- nginx NodePort 10.0.0.175 <none> 88:38696/TCP 28d

-

- 访问nodeip加端口

- 打开浏览器输入:http://10.0.0.131:38696

-

- 恭喜你,集群部署成功!

- ============================

kubeadm方式部署k8s集群

官方文档:

Installing kubeadm | Kubernetes

切记要关闭防火墙和selinux,cpu核心数至少为2;内存4G

kubeadm部署k8s高可用集群的官方文档:

Creating Highly Available Clusters with kubeadm | Kubernetes

实验环境:

k8s-master:10.0.0.130

k8s-node1:10.0.0.131

k8s-node2:10.0.0.132

全部关闭防火墙selinux

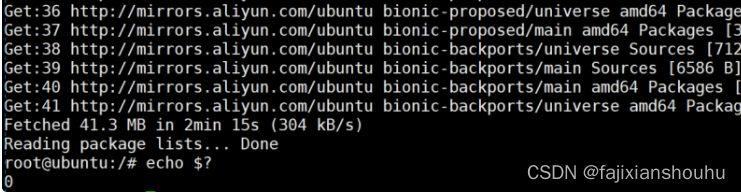

1、获取镜像

在docker hub拉取相应的镜像并重新打标:

注意:所有节点都要进行一下操作

- 直接从docker官方拉取镜像可能拉取不成功,所以我们可以从 registry.cn-hangzhou.aliyuncs.com拉取镜像,然后修改镜像tag

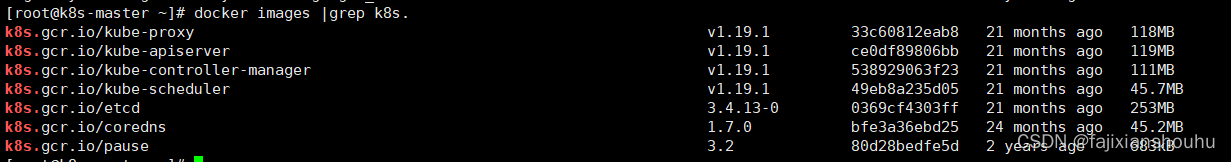

- 写一个脚本,我部署的是k8s集群1.19.1版本的,其他版本套路是一样的,不过可能会出一些小问题,我也没试过,感兴趣的兄弟可以试一下

- [root@k8s-master ~]# vim a.sh

- docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager:v1.19.1

- docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.19.1

- docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:v1.19.1

- docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler:v1.19.1

- docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:1.7.0

- docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/etcd:3.4.13-0

- docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.2

- docker pull quay-mirror.qiniu.com/coreos/flannel:v0.12.0-amd64

- [root@k8s-master ~]# bash a.sh

- ....等待镜像拉取成功,注意:kube-controller-manager、kube-proxy、kube-apiserver、kube-scheduler、的版本必须一致,flannel的版本我用的是0.12.0的,这也是看网上搜的用这个版本,pause的镜像是3.2,也是网上搜的,而coredns:1.7.0、etcd:3.4.13-0是我后来初始化失败的错误回显建议我使用这个版本

- [root@k8s-master ~]# docker images

- REPOSITORY TAG IMAGE ID CREATED SIZE

- registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy v1.19.1 33c60812eab8 21 months ago 118MB

- registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver v1.19.1 ce0df89806bb 21 months ago 119MB

- registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager v1.19.1 538929063f23 21 months ago 111MB

- registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler v1.19.1 49eb8a235d05 21 months ago 45.7MB

- registry.cn-hangzhou.aliyuncs.com/google_containers/etcd 3.4.13-0 0369cf4303ff 21 months ago 253MB

- registry.cn-hangzhou.aliyuncs.com/google_containers/coredns 1.7.0 bfe3a36ebd25 24 months ago 45.2MB

- quay.io/coreos/flannel v0.12.0-amd64 4e9f801d2217 2 years ago 52.8MB

- registry.cn-hangzhou.aliyuncs.com/google_containers/pause 3.2 80d28bedfe5d 2 years ago 683kB

- 然后一个一个改标签就行

- registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.19.1 k8s.gcr.io/kube-proxy:v1.19.1

- ....一个一个修改

改成下面这样的,flannel不用改

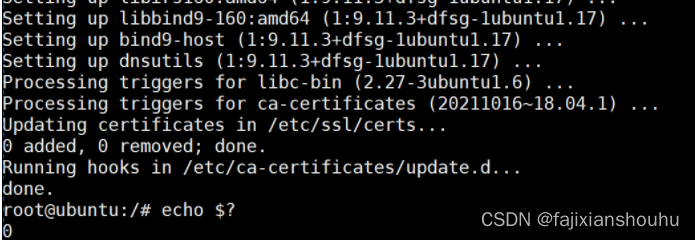

2、所有节点安装docker

- # yum install -y yum-utils device-mapper-persistent-data lvm2 git

- # yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo #记得关闭证书验证,两个

- # yum install docker-ce -y

3、禁用swap分区

所有节点都做

- # swapoff -a

- 注释掉swap分区:

- [root@k8s-master ~]# sed -i 's/.*swap.*/#&/' /etc/fstab

- # free -m

- total used free shared buff/cache available

- Mem: 3935 144 3415 8 375 3518

- Swap: 0 0 0

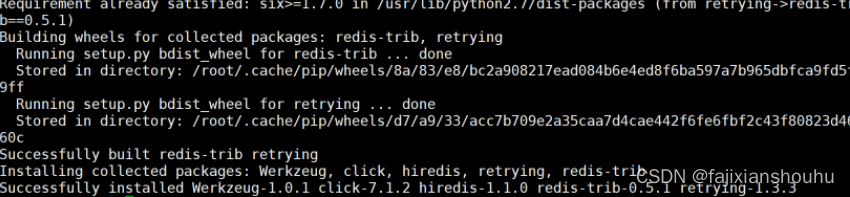

4、所有节点安装kubeadm和kubelet

- # cat <<EOF > /etc/yum.repos.d/kubernetes.repo

- [kubernetes]

- name=Kubernetes

- baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

- enabled=1

- gpgcheck=0

- repo_gpgcheck=0

- gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

- EOF

-

- # yum install -y kubelet-1.19.1-0.x86_64 kubeadm-1.19.1-0.x86_64 kubectl-1.19.1-0.x86_64 ipvsadm

-

- 加载ipvs相关内核模块

- # vim c.sh

- modprobe ip_vs

- modprobe ip_vs_rr

- modprobe ip_vs_wrr

- modprobe ip_vs_sh

- modprobe nf_conntrack_ipv4

- modprobe br_netfilter

- # bash c.sh

- 如果重新开机,需要重新加载(可以写在 /etc/rc.local 中开机自动加载)

- # vim /etc/rc.local

- modprobe ip_vs

- modprobe ip_vs_rr

- modprobe ip_vs_wrr

- modprobe ip_vs_sh

- modprobe nf_conntrack_ipv4

- modprobe br_netfilter

- # chmod +x /etc/rc.local

-

- 配置转发相关参数,否则可能会出错

- # cat <<EOF > /etc/sysctl.d/k8s.conf

- net.bridge.bridge-nf-call-ip6tables = 1

- net.bridge.bridge-nf-call-iptables = 1

- vm.swappiness=0

- EOF

- 使配置生效

- # sysctl --system

-

- 查看是否加载成功

- # lsmod | grep ip_vs

- ip_vs_sh 12688 0

- ip_vs_wrr 12697 0

- ip_vs_rr 12600 0

- ip_vs 141092 6 ip_vs_rr,ip_vs_sh,ip_vs_wrr

- nf_conntrack 133387 2 ip_vs,nf_conntrack_ipv4

- libcrc32c 12644 3 xfs,ip_vs,nf_conntrack

5、配置启动kubelet(所有节点)

- [root@k8s-master ~]# docker info |grep 'Cgroup Driver' | awk '{print $3}'

- WARNING: IPv4 forwarding is disabled

- cgroupfs #将这个cgroupfs写到等会的配置文件中

-

- 这个是使用国内的源。-###注意我们使用谷歌的镜像--操作下面的第3标题

- 2.配置kubelet的cgroups

- # cat >/etc/sysconfig/kubelet<<EOF

- KUBELET_EXTRA_ARGS="--cgroup-driver=cgroupfs --pod-infra-container-image=registry.cn-hangzhou.aliyuncs.com/google_containers/pause-amd64:3.2"

- EOF

-

- 3.配置kubelet的cgroups #我们用的是这个

- # cat >/etc/sysconfig/kubelet<<EOF

- KUBELET_EXTRA_ARGS="--cgroup-driver=cgroupfs --pod-infra-container-image=k8s.gcr.io/pause:3.2"

- EOF

-

- # cat >/etc/sysconfig/kubelet<<EOF

- KUBELET_EXTRA_ARGS="--cgroup-driver=cgroupfs --pod-infra-container-image=k8s.gcr.io/pause:3.2"

- EOF

启动

- # systemctl daemon-reload

- # systemctl enable kubelet && systemctl restart kubelet

- 在这里使用 # systemctl status kubelet,你会发现报错误信息;

-

- 10月 11 00:26:43 node1 systemd[1]: kubelet.service: main process exited, code=exited, status=255/n/a

- 10月 11 00:26:43 node1 systemd[1]: Unit kubelet.service entered failed state.

- 10月 11 00:26:43 node1 systemd[1]: kubelet.service failed.

-

- 运行 # journalctl -xefu kubelet 命令查看systemd日志才发现,真正的错误是:

- unable to load client CA file /etc/kubernetes/pki/ca.crt: open /etc/kubernetes/pki/ca.crt: no such file or directory

- #这个错误在运行kubeadm init 生成CA证书后会被自动解决,此处可先忽略。

- #简单地说就是在kubeadm init 之前kubelet会不断重启。说我们暂时忽略就行

6、配置master节点

- 运行初始化过程如下:

- 初始化之前,切记要关闭防火墙和selinux,cpu核心数至少为2

- [root@master ~]# kubeadm init --kubernetes-version=v1.19.1 --pod-network-cidr=10.244.0.0/16 --apiserver-advertise-address=10.0.0.130 --ignore-preflight-errors=Swap

- 注:

- –kubernetes-version: 用于指定k8s版本;

- –apiserver-advertise-address:用于指定kube-apiserver监听的ip地址,就是 master本机IP地址。

- –pod-network-cidr:用于指定Pod的网络范围; 10.244.0.0/16

- –service-cidr:用于指定SVC的网络范围;

- –image-repository: 指定阿里云镜像仓库地址

- 注意在检查一下swap分区是否关闭

看到以下信息说明初始化成功

- ......

-

- Your Kubernetes control-plane has initialized successfully!

-

- To start using your cluster, you need to run the following as a regular user:

-

- mkdir -p $HOME/.kube

- sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

- sudo chown $(id -u):$(id -g) $HOME/.kube/config

-

- You should now deploy a pod network to the cluster.

- Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

- https://kubernetes.io/docs/concepts/cluster-administration/addons/

-

- Then you can join any number of worker nodes by running the following on each as root:

-

- kubeadm join 10.0.0.130:6443 --token ymvzvj.5d3j0hbeq26wx9ff \

- --discovery-token-ca-cert-hash sha256:81086257eed9220e16c7ec407848b51adc1dba67cc4823dedde7396b830dbcc2 #需要记住

-

-

- 上面记录了完成的初始化输出的内容,根据输出的内容基本上可以看出手动初始化安装一个Kubernetes集群所需要的关键步骤。

- 其中有以下关键内容:

- [kubelet] 生成kubelet的配置文件”/var/lib/kubelet/config.yaml”

- [certificates]生成相关的各种证书

- [kubeconfig]生成相关的kubeconfig文件

- [bootstraptoken]生成token记录下来,后边使用kubeadm join往集群中添加节点时会用到

配置使用kubectl

以下操作在master节点操作

- [root@k8s-master ~]# mkdir -p $HOME/.kube

- [root@k8s-master ~]# cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

- [root@k8s-master ~]# chown $(id -u):$(id -g) $HOME/.kube/config

-

- 查看node节点

- [root@k8s-master ~]# kubectl get nodes

- NAME STATUS ROLES AGE VERSION

- k8s-master NotReady master 2m41s v1.19.1

7、所有node节点操作

- 配置node节点加入集群:

- 如果报错开启ip转发:

- # sysctl -w net.ipv4.ip_forward=1

-

- kubeadm join 10.0.0.130:6443 --token ymvzvj.5d3j0hbeq26wx9ff \

- --discovery-token-ca-cert-hash sha256:81086257eed9220e16c7ec407848b51adc1dba67cc4823dedde7396b830dbcc2 #就是刚才让记录的东西

-

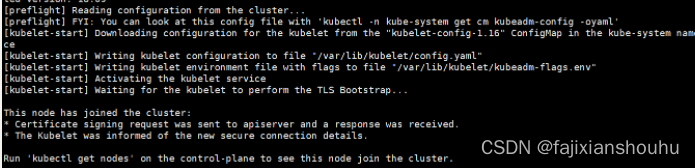

看到下面内容说明成功了,只要没有error,warnning不用管

8、配置使用网络插件

要让 Kubernetes Cluster 能够工作,必须安装 Pod 网络,否则 Pod 之间无法通信。

Kubernetes 支持多种网络方案,这里我们先使用 flannel,后面还会讨论 Canal。

- 在master节点操作

- # cd ~ && mkdir flannel && cd flannel

- # curl -O https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

这个是国外的网址,所以99%失败,下面是我在网上上找到的文件

- vim kube-flannel.yml

- ---

- apiVersion: policy/v1beta1

- kind: PodSecurityPolicy

- metadata:

- name: psp.flannel.unprivileged

- annotations:

- seccomp.security.alpha.kubernetes.io/allowedProfileNames: docker/default

- seccomp.security.alpha.kubernetes.io/defaultProfileName: docker/default

- apparmor.security.beta.kubernetes.io/allowedProfileNames: runtime/default

- apparmor.security.beta.kubernetes.io/defaultProfileName: runtime/default

- spec:

- privileged: false

- volumes:

- - configMap

- - secret

- - emptyDir

- - hostPath

- allowedHostPaths:

- - pathPrefix: "/etc/cni/net.d"

- - pathPrefix: "/etc/kube-flannel"

- - pathPrefix: "/run/flannel"

- readOnlyRootFilesystem: false

- # Users and groups

- runAsUser:

- rule: RunAsAny

- supplementalGroups:

- rule: RunAsAny

- fsGroup:

- rule: RunAsAny

- # Privilege Escalation

- allowPrivilegeEscalation: false

- defaultAllowPrivilegeEscalation: false

- # Capabilities

- allowedCapabilities: ['NET_ADMIN']

- defaultAddCapabilities: []

- requiredDropCapabilities: []

- # Host namespaces

- hostPID: false

- hostIPC: false

- hostNetwork: true

- hostPorts:

- - min: 0

- max: 65535

- # SELinux

- seLinux:

- # SELinux is unused in CaaSP

- rule: 'RunAsAny'

- ---

- kind: ClusterRole

- apiVersion: rbac.authorization.k8s.io/v1beta1

- metadata:

- name: flannel

- rules:

- - apiGroups: ['extensions']

- resources: ['podsecuritypolicies']

- verbs: ['use']

- resourceNames: ['psp.flannel.unprivileged']

- - apiGroups:

- - ""

- resources:

- - pods

- verbs:

- - get

- - apiGroups:

- - ""

- resources:

- - nodes

- verbs:

- - list

- - watch

- - apiGroups:

- - ""

- resources:

- - nodes/status

- verbs:

- - patch

- ---

- kind: ClusterRoleBinding

- apiVersion: rbac.authorization.k8s.io/v1beta1

- metadata:

- name: flannel

- roleRef:

- apiGroup: rbac.authorization.k8s.io

- kind: ClusterRole

- name: flannel

- subjects:

- - kind: ServiceAccount

- name: flannel

- namespace: kube-system

- ---

- apiVersion: v1

- kind: ServiceAccount

- metadata:

- name: flannel

- namespace: kube-system

- ---

- kind: ConfigMap

- apiVersion: v1

- metadata:

- name: kube-flannel-cfg

- namespace: kube-system

- labels:

- tier: node

- app: flannel

- data:

- cni-conf.json: |

- {

- "name": "cbr0",

- "cniVersion": "0.3.1",

- "plugins": [

- {

- "type": "flannel",

- "delegate": {

- "hairpinMode": true,

- "isDefaultGateway": true

- }

- },

- {

- "type": "portmap",

- "capabilities": {

- "portMappings": true

- }

- }

- ]

- }

- net-conf.json: |

- {

- "Network": "10.244.0.0/16",

- "Backend": {

- "Type": "vxlan"

- }

- }

- ---

- apiVersion: apps/v1

- kind: DaemonSet

- metadata:

- name: kube-flannel-ds-amd64

- namespace: kube-system

- labels:

- tier: node

- app: flannel

- spec:

- selector:

- matchLabels:

- app: flannel

- template:

- metadata:

- labels:

- tier: node

- app: flannel

- spec:

- affinity:

- nodeAffinity:

- requiredDuringSchedulingIgnoredDuringExecution:

- nodeSelectorTerms:

- - matchExpressions:

- - key: beta.kubernetes.io/os

- operator: In

- values:

- - linux

- - key: beta.kubernetes.io/arch

- operator: In

- values:

- - amd64

- hostNetwork: true

- tolerations:

- - operator: Exists

- effect: NoSchedule

- serviceAccountName: flannel

- initContainers:

- - name: install-cni

- image: quay.io/coreos/flannel:v0.12.0-amd64

- command:

- - cp

- args:

- - -f

- - /etc/kube-flannel/cni-conf.json

- - /etc/cni/net.d/10-flannel.conflist

- volumeMounts:

- - name: cni

- mountPath: /etc/cni/net.d

- - name: flannel-cfg

- mountPath: /etc/kube-flannel/

- containers:

- - name: kube-flannel

- image: quay.io/coreos/flannel:v0.12.0-amd64

- command:

- - /opt/bin/flanneld

- args:

- - --ip-masq

- - --kube-subnet-mgr

- - --iface=ens33

- resources:

- requests:

- cpu: "100m"

- memory: "50Mi"

- limits:

- cpu: "100m"

- memory: "50Mi"

- securityContext:

- privileged: false

- capabilities:

- add: ["NET_ADMIN"]

- env:

- - name: POD_NAME

- valueFrom:

- fieldRef:

- fieldPath: metadata.name

- - name: POD_NAMESPACE

- valueFrom:

- fieldRef:

- fieldPath: metadata.namespace

- volumeMounts:

- - name: run

- mountPath: /run/flannel

- - name: flannel-cfg

- mountPath: /etc/kube-flannel/

- volumes:

- - name: run

- hostPath:

- path: /run/flannel

- - name: cni

- hostPath:

- path: /etc/cni/net.d

- - name: flannel-cfg

- configMap:

- name: kube-flannel-cfg

- ---

- apiVersion: apps/v1

- kind: DaemonSet

- metadata:

- name: kube-flannel-ds-arm64

- namespace: kube-system

- labels:

- tier: node

- app: flannel

- spec:

- selector:

- matchLabels:

- app: flannel

- template:

- metadata:

- labels:

- tier: node

- app: flannel

- spec:

- affinity:

- nodeAffinity:

- requiredDuringSchedulingIgnoredDuringExecution:

- nodeSelectorTerms:

- - matchExpressions:

- - key: beta.kubernetes.io/os

- operator: In

- values:

- - linux

- - key: beta.kubernetes.io/arch

- operator: In

- values:

- - arm64

- hostNetwork: true

- tolerations:

- - operator: Exists

- effect: NoSchedule

- - key: node.kubernetes.io/not-ready

- operator: Exists

- effect: NoSchedule

- serviceAccountName: flannel

- initContainers:

- - name: install-cni

- image: quay.io/coreos/flannel:v0.12.0-arm64

- command:

- - cp

- args:

- - -f

- - /etc/kube-flannel/cni-conf.json

- - /etc/cni/net.d/10-flannel.conflist

- volumeMounts:

- - name: cni

- mountPath: /etc/cni/net.d

- - name: flannel-cfg

- mountPath: /etc/kube-flannel/

- containers:

- - name: kube-flannel

- image: quay.io/coreos/flannel:v0.12.0-arm64

- command:

- - /opt/bin/flanneld

- args:

- - --ip-masq

- - --kube-subnet-mgr

- resources:

- requests:

- cpu: "100m"

- memory: "50Mi"

- limits:

- cpu: "100m"

- memory: "50Mi"

- securityContext:

- privileged: false

- capabilities:

- add: ["NET_ADMIN"]

- env:

- - name: POD_NAME

- valueFrom:

- fieldRef:

- fieldPath: metadata.name

- - name: POD_NAMESPACE

- valueFrom:

- fieldRef:

- fieldPath: metadata.namespace

- volumeMounts:

- - name: run

- mountPath: /run/flannel

- - name: flannel-cfg

- mountPath: /etc/kube-flannel/

- volumes:

- - name: run

- hostPath:

- path: /run/flannel

- - name: cni

- hostPath:

- path: /etc/cni/net.d

- - name: flannel-cfg

- configMap:

- name: kube-flannel-cfg

- ---

- apiVersion: apps/v1

- kind: DaemonSet

- metadata:

- name: kube-flannel-ds-arm

- namespace: kube-system

- labels:

- tier: node

- app: flannel

- spec:

- selector:

- matchLabels:

- app: flannel

- template:

- metadata:

- labels:

- tier: node

- app: flannel

- spec:

- affinity:

- nodeAffinity:

- requiredDuringSchedulingIgnoredDuringExecution:

- nodeSelectorTerms:

- - matchExpressions:

- - key: beta.kubernetes.io/os

- operator: In

- values:

- - linux

- - key: beta.kubernetes.io/arch

- operator: In

- values:

- - arm

- hostNetwork: true

- tolerations:

- - operator: Exists

- effect: NoSchedule

- serviceAccountName: flannel

- initContainers:

- - name: install-cni

- image: quay.io/coreos/flannel:v0.12.0-arm

- command:

- - cp

- args:

- - -f

- - /etc/kube-flannel/cni-conf.json

- - /etc/cni/net.d/10-flannel.conflist

- volumeMounts:

- - name: cni

- mountPath: /etc/cni/net.d

- - name: flannel-cfg

- mountPath: /etc/kube-flannel/

- containers:

- - name: kube-flannel

- image: quay.io/coreos/flannel:v0.12.0-arm

- command:

- - /opt/bin/flanneld

- args:

- - --ip-masq

- - --kube-subnet-mgr

- resources:

- requests:

- cpu: "100m"

- memory: "50Mi"

- limits:

- cpu: "100m"

- memory: "50Mi"

- securityContext:

- privileged: false

- capabilities:

- add: ["NET_ADMIN"]

- env:

- - name: POD_NAME

- valueFrom:

- fieldRef:

- fieldPath: metadata.name

- - name: POD_NAMESPACE

- valueFrom:

- fieldRef:

- fieldPath: metadata.namespace

- volumeMounts:

- - name: run

- mountPath: /run/flannel

- - name: flannel-cfg

- mountPath: /etc/kube-flannel/

- volumes:

- - name: run

- hostPath:

- path: /run/flannel

- - name: cni

- hostPath:

- path: /etc/cni/net.d

- - name: flannel-cfg

- configMap:

- name: kube-flannel-cfg

- ---

- apiVersion: apps/v1

- kind: DaemonSet

- metadata:

- name: kube-flannel-ds-ppc64le

- namespace: kube-system

- labels:

- tier: node

- app: flannel

- spec:

- selector:

- matchLabels:

- app: flannel

- template:

- metadata:

- labels:

- tier: node

- app: flannel

- spec:

- affinity:

- nodeAffinity:

- requiredDuringSchedulingIgnoredDuringExecution:

- nodeSelectorTerms:

- - matchExpressions:

- - key: beta.kubernetes.io/os

- operator: In

- values:

- - linux

- - key: beta.kubernetes.io/arch

- operator: In

- values:

- - ppc64le

- hostNetwork: true

- tolerations:

- - operator: Exists

- effect: NoSchedule

- serviceAccountName: flannel

- initContainers:

- - name: install-cni

- image: quay.io/coreos/flannel:v0.12.0-ppc64le

- command:

- - cp

- args:

- - -f

- - /etc/kube-flannel/cni-conf.json

- - /etc/cni/net.d/10-flannel.conflist

- volumeMounts:

- - name: cni

- mountPath: /etc/cni/net.d

- - name: flannel-cfg

- mountPath: /etc/kube-flannel/

- containers:

- - name: kube-flannel

- image: quay.io/coreos/flannel:v0.12.0-ppc64le

- command:

- - /opt/bin/flanneld

- args:

- - --ip-masq

- - --kube-subnet-mgr

- resources:

- requests:

- cpu: "100m"

- memory: "50Mi"

- limits:

- cpu: "100m"

- memory: "50Mi"

- securityContext:

- privileged: false

- capabilities:

- add: ["NET_ADMIN"]

- env:

- - name: POD_NAME

- valueFrom:

- fieldRef:

- fieldPath: metadata.name

- - name: POD_NAMESPACE

- valueFrom:

- fieldRef:

- fieldPath: metadata.namespace

- volumeMounts:

- - name: run

- mountPath: /run/flannel

- - name: flannel-cfg

- mountPath: /etc/kube-flannel/

- volumes:

- - name: run

- hostPath:

- path: /run/flannel

- - name: cni

- hostPath:

- path: /etc/cni/net.d

- - name: flannel-cfg

- configMap:

- name: kube-flannel-cfg

- ---

- apiVersion: apps/v1

- kind: DaemonSet

- metadata:

- name: kube-flannel-ds-s390x

- namespace: kube-system

- labels:

- tier: node

- app: flannel

- spec:

- selector:

- matchLabels:

- app: flannel

- template:

- metadata:

- labels:

- tier: node

- app: flannel

- spec:

- affinity:

- nodeAffinity:

- requiredDuringSchedulingIgnoredDuringExecution:

- nodeSelectorTerms:

- - matchExpressions:

- - key: beta.kubernetes.io/os

- operator: In

- values:

- - linux

- - key: beta.kubernetes.io/arch

- operator: In

- values:

- - s390x

- hostNetwork: true

- tolerations:

- - operator: Exists

- effect: NoSchedule

- serviceAccountName: flannel

- initContainers:

- - name: install-cni

- image: quay.io/coreos/flannel:v0.12.0-s390x

- command:

- - cp

- args:

- - -f

- - /etc/kube-flannel/cni-conf.json

- - /etc/cni/net.d/10-flannel.conflist

- volumeMounts:

- - name: cni

- mountPath: /etc/cni/net.d

- - name: flannel-cfg

- mountPath: /etc/kube-flannel/

- containers:

- - name: kube-flannel

- image: quay.io/coreos/flannel:v0.12.0-s390x

- command:

- - /opt/bin/flanneld

- args:

- - --ip-masq

- - --kube-subnet-mgr

- resources:

- requests:

- cpu: "100m"

- memory: "50Mi"

- limits:

- cpu: "100m"

- memory: "50Mi"

- securityContext:

- privileged: false

- capabilities:

- add: ["NET_ADMIN"]

- env:

- - name: POD_NAME

- valueFrom:

- fieldRef:

- fieldPath: metadata.name

- - name: POD_NAMESPACE

- valueFrom:

- fieldRef:

- fieldPath: metadata.namespace

- volumeMounts:

- - name: run

- mountPath: /run/flannel

- - name: flannel-cfg

- mountPath: /etc/kube-flannel/

- volumes:

- - name: run

- hostPath:

- path: /run/flannel

- - name: cni

- hostPath:

- path: /etc/cni/net.d

- - name: flannel-cfg

- configMap:

- name: kube-flannel-cfg

上面的这个镜像,是解决网络问题的flannel镜像,每个节点都要拉取,刚开始的时候我们已经拉取过了

启动flannel

- 启动:

- # kubectl apply -f ~/flannel/kube-flannel.yml #启动完成之后需要等待一会

- NAME READY STATUS RESTARTS AGE

- coredns-5644d7b6d9-sm8hs 1/1 Running 0 9m18s

- coredns-5644d7b6d9-vddll 1/1 Running 0 9m18s

- etcd-kub-k8s-master 1/1 Running 0 8m14s

- kube-apiserver-kub-k8s-master 1/1 Running 0 8m17s

- kube-controller-manager-kub-k8s-master 1/1 Running 0 8m20s

- kube-flannel-ds-amd64-9wgd8 1/1 Running 0 8m42s

- kube-proxy-sgphs 1/1 Running 0 9m18s

- kube-scheduler-kub-k8s-master 1/1 Running 0 8m10s

-

- 查看:

- # kubectl get pods -n kube-system

- # kubectl get service

- # kubectl get svc --namespace kube-system

- 只有网络插件也安装配置完成之后,才能会显示为ready状态

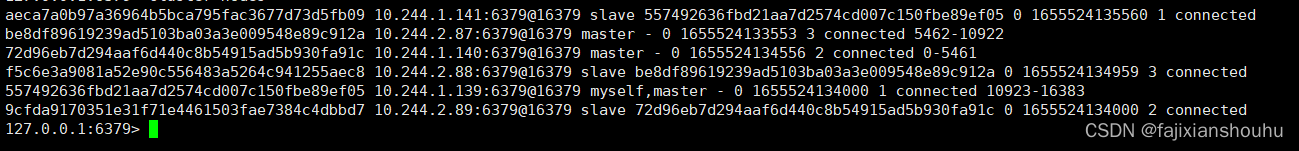

在master操作

- 各种检测:

- 1.查看pods:

- [root@k8s-master ~]# kubectl get pods -n kube-system

- NAME READY STATUS RESTARTS AGE

- coredns-5644d7b6d9-sm8hs 1/1 Running 0 39m

- coredns-5644d7b6d9-vddll 1/1 Running 0 39m

- etcd-kub-k8s-master 1/1 Running 0 37m

- kube-apiserver-kub-k8s-master 1/1 Running 0 38m

- kube-controller-manager-kub-k8s-master 1/1 Running 0 38m

- kube-flannel-ds-amd64-9wgd8 1/1 Running 0 38m

- kube-flannel-ds-amd64-lffc8 1/1 Running 0 2m11s

- kube-flannel-ds-amd64-m8kk2 1/1 Running 0 2m2s

- kube-proxy-dwq9l 1/1 Running 0 2m2s

- kube-proxy-l77lz 1/1 Running 0 2m11s

- kube-proxy-sgphs 1/1 Running 0 39m

- kube-scheduler-kub-k8s-master 1/1 Running 0 37m

-

- 2.查看异常pod信息:

- [root@k8s-master ~]# kubectl describe pods kube-flannel-ds-sr6tq -n kube-system

- Name: kube-flannel-ds-sr6tq

- Namespace: kube-system

- Priority: 0

- PriorityClassName: <none>

- 。。。。。

- Events:

- Type Reason Age From Message

- ---- ------ ---- ---- -------

- Normal Pulling 12m kubelet, node2 pulling image "registry.cn-shanghai.aliyuncs.com/gcr-k8s/flannel:v0.10.0-amd64"

- Normal Pulled 11m kubelet, node2 Successfully pulled image "registry.cn-shanghai.aliyuncs.com/gcr-k8s/flannel:v0.10.0-amd64"

- Normal Created 11m kubelet, node2 Created container

- Normal Started 11m kubelet, node2 Started container

- Normal Created 11m (x4 over 11m) kubelet, node2 Created container

- Normal Started 11m (x4 over 11m) kubelet, node2 Started container

- Normal Pulled 10m (x5 over 11m) kubelet, node2 Container image "registry.cn-shanghai.aliyuncs.com/gcr-k8s/flannel:v0.10.0-amd64" already present on machine

- Normal Scheduled 7m15s default-scheduler Successfully assigned kube-system/kube-flannel-ds-sr6tq to node2

- Warning BackOff 7m6s (x23 over 11m) kubelet, node2 Back-off restarting failed container

-

- 3.遇到这种情况直接 删除异常pod:

- [root@k8s-master ~]# kubectl delete pod kube-flannel-ds-sr6tq -n kube-system

- pod "kube-flannel-ds-sr6tq" deleted

-

- 4.查看pods:

- [root@k8s-master ~]# kubectl get pods -n kube-system

- NAME READY STATUS RESTARTS AGE

- coredns-5644d7b6d9-sm8hs 1/1 Running 0 44m

- coredns-5644d7b6d9-vddll 1/1 Running 0 44m

- etcd-kub-k8s-master 1/1 Running 0 42m

- kube-apiserver-kub-k8s-master 1/1 Running 0 43m

- kube-controller-manager-kub-k8s-master 1/1 Running 0 43m

- kube-flannel-ds-amd64-9wgd8 1/1 Running 0 43m

- kube-flannel-ds-amd64-lffc8 1/1 Running 0 7m10s

- kube-flannel-ds-amd64-m8kk2 1/1 Running 0 7m1s

- kube-proxy-dwq9l 1/1 Running 0 7m1s

- kube-proxy-l77lz 1/1 Running 0 7m10s

- kube-proxy-sgphs 1/1 Running 0 44m

- kube-scheduler-kub-k8s-master 1/1 Running 0 42m

-

- 5.查看节点:

- [root@k8s-master ~]# kubectl get nodes

- NAME STATUS ROLES AGE VERSION

- kub-k8s-master Ready master 43m v1.19.1

- kub-k8s-node1 Ready <none> 6m46s v1.19.1

- kub-k8s-node2 Ready <none> 6m37s v1.19.1

- 到此集群配置完成

错误整理

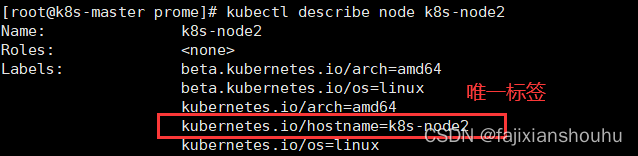

1、移除node节点的方法

[root@k8s-master ~]# kubectl drain k8s-node2 --delete-local-data --force --ignore-daemonsets

- [root@k8s-master ~]# kubectl delete nodes k8s-node2

- node "k8s-node2" deleted

- [root@k8s-master ~]# kubectl get nodes

- NAME STATUS ROLES AGE VERSION

- k8s-master Ready master 11m v1.19.1

- k8s-node1 Ready <none> 7m39s v1.19.1 #node2节点已经移除

2、添加已删除节点

前提:token未失效

- 因为之前的token还有效,我这里并没有超出token的有效期;直接执行加入集群的命令即可;

- [root@k8s-node2 ~]# kubeadm join 10.0.0.132:6443 --token jvjxs2.xu92rq4fetgtpy1o --discovery-token-ca-cert-hash sha256:56159a0de43781fd57f1df829de4fe906cf355f4fec8ff7f6f9078c77c8c292d

如果这个时候再想添加进来这个node,需要执行两步操作

第一步:停掉kubelet(需要添加进来的节点操作)

[root@k8s-node2 ~]# systemctl stop kubelet

第二步:删除相关文件

[root@k8s-node2 ~]# rm -rf /etc/kubernetes/*

第三步:添加节点

- 因为之前的token还有效,我这里并没有超出token的有效期;直接执行加入集群的命令即可;

- [root@k8s-node2 ~]# kubeadm join 10.0.0.132:6443 --token jvjxs2.xu92rq4fetgtpy1o --discovery-token-ca-cert-hash sha256:56159a0de43781fd57f1df829de4fe906cf355f4fec8ff7f6f9078c77c8c292d

第四步:验证查看,看一下是否有k8s-node2

kubectl get nodes3、忘掉token再次添加进k8s集群

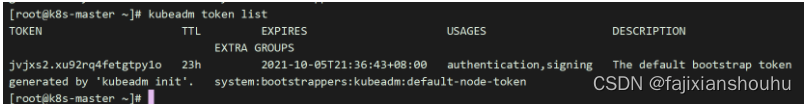

前提:token未失效

第一步:主节点执行命令

在主控节点,获取token:

第二步: 获取ca证书sha256编码hash值

- [root@k8s-master ~]# openssl x509 -pubkey -in /etc/kubernetes/pki/ca.crt | openssl rsa -pubin -outform der 2>/dev/null | openssl dgst -sha256 -hex | sed 's/^.* //'

- 56159a0de43781fd57f1df829de4fe906cf355f4fec8ff7f6f9078c77c8c292d

第三步:主节点移除node2

- [root@k8s-master ~]# kubectl drain k8s-node2 --delete-local-data --force --ignore-daemonsets

- [root@k8s-master ~]# kubectl delete nodes k8s-node2

- [root@k8s-master ~]# kubectl get node

第四步:从节点执行如下的命令

- [root@k8s-node2 ~]# systemctl stop kubelet

- [root@k8s-node2 ~]# rm -rf /etc/kubernetes/*

第五步:加入集群

指定主节点IP,端口是6443

在生成的证书前有sha256:

[root@k8s-node2 ~]# kubeadm join 10.0.0.132:6443 --token jvjxs2.xu92rq4fetgtpy1o --discovery-token-ca-cert-hash sha256:56159a0de43781fd57f1df829de4fe906cf355f4fec8ff7f6f9078c77c8c292d

第六步:主节点查看验证4、加载flannel失败

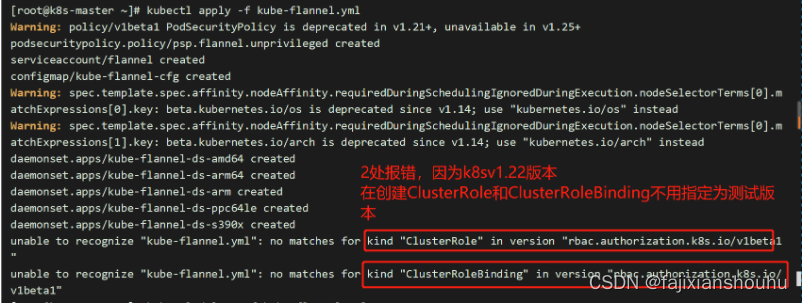

[root@k8s-master flannel]# kubectl apply -f kube-flannel.yml

4、加载flannel失败

[root@k8s-master flannel]# kubectl apply -f kube-flannel.yml

报错:

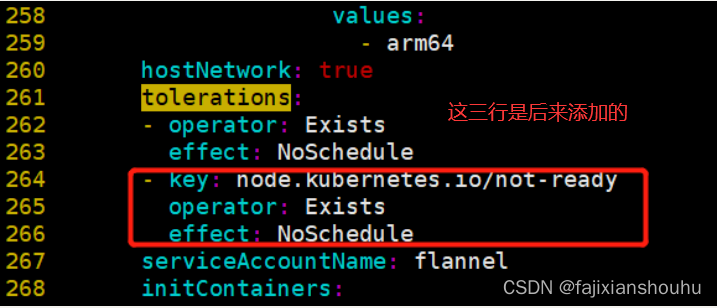

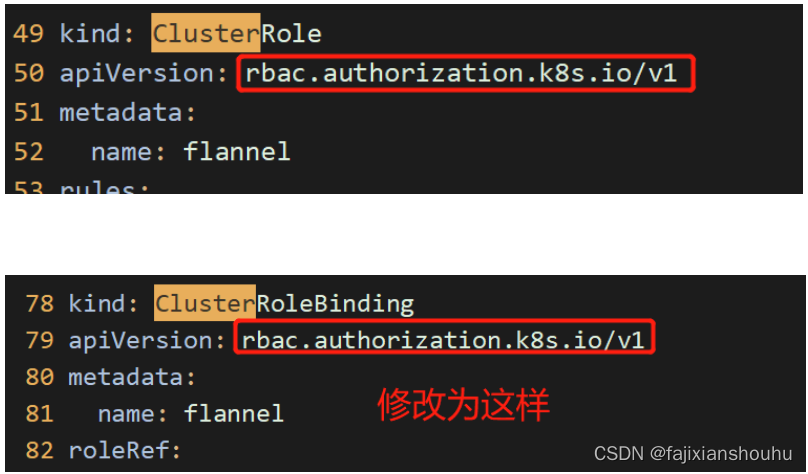

解决方法:

- [root@k8s-master flannel]# kubectl delete -f kube-flannel.yml

- [root@k8s-master flannel]# vim kube-flannel.yml #进行版本的修改

- 重新创建即可

- [root@k8s-master flannel]# kubectl apply -f kube-flannel.yml

- 查看文件中,指定的api对象,是否都创建成功

- [root@k8s-master flannel]# kubectl get pod -n kube-system

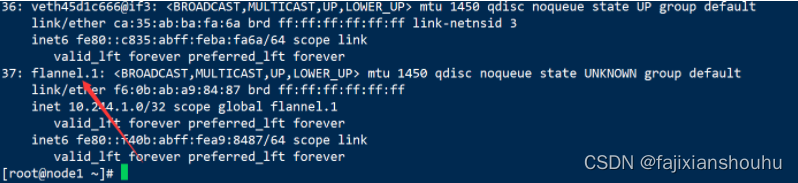

5、部署flannel网络后pod及容器无法跨主机互通问题

- 方法一:重启docker,

- 方法二:卸载flannel网络

方法二:

在master卸载flannel

kubectl delete -f kube-flannel.yml

在node节点清理flannel网络残留文件

- ifconfig cni0 down

- ip link delete cni0

- ifconfig flannel.1 down

- ip link delete flannel.1

- rm -rf /var/lib/cni/

- rm -f /etc/cni/net.d/*

重新部署flannel网络

- [root@k8s-master01 flannel]# kubectl create -f kube-flannel.yml

-

- [root@k8s-master01 flannel]# kubectl get pod -n kube-system

- NAME READY STATUS RESTARTS AGE

- coredns-5c98db65d4-8bpdd 1/1 Running 0 17s

- coredns-5c98db65d4-knfcj 1/1 Running 0 43s

- etcd-k8s-master01 1/1 Running 2 10d

- kube-apiserver-k8s-master01 1/1 Running 2 10d

- kube-controller-manager-k8s-master01 1/1 Running 3 10d

- kube-flannel-ds-amd64-56hsf 1/1 Running 0 25m

- kube-flannel-ds-amd64-56t49 1/1 Running 0 25m

- kube-flannel-ds-amd64-qz42z 1/1 Running 0 25m

- kube-proxy-5fn9m 1/1 Running 1 10d

- kube-proxy-6hjvp 1/1 Running 2 10d

- kube-proxy-t47n9 1/1 Running 2 10d

- kube-scheduler-k8s-master01 1/1 Running 4 10d

- kubernetes-dashboard-7d75c474bb-4r7hc 1/1 Running 0 23m

- [root@k8s-master01 flannel]#

flannel网络显示正常, 容器之间可以跨主机互通!

其他错误

- 错误

- 问题1:服务器时间不一致会报错

- 查看服务器时间

- =====================================

- 问题2:kubeadm init不成功,发现如下提示,然后超时报错

- [wait-control-plane] Waiting for the kubelet to boot up the control plane as static Pods from directory "/etc/kubernetes/manifests". This can take up to 4m0s

-

- 查看kubelet状态发现如下错误,主机master找不到和镜像下载失败,发现pause镜像是从aliyuncs下载的,其实我已经下载好了官方的pause镜像,按着提示的镜像名称重新给pause镜像打个ali的tag,最后重置kubeadm的环境重新初始化,错误解决

- [root@master manifests]# systemctl status kubelet -l

- ● kubelet.service - kubelet: The Kubernetes Node Agent

- Loaded: loaded (/etc/systemd/system/kubelet.service; enabled; vendor preset: disabled)

- Drop-In: /etc/systemd/system/kubelet.service.d

- └─10-kubeadm.conf

- Active: active (running) since 四 2019-01-31 15:20:32 CST; 5min ago

- Docs: https://kubernetes.io/docs/

- Main PID: 23908 (kubelet)

- Tasks: 19

- Memory: 30.8M

- CGroup: /system.slice/kubelet.service

- └─23908 /usr/bin/kubelet --bootstrap-kubeconfig=/etc/kubernetes/bootstrap-kubelet.conf --kubeconfig=/etc/kubernetes/kubelet.conf --config=/var/lib/kubelet/config.yaml --cgroup-driver=cgroupfs --network-plugin=cni --pod-infra-container-image=k8s.gcr.io/pause:3.1 --cgroup-driver=cgroupfs --pod-infra-container-image=registry.cn-hangzhou.aliyuncs.com/google_containers/pause-amd64:3.1

-

- 1月 31 15:25:41 master kubelet[23908]: E0131 15:25:41.432357 23908 kubelet.go:2266] node "master" not found

- 1月 31 15:25:41 master kubelet[23908]: E0131 15:25:41.532928 23908 kubelet.go:2266] node "master" not found

- 1月 31 15:25:41 master kubelet[23908]: E0131 15:25:41.633192 23908 kubelet.go:2266] node "master" not found

- 1月 31 15:25:41 master kubelet[23908]: I0131 15:25:41.729296 23908 kubelet_node_status.go:278] Setting node annotation to enable volume controller attach/detach

- 1月 31 15:25:41 master kubelet[23908]: E0131 15:25:41.733396 23908 kubelet.go:2266] node "master" not found

- 1月 31 15:25:41 master kubelet[23908]: E0131 15:25:41.740110 23908 remote_runtime.go:96] RunPodSandbox from runtime service failed: rpc error: code = Unknown desc = failed pulling image "registry.cn-hangzhou.aliyuncs.com/google_containers/pause-amd64:3.1": Error response from daemon: Get https://registry.cn-hangzhou.aliyuncs.com/v2/: dial tcp 0.0.0.80:443: connect: invalid argument

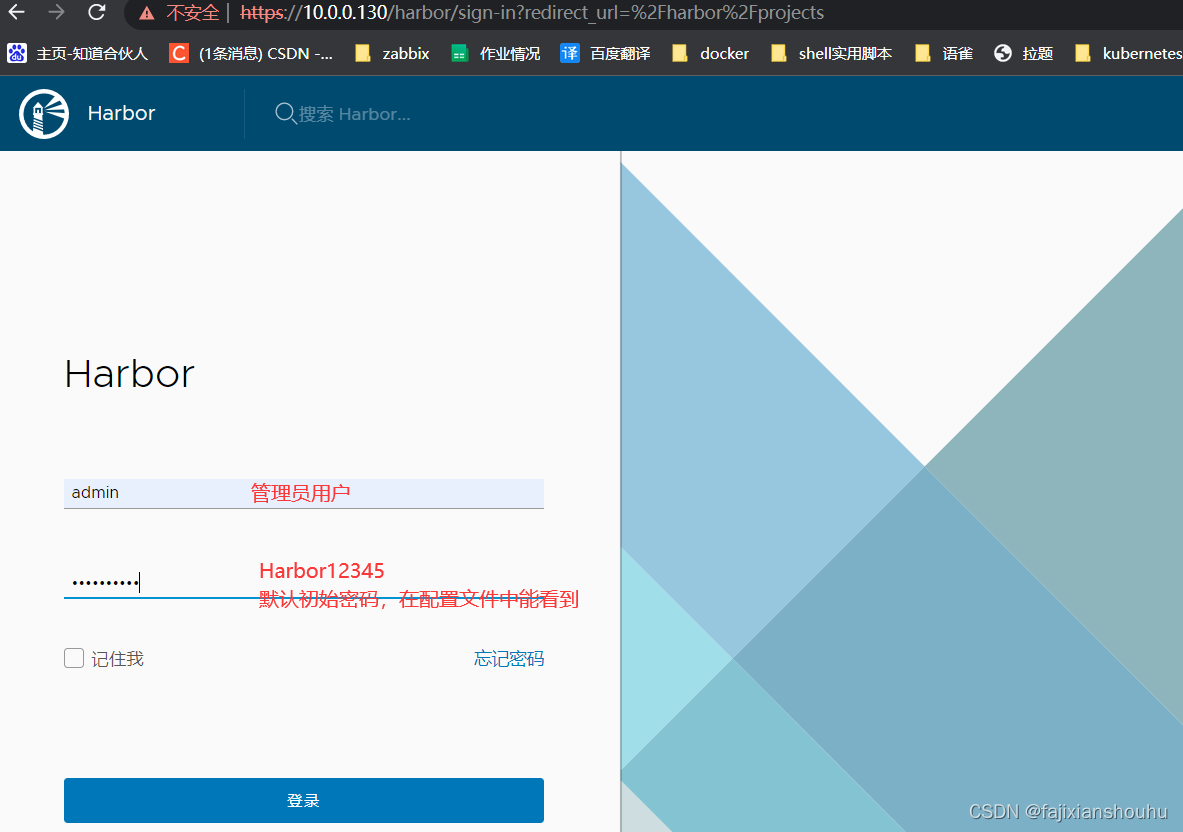

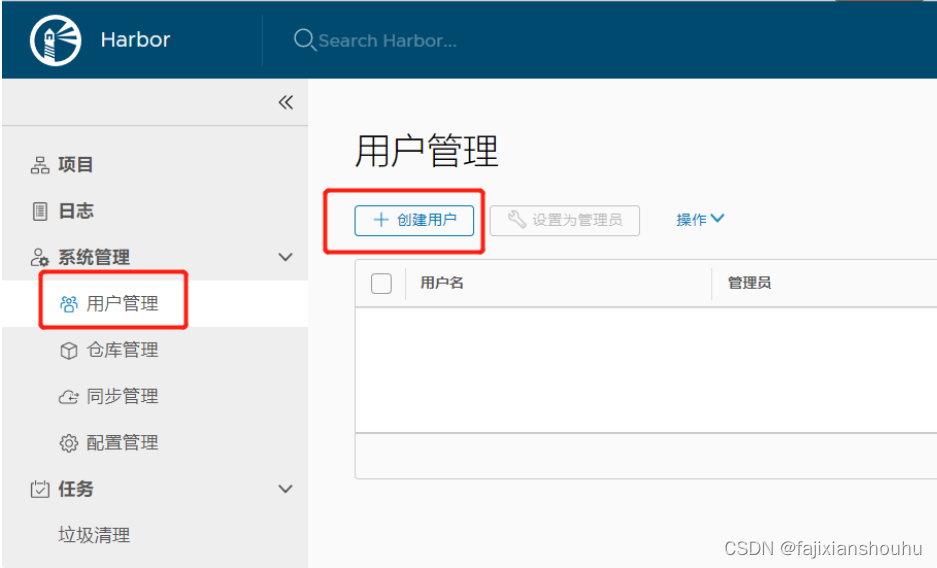

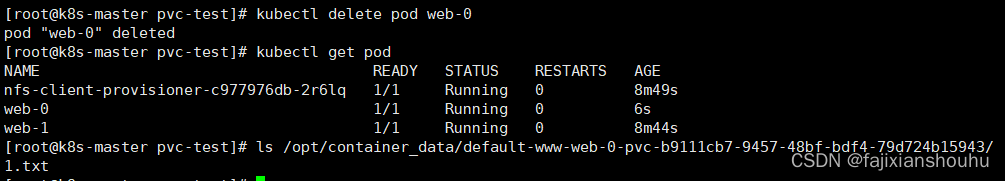

- 1月 31 15:25:41 master kubelet[23908]: E0131 15:25:41.740153 23908 kuberuntime_sandbox.go:68] CreatePodSandbox for pod "kube-controller-manager-master_kube-system(e8f43404e60ae844e375d50b1e39d91e)" failed: rpc error: code = Unknown desc = failed pulling image "registry.cn-hangzhou.aliyuncs.com/google_containers/pause-amd64:3.1": Error response from daemon: Get https://registry.cn-hangzhou.aliyuncs.com/v2/: dial tcp 0.0.0.80:443: connect: invalid argument