- 1使用Java定时从Nginx的日志中获取黑客的ip并加入访问黑名单_mstshash=administr

- 2Python时间模块之calendar模块_python calendar模块

- 3(3)LoraWAN:链路控制、SF BW CR

- 4docker + ambari(hortonworks ) 快速搭建hadoop 环境_hortorwork ambari docker 镜像

- 5CentOS下Ambari release-2.7 源码编译详解_ambari 2.7.7 ant工具

- 6简单HTML标记_html最简单的标记

- 7SpringBoot 电子书_深入浅出springboot2 pdf下载

- 8(java毕业设计源码)基于java(springboot)桂林旅游景点导游平台_设计实现基于javaspring架构的景区旅游服务平台

- 9AI之路_关于ai的观点 管理学家

- 10利用python sklearn 库实现LDA主题建模_机器学习lda模型的实战需要导入什么数据

Ollama本地部署大模型_webui could not connect to ollama

赞

踩

Ollama本地部署

1. 什么是Ollama

Ollama 是一个开源的大型语言模型运行框架,能够在方便的本地部署运行大模型。可以将其类比为 Docker ,运行在 Ollama 中的大模型类比为运行在 Docker 中的容器。

2. Ollama安装

2.1 下载安装

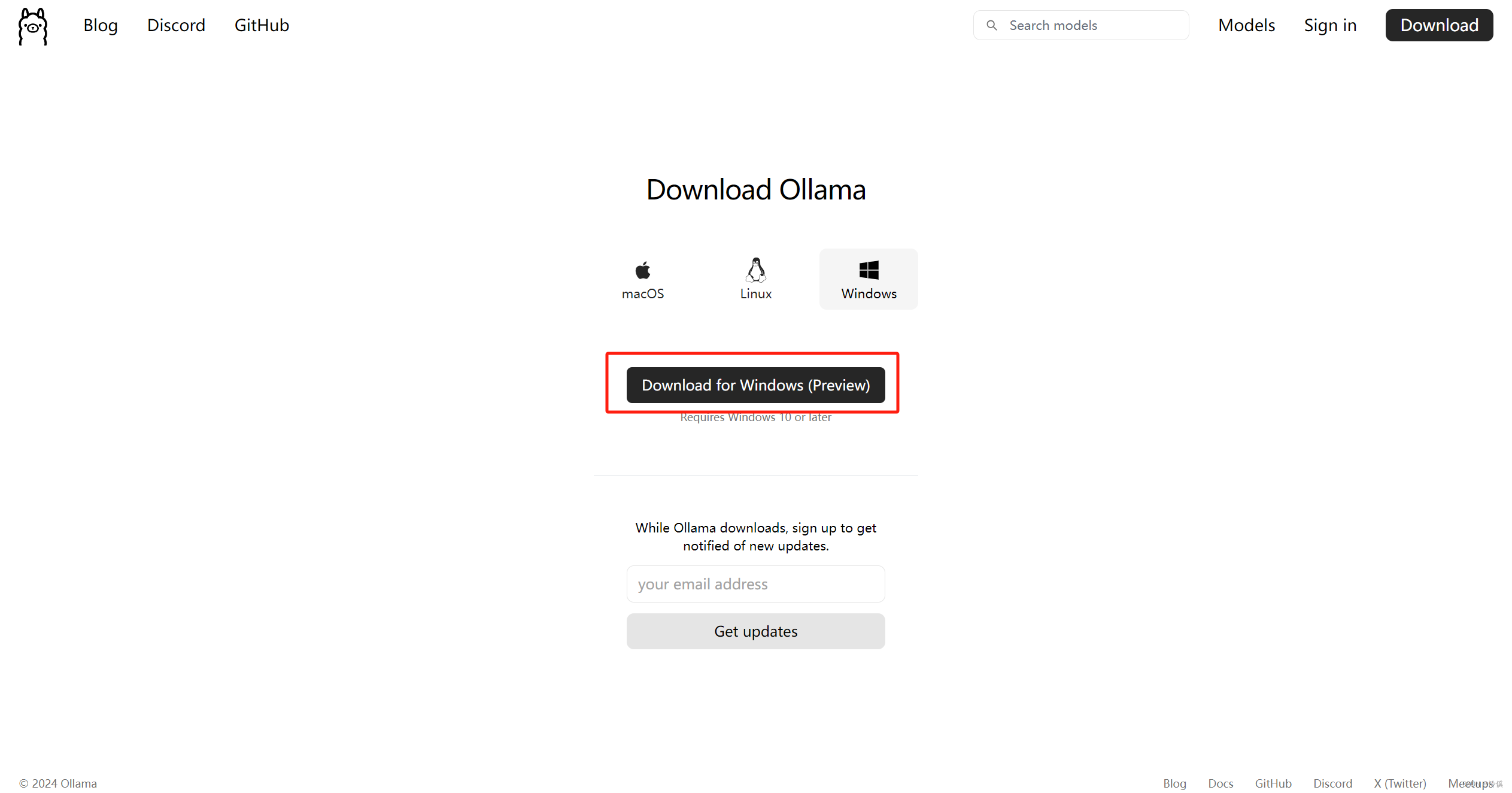

Ollama 官方支持 Windows 、Linux、 Mac 下的部署。

打开下载连接,根据情况选择部署方式,以 Windows 为例,

安装方式很简单,直接双击运行 OllamaSetup.exe 文件,完成安装即可。

可以修改系统环境变量更改模型下载位置:OLLAMA_MODELS=D:\Ollama(自定义下载位置)

2.2 运行

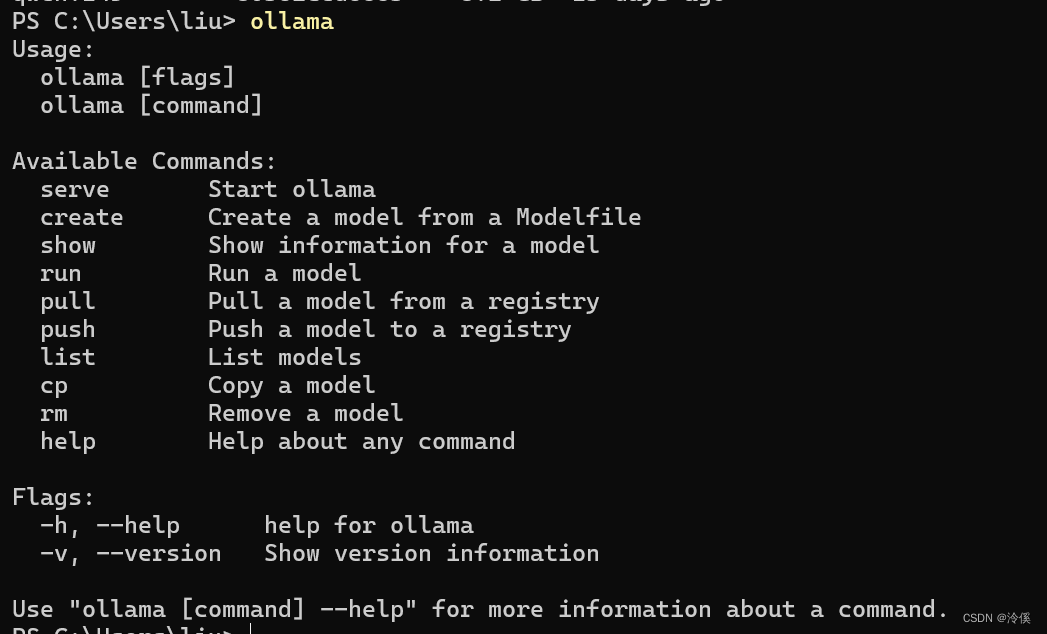

安装完成后,在命令行运行 ollama,出现以下情况,代表安装成功。

通过 ollama --verison 或 ollama -v 可以查看 ollama 版本。若运行时出现警告 Warning: could not connect to a running Ollama instance,是因为 ollama 没有运行,执行 ollama serve 命令运行 ollama 即可。

2.3 下载、运行模型

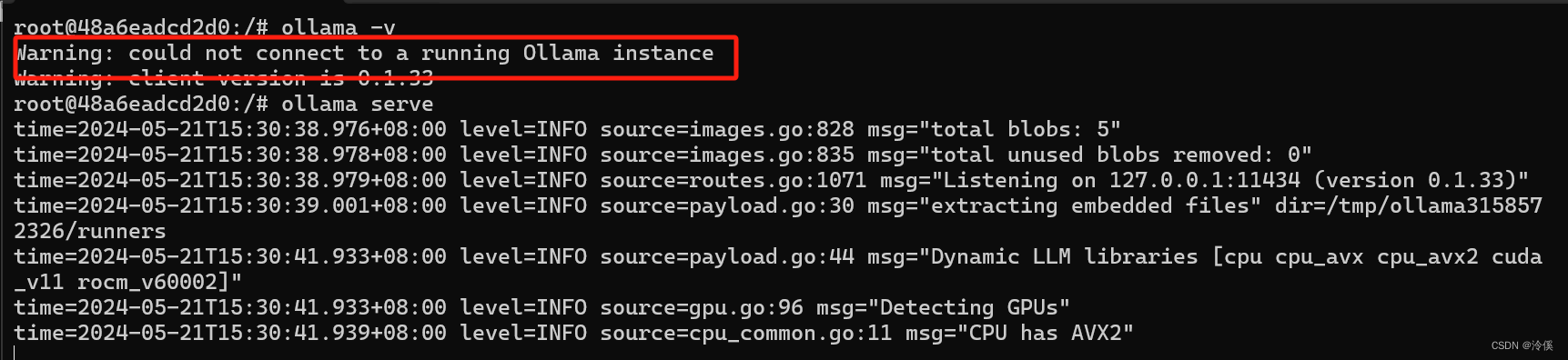

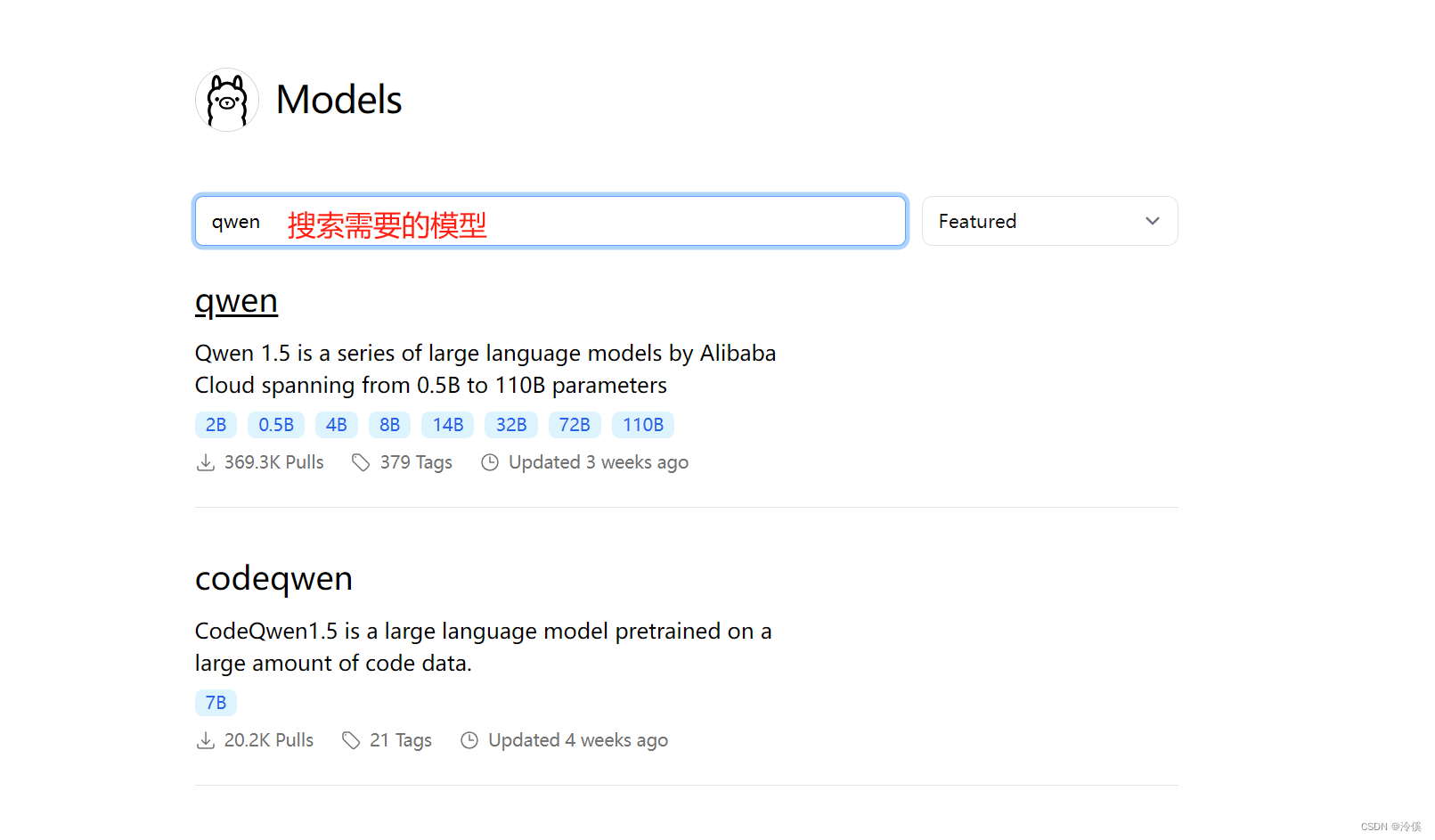

打开模型下载地址,搜索自己需要的模型,进行下载,以阿里的 ”千问“ 为例,搜索 qwen,并选择自己的版本。

本例使用 “qwen:14b”,在命令行中执行 ** ollama run qwen:14b**,便开始下载运行所选模型。等待下载完成,最后一部分会比较缓慢。

ollama run 命令和docker run命令类似,都是先去本地环境中查询,是否拥有该镜像,若没有则去远程仓库拉取。

可以使用 ollama list 查询本地已下载的模型。

2.4 使用

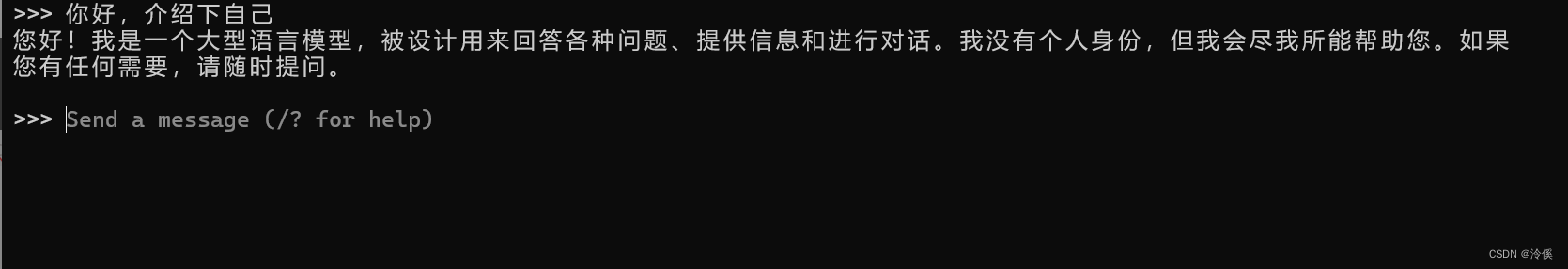

等待下载完成,并开始运行,就可以开始使用了。

3. 整合open-webui

Open WebUI是一个可扩展、特征丰富且用户友好的自托管WebUI,旨在完全离线运行。它支持各种LLM运行器,包括Ollama和OpenAI兼容的API。

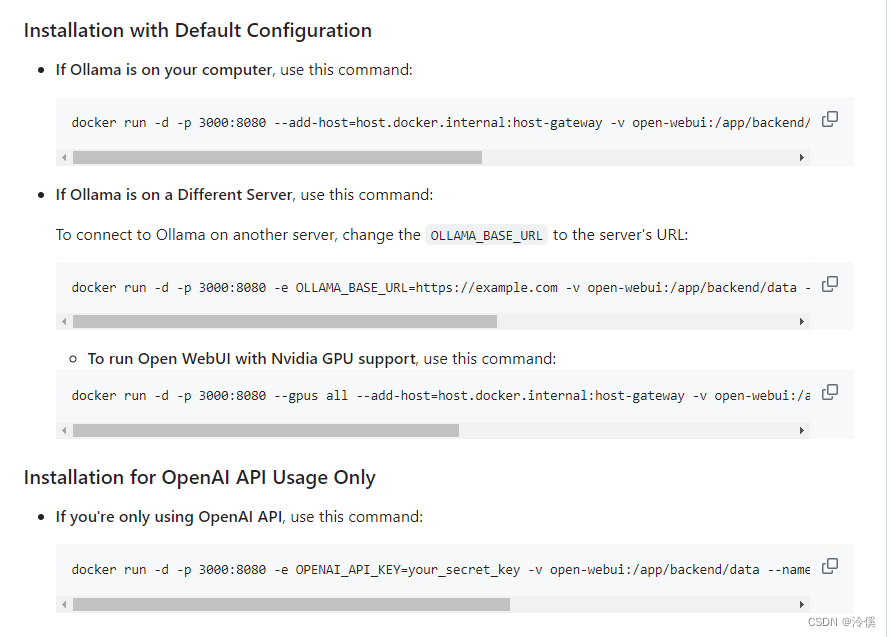

3.1 安装 open-webui

执行以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

- 1

该命令来自官方的github仓库,可以根据自己情况进行更改

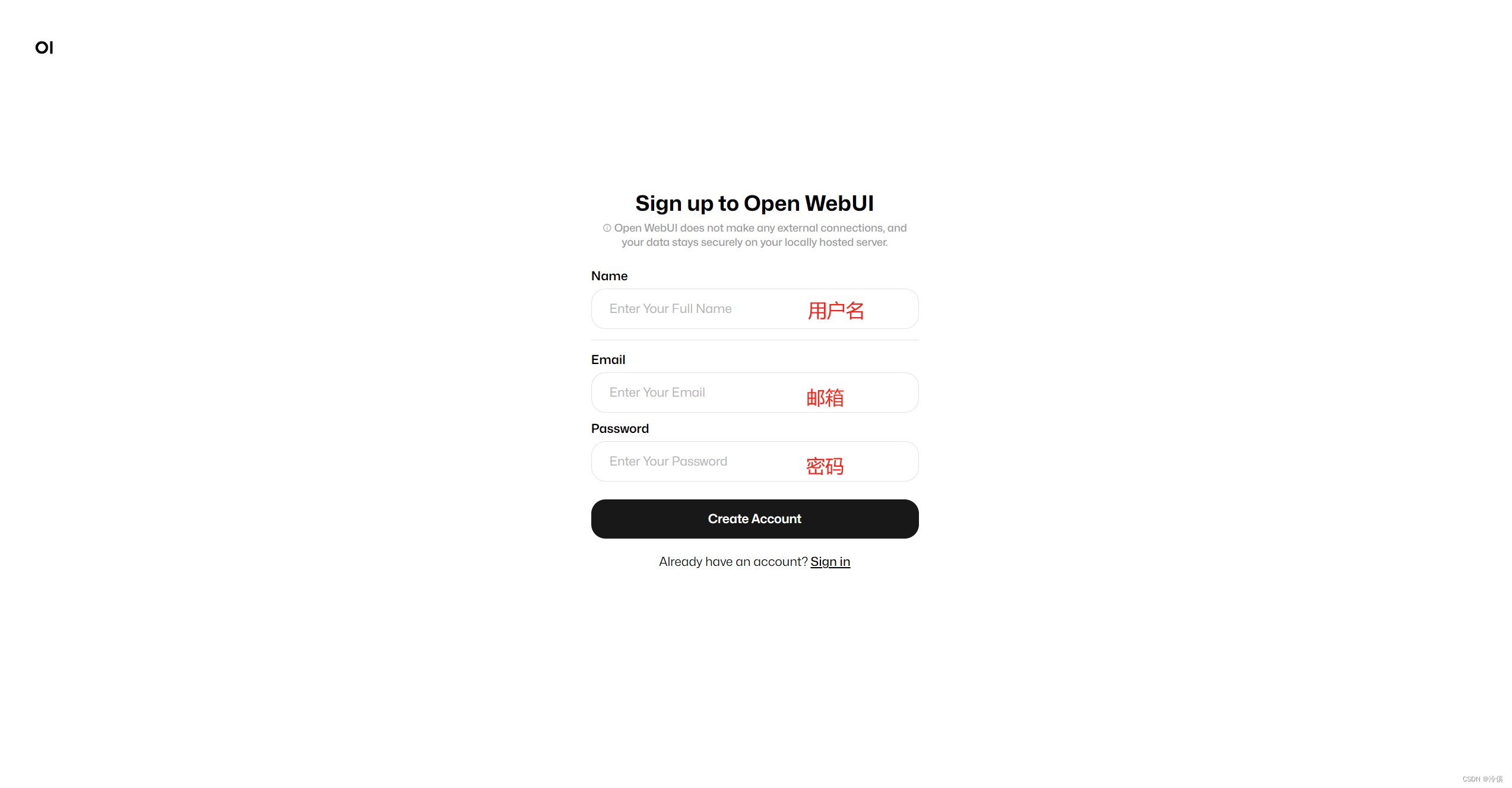

3.2 登录并配置open-webui

上述命令运行完成后,可以开打 localhost:3000,以下界面,根据提示进行注册,即可登录。后续登录是通过邮箱登录。

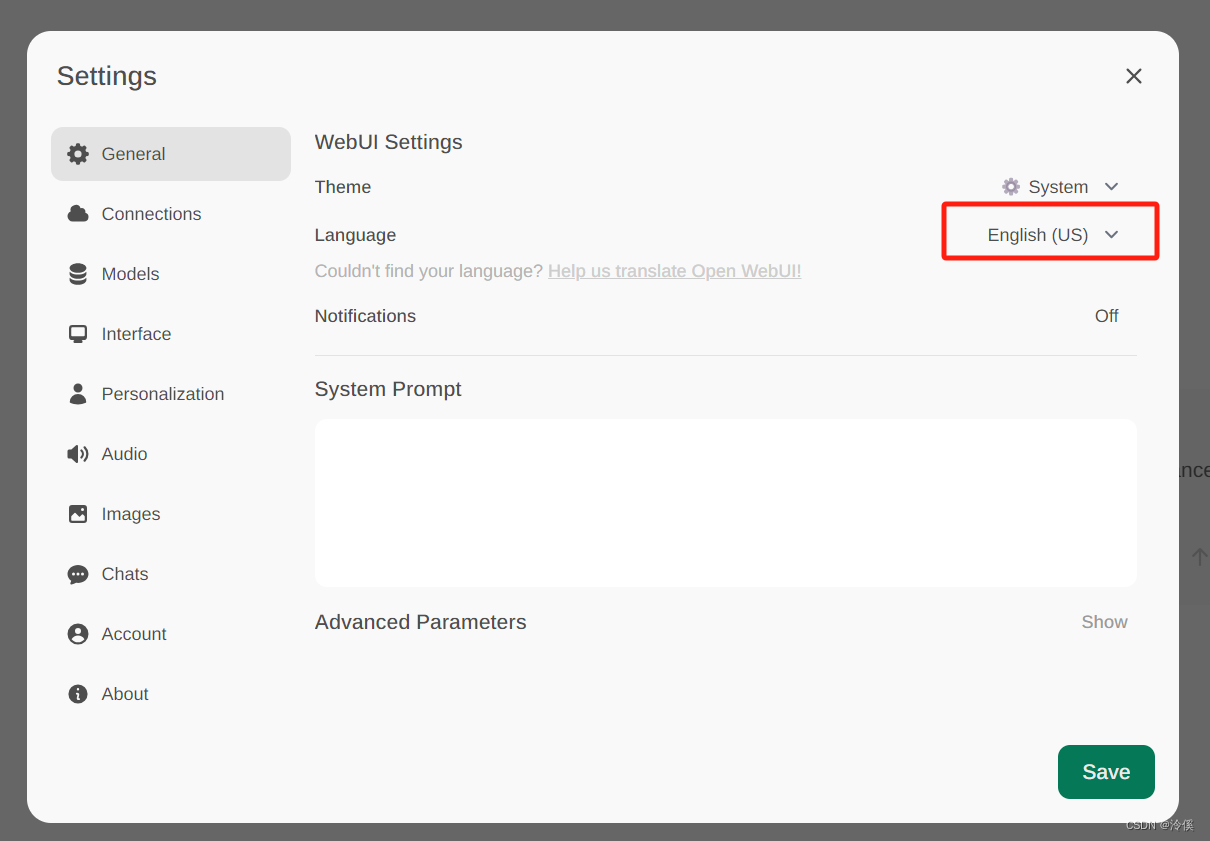

登录成功后,点击右上角配置,更改为简体中文:

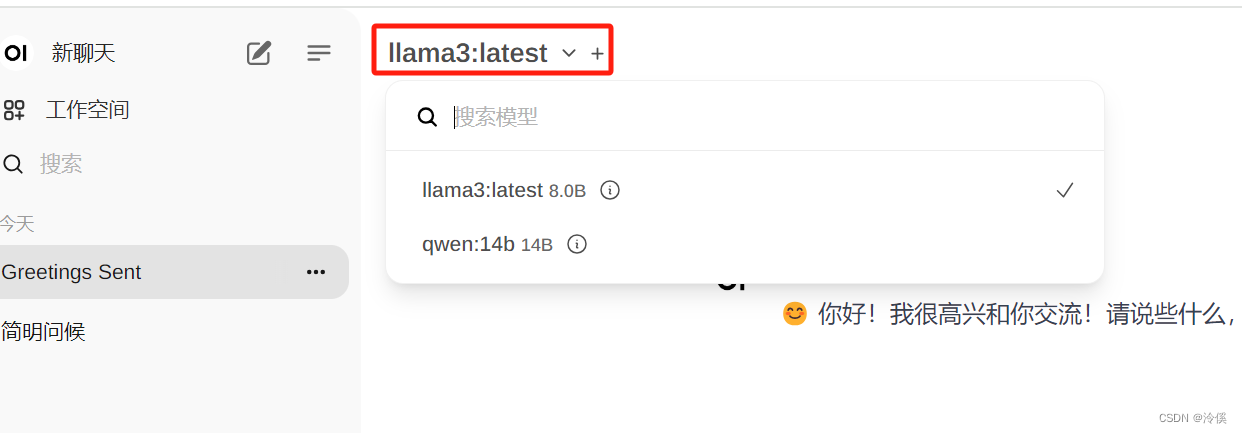

左上角选择使用模型:

以上为使用 Windows本地部署 Ollama 的流程。