- 1机器学习scikit-learn(一)(转)

- 22021-2022 ACM-ICPC Latin American Regional Programming Contest

- 3set(集合),multiset容器及pair队组的创建

- 4AI 入门指南五 :提示词编写技巧(上)_ai 提示词工程 教程

- 5绑卡测试_绑卡的测试点

- 6深入Kali Linux:高级渗透测试技术详解_kali linux无线网络渗透测试详解

- 7RK RGA _MMU unsupported memory larger then 4G!问题解决

- 8入职新公司,如何迅速脱颖而出,展现个人魅力与价值!

- 9最新!!单目深度估计方向文献综述--Monocular Depth Estimation: A Thorough Review_单目深度估计综述

- 10极狐GitLab 如何和Mailgun 进行集成配置?

本地部署一个聊天机器人模型_本地聊天部署

赞

踩

前言

前不久我突发奇想能不能在我的笔记本部署一个模型来聊聊天摸摸鱼呢?于是我就开始了百度

经过我两天的查询和测试我摸出来了两套路子。

注意下面的两种方式都有有Linux 的部署方式

有Linux 的部署方式

有Linux 的部署方式

有Linux 的部署方式

第一套:Ollama 实现部署(比较推荐)

首先这个软件是一个开源的人工智能(AI)和机器学习(ML)工具平台,特别设计用于简化大型语言模型(LLM)的部署和使用流程。

一句话来说用它省事省力

1、下载安装

首先我们需要去官网下载它

下载和安装没什么好说的

2、环境变量

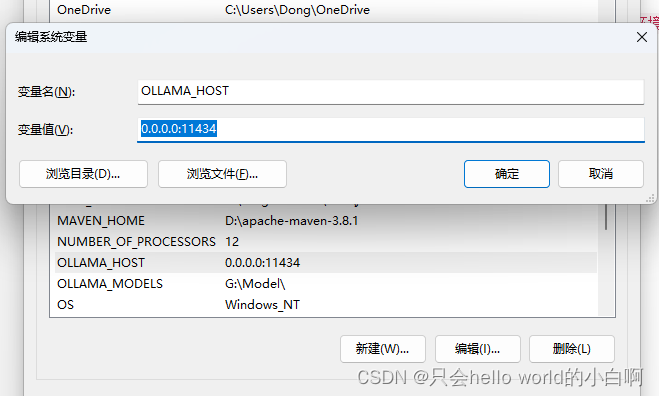

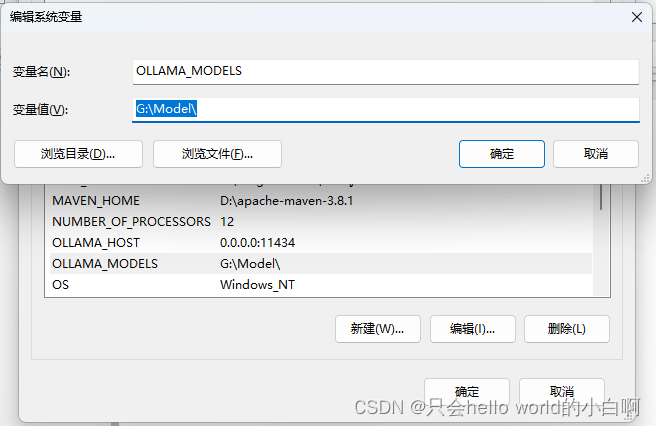

配置环境变量,我们需要在系统的高级设置里面 -> 环境变量 -> 新增环境变量

这里我们需要增加两个环境变量

- 1、

OLLAMA_HOST -

- 值:

0.0.0.0:11434

- 值:

- 2、

OLLAMA_MODELS -

- 值:

G:\Model\(参考你自己的位置不一定要和我的一样)

配置完了我们来说说这两个环境变量的作用:

- 值:

- 1、

OLLAMA_HOST是用来配置服务的,简单来说就是后续我们要接入ui 的时候会有服务器地址和端口就是在这里做配置 - 2、

OLLAMA_MODELS看名字就知道它是用了来存放我们模型的(不改的话默认会放到C盘中c:\.ollama)

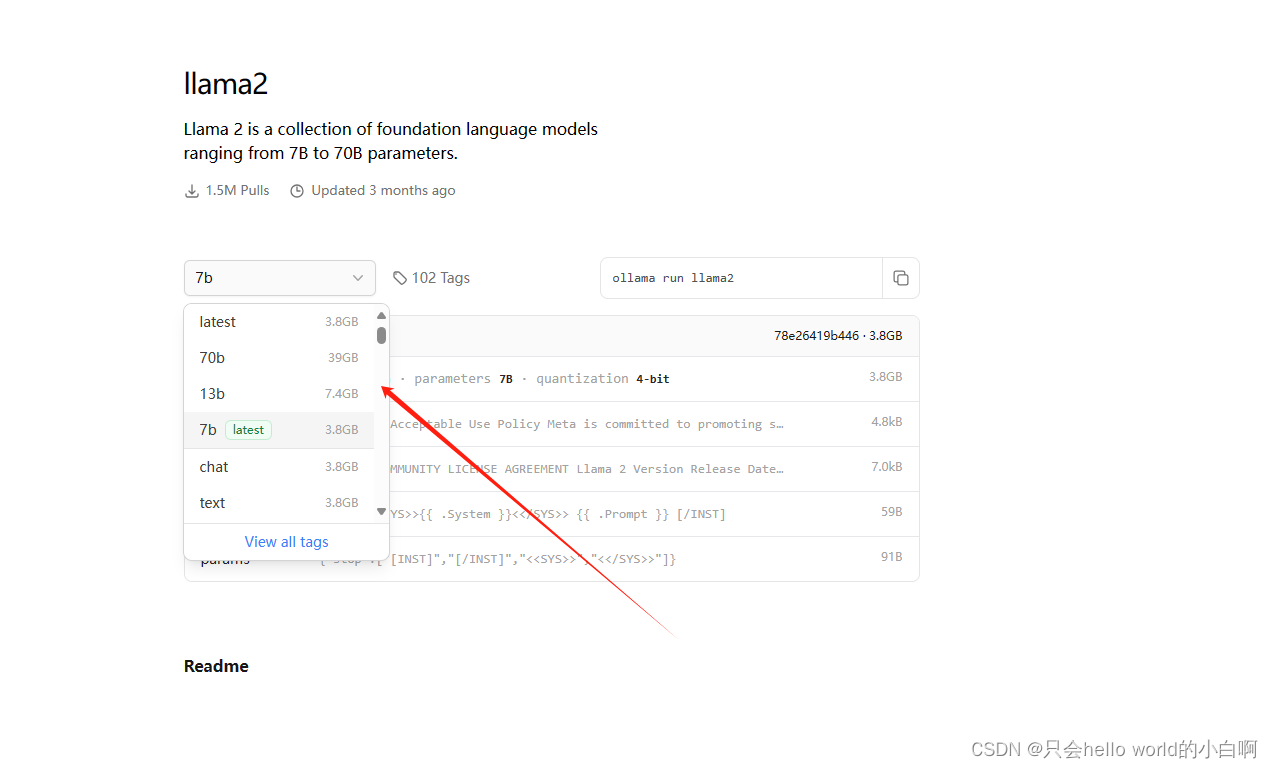

3、下载模型

打开官网点击models

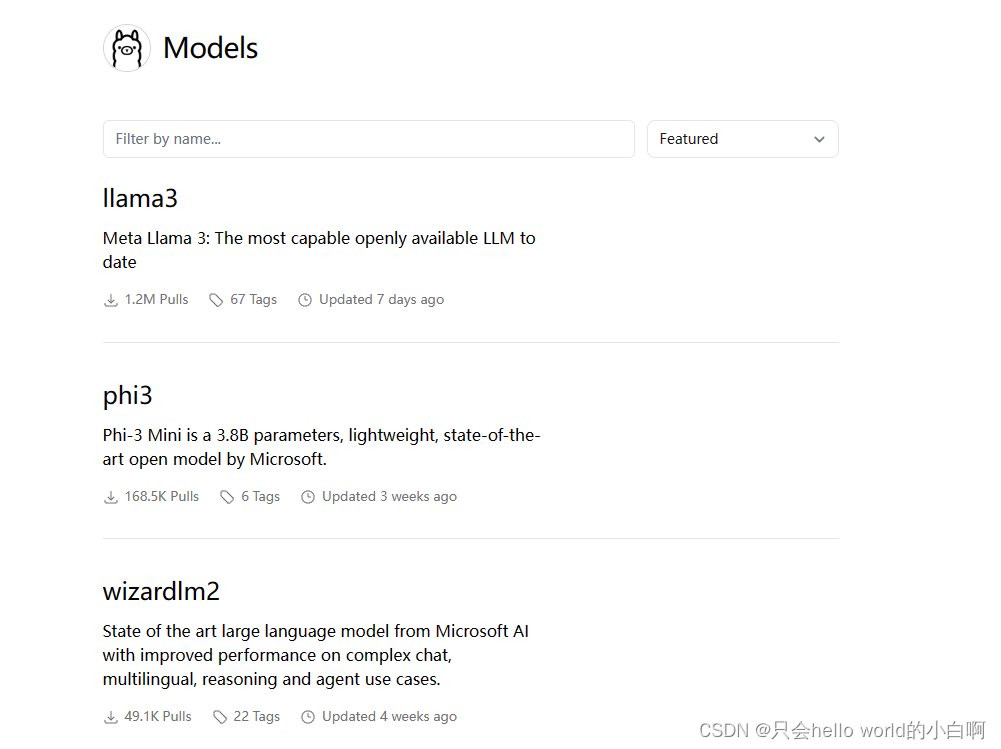

就会看到有很多模型

经过这些天的百度发现llama这个模型是开源的而且比较强大(中文处理能力稍微弱一些)

也可以使用Qwen(通义千文)的模型

具体使用那个模型看个人喜好,使用那一个包这个看你自己的设备性能(不知道用那个的可以选版本低一些的也可以去百度找找)

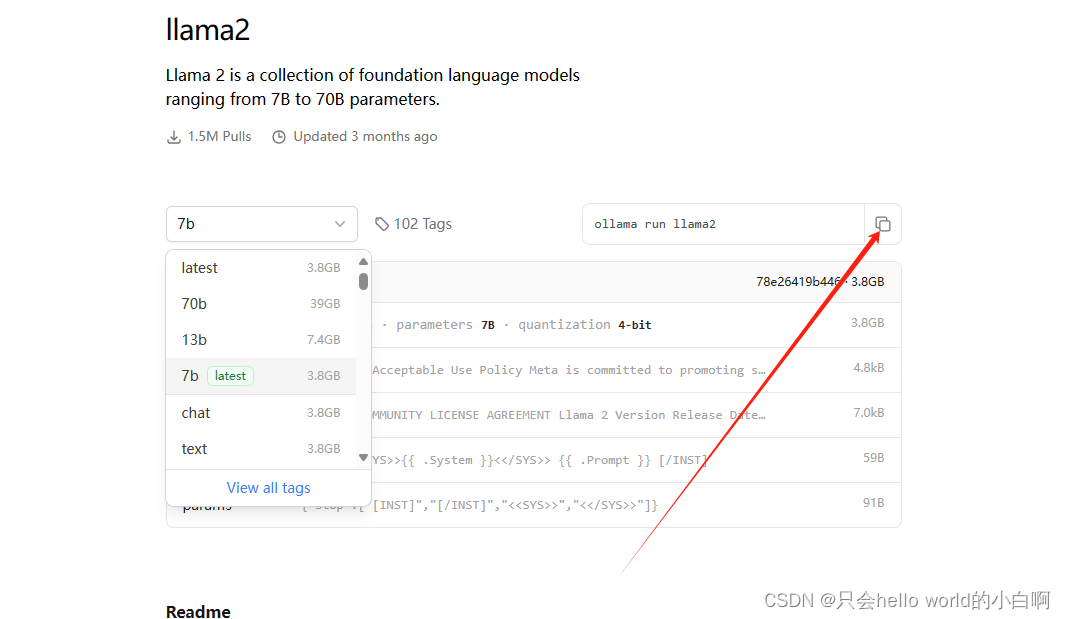

然后就复制下载命令

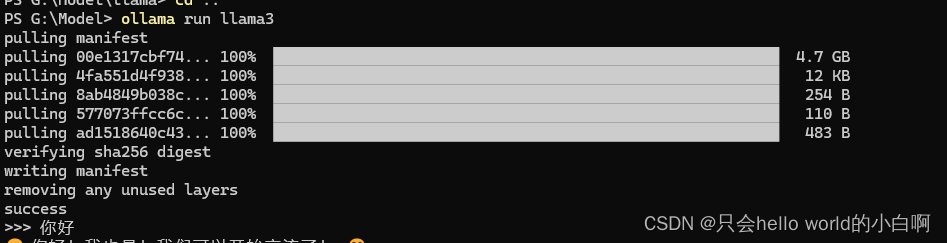

没错这里直接ollma 需要使用命令行来运行和下载,当你使用ollma 运行一个不存在的模型时它会自动帮你下载并运行

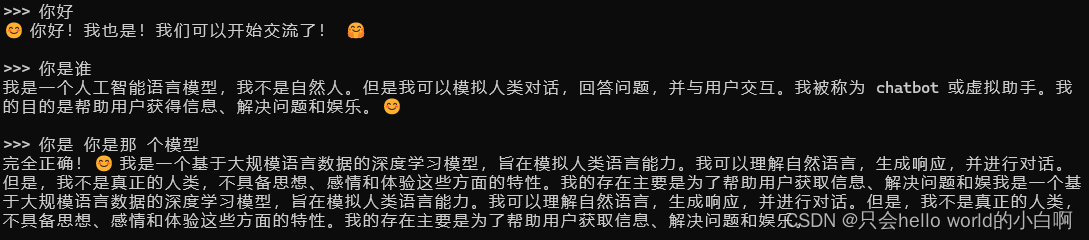

下载好了以后弹出success 并且会提示你输入的时候就说明已经部署好了

并且这个软件还支持使用api 来进行交互(正在研究着后续会使用spring ai 来实现一个简单的聊天程序)

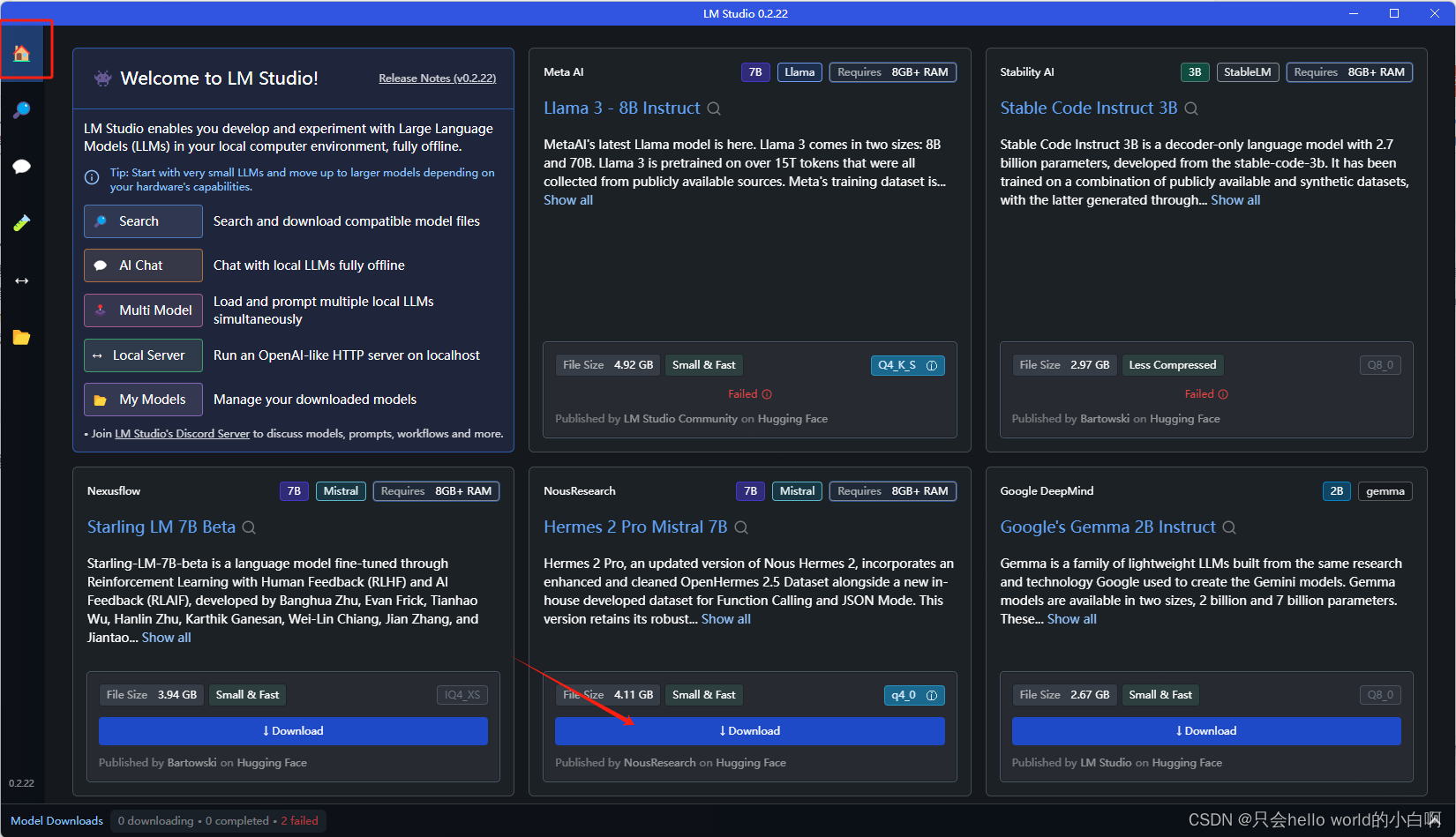

第二套:LM-Studio部署 (切记不可商用)

第二套的话相对复杂一些,没有第一套方便。但是第一套因为是面对着cmd 窗口多多少少有一些不还用(也可以使用第三防插件来实现一个gui 页面。具体的参考这篇文章)

话不多说咱们开始

1、安装

我们首先要安装LM-Studio的客户端,我们需要从官网下载然后安装

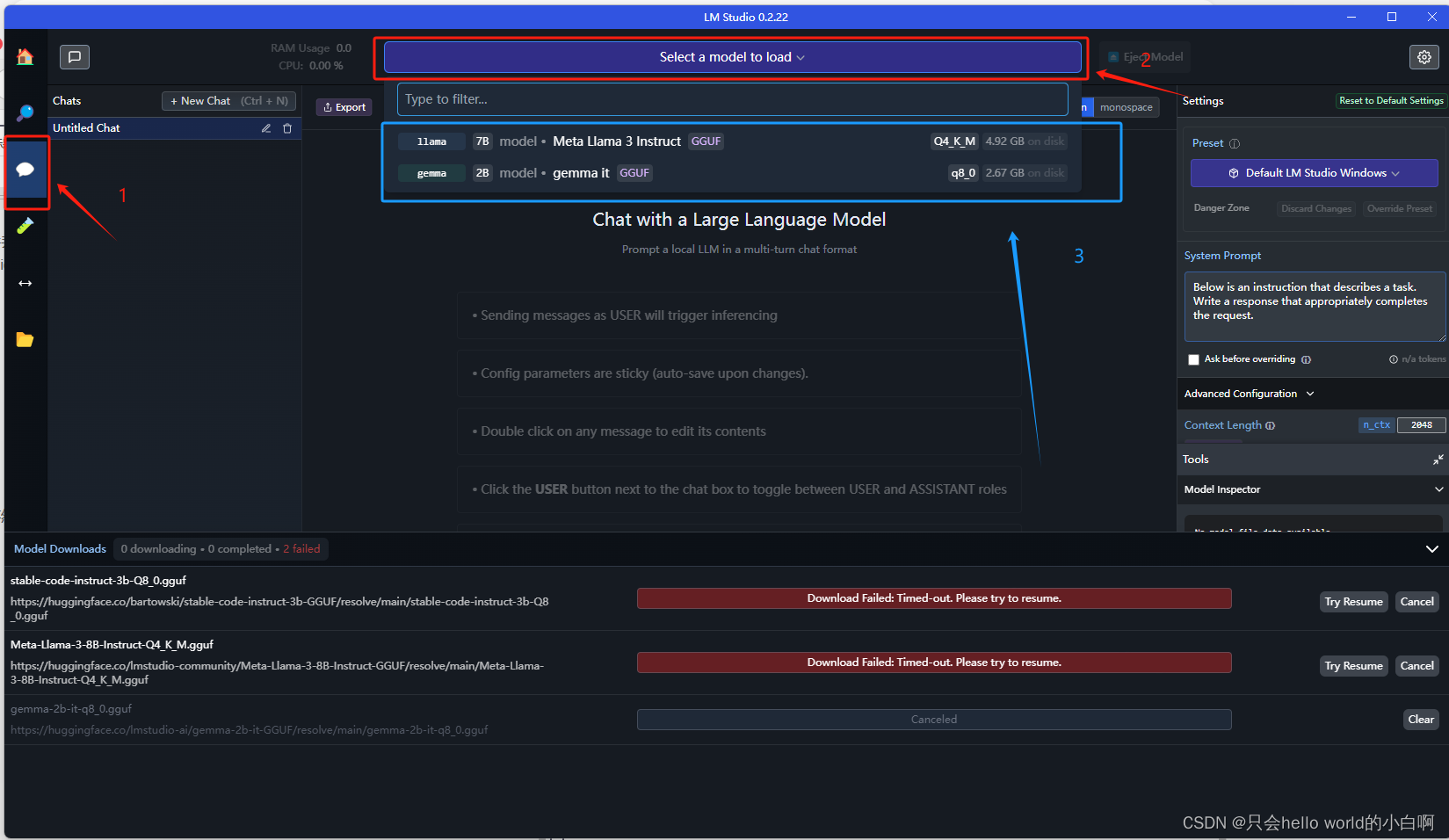

2、下载模型

在主页面中点击download 键下载即可

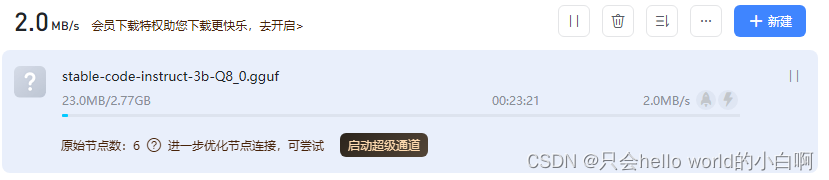

你可能会认为这个会更简单。问题就在下载这里,如果你没有科学上网(有时候也不能下载)它就下载不了。

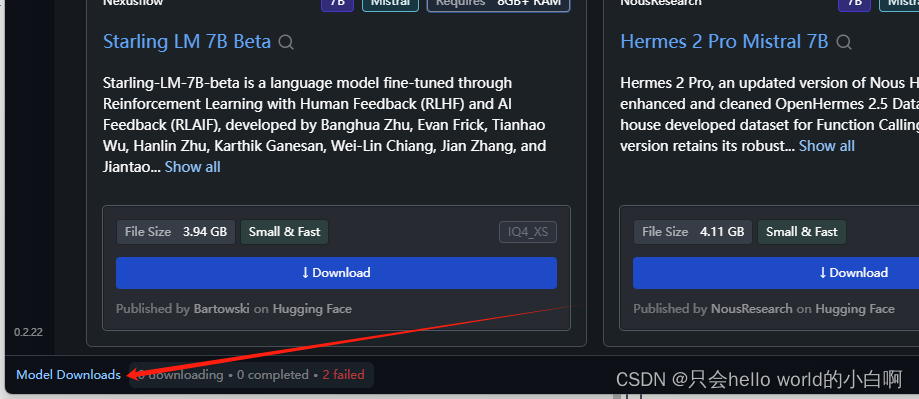

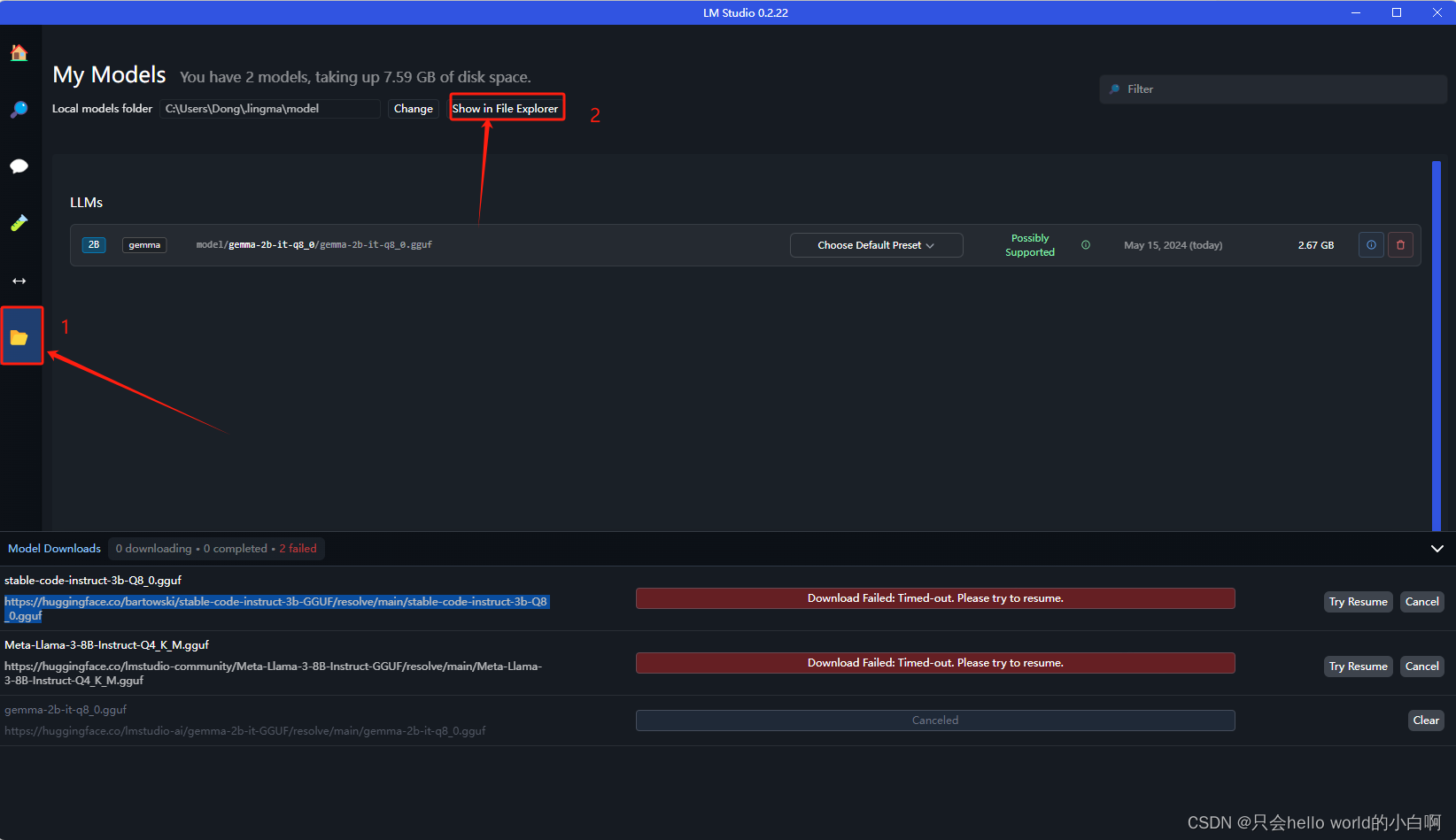

点击左下角这里

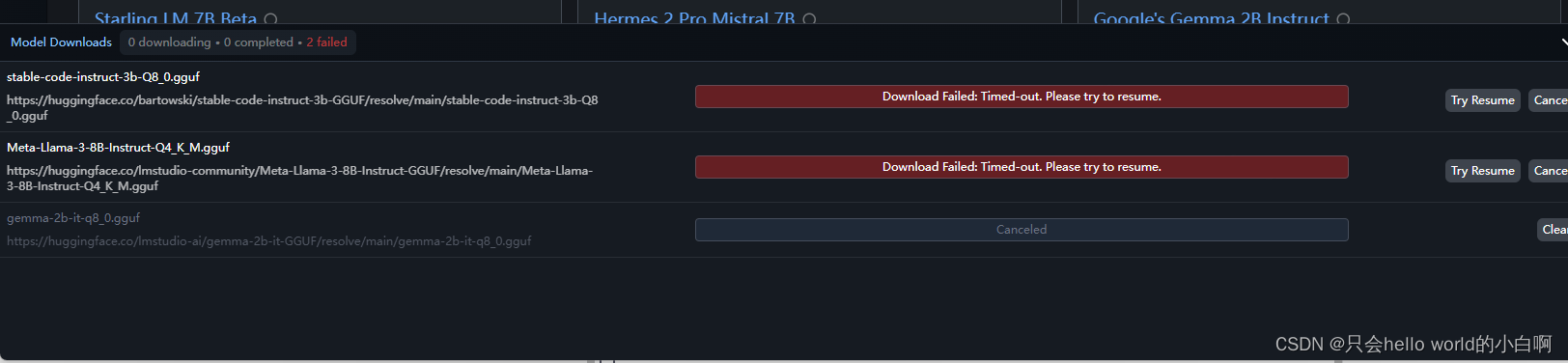

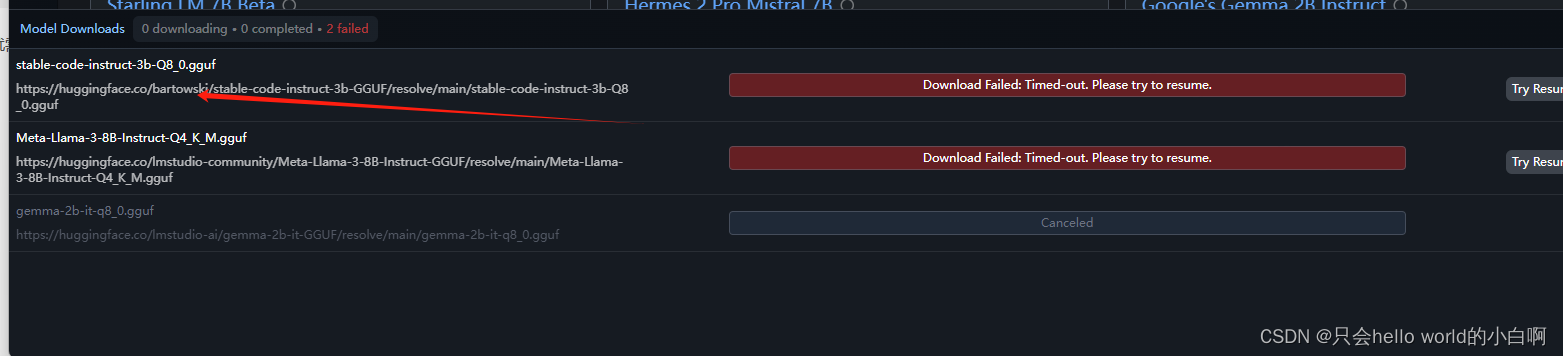

你会发现不管你怎么尝试进度条都不会动,过一会就会说下载失败

这个时候我们就需要使用其它的下载方式了。

复制模型文件连接

然后打开浏览器粘贴跳转

也可以打开迅雷粘贴下载(我是用迅雷的有时候有加速会快一些)

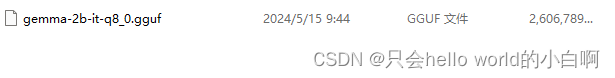

等待下载完成。

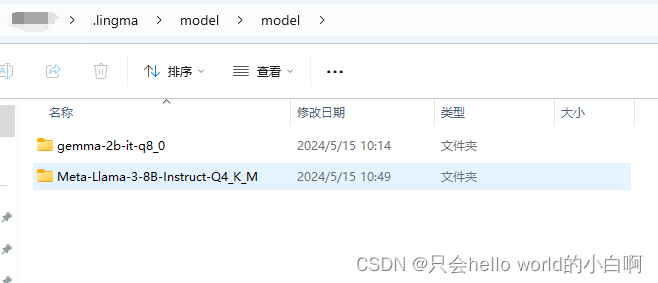

3、转移模型

为什么要转移呢?很简单因为我们下载的路径不再它的识别范围

下载好以后,打开它所在的文件夹

复制或者剪切(看个人喜好)

然后打开lmstudio

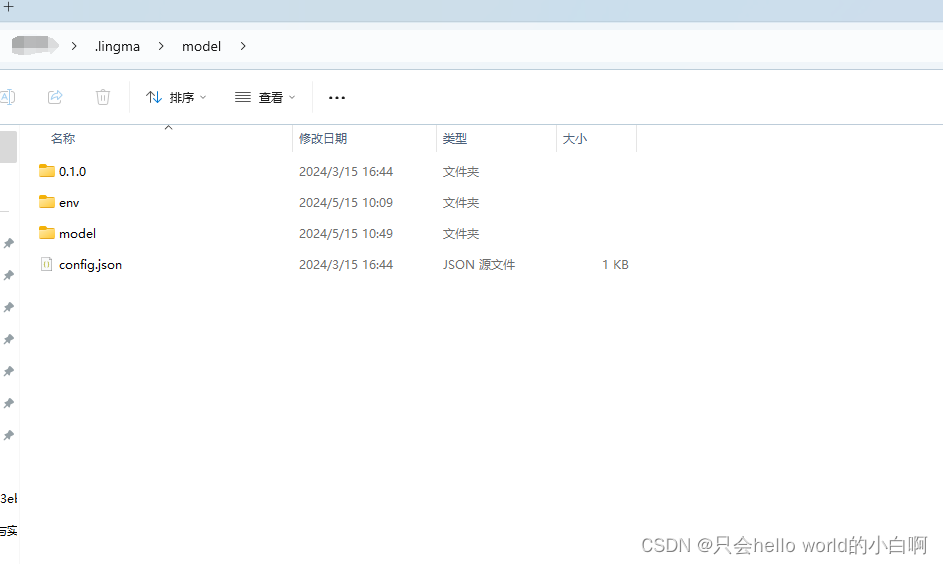

然后点击模型文件夹,打开模型文件夹

你会发现它其实在c盘(我试着改过但是改了以后会识别不到)

然后打开model文件

这里多了一个model 不通管我也不知道为什么。

- 1

然后再这里建立一个模型的文件夹,名字随便

然后把模型文件丢进来。

然后重启lmstudio

重启lmstudio

重启lmstudio

重启lmstudio

一定要重启软件,不然识别不到

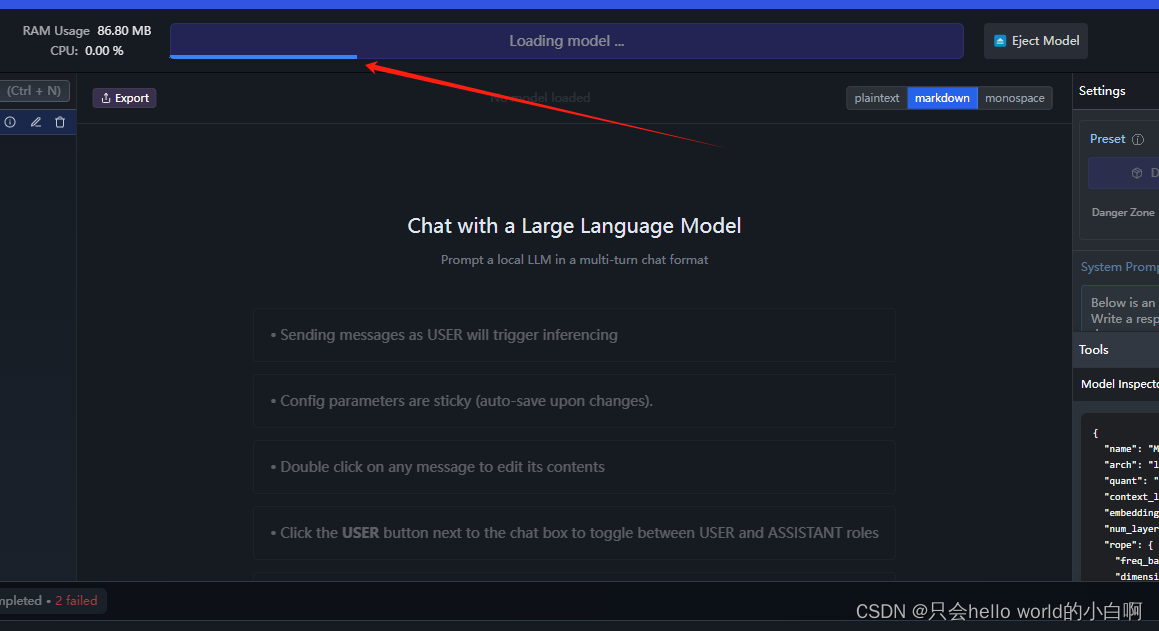

重启好了以后

这个时候就可以看到,这里的模型已经出来了

选择模型以后

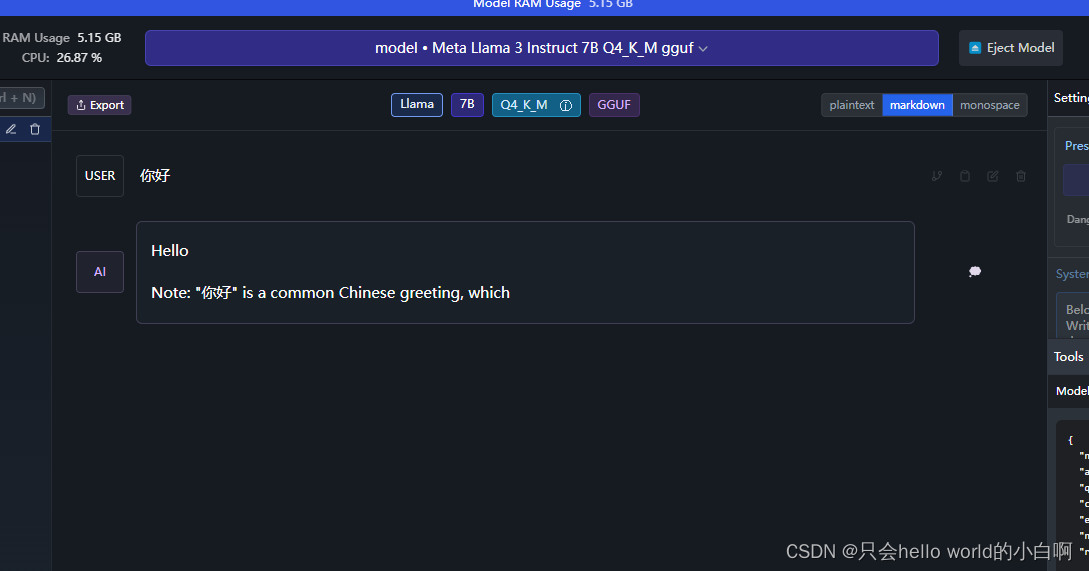

等这里的进度条加载完就可以聊天了

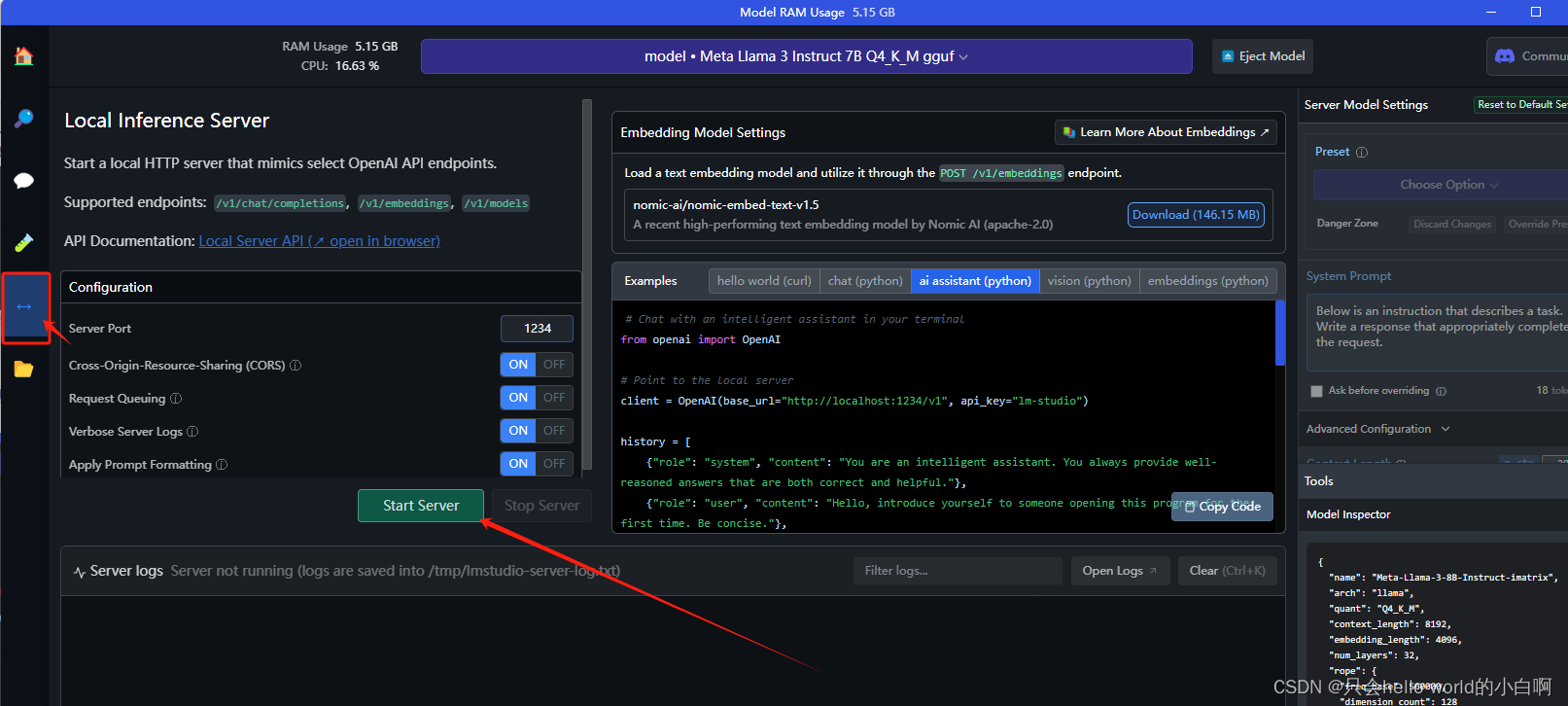

并且这个软件也支持打开server

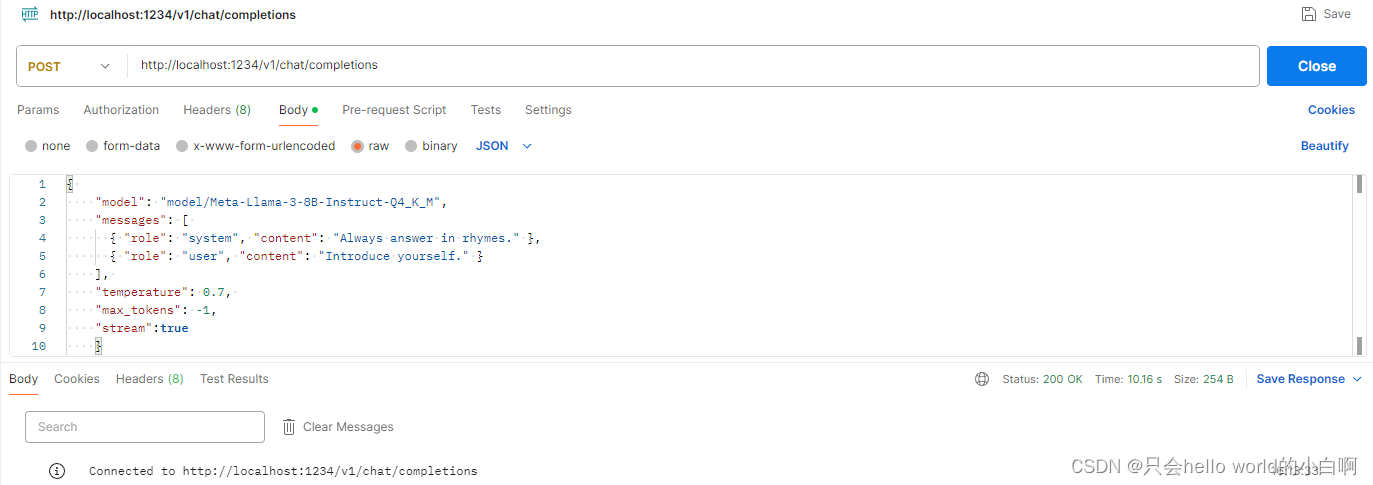

postman 测试

具体的就自己琢磨吧。